Vidéo MOFA : la technologie d'adaptation du champ de mouvement convertit les images fixes en vidéo

Introduction générale

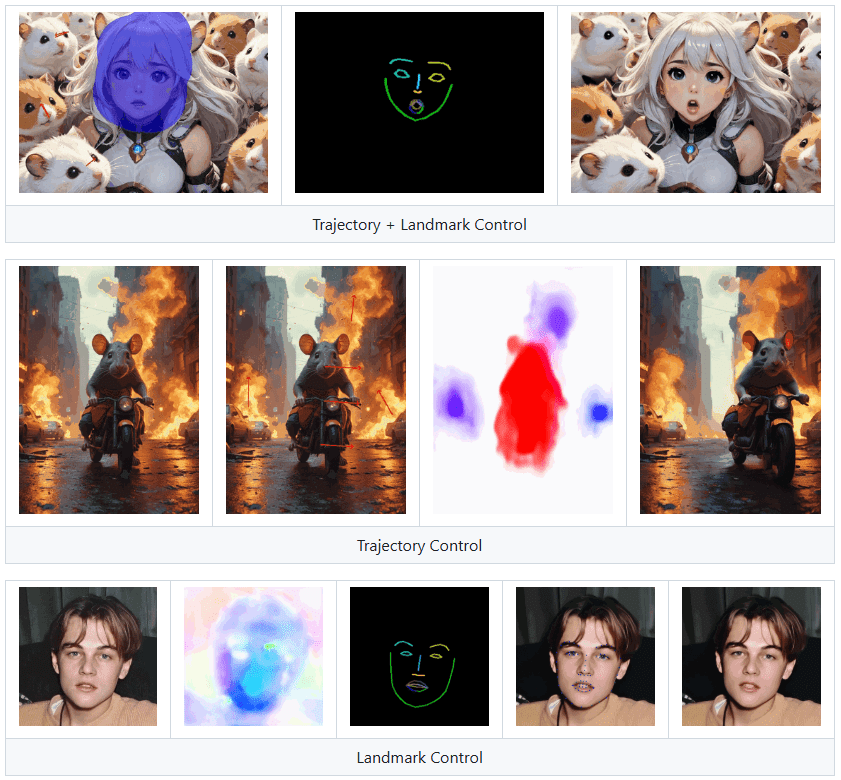

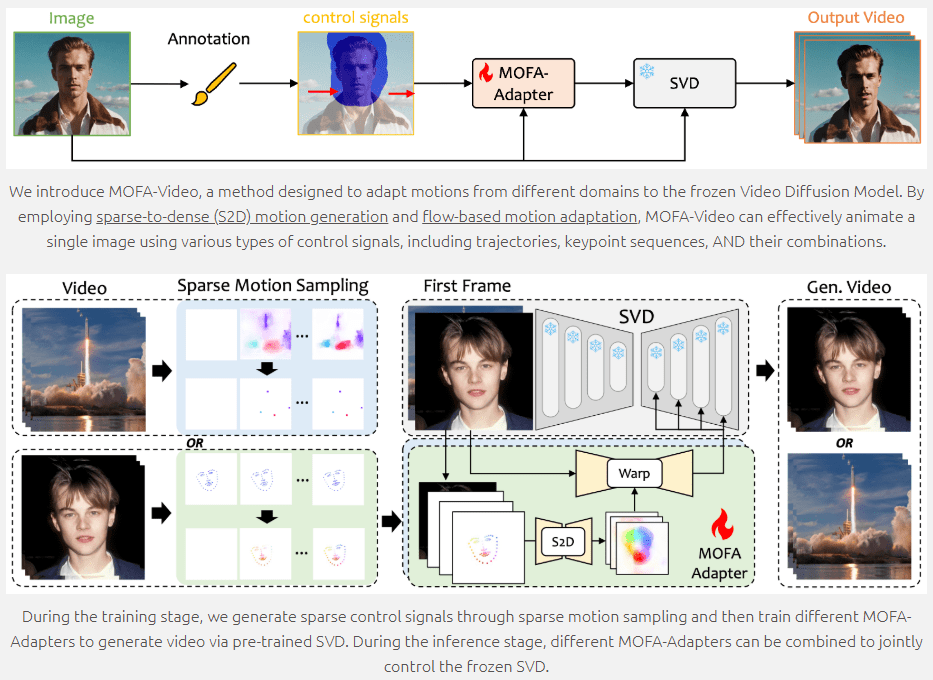

MOFA-Video est un outil de génération d'animations d'images de pointe qui utilise des techniques génératives d'adaptation du champ de mouvement pour convertir des images statiques en vidéo dynamique. Développé en collaboration avec l'Université de Tokyo et le Tencent AI Lab, et qui sera présenté à l'ECCV 2024, MOFA-Video prend en charge une variété de signaux de contrôle, y compris les trajectoires, les séquences de points clés et leurs combinaisons, permettant une animation d'image de haute qualité. Les utilisateurs peuvent accéder au code et aux ressources connexes via le dépôt GitHub pour démarrer facilement.

Landmark Control peut faire parler des personnes dans des images, mais n'est pas adapté pour être utilisé comme clone d'une personne numérique.

Liste des fonctions

- Génération d'animations d'images : conversion d'images fixes en vidéos animées

- Signaux de commande multiples : trajectoires de soutien, séquences de points clés et combinaisons de ces signaux

- Adaptation du champ de mouvement : animation grâce à la génération de mouvements clairsemés à denses et à l'adaptation du mouvement basée sur le flux

- Scripts de formation et d'inférence : fournir un code complet pour la formation et l'inférence

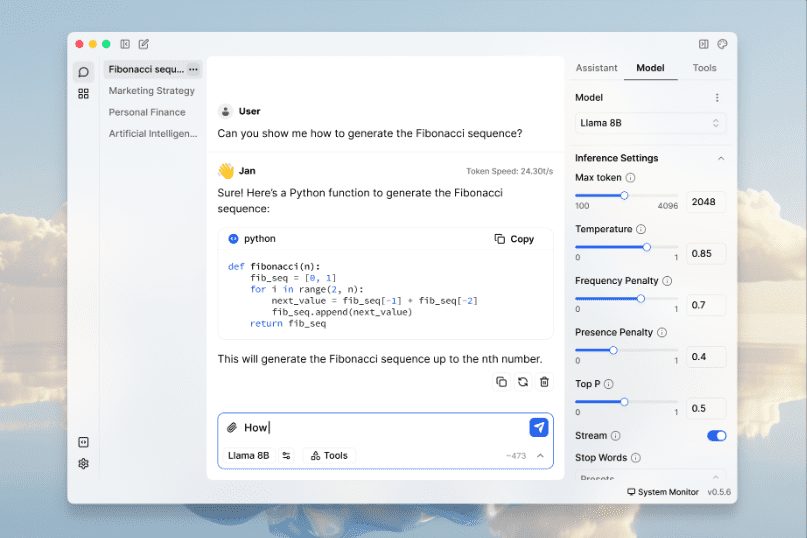

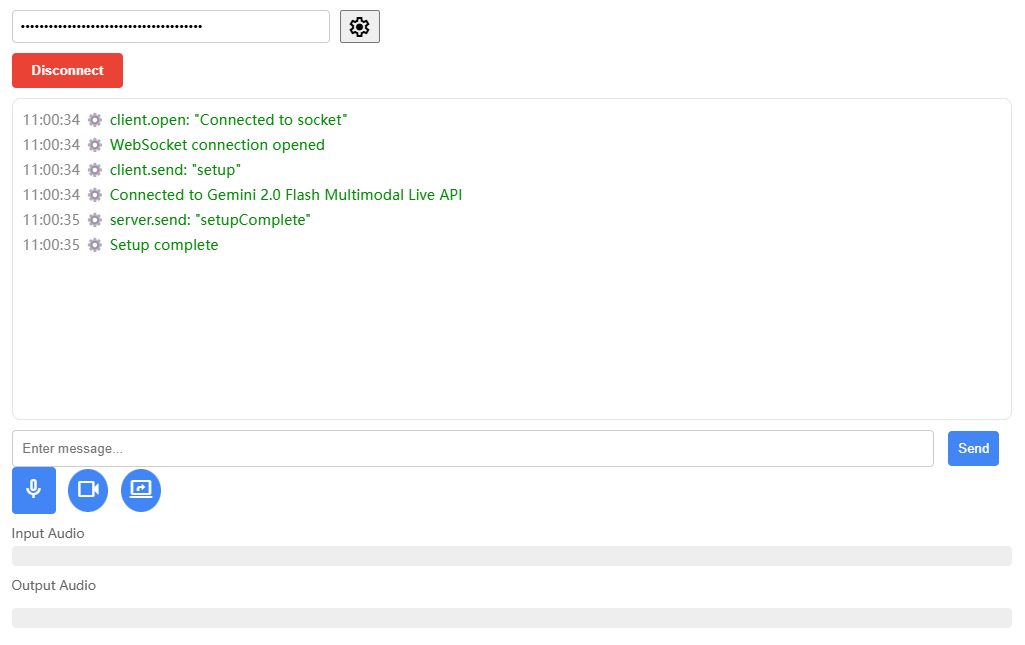

- Démonstrations de Gradio : démonstrations en ligne et téléchargements de points de contrôle

- Open source : mise à disposition du public du code et des ressources sur GitHub

Utiliser l'aide

Paramètres environnementaux

- entrepôt de clones

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

- Créer et activer un environnement Conda

conda create -n mofa python==3.10

conda activate mofa

- Installation des dépendances

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

- Télécharger les points de contrôle Télécharger les points de contrôle du référentiel HuggingFace et les placer dans le répertoire

./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpointsCatalogue.

Démonstration avec Gradio

- L'audio au service de l'animation faciale

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

- Animation faciale avec vidéo de référence

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

L'interface Gradio affichera des instructions, veuillez suivre les instructions de l'interface pour effectuer l'opération de raisonnement.

Formation et raisonnement

MOFA-Video fournit des scripts de formation et d'inférence complets, qui peuvent être personnalisés selon les besoins. Pour des instructions détaillées, veuillez vous référer au fichier README dans le dépôt GitHub.

Principales fonctions

- Génération d'animations d'images : téléchargez une image statique, sélectionnez les signaux de contrôle (trajectoire, séquence de points clés ou une combinaison de ceux-ci) et cliquez sur le bouton Générer pour générer une vidéo dynamique.

- Signaux de commande multiples : les utilisateurs peuvent choisir différentes combinaisons de signaux de commande pour obtenir des effets d'animation plus riches.

- Adaptation du champ de mouvement : assure des effets d'animation fluides et naturels grâce à des techniques de génération de mouvement clairsemé à dense et d'adaptation de mouvement basée sur le flux.

MOFA-Video offre des fonctions riches et des instructions détaillées permettant aux utilisateurs de générer des animations d'images et de personnaliser la formation en fonction de leurs besoins, et d'obtenir facilement des effets d'animation d'images de haute qualité.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...