Modèle de génération vidéo Mochi 1 : SOTA dans les modèles de génération vidéo open source

Genmo AI est un laboratoire d'intelligence artificielle de pointe qui se consacre au développement de modèles de génération vidéo open source à la pointe de la technologie. Son produit phare, Mochi 1, est un modèle de génération vidéo open source capable de générer des vidéos de haute qualité à partir d'indices textuels. L'objectif de Genmo est de stimuler l'innovation dans le domaine de l'intelligence artificielle grâce à la technologie de génération vidéo, en offrant des possibilités illimitées d'exploration et de création virtuelles.

Models est une bibliothèque open source de modèles de génération vidéo, comprenant les derniers modèles Mochi 1. Mochi 1 est basé sur la diffusion asymétrique. Transformateur (AsymmDiT), avec 1 milliard de paramètres, est le plus grand modèle de génération vidéo publié publiquement. Ce modèle est capable de générer des vidéos d'action fluides et de haute qualité qui réagissent aux signaux textuels.

Mochi 1 Preview est un modèle ouvert de génération vidéo avancée qui offre une grande fidélité des mouvements et un suivi rigoureux des repères. Notre nouveau modèle comble le fossé entre les systèmes de génération vidéo fermés et ouverts. Nous publierons le modèle sous une licence libérale Apache 2.0.

Mochi 1 adresse de prévisualisation

Visage étreint (poids du modèle)

Terrain de jeu (démo en ligne)

[bilibili]https://www.bilibili.com/video/BV1FRy6YeEui/[/bilibili]

Liste des fonctions

- Génération vidéoLes vidéos : générez du contenu vidéo de haute qualité en saisissant des invites textuelles.

- modèle open sourceMochi 1 est disponible en tant que modèle open source, ce qui permet à l'utilisateur de l'adapter et de le développer.

- Qualité de mouvement haute fidélitéLes vidéos : générez des vidéos avec des mouvements fluides et des effets physiques très fidèles.

- Alignement efficace des baguettesLa capacité de générer une vidéo qui correspond précisément aux besoins de l'utilisateur à partir d'invites textuelles.

- Soutien communautaireLes utilisateurs peuvent partager le contenu vidéo généré et en discuter au sein d'une plateforme communautaire.

- Support multiplateformeLes services d'aide à l'utilisation de plates-formes multiples, y compris le web et les appareils mobiles, sont pris en charge.

Architecture du modèle Mochi 1

Mochi 1 représente une avancée significative dans la génération vidéo open source avec un modèle de diffusion de 10 milliards de paramètres basé sur notre nouvelle architecture Asymmetric Diffusion Transformer (AsymmDiT). Formé entièrement à partir de zéro, il s'agit du plus grand modèle de génération vidéo jamais publié. Plus important encore, il s'agit d'une architecture simple et piratable.

L'efficacité est essentielle pour permettre à la communauté d'utiliser nos modèles. En plus de Mochi, nous avons également ouvert notre VAE vidéo, qui compresse la vidéo à une petite taille de 128x, en utilisant un espace de 8x8 et une compression temporelle de 6x à 12 canaux d'espace potentiel.

AsymmDiT traite efficacement les indices de l'utilisateur et les marqueurs vidéo compressés en simplifiant le traitement du texte et en concentrant la capacité du réseau neuronal sur l'inférence visuelle.AsymmDiT utilise un mécanisme d'auto-attention multimodal pour se concentrer conjointement sur le texte et les marqueurs visuels et apprend une couche MLP distincte pour chaque modalité, de manière similaire à la diffusion stable.3 Cependant, en raison des grandes dimensions cachées, notre réseau neuronal a presque quatre fois plus de paramètres pour le flux visuel que pour le flux textuel. ont presque quatre fois plus de paramètres pour le flux visuel que pour le flux textuel. Pour unifier les modalités dans le mécanisme d'auto-attention, nous utilisons un QKV asymétrique et une couche de projection de sortie. Cette conception asymétrique réduit les besoins en mémoire d'inférence.

De nombreux modèles de propagation modernes utilisent plusieurs modèles linguistiques pré-entraînés pour représenter les invites de l'utilisateur. En revanche, Mochi 1 code les indices à l'aide d'un seul modèle de langage T5-XXL.

Mochi 1 utilise un mécanisme attentionnel 3D complet pour raisonner conjointement sur une fenêtre contextuelle de 44 520 marqueurs vidéo. Pour localiser chaque marqueur, nous étendons l'intégration de la position rotationnelle (RoPE) à 3 dimensions. Le réseau apprend un mélange de fréquences d'axes spatiaux et temporels de bout en bout.

Mochi bénéficie de certaines des dernières améliorations apportées aux extensions du modèle linguistique, notamment la couche d'anticipation SwiGLU, la normalisation des clés de requête pour améliorer la stabilité et la normalisation mezzanine pour contrôler l'activation interne.

Un document technique suivra et fournira plus de détails pour faciliter les progrès dans la génération de vidéos.

Processus d'installation de Mochi 1

- entrepôt de clones : :

git clone https://github.com/genmoai/models

cd models

- Installation des dépendances : :

pip install uv

uv venv .venv

source .venv/bin/activate

uv pip install -e .

- Télécharger le modèle de poids Télécharger le fichier de poids à partir de Hugging Face ou via un lien magnétique et l'enregistrer dans un dossier local.

Processus d'utilisation

- Lancement de l'interface utilisateur : :

python3 -m mochi_preview.gradio_ui --model_dir "<path_to_downloaded_directory>"

l'interchangeabilité<path_to_downloaded_directory>est le répertoire où se trouvent les poids du modèle.

- Génération de vidéos en ligne de commande : :

python3 -m mochi_preview.infer --prompt "A hand with delicate fingers picks up a bright yellow lemon from a wooden bowl filled with lemons and sprigs of mint against a peach-colored background. The hand gently tosses the lemon up and catches it, showcasing its smooth texture. A beige string bag sits beside the bowl, adding a rustic touch to the scene. Additional lemons, one halved, are scattered around the base of the bowl. The even lighting enhances the vibrant colors and creates a fresh, inviting atmosphere." --seed 1710977262 --cfg_scale 4.5 --model_dir "<path_to_downloaded_directory>"

l'interchangeabilité<path_to_downloaded_directory>est le répertoire où se trouvent les poids du modèle.

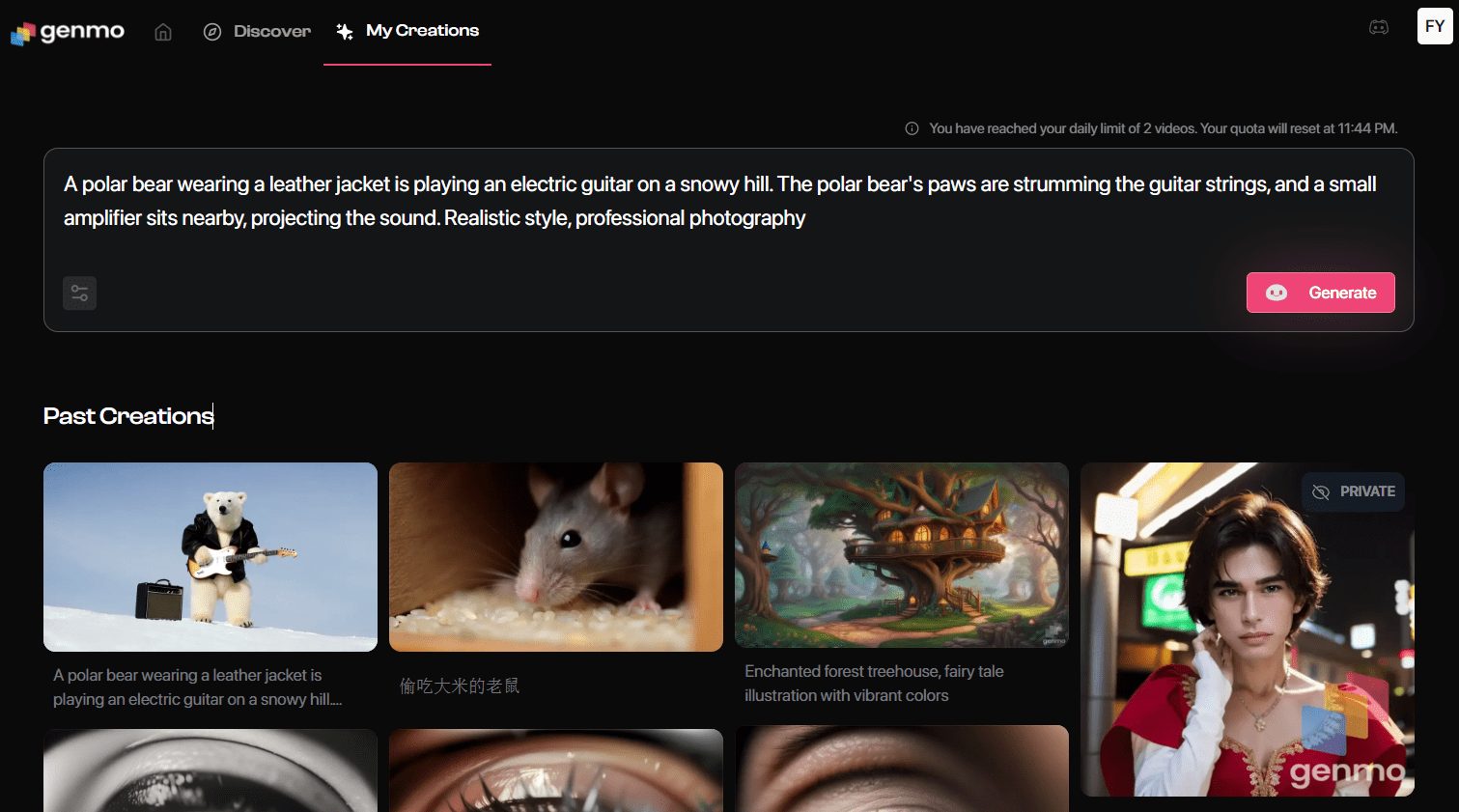

Découvrez Mochi 1 en ligne

- Aller à la page de générationAprès s'être connecté, cliquez sur "Playground" pour accéder à la page de génération de vidéos.

- invite à la saisieLa description de la vidéo que vous souhaitez générer doit être saisie dans le champ d'invite. Par exemple : "Une bande-annonce pour les aventures d'un astronaute de 30 ans portant un casque de moto en laine rouge".

- Sélection des paramètres: Sélectionnez le style vidéo, la résolution et d'autres paramètres en fonction des besoins.

- Générer une vidéoCliquez sur le bouton "Générer" et le système génère la vidéo selon vos instructions.

- Télécharger et partagerUne fois générée, la vidéo peut être prévisualisée et téléchargée localement, ou partagée directement sur les plateformes de médias sociaux.

Fonctionnalités avancées

- Modèles personnalisésLes utilisateurs peuvent télécharger les poids du modèle pour Mochi 1, les entraîner et les ajuster localement pour les personnaliser.

- Interaction communautaireLes vidéos de Genmo : Rejoignez la communauté Discord de Genmo pour échanger des expériences et partager des vidéos générées avec d'autres utilisateurs.

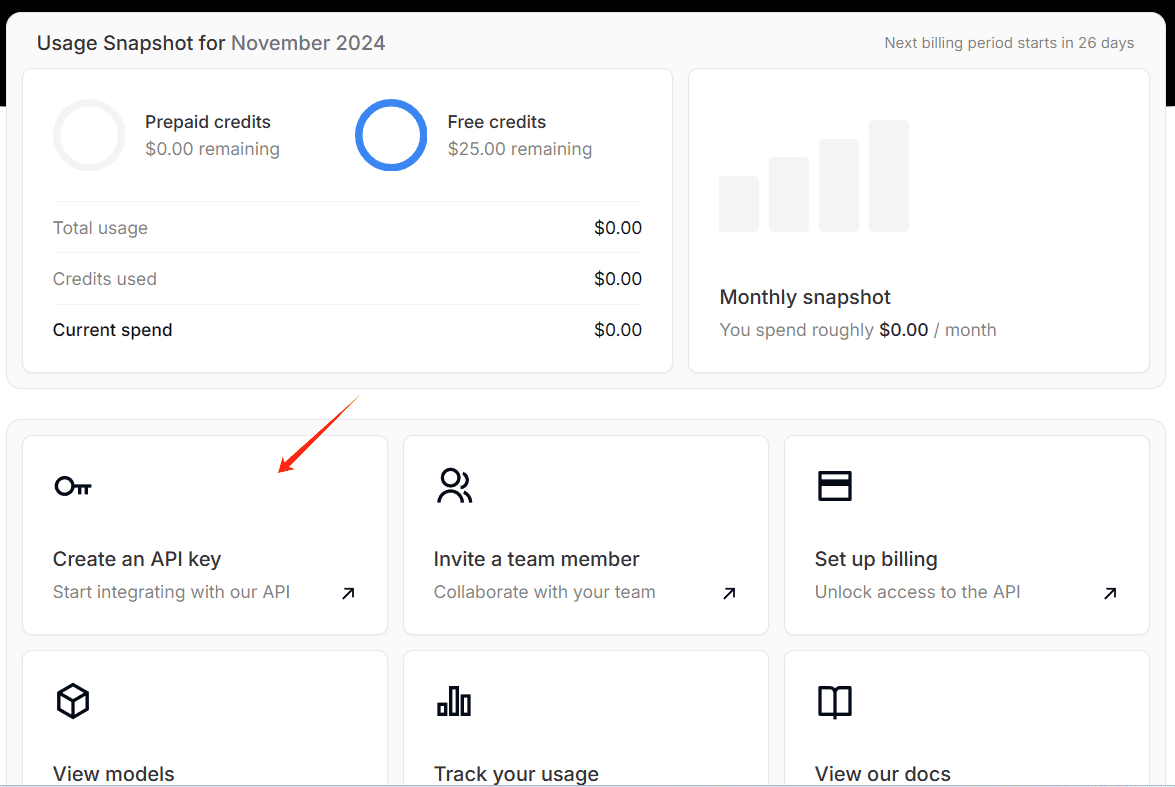

- Interface APILes développeurs peuvent utiliser l'interface API fournie par Genmo pour intégrer la fonctionnalité de génération vidéo dans leurs applications.

problèmes courants

- Échec de la génération vidéoLes déclarations d'invite : Veillez à ce que les déclarations d'invite saisies soient claires et spécifiques, en évitant les descriptions vagues ou complexes.

- Problèmes de connexionSi vous ne parvenez pas à vous connecter, vérifiez votre connexion internet ou essayez un autre navigateur.

- Modèle à téléchargerPour plus d'informations, consultez la page GitHub de Genmo pour télécharger les derniers poids du modèle Mochi 1.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...