Comment configurer le Mixtral-8x22B | Démarrer avec des conseils de modélisation de base [traduit]

Le Mixtral 8x22B est désormais disponible. C'est la première fois qu'un modèle de type GPT-4 open source est commercialisé.

Cependant, il ne s'agit pas d'un modèle optimisé pour les commandes, mais d'un modèle de base.

Cela signifie que nous devons donner des repères d'une toute nouvelle manière.

Bien que cela soit plus difficile, ce n'est pas impossible à réaliser.

Un guide concis des conseils de base en matière de modélisation :

Le modèle de base est présenté de la même manière que le modèle de base. ChatGPT Les modèles d'optimisation des commandes sont très différents. Considérez-les comme de super outils d'autocomplétion. Ils ne sont pas conçus pour entretenir un dialogue ; ils sont plutôt formés pour compléter tout texte que vous fournissez.

Cette distinction rend l'incitation plus difficile - et ouvre plus de possibilités !

Par exemple, le modèle de base est beaucoup plus expressif que le ChatGPT que vous connaissez, et vous avez peut-être remarqué que les réponses générées par le ChatGPT sont souvent facilement reconnaissables parce qu'il a été profondément ajusté. En fait, son style et son comportement sont fixes. Il est très difficile de l'amener à innover au-delà du modèle sur lequel il a été entraîné. Mais le modèle sous-jacent recèle d'infinies possibilités qui n'attendent que vous pour être découvertes.

Comment prendre en compte les indices du modèle sous-jacent :

Lorsque vous fournissez des indices au modèle de base, vous ne devez pas trop penser à la manière de décrire au modèle ce que vous voulez qu'il fasse, mais plutôt à lui montrer ce que vous voulez qu'il fasse. Vous devez vraiment entrer dans l'esprit du modèle et réfléchir à sa façon de penser.

Le modèle sous-jacent est essentiellement le reflet de ses données d'apprentissage. Si vous comprenez cela, vous pouvez faire des merveilles.

Par exemple, si vous voulez que le modèle écrive un article de presse intitulé "L'impact de l'intelligence artificielle sur les soins de santé", vous devez vous demander où il a pu rencontrer des articles de presse similaires dans ses données d'apprentissage. Probablement sur un site web d'actualités, n'est-ce pas ?

En gardant cela à l'esprit, vous pouvez construire une invite qui utilise ce concept, en incluant des éléments similaires à ceux que les pages d'articles réelles peuvent contenir. Par exemple :

Home | A la une | Opinion

Le temps de l'intelligence artificielle

--

L'impact de l'intelligence artificielle sur les soins de santé

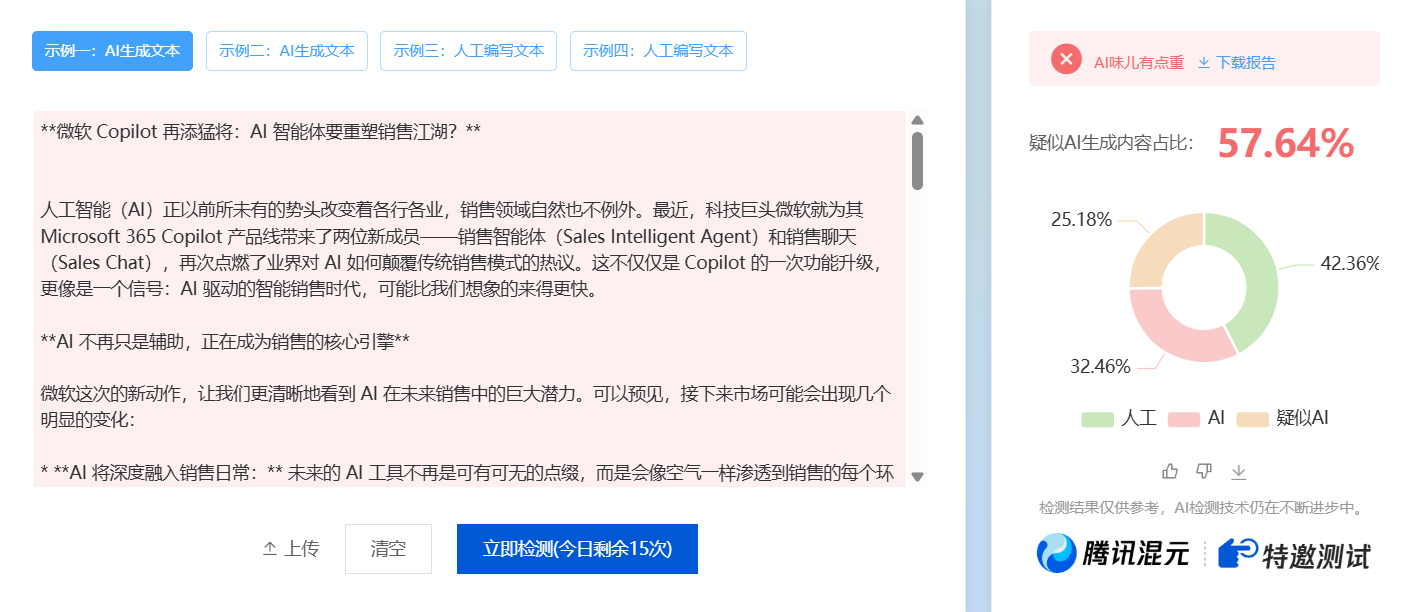

Vous pouvez voir dans la capture d'écran ci-dessous qu'en plaçant le modèle dans une situation similaire à celle qu'il aurait pu voir dans ses données d'apprentissage, il a fini par écrire un article !

![如何设置 Mixtral-8x22B | 基础模型提示入门 [译]-1 如何设置 Mixtral-8x22B | 基础模型提示入门 [译]](https://aisharenet.com/wp-content/uploads/2024/04/fde4404668566a4.png)

Mais cette méthode n'est pas parfaite. La rédaction de l'article n'est pas assez fluide et il n'y a toujours pas de garantie qu'un article sera généré.

Comment améliorer la fiabilité ?

En ajoutant des exemples.

Le modèle de base répond très bien à des messages courts. Ajoutons quelques exemples à l'invite. Pour faire vite, je vais prendre quelques articles sur Internet et les ajouter en haut de l'invite (ne me blâmez pas - il s'agit juste d'une démonstration qui ne sera pas mise en production !) .

![如何设置 Mixtral-8x22B | 基础模型提示入门 [译]-1 如何设置 Mixtral-8x22B | 基础模型提示入门 [译]](https://aisharenet.com/wp-content/uploads/2024/04/035c0c2554e0ca4-1.png)

Comme vous pouvez le constater, avec ces quelques exemples, l'article est considérablement amélioré.

Parlons de l'analyse syntaxique :

L'une des principales difficultés rencontrées lorsque l'on travaille avec des modèles de base est l'analyse de leurs données de sortie. Dans le cas des modèles pédagogiques, vous pouvez simplement leur demander de produire leurs résultats dans un format particulier, par exemple en leur demandant de "répondre en JSON", ce qui est très facile à analyser. Mais pour les modèles de base, ce n'est pas si facile.

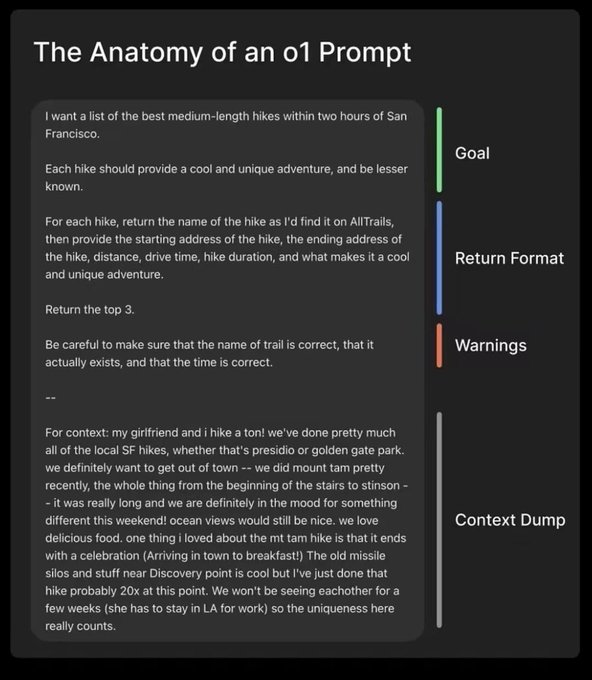

Voici une technique que j'utilise souvent et qui s'appelle le "model leading".

Si vous avez besoin de générer une liste de titres d'articles, vous pouvez presque forcer le modèle à répondre sous forme de liste en ajoutant les deux premiers caractères d'un tableau à la fin de l'invite après avoir décrit vos besoins. Voici un exemple :

![如何设置 Mixtral-8x22B | 基础模型提示入门 [译]-3 如何设置 Mixtral-8x22B | 基础模型提示入门 [译]](https://aisharenet.com/wp-content/uploads/2024/04/f070eddc9fc6b0d.png)

Voyez comment j'ai ajouté '["' à la fin de l'invite. Cette astuce simple vous permet de générer des données analysables à l'aide du modèle sous-jacent.

Méthodes plus avancées :

L'introduction ci-dessus ne présente que quelques méthodes d'application simples du modèle de base. Il existe de nombreuses techniques plus efficaces qui peuvent nous aider à obtenir de meilleurs résultats.

Par exemple, une façon de procéder est de faire croire au modèle qu'il est un interpréteur Python.

Cela peut ne pas sembler intuitif, mais cela fonctionne très bien dans la pratique.

Par exemple, vous pouvez essayer de rédiger une invite qui raccourcit le texte. Voir l'invite dans la capture d'écran, qui est une application pratique de la méthode.

![如何设置 Mixtral-8x22B | 基础模型提示入门 [译]-4 如何设置 Mixtral-8x22B | 基础模型提示入门 [译]](https://aisharenet.com/wp-content/uploads/2024/04/36cb1ab19c57b95.png)

Comme vous pouvez le voir, nous créons une invite qui simule l'interpréteur Python et nous demandons au modèle de simuler la sortie de l'interpréteur. Puisque la fonction que nous appelons consiste à raccourcir le texte, le modèle donne une version courte du texte !

Comme vous pouvez le constater, l'utilisation du modèle de base pour l'incitation est très différente de celle du modèle de chat ou de guide. J'espère que ces informations seront utiles à tous ceux qui utilisent le Mixtral 8x22B !

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...