MiniMax Première source ouverte MiniMax-01, 4M contexte super long, nouvelle architecture, défi Transformer

"MoE" plus "introduction à grande échelle sans précédent dans des environnements de production". foudre Attention", plus "refonte du logiciel et de l'ingénierie du niveau du framework au niveau CUDA", qu'est-ce que vous obtenez ?

La réponse est un nouveau modèle qui associe les capacités des modèles les plus performants et qui augmente la longueur du contexte pour atteindre le niveau de 4 millions de jetons.

Le 15 janvier, la société de macromodélisation MiniMax a officiellement lancé la nouvelle série de modèles tant attendue : MiniMax-01, qui se compose du macromodèle linguistique de base MiniMax-Text-01 et du macromodèle visuel multimodal MiniMax-VL-01, développé par l'intégration d'un modèle ViT léger.

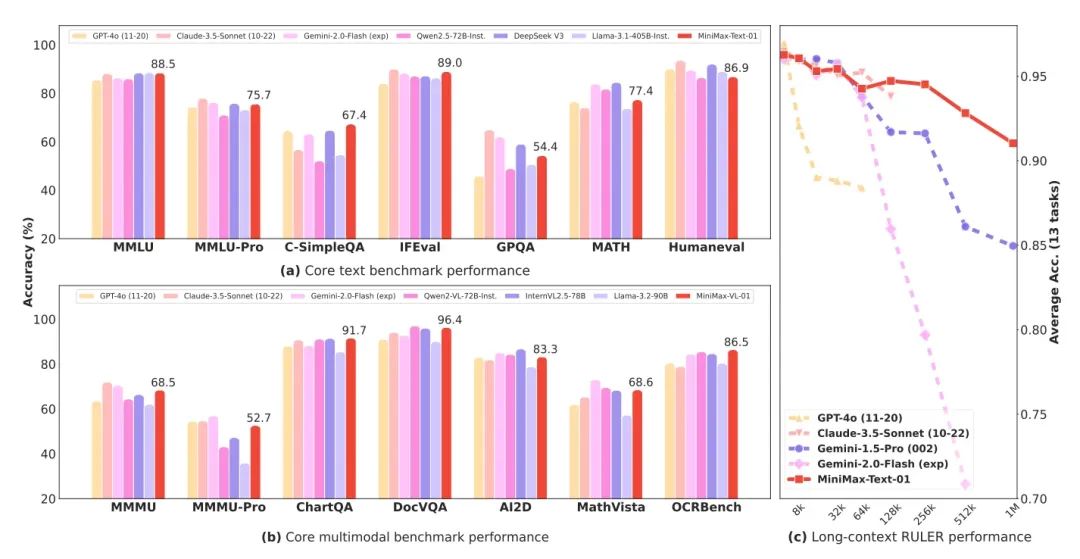

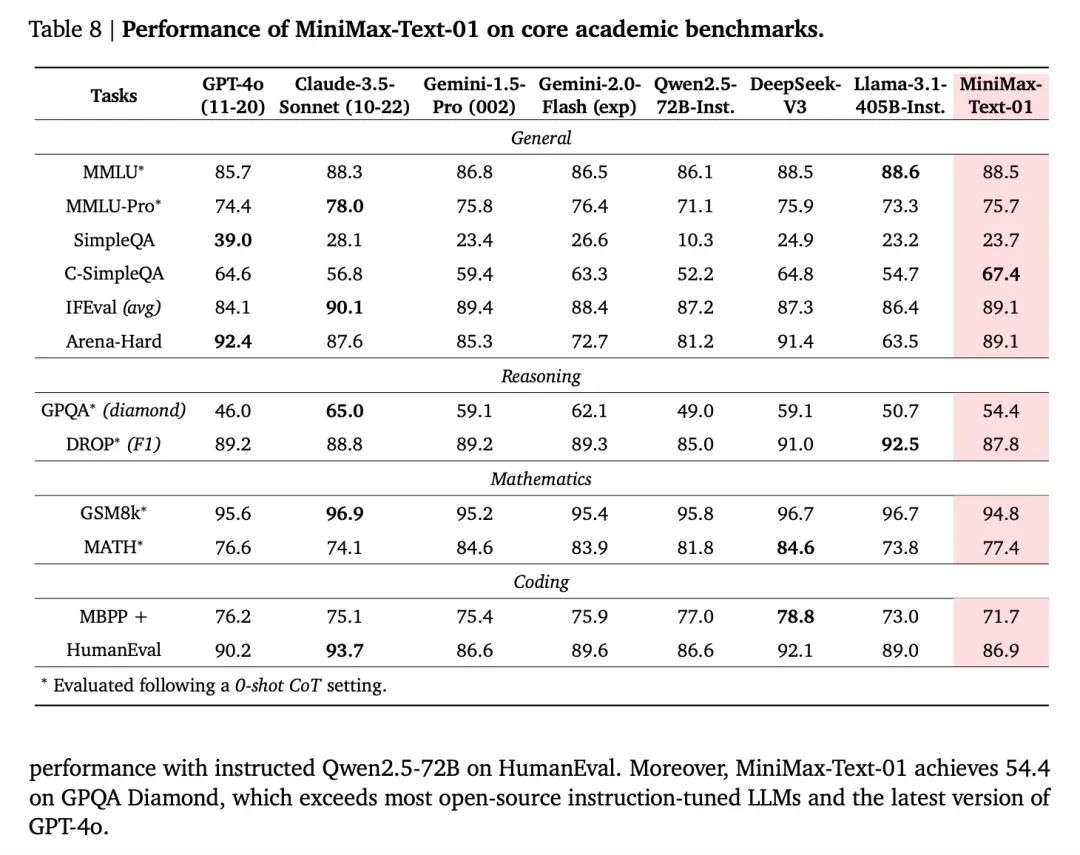

MiniMax-01 est un modèle MoE (Mixed Expert) avec 456 milliards de paramètres totaux et 32 experts, qui est au même niveau que GPT-4o et Claude 3.5 sonnet en termes de puissance combinée sur plusieurs ensembles d'examens courants, tout en ayant 20 à 32 fois la longueur de contexte des meilleurs modèles actuels, et avec des longueurs d'entrée plus importantes, c'est aussi le modèle avec la plus longue décroissance de performance. est le modèle dont la dégradation des performances est la plus lente. Il s'agit d'un véritable contexte de 4 millions de jetons.

- Macromodèle de langage de base MiniMax-Text-01, macromodèle visuel multimodal MiniMax-VL-01

- La nouvelle architecture d'attention de Lightning, Square to Linear, réduit considérablement les coûts d'inférence.

- Source ouverte importante, paramètres du modèle de texte jusqu'à 456 milliards, 32 experts

- Contexte ultra-long de 4 millions de mots et performances comparables à celles des meilleurs modèles étrangers

- Le modèle, le code et le rapport technique ont tous été publiés, très sincèrement !

L'expérience web et l'API sont désormais disponibles en ligne et dans le commerce à l'adresse indiquée à la fin de l'article.

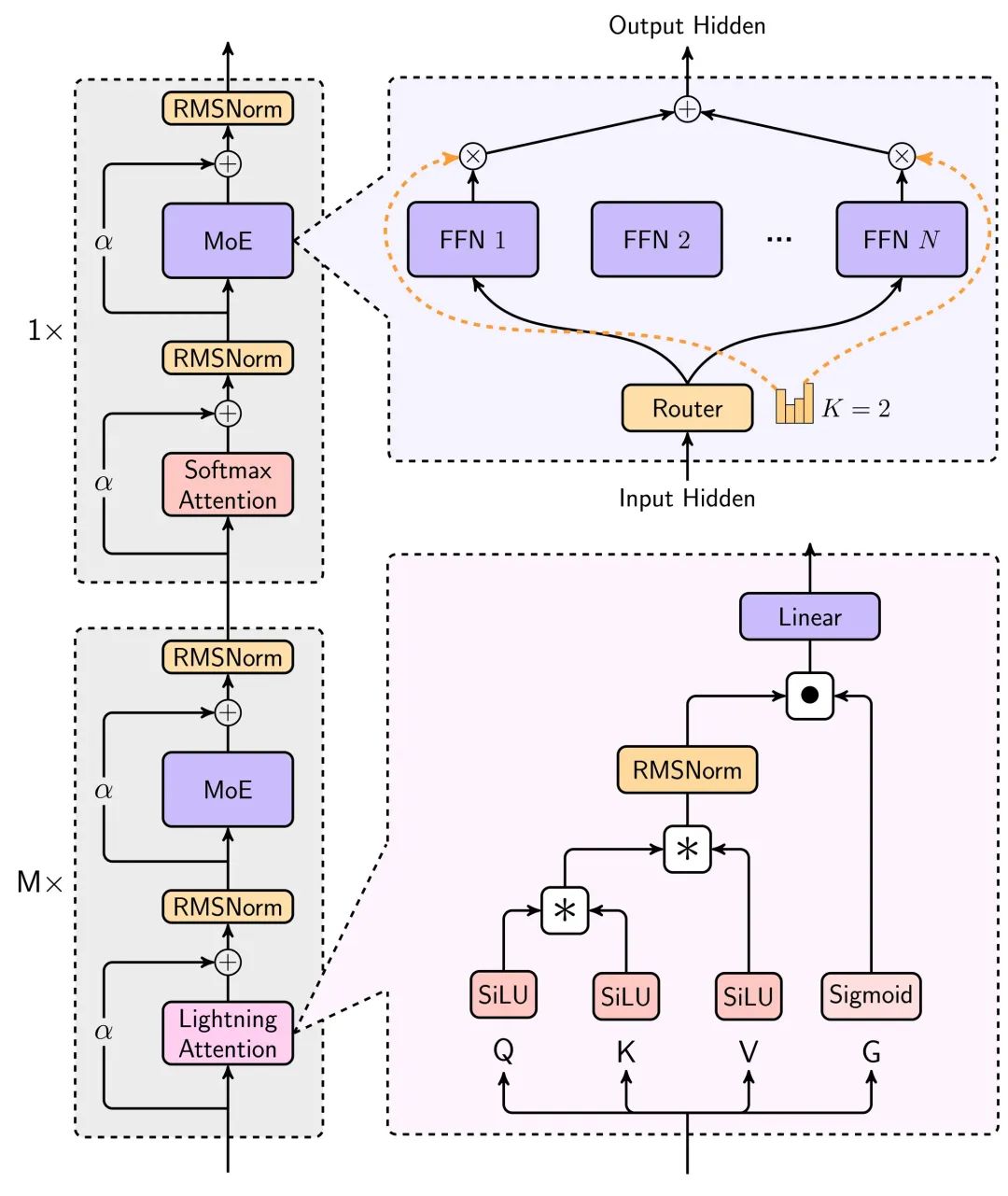

Nouvelle technologie : attention aux éclairs

L'élément le plus surprenant de ce modèle est la nouvelle architecture d'attention linéaire.

Nous savons tous que dans l'utilisation réelle de l'IA, le texte long est crucial, la mémoire longue du chat de caractères, le codage de l'IA pour écrire du code, l'agent pour accomplir une variété de tâches, ce scénario est inséparable du texte long.

Le prix des grands modèles a baissé, mais plus le contexte dans lequel ils sont utilisés est long, plus ils sont lents et chers.

La racine de ce problème est Transformateur L'architecture a une complexité informatique quadratique. La consommation arithmétique du raisonnement augmente de manière exponentielle à mesure que le contexte augmente.

Cette fois, le nouveau modèle de MiniMax utilise le mécanisme d'attention Lightning, un mécanisme d'attention linéaire qui permet de réduire considérablement le temps de calcul et d'inférence pour les textes longs.

Les principaux diagrammes architecturaux de cette modélisation sont présentés dans le rapport technique.

La réduction de la consommation de ressources pour l'inférence du modèle grâce à cette architecture est énorme, comme le montre le graphique suivant qui compare les temps d'inférence pour un texte long, où l'attention linéaire est utilisée pour permettre aux temps d'inférence d'augmenter lentement de manière quasi linéaire, plutôt que de manière exponentielle, au fur et à mesure que le contexte s'accroît.

Une description plus détaillée peut être trouvée dans le rapport technique à la fin de l'article.

Le calcul est réduit, le prix diminue et les performances ne peuvent pas être perdues trop longtemps pour que le texte soit vraiment utilisable.

Le graphique ci-dessous montre les performances de Text-1 sur l'ensemble d'évaluation des textes très longs, où il surpasse de manière surprenante l'intervalle de longueur de 512K+. Gémeaux 2.0 Flash.

Un autre point très intéressant du rapport technique est que la capacité d'apprentissage en contexte du modèle, qui augmente progressivement au fur et à mesure que le contexte s'améliore, peut être d'une grande aide pour l'écriture d'IA ainsi que pour les tâches qui nécessitent de longues mémoires.

Dans l'ensemble, l'application du mécanisme d'attention Lightning permet d'augmenter considérablement la facilité d'utilisation des textes longs pour les grands modèles, et le prix a une chance de chuter d'un autre ordre de grandeur, à l'avenir, cela vaut vraiment la peine d'attendre.

Modèle de performance, nivellement de la première ligne

En ce qui concerne les mesures de performance du modèle, en tant que modèle à source ouverte, il rattrape les meilleurs modèles à source fermée d'outre-mer dans de nombreuses mesures.

Et comme le modèle bénéficie du retour d'information de la plateforme Conch pour l'optimisation et l'itération, l'expérience de l'utilisateur dans des scénarios réels est également garantie.

L'utilisation officielle de scénarios d'utilisation réels par les utilisateurs pour constituer un ensemble de tests permet de constater que les performances dans les scénarios réels sont également très bonnes, les scénarios les plus importants étant les trois suivants : rédaction créative, quiz de connaissances, texte long.

En outre, les performances du modèle de compréhension visuelle MiniMax-VL-01 égalent ou dépassent dans tous les domaines les meilleurs modèles étrangers, en particulier les scènes pratiques d'OCR et de graphiques.

Moment transformateur suivant

Lorsque les itérations générationnelles des modèles ne sont plus féroces, la longueur du contexte et le raisonnement logique deviennent les deux directions les plus ciblées.

En termes de contexte, Gemini a déjà été le plus long. En outre, Demsi Hassabis, PDG de DeepMind, a également révélé qu'au sein de Google, le modèle Gemini a déjà atteint 10 millions de longueurs de jetons lors d'expériences et que l'on pense qu'il finira par "atteindre des longueurs infinies", mais ce qui empêche Gemini de le faire maintenant, c'est son coût correspondant. Mais ce qui empêche Gemini de le faire maintenant, c'est son coût. Lors d'une récente interview, il a déclaré que Deepmind disposait désormais d'une nouvelle approche pour résoudre ce problème de coût.

Ainsi, celui qui parviendra le premier à augmenter la longueur du contexte tout en réduisant le coût aura probablement l'avantage. À en juger par les résultats obtenus par MiniMax-01, celui-ci a réellement gagné en efficacité sur le plan qualitatif.

Dans ce rapport technique exhaustif, l'efficacité de l'utilisation du matériel peut être constatée par une statistique - l'inférence, MiniMax atteint 75% MFUs sur les GPUs H20. c'est un chiffre assez élevé.

MFU (Machine FLOPs Utilization) fait référence à l'utilisation réelle de la puissance de calcul du matériel (FLOPs, c'est-à-dire opérations en virgule flottante par seconde) par un modèle pendant son fonctionnement. En bref, MFU indique si un modèle exploite pleinement les performances du matériel. Un taux d'utilisation élevé se traduira certainement par des avantages en termes de coûts.

Le MiniMax 01 est certainement l'une des rares surprises dans le récent débat "mur à mur".Comme indiqué plus haut, Deepseek V3 et MiniMax-01 représentent chacun deux orientations importantes aujourd'hui, l'une dans le domaine de l'inférence et l'autre dans des contextes plus longs.

Il est intéressant de noter qu'en termes d'itinéraire technique, les deux optimisent dans une certaine mesure le mécanisme d'attention central de Transformer qui a jeté les bases du boom actuel, et il s'agit d'un remaniement audacieux, matériel et logiciel à la fois. deepSeek V3 a été décrit comme tirant les cartes de Nvidia à sec, et il est crucial pour la capacité de MiniMax d'atteindre une UFM d'inférence aussi élevée qu'ils le font également, c'est-à-dire qu'ils optimisent le cadre de formation et le matériel directement. Ils optimisent directement le cadre d'entraînement et le matériel.

Selon le rapport de MiniMax, l'entreprise a développé un noyau CUDA pour la capacité d'attention linéaire directement à partir de zéro, étape par étape et en profondeur, et a développé divers cadres d'accompagnement à cette fin pour optimiser l'utilisation efficace des ressources GPU. Les deux entreprises ont atteint leurs objectifs grâce à une intégration plus étroite des capacités matérielles et logicielles.

Une autre observation intéressante est que ces deux entreprises exceptionnelles sont toutes deux des entreprises qui ont déjà investi dans la recherche et le développement de la technologie des grands modèles avant l'émergence de ChatGPT, et la chose étonnante à propos de ces deux modèles n'est pas le mode "rattraper GPT4" que nous avons l'habitude de voir dans le passé, mais plutôt, selon leur propre jugement sur l'évolution de la technologie, ils ont fait de gros investissements et même quelques paris sur l'innovation, et ont livré la réponse après une série de travaux solides et soutenus. Au contraire, selon leur propre jugement sur l'évolution de la technologie, ils ont fait de gros investissements et même quelques paris sur l'innovation, et ont apporté la réponse après une série de travaux soutenus et solides.

Elles tentent toutes de prouver qu'un concept qui était autrefois bloqué dans un laboratoire peut avoir l'effet qu'il promet lorsqu'il est déployé à grande échelle dans des scénarios réels et, ce faisant, permettre à un plus grand nombre de personnes de continuer à l'optimiser.

Cela rappelle l'arrivée de Transformer.

Lorsque le mécanisme d'attention est également devenu viral en laboratoire, mais que la controverse faisait toujours rage, c'est Google, qui croyait en son potentiel, qui a vraiment mis l'arithmétique et les ressources nécessaires pour le faire passer d'une expérience théorique à une réalité mise en œuvre dans le cadre d'un déploiement à grande échelle. Ensuite, les gens se sont rués sur la voie éprouvée qui mène à la prospérité d'aujourd'hui.

Avec Transformer qui empile de plus en plus de couches et consomme de plus en plus d'énergie, et le MiniMax-01 d'aujourd'hui qui tente de remettre en cause le vieux mécanisme de l'attention, il y a comme un air de déjà-vu. Même le célèbre titre de l'article "Attention is all you need", donné par un chercheur de Google pour souligner le mécanisme de l'attention, est parfait pour MiniMax : linear attention is all you need - - - - - - - - - - - - - - - - - - - Attention is all you need". -L'attention est tout ce dont vous avez besoin.

"Le modèle conserve actuellement 1/8e de l'attention softmax normale. Nous travaillons sur des architectures plus efficaces qui, à terme, supprimeront entièrement l'attention softmax, ce qui permettra d'obtenir des fenêtres contextuelles illimitées sans surcharge de calcul."

Prix du modèle

Entrée : 1 million de dollars jeton

Résultat : 8 $/million de jetons

En principe, il faut l'utiliser les yeux fermés.

Ressources de modélisation

Code :https://github.com/MiniMax-AI/MiniMax-01

Modèles :https://huggingface.co/MiniMaxAI/MiniMax-Text-01, https://huggingface.co/MiniMaxAI/MiniMax-VL-01

Rapport technique :https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

Côté web :https://hailuo.ai

API. https://www.minimaxi.com/

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Postes connexes

Pas de commentaires...