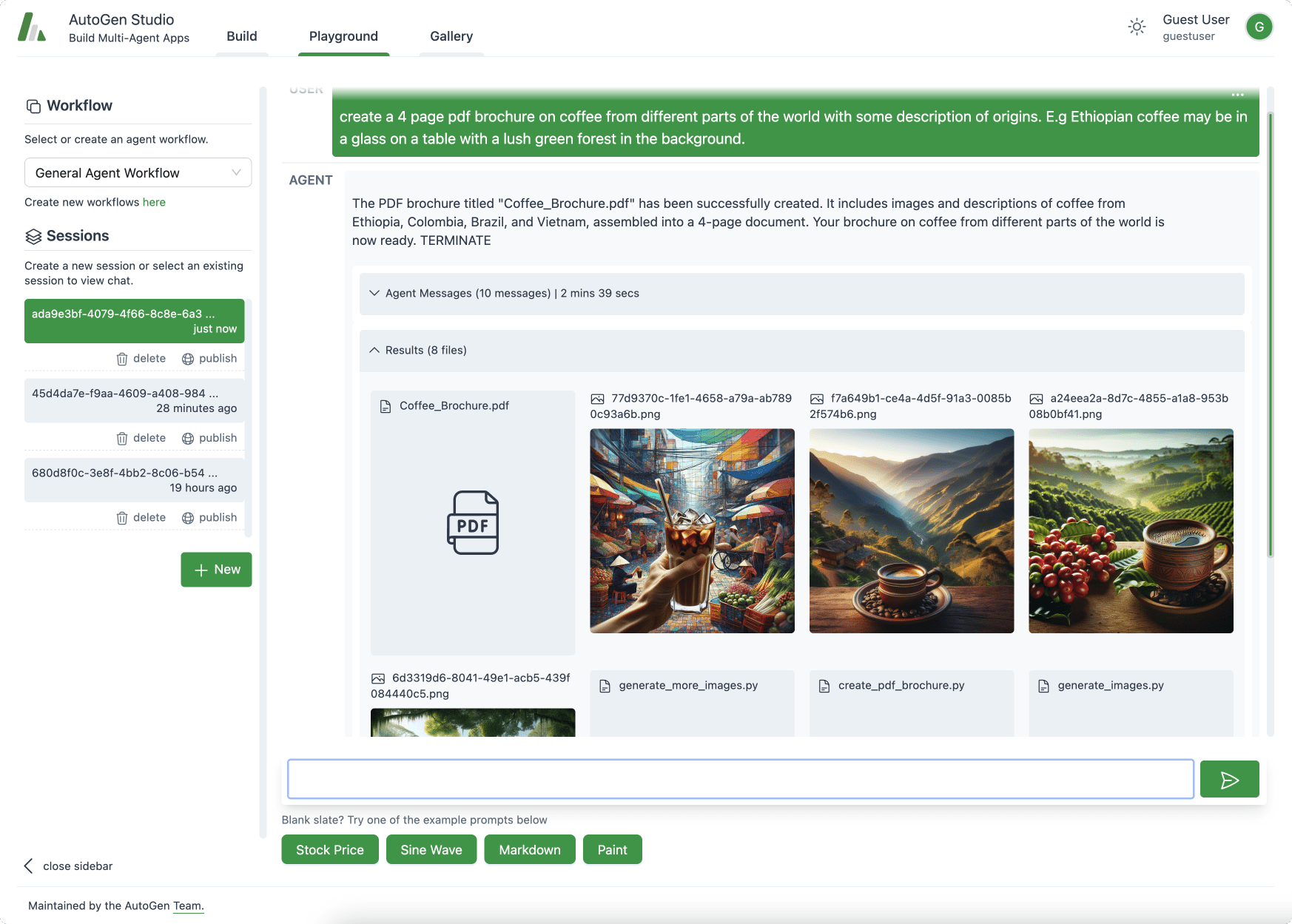

Ingénierie des indices pour les modèles d'inférence OpenAI O1 et O3-mini

Introduction : O1 d'OpenAI et O3-mini sont des modèles de "raisonnement" avancés qui diffèrent du GPT-4 de base (communément appelé GPT-4o) dans la manière dont ils traitent les invites et génèrent des réponses. Ces modèles sont conçus pour passer plus de temps à "réfléchir" à des problèmes complexes, imitant ainsi l'analyse humaine.

Ce document présente un examen approfondi de l'approche de l'OpenAI en matière de gestion de l'information. O1 répondre en chantant O3-mini Techniques d'ingénierie de Prompt pour les modèles de raisonnement. Cependant, les connaissances sur la structure des entrées, les capacités de raisonnement, les caractéristiques des réponses et les meilleures pratiques de Prompt présentées dans le document, l'étude de faisabilité de Prompt et l'étude de faisabilité de Prompt ne sont pas suffisantes pour répondre à ces questions. Pas limité aux modèles OpenAI . Avec l'essor des techniques de modélisation de l'inférence, il y a eu un afflux d'articles tels que Profondeur de l'eau-R1 et de nombreux autres modèles dotés de capacités de raisonnement supérieures. Les principes et les techniques de base présentés dans ce document peuvent également servir de référence précieuse pour aider les lecteurs à utiliser l'outil d'évaluation de la qualité de l'eau. Profondeur de l'eau-R1 et d'autres modèles d'inférence similaires en maximisant leur potentiel. Par conséquent, après avoir obtenu un aperçu des modèles O1 et O3-mini Ingénierie rapideLes détails sont accompagnés d'une invitation aux lecteurs à réfléchir à la manière dont ces leçons peuvent être intégrées et appliquées au domaine plus large de la modélisation de l'inférence afin de débloquer des capacités d'application de l'IA plus puissantes.

Différence entre O1/O3-mini et GPT-4o

Structure de l'entrée et traitement du contexte

- Raisonnement intégré et raisonnement guidé par des indices : Les modèles de la série O1 ontCompétences intégrées en matière de raisonnement en chaîne de penséeCela signifie qu'ils raisonnent de manière interne, sans être guidés par des mots-indices. En revanche, le GPT-4o a généralement besoin d'instructions externes telles que "réfléchissons étape par étape" pour le guider dans la résolution de problèmes complexes, car il n'effectue pas automatiquement le même niveau de raisonnement en plusieurs étapes. Avec O1/O3-mini, vous pouvez simplement poser la question ; le modèle l'analysera en profondeur de lui-même.

- Le besoin d'informations externes : Le GPT-4o dispose d'une base de connaissances étendue et d'un accès aux outils (par exemple, navigation, plug-ins, vision) dans certains déploiements, ce qui l'aide à traiter une variété de sujets. En revanche, le modèle O1 ne fait pas partie de l'objectif de formation de l'équipe d'experts.Base de connaissances plus étroite. Cela signifie que lors de l'utilisation de l'O1/O3-mini, si la tâche dépasse le sens commun, l'O1/O3-mini peut être utilisé comme un outil de travail.Des informations contextuelles importantes doivent être incluses dans les messages-guides.--Ne partez pas du principe que le modèle connaît des faits de niche. gpt-4o peut déjà connaître un précédent juridique ou un détail obscur, alors que O1 peut avoir besoin que vous lui fournissiez ce texte ou ces données.Exemple de conseil :

- GPT-4o : "Une analyse de la récente décision de la Cour suprême des États-Unis sur le droit à l'avortement. (GPT-4o peut déjà avoir des connaissances)

- O1 : "Analyser l'impact de l'arrêt sur le droit à l'avortement sur la société américaine à la lumière des informations de base suivantes : [coller des résumés de rapports d'actualité et de documents juridiques pertinents]. (O1 peut avoir besoin d'informations plus détaillées)

- Longueur du contexte : Le modèle d'inférence dispose d'une très grande fenêtre contextuelle. O1 prend en charge jusqu'à 128k jetons en entrée et O3-mini accepte jusqu'à 200k jetons (jusqu'à 100k jetons en sortie), ce qui dépasse la longueur de contexte de GPT-4o. Cela vous permet d'alimenter directement O1/O3 avec des fichiers de cas ou des ensembles de données volumineux.Organisation claire des grandes entrées pour les projets d'incitation(GPT-4o et O1 peuvent tous deux traiter de longues invites, mais la capacité supérieure de O1/O3 signifie que vous pouvez inclure un contexte plus détaillé dans une seule entrée, ce qui est très utile dans les analyses complexes.Exemple de conseil :

- "Résumez les points essentiels de l'affaire et le jugement final du tribunal sur la base de ce long document juridique collé ci-dessous. (O1/O3-mini peut traiter efficacement une entrée aussi longue)

Capacité de raisonnement et de déduction logique

- Profondeur du raisonnement : O1 et O3-mini pourRaisonnement systématique, en plusieurs étapesOptimisé. Ils "réfléchissent plus longtemps" avant de répondre, ce qui permet d'obtenir des solutions plus précises pour les tâches complexes. Par exemple, O1-preview a résolu 831 TP3T lors d'un examen de mathématiques difficile (AIME), tandis que GPT-4o a obtenu un taux de résolution de 131 TP3T, ce qui prouve sa supériorité en matière de déduction logique dans le monde professionnel. Le GPT-4o est également puissant mais tend à être plus direct dans la génération des réponses ; sans incitations explicites, il peut ne pas effectuer d'analyses exhaustives, ce qui peut conduire à des erreurs dans des situations très complexes qui peuvent être capturées par O1.

- Traitement des tâches complexes par rapport aux tâches simples : Puisque la famille de modèles O1 utilise par défaut l'inférence profonde, ils sont performants sur des problèmes complexes avec de nombreuses étapes d'inférence (par exemple, des analyses à multiples facettes, de longues preuves). En fait, dans les tâches nécessitant cinq étapes d'inférence ou plus, les modèles d'inférence tels que O1-mini ou O3 surpassent GPT-4 de plus de 161 TP3T en termes de précision. Cependant, cela signifie également quePour les requêtes très simples, O1 peut "trop réfléchir". Il a été constaté que dans les tâches simples (moins de 3 étapes de raisonnement), les processus analytiques supplémentaires de O1 peuvent être un désavantage - dans de nombreux cas, il n'a pas obtenu d'aussi bons résultats que GPT-4 en raison d'un raisonnement excessif. GPT-4o peut répondre à une question simple de manière plus directe et plus rapide, alors que O1 peut générer des analyses inutiles. inutiles. La différence essentielle réside dans le fait que O1 est calibré pour la complexitéIl peut donc s'avérer moins efficace dans le cas de questions triviales.Exemple de conseil :

- Tâches complexes (adaptées à O1) : "Analyser et résumer les impacts à long terme du changement climatique sur l'économie mondiale, y compris les risques et les opportunités potentiels pour les différentes industries, le marché de l'emploi et le commerce international".

- Tâches simples (adaptées au GPT-4o) : "Quel temps fait-il aujourd'hui ?"

- Style de déduction logique : Lorsqu'il s'agit d'énigmes, de raisonnement déductif ou de problèmes à résoudre étape par étape, le GPT-4o a généralement besoin de donner des indications sur les travaux à réaliser (sinon, il risque de sauter à la réponse). Pour l'utilisateur, cela signifie que les O1Les réponses finales sont souvent bien argumentées et moins sujettes à des lacunes logiques.Il complète en fait la "chaîne de pensée" en interne pour en vérifier la cohérence. Il complète en fait la "chaîne de pensée" interne pour vérifier à nouveau la cohérence. Du point de vue des repères, vous devez généralementIl n'est pas nécessaire de demander à O1 d'expliquer ou de vérifier sa logique.--Il le fait automatiquement avant de présenter la réponse. Pour le GPT-4o, vous pourriez inclure des instructions telles que "énumérer d'abord les hypothèses, puis tirer des conclusions" pour garantir la rigueur logique ; pour O1, de telles instructions sont souvent redondantes, voire contre-productives.Exemple de conseil :

- GPT-4o : "Résolvez cette énigme logique : [contenu de l'énigme]. Montrez votre solution étape par étape et expliquez le raisonnement qui sous-tend chaque étape."

- O1 : "Résolvez cette énigme logique : [contenu de l'énigme]." (O1 raisonnera automatiquement de manière logique et donnera une réponse bien argumentée)

Caractérisation de la réponse et optimisation du rendement

- Détails et redondance : En raison de leur raisonnement approfondi, O1 et O3-mini sont généralement générés pour des requêtes complexes.Réponses détaillées et structurées. Par exemple, O1 peut décomposer la solution mathématique en plusieurs étapes ou justifier chaque partie du plan stratégique. D'autre part, GPT-4o peut donner par défaut des réponses plus concises ou des résumés de haut niveau, à moins d'être invité à fournir une description détaillée. En termes d'ingénierie de l'invite, cela signifieLes réponses à O1 peuvent être plus longues ou plus techniques. Les directives permettent de mieux contrôler cette redondance. Si vous voulez que O1 soit concis, vous devez le lui dire explicitement (comme vous l'avez fait avec GPT-4) - sinon, il pourrait avoir tendance à être exhaustif. Inversement, si vous voulez que la sortie soitexpliquer étape par étapeIl se peut qu'il faille demander au GPT-4o d'en inclure un, tandis que O1 sera heureux de le fournir si on le lui demande (et il se peut qu'il ait fait le raisonnement en interne de toute façon).Exemple de conseil :

- Demande d'explication détaillée (GPT-4o) : "Expliquer en détail le fonctionnement du modèle de transformateur, y compris les rôles spécifiques de chaque composant, et utiliser la terminologie technique dans la mesure du possible.

- Des réponses succinctes sont requises (O1) : "Résumez l'idée centrale du modèle Transformer en trois phrases".

- Précision et autocontrôle : Le modèle d'inférence présente uneAutocontrôle des faitsOpenAI note que O1 est plus apte à repérer ses propres erreurs lors de la génération des réponses, ce qui améliore l'exactitude des faits dans les réponses complexes. GPT-4o est généralement précis, mais sans guide, il peut occasionnellement se tromper en toute confiance ou halluciner. L'architecture d'O1 réduit ce risque en validant les détails tout en "pensant". En fait, les utilisateurs ont observé que O1 produit moins de réponses incorrectes ou dénuées de sens à des questions délicates, alors que GPT-4o peut nécessiter des techniques de repérage (par exemple, lui demander de critiquer ou de valider ses réponses) pour atteindre le même niveau de confiance. Cela signifie que vous pouvez généralement faire confiance à O1/O3-mini pour répondre correctement à des questions complexes en l'invitant directement à le faire, alors qu'avec GPT-4, vous devrez peut-être ajouter des instructions telles que "vérifiez que votre réponse est cohérente avec les faits ci-dessus". Néanmoins, aucun modèle n'étant absolument fiable, les résultats factuels clés doivent toujours être vérifiés.Exemple de conseil :

- GPT-4o (accent mis sur la précision) : "Analysez les chiffres de ce rapport financier et calculez la marge bénéficiaire nette de l'entreprise. Veillez à revérifier les chiffres pour vous assurer que les calculs sont exacts."

- O1 (confiance par défaut) : "Analysez les données de ce rapport financier et calculez la marge bénéficiaire nette de l'entreprise.

- Rapidité et coût : Une différence notable est que le modèle O1 est plus lent et plus coûteux pour un raisonnement plus approfondi.O1 Pro inclut même une barre de progression pour les longues requêtes.GPT-4o a tendance à être plus réactif pour les requêtes typiques.O3-mini a été introduit pour fournir un service d'aide à la décision.Des modèles de raisonnement plus rapides et plus rentables--Il est beaucoup moins cher par jeton que O1 ou GPT-4o et a une latence plus faible. Cependant, O3-mini est un modèle plus petit, et bien qu'il soit puissant pour le raisonnement STEM, il peut ne pas être en mesure d'égaler O1 ou GPT-4 pour les connaissances générales ou le raisonnement extrêmement complexe. Afin de fournir le meilleurréactivitéLorsque l'on fait de l'ingénierie d'invite, il faut trouver un équilibre entre la profondeur et la rapidité : O1 peut prendre plus de temps pour répondre de manière exhaustive. Si la latence est un problème et que la tâche n'est pas d'une complexité maximale, O3-mini (ou même GPT-4o) peut être un meilleur choix. problèmes vraiment difficiles. En bref, utilisez le bon outil pour le travail - si vous utilisez O1, attendez-vous à des temps de réponse plus longs et prévoyez une sortie plus lente (éventuellement en avertissant l'utilisateur ou en ajustant le délai d'attente du système).Exemple de conseil :

- Priorité à la vitesse (adaptée à GPT-4o ou O3-mini) : "Résumez rapidement les principaux points de cet article, le plus vite sera le mieux".

- Priorité à la profondeur (adaptée à O1) :"Analyser en profondeur la logique et les preuves de l'argumentation de cet article et évaluer la crédibilité de ses arguments".

Conseils pour maximiser les performances techniques

L'utilisation efficace de O1 et O3-mini nécessite une approche légèrement différente de celle de GPT-4o. Voici les principales techniques d'ingénierie de repérage et les meilleures pratiques pour obtenir des résultats optimaux à partir de ces modèles d'inférence :

Les conseils doivent être clairs et réduits au minimum

Formulez votre demande de manière succincte et claire. Parce que O1 et O3 effectuent un raisonnement interne intensif, ils ne sont pas intéressés par des questions ciblées ou des instructions sans texte étranger.L'openAI et des recherches récentes suggèrent qu'il faut éviter d'utiliser des indices trop complexes ou trop réduits pour ces modèles. En pratique, cela signifie que vous devriezÉnoncer clairement le problème ou la tâche et ne fournir que les détails nécessaires.Il n'est pas nécessaire d'ajouter des "modificateurs" ou de reformuler la demande plusieurs fois. Il n'est pas nécessaire d'ajouter des "modificateurs" ou de reformuler la question plusieurs fois. Par exemple, au lieu d'écrire : "Dans cette énigme difficile, je veux que vous réfléchissiez soigneusement à chaque étape pour parvenir à la bonne solution. Décomposons-la étape par étape ......", il serait préférable de demander simplement : "Résolvez l'énigme suivante [y compris les détails de l'énigme]. Expliquez votre raisonnement." Le modèle pensera naturellement de manière interne, étape par étape, et donnera une explication. Trop d'instructions peuvent en fait rendre les choses plus difficiles.compliquer-Une étude a montré que l'ajout d'un trop grand nombre d'indices ou d'exemples peutRéduction des performances de O1qui dépasse essentiellement son processus de raisonnement.Conseil : Pour les tâches complexes, commencez par un échantillon d'indices nul (description de la tâche uniquement) et n'ajoutez des instructions que lorsque vous constatez que le résultat ne répond pas à vos besoins. Souvent, la minimisation des indices produit les meilleurs résultats pour ces modèles d'inférence.

Exemple de conseil :

- Conseils simples (O1/O3-mini) : "Analysez ce rapport d'étude de marché pour identifier les trois tendances les plus importantes du marché.

- Conseil de redondance (non recommandé) : "J'ai ici un rapport d'étude de marché très important, avec beaucoup de contenu et d'informations, et j'aimerais que vous le lisiez attentivement, que vous y réfléchissiez profondément et que vous l'analysiez. Le mieux serait d'énumérer les trois tendances les plus importantes et d'expliquer pourquoi vous pensez qu'elles sont les plus importantes".

Éviter les exemples inutilement petits

Les travaux traditionnels de repérage GPT-3/4 utilisent généralement moins d'exemples ou de démonstrations pour guider le modèle. La série O1 est spécifiquement entraînée à ne pas inclure de repères avec un grand nombre d'exemples. En fait, l'utilisation de plusieurs exemplessaperPerformance. La recherche sur O1-preview et O1-mini suggère que les indices avec moins d'échantillons dégradent systématiquement leurs performances - même des exemples bien choisis peuvent les rendre pires que de simples indices dans de nombreux cas. Le raisonnement interne semble être distrait ou limité par les exemples. Les lignes directrices de l'OpenAI vont dans le même sens : elles recommandent de limiter le modèle d'inférence à d'autres contextes ou exemples afin d'éviter de confondre sa logique interne. Meilleure pratique : n'utilisez aucun exemple ou au plus un exemple absolument nécessaire. Si vous incluez un exemple, faites en sorte qu'il soit très pertinent et simple. Par exemple, dans les questions d'analyse juridique, vous devez généralementne sera pas (n'agira pas, n'arrivera pas, etc.)Ajoutez l'étude de cas complète à l'avance ; au lieu de cela, demandez directement le nouveau cas. Le seul cas où vous pouvez utiliser une démonstration est celui où le format de la tâche est très spécifique et où le modèle ne suit pas les instructions - montrez alors un court exemple du format souhaité. Sinon, faites confiance au modèle pour trouver la solution à partir de la question directe.

Exemple de conseil :

- Zéro pointes d'échantillon (optimal) : "Sur la base des informations suivantes du dossier médical, diagnostiquez une maladie dont le patient pourrait être atteint. [coller les informations sur les antécédents médicaux]"

- Moins de pointes d'échantillonnage (non recommandé) : "Voici quelques exemples de diagnostics de maladies : [Exemple 1], [Exemple 2] Maintenant, veuillez diagnostiquer une maladie dont le patient pourrait être atteint en vous basant sur les informations suivantes du dossier médical. (pour O1/O3-mini, les questions à zéro échantillon sont généralement plus efficaces)

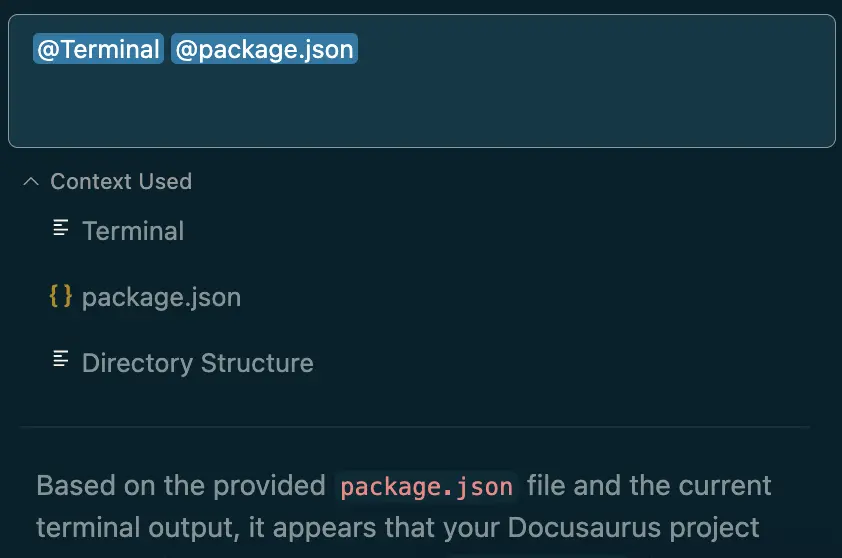

Définition des rôles et des formats à l'aide des commandes système/développeur

explicitecontexte de commandeAide à guider la réponse du modèle. Utilisez les API (ou les messages système dans les dialogues) pour définir succinctement le rôle ou le style du modèle. Par exemple, un message système pourrait être : "Vous êtes un chercheur scientifique professionnel spécialisé dans l'explication de solutions étape par étape". O1 et O3-mini réagissent bien à ces directives sur le rôle et les intègrent dans leur raisonnement. Cependant, gardez à l'esprit qu'ils sont déjà capables de comprendre des tâches complexes, et que vos instructions doivent donc se concentrer sur les points suivantsLe type de sortie que vous souhaitez** au lieu de l'optionComment penser. Les bonnes utilisations des directives du système/développeur comprennent:**

- Définir l'étendue de la tâche ou du rôle : Par exemple, "agir comme un analyste juridique" ou "résoudre des problèmes comme un professeur de mathématiques l'explique à un élève". Cela influe sur le ton et le niveau de détail.

- Spécifie le format de sortie : Si vous avez besoin d'une réponse sous une forme structurée (liste à puces, tableau, JSON, etc.), veuillez le spécifier explicitement. O1, et surtout O3-mini, prennent en charge les modes de sortie structurés et se conformeront aux demandes de formatage. Par exemple, "Fournissez vos conclusions sous la forme d'une liste de puces clés". Étant donné leur nature logique, ils ont tendance à suivre exactement les instructions de formatage, ce qui contribue à la cohérence des réponses.

- Fixer les limites : Si vous souhaitez contrôler la redondance ou la focalisation, vous pouvez inclure des éléments tels que "fournir de brèves conclusions après des analyses détaillées" ou "n'utiliser que les informations fournies et ne faire aucune hypothèse extérieure". Les modèles de raisonnement respecteront ces limites et pourront être empêchés de s'écarter du sujet ou de créer des illusions. Ceci est important car O1 peut produire des analyses très détaillées - ce qui est généralement bien, mais pas si vous avez explicitement besoin d'un résumé.

Veillez à inclure à chaque fois les conseils relatifs au ton, à la caractérisation et à la mise en forme.

Exemple d'invite (message système) :

- Message du système : "Vous êtes un conseiller juridique expérimenté, spécialisé dans l'analyse de cas juridiques complexes et dans la fourniture de conseils juridiques professionnels et rigoureux.

- Conseil à l'utilisateur : Analysez l'affaire "Smith contre Jones" et déterminez si Jones doit être tenu pour responsable. (Le modèle sera analysé dans le rôle et sur le ton d'un conseiller juridique)

Contrôle de la redondance et de la profondeur par des commandes

Alors que O1 et O3-mini raisonnent naturellement en profondeur, vous pouvez contrôler ce raisonnement dans la sectionexportationsLa mesure dans laquelle elle est reflétée dans les Si vous souhaitezPour une explication détaillée**, invitez-les à le faire (par exemple, "Montrez votre raisonnement étape par étape dans votre réponse"). Il n'est pas nécessaire d'insisteraller de l'avantraisonnement, mais si vous voulezvoir queIl faut qu'ils en soient informés. Si vous estimez que la réponse du modèle est trop longue ou trop technique, demandez-lui d'être plus concise ou de ne se concentrer que sur certains aspects. Par exemple, "Résumez l'analyse en 2 ou 3 paragraphes, en ne reprenant que les points les plus importants". Les modèles suivent généralement ces instructions concernant la longueur ou le ciblage. N'oubliez pas que le comportement par défaut de O1 est la minutie - il est optimisé pour l'exactitude plutôt que pour la brièveté - et qu'il peut donc avoir tendance à fournir plus de détails. Dans la plupart des cas, une exigence directe de concision l'emportera sur cette tendance. **

en ce qui concerneO3-mini**, OpenAI fournit un outil supplémentaire pour gérer la profondeur :"Paramètre "force du raisonnement(Faible, Moyen, Élevé). Ce paramètre permet au modèle de savoir à quel point il est difficile de "penser". En termes d'indices, si vous utilisez une API ou un système qui expose cette fonctionnalité, vous pouvez l'augmenter pour les tâches très complexes (garantissant un raisonnement maximal au prix de réponses plus longues et de retards) ou la diminuer pour les tâches plus simples (réponses plus rapides et plus rationalisées). Il s'agit essentiellement d'un autre moyen de contrôler la redondance et la rigueur. Si vous n'avez pas un accès direct à ce paramètre, vous pouvez le simuler en indiquant explicitement "donner une réponse rapide, sans analyse approfondie".faible intensitépour les situations où la vitesse est plus importante qu'une précision parfaite. Au lieu de cela, pour simulerforte intensitéVous pouvez dire "Prenez toutes les mesures nécessaires pour arriver à la bonne réponse, même si l'explication est longue". Ces conseils sont cohérents avec le fonctionnement des paramètres internes du modèle. **

Exemple de conseil :

- Contrôle de la redondance : "Résumez les points principaux de cet article, avec une limite de 200 mots".

- Profondeur de contrôle : "Analysez en profondeur la structure argumentative de cet essai et évaluez s'il est logique et bien argumenté."

Assurer la précision des tâches complexes

Afin d'obtenir la réponse la plus précise possible sur les questions difficiles, veuillezTirez parti du modèle d'inférence dans l'invite**. Puisque O1 est capable de s'autocontrôler et même de repérer les contradictions, vous pouvez lui demander d'en tirer parti : par exemple, "Analysez tous les faits et vérifiez la cohérence de vos conclusions."En général, il le fait sans y être invité.Jamahiriya arabe libyenneaugmenterCette commande incite le modèle à redoubler de prudence. Il est intéressant de noter que, comme O1 effectue déjà une auto-vérification des faits, il est rarement nécessaire de l'inviter à "valider chaque étape" (ce qui est plus utile pour GPT-4o). Au lieu de cela, concentrez-vous sur la fourniture d'informations complètes et claires. Si la question ou la tâche comporte des ambiguïtés potentielles, clarifiez-les dans l'invite ou demandez au modèle de dresser la liste des hypothèses. Cela évite au modèle de faire des suppositions erronées. **

Traitement des sources et des données : Si votre tâche consiste à analyser des données données (par exemple, résumer un document ou calculer une réponse sur la base des chiffres fournis), veillez à présenter ces données de manière claire.O1/O3-mini les utilisera consciencieusement. Vous pouvez même décomposer les données en puces ou en tableaux pour plus de clarté. Si le modèle ne doit pas créer d'illusions (par exemple, dans un contexte juridique, il ne doit pas inventer de lois), indiquez clairement que "votre réponse est basée uniquement sur les informations fournies et le bon sens ; n'inventez pas de détails". Les modèles de raisonnement s'en tiennent souvent à des faits connus, et de telles instructions réduisent encore la probabilité d'hallucinations.Itération et validation : Si la tâche est critique (par exemple, un raisonnement juridique complexe ou des calculs d'ingénierie à fort enjeu), les techniques d'ingénierie rapide sont les suivantesintégré (comme dans circuit intégré)La réponse du modèle. Il ne s'agit pas d'une invite unique, mais d'une stratégie : vous pouvez exécuter la requête (ou demander au modèle d'envisager des solutions alternatives) plusieurs fois, puis comparer les réponses. Le caractère aléatoire de O1 signifie qu'il peut explorer un chemin de raisonnement différent à chaque fois. En comparant les résultats ou en demandant au modèle de "réfléchir à l'existence d'explications alternatives" dans les invites suivantes, vous pouvez améliorer la confiance dans les résultats. Bien que GPT-4o bénéficie également de cette approche, elle est particulièrement utile pour O1 lorsque la précision absolue est critique - essentiellement en exploitant la profondeur du modèle lui-même par le biais de la validation croisée.

Enfin, n'oubliez pas que la sélection du modèle fait partie de l'ingénierie des signaux : si le problème ne nécessite pas réellement un raisonnement de niveau O1, il peut être plus efficace et tout aussi précis d'utiliser GPT-4o. openAI recommande de réserver O1 aux cas difficiles et d'utiliser GPT-4o pour le reste. méta-conseil : évaluez d'abord la complexité de la tâche. Si elle est simple, il faut soit donner un signal très direct à O1 pour éviter de trop réfléchir, soit passer à GPT-4o. Si elle est complexe, il faut utiliser les techniques ci-dessus pour tirer parti des capacités d'O1.

Exemple de conseil :

- L'accent est mis sur les sources de données : "Analysez les catégories de produits dont les ventes ont augmenté le plus rapidement au cours du dernier trimestre, en vous basant sur le tableau de données de vente suivant : [coller le tableau de données de vente]. [Veillez à n'utiliser que les données du tableau pour votre analyse et à ne pas vous référer à d'autres sources."

- Validation itérative : Analyser l'affaire "Smith contre Jones" et déterminer si la responsabilité de Jones doit être engagée. Veuillez donner les résultats de votre première analyse. Ensuite, veuillez revoir votre analyse et examiner s'il existe d'autres explications ou lacunes possibles. Enfin, veuillez combiner les résultats des deux analyses et donner votre avis juridique final". (Améliorer la fiabilité des analyses juridiques par l'itération et la réflexion)

Comment O1/O3-mini gère la déduction logique par rapport à GPT-4o

Ces modèles de raisonnement traitent les problèmes logiques d'une manière fondamentalement différente de celle du GPT-4o, et votre stratégie d'incitation doit être adaptée en conséquence :

- Chaîne de pensée interne : O1 et O3-mini effectuent efficacement le dialogue interne ou les solutions étape par étape parce qu'ils interprètent les réponses. Sauf instruction explicite, le GPT-4o peut ne pas passer rigoureusement par chaque étape. Par exemple, dans les puzzles logiques ou les problèmes mathématiques, le GPT-4o peut donner une réponse rapide qui semble plausible mais qui ne tient pas compte d'une partie du raisonnement, ce qui augmente le risque d'erreur. Le O1 décompose automatiquement le problème, en considérant tous les angles, avant de donner la réponse, ce qui explique pourquoi il obtient des scores nettement plus élevés dans les évaluations à forte composante logique.Différence d'indice : ne demandez pas à O1 de "montrer la déduction" à moins que vous ne souhaitiez réellement la voir. Pour GPT-4o, vous utiliserez l'invite CoT ("D'abord, considérez ...... puis ......") pour améliorer la déduction, mais pour O1, il est intégré de le dire de l'extérieur ! Cela peut être redondant ou même déroutant. Au lieu de cela, assurez-vous d'énoncer clairement le problème et laissez O1 raisonner par déduction.Exemple de conseil :

- GPT-4o (nécessité d'orienter la chaîne de pensée) : "Résolvez le problème d'application mathématique suivant : [SUJET D'APPLICATION]. Suivez les étapes suivantes pour résoudre le problème : 1. comprenez la signification du problème ; 2. analysez les conditions connues et inconnues ; 3. énumérez les étapes pour résoudre le problème ; et 4. calculez la réponse."

- O1 (pas de démarrage) : "Résoudre le problème d'application mathématique suivant : [Titre de l'application]. (O1 va automatiquement raisonner logiquement et donner la réponse)

- Gérer l'ambiguïté : Dans une tâche de déduction logique, le GPT-4o peut émettre des hypothèses immédiates en cas de manque d'informations ou d'ambiguïté. En raison de son approche réflexive, O1 est plus susceptible de souligner les ambiguïtés ou d'envisager plusieurs possibilités. Pour tirer parti de cette situation, vous pourriez demander directement à O1 : "En cas d'incertitude, veuillez formuler vos hypothèses avant de les résoudre." Le GPT-4 a peut-être davantage besoin de cette incitation. o1 peut le faire naturellement ou, du moins, est moins susceptible de supposer des faits qui ne sont pas donnés. Ainsi, en comparant les deuxL'interprétation de O1 est minutieuse et complèteet le rendu du GPT-4o est rapide et complet. Ajustez vos signaux en conséquence - avec GPT-4o, guidez-le discrètement ; avec O1, vous devez surtout lui fournir des informations et le laisser faire.Exemple de conseil :

- O1 (gestion de l'ambiguïté) : "Analysez ce contrat et déterminez s'il est valable. Si, au cours de votre analyse, vous constatez des ambiguïtés dans l'une ou l'autre des clauses, identifiez-les clairement et indiquez votre compréhension et vos hypothèses concernant ces ambiguïtés".

- Exportation progressive : Parfois, on a envie d'être dansexportationsVoir les étapes logiques dans (pour l'enseignement ou la transparence). Avec le GPT-4o, vous devez demander explicitement ("Veuillez montrer votre travail"). Si la question est suffisamment complexe, O1 peut inclure une justification structurée par défaut, mais il fournira généralement une réponse bien raisonnée sans avoir à énumérer explicitement chaque étape, à moins qu'on ne le lui demande. Si vous souhaitez que O1 produise une chaîne logique, il suffit de le lui demander - il le fera sans difficulté. En fait, il a été noté que O1-mini est capable de fournir des décompositions étape par étape lorsqu'on le lui demande (par exemple, dans les problèmes de codage). De plus, si vous(préfixe négatif)Si vous souhaitez que O1 fournisse un long exposé de la logique (peut-être voulez-vous simplement la réponse finale), vous devez dire "donner directement la réponse finale" pour éviter l'explication détaillée.Exemple de conseil :

- Nécessite une sortie pas à pas (O1) : "Résolvez ce problème de programmation : [description du problème de programmation]. Montrez votre solution étape par étape, en incluant chaque ligne de code que vous avez écrite, et expliquez ce que fait le code."

- Nécessite une sortie directe (O1) : "Résolvez ce problème de programmation : [description du problème de programmation]. Veuillez donner le code final du programme directement, sans explication."

- Rigueur logique contre créativité : Autre différence : le GPT-4 (et 4o) se caractérise par sa créativité et sa générosité. Dans les problèmes de logique, cela peut parfois l'amener à "imaginer" des scénarios ou des analogies, ce qui n'est pas toujours nécessaire. o1 est plus rigoureux et s'en tient à l'analyse logique. Si votre question comporte un scénario qui nécessite à la fois de la déduction et un peu de créativité (par exemple, en reconstituant des indices), vous pouvez l'utiliser comme exemple.répondre en chantantajouter une narration pour résoudre un mystère), GPT-4 peut être meilleur pour gérer la narration, tandis que O1 se concentrera strictement sur la déduction. Dans le cadre du projet, vous pouvez combiner leurs forces : utilisez O1 pour obtenir une solution logique, puis utilisez GPT-4 pour embellir la présentation. Si vous vous en tenez à O1/O3-mini, sachez que vous devrez peut-être lui demander explicitement des touches créatives ou des réponses plus imaginatives, car ils sont conçus pour donner la priorité à la logique et à l'exactitude.Exemple de conseil :

- L'accent est mis sur la créativité (GPT-4o) : "Il vous est demandé de jouer le rôle d'un détective et d'élaborer une histoire policière captivante sur la base des indices suivants, y compris la cause, le déroulement et l'issue de l'affaire, ainsi que les motifs et le mode opératoire du meurtrier. [fournir des indices]"

- L'accent est mis sur la rigueur logique (O1) : "Il vous est demandé de jouer le rôle d'un logicien qui, sur la base des indices suivants, déduit rigoureusement la vérité de l'affaire et explique la base logique de chaque étape du raisonnement. [fournir des indices]"

Ajustements clés : En bref, pour tirer parti de la logique de O1/O3-mini, fournissez-leur les tâches de raisonnement les plus exigeantes sous la forme d'invites individuelles bien définies. Laissez-les compléter la logique en interne (ils sont conçus à cet effet) sans avoir à micro-gérer leur processus de pensée. Pour le GPT-4o, continuez à utiliser l'ingénierie classique des messages-guides (décomposer les problèmes, exiger un raisonnement par étapes, etc. ) pour induire le même niveau de déduction. Et adaptez toujours le style de l'invite au modèle - ce qui pourrait déconcerter le GPT-4o peut convenir à O1 et vice versa, en raison de ses méthodes de raisonnement différentes.

Produire des conseils efficaces : un résumé des meilleures pratiques

Afin de consolider ce qui précède en un guide pratique, voici une liste des meilleures pratiques à suivre lors de la sollicitation de l'O1 ou de l'O3-mini :

- Utilisez des instructions claires et précises : Indiquez clairement ce que vous voulez que le modèle fasse ou réponde. Évitez les détails non pertinents. Pour les questions complexes, un questionnement direct suffit généralement (il n'est pas nécessaire de recourir à des jeux de rôle complexes ou à des questions multiples).

- Fournir le contexte nécessaire et omettre le reste : Incluez toutes les informations relatives au domaine dont le modèle aura besoin (faits concernant l'affaire, données concernant le problème de mathématiques, etc. Toutefois, n'incluez pas de texte non pertinent ou trop d'exemples dans l'invite.affaiblissementModélisation de l'attention.

- Exemples de sous-échantillons minimes ou inexistants : Par défaut, commencez avec zéro échantillon. Si le modèle ne comprend pas la tâche ou le format, ajoutez un échantillon simple comme guide, mais n'ajoutez pas de longues chaînes d'échantillons pour O1/O3-mini. Ils n'en ont pas besoin et peuvent même dégrader les performances.

- Définissez le personnage ou le ton de la voix si nécessaire : Utilisez des messages système ou des préfixes courts pour mettre le modèle dans le bon état d'esprit (par exemple, "Vous êtes un assistant juridique senior chargé d'analyser des affaires"). . Cela permet notamment d'améliorer le ton (formel ou décontracté) et de s'assurer que le langage utilisé est adapté au domaine.

- Spécifie le format de sortie : Si vous souhaitez que la réponse ait une structure spécifique (liste, schéma, JSON, etc.), veuillez en informer explicitement le modèle. Le modèle d'inférence suivra de manière fiable les instructions de formatage. Par exemple, "Donnez votre réponse sous la forme d'une liste ordonnée d'étapes".

- Contrôler la longueur et les détails par description : Si vous souhaitez une réponse courte, rendez-la explicite ("Répondez en un paragraphe" ou "Répondez uniquement par oui/non et expliquez en une phrase"). Si vous souhaitez une analyse approfondie, encouragez-la ("fournir une explication détaillée"). Ne supposez pas que le modèle connaît par défaut le niveau de détail que vous souhaitez - donnez-lui des instructions.

- Utilisation du réglage de la force d'inférence de l'O3-mini : Lorsque vous utilisez O3-mini via l'API, sélectionnez la force de raisonnement appropriée (faible/moyenne/élevée) pour la tâche. Le niveau élevé fournit des réponses plus approfondies (pour les raisonnements juridiques complexes ou les questions difficiles) et le niveau faible fournit des réponses plus rapides et plus courtes (pour les vérifications rapides ou les questions plus simples). Il s'agit d'une façon unique d'ajuster le comportement des messages-guides O3-mini.

- Évitez les invites "étape par étape" redondantes : n'ajoutez pas de phrases ou d'instructions de type "réfléchissons bien" pour O1/O3-mini ; le modèle le fait déjà en interne. Conservez ces jetons et n'utilisez ces conseils que sur le GPT-4o, où ils ont un impact. Une exception peut être faite si vous souhaitez explicitement que le modèle produise chaque étape pour plus de transparence - vous pouvez alors l'utiliser dans la commandeexportationsIl est tenu de le faire, mais il n'est pas nécessaire de lui demander de le faire.Mise en œuvre pratiqueRaisonnement.

- Tests et itérations : Comme ces modèles peuvent être sensibles à la formulation, si vous n'obtenez pas une bonne réponse, essayez de reformuler la question ou de renforcer les instructions. Vous constaterez peut-être que de petits changements (par exemple, poser des questions directes plutôt que des questions ouvertes) permettent d'obtenir de bien meilleures réponses. Heureusement, O1/O3-mini nécessite moins d'itérations que les modèles plus anciens (ils effectuent souvent des tâches complexes correctement en une seule séance), mais les ajustements des messages-guides peuvent toujours aider à optimiser la clarté ou la mise en forme.

- Valide les résultats importants : Pour les cas d'utilisation critiques, ne vous contentez pas d'un seul cycle invite-réponse. Utilisez des invites de suivi pour demander au modèle de valider ou de justifier sa réponse ("Êtes-vous sûr de cette conclusion ? Expliquez pourquoi"). ou de relancer l'invite pour vérifier si les résultats obtenus sont cohérents. Des réponses cohérentes et bien argumentées indiquent que le raisonnement du modèle est fiable.

En suivant ces techniques, vous pouvez tirer parti de toutes les capacités des O1 et O3-mini avec une réponse hautement optimisée.

Application des meilleures pratiques aux études de cas juridiques

Enfin, examinons comment nous pouvons traduire ces conseils d'ingénierie enScénario d'analyse d'un cas juridique** (comme décrit précédemment). Les analyses juridiques sont des exemples parfaits de tâches de raisonnement complexes pour lesquelles O1 peut être très efficace, à condition de bien formuler l'invitation**.

- Entrée construite : Commencez par exposer clairement les faits essentiels de l'affaire et les questions juridiques auxquelles vous devez répondre. Par exemple, énoncez les faits de base sous forme de puces ou de courts paragraphes, puis posez explicitement la question juridique suivante : "À la lumière des faits susmentionnés, veuillez déterminer si la partie A est responsable d'une rupture de contrat en vertu du droit américain." En construisant l'invite de cette manière, le modèle peut analyser le scénario plus facilement. Elle permet également de s'assurer qu'aucun détail essentiel n'est oublié ou négligé.

- Fournir le contexte ou la loi pertinente : O1 ne dispose pas d'une fonction de navigation et peut ne pas être en mesure de se rappeler les lois de niche de mémoire, donc si vos analyses dépendent du texte d'une loi spécifique, fournissez-le au modèle. Par exemple, "Sur la base de [l'extrait de la loi X], [fournir le texte] ...... applique cette loi à l'affaire." De cette manière, le modèle dispose des outils nécessaires pour effectuer des déductions précises.

- Définition des rôles dans les messages du système : Les instructions du système, telles que "Vous êtes un analyste juridique qui explique l'application du droit aux faits de manière claire et étape par étape", inciteront le modèle à produire une analyse formelle et raisonnée. incitera le modèle à produire une analyse formelle et raisonnée. Bien que O1 ait tenté un raisonnement prudent, la consigne aligne son ton et sa structure sur ce que nous attendons d'un discours juridique (par exemple, citer des faits, appliquer le droit, tirer des conclusions).

- Il n'est pas nécessaire de multiplier les exemples : Ne fournissez pas d'exemple complet d'étude de cas en guise d'invite (vous pouvez envisager d'utiliser le GPT-4o pour cela).O1 n'a pas besoin de suivre l'exemple - il peut effectuer l'analyse à partir de zéro. O1 n'a pas besoin de suivre l'exemple - il peut effectuer l'analyse à partir de zéro. Cependant, vous pouvez mentionner brièvement le format requis, "Fournissez votre réponse dans le format IRAC (question, règle, analyse, conclusion)." Cette note de formatage fournit un modèle sans qu'il soit nécessaire d'afficher de longs exemples, et O1 organisera le résultat en conséquence.

- Contrôler la redondance si nécessaire : Si vous avez besoin d'une analyse exhaustive de l'affaire, demandez à O1 de produire son raisonnement complet. Il peut en résulter plusieurs paragraphes qui couvrent chaque question en profondeur. Si vous trouvez le résultat trop long, ou si vous avez besoin d'un résumé succinct (par exemple, un avis consultatif rapide), demandez au modèle de "limiter l'analyse à quelques paragraphes clés, en se concentrant sur les questions essentielles". Vous serez ainsi assuré de ne recevoir que les points essentiels. D'autre part, si la réponse initiale semble trop courte ou superficielle, demandez à nouveau : "Expliquez plus en détail, en particulier comment vous appliquez le droit aux faits." L'O1 sera heureux de développer, car il a déjà fait le gros du raisonnement en interne.

- Précision et cohérence logique : L'analyse juridique exige de la précision dans l'application des règles aux faits. Avec O1, vous pouvez lui faire confiance pour résoudre les problèmes de manière logique, mais il est judicieux de revérifier les références juridiques ou les déclarations spécifiques qu'il fait (étant donné que ses données d'entraînement peuvent ne pas contenir tous les détails). Vous pouvez même ajouter un indice à la fin, par exemple : "Vérifiez que tous les faits ont été résolus et que les conclusions sont conformes à la loi". Étant donné que O1 a tendance à s'autocontrôler, il peut lui-même signaler que quelque chose ne tient pas la route ou que d'autres hypothèses sont nécessaires. Il s'agit d'un filet de sécurité utile dans les domaines où la nuance est importante.

- Utilisez des questions de suivi : Dans les scénarios juridiques, il est courant de poser des questions complémentaires. Par exemple, si O1 présente une analyse, vous pouvez demander : "Et si le contrat prévoyait des conditions de résiliation différentes ? En quoi cela changerait-il l'analyse ?" O1 peut très bien répondre à ces questions itératives par le raisonnement. Gardez à l'esprit que si vous travaillez sur un projet, l'interface n'a pas de mémoire à long terme au-delà du contexte de dialogue actuel (et n'est pas parcourue), et chaque élément de contenu ultérieur doit s'appuyer sur le contexte fourni ou inclure toute nouvelle information nécessaire. Pour éviter toute confusion, le dialogue doit rester centré sur les faits de l'affaire en cours.

En appliquant ces bonnes pratiques, vos conseils guideront l'O1 ou l'O3-mini dans la réalisation d'analyses juridiques de haute qualité. En résumé, présentez les cas de manière claire, assignez des tâches et laissez les modèles de raisonnement faire le gros du travail.Le résultat doit être une discussion juridique bien raisonnée, étape par étape, qui utilise les capacités logiques de O1, le tout optimisé par une construction efficace de l'invite.

L'utilisation des modèles d'inférence d'OpenAI de cette manière vous permet de profiter de leurs forces dans la résolution de problèmes complexes tout en gardant le contrôle sur le style et la clarté de la sortie. Comme le souligne la documentation d'OpenAI, la série O1 excelle dans les tâches de raisonnement profond dans des domaines tels que la recherche et la stratégie - l'analyse juridique bénéficie également de cette caractéristique. En comprenant les différences avec le GPT-4o et en adaptant vos méthodes d'incitation en conséquence, vous pouvez maximiser les performances des O1 et O3-mini et obtenir des réponses précises et bien structurées, même pour les tâches de raisonnement les plus difficiles.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...