GRATUIT !!! Github s'associe à Azure pour rendre gratuits pour les développeurs les principaux appels d'API de modèles open source fermés, y compris o1.

Le code dense qui s'affiche à l'écran est entrecoupé d'informations sur la configuration de divers modèles d'API, et le café qui se trouve sur la table est froid depuis longtemps.

C'est une image fidèle de ce que de nombreux développeurs rencontrent lorsqu'ils essaient de créer des applications d'IA : une configuration d'environnement fastidieuse, des API coûteuses et une documentation insuffisante. ......

"Il serait formidable de disposer d'une plateforme unifiée qui permettrait à tous les développeurs d'utiliser facilement une variété de modèles d'IA.

Aujourd'hui, ce souhait est enfin devenu réalité.

GitHub a officiellement lancé le service GitHub Models, apportant une révolution dans le développement de l'IA à plus de 100 millions de développeurs dans le monde.

Nous allons nous pencher sur ce nouveau produit qui change la donne.

Une révolution tranquille en matière de développement

Le rôle du développeur est en train de changer profondément dans le monde de l'IA qui évolue rapidement.GitHub a officiellement annoncé le plan GitHub Copilot Free, qui est maintenant disponible pour tous les utilisateurs !

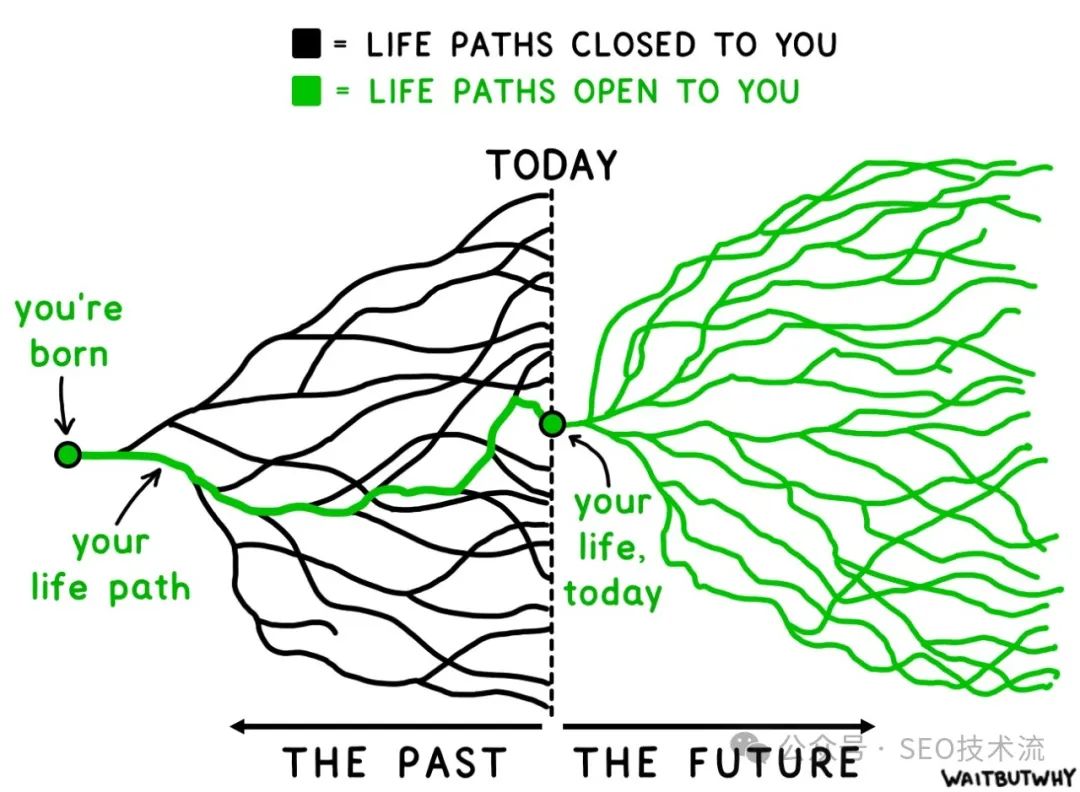

Le passage du "codeur" traditionnel à l'"ingénieur en IA" n'est pas seulement un changement de titre, mais une révolution de l'ensemble du paradigme de développement de logiciels.

L'émergence des modèles GitHub témoigne de ce tournant historique.

Pourquoi les modèles GitHub ?

Il n'est plus nécessaire d'utiliser des modèles d'IA dans vos projets :

- Passer d'une plateforme à l'autre pour trouver le bon modèle

- Configurer différents environnements et dépendances pour chaque modèle

- S'inquiéter des coûts élevés des appels API

- S'enliser dans des processus de déploiement complexes

Tous ces problèmes sont élégamment résolus dans les modèles GitHub.

Des modèles puissants à portée de main

La gamme de modèles est de luxe

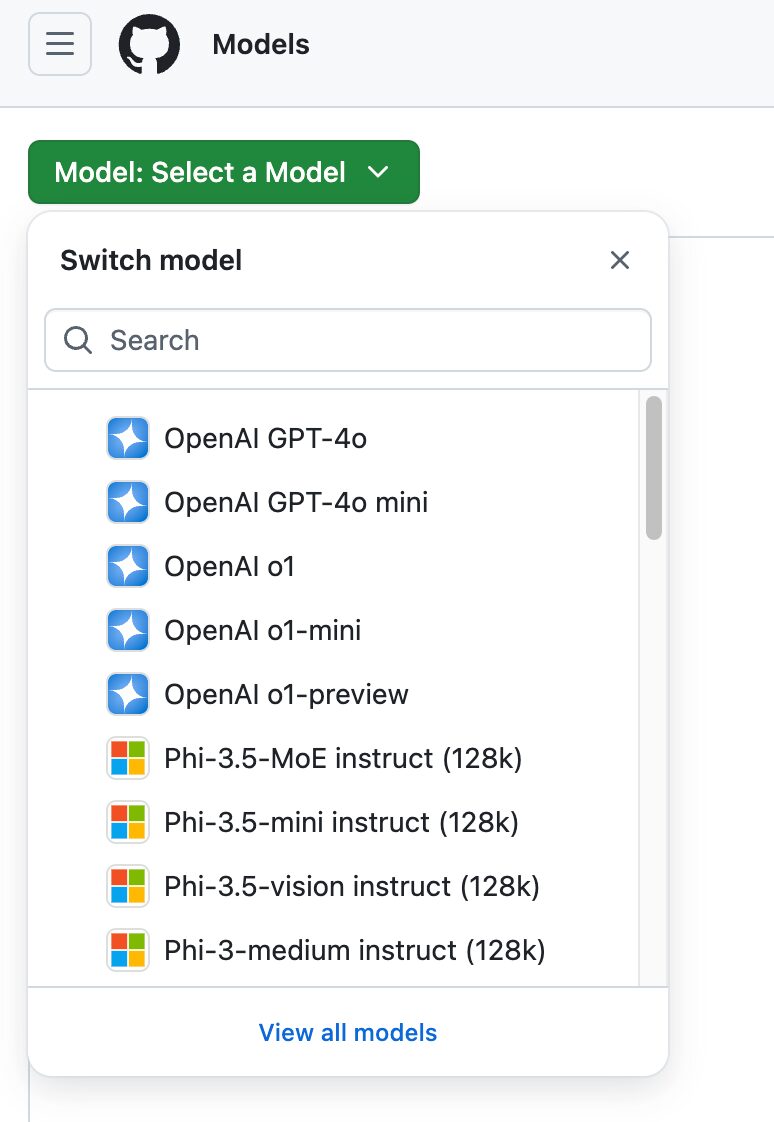

GitHub Models propose une bibliothèque impressionnante de modèles :

- Llama 3.1 : le dernier grand modèle open-source de Meta excelle dans plusieurs benchmarks

- GPT-4o : l'un des modèles commerciaux les plus puissants d'OpenAI avec support d'entrée multimodal

- GPT-4o mini : une version plus légère pour les applications nécessitant un temps de réponse rapide

- Phi 3 : Le modèle efficace de Microsoft qui donne d'excellents résultats pour des tâches spécifiques

- Mistral Large 2 : Connu pour sa faible latence, convient au développement d'applications en temps réel

Chaque modèle a ses propres avantages et les développeurs peuvent choisir celui qui répond le mieux à leurs besoins spécifiques.

Étonnamment facile à utiliser

Imdoaa de notre groupe, responsable technique d'une startup, a partagé son expérience de l'utilisation des modèles GitHub :

"Auparavant, la sélection et le test des modèles d'IA nous posaient des problèmes particuliers. Nous devions soit payer des frais élevés, soit passer beaucoup de temps à déployer des modèles open source. Avec GitHub Models, ces problèmes n'existent plus. Nous pouvons rapidement comparer les résultats de différents modèles dans la cour de récréation et trouver celui qui répond le mieux à nos besoins. Le plus intéressant, c'est que l'ensemble du processus, de l'expérimentation au déploiement, se déroule au sein de l'écosystème GitHub et que l'expérience est incroyablement fluide."

Compréhension approfondie des trois points forts

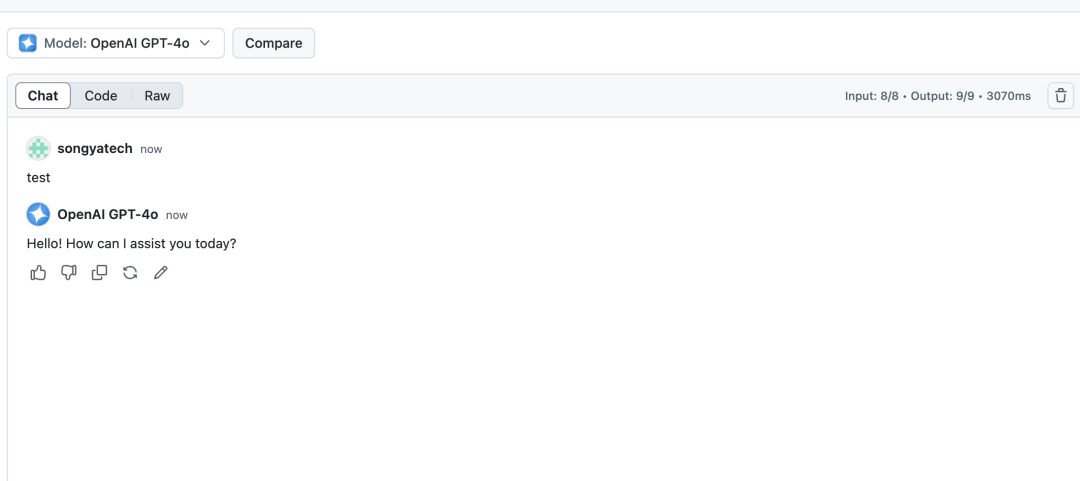

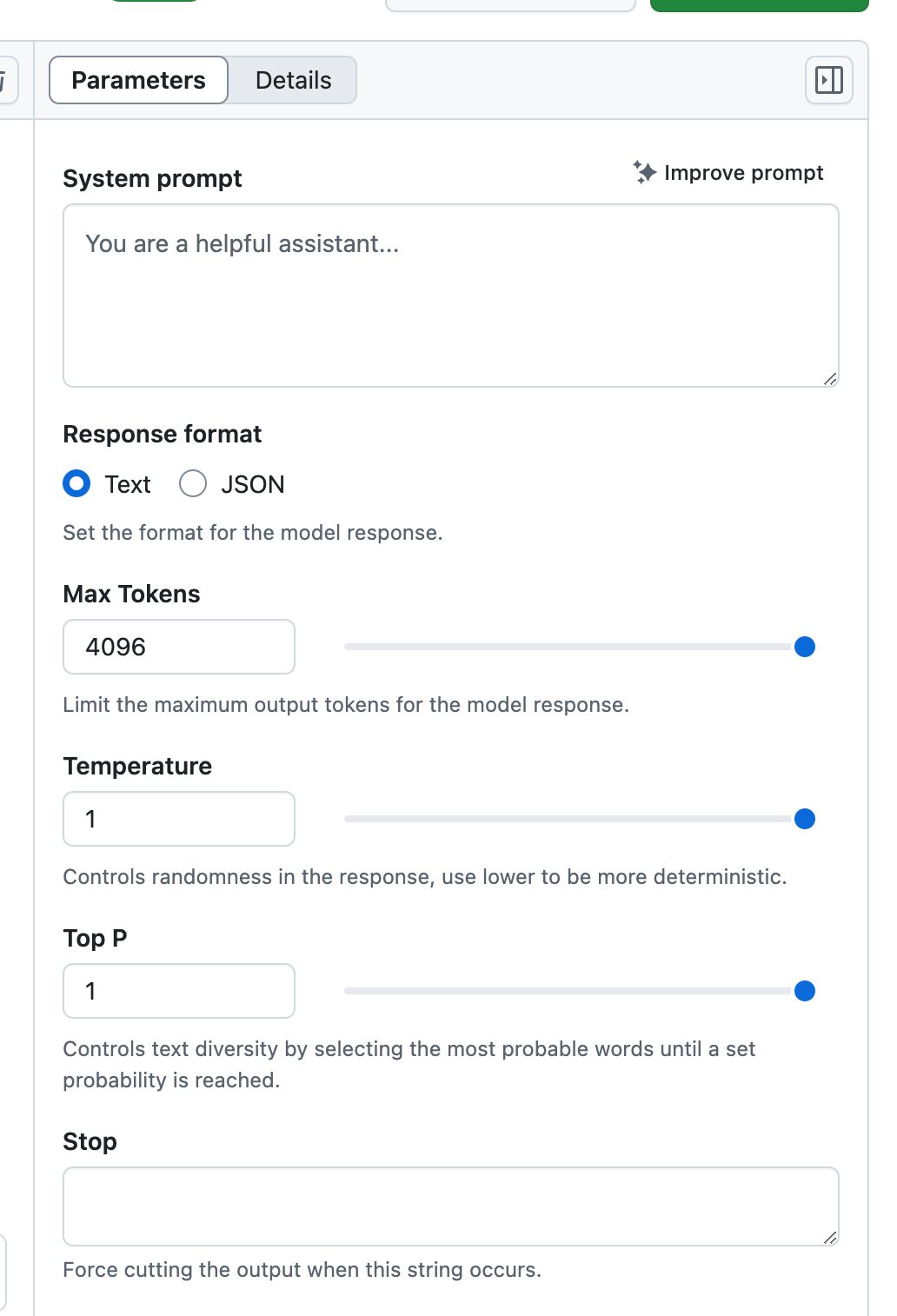

1. l'environnement révolutionnaire de l'aire de jeux

Playground est plus qu'un simple environnement de test de modèles, c'est un laboratoire d'IA complet :

- Réglage des paramètres en temps réel: :

- Contrôle de la température

- Réglage du nombre maximal de jetons

- Réglage de l'échantillonnage Top-p

- Optimisation des messages-guides du système

- Comparaison de plusieurs modèles: :

Plusieurs modèles peuvent être ouverts en même temps pour des tests de comparaison afin de visualiser la différence de performance de différents modèles avec la même entrée. - Sauvegarde de l'histoire: :

Toutes les procédures expérimentales sont enregistrées en vue d'une révision et d'une optimisation ultérieures.

2. intégration transparente des espaces codés

L'intégration de Codespaces rend le processus de développement incroyablement fluide :

- Environnement préconfiguré: :

Toutes les dépendances et configurations nécessaires sont prêtes à l'emploi. - Prise en charge multilingue: :

Fournir des exemples de code et de SDK pour Python, JavaScript, Java et d'autres langages courants.

- contrôle des versions: :

L'intégration directe avec les dépôts GitHub facilite la gestion des modifications du code.

3. l'assurance d'un déploiement au niveau de l'entreprise

Grâce à la prise en charge d'Azure AI, les déploiements au niveau de l'entreprise deviennent simples et fiables :

- Déploiement mondial: :

Plus de 25 régions Azure au choix, garantissant un accès rapide aux utilisateurs du monde entier. - Conformité en matière de sécurité: :

Il est conforme aux normes de sécurité de l'entreprise et prend en charge le cryptage des données et le contrôle d'accès. - évolutivité: :

Les ressources s'adaptent automatiquement à la demande pour garantir la stabilité du service.

Analyse approfondie de l'utilisation des quotas

La conception des quotas d'utilisation pour les différentes versions reflète la stratégie de produit de GitHub :

Version gratuite et Copilot Individual

- Demandes par minute : 10

- Quota journalier : 50

- Limitations des jetons :

- Entrée : 8000

- Rendement : 4000

- Demandes simultanées : 2

Ce quota convient aux développeurs individuels pour la validation de projets et l'apprentissage.

Copilote Business

- Conserver les mêmes limites de concurrence et de jetons

- Demandes quotidiennes portées à 100

- Adapté aux besoins de développement des petites équipes

Copilot Enterprise

- Demandes par minute : 15

- Quota journalier : 150

- Limite de jetons plus élevée :

- Entrée : 16000

- Sortie : 8000

- Demandes simultanées : 4

- Convient au développement d'applications au niveau de l'entreprise

Conseils pratiques

Développement Efficacité Amélioration Conseils

- Politique de mise en cache intelligente

# 示例代码:实现简单的结果缓存 import hashlib import json class ModelCache: def __init__(self): self.cache = {} def get_cache_key(self, prompt, params): data = f"{prompt}_{json.dumps(params, sort_keys=True)}" return hashlib.md5(data.encode()).hexdigest() def get_or_compute(self, prompt, params, model_func): key = self.get_cache_key(prompt, params) if key in self.cache: return self.cache[key] result = model_func(prompt, params) self.cache[key] = result return result - Optimisation du traitement par lots

Organisez judicieusement les lots de demandes pour éviter les appels fréquents à l'API. - Meilleures pratiques en matière de gestion des erreurs

Mettre en œuvre un mécanisme de relance intelligent pour gérer les défaillances temporaires.

Recommandations de sécurité

- Gestion des jetons d'accès

- Rotation régulière Accès personnel Jeton

- Utilisation du principe du moindre privilège

- Éviter le codage en dur des jetons dans le code

- la sécurité des données

- Désensibiliser les données avant de les envoyer au modèle

- Permettre les audits d'accès aux données

- Vérification régulière des journaux de sécurité

regarder vers l'avenir

La vision de Thomas Dohmke, PDG de GitHub, est d'aider le monde à atteindre son objectif d'un milliard de développeurs dans les prochaines années. Derrière cette ambition se cache une croyance forte en la démocratisation de l'IA.

Commencez dès aujourd'hui votre parcours d'ingénieur en IA !

- Préparation de la demande

- Visitez la page officielle des modèles GitHub

- Soumettre une demande d'inscription sur la liste d'attente

- Préparer un compte GitHub et un jeton d'accès personnel

- Configuration de l'environnement

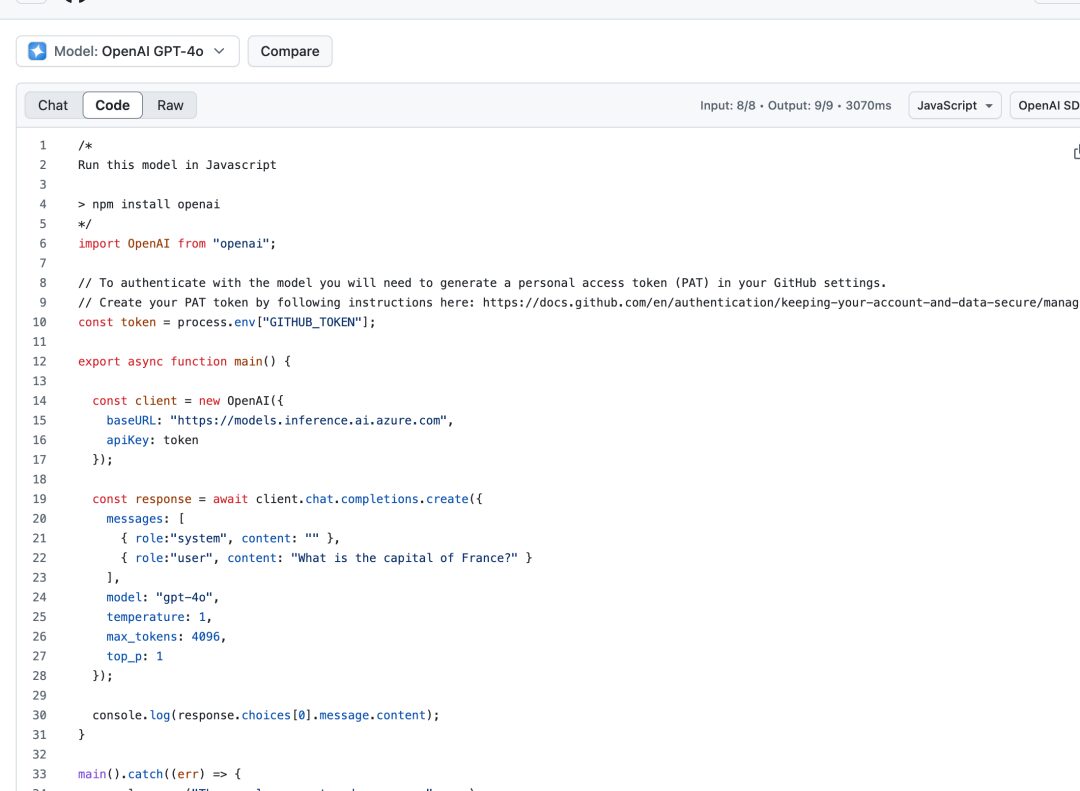

import OpenAI from "openai"; const token = process.env["GITHUB_TOKEN"]; const client = new OpenAI({ baseURL: "https://models.inference.ai.azure.com", apiKey: token }); - Démarrer l'expérience

- Tester différents modèles dans une aire de jeux

- Projet de démarrage rapide avec exemple de code

- Extension progressive des fonctionnalités de l'application

remarques finales

L'évolution de la technologie de l'IA est en train de remodeler l'avenir du développement logiciel. Le lancement de GitHub Models est plus que la naissance d'un nouveau produit, c'est le début d'une nouvelle ère. Il donne à chaque développeur l'opportunité de participer à la révolution de l'IA et de changer le monde avec des idées et des pratiques innovantes.

Désormais, la question qui se pose n'est plus de savoir s'il faut se lancer dans le développement de l'IA, mais comment mieux utiliser la puissante plateforme des modèles GitHub pour aller plus loin sur le chemin d'un ingénieur en IA. L'opportunité est là, êtes-vous prêt ?

Comme l'a déclaré un développeur chevronné, "GitHub Models n'est pas seulement un outil, c'est une clé pour ouvrir l'ère de l'IA. Grâce à lui, chaque développeur peut devenir un ingénieur en IA et chaque idée peut devenir une réalité."

Il est maintenant temps de commencer votre voyage de développement de l'IA.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...