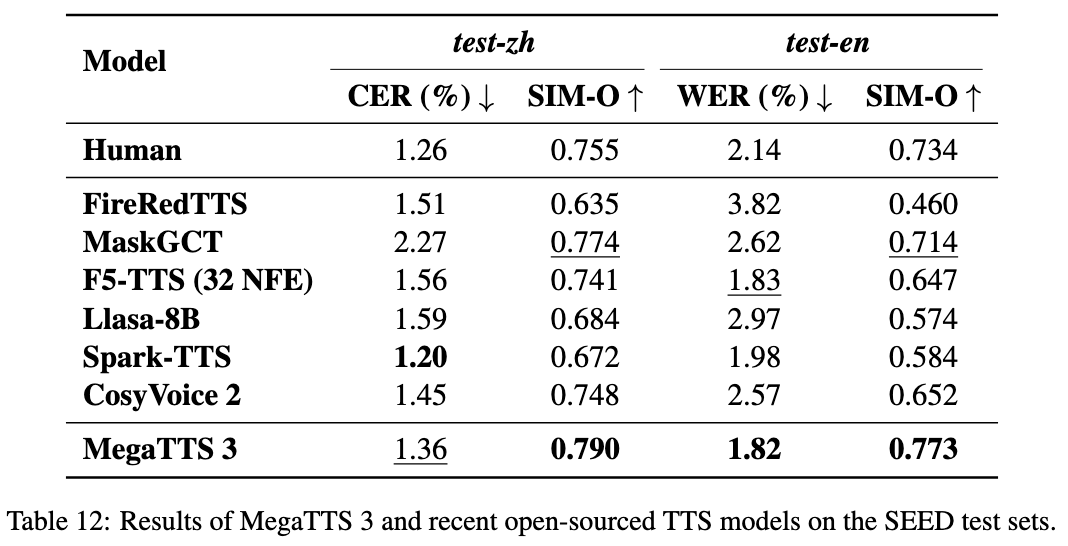

MegaTTS3 : un modèle léger pour la synthèse de la parole chinoise et anglaise

Introduction générale

MegaTTS3 est un outil de synthèse vocale open source développé par ByteDance en collaboration avec l'Université de Zhejiang, qui se concentre sur la génération de discours chinois et anglais de haute qualité. Son modèle de base ne comporte que 0,45 milliard de paramètres, il est léger et efficace et prend en charge la génération de discours chinois et anglais mixtes et le clonage de discours. Le projet est hébergé sur GitHub et fournit le code et les modèles pré-entraînés pour un téléchargement gratuit. MegaTTS3 peut imiter la voix cible avec quelques secondes d'échantillons audio, et permet également d'ajuster l'intensité de l'accent. Il convient à la recherche universitaire, à la création de contenu et au développement d'applications vocales, des fonctions de contrôle de la prononciation et de la durée devant être ajoutées à l'avenir.

Liste des fonctions

- Générer des discours chinois, anglais et mixtes avec une sortie naturelle et fluide.

- Le clonage de la parole de haute qualité est réalisé avec une petite quantité d'audio qui imite un timbre spécifique.

- Prise en charge du réglage de l'intensité de l'accent, permettant de générer un discours avec un accent ou une prononciation standard.

- Utiliser des latents acoustiques pour améliorer l'efficacité de l'apprentissage des modèles.

- Vocodeur WaveVAE intégré de haute qualité pour une intelligibilité et un réalisme accrus de la parole.

- Les sous-modules Aligneur et Graphme-to-Phoneme sont fournis pour soutenir l'analyse de la parole.

- Code source ouvert et modèles pré-entraînés pour un développement défini par l'utilisateur.

Utiliser l'aide

MegaTTS3 nécessite une certaine expérience de la programmation de base, en particulier avec Python et les environnements d'apprentissage profond. Vous trouverez ci-dessous des instructions détaillées sur l'installation et l'utilisation.

Processus d'installation

- Environnement bâti

MegaTTS3 RecommandéPython 3.9. Il est possible d'utiliser leCondaCréer un environnement virtuel :conda create -n megatts3-env python=3.9 conda activate megatts3-envAprès l'activation, toutes les opérations sont effectuées dans cet environnement.

- Télécharger le code

Exécutez la commande suivante dans un terminal pour clonerGitHubEntrepôt :git clone https://github.com/bytedance/MegaTTS3.git cd MegaTTS3 - Installation des dépendances

Offres de projetsrequirements.txtSi vous souhaitez installer les bibliothèques requises, exécutez la commande suivante :pip install -r requirements.txtLe temps d'installation varie en fonction du réseau et de l'appareil, mais il est généralement de quelques minutes.

- Obtenir le modèle

Les modèles pré-entraînés peuvent être téléchargés à partir de Google Drive ou de Hugging Face (voir les liens officiels).README). Téléchargez-le et décompressez-le à./checkpoints/Dossier. Exemple :- commandant en chef (militaire)

model.pthmettre en./checkpoints/model.pth. - pré-extrait

latentsLes fichiers doivent être téléchargés à partir du lien spécifié dans le même répertoire.

- commandant en chef (militaire)

- test d'installation

Exécutez une simple commande de test pour vérifier l'environnement :python tts/infer_cli.py --input_wav 'assets/Chinese_prompt.wav' --input_text "测试" --output_dir ./genSi aucune erreur n'est signalée, l'installation a réussi.

Principales fonctions

synthèse vocale

La génération de la parole est la fonction principale de MegaTTS3. Elle nécessite l'entrée d'un texte et d'un son de référence :

- Préparer le document

existentassets/dans le fichier audio de référence (par ex.Chinese_prompt.wavetlatents(par exempleChinese_prompt.npy). Si aucunlatentsLes fichiers officiels pré-extraits sont nécessaires. - Exécuter la commande

Entrée :CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/Chinese_prompt.wav' --input_text "你好,这是一段测试语音" --output_dir ./gen--input_wavest le chemin audio de référence.--input_textest le texte à synthétiser.--output_direst le dossier de sortie.

- Voir les résultats

Le discours généré est enregistré dans le fichier./gen/output.wavLe film est disponible en lecture directe.

clonage de la parole

Il suffit de quelques secondes d'échantillons audio pour imiter un son spécifique :

- Préparer un son de référence clair (5-10 secondes recommandées).

- Utilisez la commande de synthèse ci-dessus pour spécifier le

--input_wav. - La voix de sortie sera aussi proche que possible de la tonalité de référence.

contrôle de l'accent

Réglage de l'intensité de l'accent par les paramètres p_w répondre en chantant t_w: :

- Entrez l'anglais audio avec un accent :

CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text "这是一条有口音的音频" --output_dir ./gen --p_w 1.0 --t_w 3.0 p_wapproche1.0L'accent d'origine est parfois conservé, et l'augmentation tend vers la prononciation standard.t_wContrôles de la similarité des timbres, généralement plus dep_wvotre (honorifique)0-3.- Générer une prononciation standardisée :

CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text "这条音频发音标准一些" --output_dir ./gen --p_w 2.5 --t_w 2.5

Opérations de l'interface utilisateur Web

Permet de fonctionner via une interface web :

- La course à pied :

CUDA_VISIBLE_DEVICES=0 python tts/gradio_api.py - Ouvrez votre navigateur et entrez l'adresse (par défaut)

localhost:7860), télécharger des données audio et du texte pour générer de la parole.CPUEnviron 30 secondes dans l'environnement.

Utilisation des sous-modules

Aligneur

- FonctionnalitéAligner la parole et le texte : Aligner la parole et le texte.

- utilisation: Run

tts/frontend_function.pyL'exemple de code pour la segmentation de la parole ou la reconnaissance des phonèmes dans l'application

De la graphie à la phonétique

- Fonctionnalité: Convertit le texte en phonèmes.

- utilisation: Référence

tts/infer_cli.pyVoici une liste des principales caractéristiques de l'analyse de la prononciation.

VVAE

- FonctionnalitéL'audio compressé est

latentset reconstruit. - contrainteLes paramètres de l'encodeur ne sont pas divulgués et ne peuvent être utilisés qu'avec des données pré-extraites.

latents.

mise en garde

- Les paramètres de l'encodeur WaveVAE ne sont pas disponibles pour des raisons de sécurité et ne peuvent être utilisés qu'avec la version officielle de l'encodeur WaveVAE.

latentsDocumentation. - Le projet a été lancé le 22 mars 2025 et est toujours en cours de développement, avec de nouvelles prononciations et des ajustements de durée prévus.

GPURecommandations accélérées.CPUFonctionne mais est lent.

scénario d'application

- recherche universitaire

Les chercheurs peuvent tester les techniques de synthèse vocale avec MegaTTS3, en analysant les résultats de la synthèse vocale.latentsL'effet de la - Aides pédagogiques

Convertir les manuels scolaires en discours et générer des livres audio pour améliorer l'expérience d'apprentissage. - création de contenu

Générez une narration pour les vidéos ou les podcasts et économisez sur les coûts d'enregistrement manuel. - interaction vocale

Les développeurs peuvent l'intégrer dans leurs appareils pour permettre un dialogue vocal en anglais et en chinois.

QA

- Quelles sont les langues prises en charge ?

Prend en charge le chinois, l'anglais et la parole mixte, avec la possibilité de l'étendre à d'autres langues à l'avenir. - doit

GPUOui, oui.

Pas nécessaire.CPUIl peut être exécuté, mais il est lent et il est recommandé d'utiliser la fonctionGPU. - Comment gérer les échecs d'installation ?

mise à jourpip(pip install --upgrade pip), en vérifiant le réseau, ou enGitHubSoumettre un numéro. - Pourquoi les encodeurs WaveVAE sont-ils absents ?

Non divulgué pour des raisons de sécurité. Pré-extraction officielle requise.latents.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...