综合介绍

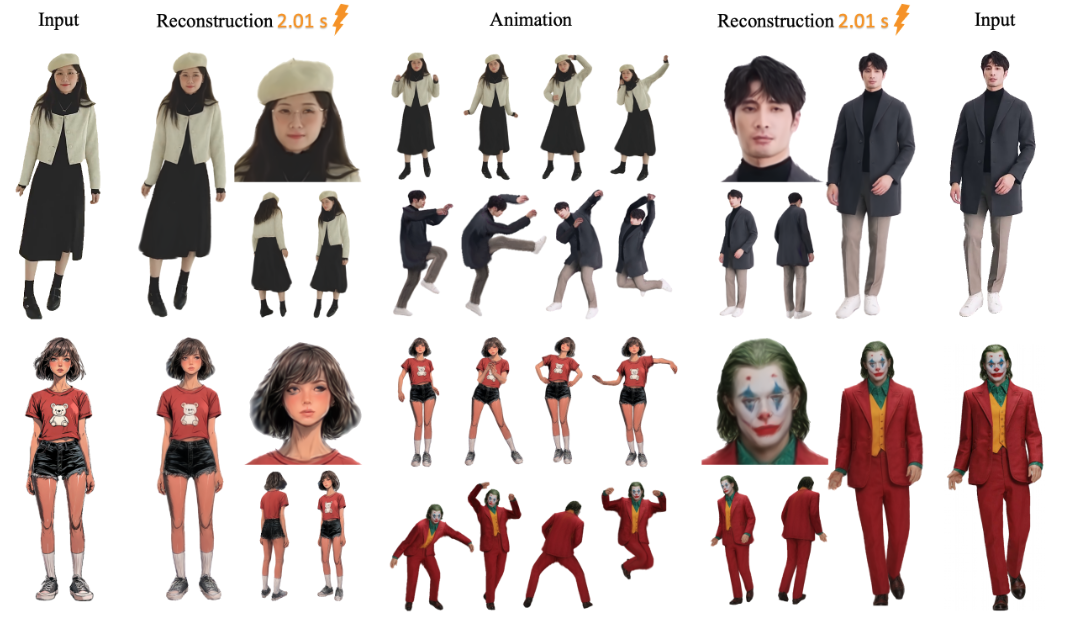

Marco-o1是由阿里巴巴国际数字商业集团(AIDC-AI)开发的开放式推理模型,旨在解决复杂的现实世界问题。该模型结合了思维链(CoT)微调、蒙特卡洛树搜索(MCTS)和创新的推理策略,优化了复杂问题解决任务。Marco-o1不仅关注数学、物理和编程等有标准答案的学科,还致力于在没有明确标准和难以量化奖励的领域中实现泛化。该项目的目标是探索大型推理模型在多语言应用中的潜力,并通过不断优化和改进,提升模型的推理能力和应用范围。

功能列表

- 思维链微调(CoT):通过对基础模型进行全参数微调,结合开源CoT数据集和自研合成数据,提升模型的推理能力。

- 蒙特卡洛树搜索(MCTS):利用模型输出的置信度引导搜索,扩展解决方案空间,优化推理路径。

- 推理动作策略:实施创新的推理动作策略和反思机制,探索不同粒度的动作,提高模型解决复杂问题的能力。

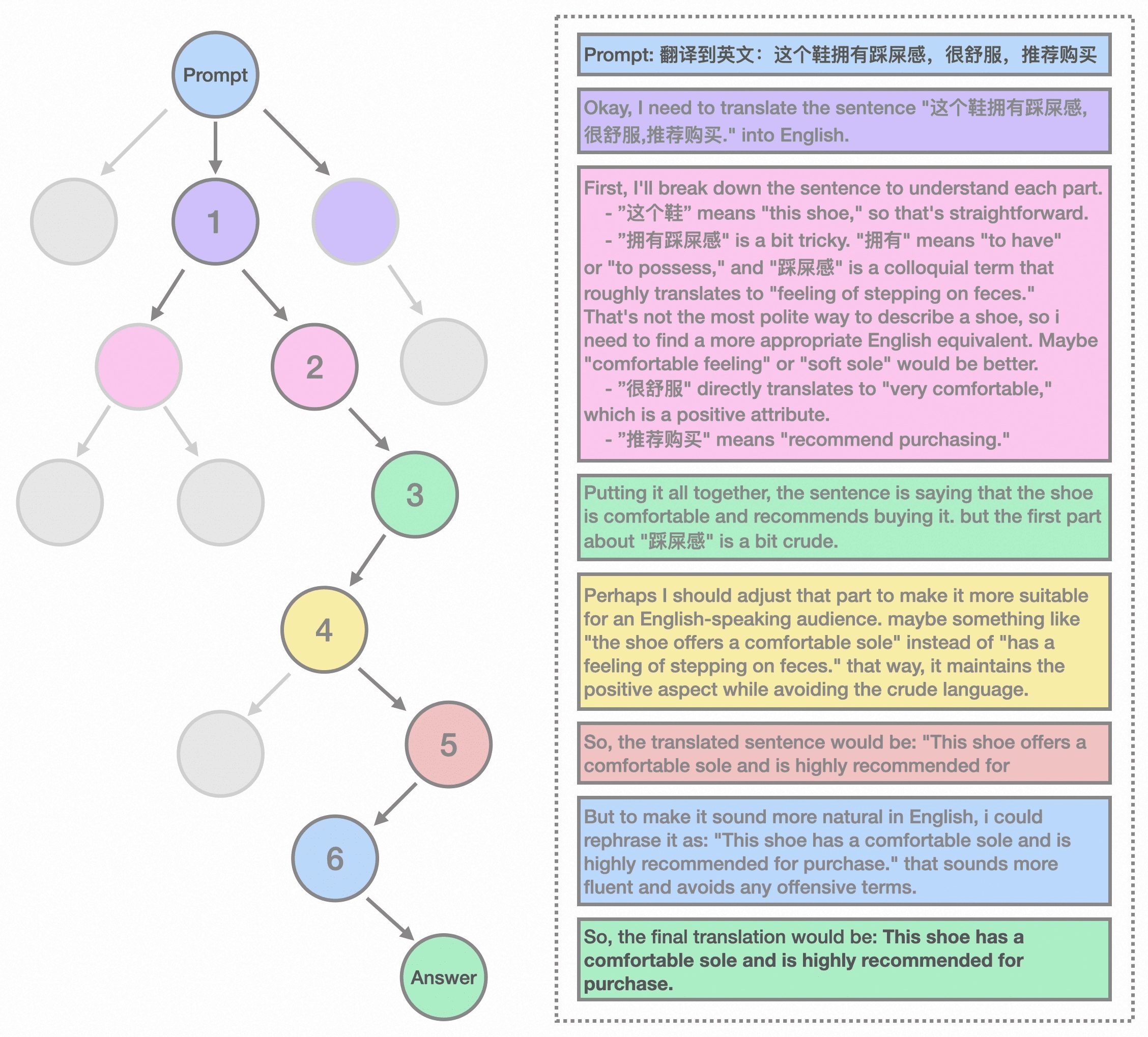

- 多语言翻译任务:首次将大型推理模型应用于机器翻译任务,探索多语言和翻译领域的推理时间缩放规律。

- 奖励模型训练:开发结果奖励建模(ORM)和过程奖励建模(PRM),提供更准确的奖励信号,减少树搜索结果的随机性。

- 强化学习训练:通过强化学习技术,优化模型的决策过程,进一步提升其问题解决能力。

使用帮助

安装流程

- 访问GitHub页面:前往Marco-o1 GitHub页面。

- 克隆仓库:使用命令

git clone https://github.com/AIDC-AI/Marco-o1.git克隆仓库到本地。 - 安装依赖:进入项目目录,运行

pip install -r requirements.txt安装所需依赖。

使用指南

- 加载模型:在Python环境中,使用以下代码加载模型:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "AIDC-AI/Marco-o1" model = AutoModelForCausalLM.from_pretrained(model_name) tokenizer = AutoTokenizer.from_pretrained(model_name) - 推理示例:使用模型进行推理,以下是一个简单的示例:

python

input_text = "How many 'r' are in strawberry?"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True)) - 多语言翻译:Marco-o1在多语言翻译任务中表现出色,以下是一个翻译示例:

python

input_text = "这个鞋拥有踩屎感"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

详细功能操作流程

- 思维链微调(CoT):

- 数据准备:收集并整理开源CoT数据集和自研合成数据。

- 模型微调:使用上述数据对基础模型进行全参数微调,提升其推理能力。

- 蒙特卡洛树搜索(MCTS):

- 节点表示:在MCTS框架中,每个节点表示问题解决过程中的一个推理状态。

- 动作输出:节点的可能动作由LLM生成,代表推理链中的潜在步骤。

- 回滚和奖励计算:在回滚阶段,LLM继续推理过程直至终止状态。

- 引导搜索:使用奖励分数评估和选择有前途的路径,引导搜索向更可靠的推理链发展。

- 推理动作策略:

- 动作粒度:在MCTS框架内探索不同粒度的动作,提高搜索效率和准确性。

- 反思机制:提示模型自我反思,显著增强其解决复杂问题的能力。

- 多语言翻译任务:

- 任务应用:将大型推理模型应用于机器翻译任务,探索多语言和翻译领域的推理时间缩放规律。

- 翻译示例:展示模型在翻译俚语表达方面的优越表现。

- 奖励模型训练:

- 结果奖励建模(ORM):训练模型以提供更准确的奖励信号,减少树搜索结果的随机性。

- 过程奖励建模(PRM):通过过程奖励建模,进一步优化模型的推理路径。

- 强化学习训练:

- 决策优化:通过强化学习技术,优化模型的决策过程,提升其问题解决能力。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...