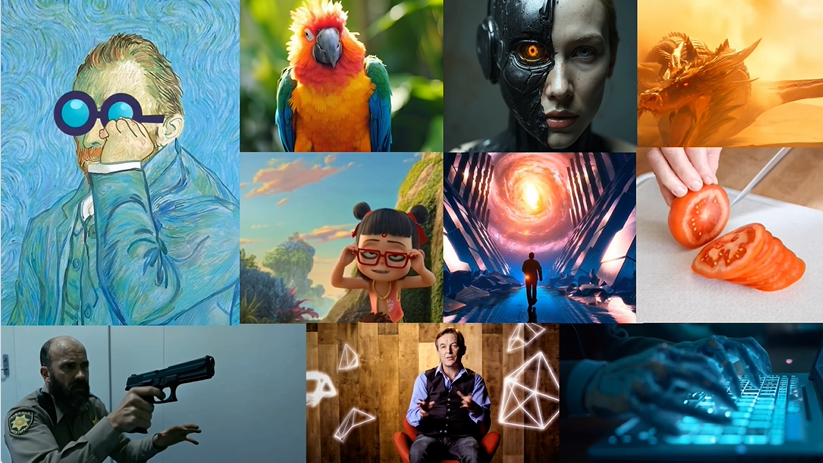

Magic 1-For-1 : projet open-source de génération efficace de vidéo qui prétend générer une vidéo d'une minute en moins d'une minute

Introduction générale

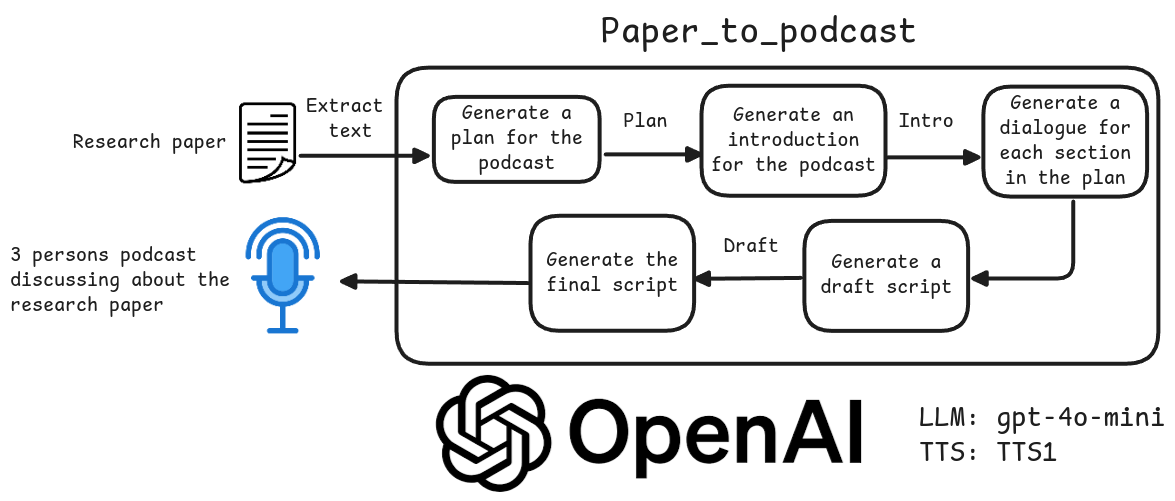

Magic 1-For-1 est un modèle de génération vidéo efficace conçu pour optimiser l'utilisation de la mémoire et réduire le temps de latence de l'inférence. Le modèle décompose la tâche de génération texte-vidéo en deux sous-tâches : génération texte-image et génération image-vidéo, pour une formation et une distillation plus efficaces. Magic 1-For-1 peut générer des clips vidéo de haute qualité d'une minute en moins d'une minute pour les scénarios où des vidéos courtes doivent être générées rapidement. Le projet a été développé par des chercheurs de l'Université de Pékin, de Hedra Inc. et de Nvidia, et le code et les poids du modèle sont accessibles au public sur GitHub.

Liste des fonctions

- Génération texte-image : convertit la description textuelle en image.

- Génération d'images en vidéo : convertissez les images générées en clips vidéo.

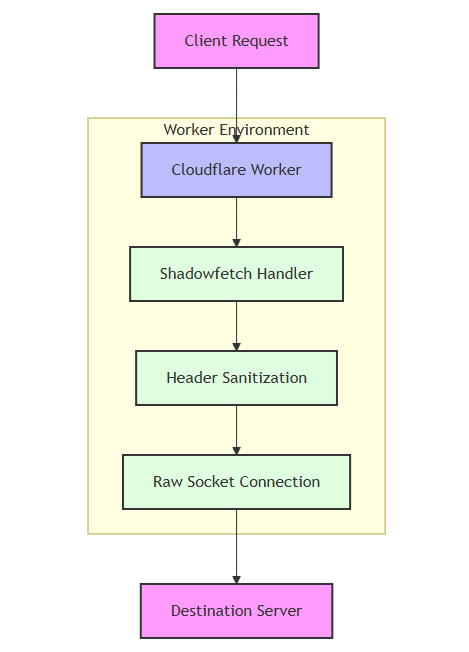

- Utilisation efficace de la mémoire : optimise l'utilisation de la mémoire pour les environnements à un seul GPU.

- Inférence rapide : réduction de la latence de l'inférence pour une génération vidéo rapide.

- Téléchargement des poids des modèles : fournit des liens pour télécharger les poids des modèles pré-entraînés.

- Configuration de l'environnement : fournit une configuration détaillée de l'environnement et un guide d'installation des dépendances.

Utiliser l'aide

Paramètres environnementaux

- Installer git-lfs :

sudo apt-get install git-lfs

- L'environnement Conda est créé et activé :

conda create -n video_infer python=3.9

conda activate video_infer

- Installer les dépendances du projet :

pip install -r requirements.txt

Télécharger le modèle de poids

- Créer un répertoire pour stocker les poids pré-entraînés :

mkdir pretrained_weights

- Télécharger les poids magiques 1-pour-1 :

wget -O pretrained_weights/magic_1_for_1_weights.pth <model_weights_url>

- Téléchargez le composant "Hugging Face" :

huggingface-cli download tencent/HunyuanVideo --local_dir pretrained_weights --local_dir_use_symlinks False

huggingface-cli download xtuner/llava-llama-3-8b-v1_1-transformers --local_dir pretrained_weights/text_encoder --local_dir_use_symlinks False

huggingface-cli download openai/clip-vit-large-patch14 --local_dir pretrained_weights/text_encoder_2 --local_dir_use_symlinks False

Générer une vidéo

- Exécutez les commandes suivantes pour la génération de texte et d'image-vidéo :

python test_ti2v.py --config configs/test/text_to_video/4_step_ti2v.yaml --quantization False

- Ou utilisez le script fourni :

bash scripts/generate_video.sh

Fonction détaillée du déroulement des opérations

- Génération d'images à partir de textesDescription textuelle : Saisissez une description textuelle et le modèle générera une image correspondante.

- Génération d'images en vidéoLes images générées sont introduites dans le module de génération vidéo afin de générer de courts clips vidéo.

- Utilisation efficace de la mémoireLe système de gestion de l'information de l'entreprise : Il garantit un fonctionnement efficace même dans les environnements à GPU unique en optimisant l'utilisation de la mémoire.

- déduction rapideLe projet de loi sur la protection de l'environnement de l'Union européenne (UE) a pour objectif de réduire le délai d'inférence et de permettre une génération rapide de vidéos pour les scénarios qui nécessitent une génération rapide de vidéos courtes.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...