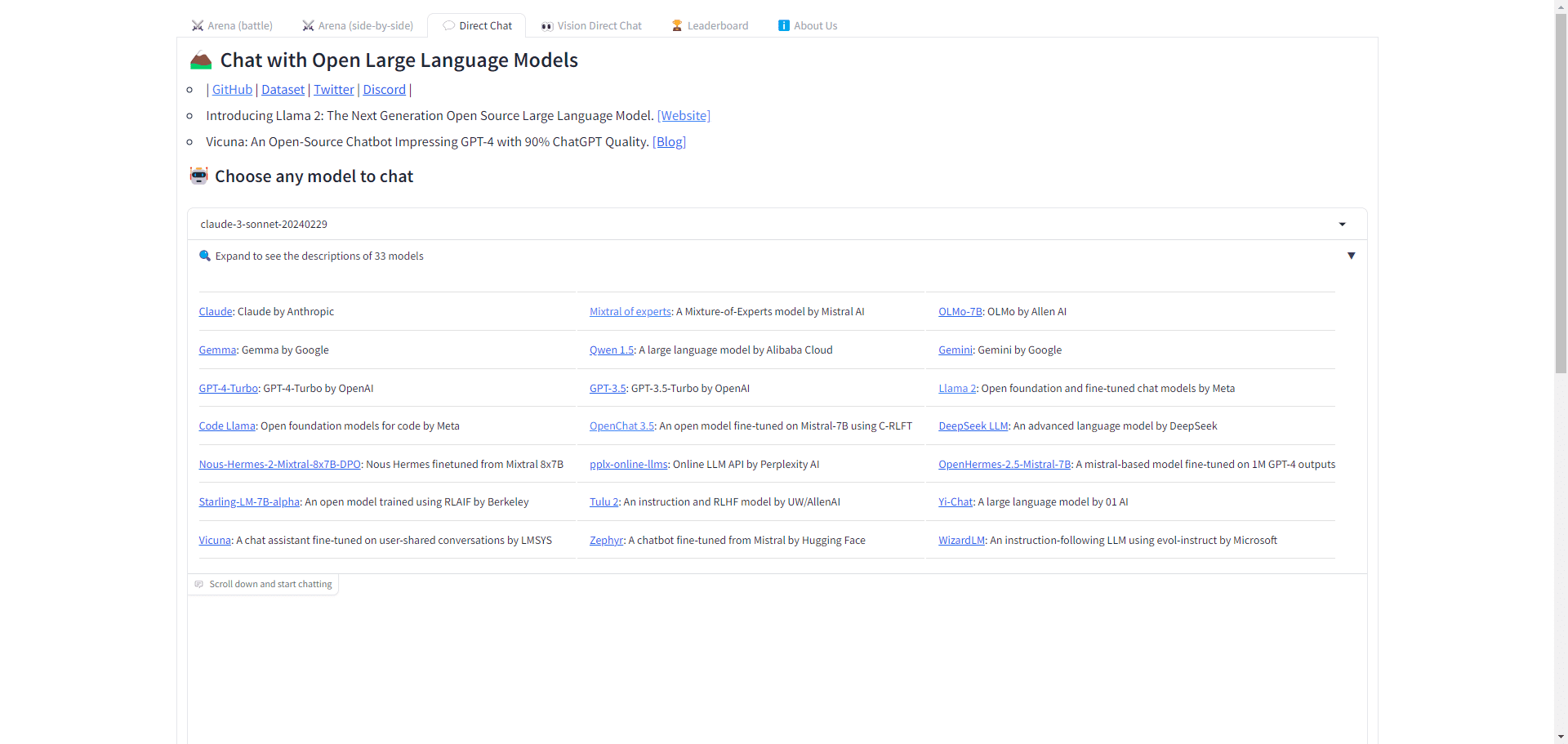

Chatbot Arena (LMSYS) : une plateforme compétitive en ligne pour l'évaluation comparative de grands modèles de langage et la comparaison des performances de plusieurs modèles.

Introduction générale

LMSYS Org, connue sous le nom de Large Model Systems Organization, est une organisation de recherche ouverte cofondée par des étudiants et des professeurs de l'université de Californie à Berkeley, en collaboration avec l'université de Californie à San Diego et l'université Carnegie Mellon. L'objectif de l'organisation est de rendre les grands modèles accessibles à tous en codéveloppant des modèles, des ensembles de données, des systèmes et des outils d'évaluation ouverts.

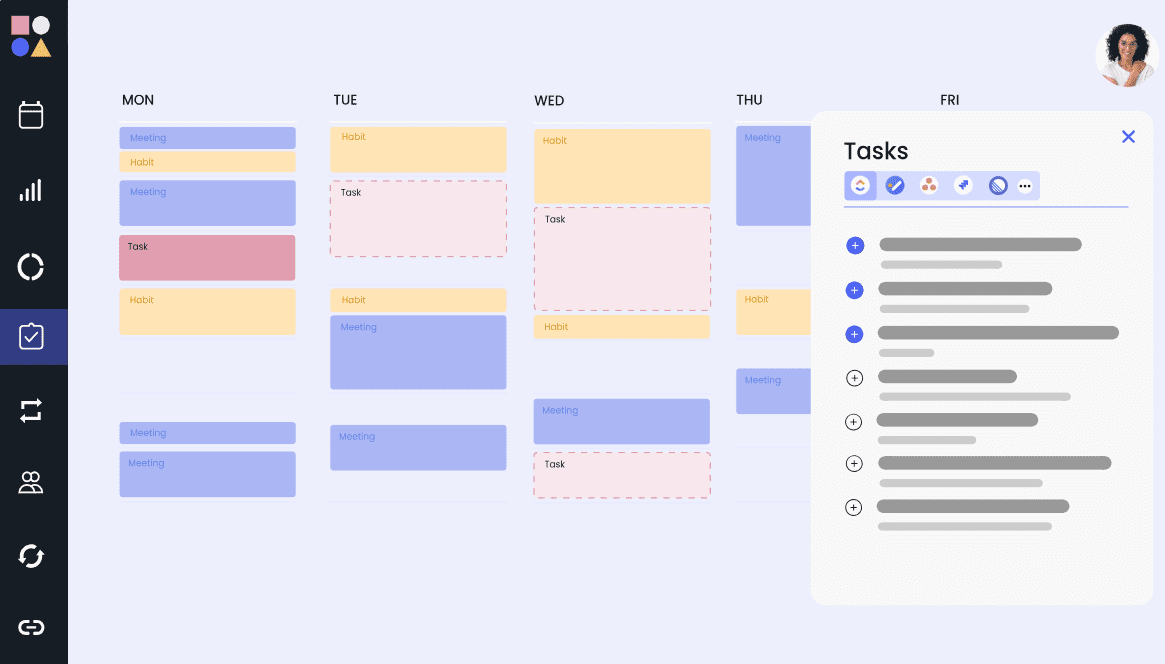

Chatbot Arena est une plateforme en ligne axée sur l'étalonnage et la comparaison des performances de différents grands modèles de langage (LLM). La plateforme a été créée par des chercheurs pour fournir aux utilisateurs un environnement anonyme et aléatoire leur permettant d'interagir et d'évaluer différents chatbots d'IA côte à côte. Grâce à des analyses détaillées de la qualité, des performances et des prix, Chatbot Arena aide les utilisateurs à trouver la solution d'IA qui répond le mieux à leurs besoins.

Modèle PK : https://lmarena.ai/

Liste des fonctions

- Vicuna : un chatbot avec la qualité 90% ChatGPT, disponible dans les tailles 7B/13B/33B.

- Chatbot Arena : évaluation évolutive et ludique des LLM grâce au crowdsourcing et au système d'évaluation Elo.

- SGLang : interface efficace et moteur d'exécution pour les programmes LLM complexes.

- LMSYS-Chat-1M : un ensemble de données à grande échelle de dialogues LLM réels.

- FastChat : une plateforme ouverte pour la formation, le service et l'évaluation des chatbots basés sur le LLM.

- MT-Bench : un ensemble de questions stimulantes, multirondes et ouvertes pour l'évaluation des chatbots.

Utiliser l'aide

- comparaison des modèles: :

- Visitez la page de comparaison des modèles.

- Sélectionnez les modèles que vous souhaitez comparer et cliquez sur le bouton "Ajouter à la comparaison".

- Consultez les résultats des comparaisons, y compris la qualité, la performance, le prix et d'autres paramètres.

- le contrôle de la qualité: :

- Consultez les résultats des tests de qualité sur la page Détails du modèle.

- En savoir plus sur les scores et les classements spécifiques pour les différentes dimensions du test.

- Analyse des prix: :

- Sur la page des détails du modèle, consultez l'analyse des prix.

- Comparez les prix des différents modèles pour trouver l'option la plus rentable.

- Évaluation des performances: :

- Sur la page Détails du modèle, affichez les résultats de l'évaluation des performances.

- Comprendre la vitesse de sortie du modèle, la latence et d'autres paramètres de performance.

- analyse de la fenêtre contextuelle: :

- Sur la page Détails du modèle, affichez l'analyse de la fenêtre de contexte.

- Comprendre la taille de la fenêtre contextuelle du modèle pour différents scénarios d'application.

En suivant ces étapes, les utilisateurs peuvent acquérir une compréhension globale des performances et des caractéristiques des différents modèles linguistiques à grande échelle et faire le choix qui répond le mieux à leurs besoins.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...