LLaMA Factory : mise au point efficace de plus d'une centaine de macromodèles open-source, personnalisation aisée des modèles

Introduction générale

LLaMA-Factory est un cadre unifié et efficace de réglage fin qui permet une personnalisation flexible et un entraînement efficace de plus de 100 grands modèles de langage (LLM). L'interface web intégrée LLaMA Board permet aux utilisateurs d'affiner les modèles sans écrire de code. Le cadre intègre une variété de méthodes d'entraînement avancées et de conseils pratiques pour améliorer de manière significative la vitesse d'entraînement et l'utilisation de la mémoire du GPU.

Liste des fonctions

- Prise en charge de plusieurs modèlesSupport pour LLaMA, LLaVA, Mistral, Qwen et d'autres modèles multilingues.

- Méthodes de formation multiplesLes services d'assistance technique de la Commission européenne sont les suivants : ils comprennent l'élagage de tout le volume, l'élagage de congélation, le LoRA, le QLoRA, etc.

- algorithme efficaceIntégration de GaLore, BAdam, Adam-mini, DoRA et d'autres algorithmes avancés.

- compétence pratiqueSupport pour FlashAttention-2, Unsloth, Liger Kernel, et plus encore.

- Suivi expérimentalLlamaBoard : fournit des outils de surveillance tels que LlamaBoard, TensorBoard, Wandb, MLflow, et plus encore.

- déduction rapide: fournit des API de type OpenAI, l'interface utilisateur Gradio et des interfaces CLI.

- Soutien aux ensembles de donnéesSupport pour le téléchargement de modèles pré-entraînés et d'ensembles de données à partir de HuggingFace, ModelScope et d'autres plateformes.

Utiliser l'aide

Processus d'installation

- Cloner le code du projet :

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

- Installer la dépendance :

pip install -e ".[torch,metrics]"

Les dépendances optionnelles incluent : torch, torch-npu, metrics, deepspeed, liger-kernel, bitsandbytes, et plus encore.

Préparation des données

veuillez vous référer à data/README.md En savoir plus sur le format de fichier des jeux de données. Vous pouvez utiliser les jeux de données sur le hub HuggingFace / ModelScope / Modelers, ou charger des jeux de données sur votre disque local.

Démarrage rapide

Utilisez les commandes suivantes pour exécuter LoRA afin d'affiner, de raisonner et de fusionner les modèles Llama3-8B-Instruct :

llamafactory-cli train examples/train_lora/llama3_lora_sft.yaml

llamafactory-cli chat examples/inference/llama3_lora_sft.yaml

llamafactory-cli export examples/merge_lora/llama3_lora_sft.yaml

Pour une utilisation plus avancée, voir examples/README.md.

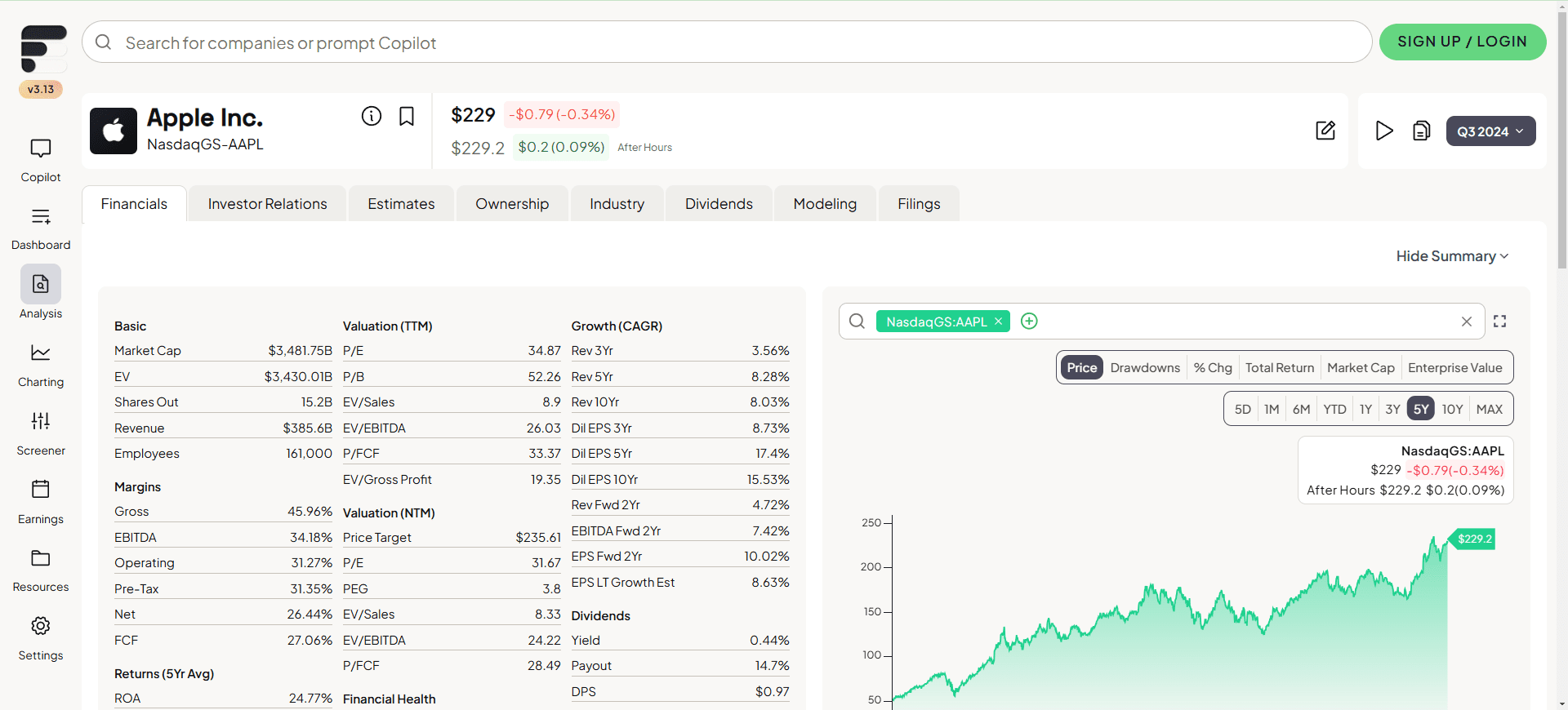

Utilisation de l'interface graphique de la carte LLaMA

La mise au point est effectuée par le biais de l'interface graphique de la carte LLaMA fournie par Gradio :

llamafactory-cli webui

Déploiement Docker

Pour les utilisateurs de CUDA :

cd docker/docker-cuda/

docker compose up -d

docker compose exec llamafactory bash

Pour les utilisateurs d'Ascend NPU :

cd docker/docker-npu/

docker compose up -d

docker compose exec llamafactory bash

Pour les utilisateurs d'AMD ROCm :

cd docker/docker-rocm/

docker compose up -d

docker compose exec llamafactory bash

Déploiement de l'API

Utiliser des API de type OpenAI et vLLM Raisonnement :

API_PORT=8000 llamafactory-cli api examples/inference/llama3_vllm.yaml

Consultez cette page pour obtenir la documentation de l'API.

Télécharger les modèles et les ensembles de données

Si vous avez des difficultés à télécharger les modèles et les ensembles de données de Hugging Face, vous pouvez utiliser ModelScope :

export USE_MODELSCOPE_HUB=1

Former un modèle en spécifiant l'ID du modèle du Hub ModelScope, par exemple LLM-Research/Meta-Llama-3-8B-Instruct.

Enregistrement des résultats expérimentaux avec W&B

Pour utiliser Poids & Biases enregistre les résultats de l'expérience avec les paramètres suivants dans le fichier yaml :

wandb:

project: "your_project_name"

entity: "your_entity_name"

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...