Llama 3 : une famille de modèles d'IA polyvalents et libres

Résumés.

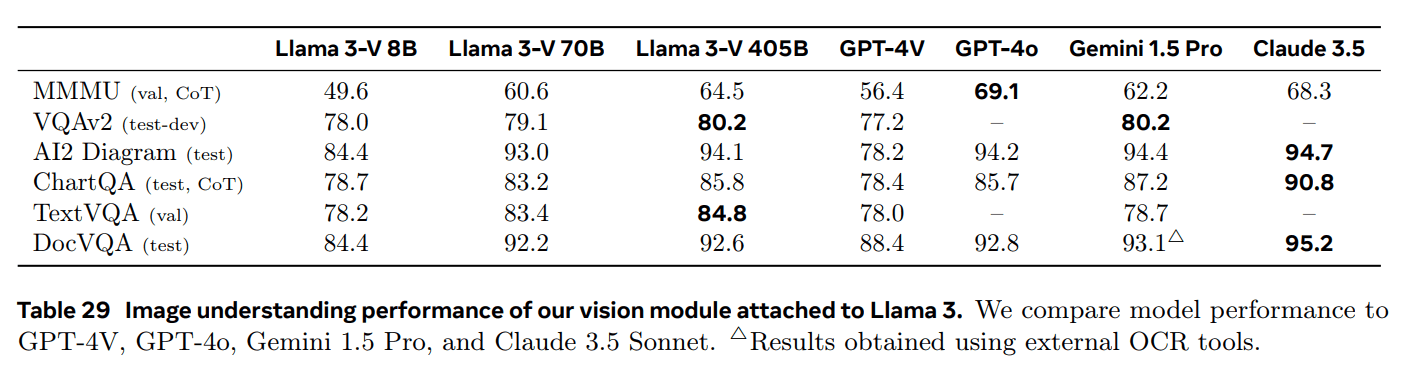

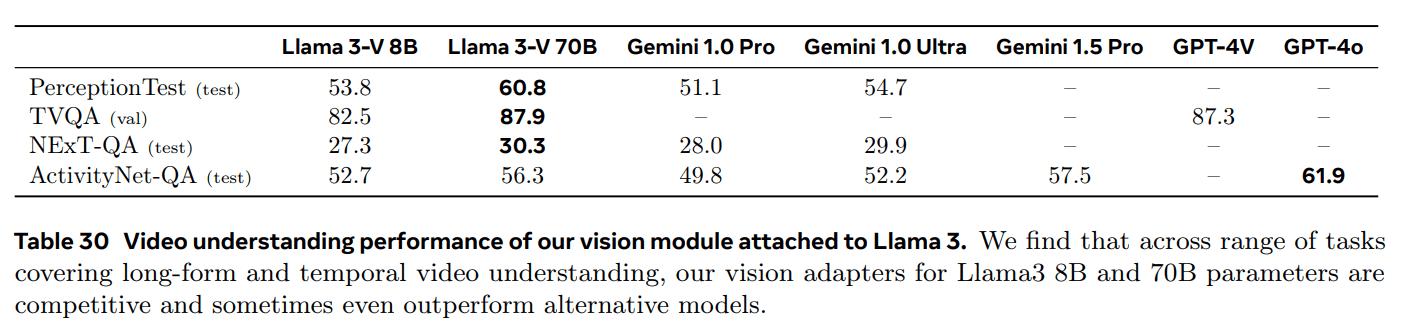

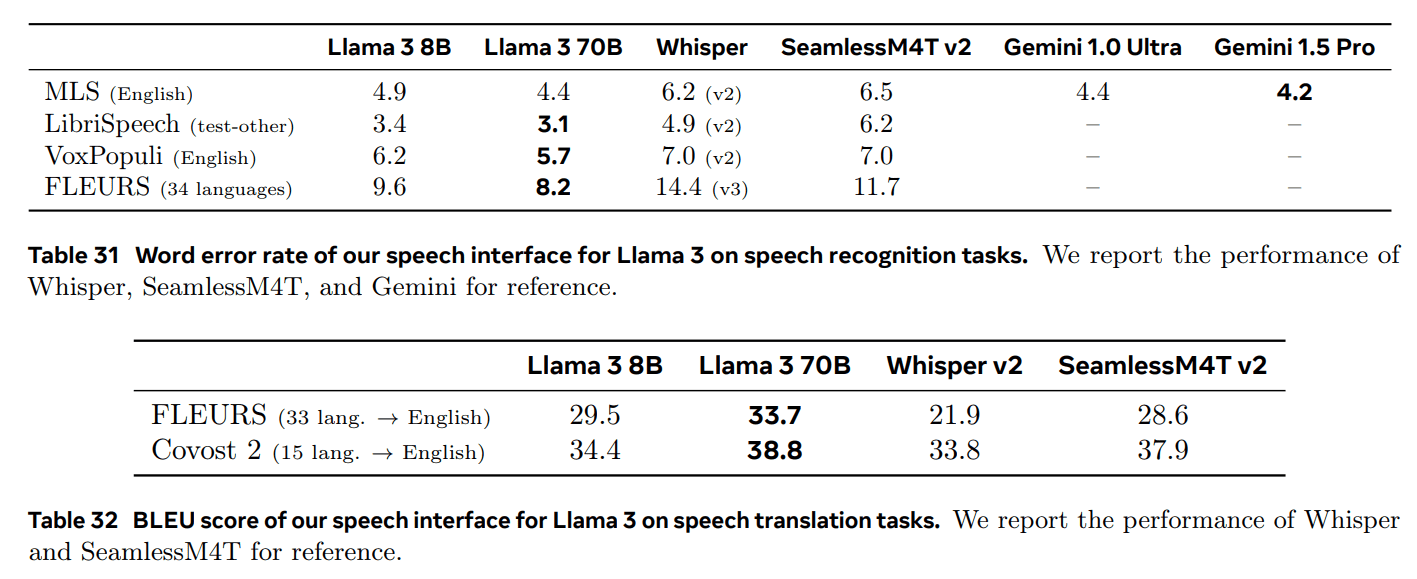

Cet article présente un nouvel ensemble de modèles de base appelé Llama 3. Llama 3 est une communauté de modèles de langage qui soutient intrinsèquement le multilinguisme, l'écriture de code, le raisonnement et l'utilisation d'outils. Notre plus grand modèle est un transformateur dense avec 405 milliards de paramètres et une fenêtre de contexte pouvant contenir jusqu'à 128 000 tokens. Cet article réalise une série d'évaluations empiriques de Llama 3. Les résultats montrent que Llama 3 atteint une qualité comparable à celle des principaux modèles de langage tels que GPT-4 dans de nombreuses tâches. Nous mettons Llama 3 à la disposition du public, y compris les modèles de langage 405 milliards de paramètres pré-entraînés et post-entraînés, ainsi que le modèle Llama Guard 3 pour la sécurité des entrées-sorties. Cet article présente également des résultats expérimentaux sur l'intégration de caractéristiques d'image, de vidéo et de parole dans Llama 3 par le biais d'une approche combinatoire. Nous observons que cette approche est compétitive par rapport aux approches de pointe pour les tâches de reconnaissance d'image, de vidéo et de parole. Ces modèles étant encore en phase de développement, ils n'ont pas fait l'objet d'une large publication.

Texte intégral à télécharger pdf :

1722344341-Llama_3.1 paper : a versatile, open-source _AI_ model family (version chinoise)

1 Introduction

modèle de basesont des modèles généraux du langage, de la vision, de la parole et d'autres modalités, conçus pour prendre en charge un large éventail de tâches d'intelligence artificielle. Ils constituent la base de nombreux systèmes d'IA modernes.

L'élaboration d'un modèle de base moderne se divise en deux phases principales :

(1) Phase de préformation. Les modèles sont entraînés sur des quantités massives de données, en utilisant des tâches simples telles que la prédiction de mots ou la génération d'annotations de graphiques ;

(2) Phase post-formation. Les modèles sont affinés pour suivre les instructions, s'aligner sur les préférences humaines et améliorer des capacités spécifiques (par exemple, le codage et le raisonnement).

Cet article présente un nouvel ensemble de modèles de base linguistique appelé Llama 3. La famille de modèles Llama 3 Herd prend intrinsèquement en charge le multilinguisme, l'encodage, le raisonnement et l'utilisation d'outils. Notre plus grand modèle est un transformateur dense avec 405B paramètres, capable de traiter des informations dans des fenêtres contextuelles allant jusqu'à 128K tokens.

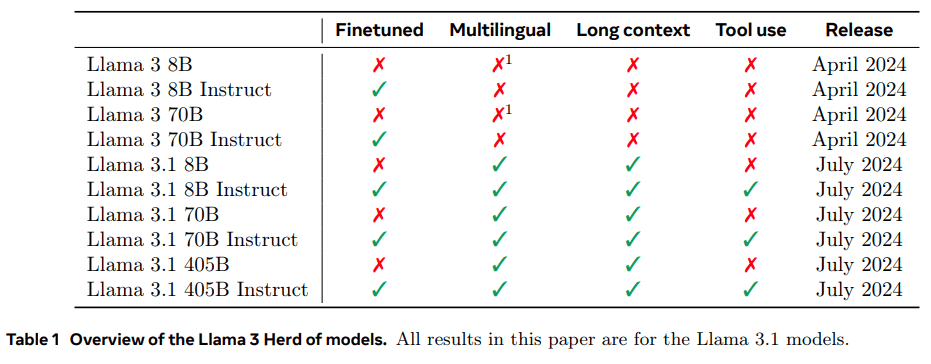

Le tableau 1 présente chaque membre du troupeau. Tous les résultats présentés dans ce document sont basés sur le modèle Llama 3.1 (Llama 3 en abrégé).

Nous pensons que les trois outils clés pour développer des modèles de base de haute qualité sont la gestion des données, de l'échelle et de la complexité. Nous nous efforcerons d'optimiser ces trois domaines au cours de notre processus de développement :

- Données. La quantité et la qualité des données que nous avons utilisées pour le pré-entraînement et le post-entraînement ont été améliorées par rapport aux versions précédentes de Llama (Touvron et al., 2023a, b). Ces améliorations comprennent le développement de pipelines de pré-traitement et de curation plus prudents pour les données de pré-entraînement et le développement d'une assurance qualité et d'un filtrage plus rigoureux. Ces améliorations comprennent le développement de pipelines de prétraitement et de curation plus prudents pour les données de pré-entraînement et le développement d'une assurance qualité et d'un filtrage plus rigoureux. Llama 3 a été pré-entraîné sur un corpus d'environ 15T tokens multilingues, tandis que Llama 2 a été pré-entraîné sur 1,8T tokens.

- Champ d'application. Nous avons formé un modèle plus grand que le modèle Llama précédent : notre modèle linguistique phare utilise 3,8 × 1025 FLOPs pour le pré-entraînement, soit près de 50 fois plus que la plus grande version de Llama 2. Plus précisément, nous avons pré-entraîné un modèle phare avec 405B paramètres entraînables sur 15,6T tokens de texte. Comme prévu, le modèle

- Gérer la complexité. Les choix de conception que nous avons faits visaient à maximiser l'évolutivité du processus de développement du modèle. Par exemple, nous avons choisi un modèle standard dense Transformateur (Vaswani et al., 2017) avec quelques ajustements mineurs, plutôt que d'utiliser un modèle de mélange expert (Shazeer et al., 2017) pour maximiser la stabilité de l'entraînement. De même, nous avons utilisé un post-processeur relativement simple basé sur le réglage fin supervisé (SFT), l'échantillonnage par rejet (RS) et l'optimisation directe des préférences (DPO ; Rafailov et al. (2023)), plutôt que des algorithmes d'apprentissage par renforcement plus complexes (Ouyang et al., 2022 ; Schulman et al., 2017), qui sont souvent moins stables et difficiles à mettre à l'échelle. difficiles à mettre à l'échelle.

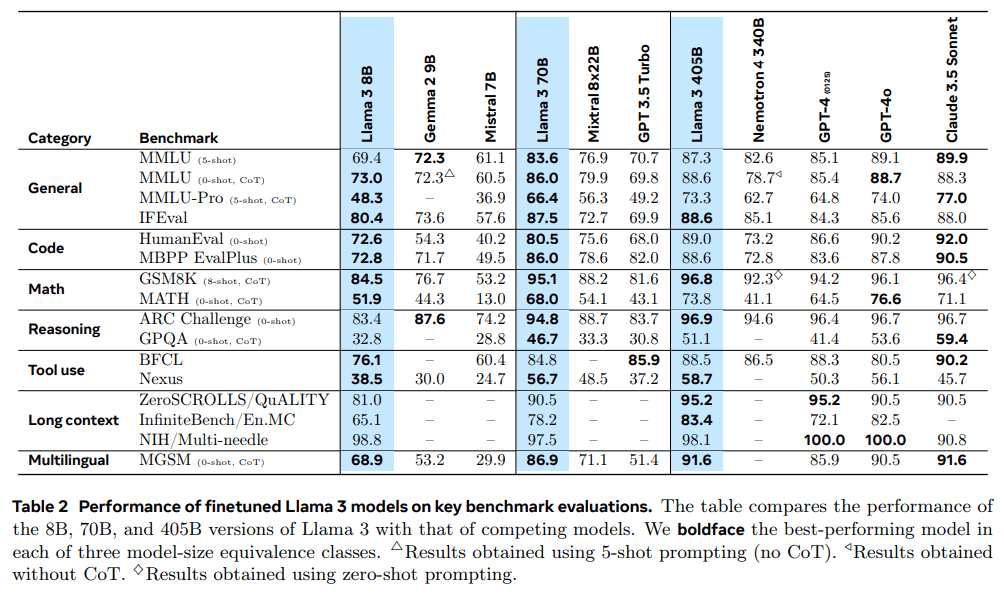

Le résultat de notre travail est Llama 3 : un multilingue à trois langues avec des paramètres de 8B, 70B et 405B.1population de modèles de langage. Nous avons évalué les performances de Llama 3 sur un grand nombre d'ensembles de données de référence couvrant un large éventail de tâches de compréhension du langage. En outre, nous avons réalisé des évaluations manuelles approfondies comparant Llama 3 à des modèles concurrents. Le tableau 2 donne un aperçu des performances du modèle phare Llama 3 dans les principaux tests de référence. Nos évaluations expérimentales montrent que notre modèle phare est au même niveau que les principaux modèles de langage tels que GPT-4 (OpenAI, 2023a) et proche de l'état de l'art sur une variété de tâches. Notre plus petit modèle est le meilleur de sa catégorie et surpasse d'autres modèles avec un nombre similaire de paramètres (Bai et al., 2023 ; Jiang et al., 2023).Llama 3 trouve également un meilleur équilibre entre l'utilité et l'innocuité que son prédécesseur (Touvron et al., 2023b). Nous analysons la sécurité de Llama 3 en détail dans la section 5.4.

Nous publions les trois modèles Llama 3 sous une version mise à jour de la licence communautaire Llama 3 ; voir https://llama.meta.com. Cela inclut des versions pré-entraînées et post-traitées de notre modèle de langage paramétrique 405B, ainsi qu'une nouvelle version du modèle Llama Guard (Inan et al., 2023) pour la sécurité des entrées et des sorties. d'entrée et de sortie. Nous espérons que la publication d'un modèle phare inspirera une vague d'innovation dans la communauté des chercheurs et accélérera les progrès vers un développement responsable de l'intelligence artificielle (AGI).

Multilingue : il s'agit de la capacité du modèle à comprendre et à générer du texte dans plusieurs langues.

Au cours du développement de Llama 3, nous avons également développé des extensions multimodales du modèle pour permettre la reconnaissance d'images, la reconnaissance vidéo et la compréhension de la parole. Ces modèles sont toujours en cours de développement et ne sont pas encore prêts à être diffusés. Outre les résultats de la modélisation linguistique, ce document présente les résultats de nos premières expériences avec ces modèles multimodaux.

Llama 3 8B et 70B ont été pré-entraînés sur des données multilingues, mais ont été principalement utilisés pour l'anglais à l'époque.

2 Généralités

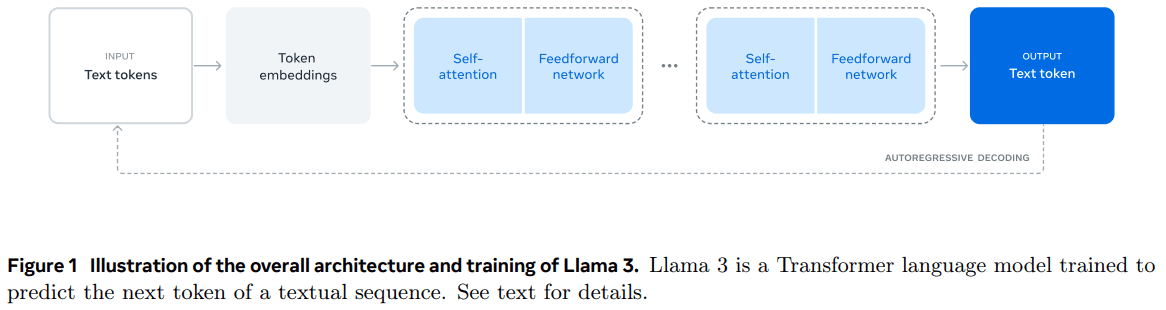

L'architecture du modèle Llama 3 est présentée à la figure 1. Le développement de notre modèle linguistique Llama 3 est divisé en deux phases principales :

- Pré-entraînement du modèle linguistique.Nous convertissons d'abord un grand corpus de textes multilingues en jetons discrets et pré-entraînons un grand modèle de langage (LLM) sur les données résultantes pour la prédiction du jeton suivant. Dans la phase de pré-entraînement du LLM, le modèle apprend la structure de la langue et acquiert une grande quantité de connaissances sur le monde à partir du texte qu'il "lit". Pour faire cela efficacement, le pré-entraînement est fait à l'échelle : nous avons pré-entraîné un modèle avec 405B paramètres sur un modèle avec 15.6T tokens, en utilisant une fenêtre de contexte de 8K tokens. Cette phase de pré-entraînement standard est suivie d'une phase de pré-entraînement continu, qui augmente la fenêtre contextuelle supportée à 128K tokens. Voir la section 3 pour plus d'informations.

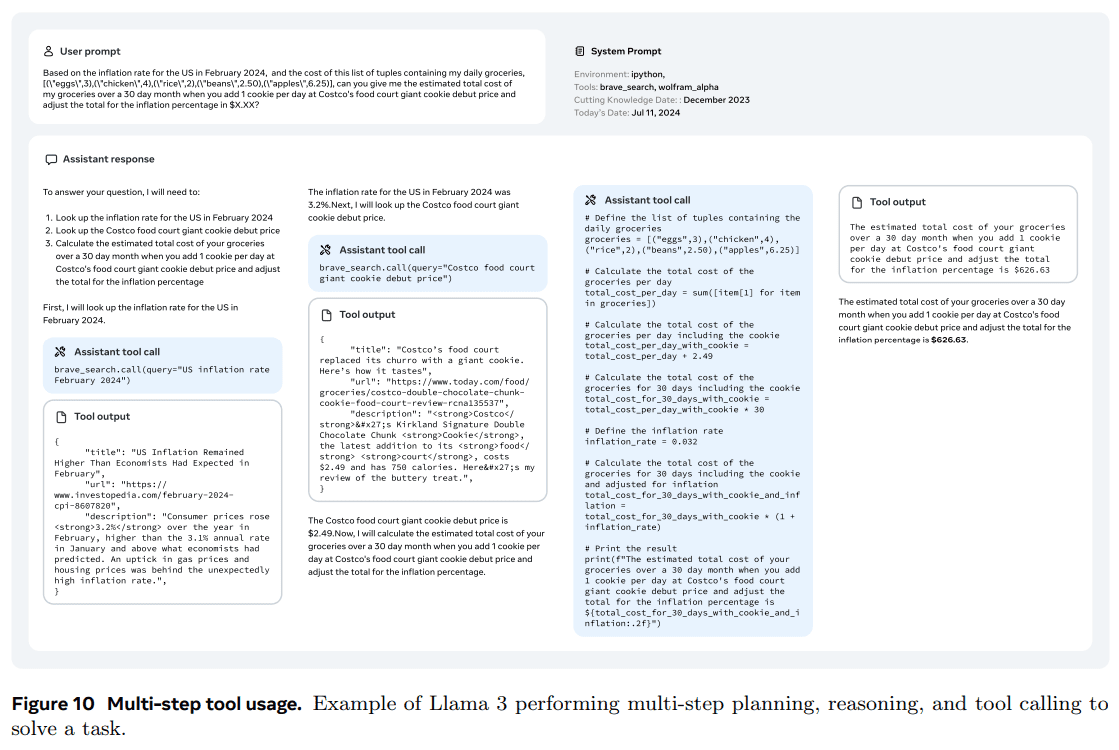

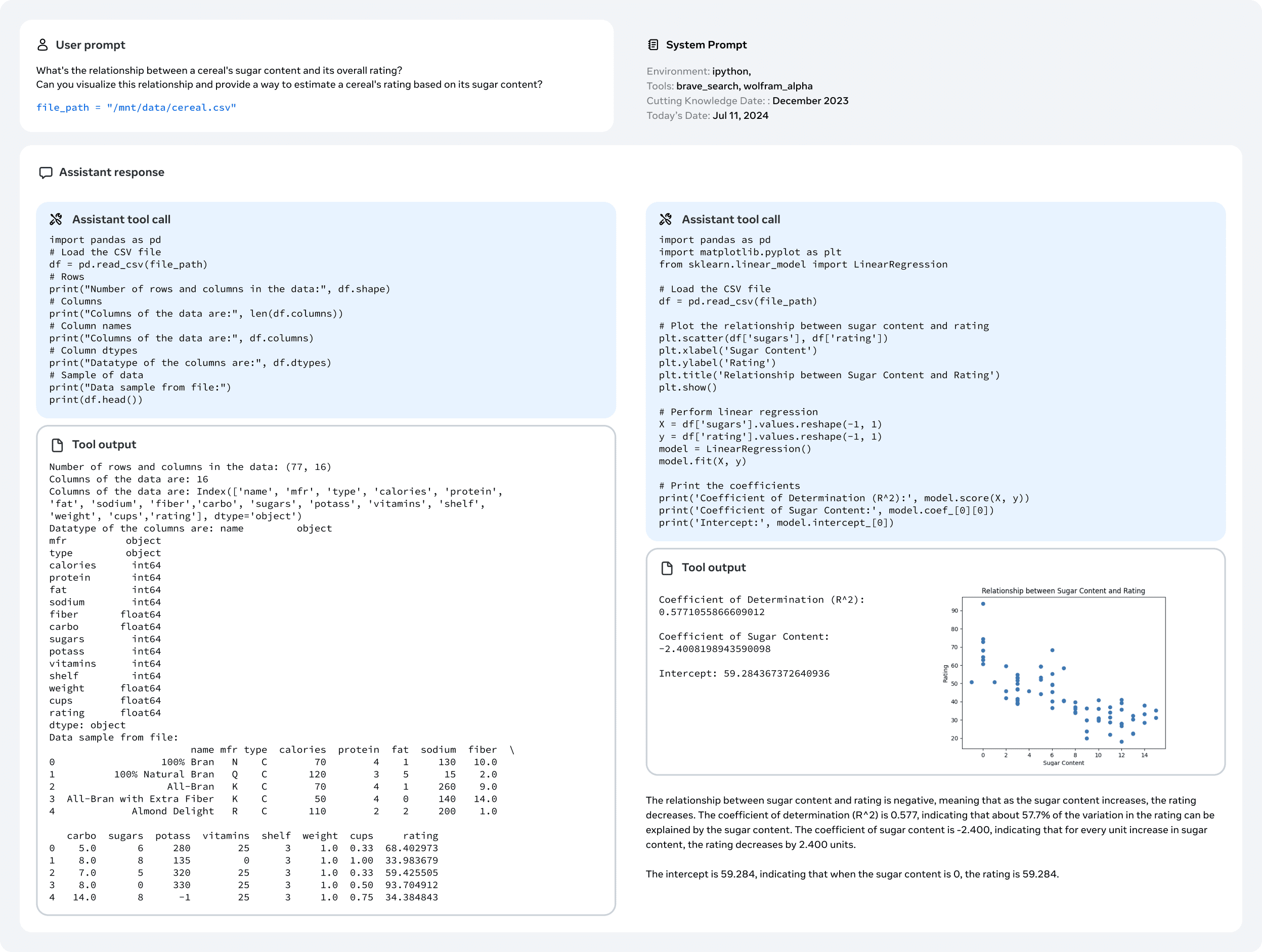

- Formation post-modèle.Le modèle linguistique pré-entraîné a une compréhension approfondie de la langue, mais il n'a pas encore suivi les instructions ou ne s'est pas comporté comme l'assistant que nous attendons de lui. Nous avons calibré le modèle grâce au retour d'information humain en plusieurs étapes, chacune comprenant un réglage fin supervisé (SFT) et une optimisation directe des préférences (DPO ; Rafailov et al., 2024) sur des données réglées sur les instructions. Dans cette phase de post-entraînement, nous avons également intégré de nouvelles caractéristiques, telles que l'utilisation d'outils, et observé des améliorations significatives dans des domaines tels que le codage et l'inférence. Pour plus d'informations, voir la section 4. Enfin, les mesures d'atténuation de la sécurité sont également intégrées au modèle dans la phase de post-entraînement, dont les détails sont décrits à la section 5.4. Les modèles générés sont riches en fonctionnalités. Ils sont capables de répondre à des questions dans au moins huit langues, d'écrire un code de haute qualité, de résoudre des problèmes d'inférence complexes et d'utiliser des outils prêts à l'emploi ou à partir d'un échantillon zéro.

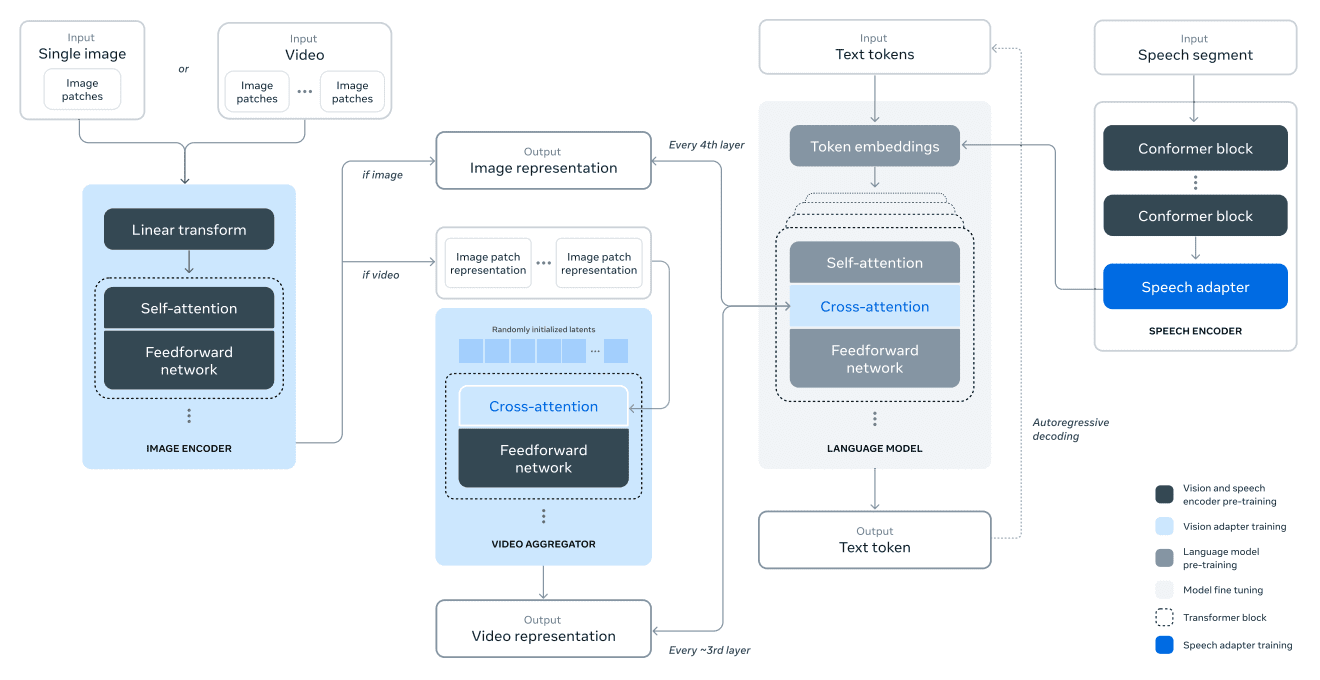

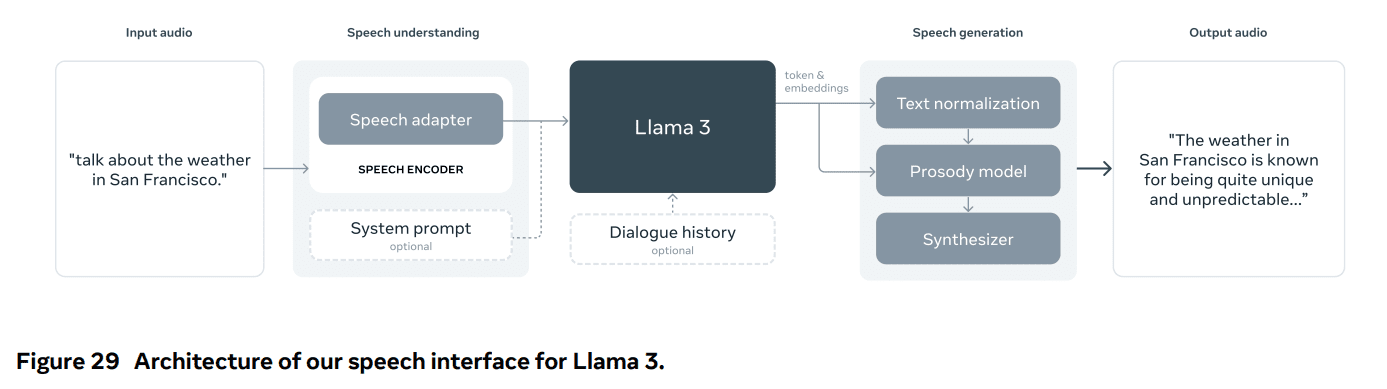

Nous menons également des expériences pour ajouter des capacités d'image, de vidéo et de voix au Llama 3 par le biais d'une approche combinée. L'approche que nous étudions consiste en trois phases supplémentaires illustrées à la figure 28 :

- Pré-entraînement de l'encodeur multimodal.Nous formons des codeurs distincts pour l'image et la parole. Nous entraînons le codeur d'image sur un grand nombre de paires image-texte. Cela permet au modèle d'apprendre la relation entre le contenu visuel et sa description en langage naturel. Notre codeur vocal utilise une méthode auto-supervisée qui masque une partie de l'entrée vocale et tente de reconstruire la partie masquée par le biais d'une représentation discrète des marqueurs. Ainsi, le modèle apprend la structure du signal vocal. Voir la section 7 pour plus d'informations sur les codeurs d'images et la section 8 pour plus d'informations sur les codeurs vocaux.

- Formation d'adaptateur visuel.Nous formons un adaptateur qui intègre un codeur d'images préformé avec un modèle de langage préformé. L'adaptateur se compose d'une série de couches d'attention croisée qui introduisent la représentation de l'encodeur d'images dans le modèle linguistique. L'adaptateur est entraîné sur des paires texte-image, ce qui permet d'aligner la représentation de l'image sur celle du langage. Pendant la formation de l'adaptateur, nous mettons également à jour les paramètres de l'encodeur d'images, mais nous ne mettons pas intentionnellement à jour les paramètres du modèle linguistique. Nous formons également un adaptateur vidéo au-dessus de l'adaptateur image, en utilisant des données vidéo-texte appariées. Cela permet au modèle d'agréger les informations entre les images. Pour plus d'informations, voir la section 7.

- Enfin, nous intégrons l'encodeur vocal dans le modèle par le biais d'un adaptateur qui convertit le codage vocal en une représentation étiquetée qui peut être introduite directement dans le modèle linguistique affiné. Au cours de la phase d'ajustement supervisé, les paramètres de l'adaptateur et de l'encodeur sont mis à jour conjointement afin d'obtenir une compréhension vocale de haute qualité. Nous ne modifions pas le modèle linguistique pendant la formation de l'adaptateur vocal. Nous intégrons également un système de synthèse vocale. Voir la section 8 pour plus de détails.

Nos expériences multimodales ont abouti à des modèles qui reconnaissent le contenu des images et des vidéos et permettent une interaction par le biais d'une interface vocale. Ces modèles sont encore en cours de développement et ne sont pas encore prêts à être diffusés.

3 Préformation

Le pré-entraînement des modèles linguistiques comprend les aspects suivants :

(1) Collecte et filtrage de corpus de formation à grande échelle ;

(2) Développement d'architectures de modèles et de lois d'échelle correspondantes pour déterminer la taille du modèle ;

(3) Développement de techniques pour un pré-entraînement efficace à grande échelle ;

(4) l'élaboration d'un programme de préformation. Nous décrivons ci-dessous chacun de ces éléments.

3.1 Données de pré-entraînement

Nous avons créé des ensembles de données de pré-entraînement de modèles linguistiques à partir de diverses sources de données contenant des connaissances jusqu'à la fin de l'année 2023. Nous avons appliqué plusieurs méthodes de déduplication et mécanismes de nettoyage des données à chaque source de données afin d'obtenir un étiquetage de haute qualité. Nous avons supprimé les domaines contenant de grandes quantités d'informations personnelles identifiables (PII), ainsi que les domaines connus pour leur contenu adulte.

3.11 Nettoyage des données sur le web

La plupart des données que nous utilisons proviennent du web et nous décrivons notre processus de nettoyage ci-dessous.

Filtrage des IIP et de la sécurité. Entre autres mesures, nous avons mis en place des filtres conçus pour supprimer les données des sites web susceptibles de contenir des contenus dangereux ou de grandes quantités d'informations personnelles, des domaines classés comme dangereux selon diverses normes de sécurité Meta, et des domaines connus pour leur contenu pour adultes.

Extraction et nettoyage de textes. Nous traitons le contenu HTML brut pour en extraire un texte diversifié de haute qualité et nous utilisons à cette fin des documents web non tronqués. Pour ce faire, nous avons construit un analyseur personnalisé qui extrait le contenu HTML et optimise la précision de la suppression des modèles et le rappel du contenu. Nous avons évalué la qualité de l'analyseur par le biais d'une évaluation manuelle et l'avons comparé à des analyseurs HTML tiers populaires optimisés pour le contenu d'articles similaires. Nous prenons soin de préserver la structure des pages HTML contenant des mathématiques et du code. Nous conservons le texte de l'attribut alt de l'image car le contenu mathématique est généralement représenté sous la forme d'une image pré-rendue où les mathématiques sont également fournies dans l'attribut alt.

Nous avons constaté que Markdown nuisait aux performances du modèle, qui a été principalement formé sur des données Web, par rapport au texte brut, et nous avons donc supprimé toutes les balises Markdown.

Désaccentuation. Nous appliquons plusieurs cycles de dédoublonnage au niveau de l'URL, du document et de la ligne :

- Déduplication au niveau de l'URL. Nous effectuons une déduplication au niveau de l'URL sur l'ensemble de la base de données. Pour chaque page correspondant à une URL, nous conservons la dernière version.

- Déduplication au niveau du document. Nous effectuons un dédoublonnage global MinHash (Broder, 1997) sur l'ensemble de la base de données afin de supprimer les documents en quasi-doublement.

- Déduplication au niveau des lignes. Nous effectuons un dédoublonnage au niveau radical similaire à ccNet (Wenzek et al., 2019). Nous supprimons les lignes qui apparaissent plus de 6 fois dans chaque groupe contenant 30 millions de documents.

Bien que nos analyses qualitatives manuelles suggèrent que le dédoublonnage au niveau des lignes supprime non seulement le contenu résiduel de type "boilerplate" d'une variété de sites (par exemple, les menus de navigation, les avertissements relatifs aux cookies), mais aussi des textes fréquents de haute qualité, nos évaluations empiriques révèlent des améliorations significatives.

Filtrage heuristique. Des heuristiques ont été développées pour éliminer les documents supplémentaires de faible qualité, les documents aberrants et les documents comportant trop de répétitions. Voici quelques exemples d'heuristiques :

- Nous utilisons la couverture des n-tuplets dupliqués (Rae et al., 2021) pour supprimer les lignes constituées d'un contenu dupliqué (par exemple, les journaux ou les messages d'erreur). Ces lignes peuvent être très longues et uniques, et ne peuvent donc pas être filtrées par la déduplication des lignes.

- Nous utilisons un compteur de "mots sales" (Raffel et al., 2020) pour filtrer les sites pour adultes qui ne sont pas couverts par la liste noire des domaines.

- Nous utilisons la dispersion de Kullback-Leibler de la distribution des jetons pour filtrer les documents contenant trop de jetons anormaux par rapport à la distribution du corpus de formation.

Filtrage de la qualité basé sur un modèle.

En outre, nous avons tenté d'utiliser divers classificateurs de qualité basés sur des modèles pour sélectionner des étiquettes de haute qualité. Ces méthodes sont les suivantes :

- Utiliser des classificateurs rapides tels que fasttext (Joulin et al., 2017), qui sont entraînés à reconnaître si un texte donné sera cité par Wikipédia (Touvron et al., 2023a).

- Un classificateur de modèle Roberta (Liu et al., 2019a), plus intensif en termes de calcul, a été utilisé, qui a été formé sur les prédictions du lama 2.

Pour entraîner le classificateur de qualité basé sur Llama 2, nous avons créé un ensemble de documents Web nettoyés décrivant les exigences de qualité et avons demandé au modèle de chat de Llama 2 de déterminer si les documents répondaient à ces exigences. Par souci d'efficacité, nous utilisons DistilRoberta (Sanh et al., 2019) pour générer des scores de qualité pour chaque document. Nous évaluerons expérimentalement l'efficacité de diverses configurations de filtrage de la qualité.

Code et données d'inférence.

Comme DeepSeek-AI et al. (2024), nous avons construit des pipelines spécifiques à un domaine pour extraire les pages web contenant du code et celles liées aux mathématiques. Plus précisément, les classificateurs de code et d'inférence sont des modèles DistilledRoberta entraînés à l'aide des données Web annotées par Llama 2. Contrairement aux classificateurs de qualité génériques mentionnés ci-dessus, nous effectuons un réglage des indices pour cibler les pages web contenant des inférences mathématiques, des raisonnements dans les domaines des STIM et du code intégré dans le langage naturel. Étant donné que les distributions de jetons du code et des mathématiques sont très différentes de celles du langage naturel, ces pipelines mettent en œuvre une extraction HTML spécifique au domaine, des caractéristiques de texte personnalisées et des heuristiques pour le filtrage.

Données multilingues.

Comme pour le pipeline de traitement en anglais décrit ci-dessus, nous mettons en œuvre des filtres pour supprimer les données des sites web susceptibles de contenir des informations personnelles identifiables (PII) ou un contenu non sécurisé. Notre pipeline de traitement de texte multilingue présente les caractéristiques uniques suivantes :

- Nous utilisons un modèle de reconnaissance linguistique basé sur un texte rapide pour classer les documents en 176 langues.

- Nous procédons à la déduplication des données au niveau des documents et des lignes pour chaque langue.

- Nous appliquons des heuristiques spécifiques à la langue et des filtres basés sur des modèles pour supprimer les documents de mauvaise qualité.

En outre, nous utilisons un classificateur multilingue basé sur Llama 2 pour classer la qualité des documents multilingues afin de garantir que le contenu de haute qualité est traité en priorité. Le nombre de tokens multilingues que nous utilisons dans la préformation est déterminé expérimentalement, et les performances du modèle sont équilibrées sur des tests de référence anglais et multilingues.

3.12 Détermination de la combinaison de données

为了获得高质量语言模型,必须谨慎确定预训练数据混合中不同数据源的比例。我们主要利用知识分类和尺度定律实验来确定这一数据混合。

知识分类。我们开发了一个分类器,用于对网页数据中包含的信息类型进行分类,以便更有效地确定数据组合。我们使用这个分类器对网页上过度代表的数据类别(例如艺术和娱乐)进行下采样。

为了确定最佳数据混合方案。我们进行规模定律实验,其中我们将多个小型模型训练于特定数据混合集上,并利用其预测大型模型在该混合集上的性能(参见第 3.2.1 节)。我们多次重复此过程,针对不同的数据混合集选择新的候选数据混合集。随后,我们在该候选数据混合集上训练一个更大的模型,并在多个关键基准测试上评估该模型的性能。

数据混合摘要。我们的最终数据混合包含大约 50% 的通用知识标记、25% 的数学和推理标记、17% 的代码标记以及 8% 的多语言标记。

3.13 Données de recuit

Les résultats empiriques montrent que le recuit sur une petite quantité de données de code et de mathématiques de haute qualité (voir la section 3.4.3) peut améliorer la performance des modèles pré-entraînés sur des tests de référence clés. Comme dans l'étude de Li et al. (2024b), nous effectuons un recuit en utilisant un ensemble de données mixte contenant des données de haute qualité provenant de domaines sélectionnés. Nos données recuites ne contiennent pas d'ensembles d'entraînement provenant de tests de référence couramment utilisés. Cela nous permet d'évaluer la véritable capacité d'apprentissage sur quelques échantillons et la généralisation hors domaine de Llama 3.

Suivant OpenAI (2023a), nous avons évalué l'effet du recuit sur les ensembles d'entraînement GSM8k (Cobbe et al., 2021) et MATH (Hendrycks et al., 2021b). Nous constatons que le recuit améliore les performances du modèle Llama 3 8B pré-entraîné de 24,0% et 6,4% sur les ensembles de validation GSM8k et MATH, respectivement.Cependant, l'amélioration est négligeable pour le modèle 405B, ce qui suggère que notre modèle phare a de fortes capacités d'apprentissage et d'inférence contextuelles, et qu'il ne nécessite pas d'échantillons d'entraînement spécifiques au domaine pour atteindre des performances robustes.

Utiliser le recuit pour évaluer la qualité des données.Comme Blakeney et al. (2024), nous constatons que le recuit nous permet de juger de la valeur de petits ensembles de données spécifiques à un domaine. Nous mesurons la valeur de ces ensembles de données en recuisant linéairement le taux d'apprentissage du modèle Llama 3 8B, qui a été formé avec 50%, à 0 sur 40 milliards de tokens. Dans ces expériences, nous attribuons des pondérations de 30% au nouvel ensemble de données et les pondérations restantes de 70% à l'ensemble de données par défaut. Il est plus efficace d'utiliser le recuit pour évaluer les nouvelles sources de données que d'effectuer des expériences de loi d'échelle sur chaque petit ensemble de données.

3.2 Architecture du modèle

Llama 3 utilise l'architecture standard du transformateur dense (Vaswani et al., 2017). L'architecture de son modèle n'est pas significativement différente de celle de Llama et Llama 2 (Touvron et al., 2023a, b) ; nos gains de performance proviennent principalement de l'amélioration de la qualité et de la diversité des données, ainsi que de l'augmentation de la taille de l'entraînement.

Nous avons apporté quelques modifications mineures :

- Nous utilisons Grouped Query Attention (GQA ; Ainslie et al. (2023)), où 8 en-têtes de valeur-clé sont utilisés pour augmenter la vitesse d'inférence et réduire la taille du cache de valeur-clé pendant le décodage.

- Nous utilisons un masque d'attention pour empêcher les mécanismes d'auto-attention entre les différents documents de la séquence. Nous constatons que ce changement a un impact limité lors d'un pré-entraînement standard, mais qu'il est important lors d'un pré-entraînement continu de très longues séquences.

- Nous utilisons un vocabulaire de 128 000 tokens. Notre vocabulaire tokenisé combine les 100K tokens du vocabulaire tiktoken3 avec 28K tokens supplémentaires pour mieux prendre en charge les langues non anglaises. Par rapport au vocabulaire Llama 2, notre nouveau vocabulaire améliore la compression des échantillons de données anglaises de 3,17 à 3,94 caractères/token. Cela permet au modèle de "lire" plus de texte avec la même quantité de calcul d'entraînement. Nous avons également constaté que l'ajout de 28 000 tokens provenant de langues non anglaises spécifiques améliorait la compression et les performances en aval, tout en n'ayant aucun effet sur la tokenisation de l'anglais.

- Nous augmentons l'hyperparamètre de fréquence de base RoPE à 500 000. Cela nous permet de mieux prendre en charge les contextes plus longs ; Xiong et al. (2023) montrent que cette valeur est valable pour des longueurs de contexte allant jusqu'à 32 768.

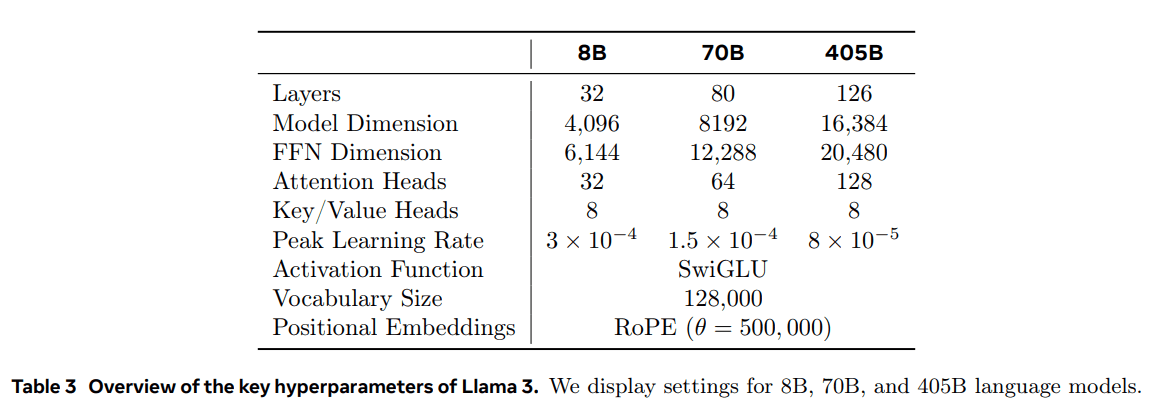

Le Llama 3 405B utilise une architecture comportant 126 couches, 16 384 dimensions de représentation des marqueurs et 128 têtes d'attention ; pour plus d'informations, voir le tableau 3. Il en résulte une taille de modèle qui est approximativement optimale sur le plan informatique, sur la base de nos données et d'un budget d'apprentissage de 3,8 × 10^25 FLOPs.

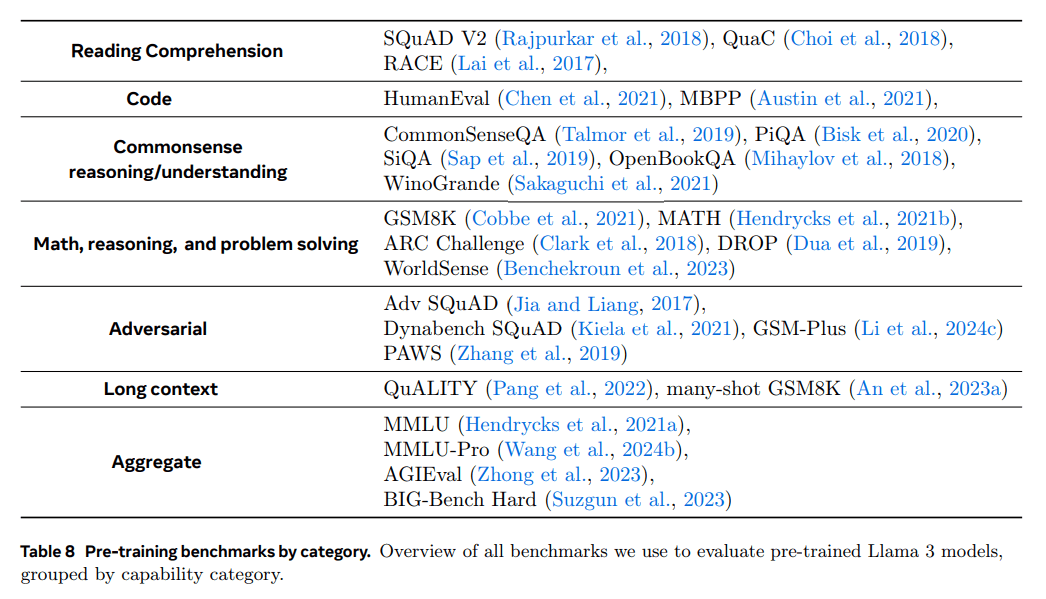

3.2.1 Lois d'échelle

Nous avons utilisé les lois d'échelle (Hoffmann et al., 2022 ; Kaplan et al., 2020) pour déterminer la taille optimale du modèle phare compte tenu de notre budget de calcul de pré-entraînement. Outre la détermination de la taille optimale du modèle, la prédiction des performances du modèle phare sur les tâches de référence en aval présente des défis importants pour les raisons suivantes :

- Les lois d'échelonnement existantes ne prévoient généralement que la perte de prédiction de la prochaine marque, et non une performance de référence spécifique.

- Les lois de mise à l'échelle peuvent être bruyantes et peu fiables car elles sont élaborées sur la base d'essais de pré-entraînement utilisant un petit budget de calcul (Wei et al., 2022b).

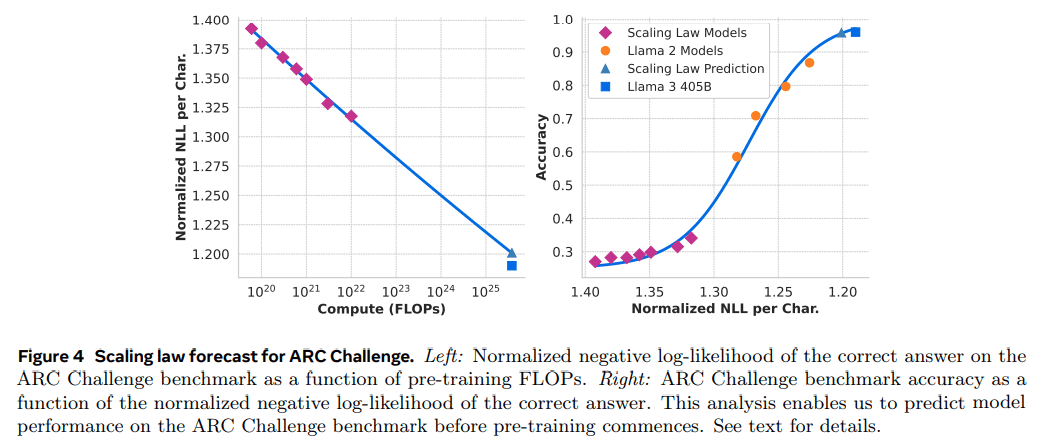

Pour relever ces défis, nous avons mis en œuvre une approche en deux phases pour développer des lois de mise à l'échelle qui prédisent avec précision les performances de l'analyse comparative en aval :

- Nous établissons d'abord la corrélation entre les FLOP de pré-entraînement et le calcul de la log-vraisemblance négative du meilleur modèle sur la tâche en aval.

- Ensuite, nous corrélons la log-vraisemblance négative sur la tâche en aval avec la précision de la tâche à l'aide du modèle Scaling Laws et d'un modèle plus ancien entraîné précédemment en utilisant des FLOP de calcul plus élevés. Dans cette étape, nous utilisons exclusivement la famille de modèles Llama 2.

Cette approche nous permet de prédire la performance de la tâche en aval (pour les modèles optimaux sur le plan informatique) sur la base d'un nombre spécifique de FLOPs pré-entraînés. Nous utilisons une approche similaire pour sélectionner notre combinaison de données de pré-entraînement (voir section 3.4).

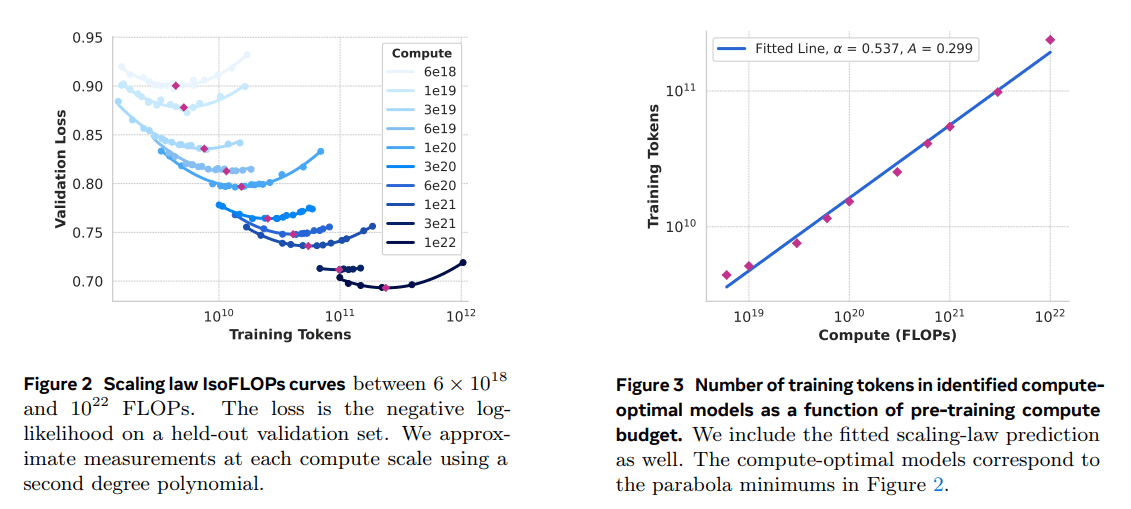

Mise à l'échelle Expérience en matière de droit.Plus précisément, nous avons construit des lois de mise à l'échelle en pré-entraînant des modèles à l'aide de budgets de calcul compris entre 6 × 10^18 FLOPs et 10^22 FLOPs. Pour chaque budget de calcul, nous avons pré-entraîné des modèles avec des tailles comprises entre 40M et 16B paramètres et nous avons utilisé une fraction de la taille du modèle pour chaque budget de calcul. Dans ces cycles d'entraînement, nous utilisons une planification du taux d'apprentissage en cosinus et un échauffement linéaire dans les 2 000 étapes d'entraînement. Le taux d'apprentissage maximal a été fixé entre 2 × 10^-4 et 4 × 10^-4 en fonction de la taille du modèle. Nous avons fixé la décroissance du cosinus à 0,1 fois la valeur maximale. La décroissance du poids pour chaque étape a été fixée à 0,1 fois le taux d'apprentissage pour cette étape. Nous avons utilisé une taille de lot fixe pour chaque taille de calcul, allant de 250K à 4M.

Ces expériences ont produit les courbes IsoFLOPs de la figure 2. Les pertes dans ces courbes ont été mesurées sur des ensembles de validation distincts. Nous ajustons les valeurs de perte mesurées à l'aide d'un polynôme du second ordre et déterminons la valeur minimale de chaque parabole. Nous désignons le minimum de la parabole comme le modèle optimal du point de vue du calcul dans le cadre du budget de calcul pré-entraîné correspondant.

Nous utilisons des modèles informatiques optimaux identifiés de cette manière pour prédire le nombre optimal de jetons d'apprentissage pour un budget informatique donné. À cette fin, nous supposons qu'il existe une relation de type loi de puissance entre le budget de calcul C et le nombre optimal de jetons d'apprentissage N (C) :

N (C) = AC α .

Nous ajustons A et α en utilisant les données de la figure 2. Nous trouvons (α, A) = (0,53, 0,29) ; l'ajustement correspondant est montré dans la figure 3. L'extrapolation de la loi d'échelle résultante à 3,8 × 10 25 FLOPs suggère l'apprentissage d'un modèle avec 402B paramètres et l'utilisation de 16,55T jetons.

Une observation importante est que la courbe IsoFLOPs s'aplatit autour du minimum à mesure que le budget de calcul augmente. Cela implique que la performance du modèle phare est relativement stable face à de petites variations dans le compromis entre la taille du modèle et les marqueurs d'entraînement. Sur la base de cette observation, nous avons finalement décidé de former un modèle phare contenant le paramètre 405B.

Prédire la performance des tâches en aval.Nous utilisons le modèle optimal généré pour prédire les performances du modèle phare Llama 3 sur l'ensemble de données de référence. Tout d'abord, nous établissons une relation linéaire entre la log-vraisemblance négative (normalisée) de la réponse correcte dans l'ensemble de données de référence et les FLOP d'entraînement. Pour cette analyse, nous n'avons utilisé que le modèle de loi d'échelle entraîné à 10^22 FLOPs sur le mélange de données ci-dessus. Ensuite, nous avons établi une relation en forme de S entre la log-vraisemblance et la précision en utilisant le modèle de loi d'échelle et le modèle Llama 2, qui a été entraîné en utilisant le mélange de données et le marqueur Llama 2. (Nous montrons les résultats de cette expérience sur le benchmark ARC Challenge dans la figure 4). Nous constatons que cette prédiction de loi d'échelle en deux étapes (extrapolée sur quatre ordres de grandeur) est assez précise : elle ne sous-estime que légèrement les performances finales du modèle phare Llama 3.

3.3 Infrastructure, expansion et efficacité

Nous décrivons le matériel et l'infrastructure utilisés pour le pré-entraînement du Llama 3 405B et discutons de plusieurs optimisations qui améliorent l'efficacité de l'entraînement.

3.3.1 Infrastructure de formation

Les modèles Llama 1 et Llama 2 ont été entraînés sur le supercluster de recherche en IA de Meta (Lee et Sengupta, 2022). Au fur et à mesure de la montée en charge, l'entraînement de Llama 3 a été transféré sur le cluster de production de Meta (Lee et al., 2024). Cette configuration optimise la fiabilité au niveau de la production, ce qui est essentiel lorsque nous augmentons la formation.

Ressources informatiques : Le Llama 3 405B entraîne jusqu'à 16 000 GPU H100, chacun fonctionnant à 700W TDP avec 80GB HBM3, en utilisant la plateforme de serveur d'IA Grand Teton de Meta (Matt Bowman, 2022). Chaque serveur est équipé de huit GPU et de deux CPU ; au sein du serveur, les huit GPU sont connectés via NVLink. Les tâches d'entraînement sont planifiées à l'aide de MAST (Choudhury et al., 2024), le planificateur d'entraînement à l'échelle mondiale de Meta.

Stockage : Tectonic (Pan et al., 2021), le système de fichiers distribués à usage général de Meta, a été utilisé pour construire l'architecture de stockage pour le pré-entraînement de Llama 3 (Battey et Gupta, 2024). Il fournit 240 Po d'espace de stockage et se compose de 7 500 serveurs équipés de disques SSD qui prennent en charge un débit durable de 2 To/s et un débit de pointe de 7 To/s. L'un des principaux défis consiste à prendre en charge les écritures de points de contrôle en rafale qui saturent la structure de stockage dans un court laps de temps. Les points de contrôle sauvegardent l'état du modèle par GPU, allant de 1MB à 4GB par GPU, pour la récupération et le débogage. Notre objectif est de minimiser le temps de pause du GPU pendant les points de contrôle et d'augmenter la fréquence des points de contrôle afin de réduire la quantité de travail perdue après la récupération.

Mise en réseau : Le Llama 3 405B utilise une architecture RDMA over Converged Ethernet (RoCE) basée sur les commutateurs de rack Arista 7800 et Minipack2 Open Compute Project (OCP). Les modèles plus petits de la série Llama 3 ont été entraînés en utilisant le réseau Infiniband Quantum2 de Nvidia. Les clusters RoCE et Infiniband utilisent tous deux une connexion de 400 Gbps entre les GPU. Malgré les différences entre les technologies de réseau sous-jacentes de ces clusters, nous les avons tous deux réglés pour fournir des performances équivalentes afin de gérer ces charges de travail d'entraînement importantes. Nous reviendrons plus en détail sur notre réseau RoCE lorsque nous aurons pris la pleine responsabilité de sa conception.

- Topologie du réseau : Notre cluster d'IA basé sur RoCE contient 24 000 GPU (note de bas de page 5) connectés via un réseau Clos à trois niveaux (Lee et al., 2024). Au niveau inférieur, chaque rack héberge 16 GPU, alloués à deux serveurs et connectés via un seul commutateur Minipack2 top-of-rack (ToR). Au niveau intermédiaire, 192 de ces racks sont connectés via des commutateurs de cluster pour former un Pod de 3 072 GPU avec une bande passante bidirectionnelle complète, garantissant l'absence de sursouscription. Au niveau supérieur, huit pods de ce type situés dans le même bâtiment du centre de données sont connectés via des commutateurs d'agrégation pour former une grappe de 24 000 GPU. Cependant, au lieu de maintenir une bande passante bidirectionnelle complète, les connexions réseau au niveau de l'agrégation ont un taux de sursouscription de 1:7. Notre approche modèle-parallèle (voir section 3.3.2) et le planificateur de tâches de formation (Choudhury et al., 2024) sont tous deux optimisés pour tenir compte de la topologie du réseau, afin de minimiser la communication réseau entre les Pods.

- Équilibrage de la charge : L'apprentissage de grands modèles linguistiques génère un trafic réseau important qu'il est difficile d'équilibrer sur tous les chemins disponibles par des méthodes traditionnelles telles que le routage à coûts égaux et à chemins multiples (ECMP). Pour relever ce défi, nous utilisons deux techniques. Tout d'abord, notre bibliothèque agrégée crée 16 flux réseau entre deux GPU au lieu d'un, ce qui réduit le volume de trafic par flux et fournit plus de flux pour l'équilibrage de la charge. Deuxièmement, notre protocole Enhanced ECMP (E-ECMP) équilibre efficacement ces 16 flux sur différents chemins de réseau en hachant d'autres champs dans le paquet d'en-tête RoCE.

- Contrôle de la congestion : Nous utilisons des commutateurs à tampon profond (Gangidi et al., 2024) dans le réseau dorsal pour faire face à la congestion transitoire et à la mise en mémoire tampon causées par les modèles de communication agrégés. Cela permet de limiter l'impact de la congestion persistante et de la contre-pression du réseau causée par des serveurs lents, ce qui est courant dans la formation. Enfin, un meilleur équilibrage de la charge grâce à l'E-ECMP réduit considérablement la probabilité de congestion. Grâce à ces optimisations, nous avons réussi à faire fonctionner une grappe de 24 000 GPU sans avoir recours aux méthodes traditionnelles de contrôle de la congestion, telles que la notification de la congestion quantifiée du centre de données (DCQCN).

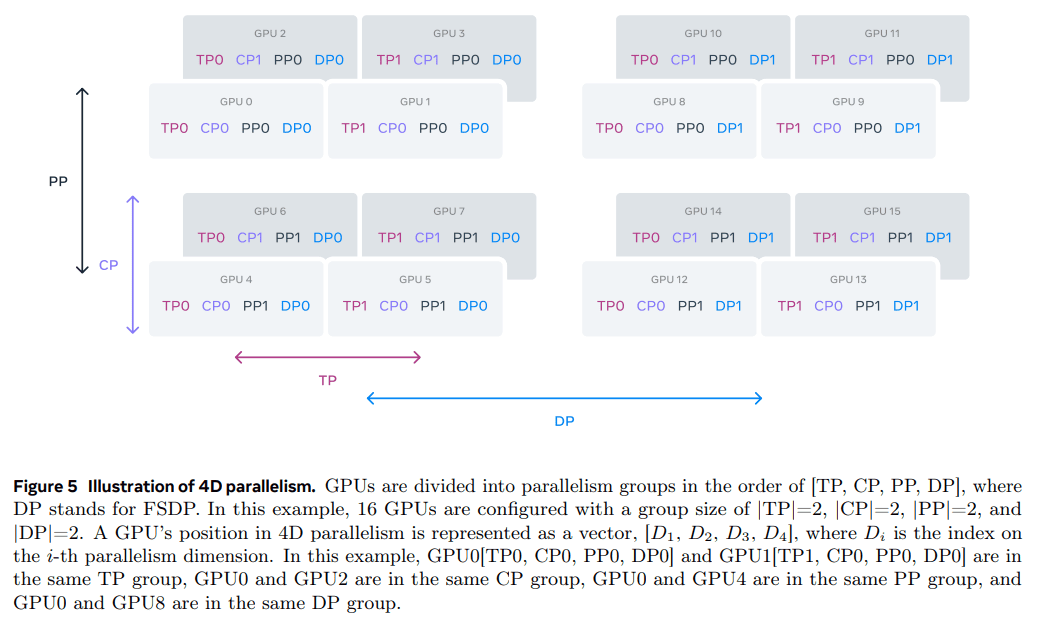

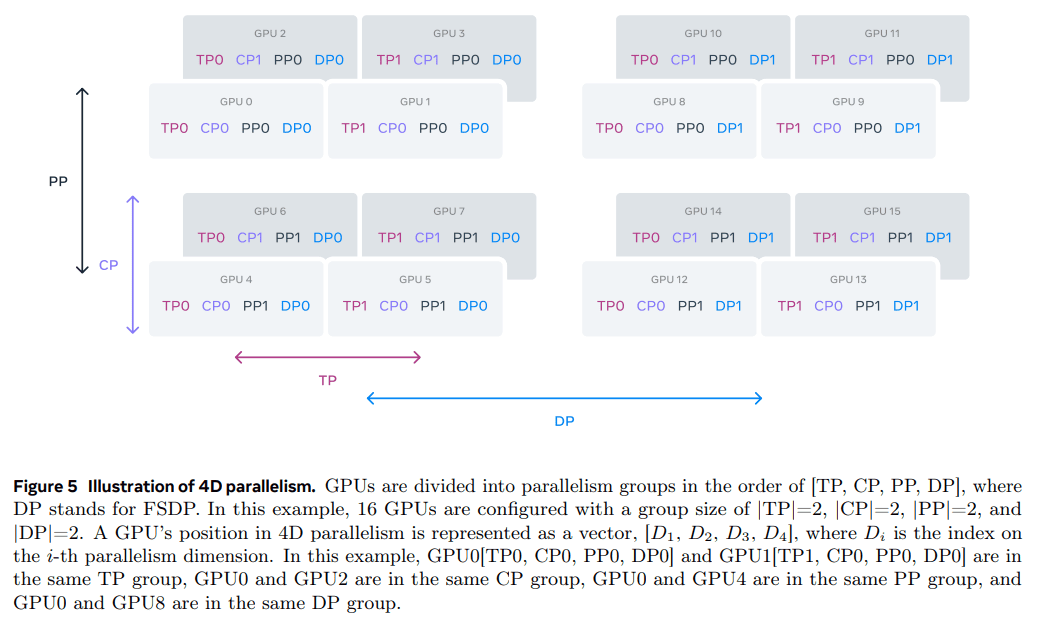

3.3.2 Parallélisme dans la mise à l'échelle des modèles

Pour augmenter l'entraînement de notre plus grand modèle, nous le partageons en utilisant le parallélisme 4D - un schéma qui combine quatre approches parallèles différentes. Cette approche répartit efficacement le calcul sur plusieurs GPU et garantit que les paramètres du modèle, les états de l'optimiseur, les gradients et les valeurs d'activation de chaque GPU s'intègrent dans son HBM. Notre implémentation parallèle 4D (comme indiqué dans et al. (2020) ; Ren et al. (2021) ; Zhao et al. (2023b)) découpe le modèle, l'optimiseur et le gradient tout en mettant en œuvre le parallélisme des données, qui traite les données en parallèle sur plusieurs GPU et les synchronise après chaque étape d'entraînement. Nous utilisons FSDP pour découper l'état de l'optimiseur et le gradient pour Llama 3, mais pour le découpage du modèle, nous ne recoupons pas après le calcul en amont pour éviter une communication supplémentaire de la collection complète pendant les passes en aval.

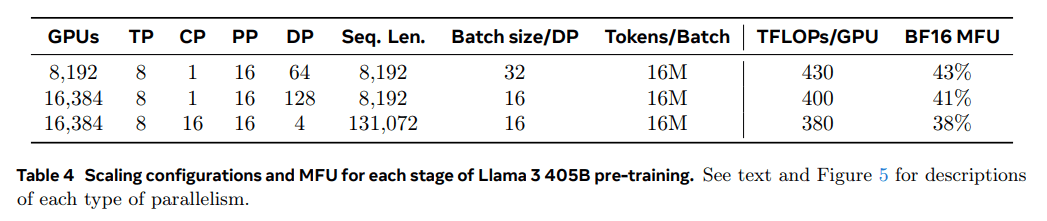

Utilisation du GPU.En réglant soigneusement la configuration parallèle, le matériel et le logiciel, nous obtenons une utilisation des FLOPs du modèle BF16 (MFU ; Chowdhery et al. (2023)) de 38-43%. Les configurations présentées dans le tableau 4 indiquent que par rapport à 43% sur 8K GPUs et DP=64, la chute de la MFU à 41% sur 16K GPUs et DP=128 est due à la nécessité de réduire la taille du lot de chaque groupe DP pour maintenir le nombre de marqueurs globaux constants pendant l'entraînement. 41% est due à la nécessité de réduire la taille des lots de chaque groupe de DP afin de maintenir constant le nombre de jetons globaux pendant l'entraînement.

Rationaliser les améliorations parallèles.Nous avons rencontré plusieurs difficultés dans notre mise en œuvre actuelle :

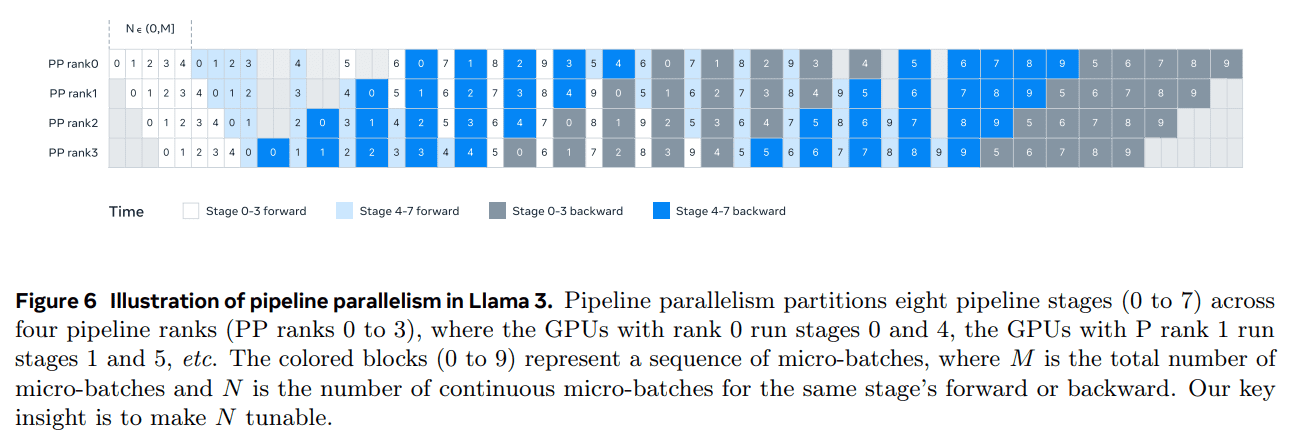

- Limitation de la taille des lots.Les implémentations actuelles imposent une limite à la taille du lot supportée par le GPU, en exigeant qu'elle soit divisible par le nombre d'étapes du pipeline. Pour l'exemple de la figure 6, le parallélisme de pipeline pour l'ordonnancement en profondeur d'abord (DFS) (Narayanan et al. (2021)) nécessite N = PP = 4, tandis que l'ordonnancement en largeur d'abord (BFS ; Lamy-Poirier (2023)) nécessite N = M, où M est le nombre total de micro-lots et N est le nombre de micro-lots consécutifs dans la même étape dans la direction avant ou arrière. Toutefois, le pré-entraînement exige généralement une certaine souplesse dans le dimensionnement des lots.

- Déséquilibre de la mémoire.Les implémentations parallèles en pipeline existantes entraînent une consommation déséquilibrée des ressources. La première étape consomme plus de mémoire en raison de l'intégration et du réchauffement des micro-lots.

- Les calculs ne sont pas équilibrés. Après la dernière couche du modèle, nous devons calculer les sorties et les pertes, ce qui fait de cette phase un goulot d'étranglement dans la latence d'exécution. où Di est l'indice de la i-ième dimension parallèle. Dans cet exemple, les GPU0 [TP0, CP0, PP0, DP0] et GPU1 [TP1, CP0, PP0, DP0] sont dans le même groupe TP, les GPU0 et GPU2 sont dans le même groupe CP, les GPU0 et GPU4 sont dans le même groupe PP, et les GPU0 et GPU8 sont dans le même groupe DP.

Pour résoudre ces problèmes, nous avons modifié l'approche d'ordonnancement du pipeline, comme le montre la figure 6, qui permet un réglage flexible de N - dans ce cas N = 5, ce qui permet d'exécuter n'importe quel nombre de micro-lots dans chaque lot. Cela nous permet de

(1) Lorsqu'il existe une limite à la taille du lot, il faut exécuter moins de micro-lots que le nombre d'étapes ; ou

(2) Exécuter davantage de micro-lots pour masquer la communication peer-to-peer et trouver la meilleure efficacité en termes de communication et de mémoire entre l'ordonnancement en profondeur d'abord (DFS) et l'ordonnancement en largeur d'abord (BFS). Pour équilibrer le pipeline, nous réduisons une couche de transformateur de la première et de la dernière étape, respectivement. Cela signifie que le premier bloc de modèle de la première étape n'a que la couche d'intégration, tandis que le dernier bloc de modèle de la dernière étape n'a que la projection de sortie et le calcul de la perte.

Pour réduire les bulles de pipeline, nous utilisons une approche d'ordonnancement entrelacé (Narayanan et al., 2021) sur une hiérarchie de pipeline avec V étapes de pipeline. Le ratio global de bulle du pipeline est de PP-1 V * M . En outre, nous utilisons la communication asynchrone entre pairs, qui accélère considérablement la formation, en particulier dans les cas où les masques de documents introduisent des déséquilibres de calcul supplémentaires. Nous activons TORCH_NCCL_AVOID_RECORD_STREAMS pour réduire l'utilisation de la mémoire par la communication asynchrone entre homologues. Enfin, pour réduire les coûts de mémoire, sur la base d'une analyse détaillée de l'allocation de la mémoire, nous libérons de manière proactive les tenseurs qui ne seront pas utilisés pour des calculs futurs, y compris les tenseurs d'entrée et de sortie pour chaque étape du pipeline. ** Grâce à ces optimisations, nous sommes en mesure d'exécuter les 8K tenseurs sans utiliser de points de contrôle d'activation, sans utiliser de points de contrôle d'activation. jeton séquences de pré-entraînement du lama 3.

La parallélisation contextuelle est utilisée pour les longues séquences. Nous tirons parti de la parallélisation des contextes (CP) pour améliorer l'efficacité de la mémoire lors de la mise à l'échelle des longueurs de contexte Llama 3 et pour permettre l'entraînement sur des séquences très longues, jusqu'à 128K de long. Dans la CP, nous partitionnons les dimensions de la séquence, c'est-à-dire que nous divisons la séquence d'entrée en 2 × blocs CP de sorte que chaque niveau CP reçoive deux blocs pour un meilleur équilibrage de la charge. Le ième niveau du CP reçoit le ième bloc et (2 × CP -1 -i) blocs.

Contrairement aux implémentations CP existantes qui chevauchent la communication et le calcul dans une structure en anneau (Liu et al., 2023a), notre implémentation CP utilise une approche basée sur la collecte globale qui agrège d'abord globalement le tenseur clé-valeur (K, V), puis calcule les sorties attentionnelles des blocs tensoriels de requête (Q) locaux. Bien que le temps de latence de la communication globale soit sur le chemin critique, nous adoptons toujours cette approche pour deux raisons principales :

(1) Il est plus facile et plus souple de prendre en charge différents types de masques d'attention, tels que les masques de documents, dans le cadre de l'attention de la PC basée sur la collecte globale ;

(2) La latence exposée de la collecte globale est faible parce que le tenseur K et V de la communication est beaucoup plus petit que le tenseur Q, en raison de l'utilisation de l'AQG (Ainslie et al., 2023). Par conséquent, la complexité temporelle du calcul de l'attention est supérieure d'un ordre de grandeur à celle de la collecte globale (O(S²) contre O(S), où S représente la longueur de la séquence dans le masque causal complet), ce qui rend la surcharge de la collecte globale négligeable.

Configuration parallélisée tenant compte du réseau.L'ordre des dimensions de la parallélisation [TP, CP, PP, DP] est optimisé pour la communication réseau. La couche la plus interne de la parallélisation nécessite la bande passante la plus élevée et la latence la plus faible, et est donc généralement limitée au sein du même serveur. La couche externe de la parallélisation peut s'étendre sur des réseaux multi-sauts et doit pouvoir tolérer une latence plus élevée. Par conséquent, sur la base des exigences en matière de bande passante et de latence du réseau, nous classons les dimensions de la parallélisation dans l'ordre suivant : [TP, CP, PP, DP].DP (c.-à-d. FSDP) est la couche de parallélisation la plus externe car elle peut tolérer une plus grande latence du réseau en préachetant de manière asynchrone les poids du modèle de découpage et en réduisant le gradient. Déterminer la configuration de parallélisation optimale avec un surcoût de communication minimal tout en évitant la saturation de la mémoire du GPU est un défi. Nous avons développé un estimateur de la consommation de mémoire et un outil de projection des performances, qui nous ont aidés à explorer diverses configurations de parallélisation et à prédire les performances globales de l'apprentissage, ainsi qu'à identifier efficacement les lacunes en matière de mémoire.

Stabilité numérique.En comparant les pertes d'entraînement entre différentes configurations parallèles, nous résolvons certains problèmes numériques qui affectent la stabilité de l'entraînement. Pour garantir la convergence de l'apprentissage, nous utilisons l'accumulation de gradient FP32 pendant le calcul inverse de plusieurs micro-lots et réduisons la dispersion des gradients à l'aide de FP32 entre les travailleurs en parallèle dans le FSDP. Pour les tenseurs intermédiaires qui sont utilisés plusieurs fois dans les calculs en amont, tels que les sorties du codeur visuel, le gradient inverse est également accumulé en FP32.

3.3.3 Communications collectives

La bibliothèque de communication collective de Llama 3 est basée sur une branche de la bibliothèque NCCL de Nvidia appelée NCCLX. NCCLX améliore considérablement les performances de NCCL, en particulier pour les réseaux à forte latence. Rappelons que l'ordre des dimensions parallèles est [TP, CP, PP, DP], où DP correspond à FSDP, et que les dimensions parallèles les plus extérieures, PP et DP, peuvent communiquer sur un réseau multi-sauts avec des latences de l'ordre de quelques dizaines de microsecondes. Les opérations de communication collective all-gather et reduce-scatter du NCCL original sont utilisées dans le FSDP, tandis que la communication point à point est utilisée pour le PP, qui nécessite un découpage des données et une réplication des données par étapes. Cette approche entraîne certaines des inefficacités suivantes :

- Un grand nombre de petits messages de contrôle doivent être échangés sur le réseau pour faciliter le transfert des données ;

- Opérations supplémentaires de copie de mémoire ;

- Utiliser les cycles supplémentaires du GPU pour la communication.

Pour l'entraînement du Llama 3, nous remédions à certaines de ces inefficacités en adaptant le découpage et les transferts de données à la latence de notre réseau, qui peut atteindre des dizaines de microsecondes dans les grands clusters. Nous permettons également aux petits messages de contrôle de passer par notre réseau avec une priorité plus élevée, en évitant notamment le blocage de la tête de file dans les commutateurs centraux profondément mis en mémoire tampon.

Nos travaux en cours pour les futures versions de Llama comprennent des modifications plus profondes de NCCLX afin de résoudre tous les problèmes susmentionnés.

3.3.4 Fiabilité et défis opérationnels

La complexité et les scénarios de défaillance potentiels de l'entraînement par GPU 16K dépassent ceux des clusters de CPU plus importants sur lesquels nous avons travaillé. En outre, la nature synchrone de l'entraînement le rend moins tolérant aux pannes - une seule défaillance du GPU peut nécessiter le redémarrage de l'ensemble du travail. Malgré ces difficultés, pour Llama 3, nous avons obtenu des temps d'entraînement effectifs supérieurs à 90% tout en prenant en charge la maintenance automatisée de la grappe (par exemple, les mises à niveau du micrologiciel et du noyau Linux (Vigraham et Leonhardi, 2024)), ce qui a entraîné au moins une interruption de l'entraînement par jour.

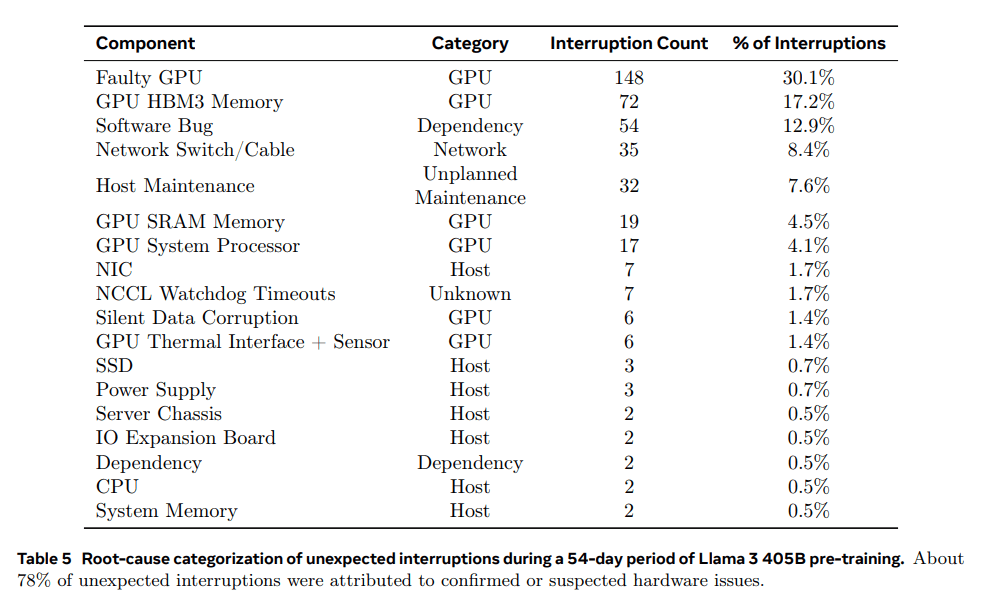

Le temps de formation effective est le temps consacré à la formation effective pendant la période écoulée. Au cours des 54 jours précédant la formation, nous avons connu un total de 466 interruptions opérationnelles. Parmi celles-ci, 47 étaient des interruptions planifiées dues à des opérations de maintenance automatisées (par exemple, des mises à niveau de micrologiciels ou des opérations initiées par l'opérateur, telles que des mises à jour de configuration ou d'ensembles de données). Les 419 autres interruptions étaient imprévues et sont classées dans le tableau 5. Environ 78% des pannes imprévues ont été attribuées à des problèmes matériels identifiés, tels que des défaillances du GPU ou des composants de l'hôte, ou à des problèmes soupçonnés d'être liés au matériel, tels qu'une corruption silencieuse des données et des événements de maintenance individuels non planifiés de l'hôte.Les problèmes liés au GPU ont constitué la catégorie la plus importante, représentant 58,7% de tous les problèmes imprévus.Malgré le grand nombre de pannes, seules trois interventions manuelles majeures ont été nécessaires au cours de cette période, et la plupart des pannes n'ont pas été évitées. Malgré le grand nombre de défaillances, seules trois interventions manuelles majeures ont été nécessaires au cours de cette période et les autres problèmes ont été traités par l'automatisation.

Pour améliorer le temps de formation effectif, nous avons réduit le temps de démarrage des tâches et des points de contrôle, et développé des outils de diagnostic rapide et de résolution des problèmes. Nous avons fait un usage intensif de l'enregistreur de vol NCCL intégré à PyTorch (Ansel et al., 2024) - une fonction qui capture les métadonnées collectives et les traces de pile dans un tampon circulaire, ce qui nous permet de diagnostiquer rapidement les blocages et les problèmes de performance à l'échelle, en particulier dans le cas des aspects NCCLX. NCCLX. En l'utilisant, nous pouvons enregistrer efficacement les événements de communication et les durées pour chaque opération collective, et vider automatiquement les données de trace dans le cas d'un chien de garde NCCLX ou d'un dépassement de temps de battement de cœur. Grâce aux changements de configuration en ligne (Tang et al., 2015), nous pouvons activer de manière sélective des opérations de traçage et de collecte de métadonnées plus intensives en termes de calcul, sans avoir à modifier le code ou à redémarrer le travail. Les problèmes de débogage dans la formation à grande échelle sont compliqués par l'utilisation mixte de NVLink et RoCE dans notre réseau. Les transferts de données sont généralement effectués sur NVLink via des opérations load/store émises par le noyau CUDA, et la défaillance d'un GPU distant ou d'une connexion NVLink se manifeste souvent par une opération load/store bloquée dans le noyau CUDA sans qu'un code d'erreur explicite ne soit renvoyé. PyTorch d'accéder à l'état interne de NCCLX et de suivre les informations pertinentes. Bien qu'il ne soit pas possible d'empêcher complètement les blocages dus aux défauts NVLink, notre système surveille l'état des bibliothèques de communication et temporise automatiquement lorsque de tels blocages sont détectés. En outre, NCCLX suit l'activité du noyau et du réseau pour chaque communication NCCLX et fournit un instantané de l'état interne du collectif NCCLX défaillant, y compris les transferts de données terminés et non terminés entre tous les rangs. Nous analysons ces données pour déboguer les problèmes d'extension de NCCLX.

Parfois, des problèmes matériels peuvent entraîner l'apparition de traînards lents mais toujours en activité, qui sont difficiles à détecter. Même s'il n'y a qu'un seul retardataire, il peut ralentir des milliers d'autres GPU, souvent sous la forme d'un fonctionnement normal mais d'une communication lente. Nous avons mis au point des outils permettant de hiérarchiser les communications potentiellement problématiques provenant de groupes de processus sélectionnés. En enquêtant uniquement sur quelques suspects clés, nous sommes souvent en mesure d'identifier efficacement les traînards.

Une observation intéressante est l'impact des facteurs environnementaux sur les performances de l'entraînement à grande échelle. Pour le Llama 3 405B, nous avons remarqué des fluctuations de débit de 1-2% basées sur la variation du temps. Cette fluctuation est due aux températures élevées de la mi-journée qui affectent la tension dynamique du GPU et la mise à l'échelle de la fréquence. Pendant l'entraînement, des dizaines de milliers de GPU peuvent simultanément augmenter ou diminuer la consommation d'énergie, par exemple parce que tous les GPU attendent la fin d'un point de contrôle ou d'une communication collective, ou encore le démarrage ou l'arrêt d'un travail d'entraînement entier. Lorsque cela se produit, cela peut entraîner des fluctuations transitoires de la consommation d'énergie au sein du centre de données de l'ordre de dizaines de mégawatts, ce qui met à rude épreuve les limites du réseau électrique. Il s'agit d'un défi permanent dans la mesure où nous développons la formation pour les futurs modèles de lamas, qui seront encore plus grands.

3.4 Programmes de formation

La recette de pré-entraînement du lama 3 405B comprend trois étapes principales :

(1) pré-entraînement initial, (2) pré-entraînement en contexte long et (3) recuit. Chacune de ces trois étapes est décrite ci-dessous. Nous utilisons des recettes similaires pour le pré-entraînement des modèles 8B et 70B.

3.4.1 Pré-entraînement initial

Nous avons pré-entraîné le modèle Llama 3 405B en utilisant un schéma de taux d'apprentissage en cosinus avec un taux d'apprentissage maximal de 8 × 10-⁵, un échauffement linéaire jusqu'à 8 000 étapes et une décroissance jusqu'à 8 × 10-⁷ après 1 200 000 étapes d'entraînement. Pour améliorer la stabilité de la formation, nous utilisons une taille de lot plus petite au début de la formation et augmentons ensuite la taille du lot pour améliorer l'efficacité. Plus précisément, nous avons initialement une taille de lot de 4 millions de jetons et une longueur de séquence de 4 096. Après le pré-entraînement de 252 millions de jetons, nous doublons la taille du lot et la longueur de la séquence à 8 millions de séquences et 8 192 jetons, respectivement. Après le pré-entraînement de 2,87 tonnes de jetons, nous doublons à nouveau la taille du lot à 16 millions de jetons. Cette méthode d'apprentissage est très stable : très peu de pics de perte se produisent et aucune intervention n'est nécessaire pour corriger les déviations dans l'apprentissage du modèle.

Ajustement des combinaisons de données. Au cours de la formation, nous avons procédé à plusieurs ajustements de la combinaison de données de préformation afin d'améliorer les performances du modèle dans des tâches spécifiques en aval. En particulier, nous avons augmenté la proportion de données non anglaises pendant la préformation afin d'améliorer les performances multilingues du Llama 3. Nous avons également augmenté la proportion de données mathématiques pour améliorer le raisonnement mathématique du modèle, ajouté des données de réseau plus récentes dans les dernières étapes de la préformation pour mettre à jour les seuils de connaissance du modèle, et ajusté à la baisse la proportion d'un sous-ensemble de données qui a été identifié plus tard comme étant de moindre qualité.

3.4.2 Pré-entraînement en contexte long

Dans la dernière étape du pré-entraînement, nous entraînons de longues séquences pour prendre en charge des fenêtres contextuelles allant jusqu'à 128 000 tokens. Nous n'entraînons pas de longues séquences plus tôt car le calcul dans la couche d'auto-attention croît quadratiquement avec la longueur de la séquence. Nous augmentons progressivement la longueur du contexte pris en charge et nous effectuons un pré-entraînement une fois que le modèle s'est adapté avec succès à l'augmentation de la longueur du contexte. Nous évaluons la réussite de l'adaptation en mesurant à la fois

(1) Les performances du modèle dans les évaluations en contexte court ont-elles été entièrement rétablies ?

(2) Le modèle peut-il résoudre parfaitement la tâche "aiguille dans une botte de foin" jusqu'à cette longueur ? Lors du pré-entraînement du Llama 3 405B, nous avons augmenté progressivement la longueur du contexte en six étapes, en commençant par une fenêtre contextuelle initiale de 8 000 tokens et en atteignant finalement une fenêtre contextuelle de 128 000 tokens. Cette phase de pré-entraînement à contexte long a utilisé environ 800 milliards de tokens d'entraînement.

3.4.3 Recuit

Pendant le pré-entraînement des 40 derniers millions de tokens, nous avons recuit le taux d'apprentissage linéairement jusqu'à 0 tout en maintenant une longueur de contexte de 128 000 tokens. Au cours de cette phase de recuit, nous avons également ajusté la combinaison de données pour augmenter la taille de l'échantillon de sources de données de très haute qualité ; voir la section 3.1.3. Enfin, nous avons calculé la moyenne des points de contrôle du modèle (moyenne de Polyak (1991)) pendant le recuit pour générer le modèle pré-entraîné final.

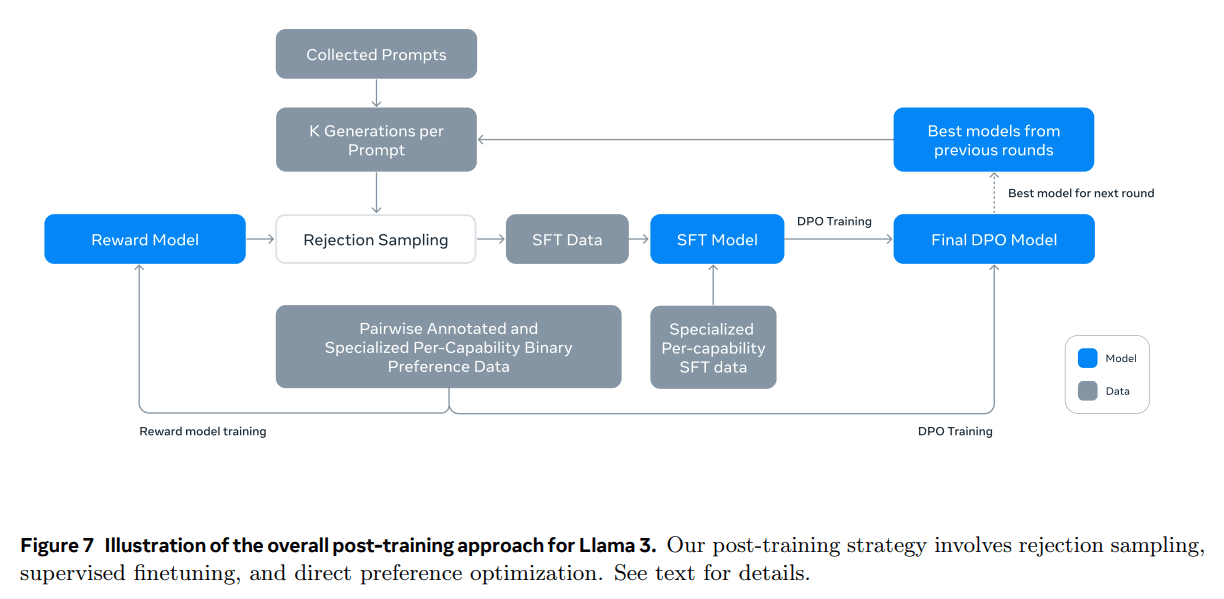

4 Formation de suivi

Nous avons généré et aligné des modèles Llama 3 en appliquant plusieurs cycles d'entraînement de suivi. Ces formations de suivi sont basées sur des points de contrôle pré-entraînés et intègrent un retour d'information humain pour l'alignement des modèles (Ouyang et al., 2022 ; Rafailov et al., 2024). Chaque cycle de formation de suivi a consisté en un réglage fin supervisé (SFT), suivi d'une optimisation directe des préférences (DPO ; Rafailov et al., 2024) à l'aide d'exemples générés par une annotation ou une synthèse manuelle. Nous décrivons notre modélisation de l'apprentissage et nos méthodes de données dans les sections 4.1 et 4.2, respectivement. En outre, nous fournissons des détails supplémentaires sur les stratégies de collecte de données personnalisées dans la section 4.3 afin d'améliorer le modèle en termes d'inférence, de capacités de programmation, de factorisation, de support multilingue, d'utilisation d'outils, de contextes longs et de respect d'instructions précises.

4.1 Modélisation

Notre stratégie de post-entraînement repose sur un modèle de récompense et un modèle linguistique. Nous formons d'abord un modèle de récompense au-dessus des points de contrôle de préformation en utilisant des données de préférence étiquetées par l'homme (voir section 4.1.2). Nous affinons ensuite les points de contrôle de préformation à l'aide d'un ajustement supervisé (SFT ; voir la section 4.1.3) et les alignons davantage sur les points de contrôle à l'aide d'une optimisation directe des préférences (DPO ; voir la section 4.1.4). Ce processus est illustré à la figure 7. Sauf indication contraire, notre processus de modélisation s'applique au Llama 3 405B, que nous appelons Llama 3 405B par souci de simplicité.

4.1.1 Format du dialogue de chat

Afin d'adapter un Grand Modèle de Langage (LLM) à l'interaction homme-machine, nous devons définir un protocole de dialogue qui permette au modèle de comprendre les commandes humaines et d'effectuer des tâches de dialogue. Par rapport à son prédécesseur, Llama 3 possède de nouvelles fonctionnalités telles que l'utilisation d'outils (Section 4.3.5), ce qui peut nécessiter la génération de plusieurs messages dans un seul tour de dialogue et leur envoi à différents endroits (par exemple, l'utilisateur, ipython). Pour ce faire, nous avons conçu un nouveau protocole de discussion multi-messages qui utilise une variété de jetons d'en-tête et de terminaison spéciaux. Les jetons d'en-tête sont utilisés pour indiquer la source et la destination de chaque message dans un dialogue. De même, les marqueurs de fin indiquent quand c'est au tour de l'humain et de l'IA d'alterner la parole.

4.1.2 Modélisation des récompenses

Nous avons formé un modèle de récompense (RM) couvrant différentes capacités et l'avons construit au-dessus des points de contrôle pré-entraînés. L'objectif de formation est le même que dans Llama 2, mais nous supprimons le terme marginal dans la fonction de perte parce que nous observons une amélioration réduite au fur et à mesure que la taille des données augmente. Comme dans Llama 2, nous utilisons toutes les données de préférence pour la modélisation de la récompense après avoir filtré les échantillons présentant des réponses similaires.

En plus des paires de préférences de réponses standard (sélectionnées, rejetées), l'annotation crée une troisième "réponse éditée" pour certains indices, où la réponse sélectionnée dans la paire est encore éditée pour être améliorée (voir la section 4.2.1). Ainsi, chaque échantillon de tri des préférences comporte deux ou trois réponses clairement classées (éditées > sélectionnées > rejetées). Au cours de l'entraînement, nous avons concaténé les indices et les réponses multiples en une seule ligne et randomisé les réponses. Il s'agit d'une approximation du scénario standard de calcul des scores en plaçant les réponses dans des lignes séparées, mais dans nos expériences d'ablation, cette approche améliore l'efficacité de la formation sans perte de précision.

4.1.3 Mise au point de la surveillance

Les indices étiquetés par l'homme sont d'abord rejetés pour l'échantillonnage à l'aide du modèle de récompense, dont la méthodologie détaillée est décrite à la section 4.2. Nous combinons ces données échantillonnées et rejetées avec d'autres sources de données (y compris des données synthétiques) pour affiner le modèle linguistique pré-entraîné à l'aide de pertes d'entropie croisées standard, dans le but de prédire le marquage de la cible (tout en masquant les pertes dues au marquage des indices). Voir la section 4.2 pour plus de détails sur le mélange de données. Bien que de nombreuses cibles d'entraînement soient générées par le modèle, nous qualifions cette phase de mise au point supervisée (SFT ; Wei et al. 2022a ; Sanh et al. 2022 ; Wang et al. 2022b).

Notre modèle maximal est ajusté avec un taux d'apprentissage de 1e-5 dans un délai de 8,5K à 9K étapes. Nous avons constaté que ces paramètres hyperparamétriques étaient adaptés à différentes séries et à différents mélanges de données.

4.1.4 Optimisation directe des préférences

Nous avons ensuite formé nos modèles SFT pour l'alignement des préférences humaines à l'aide de l'optimisation directe des préférences (DPO ; Rafailov et al., 2024). Lors de l'entraînement, nous utilisons principalement les derniers lots de données de préférences collectées auprès des modèles les plus performants lors du cycle d'alignement précédent. Par conséquent, nos données de formation correspondent mieux à la distribution des modèles de stratégie optimisés à chaque tour. Nous avons également exploré des algorithmes de stratégie tels que PPO (Schulman et al., 2017), mais nous avons constaté que DPO nécessite moins de calculs et donne de meilleurs résultats sur les modèles à grande échelle, en particulier dans les benchmarks d'adhésion aux instructions tels que IFEval (Zhou et al., 2023).

Pour Llama 3, nous avons utilisé un taux d'apprentissage de 1e-5 et fixé l'hyperparamètre β à 0.1. En outre, nous avons appliqué les modifications algorithmiques suivantes à DPO :

- Masquage des marqueurs de formatage dans les pertes d'OPH. Nous masquons les marqueurs de format spéciaux (y compris les marqueurs d'en-tête et de terminaison décrits à la section 4.1.1) des réponses sélectionnées et rejetées afin de stabiliser l'entraînement des OPH. Nous notons que l'implication de ces marqueurs dans la perte peut conduire à un comportement indésirable du modèle, tel que la duplication de la queue ou la génération soudaine de marqueurs de terminaison. Nous émettons l'hypothèse que cela est dû à la nature contrastée de la perte de DPO - la présence de marqueurs communs dans les réponses sélectionnées et rejetées peut conduire à des objectifs d'apprentissage contradictoires, car le modèle doit simultanément augmenter et diminuer la probabilité de ces marqueurs.

- Régularisation à l'aide de pertes NLL : la Nous avons ajouté un terme de perte de log-vraisemblance négative (NLL) aux séquences sélectionnées avec un facteur d'échelle de 0,2, comme Pang et al. (2024). Cela permet de stabiliser davantage la formation des OPH en maintenant le format requis pour la génération et en empêchant la log-vraisemblance des réponses sélectionnées de diminuer (Pang et al., 2024 ; Pal et al., 2024).

4.1.5 Calcul de la moyenne du modèle

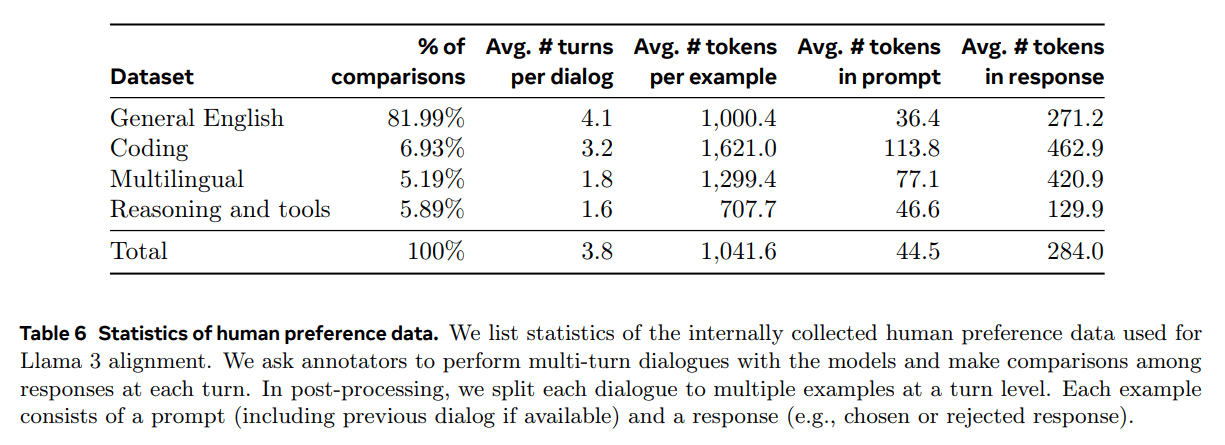

Enfin, nous avons calculé la moyenne des modèles obtenus lors d'expériences utilisant diverses versions de données ou divers hyperparamètres à chaque étape de la RM, de la SFT ou de la DPO (Izmailov et al. 2019 ; Wortsman et al. 2022 ; Li et al. 2022). Nous présentons des informations statistiques sur les données de préférence humaine collectées en interne et utilisées pour le conditionnement du Llama 3. Nous avons demandé aux évaluateurs de s'engager dans plusieurs tours de dialogue avec le modèle et nous avons comparé les réponses de chaque tour. Au cours du post-traitement, nous avons divisé chaque dialogue en plusieurs exemples, chacun contenant une invite (y compris le dialogue précédent s'il est disponible) et une réponse (par exemple, une réponse qui a été sélectionnée ou rejetée).

4.1.6 Tours d'itération

Après le Llama 2, nous avons appliqué la méthodologie ci-dessus pour six séries d'itérations. À chaque tour, nous avons collecté de nouvelles données d'étiquetage des préférences et de mise au point (SFT) et échantillonné des données synthétiques à partir du dernier modèle.

4.2 Données post-formation

La composition des données post-entraînement joue un rôle crucial dans l'utilité et le comportement du modèle linguistique. Dans cette section, nous examinons notre procédure d'annotation et la collecte des données de préférence (section 4.2.1), la composition des données SFT (section 4.2.2) et les méthodes de contrôle de la qualité et de nettoyage des données (section 4.2.3).

4.2.1 Préférences

Notre processus d'étiquetage des données de préférence est similaire à celui de Llama 2. Après chaque tour, nous déployons plusieurs modèles pour l'annotation et nous échantillonnons deux réponses de différents modèles pour chaque indice de l'utilisateur. Ces modèles peuvent être entraînés à l'aide de différents schémas de mélange et d'alignement des données, ce qui permet de disposer de différentes capacités (par exemple, l'expertise en matière de code) et d'accroître la diversité des données. Nous avons demandé aux annotateurs de classer les scores de préférence dans l'une des quatre catégories en fonction de leur niveau de préférence : nettement meilleur, meilleur, légèrement meilleur ou légèrement meilleur.

Nous avons également inclus une étape d'édition après l'ordre des préférences afin d'encourager l'annotateur à affiner la réponse préférée. L'annotateur peut soit modifier directement la réponse sélectionnée, soit utiliser le modèle d'indice de retour d'information pour affiner sa propre réponse. Par conséquent, certaines données de préférences comportent trois réponses triées (Editer > Sélectionner > Rejeter).

Les statistiques d'annotation des préférences que nous avons utilisées pour la formation du Llama 3 sont présentées dans le tableau 6. L'anglais général couvre plusieurs sous-catégories, telles que les questions-réponses basées sur les connaissances ou le suivi d'instructions précises, qui dépassent le cadre des capacités spécifiques. Par rapport à Llama 2, nous avons observé une augmentation de la longueur moyenne des messages-guides et des réponses, ce qui suggère que nous formons Llama 3 à des tâches plus complexes. En outre, nous avons mis en œuvre un processus d'analyse de la qualité et d'évaluation manuelle pour évaluer de manière critique les données collectées, ce qui nous a permis d'affiner les messages-guides et de fournir un retour d'information systématique et exploitable aux annotateurs. Par exemple, au fur et à mesure que Llama 3 s'améliore après chaque cycle, nous augmenterons en conséquence la complexité des indices afin de cibler les domaines dans lesquels le modèle est à la traîne.

Lors de chaque cycle de formation tardive, nous utilisons toutes les données de préférence disponibles à ce moment-là pour la modélisation des récompenses, et uniquement les lots les plus récents de chaque capacité pour la formation DPO. Pour la modélisation des récompenses et la DPO, nous nous entraînons avec des échantillons étiquetés comme "réponse de sélection significativement meilleure ou supérieure" et nous écartons les échantillons avec des réponses similaires.

4.2.2 Données SFT

Nos données de réglage fin proviennent principalement des sources suivantes :

- Indices de notre collection annotée manuellement et de leur rejet des réponses d'échantillonnage

- Données synthétiques pour des capacités spécifiques (voir section 4.3 pour plus de détails)

- Petite quantité de données étiquetées manuellement (voir section 4.3 pour plus de détails)

Au fur et à mesure que nous progressions dans notre cycle de post-formation, nous avons développé des variantes plus puissantes de Llama 3 et les avons utilisées pour collecter des ensembles de données plus importants afin de couvrir un large éventail de capacités complexes. Dans cette section, nous abordons les détails du processus d'échantillonnage des rejets et la composition globale du mélange final de données SFT.

Refus de prélèvement.Dans l'échantillonnage des rejets, pour chaque indice collecté pendant l'annotation manuelle (section 4.2.1), nous échantillonnons K sorties de la stratégie de modélisation du chat la plus récente (généralement les meilleurs points de contrôle d'exécution de l'itération post-formation précédente, ou les meilleurs points de contrôle d'exécution pour une compétence particulière) et utilisons notre modèle de récompense pour sélectionner le meilleur candidat, conformément à Bai et al. (2022). À des stades ultérieurs de la post-formation, nous introduisons des indices système pour guider les réponses du RS afin qu'elles se conforment à un ton, un style ou un format désiré, qui peut varier en fonction des capacités.

Pour améliorer l'efficacité de l'échantillonnage par rejet, nous utilisons PagedAttention (Kwon et al., 2023). PagedAttention améliore l'efficacité de la mémoire grâce à l'allocation dynamique du cache clé-valeur. Il prend en charge une longueur de sortie arbitraire en programmant dynamiquement les demandes en fonction de la capacité actuelle du cache. Malheureusement, cela introduit le risque de permutation lorsque la mémoire est épuisée. Pour éliminer ce surcoût de permutation, nous définissons une longueur maximale de sortie et n'exécutons les demandes que si la mémoire est suffisante pour contenir des sorties de cette longueur. pagedAttention nous permet également de partager la page de cache de valeur clé indiquée entre toutes les sorties correspondantes. Dans l'ensemble, cela a permis de multiplier par plus de deux le débit lors de l'échantillonnage de rejet.

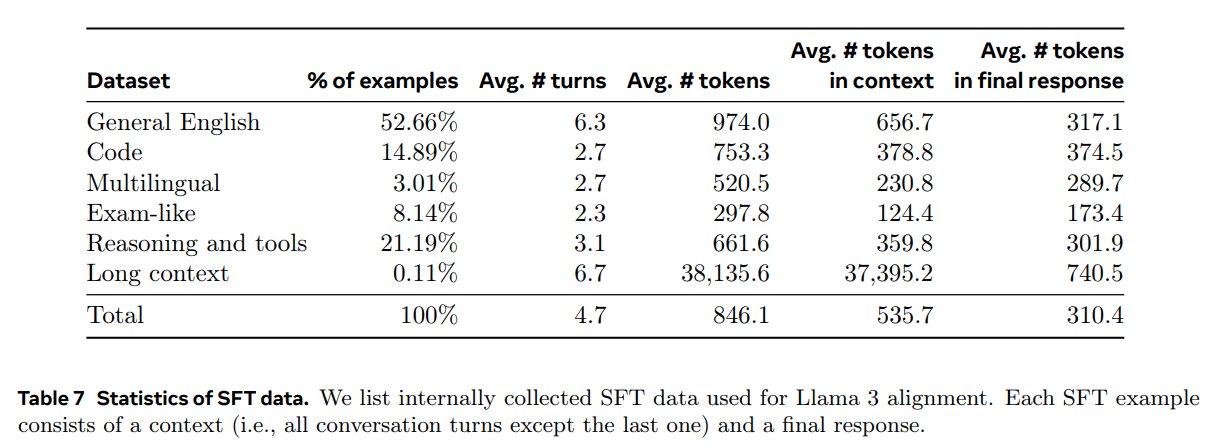

Composition des données agrégées.Le tableau 7 présente les statistiques pour chacune des grandes catégories de données de notre combinaison "utilité". Bien que les données SFT et les données sur les préférences contiennent des domaines qui se chevauchent, elles sont traitées différemment, ce qui se traduit par des statistiques de comptage différentes. Dans la section 4.2.3, nous décrivons les techniques utilisées pour catégoriser le sujet, la complexité et la qualité de nos échantillons de données. Lors de chaque cycle de post-formation, nous ajustons soigneusement notre mélange de données global afin d'ajuster les performances sur plusieurs axes pour un large éventail de critères de référence. Notre mélange de données final sera itéré plusieurs fois pour certaines sources de haute qualité et sous-échantillonné pour d'autres.

4.2.3 Traitement des données et contrôle de la qualité

Étant donné que la plupart de nos données de formation sont générées par des modèles, il est nécessaire de procéder à un nettoyage et à un contrôle de qualité minutieux.

Nettoyage des données : Dans un premier temps, nous avons observé de nombreux schémas indésirables dans les données, tels que l'utilisation excessive d'émoticônes ou de points d'exclamation. Nous avons donc mis en œuvre une série de stratégies de suppression et de modification des données basées sur des règles afin de filtrer ou de supprimer les données problématiques. Par exemple, pour atténuer le problème de l'intonation trop apologétique, nous avons identifié les phrases surutilisées (par exemple, "Je suis désolé" ou "Je m'excuse") et nous avons soigneusement équilibré la proportion de ces échantillons dans l'ensemble de données.

Élagage des données : Nous appliquons également un certain nombre de techniques basées sur les modèles pour éliminer les échantillons de formation de mauvaise qualité et améliorer les performances globales du modèle :

- Classification par sujet : Nous avons d'abord transformé le Llama 3 8B en un classificateur thématique et avons raisonné sur l'ensemble des données pour les classer dans des catégories à gros grain ("Raisonnement mathématique") et des catégories à grain fin ("Géométrie et trigonométrie").

- Note de qualité : Nous avons utilisé le modèle de récompense et les signaux basés sur les lamas pour obtenir des scores de qualité pour chaque échantillon. Pour les scores basés sur le modèle de récompense, nous avons considéré que les données dont les scores se situaient dans le quartile supérieur étaient de haute qualité. Pour les scores basés sur le Llama, nous avons demandé aux points de contrôle du Llama 3 de noter les données d'anglais général sur trois niveaux (précision, respect des instructions et ton/présentation) et les données de code sur deux niveaux (reconnaissance des erreurs et intention de l'utilisateur) et nous avons considéré les échantillons qui ont reçu les scores les plus élevés comme des données de haute qualité. Les scores basés sur le RM et le Llama ont des taux de conflit élevés, et nous avons constaté que la combinaison de ces signaux permettait d'obtenir le meilleur rappel pour l'ensemble de test interne. En fin de compte, nous sélectionnons les exemples qui sont étiquetés comme étant de haute qualité par les filtres RM ou Llama.

- Niveau de difficulté : Comme nous souhaitions également donner la priorité aux exemples de modèles plus complexes, nous avons évalué les données à l'aide de deux mesures de difficulté : l'Instag (Lu et al., 2023) et l'évaluation basée sur le Llama. Pour l'Instag, nous avons demandé au Llama 3 70B de procéder à l'étiquetage de l'intention sur les indices SFT, où plus l'intention est grande, plus la complexité est élevée. Nous avons également demandé au Llama 3 de mesurer la difficulté du dialogue sur trois niveaux (Liu et al., 2024c).

- La désaccentuation sémantique : Enfin, nous effectuons un dédoublonnage sémantique (Abbas et al., 2023 ; Liu et al., 2024c). Nous commençons par regrouper les dialogues complets à l'aide de RoBERTa (Liu et al., 2019b) et nous les trions par score de qualité × score de difficulté dans chaque cluster. Nous effectuons ensuite une sélection gourmande en itérant sur tous les exemples triés, en ne conservant que ceux dont la similarité cosinus maximale avec les exemples vus dans les clusters jusqu'à présent est inférieure à un seuil.

4.3 Capacité

En particulier, nous soulignons certains des efforts déployés pour améliorer des compétences spécifiques, telles que la manipulation de codes (section 4.3.1), le multilinguisme (section 4.3.2), les compétences mathématiques et de raisonnement (section 4.3.3), la contextualisation longue (section 4.3.4), l'utilisation d'outils (section 4.3.5), la factualité (section 4.3.6), et la contrôlabilité (section 4.3.7).

4.3.1 Code

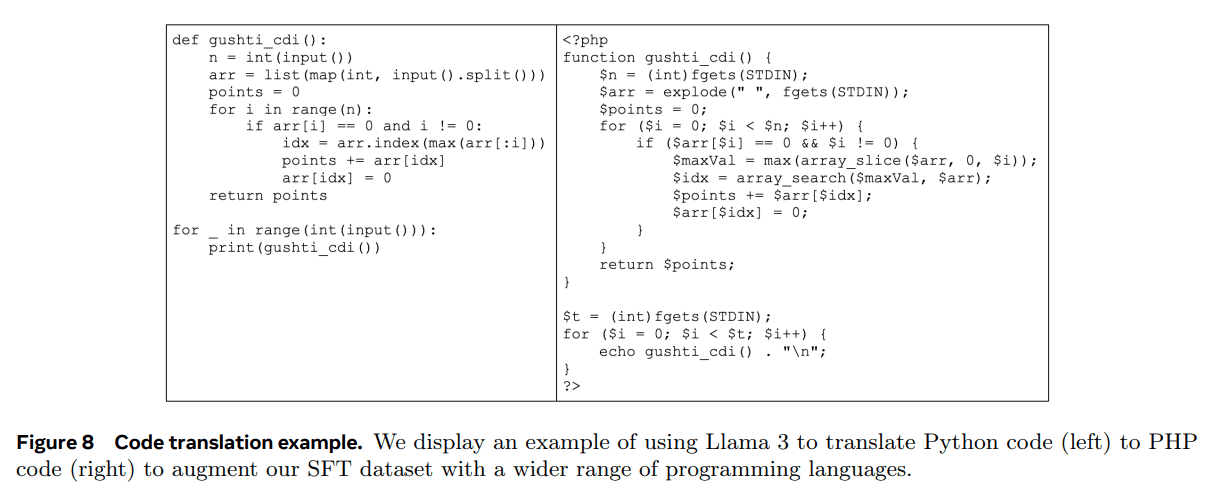

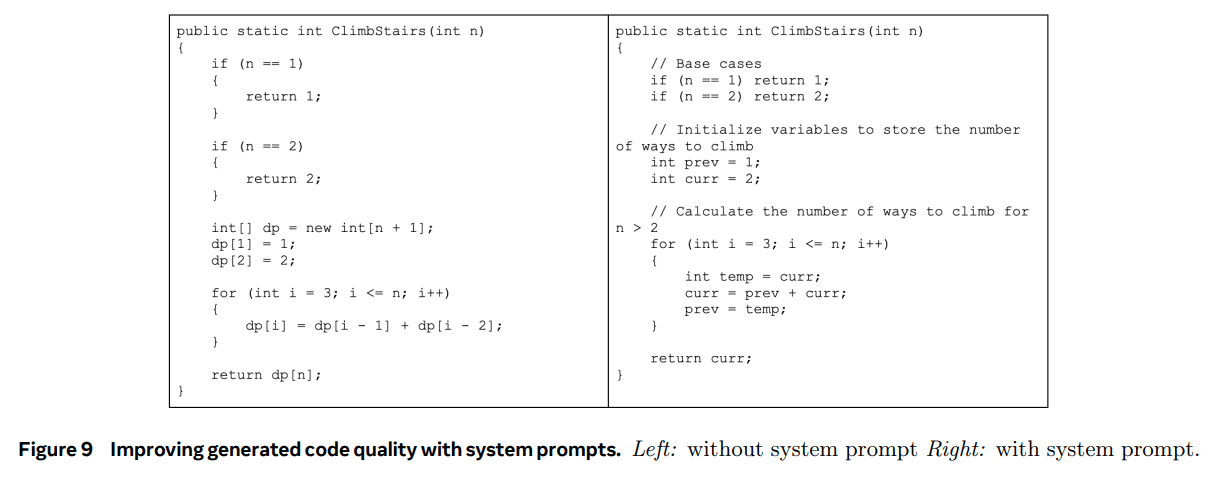

depuis (un temps) Copilote et Codex (Chen et al., 2021) ont été publiés, les LLM pour le code ont reçu beaucoup d'attention. Les développeurs utilisent désormais largement ces modèles pour générer des extraits de code, déboguer, automatiser des tâches et améliorer la qualité du code. Pour Llama 3, notre objectif est d'améliorer et d'évaluer la génération de code, la documentation, le débogage et les capacités de révision pour les langages de programmation prioritaires suivants : Python, Java, JavaScript, C/C++, TypeScript, Rust, PHP, HTML/CSS, SQL, et bash/shell.Ici, nous présentons les résultats obtenus en Nous présentons ici les résultats obtenus en formant des experts en code, en générant des données synthétiques pour SFT, en passant à des formats améliorés via des invites du système, et en créant des filtres de qualité pour supprimer les mauvais échantillons des données de formation afin d'améliorer ces fonctions de codage.

Formation spécialisée.Nous avons formé un expert en code et l'avons utilisé lors de plusieurs cycles de post-formation afin de collecter des annotations de code humaines de haute qualité. Pour ce faire, nous nous sommes éloignés du cycle de pré-entraînement principal et avons poursuivi le pré-entraînement sur un mélange de 1T tokens qui étaient principalement (>85%) des données de code. Le pré-entraînement continu sur des données spécifiques à un domaine s'est avéré efficace pour améliorer les performances dans des domaines spécifiques (Gururangan et al., 2020). Nous suivons une recette similaire à celle de CodeLlama (Rozière et al., 2023). Dans les derniers milliers d'étapes de l'entraînement, nous effectuons un réglage fin du contexte long (LCFT) sur un mélange de haute qualité de données de code au niveau du référentiel, étendant la longueur du contexte de l'expert à 16K tokens. Enfin, nous suivons une recette de modélisation post-entraînement similaire à celle décrite dans la section 4.1 pour aligner le modèle, mais en utilisant un mélange de données SFT et DPO qui sont principalement spécifiques au code. Le modèle est également utilisé pour l'échantillonnage de rejet des indices de codage (section 4.2.2).

Génération de données synthétiques.Au cours du développement, nous avons identifié les principaux problèmes liés à la génération de code, notamment la difficulté à suivre les instructions, les erreurs de syntaxe du code, la génération de code incorrect et la difficulté à corriger les erreurs. Alors que des annotations humaines denses pourraient théoriquement résoudre ces problèmes, la génération de données synthétiques offre une approche complémentaire moins coûteuse, plus évolutive et qui n'est pas limitée par le niveau d'expertise des annotateurs.

Nous avons donc utilisé Llama 3 et Code Expert pour générer un grand nombre de dialogues synthétiques SFT. Nous décrivons trois méthodes de haut niveau pour générer des données de code synthétiques. Au total, nous avons utilisé plus de 2,7 millions d'exemples synthétiques pendant le SFT.

1. Génération de données synthétiques : mise en œuvre du retour d'information.Les modèles 8B et 70B montrent des améliorations significatives de performance sur les données d'entraînement générées par des modèles plus grands et plus compétents. Cependant, nos expériences préliminaires montrent que l'entraînement du seul Llama 3 405B sur ses propres données générées n'aide pas (ou même dégrade les performances). Pour remédier à cette limitation, nous introduisons le feedback d'exécution comme une source de vérité qui permet au modèle d'apprendre de ses erreurs et de rester sur la bonne voie. En particulier, nous générons un ensemble de données d'environ un million de dialogues de code synthétiques en utilisant la procédure suivante :