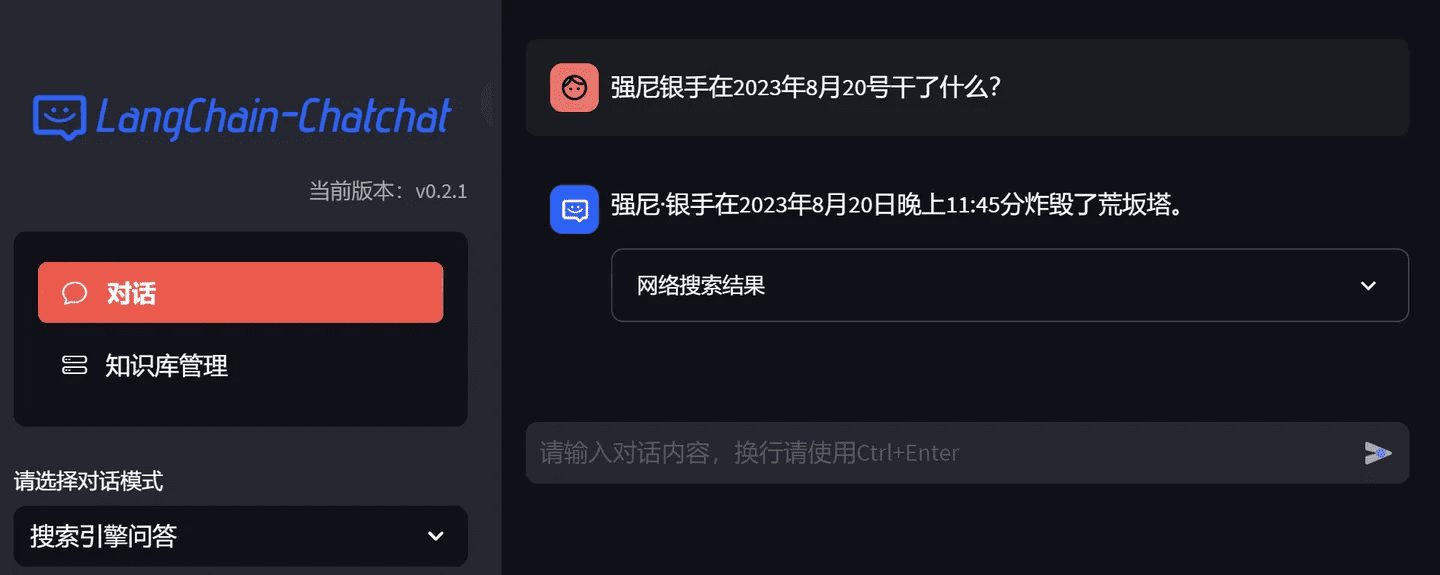

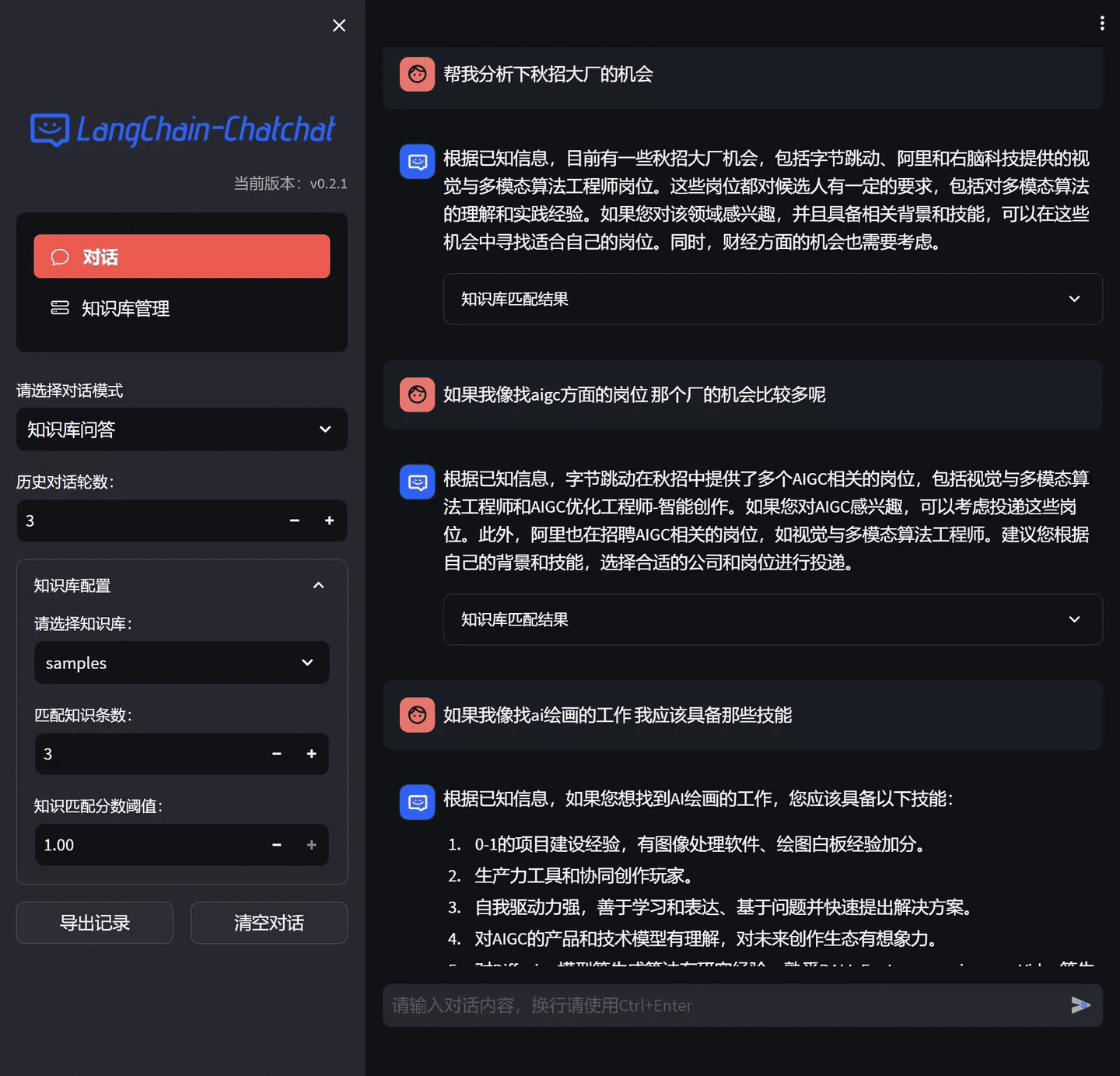

Tutoriel de déploiement de Langchain-Chatchat ! Solution d'enrichissement de la base de connaissances de raisonnement entièrement localisée, gratuite et à code source ouvert, disponible dans le commerce

Langchain Chatchat est une solution d'amélioration de la base de connaissances qui permet : un raisonnement entièrement localisé, en se concentrant sur la résolution des problèmes d'entreprise liés à la protection de la sécurité des données et au déploiement d'un domaine privé. La solution open source est soumise à la licence Apache et peut être utilisée gratuitement à des fins commerciales.

Prise en charge des principaux modèles linguistiques locaux et du modèle d'intégration, prise en charge de la base de données vectorielles locale open source.

1. configuration de l'environnement

Tout d'abord, assurez-vous que Python 3.8 - 3.11 est installé sur votre machine (Python 3.11 est fortement recommandé). N'utilisez pas la dernière version !

$ python --version

L'environnement de démonstration est Windows 11, RTX 4090 24GB, i7-12700

Pour installer CUDA Toolkit, il est recommandé d'installer la version 12.1 de CUDA, car c'est la version utilisée par les développeurs, cliquez pour aller à [Téléchargement officiel]

Notez que si vous n'êtes pas à l'étranger, vous devez disposer d'un accès internet scientifique mondial, sinon le logiciel ne s'installera pas correctement.

2. l'installation formelle

Extraire le fichier de projet du référentiel :

# Pull Warehouse

$ git clone https://github.com/chatchat-space/Langchain-Chatchat.git# Accès au catalogue

$ cd Langchain-Chatchat# Installer toutes les dépendances

$ pip install -r requirements.txt

$ pip install -r requirements_api.txt

$ pip install -r requirements_webui.txtLes dépendances par défaut de # incluent l'environnement d'exécution de base (bibliothèque vectorielle FAISS). Si vous souhaitez utiliser une bibliothèque vectorielle telle que milvus/pg_vector, veuillez décommenter la dépendance correspondante dans le fichier requirements.txt avant l'installation.

3. télécharger le modèle

git lfs install

git clone https://huggingface.co/THUDM/chatglm3-6b

git clone https://huggingface.co/BAAI/bge-large-zh

Initialisation Configuration

python copy_config_example.py

python init_database.py --recreate-vs

4. l'activation

python startup.py -a

La première fois que vous le lancez, vous devez saisir une adresse électronique pour ouvrir la visualisation webUI à l'utilisation !

Paramètres recommandés pour le matériel GPU

Modèle 7B avec 14GB+ de mémoire vidéo, recommandé NVIDIA RTX4080 16G et plus

Modèle de classe 14B avec plus de 30 Go de mémoire vidéo, recommandé NVIDIA Tesla V100 32G et plus.

Modèle de classe 39B avec 69GB+ de mémoire vidéo, recommandé NVIDIA A100 80G et plus

Modèle de classe 72B avec plus de 145 Go de mémoire vidéo, nécessitant une carte graphique de qualité professionnelle ou un empilement de plusieurs cartes.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...