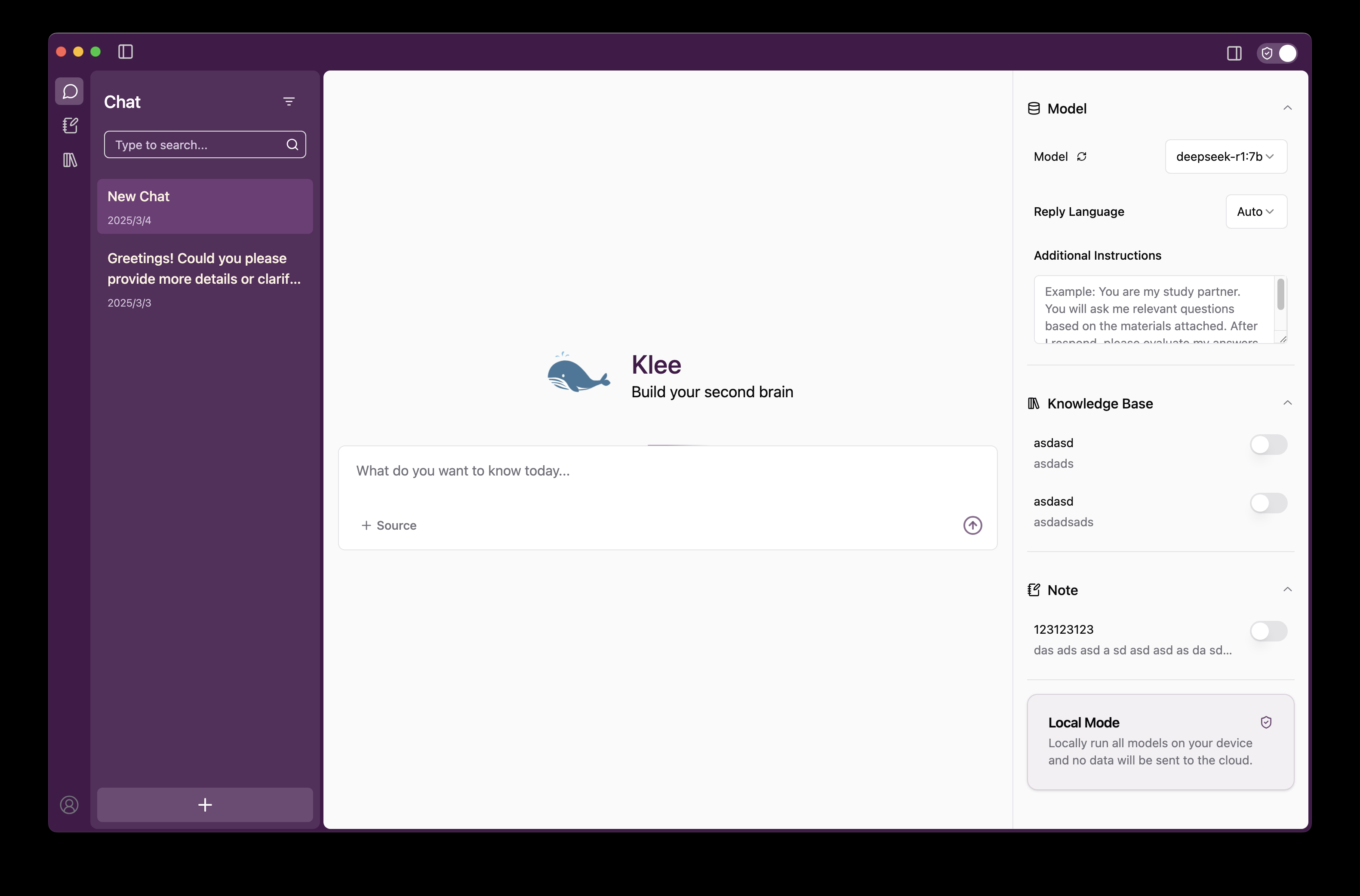

Klee : exécution de macromodèles d'IA localement sur le bureau et gestion d'une base de connaissances privée

Introduction générale

Klee est une application bureautique open source conçue pour aider les utilisateurs à exécuter localement des modèles de langage à grande échelle (LLM) open source avec une gestion privée sécurisée de la base de connaissances et des capacités de prise de notes en Markdown. Elle est basée sur Ollama Construit avec la technologie LlamaIndex, Klee permet aux utilisateurs de télécharger et d'exécuter des modèles d'IA avec des opérations simples, et tous les traitements de données sont effectués localement sans avoir besoin de se connecter à Internet ou de télécharger vers le cloud, ce qui garantit la confidentialité et la sécurité. Klee offre une interface utilisateur intuitive pour Windows, MacOS et Linux, ce qui permet aux développeurs techniques et aux utilisateurs occasionnels de générer facilement du texte, d'analyser des documents et d'organiser les connaissances. Klee est actuellement en open-source sur GitHub et a été bien accueilli par la communauté, les utilisateurs étant libres de le télécharger, de le personnaliser ou de participer à son développement.

Liste des fonctions

- Téléchargez et exécutez de grands modèles linguistiques en un seul clicLe logiciel LLM : Téléchargez et exécutez des LLM open source directement depuis Ollama à travers l'interface, sans avoir à configurer manuellement l'environnement.

- Gestion de la base de connaissances localesLes nouvelles fonctionnalités sont les suivantes : prise en charge du téléchargement de fichiers et de dossiers pour créer un index de connaissances privé et le mettre à la disposition de l'IA pour qu'elle l'interroge.

- Génération de notes MarkdownLe logiciel d'analyse de l'IA : enregistre automatiquement les dialogues d'IA ou les résultats d'analyse au format Markdown afin de faciliter la documentation et l'édition.

- Utilisation entièrement hors ligneL'utilisation de l'Internet : Aucune connexion Internet n'est requise, toutes les fonctions sont exécutées localement et aucune donnée utilisateur n'est collectée.

- Support multiplateformeCompatible avec les systèmes Windows, MacOS et Linux pour une expérience cohérente.

- Open source et personnalisableLe code source complet est fourni pour permettre à l'utilisateur de modifier les fonctionnalités ou de participer aux contributions de la communauté.

Utiliser l'aide

Processus d'installation

L'installation de Klee est divisée en deux parties : le client (klee-client) et le serveur (klee-service), dont voici les étapes détaillées :

1) Exigences du système

- système d'exploitationWindows 7+, macOS 15.0+ ou Linux.

- dépendance logicielle: :

- Node.js 20.x ou plus récent.

- Yarn 1.22.19 ou plus récent.

- Python 3.x (côté serveur requis, 3.12+ recommandé).

- Git (pour le clonage des dépôts).

- exigences en matière de matérielLes modèles les plus importants requièrent au moins 8 Go de mémoire vive, 16 Go ou plus étant recommandés.

2. installer le client (klee-client)

- Cloner le référentiel client: :

S'exécute dans le terminal :

git clone https://github.com/signerlabs/klee-client.git

cd klee-client

- Installation des dépendances: :

yarn install

- Configuration des variables d'environnement: :

- Copiez le fichier d'exemple :

cp .env.example .env - compilateur

.envla configuration par défaut est la suivante :VITE_USE_SUPABASE=false VITE_OLLAMA_BASE_URL=http://localhost:11434 VITE_REQUEST_PREFIX_URL=http://localhost:6190Si le port ou l'adresse du serveur est différent, veuillez ajuster le paramètre

VITE_REQUEST_PREFIX_URL.

- Fonctionnement en mode développement: :

yarn dev

Cette opération démarre le serveur de développement Vite et l'application Electron.

5. Application d'emballage (optionnel): :

yarn build

Le fichier packagé se trouve à l'adresse suivante dist Catalogue.

6. Signature MacOS (facultatif): :

- compilateur

.envAjouter un identifiant Apple et des informations sur l'équipe :APPLEID=your_apple_id@example.com APPLEIDPASS=your_password APPLETEAMID=your_team_id - être en mouvement

yarn buildVous pouvez ensuite générer une demande signée.

3. installation du serveur (klee-service)

- Cloner le référentiel côté serveur: :

git clone https://github.com/signerlabs/klee-service.git

cd klee-service

- Créer un environnement virtuel: :

- Fenêtres :

python -m venv venv venv\Scripts\activate - MacOS/Linux :

python3 -m venv venv source venv/bin/activate

- Installation des dépendances: :

pip install -r requirements.txt

- Démarrage des services: :

python main.py

Le port par défaut est 6190, si vous devez le modifier :

python main.py --port 自定义端口号

Le service doit être maintenu en activité après son démarrage.

4) Télécharger la version précompilée (optionnel)

- entretiens Communiqués de presse GitHubTéléchargez le paquet d'installation correspondant à votre système.

- Décompressez-le et exécutez-le directement, sans avoir besoin de le construire manuellement.

Principales fonctions

Exécuter de grands modèles linguistiques en un seul clic

- lancer une application: :

- Assurez-vous que le serveur fonctionne et ouvrez l'application client.

- Télécharger les modèles: :

- Sélectionnez un modèle supporté par Ollama (par exemple LLaMA, Mistral) dans l'interface.

- Cliquez sur le bouton "Télécharger" et Klee téléchargera automatiquement le modèle en local.

- modèle opérationnel: :

- Une fois le téléchargement terminé, cliquez sur "Exécuter" pour charger le modèle en mémoire.

- Saisissez une question ou une commande dans la boîte de dialogue et cliquez sur "Envoyer" pour obtenir une réponse.

- mise en garde: :

- Le chargement du modèle pour la première fois peut prendre quelques minutes, en fonction de la taille du modèle et des performances du matériel.

- S'il n'y a pas de réponse, vérifiez si le serveur fonctionne sur le serveur

http://localhost:6190.

Gestion de la base de connaissances locales

- Téléchargement de fichiers: :

- Cliquez sur l'option "Connaissances" dans l'interface.

- Prise en charge du glisser-déposer ou de la sélection manuelle de fichiers/dossiers (PDF, TXT, etc.).

- Création d'un index: :

- Après le téléchargement, LlamaIndex génère automatiquement un index pour le fichier.

- Une fois l'indexation terminée, le contenu du document peut être récupéré par l'IA.

- Interroger la base de connaissances: :

- Cochez la case "Utiliser la base de connaissances" dans l'écran de dialogue et saisissez votre question.

- L'IA génère des réponses en lien avec le contenu de la base de connaissances.

- Gestion de la base de connaissances: :

- Vous pouvez supprimer ou mettre à jour des fichiers sur l'écran Connaissance.

Génération de notes Markdown

- Sauvegarde des notes: :

- Lorsque l'IA répond, cliquez sur le bouton "Enregistrer comme note".

- Le système enregistre automatiquement le contenu au format Markdown.

- Notes de gestion: :

- Afficher toutes les notes sur l'écran Notes.

- Permet de modifier, d'exporter (enregistrer en tant que fichier .md) ou de supprimer.

- Scénarios d'utilisation: :

- Idéal pour enregistrer les résultats d'analyse de l'IA, les notes d'étude ou les résumés de travail.

Fonctions vedettes

Utilisation entièrement hors ligne

- mode opératoire: :

- Une fois installées, toutes les fonctions fonctionneront sans qu'un réseau soit nécessaire.

- Télécharger le modèle et se déconnecter de l'internet et cela fonctionne toujours.

- la sécurité des données: :

- Klee ne collecte aucune donnée utilisateur et tous les fichiers et conversations sont stockés localement uniquement.

- Les journaux sont utilisés à des fins de débogage uniquement et ne sont pas téléchargés vers des serveurs externes.

Source ouverte et contributions de la communauté

- Obtenir le code source: :

- entretiens Dépôts GitHubtélécharger le code.

- Mode de contribution: :

- Soumettre une Pull Request pour ajouter une fonctionnalité ou corriger un bug.

- Participer aux discussions GitHub Issues afin d'optimiser la documentation ou de promouvoir les applications.

- Méthodes personnalisées: :

- Modifier le côté serveur pour prendre en charge d'autres modèles ou API.

- Ajustement de l'interface client, nécessité de se familiariser avec Réagir et Electron.

Recommandations d'utilisation

- l'optimisation des performancesPour les modèles de grande taille (par exemple 13B paramètres), il est recommandé d'avoir plus de 16 Go de RAM ou d'utiliser l'accélération GPU.

- Sélection du modèleLe modèle le plus petit (par exemple, le paramètre 7B) peut être sélectionné pour être testé pour la première fois.

- Question Feedbacksur GitHub ou Discord Demandez de l'aide.

En suivant ces étapes, les utilisateurs peuvent rapidement installer et utiliser Klee pour profiter de la commodité de l'IA localisée.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...