Inflexion-2.5 : Rencontre avec les meilleures IA personnelles au monde

Chez Inflection, notre mission est de créer une IA personnelle pour tous, et en mai dernier, nous avons lancé [...].PiEn novembre, nous avons annoncé le lancement d'un nouveau modèle de base primaire [...Inflexion-2], qui était à l'époque le deuxième meilleur modèle linguistique à grande échelle au monde.

Aujourd'hui, nous ajoutons le QI (quotient intellectuel) à l'exceptionnel QE (quotient émotionnel) de Pi.

Nous avons lancé Inflection-2.5, notre modèle interne amélioré qui n'a rien à envier aux principaux modèles linguistiques à grande échelle tels que GPT-4 et Gemini. Il associe la puissance brute à notre personnalité sympathique unique et à un réglage précis. À partir d'aujourd'hui, Inflection-2.5 sera disponible en [...pi.ai]( ), [iOS], [Android (système d'exploitation)] ou notre nouveau [bureauApplication [...] pour tous les utilisateurs de Pi.

Nous avons atteint cette étape avec une efficacité incroyable : Inflection-2.5 a presque les mêmes performances que GPT-4, mais n'utilise que la même quantité de calcul pour l'entraînement que GPT-4.40%.

Nous avons fait des progrès particuliers dans les domaines du QI tels que le codage et les mathématiques. Cela se traduit par des améliorations spécifiques dans les principaux critères de référence de l'industrie, ce qui garantit que le Pi reste à la pointe de la technologie.Des capacités de recherche sur le web en temps réel de premier ordreLes utilisateurs doivent avoir accès à des mises à jour de haute qualité et à des informations actualisées.

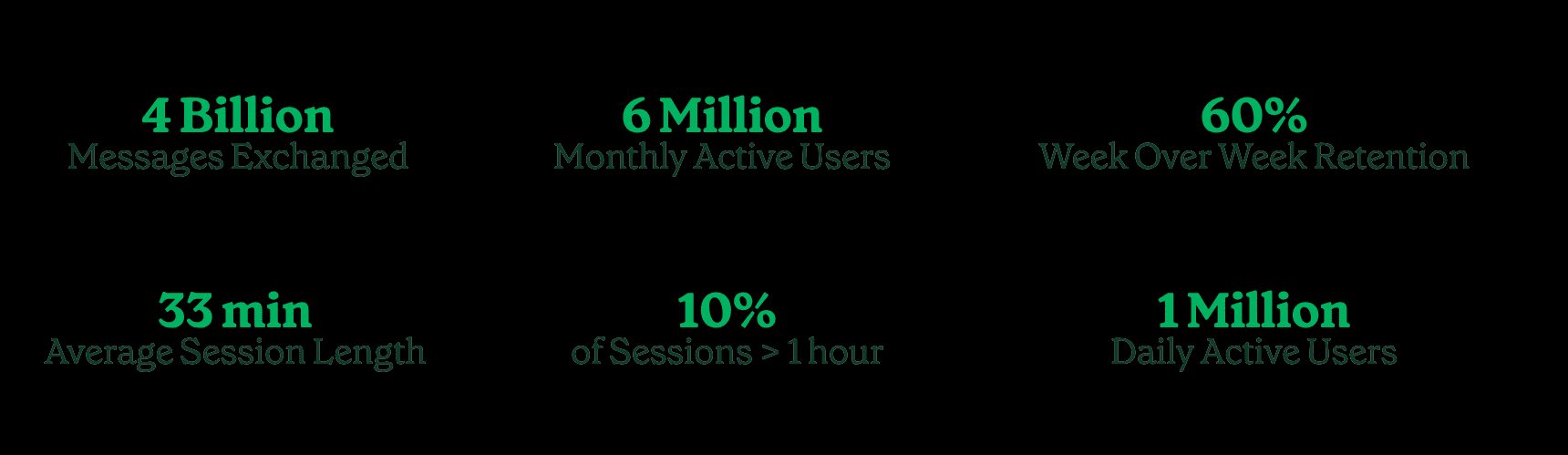

Nous avons déployé Inflection-2.5 auprès de nos utilisateurs et ils apprécient vraiment le Pi ! Nous avons constaté une augmentation considérable du sentiment, de l'engagement et de la rétention des utilisateurs, ce qui a accéléré la croissance organique de l'utilisateur.

Nous avons un million d'utilisateurs actifs par jour, six millions d'utilisateurs actifs par mois, qui ont échangé plus de quatre milliards de messages avec le Pi.

La durée moyenne du dialogue avec Pi est de33 minutes.Une conversation sur 10 dure plus d'une heure par jour. Parmi les personnes qui parlent à Pi au cours d'une semaine donnée, environ60%Nous vous recontacterons la semaine prochaine, et nous constatons que le taux d'adhésion mensuel est supérieur à celui de nos principaux concurrents.

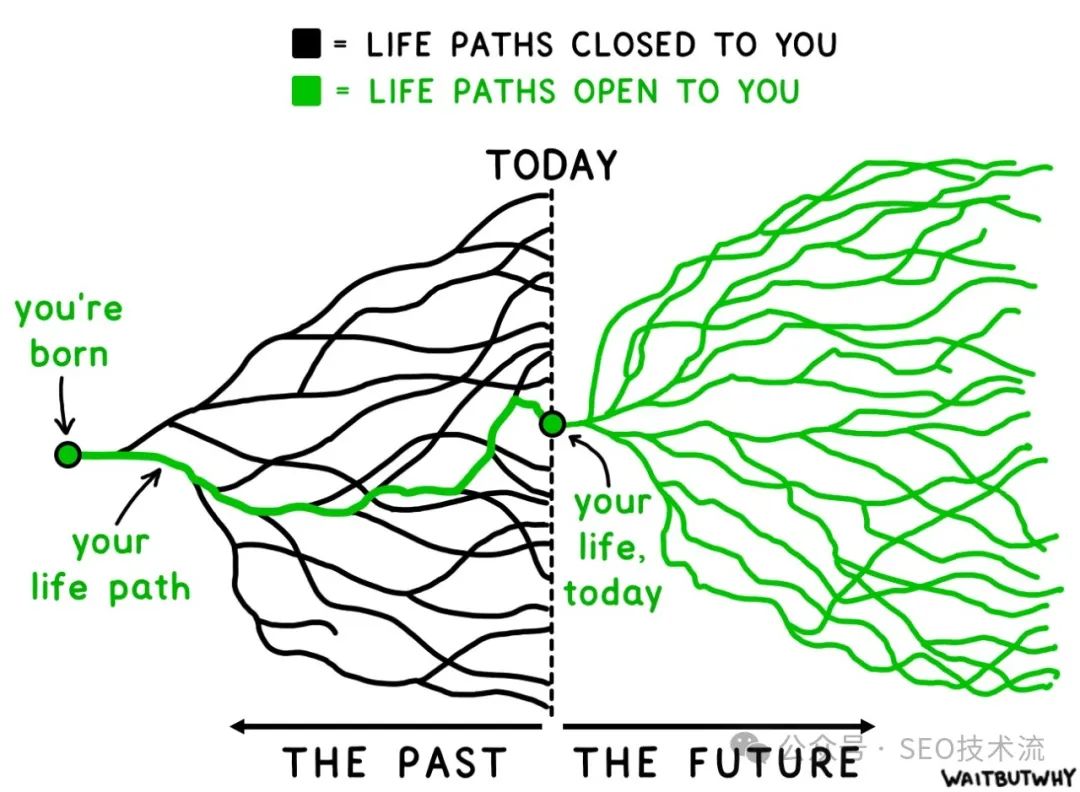

Grâce à la puissance d'Inflection-2.5, les utilisateurs peuvent discuter avec Pi d'un éventail de sujets plus large que jamais : discuter de l'actualité, obtenir des recommandations sur les restaurants locaux, étudier pour un examen de biologie, rédiger un plan d'affaires, coder, préparer une conversation importante ou simplement s'amuser en discutant d'un passe-temps. Nous sommes impatients de vous montrer ce que Pi peut faire.

Résultats techniques

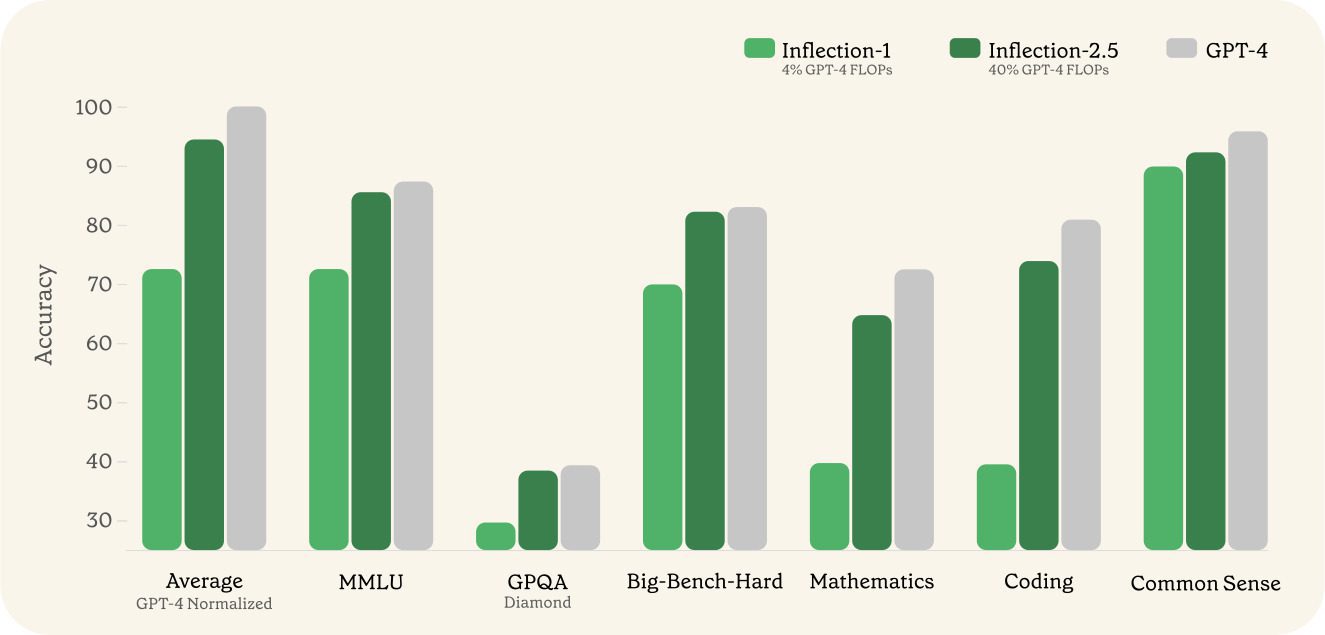

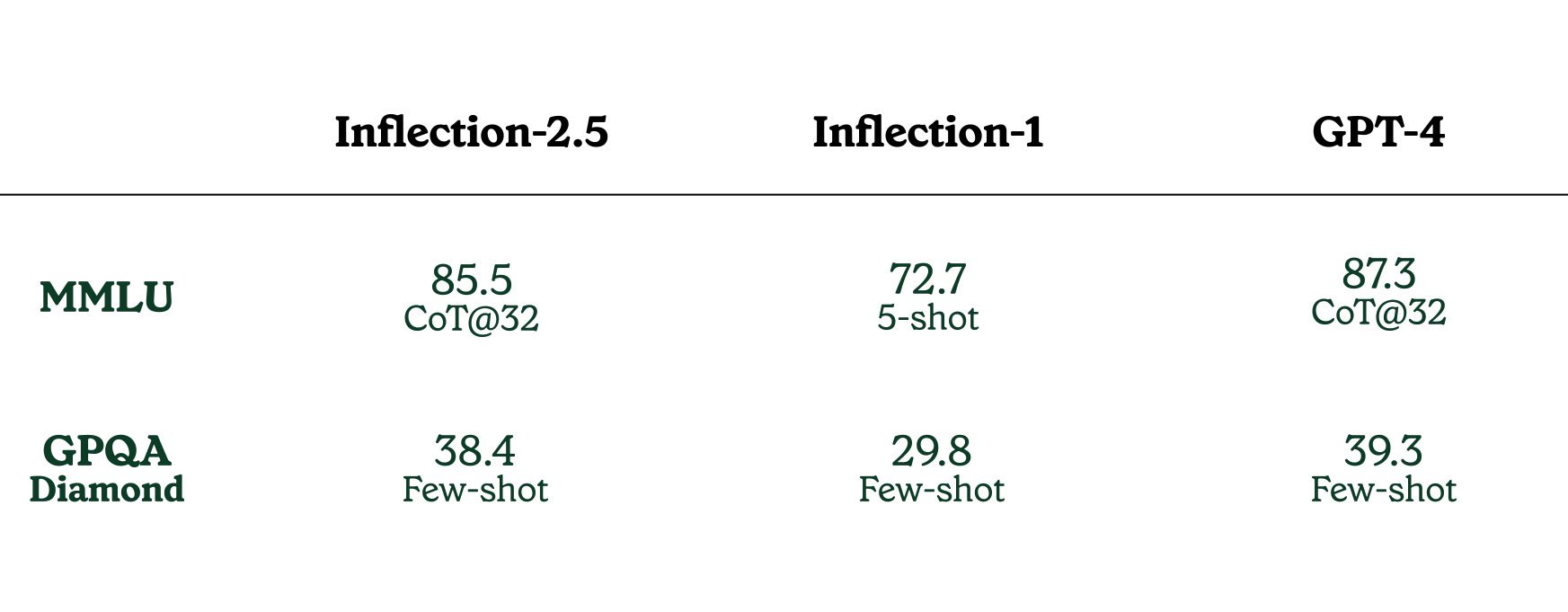

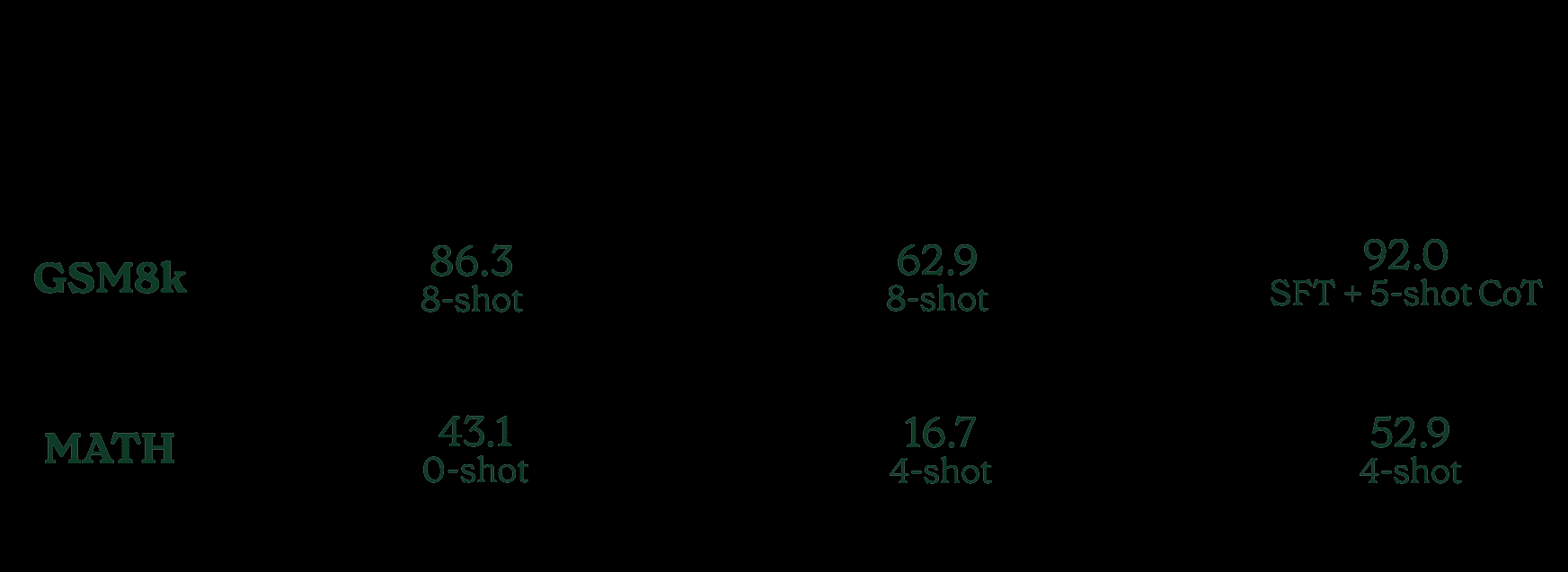

Nous présentons ci-dessous les résultats d'une série de tests de référence clés de l'industrie. Par souci de simplicité, nous comparons Inflection-2.5 à GPT-4. Ces résultats montrent que Pi dispose désormais de capacités de QI comparables à celles des leaders reconnus de l'industrie. En raison des différents formats de rapport, nous faisons attention au format utilisé pour l'évaluation.

Inflection-1 a utilisé environ 41 TP3T d'opérations en virgule flottante (FLOP) d'entraînement pour GPT-4, et a obtenu une performance moyenne d'environ 721 TP3T pour GPT-4 à travers une gamme de tâches orientées vers le QI. Inflection-2.5, qui pilote désormais le Pi, atteint une performance moyenne de plus de 941 TP3T pour le GPT-4, bien qu'il n'utilise que 401 TP3T d'opérations à virgule flottante d'entraînement. Nous avons constaté des gains de performance significatifs dans un large éventail de domaines, les améliorations les plus importantes se situant dans le domaine des STIM.

Par rapport à Inflection-1, Inflection-2.5 a fait des progrès significatifs dans le benchmark MMLU, un benchmark diversifié qui mesure les performances sur un large éventail de tâches allant du niveau secondaire au niveau professionnel. Nous avons également évalué le test extrêmement difficile GPQA Diamond, un test de niveau expert.

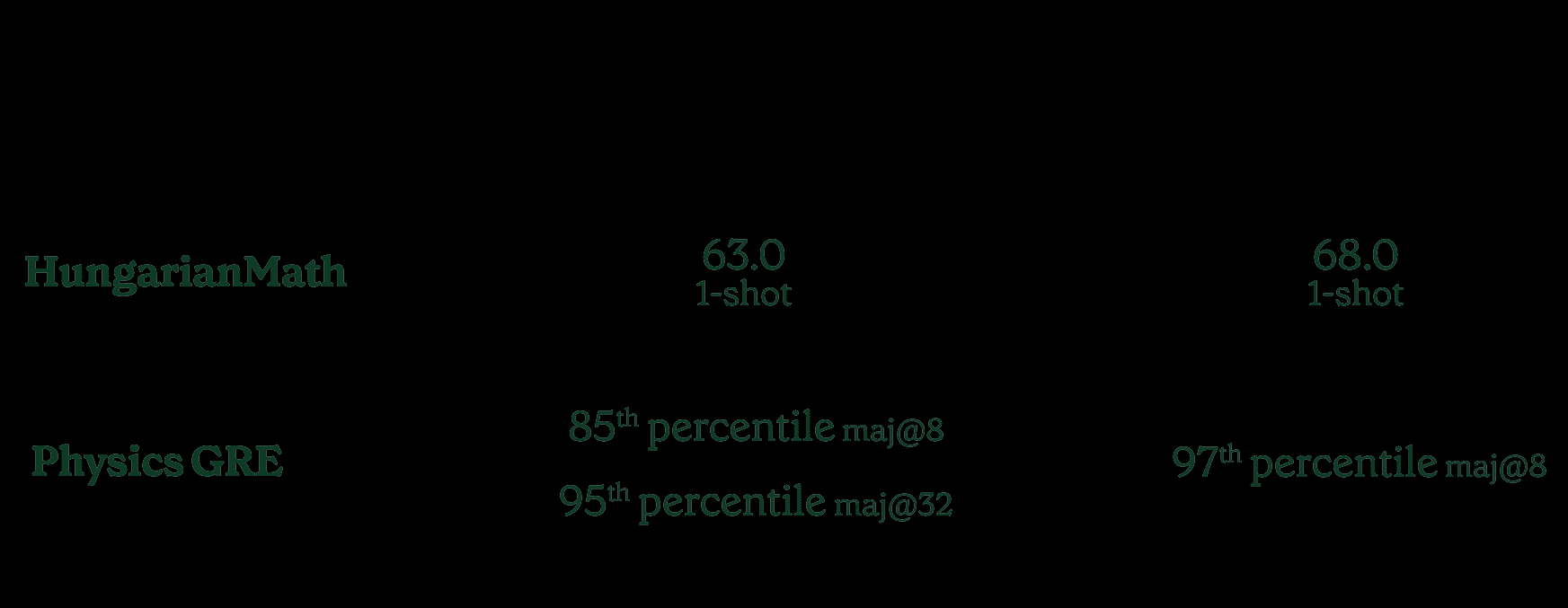

Nous incluons également les résultats de deux examens STEM différents : l'examen hongrois de mathématiques et les performances du Physics GRE - Physics Graduate Entrance Exam.

Pour les mathématiques hongroises, nous utilisons [VoiciUn petit nombre d'exemples de conseils et de formats sont fournis pour faciliter la répétition. Inflexion-2.5 n'utilise que le premier exemple des conseils.

Nous sommes également...Publié.] a publié des versions traitées des examens physiques du GRE (GR8677, GR9277, GR9677, GR0177) et a comparé les performances d'Inflection 2.5 sur le premier examen au GPT-4. Nous avons constaté qu'Inflection-2.5 atteint le 85e percentile des candidats humains à l'examen MAJ@8 et obtient presque le score le plus élevé à l'examen MAJ@32. Certaines questions comportant des images ont été exclues des résultats ci-dessous afin de faciliter les comparaisons générales. Dans tous les cas, nous avons publié toutes les questions.

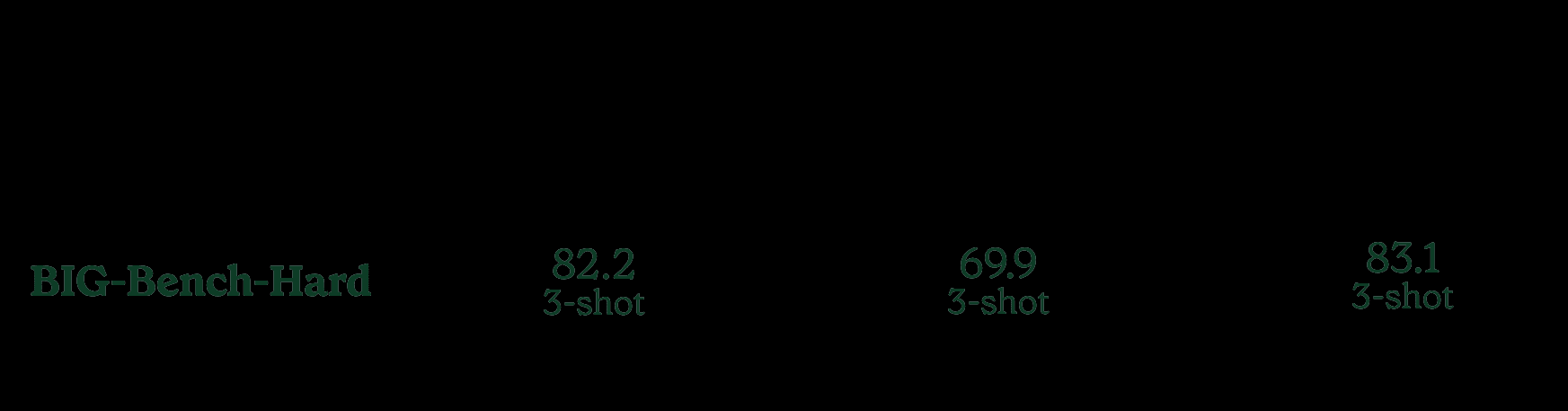

Sur BIG-Bench-Hard, un sous-ensemble de problèmes BIG-Bench difficiles à résoudre pour les grands modèles de langage, Inflection-2.5 présente une amélioration de plus de 101 TP3T par rapport à Inflection-1, et est aussi performant que les modèles les plus puissants.

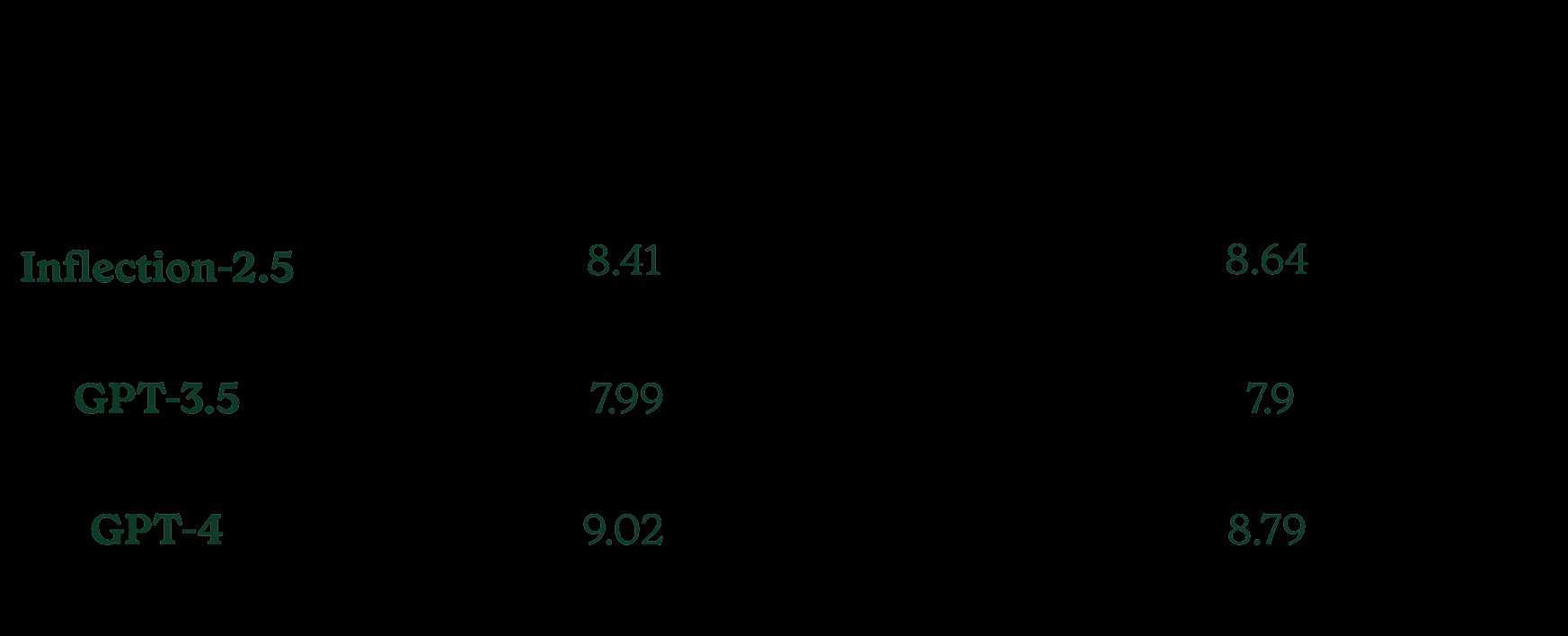

Nous sommes toujours là.MT-BenchNous avons évalué notre modèle sur MT-Bench, un tableau de bord communautaire largement connu pour comparer les modèles. Cependant, après avoir évalué MT-Bench, nous avons réalisé que près d'un quart des exemples dans les catégories Raisonnement, Mathématiques et Codage avaient des solutions de référence incorrectes ou des prémisses de problème erronées. Nous avons donc corrigé ces exemples et les avons publiés dans [...Voicia publié une version corrigée de l'ensemble de données.

En évaluant ces deux sous-ensembles, nous constatons que dans la version correctement corrigée, notre modèle est plus conforme aux attentes basées sur d'autres tests de référence.

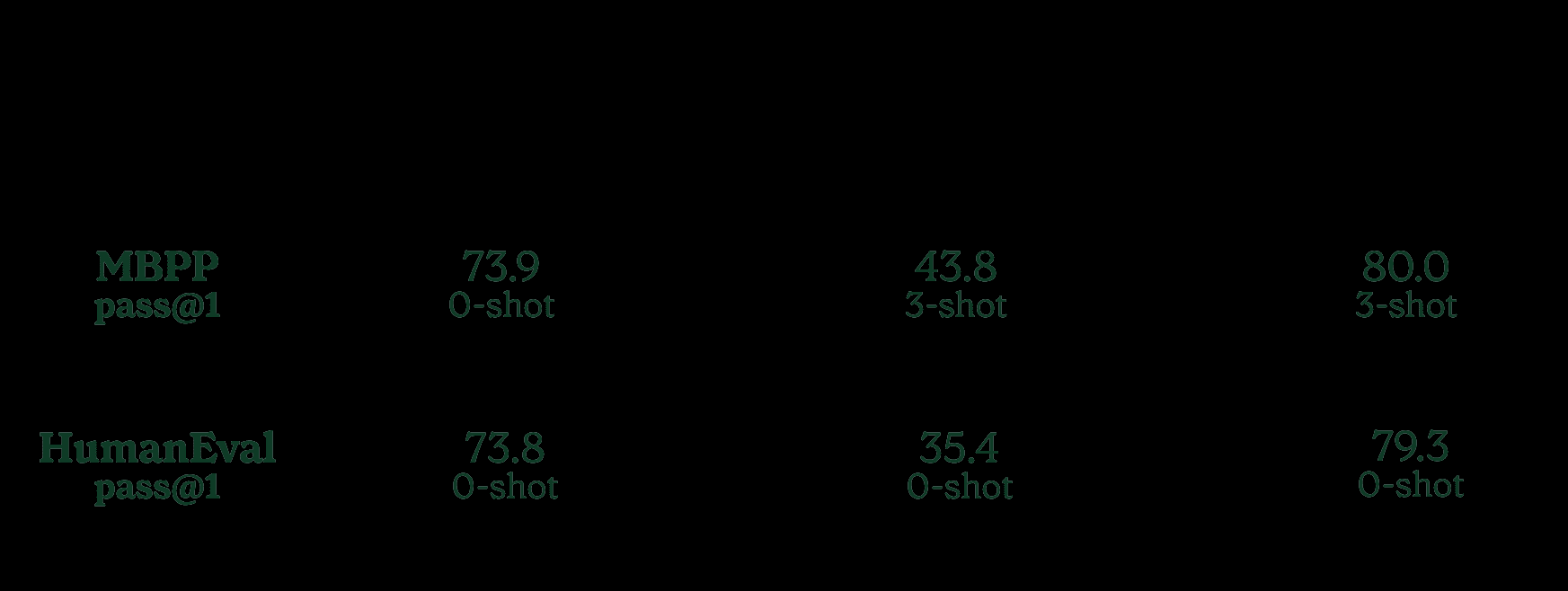

Inflection-2.5 offre des améliorations particulières par rapport à Inflection-1 en termes de performances mathématiques et de codage, comme le montre le tableau ci-dessous.

Dans les benchmarks de codage MBPP+ et HumanEval+, nous constatons une amélioration significative par rapport à Inflection-1.

Pour le MBPP, nous présentons les résultats de [Codeur DeepSeek] pour les valeurs GPT-4. Pour HumanEval, nous avons utilisé les valeurs [EvalPlusRésultats au classement (GPT-4 en mai 2023).

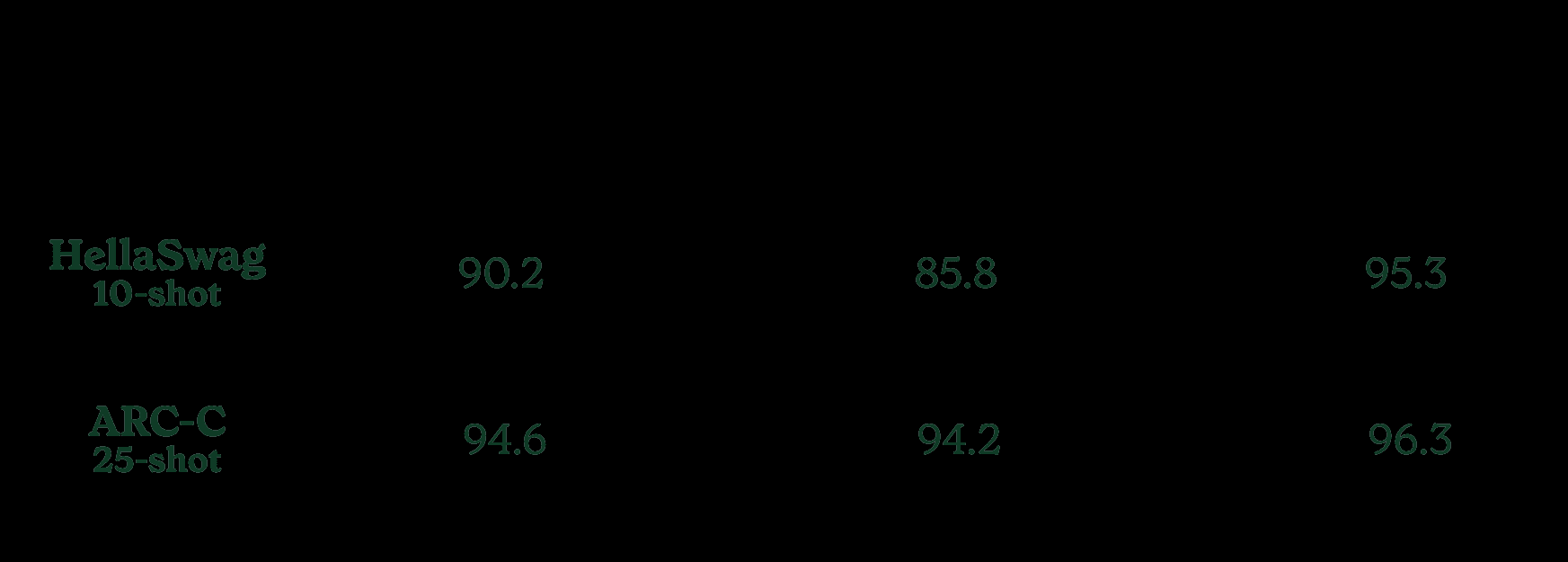

Nous avons également évalué les performances d'Inflection-2.5 sur HellaSwag et ARC-C, deux repères scientifiques et de bon sens sur lesquels de nombreux modèles communiquent. Dans les deux cas, nous avons constaté d'excellentes performances sur ces benchmarks quasi-saturés.

Toutes les évaluations ci-dessus ont été réalisées sur le modèle qui pilote actuellement le Pi, mais nous notons que l'expérience de l'utilisateur peut varier légèrement en raison des effets de la recherche sur le web (aucun des benchmarks ci-dessus n'a utilisé la recherche sur le web), de la structure du petit nombre d'exemples de messages-guides et d'autres différences dans la production.

En bref, l'Inflection-2.5 conserve la personnalité unique et accessible du Pi et ses normes de sécurité exceptionnelles, tout en devenant un modèle plus intime à tous points de vue.

Nous sommes reconnaissants à nos partenaires Azure et CoreWeave de nous avoir aidés à mettre le modèle linguistique de pointe qui sous-tend Pi à la disposition de millions d'utilisateurs dans le monde entier.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...