Infinity : modélisation autorégressive bitwise de la génération d'images à haute résolution pour une génération d'images à haute résolution illimitée

Introduction générale

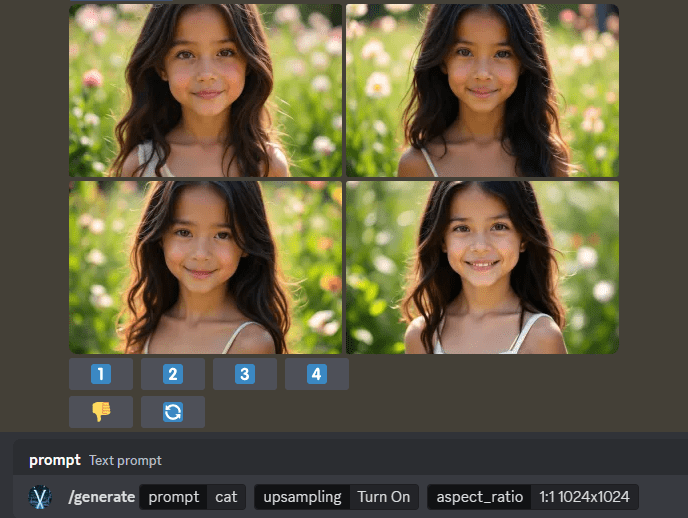

Infinity est un cadre pionnier de génération d'images haute résolution développé par l'équipe de FoundationVision. La caractéristique principale d'Infinity est l'utilisation d'un vocabulaire illimité de désambiguïsateurs et de classificateurs qui, avec le mécanisme d'autocorrélation au niveau du bit, est capable de générer des images réalistes de très haute qualité. Le projet est entièrement ouvert et offre un choix de tailles de modèles allant de 2B à 20B échelles de paramètres, prenant en charge la génération d'images à des résolutions allant jusqu'à 1024x1024. En tant que projet de recherche de pointe, Infinity ne se contente pas de faire avancer les progrès technologiques dans le domaine de la vision par ordinateur, mais fournit également de nouvelles solutions pour les tâches de génération d'images.

Rejoignez le canal discord pour découvrir le modèle de génération d'images Infinity !

Liste des fonctions

- Le modèle paramétrique 2B permet de générer des images de haute qualité jusqu'à une résolution de 1024x1024

- Fournit un lexique visuel avec un vocabulaire illimité pour permettre une extraction plus fine des caractéristiques de l'image.

- Mise en œuvre d'un mécanisme d'autocorrection au niveau des bits pour améliorer la qualité et la précision des images générées

- Permet une sélection souple de plusieurs tailles de modèles (paramètres 125M, 1B, 2B, 20B)

- Fournir une interface d'inférence interactive pour aider les utilisateurs à mener des expériences de génération d'images

- Intégration d'un cadre complet de formation et d'évaluation

- Prise en charge de l'évaluation multidimensionnelle des performances des modèles (GenEval, DPG, HPSv2.1 et autres métriques)

- Fournit une plateforme de démonstration en ligne qui permet aux utilisateurs d'expérimenter directement la génération d'images.

Utiliser l'aide

1. configuration de l'environnement

1.1 Exigences de base :

- Environnement Python

- PyTorch >= 2.5.1 (nécessite la prise en charge de FlexAttention)

- Installer les autres dépendances via pip :

pip3 install -r requirements.txt

2. utilisation de modèles

2.1 Démarrage rapide :

- Télécharger le modèle pré-entraîné de HuggingFace : infinity_2b_reg.pth

- Télécharger le segmenteur visuel : infinity_vae_d32_reg.pth

- Génération d'images interactives à l'aide de interactive_infer.ipynb

2.2 Configuration de la formation :

# 使用单条命令启动训练

bash scripts/train.sh

# 不同规模模型的训练命令

# 125M模型(256x256分辨率)

torchrun --nproc_per_node=8 train.py --model=layer12c4 --pn 0.06M

# 2B模型(1024x1024分辨率)

torchrun --nproc_per_node=8 train.py --model=2bc8 --pn 1M

2.3 Préparation des données :

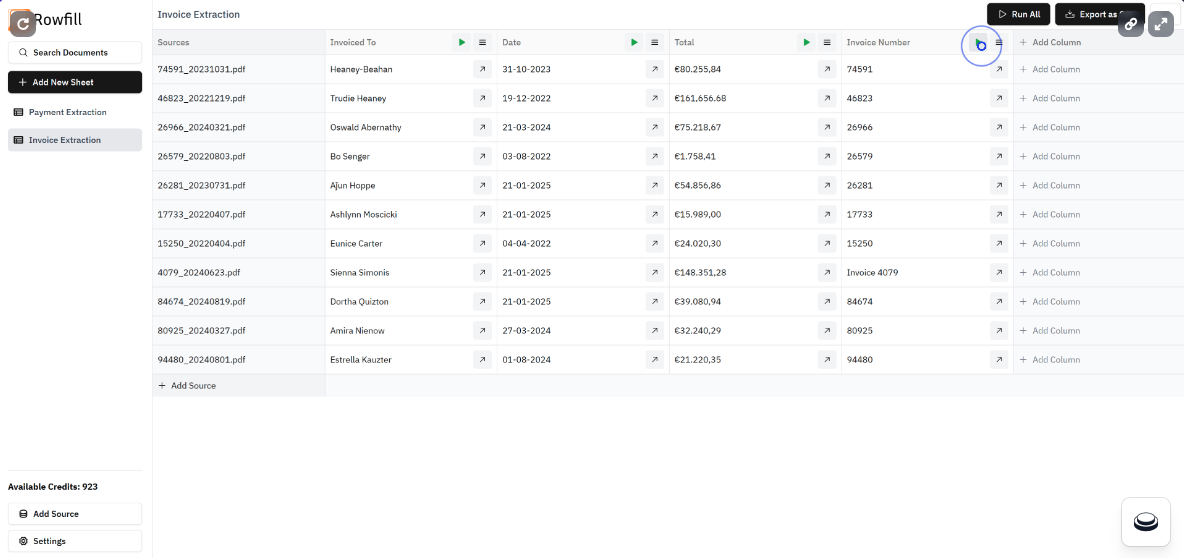

- Les données d'entraînement doivent être préparées au format JSONL.

- Chaque donnée contient : le chemin d'accès à l'image, une description textuelle longue et courte, le format de l'image et d'autres informations.

- Des échantillons de données sont fournis par le projet à titre de référence.

2.4 Évaluation du modèle :

- Prise en charge de plusieurs indicateurs d'évaluation :

- ImageReward : évaluation des scores de préférence humaine pour les images générées

- HPS v2.1 : Mesures d'évaluation basées sur 798K classements manuels

- GenEval : évaluation de l'alignement texte-image

- FID : évaluation de la qualité et de la diversité des images générées

2.5 Présentation en ligne :

- Visitez la plateforme de démonstration officielle : https://opensource.bytedance.com/gmpt/t2i/invite

- Saisissez une description textuelle pour générer une image de haute qualité correspondante.

- Permet d'ajuster plusieurs résolutions d'images et paramètres de génération

3. fonctions avancées

3.1 Mécanismes d'autocorrection au niveau des bits :

- Reconnaissance et correction automatiques des erreurs dans le processus de génération

- Améliorer la qualité et la précision des images générées

3.2 Extensions du modèle :

- Prise en charge d'une mise à l'échelle flexible de la taille des modèles

- Plusieurs modèles disponibles de 125M à 20B paramètres

- S'adapter à différents environnements matériels et aux exigences des applications

4) Précautions

- S'assurer que les ressources matérielles répondent aux exigences du modèle

- Les modèles à grande échelle nécessitent une mémoire GPU suffisante

- Equipement de calcul de haute performance recommandé pour la formation

- Points de contrôle réguliers de la formation d'appoint

- Notez l'adhésion au protocole open source du MIT.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...