Inception Labs publie le premier modèle de diffusion de Big Language de qualité commerciale

Inception Labs présente la famille Mercury de modèles linguistiques diffusés (dLLM), qui sont jusqu'à 10 fois plus rapides et moins chers que les LLM existants, repoussant ainsi les limites de la modélisation linguistique en termes d'intelligence et de rapidité.

centre

- Inception Labs a officiellement lancé la famille Mercury de modèles linguistiques diffus (dLLM), marquant la naissance d'une nouvelle génération de LLM et annonçant un nouveau niveau de technologie de génération de texte rapide et de haute qualité.

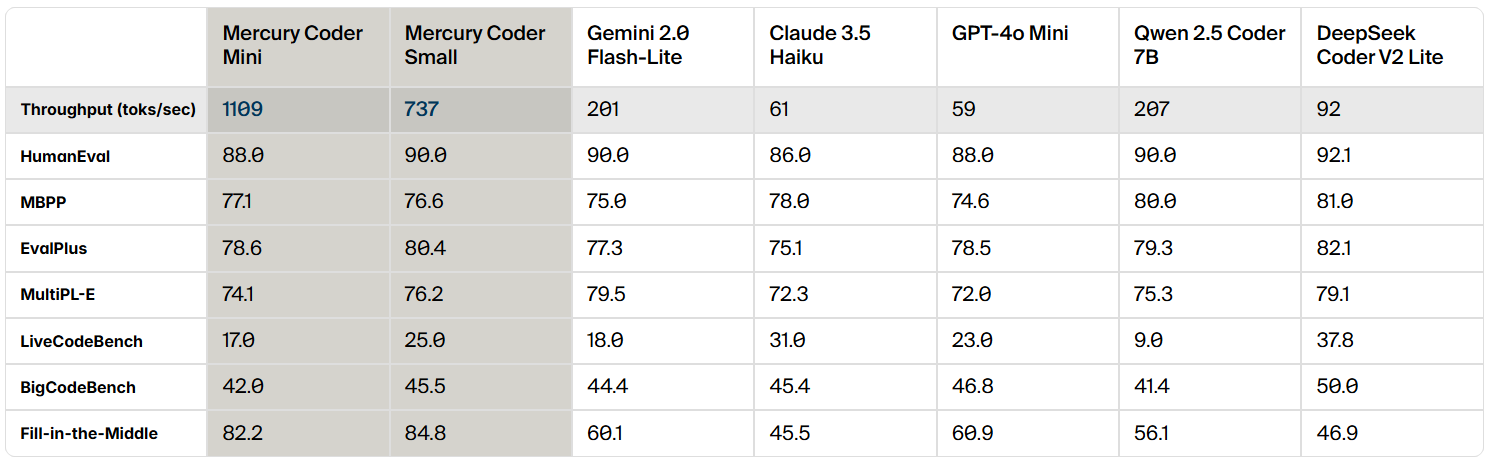

- Mercury est 10 fois plus rapide que les LLM actuels à vitesse optimisée. Sur les GPU NVIDIA H100, les modèles Mercury fonctionnent à plus de 1 000 jetons/seconde, une vitesse qui n'était auparavant possible qu'avec des puces personnalisées.

- modèle de génération de code Codeur Mercury Maintenant dans aire de jeux Inception Labs fournit un accès aux modèles de code et aux modèles génériques pour les entreprises par le biais d'API et de déploiements natifs.

La vision d'Inception Labs - Diffusion Donner du pouvoir à la prochaine génération de LLM

Les grands modèles linguistiques (LLM) actuels utilisent généralement un modèle autorégressif, ce qui signifie qu'ils sont écrits comme l'écriture humaine, de gauche à droite, un par un jeton Générer du texte. Cette génération est intrinsèquement sérielle - les jetons précédents doivent être générés avant que les jetons suivants puissent être générés, et chaque jeton généré nécessite l'évaluation d'un réseau neuronal avec des milliards de paramètres. Les leaders de l'industrie du LLM misent sur l'augmentation du calcul du temps d'inférence pour améliorer les capacités d'inférence et de correction d'erreur de leurs modèles, mais la génération de longs processus d'inférence fait également monter en flèche les coûts d'inférence et augmente la latence, ce qui rend finalement les produits difficiles à utiliser. Un changement de paradigme est impératif pour que les solutions d'IA de haute qualité soient réellement omniprésentes.

Les modèles de diffusion offrent la possibilité d'un tel changement de paradigme. Ces modèles utilisent un processus de génération "grossier à fin". Comme le montre la vidéo, la sortie du modèle commence par un bruit pur et est progressivement optimisée en plusieurs étapes de "débruitage".

Contrairement aux modèles autorégressifs, les modèles de diffusion ne sont pas contraints de prendre en compte uniquement ce qui a été produit précédemment. Ils sont donc plus performants en matière d'inférence et de structuration des réponses. En outre, comme les modèles de diffusion sont capables d'optimiser en permanence leurs résultats, ils peuvent corriger efficacement les erreurs et réduire les illusions. C'est sur la base de ces avantages que les modèles de diffusion sont au cœur de nombreuses solutions d'IA remarquables dans le domaine de la génération de vidéos, d'images et de sons, telles que Sora, Midjourney et Riffusion, pour n'en citer que quelques-unes. Cependant, les tentatives d'application des modèles de diffusion aux données discrètes, telles que le texte et le code, n'ont jamais été couronnées de succès jusqu'à présent. Jusqu'à Mercury, cette situation était complètement bouleversée.

Mercury Coder - 1000+ Tokens/Seconde, l'intelligence de pointe au bout des doigts !

Inception Labs est heureux d'annoncer la sortie de Mercury Coder, le premier dLLM accessible au public.

Mercury Coder repousse les limites des capacités de l'IA : il est 5 à 10 fois plus rapide que les LLM de la génération actuelle et fournit des réponses de haute qualité à un coût bien moindre.Mercury Coder est le résultat des recherches révolutionnaires de l'équipe fondatrice d'Inception Labs - qui a non seulement été pionnière dans la modélisation de la diffusion d'images, mais a également co-inventé de nombreuses technologies d'IA générative, notamment l'optimisation directe des préférences (DPO) et les transformateurs de décision. Mercury Coder est le résultat de recherches novatrices menées par l'équipe fondatrice d'Inception Labs, qui a non seulement été à l'origine de la modélisation de la diffusion d'images, mais a également co-inventé un certain nombre de technologies fondamentales d'IA générative, notamment l'optimisation directe des préférences (DPO), l'attention flash et les transformateurs de décision.

dLLM peut être utilisé en remplacement direct des LLM autorégressifs existants et prend en charge tous les scénarios d'application, y compris RAG (Retrieval Augmentation Generation), l'utilisation d'outils et les flux de travail des agents. dLLM ne génère pas de réponses jeton par jeton lors de la réception d'une requête d'utilisateur. Lors de la réception d'une requête utilisateur, dLLM ne génère pas la réponse jeton par jeton, mais génère plutôt la réponse de manière grossière à fine, comme le montre l'animation ci-dessus. Le modèle de transformateur (utilisé dans Mercury Coder) a été entraîné sur une grande quantité de données et est capable d'optimiser la qualité de la réponse globalement, en modifiant plusieurs jetons en parallèle afin d'améliorer les résultats en permanence. Le modèle Transformer (utilisé dans Mercury Coder) a été entraîné sur une grande quantité de données afin d'optimiser la qualité de la réponse de manière globale et de modifier plusieurs tokens en parallèle afin d'améliorer les résultats de manière continue.

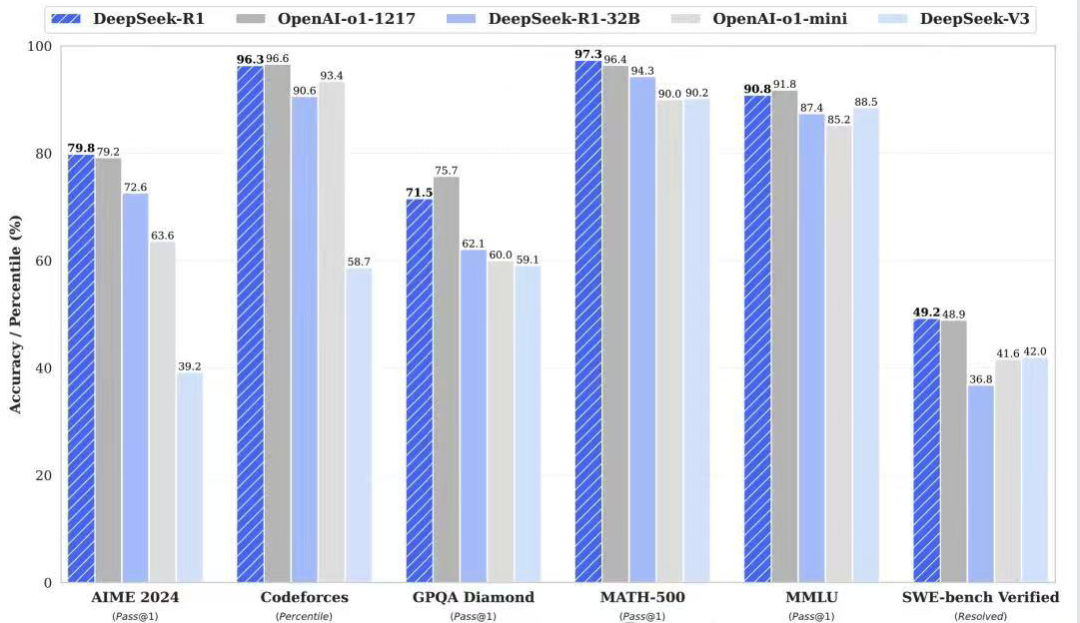

Mercury Coder est un dLLM optimisé pour la génération de code, et dans les analyses comparatives de code standard, Mercury Coder excelle dans une large gamme de points de référence, surpassant souvent le GPT-4o Mini et le Claude 3.5 Les modèles autorégressifs optimisés pour la vitesse, tels que Haiku, sont également jusqu'à 10 fois plus rapides.

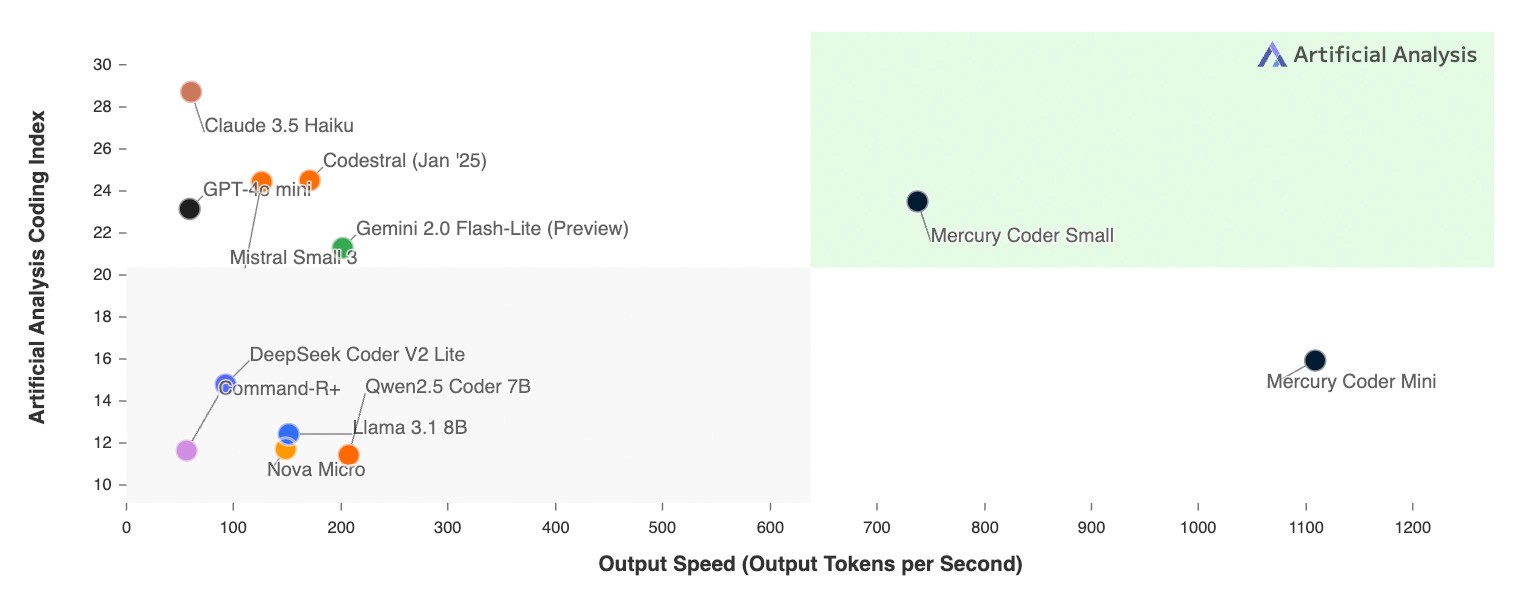

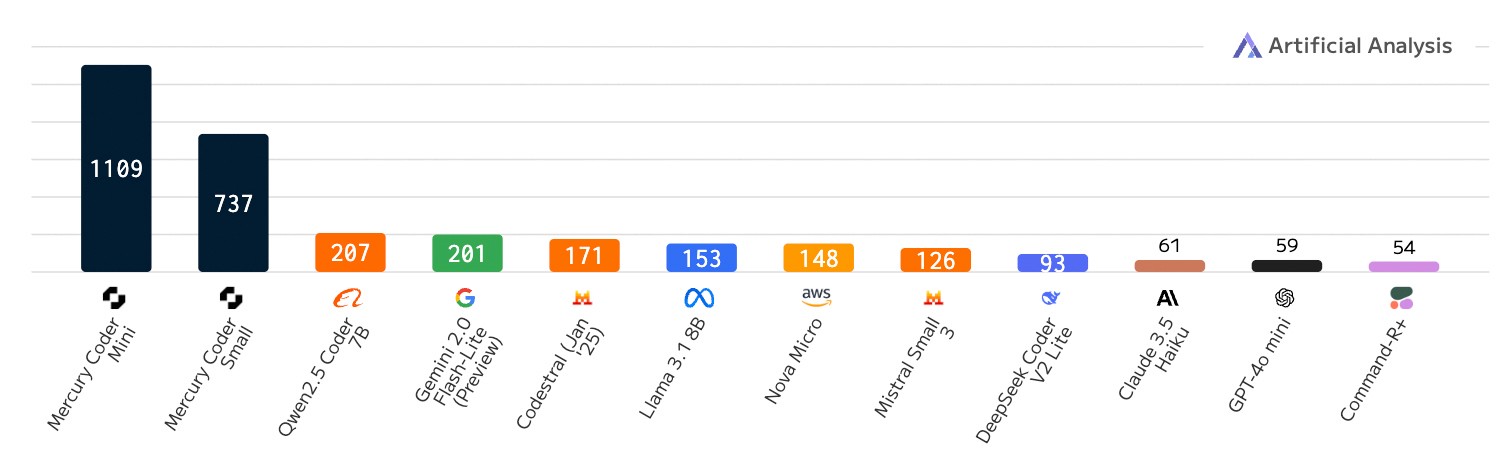

La caractéristique unique de dLLM est sa vitesse incroyable. Alors que même les modèles autorégressifs optimisés en termes de vitesse s'exécutent à un maximum de 200 tokens/sec, Mercury Coder s'exécute à plus de 1000 tokens/sec sur un GPU NVIDIA H100 à usage général, soit une accélération de 5 fois. Mercury Coder est même plus de 20 fois plus rapide que certains modèles frontières, qui peuvent fonctionner à moins de 50 tokens/sec.

Auparavant, seul du matériel dédié tel que Groq, Cerebras et SambaNova permettait d'atteindre des débits tels que ceux de dLLM. Les améliorations algorithmiques de Mercury Coder et l'accélération matérielle vont de pair, et sur des puces plus rapides, les gains de vitesse sont encore plus importants.

Comparaison de la vitesse : nombre de jetons produits par seconde ; charges de travail liées à l'écriture de code

Ce qui est encore plus intéressant, c'est que les développeurs préfèrent la fonction de complétion de code de Mercury Coder. En effet, dans le Copilote Dans les benchmarks d'Arena, Mercury Coder Mini est arrivé en deuxième position, surpassant les modèles à vitesse optimisée tels que GPT-4o Mini et Gemini-1.5-Flash, et égalant même les performances de modèles plus grands tels que GPT-4o. Parallèlement, Mercury Coder est également le modèle le plus rapide, environ quatre fois plus rapide que GPT-4o Mini.

Inception Labs vous invite à découvrir par vous-même la puissance de Mercury Coder. Inception Labs s'est associé à Lambda Labs dans le cadre de l'étude de faisabilité de Mercury Coder. aire de jeux La plateforme vous offre un accès d'essai à Mercury Coder. Découvrez comment Mercury Coder génère un code de haute qualité en une fraction du temps, comme le montre la vidéo ci-dessous.

Qu'est-ce que cela signifie pour les applications de l'IA ?

Les premiers utilisateurs de Mercury dLLM, notamment les leaders du marché de l'assistance à la clientèle, de la génération de codes et de l'automatisation des entreprises, passent avec succès du modèle de base autorégressif standard à Mercury dLLM, qui le remplace directement. Ce changement se traduit directement par une meilleure expérience utilisateur et une réduction des coûts. Dans les scénarios d'application sensibles à la latence, les partenaires ont souvent dû choisir des modèles plus petits et moins performants dans le passé pour répondre aux exigences strictes en matière de latence. Désormais, grâce aux performances supérieures du dLLM, ces partenaires peuvent utiliser des modèles plus grands et plus puissants tout en respectant leurs exigences initiales en matière de coût et de vitesse.

Inception Labs fournit un accès à la famille de modèles Mercury par le biais d'une API et d'un déploiement local.Les modèles Mercury sont entièrement compatibles avec le matériel existant, les ensembles de données et les processus de réglage fin supervisé (SFT) et d'alignement (RLHF).Le réglage fin est pris en charge à la fois dans l'API et dans le déploiement local.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...