Hunyuan3D-2 : outil de génération de modèles 3D haute résolution open source de Tencent

Introduction générale

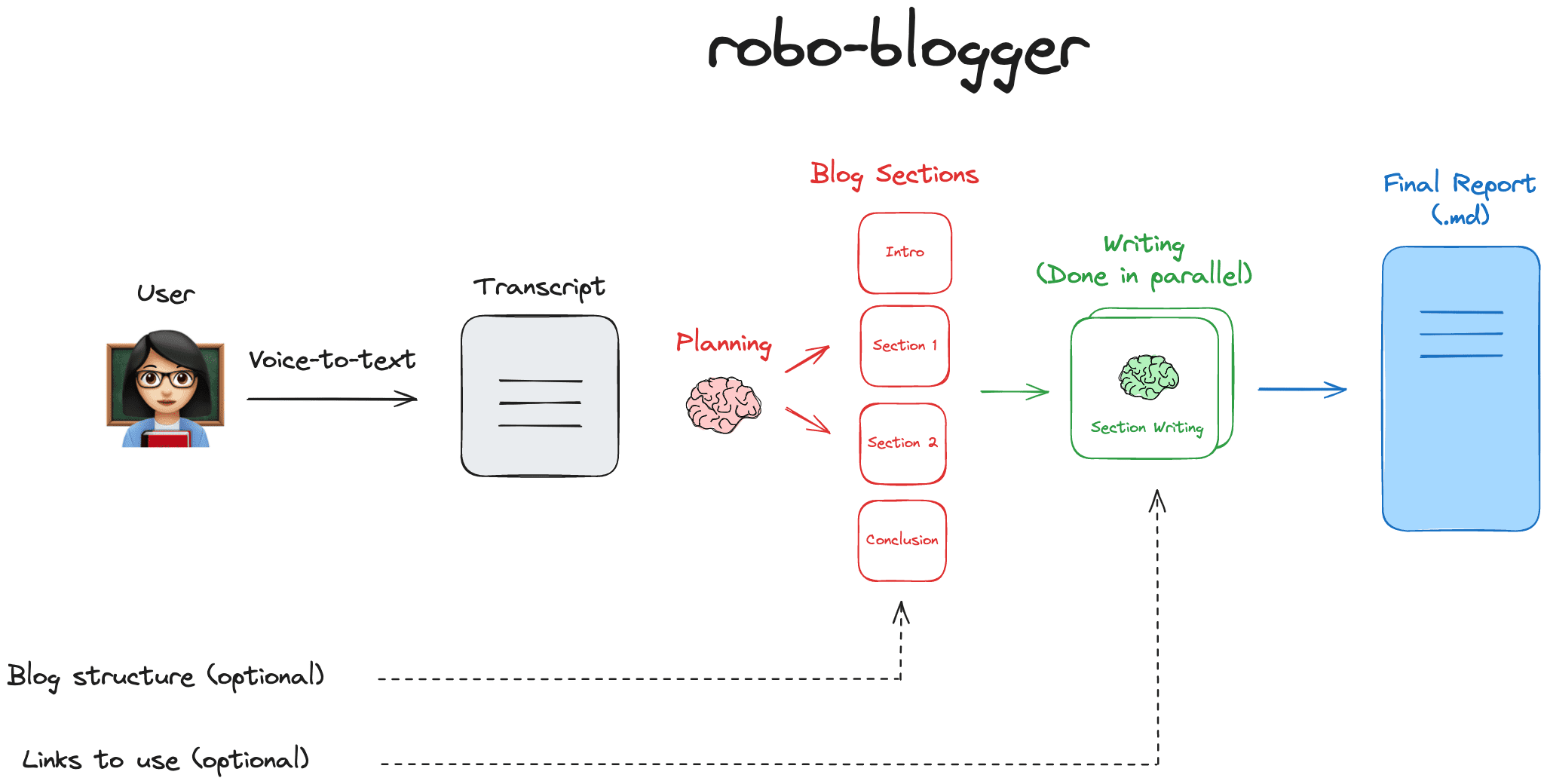

Hunyuan3D-2 est un projet open source développé par Tencent, visant à générer des modèles 3D haute résolution à partir de textes ou d'images. Il se compose de deux éléments principaux : le modèle de génération de formes (Hunyuan3D-DiT) et le modèle de génération de textures (Hunyuan3D-Paint). Les utilisateurs peuvent saisir des descriptions textuelles ou télécharger des images pour générer des actifs numériques 3D avec des textures détaillées. L'outil est disponible gratuitement sur GitHub avec le code et les modèles pré-entraînés, et la dernière version a été mise à jour le 18 mars 2025. Il prend en charge plusieurs modèles, y compris une version rapide et une version mini pour différents appareils. Hunyuan3D-2 est largement utilisé dans le développement de jeux, l'art numérique et la recherche.

Liste des fonctions

- Prise en charge de la génération de modèles 3D à partir d'un texte, les utilisateurs peuvent saisir une description pour générer la géométrie correspondante.

- Prise en charge de la génération de modèles 3D à partir d'images et de la génération de ressources 3D avec des textures après le téléchargement d'images.

- Fournit une sortie haute résolution avec des détails de modèle nets et des couleurs de texture vibrantes.

- Contient le modèle de génération de formes (Hunyuan3D-DiT), qui est responsable de la génération de la géométrie sous-jacente.

- Inclut un modèle de génération de texture (Hunyuan3D-Paint) pour ajouter une texture haute résolution au modèle.

- Prise en charge de la génération de vues multiples (Hunyuan3D-2mv) pour optimiser le modèle à partir de plusieurs points de vue.

- Une version mini du modèle (Hunyuan3D-2mini) est fournie, avec seulement 0,6 milliard de paramètres et un fonctionnement plus rapide.

- Prise en charge d'une version rapide du modèle (Fast), qui réduit de moitié le temps d'inférence et le rend plus efficace.

- Blender peut être intégré pour générer et éditer des modèles 3D directement via le plug-in.

- Code et modèles à source ouverte que les utilisateurs peuvent librement télécharger et modifier.

Utiliser l'aide

Hunyuan3D-2 est un outil puissant qui nécessite quelques bases en matière de matériel et de programmation. Ce qui suit est un guide d'installation et d'utilisation détaillé pour aider les utilisateurs à démarrer rapidement.

Processus d'installation

- Préparation des environnements matériels et logiciels

- Requiert un GPU NVIDIA avec prise en charge CUDA et au moins 6 Go (Mini) ou 12 Go (Standard) de mémoire vidéo.

- Installez Python 3.9 ou une version ultérieure.

- Installer Git pour télécharger le code.

- Télécharger le code et les modèles

- S'exécute dans le terminal :

git clone https://github.com/Tencent/Hunyuan3D-2.git cd Hunyuan3D-2 - Téléchargez le modèle pré-entraîné de Hugging Face :

huggingface-cli download tencent/Hunyuan3D-2 --local-dir ./weights

- S'exécute dans le terminal :

- Installation des dépendances

- Installer les dépendances de base :

pip install -r requirements.txt - Installe des modules supplémentaires pour la génération de textures :

cd hy3dgen/texgen/custom_rasterizer python3 setup.py install cd ../../.. cd hy3dgen/texgen/differentiable_renderer python3 setup.py install - L'accélération Flash Attention peut être installée en option :

pip install ninja pip install git+https://github.com/Dao-AILab/flash-attention.git@v2.6.3

- Installer les dépendances de base :

- Vérifier l'installation

- Exécutez l'exemple de code :

python minimal_demo.py - Si le modèle est exporté avec succès, l'installation est terminée.

- Exécutez l'exemple de code :

Principales fonctions

1) Génération de modèles 3D à partir d'images

- déplacer: :

- Préparer une image (par exemple

demo.png), placé dans leassetsDossier. - Générer la forme de base :

from hy3dgen.shapegen import Hunyuan3DDiTFlowMatchingPipeline from PIL import Image pipeline = Hunyuan3DDiTFlowMatchingPipeline.from_pretrained('tencent/Hunyuan3D-2') image = Image.open('assets/demo.png') mesh = pipeline(image=image, num_inference_steps=30)[0] mesh.export('output.glb') - Ajoutez de la texture :

from hy3dgen.texgen import Hunyuan3DPaintPipeline pipeline = Hunyuan3DPaintPipeline.from_pretrained('tencent/Hunyuan3D-2') mesh = pipeline(mesh, image=image) mesh.export('textured.glb')

- Préparer une image (par exemple

- en fin de compteModèle 3D : Générer un modèle 3D avec des textures, sauvegarder en tant que

.glbDocumentation.

2. la génération de modèles 3D à partir de textes

- déplacer: :

- Installer le module de conversion texte-image (HunyuanDiT) :

huggingface-cli download Tencent-Hunyuan/HunyuanDiT-v1.1-Diffusers-Distilled --local-dir ./weights/hunyuanDiT - Exécutez le code :

from hy3dgen.text2image import HunyuanDiTPipeline from hy3dgen.shapegen import Hunyuan3DDiTFlowMatchingPipeline t2i = HunyuanDiTPipeline('Tencent-Hunyuan/HunyuanDiT-v1.1-Diffusers-Distilled') i23d = Hunyuan3DDiTFlowMatchingPipeline.from_pretrained('tencent/Hunyuan3D-2') image = t2i('a cute rabbit') mesh = i23d(image, num_inference_steps=30)[0] mesh.export('rabbit.glb')

- Installer le module de conversion texte-image (HunyuanDiT) :

- en fin de compteGénérer des modèles 3D à partir d'un texte.

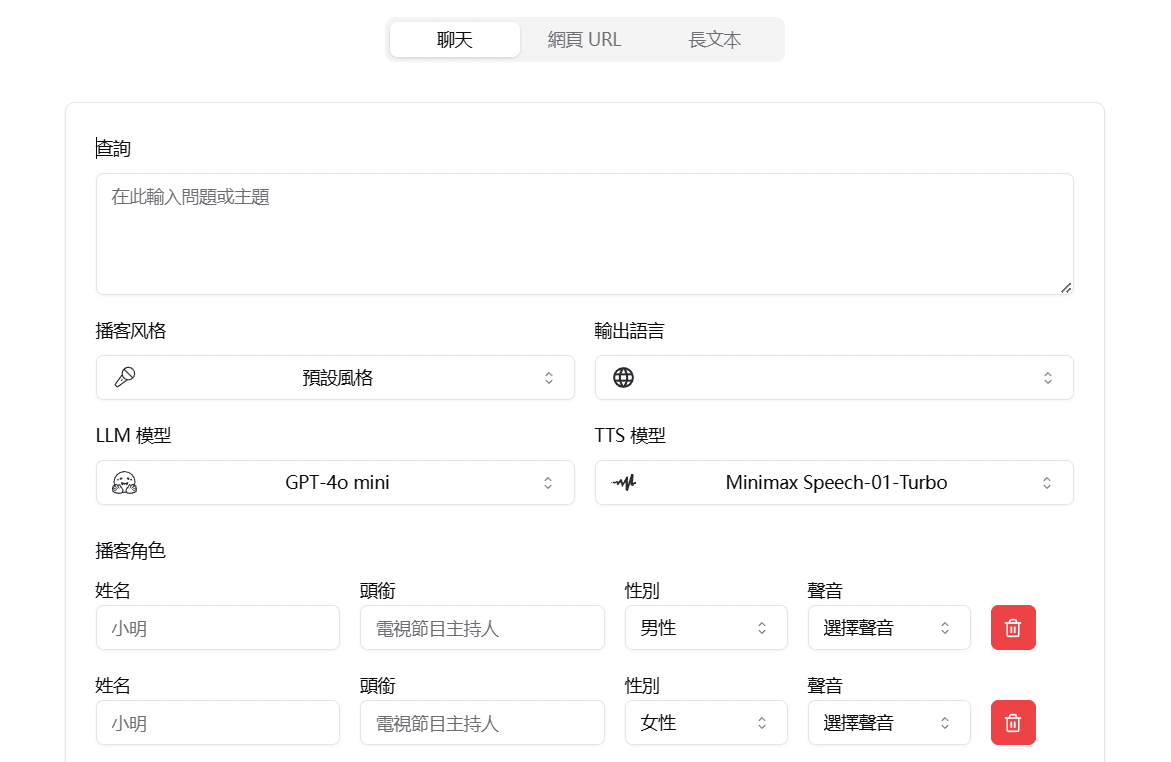

3. utiliser l'interface de Gradio

- déplacer: :

- Lancez l'application Gradio :

python3 gradio_app.py --model_path tencent/Hunyuan3D-2 --subfolder hunyuan3d-dit-v2-0 --texgen_model_path tencent/Hunyuan3D-2 - Ouvrez votre navigateur et visitez l'adresse locale demandée.

- Téléchargez une image ou saisissez du texte et cliquez sur Générer.

- Lancez l'application Gradio :

- en fin de compteLes modèles : Générer des modèles par le biais d'une interface web sans écrire de code.

4. utilisation des services API

- déplacer: :

- Démarrer le serveur API :

python api_server.py --host 0.0.0.0 --port 8080 - Envoyer une demande pour générer un modèle :

img_b64_str=$(base64 -i assets/demo.png) curl -X POST "http://localhost:8080/generate" \ -H "Content-Type: application/json" \ -d '{"image": "'"$img_b64_str"'"}' \ -o test.glb

- Démarrer le serveur API :

- en fin de compteGénérer des modèles 3D via l'API.

5. utilisation du plug-in Blender

- montage: :

- téléchargement

blender_addon.pyDocumentation. - Ouvrez Blender, installez et activez le plugin dans Edit > Preferences > Plugins.

- téléchargement

- gréement: :

- Démarrer le serveur API (voir ci-dessus).

- Trouvez "Hunyuan3D-2" dans la barre latérale de Blender.

- Saisissez du texte ou téléchargez une image et cliquez sur Générer.

- en fin de compteLes modèles : générez et éditez des modèles directement dans Blender.

Fonction en vedette Fonctionnement

Génération de vues multiples (Hunyuan3D-2mv)

- Utilisez la commande :

pipeline = Hunyuan3DDiTFlowMatchingPipeline.from_pretrained('tencent/Hunyuan3D-2mv', subfolder='hunyuan3d-dit-v2-mv')

mesh = pipeline(image=Image.open('assets/demo.png'))[0]

mesh.export('mv_model.glb')

- Idéal pour les scènes nécessitant une modélisation précise sous plusieurs angles.

Génération rapide (Hunyuan3D-2mini)

- Utilisez la commande :

pipeline = Hunyuan3DDiTFlowMatchingPipeline.from_pretrained('tencent/Hunyuan3D-2mini', subfolder='hunyuan3d-dit-v2-mini')

mesh = pipeline(image=Image.open('assets/demo.png'))[0]

mesh.export('mini_model.glb')

- Rapide et adapté aux appareils à faible configuration.

mise en garde

- Assurez-vous que le pilote GPU est compatible avec la version CUDA pour éviter les erreurs d'exécution.

- s'adapter

num_inference_stepsLes paramètres peuvent être optimisés pour la qualité de la production. - Si vous avez des problèmes, demandez de l'aide sur GitHub Issues ou Discord (https://discord.gg/dNBrdrGGMa).

scénario d'application

- développement de jeux

Les développeurs peuvent l'utiliser pour générer rapidement des modèles de personnages ou d'accessoires dans le jeu, réduisant ainsi le temps de modélisation manuelle. - art numérique

Les artistes créent des œuvres d'art en 3D à partir de textes ou d'images à des fins de création ou de production NFT. - conception de produits

Les concepteurs téléchargent des images de produits pour générer des modèles 3D permettant de présenter ou de tester des prototypes. - Recherche en éducation

Les étudiants et les chercheurs l'utilisent pour explorer les techniques de 3D générées par l'IA et pour valider les modèles de diffusion.

QA

- Quelle est la configuration matérielle minimale requise ?

La Mini nécessite 6 Go de mémoire vidéo et la Standard 12 Go, avec un GPU NVIDIA recommandé. - Est-il disponible dans le commerce ?

La version open source est réservée à un usage non commercial. Pour un usage commercial, veuillez contacter pour obtenir une autorisation. - Combien de temps faut-il pour générer un modèle ?

Environ 30 secondes pour la version rapide et 1 à 2 minutes pour la version standard, en fonction du matériel et des paramètres.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...