Hume AI : Donner à l'IA les moyens de reconnaître les émotions | Reconnaître les états émotionnels à partir de sons et d'expressions | Générer des discours avec des états émotionnels

Introduction générale

Hume AI est une entreprise spécialisée dans l'intelligence émotionnelle, qui développe des technologies d'IA multimodales permettant de comprendre les émotions humaines et d'y répondre. Son produit phare, l'interface vocale empathique (EVI), reconnaît et réagit aux émotions de l'utilisateur sous de multiples formes, notamment la parole, les expressions faciales et le langage, afin d'améliorer l'expérience émotionnelle de l'interaction homme-machine.L'objectif de Hume AI est de veiller à ce que la technologie de l'IA puisse réellement servir le bien-être émotionnel des êtres humains grâce à une approche scientifique et à des principes éthiques.

Liste des fonctions

- reconnaissance des émotionsReconnaître les émotions de l'utilisateur sous diverses formes, y compris la parole, les expressions faciales et le langage.

- synthèse vocaleLes réponses vocales : Générer des réponses vocales avec émotion pour améliorer l'expérience interactive.

- interaction multimodaleLa technologie de l'Internet : elle prend en charge un large éventail d'interactions telles que la voix, le texte et les émoticônes.

- PersonnalisationPersonnalisation des personnalités de l'IA et des styles de voix en fonction des besoins de l'utilisateur.

- réponse en temps réelLe système d'information sur les sentiments : il permet d'analyser les sentiments et d'y répondre en temps réel pour un large éventail de scénarios d'application.

Utiliser l'aide

Installation et utilisation

Hume AI est très facile à utiliser et ne nécessite pas de processus d'installation compliqué. Les utilisateurs n'ont qu'à se rendre sur le site officiel et s'inscrire pour ouvrir un compte afin de commencer à utiliser son service en ligne. Voici les étapes détaillées pour l'utiliser :

- S'inscrire à un compte: Accès Site officiel de Hume AICliquez sur le bouton "S'inscrire" et remplissez les informations nécessaires pour compléter l'inscription.

- Plate-forme de connexionPour ce faire, vous devez vous connecter à la plateforme Hume AI à l'aide de votre compte et de votre mot de passe.

- Sélectionner un serviceSélectionnez le module de service que vous souhaitez utiliser sur la page d'accueil de la plateforme, comme la reconnaissance des émotions, la synthèse vocale, etc.

- Télécharger les donnéesLes données vocales, vidéo ou textuelles peuvent être téléchargées pour être analysées comme demandé.

- Voir les résultatsLe système effectue automatiquement une analyse des sentiments et génère des rapports détaillés et des résultats de réponse.

Fonction Opération Déroulement

reconnaissance des émotions

- Accès au module de reconnaissance des émotionsAprès avoir ouvert une session, cliquez sur "Reconnaissance des émotions" dans la barre de navigation.

- Télécharger les donnéesPour plus d'informations, consultez le site Web de la Commission européenne : sélectionnez le fichier vocal ou vidéo à analyser et cliquez sur Charger.

- Commencer l'analyseCliquez sur le bouton "Commencer l'analyse" et le système procédera automatiquement à la reconnaissance des sentiments.

- Voir le rapportUne fois l'analyse terminée, les utilisateurs peuvent consulter un rapport détaillé sur l'analyse des sentiments, y compris le type de sentiment, l'intensité et les tendances de changement.

synthèse vocale

- Accès au module de synthèse vocaleAprès avoir ouvert une session, cliquez sur "Synthèse vocale" dans la barre de navigation.

- texte d'entréeLe texte à synthétiser : Saisissez le contenu du texte à synthétiser dans la zone de texte.

- Sélectionner le style de voixLes langues étrangères : Choisir différents styles de voix et d'expressions émotionnelles en fonction des besoins.

- Générer un discoursCliquez sur le bouton "Generate Voice", le système génère le fichier vocal correspondant.

- Télécharger VoiceUne fois la génération terminée, les utilisateurs peuvent télécharger les fichiers vocaux pour les utiliser dans divers scénarios d'application.

interaction multimodale

- Accès au module d'interaction multimodaleAprès vous être connecté, cliquez sur "Interaction multimodale" dans la barre de navigation.

- Sélectionner la méthode d'interactionInteraction avec la voix : Choisissez d'interagir avec la voix, le texte ou l'emoji.

- Démarrage de l'interactionLe système reconnaît les émotions de l'utilisateur et y répond en temps réel.

- Voir les dossiersA la fin de l'interaction, l'utilisateur peut consulter l'historique de l'interaction et les résultats de l'analyse des sentiments.

Hume AI fournit une abondante documentation et des tutoriels, et les utilisateurs peuvent trouver des guides détaillés et des FAQ dans le centre d'aide du site web. Si vous rencontrez des problèmes lors de l'utilisation de Hume AI, n'hésitez pas à contacter l'équipe du service clientèle de Hume AI pour obtenir de l'aide.

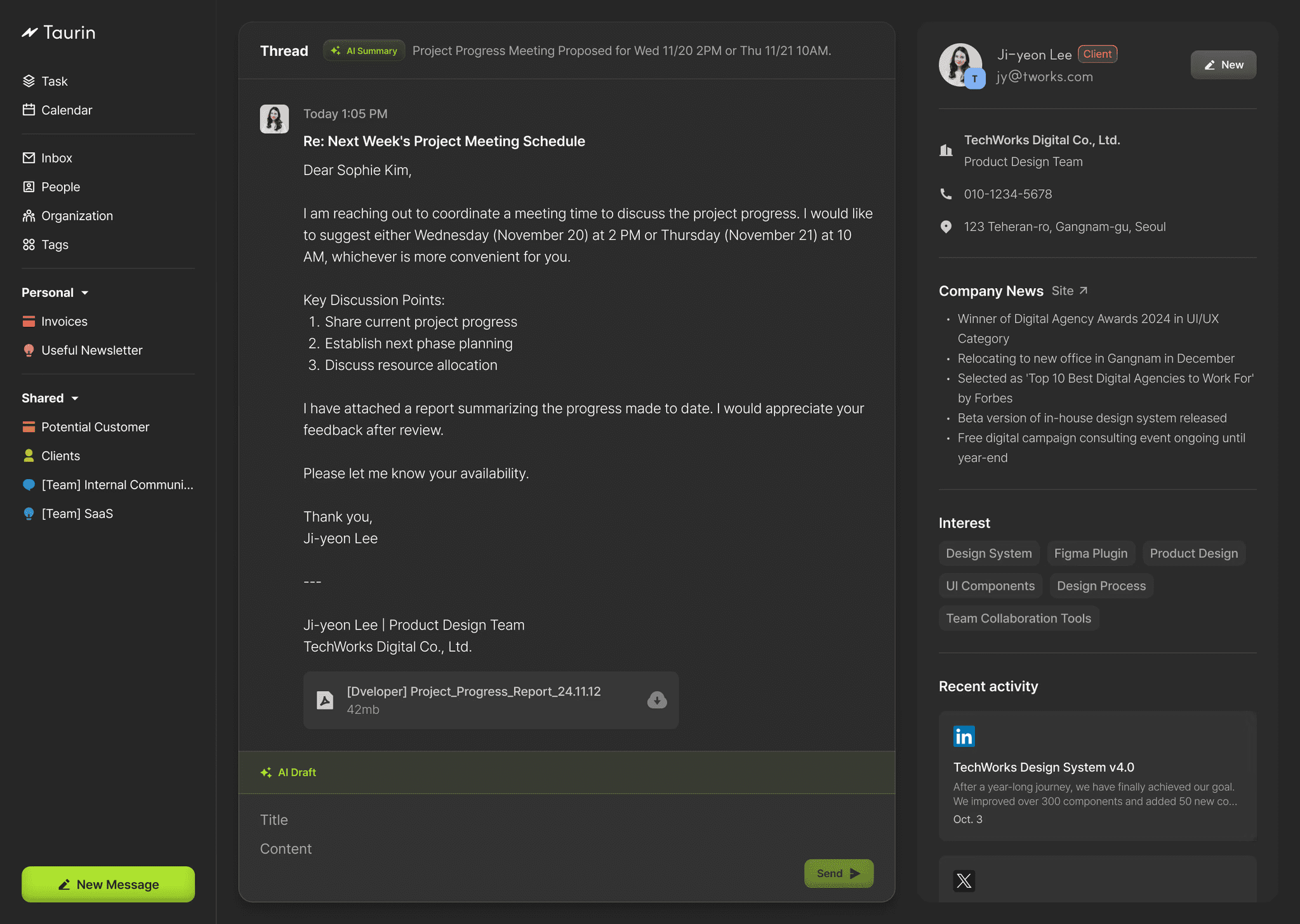

Interface vocale empathique (EVI)

L'interface vocale émotionnellement intelligente (EVI) de Hume est la première IA vocale au monde dotée d'une intelligence émotionnelle. Elle prend des données audio en direct et renvoie des transcriptions audio et textuelles enrichies de données sur l'expressivité tonale. En analysant la hauteur, le rythme et le timbre, l'EVI débloque des fonctionnalités supplémentaires, telles que la vocalisation au bon moment et la bonne intonation pour produire un discours empathique. Ces fonctionnalités rendent les interactions homme-machine basées sur la voix plus fluides et plus satisfaisantes, tout en ouvrant de nouvelles possibilités dans de nouveaux domaines tels que l'IA personnelle, le service à la clientèle, la facilité d'utilisation, la robotique, les jeux immersifs, les expériences VR, etc.

Nous fournissons une suite complète d'outils pour faciliter l'intégration et la personnalisation de l'EVI dans vos applications, y compris une API WebSocket pour gérer les transferts audio et de texte, une API REST et des SDK pour Typescript et Python afin de simplifier l'intégration dans les projets Web et Python. En outre, nous fournissons des études de cas et des widgets web open source comme point de départ pratique pour les développeurs afin d'explorer et de mettre en œuvre les capacités de l'EVI dans leurs propres projets.

Construire avec l'EVI

La principale façon d'utiliser EVI est par le biais d'une connexion WebSocket qui envoie de l'audio et reçoit des commentaires en temps réel. Cela permet un dialogue bidirectionnel fluide : l'utilisateur commente, l'EVI écoute et analyse son expression, puis l'EVI génère un retour d'information émotionnellement intelligent.

Vous pouvez entamer un dialogue en vous connectant à un WebSocket et en envoyant la voix de l'utilisateur à l'EVI. Vous pouvez également envoyer du texte à l'EVI qui le lira.

L'EVI répondra de la manière suivante :

- Donner une réponse textuelle de l'EVI

- Fournit un retour audio expressif pour l'EVI

- Transcription des messages des utilisateurs et mesure de leurs expressions vocales

- Si l'utilisateur interrompt l'IVE, il reçoit un retour d'information à ce sujet.

- Lorsque l'IVE a fini de répondre, il émet un message d'alerte

- En cas de problème, un message d'erreur est affiché

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...