Des réseaux neuronaux à l'étreinte - Brève histoire des réseaux neuronaux et de l'apprentissage profond

TL;DR Cet article comporte plus de 8200 mots et nécessite environ 15 minutes pour être lu dans son intégralité. Cet article passe brièvement en revue les dernières applications des grands modèles, des machines perceptives à l'apprentissage profond. ChatGPT L'histoire de la

Original : https://hutusi.com/articles/the-history-of-neural-networks

Il n'y a rien à craindre dans la vie, seulement des choses à comprendre.

-- Mme Curie

I Réseaux de croyances profondes

En 2006, Jeffrey Hinton, professeur à l'université de Toronto, au Canada, effectuait des recherches sur la manière d'entraîner les réseaux neuronaux multicouches, et il travaille discrètement dans le domaine des réseaux neuronaux depuis plus de trois décennies. Bien qu'il soit considéré comme une figure titanesque dans ce domaine, les résultats de ses recherches ont été sous-appréciés par l'industrie, car les réseaux neuronaux ont été sous-appréciés dans l'industrie de l'intelligence artificielle.

Née à Londres, en Angleterre, la famille de Hinton a produit un certain nombre de savants éminents, et George Boole, le logicien qui a fondé l'algèbre de Boole, était son arrière-arrière-grand-père. Son grand-père était écrivain scientifique et son père entomologiste. Hinton était plus intelligent que tous ceux qui l'entouraient, mais son parcours scolaire a été quelque peu détourné : il a d'abord étudié l'architecture à l'université, puis la physique, puis la philosophie, pour finalement obtenir une licence en psychologie. 1972 Hinton est entré à l'université d'Édimbourg pour faire son doctorat, en se concentrant sur les réseaux neuronaux. À l'époque, les réseaux neuronaux étaient méprisés par l'industrie, et même les superviseurs de Hinton pensaient qu'ils avaient peu d'utilité pratique et qu'ils n'avaient pas d'avenir. Cependant, Hinton ne s'est pas laissé abattre et a cru en la recherche sur les réseaux neuronaux, insistant sur le fait qu'il pouvait prouver la valeur des réseaux neuronaux, ce sur quoi il a insisté pendant plus de 30 ans.

M. Hinton s'est rompu un disque dans la colonne lombaire alors qu'il était jeune homme et qu'il déplaçait un radiateur, et il souffre depuis de problèmes lombaires. Ces dernières années, le problème s'est aggravé et, la plupart du temps, il doit s'allonger sur le dos pour soulager la douleur, ce qui signifie qu'il ne peut ni conduire, ni prendre l'avion, ni même s'allonger sur un lit pliant dans son bureau lorsqu'il rencontre des étudiants dans le laboratoire. La douleur physique de cette épreuve n'a pas frappé Hinton aussi durement que l'indifférence à l'égard de la recherche universitaire. Dès 1969, Minsky, dans son livre Perceptual Machines, a établi la loi sur les machines perceptives multicouches, donnant ainsi son aval aux recherches ultérieures sur les réseaux neuronaux : "Il n'y aura pas d'avenir pour les machines perceptives multicouches parce que personne au monde ne peut entraîner une machine perceptive multicouche suffisamment bien, même pour la rendre capable d'apprendre les méthodes de fonctionnement les plus simples". La capacité limitée des perceptrons monocouches, qui ne peuvent même pas résoudre des problèmes de classification de base tels que l'"hétéroscédasticité", et le manque de méthodes de formation disponibles pour les perceptrons multicouches, reviennent à dire que l'orientation de la recherche sur les réseaux neuronaux est une impasse. Les réseaux neuronaux étaient considérés comme une hérésie académique dans l'industrie, et personne ne croyait qu'ils pouvaient réussir. Par conséquent, les étudiants prenaient soin d'éviter les réseaux neuronaux lorsqu'ils choisissaient leurs superviseurs, et pendant un certain temps, Sinton n'a même pas pu recruter suffisamment d'étudiants de troisième cycle.

En 1983, Hinton a inventé la machine de Boltzmann et, plus tard, la machine de Boltzmann restreinte simplifiée a été appliquée à l'apprentissage automatique et est devenue la base de la structure hiérarchique des réseaux neuronaux profonds. En 1986, Hinton a proposé l'algorithme de rétropropagation de l'erreur (BP) pour les machines perceptuelles multicouches, un algorithme qui a jeté les bases de ce qui allait devenir l'apprentissage profond. Hinton a inventé quelque chose de nouveau de temps en temps, et il a persisté à écrire plus de deux cents articles sur les réseaux neuronaux, même s'ils n'étaient pas bien accueillis. En 2006, Hinton avait accumulé une riche base théorique et pratique et, cette fois, il a publié un article qui allait changer l'ensemble de l'apprentissage automatique et, en fait, le monde entier.

Sinton a constaté que les réseaux neuronaux à plusieurs couches cachées peuvent avoir la capacité d'extraire automatiquement des caractéristiques pour l'apprentissage, ce qui est plus efficace que l'apprentissage automatique traditionnel avec l'extraction manuelle des caractéristiques. En outre, la difficulté de la formation des réseaux neuronaux multicouches peut être réduite grâce à la préformation couche par couche, ce qui résout le problème de longue date de la formation des réseaux neuronaux multicouches. Hinton a publié ses résultats dans deux articles à une époque où le terme "réseau neuronal" était rejeté par de nombreux éditeurs de revues universitaires, et certains titres de manuscrits ont même été renvoyés parce qu'ils contenaient le mot "réseau neuronal". Afin de ne pas irriter la sensibilité de ces personnes, Hinton a pris un nouveau nom et a baptisé le modèle "Deep Belief Network" (réseau de croyance profond).

II Capteurs

En fait, la recherche sur les réseaux neuronaux remonte aux années 1940. En 1940, Walter Pitts, âgé de 17 ans, a rencontré le professeur Warren McCulloch, âgé de 42 ans, à l'université de l'Illinois à Chicago, et a rejoint le projet de recherche de ce dernier : essayer d'utiliser les réseaux de neurones pour construire un modèle mécanique du cerveau basé sur des opérations logiques. Ils ont utilisé des opérations logiques pour abstraire le modèle de pensée du cerveau humain et ont avancé le concept de "réseau neuronal" (Neural Network), les neurones étant la plus petite unité de traitement de l'information dans le réseau neuronal ; ils ont abstrait et simplifié le processus de fonctionnement des neurones en un modèle d'opérations logiques très simple, qui a été baptisé par la suite "M-P Neural". Le modèle a été baptisé "Modèle de neurones M-P" d'après les initiales de leurs deux noms.

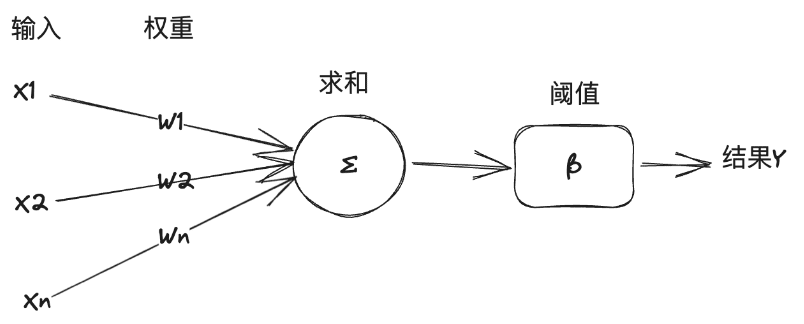

Dans ce modèle, un neurone reçoit un certain nombre de signaux d'entrée d'autres neurones, et l'importance des signaux d'entrée varie d'un neurone à l'autre, ce qui est représenté par le "poids" de la connexion, et le neurone additionne toutes les entrées en fonction du poids, et compare le résultat avec le "seuil" du neurone pour décider s'il faut ou non émettre le signal. Le neurone additionne toutes les entrées en fonction des poids et compare le résultat avec le "seuil" du neurone pour décider de transmettre ou non un signal au monde extérieur.

Le "modèle M-P" est suffisamment simple et direct pour être modélisé par la logique symbolique, et les experts en IA l'ont utilisé comme base pour construire des modèles de réseaux neuronaux afin de résoudre des tâches d'apprentissage automatique. Voici une brève explication de la relation entre l'intelligence artificielle, l'apprentissage automatique et l'apprentissage profond : L'intelligence artificielle est l'utilisation de la technologie informatique pour atteindre l'intelligence humaine, dans le manuel général défini comme l'étude et la construction d'agents intelligents. Un agent intelligent est un agent intelligent, ou simplement un agent, qui résout des tâches spécifiques ou des tâches générales en imitant la pensée et la cognition humaines. Un agent intelligent qui résout des tâches caractéristiques est connu sous le nom d'intelligence artificielle faible, ou intelligence artificielle étroite (ANI), tandis qu'un agent intelligent qui résout des tâches générales est connu sous le nom d'intelligence artificielle forte, ou intelligence artificielle polyvalente (AGI). L'apprentissage automatique est une branche de l'IA qui apprend à partir de données et améliore les systèmes. L'apprentissage profond, quant à lui, est une autre branche de l'apprentissage automatique, qui utilise des techniques de réseaux neuronaux pour l'apprentissage automatique.

En 1957, Rosenblatt, professeur de psychologie à l'université Cornell, a simulé et mis en œuvre un modèle de réseau neuronal, qu'il a appelé le Perceptron, sur un ordinateur IBM. Son approche consistait à rassembler un ensemble de neurones du modèle M-P pouvant être utilisés pour former et effectuer certaines tâches de reconnaissance des formes de la vision artificielle. En général, l'apprentissage automatique comporte deux types de tâches : la classification et la régression. La classification consiste à déterminer la classe à laquelle appartiennent les données, par exemple identifier si une image est un chat ou un chien, tandis que la régression consiste à prédire une donnée à partir d'une autre, par exemple prédire le poids d'une personne sur la base de son image. Les perceptrons résolvent les problèmes de classification linéaire. Expliquez cela à l'aide d'un exemple de fonctionnement des perceptrons tiré du livre "The Frontiers of Intelligence" (Les frontières de l'intelligence) :

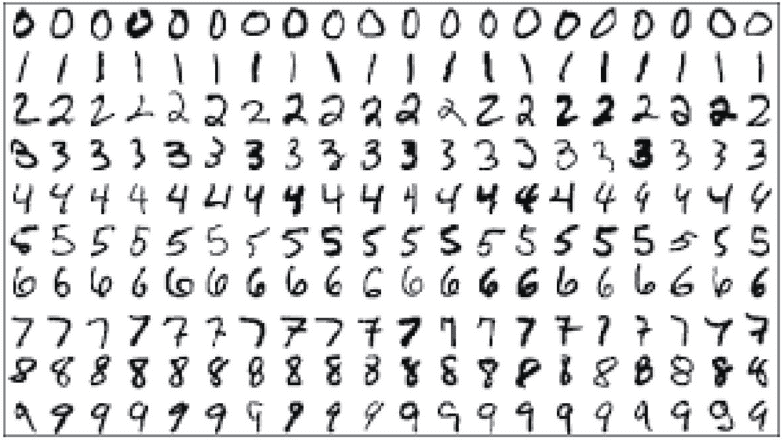

Supposons que l'objectif de la tâche soit de reconnaître automatiquement les chiffres arabes, les chiffres à reconnaître seront écrits à la main ou imprimés sous différentes formes, les chiffres seront stockés en les scannant dans un fichier image d'une taille de 14*14 pixels. Tout d'abord, un ensemble d'entraînement similaire à la figure suivante est préparé pour l'apprentissage automatique. Il ne s'agit pas seulement d'un ensemble d'images et d'autres données, mais aussi d'un pré-étiquetage manuel indiquant à la machine quels sont les chiffres représentés par les images.

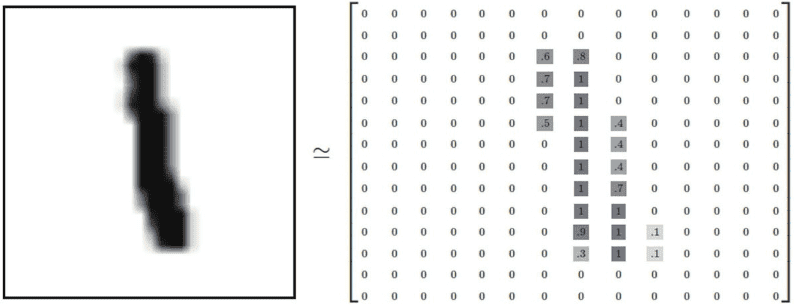

Ensuite, nous devons concevoir une structure de données pour que la machine puisse stocker et traiter ces images. Pour une image numérique 14*14 en niveaux de gris, les pixels noirs peuvent être représentés par 1, les pixels blancs par 0, et les pixels en niveaux de gris entre le noir et le blanc sont représentés par un nombre à virgule flottante entre 0 et 1 en fonction de l'intensité de leurs niveaux de gris. Comme le montre la figure ci-dessous, cette figure peut être convertie en un tableau tensoriel 2D :

La machine est capable de reconnaître les nombres figurant sur l'image, principalement en trouvant les caractéristiques de l'image qui représentent un nombre particulier. Pour les humains, il est facile de reconnaître ces chiffres manuscrits, mais il est difficile d'expliquer ce que sont ces caractéristiques. L'objectif de l'apprentissage automatique est d'extraire les caractéristiques de ces images de l'ensemble d'apprentissage qui représentent des nombres. Selon le modèle M-P, la manière d'extraire les caractéristiques est de choisir de pondérer et d'additionner les valeurs des pixels individuels de l'image, et de calculer le poids de chaque pixel correspondant à chaque nombre sur la base des résultats de la correspondance entre les images de l'ensemble d'apprentissage et les données annotées : si un pixel particulier a une preuve très négative que l'image n'appartient pas à un certain nombre, il est possible d'extraire les caractéristiques de l'image en fonction de la valeur du pixel. Si un pixel a une preuve très négative que l'image n'appartient pas à un certain nombre, le poids de ce pixel est fixé à une valeur négative pour ce nombre. Au contraire, si un pixel a une preuve très positive que l'image appartient à un certain nombre, le poids de ce pixel est fixé à une valeur positive pour ce nombre. Par exemple, pour le nombre "0", le pixel situé au milieu de l'image ne doit pas être noir (1). S'il apparaît, c'est que l'image appartient au nombre 0, ce qui réduit la probabilité que l'image corresponde au nombre 0. De cette manière, après l'entraînement et l'étalonnage de l'ensemble de données, la distribution de poids de chaque pixel correspondant à chaque chiffre 0-9 peut être obtenue comme 14*14 (=196).

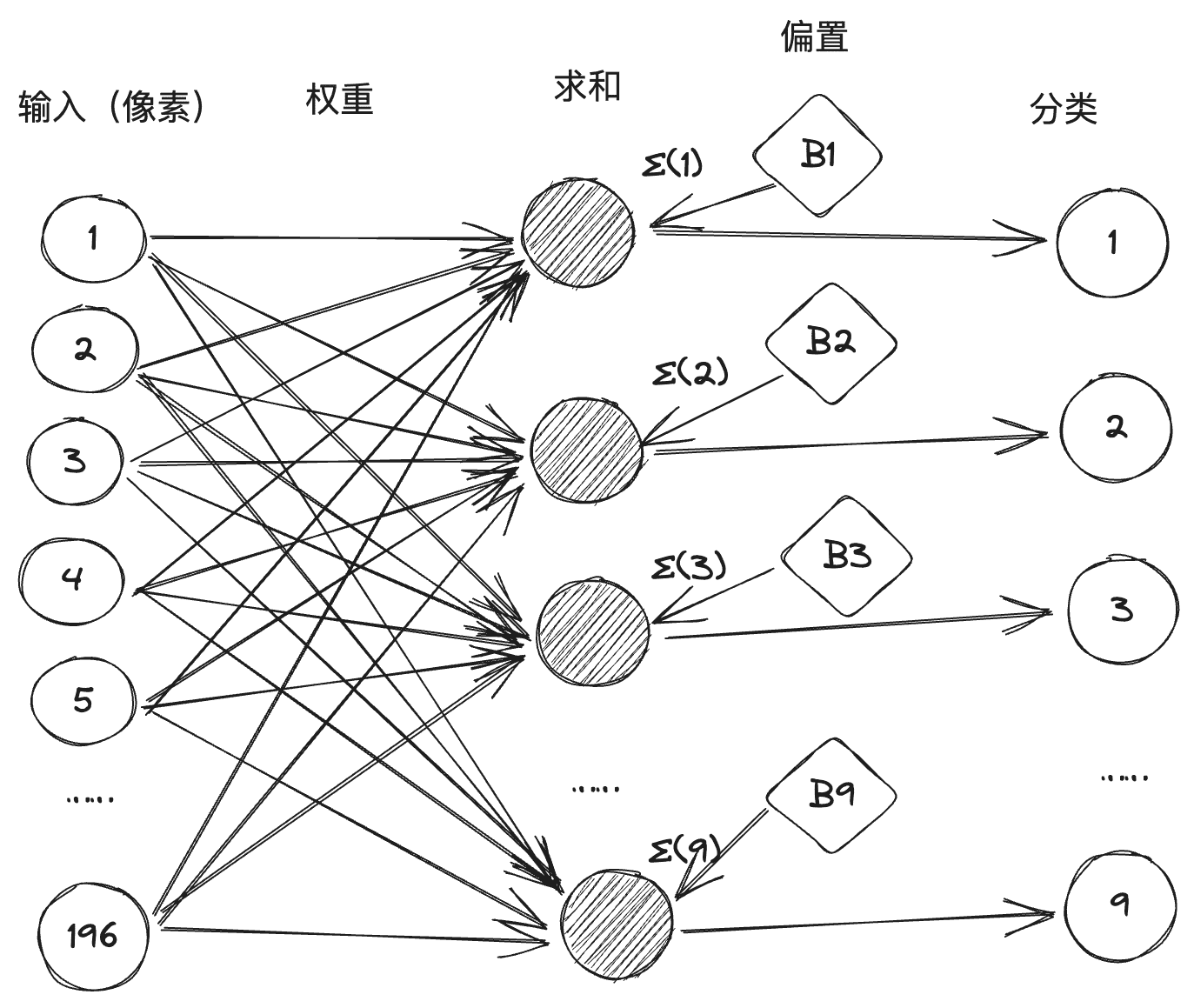

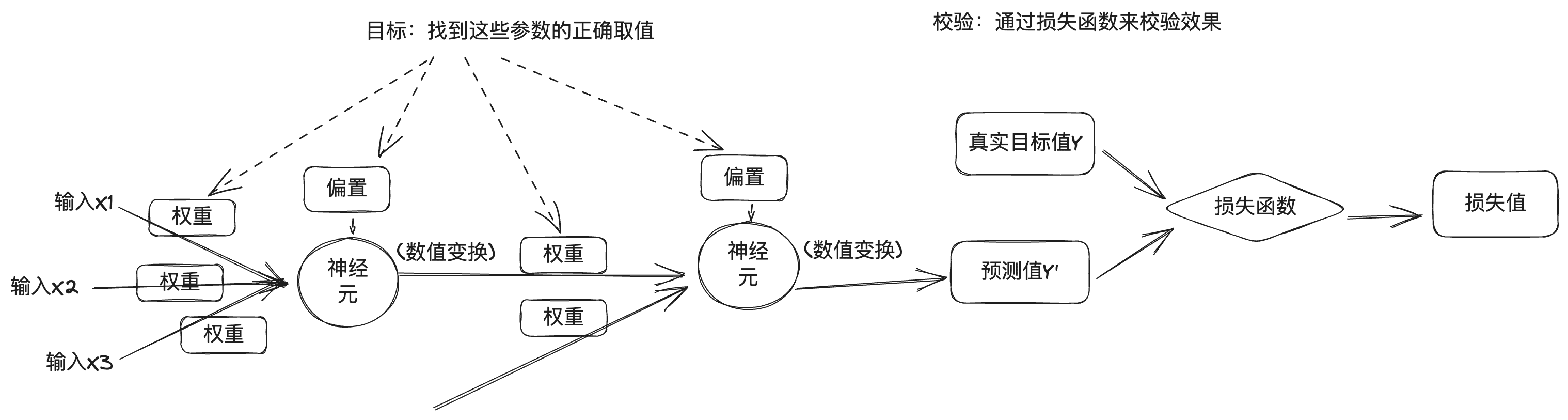

Nous convertissons ensuite le processus de classification de chaque nombre en un neurone M-P, chaque neurone a 196 entrées de pixels, et la valeur du poids entre chaque entrée et ce neurone est obtenue par entraînement, de sorte qu'il constitue un réseau neuronal composé de 10 neurones, 196 entrées et 1 960 lignes de connexion avec des poids devant elles, comme indiqué ci-dessous : (En général, dans un réseau neuronal, la valeur du seuil sera est convertie en un biais, appelé l'un des termes de sommation, pour simplifier le processus arithmétique).

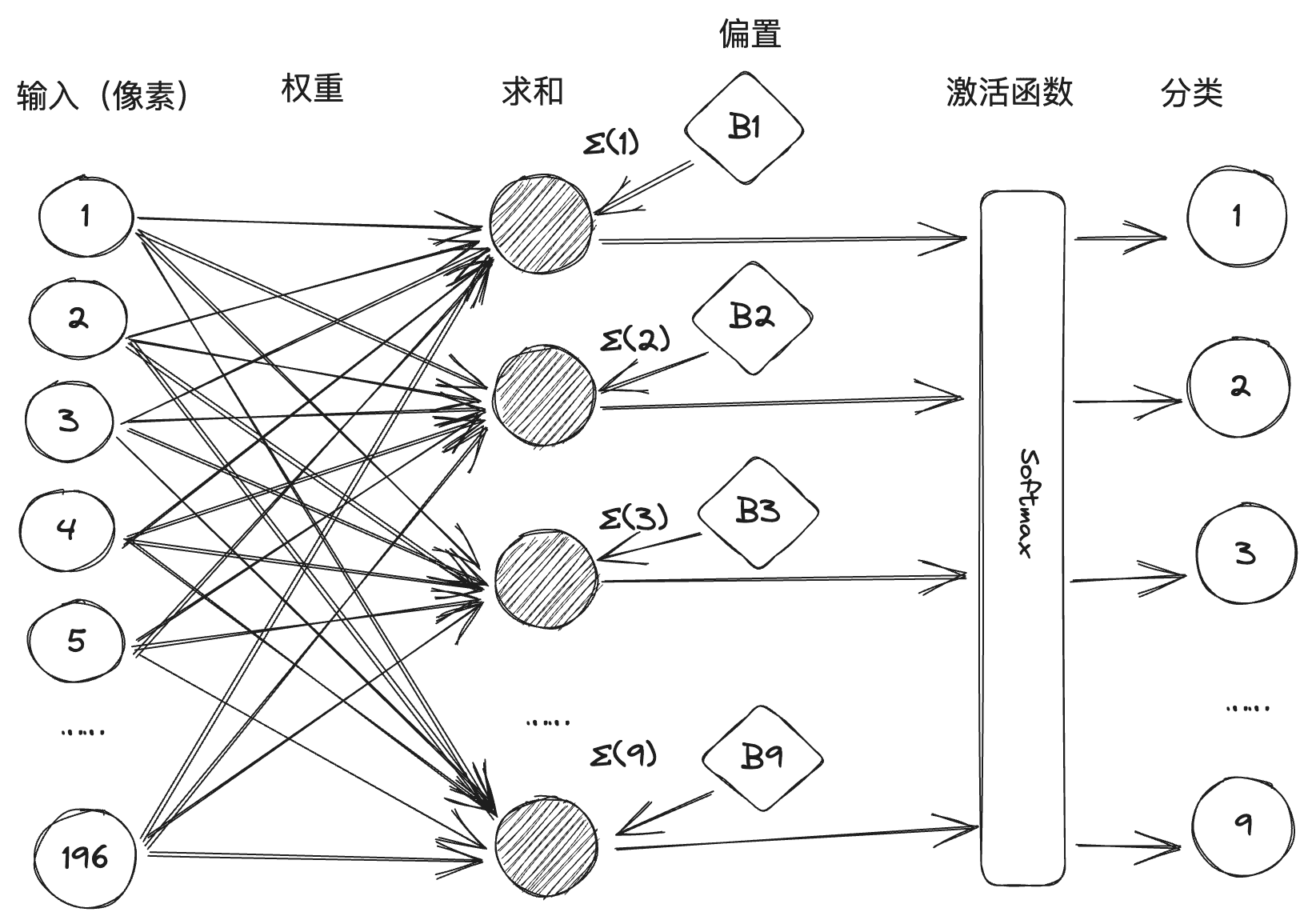

Toutefois, dans la pratique, certaines polices manuscrites présentent des ambiguïtés qui peuvent entraîner l'activation de deux neurones ou plus après la sommation pondérée. La machine perceptive est donc mise en œuvre en introduisant la conception d'une fonction d'activation, comme le montre la figure ci-dessous. Softmax est une fonction d'activation qui traitera la valeur de sommation pour inhiber la classification numérique avec une faible probabilité et améliorer la classification numérique avec une forte probabilité.

Deux ans plus tard, Rosenblatt a fabriqué le premier perceptron matériel au monde, le "Mark-1", capable d'identifier l'alphabet anglais, mais qui a fait sensation à l'époque. Le ministère américain de la défense et l'armée de la marine l'ont également remarqué et ont apporté un soutien financier considérable. La confiance de Rosenblatt dans la machine a atteint son apogée, et même un journaliste a demandé s'il ne pensait pas que la machine ne pouvait pas faire certaines choses, ce à quoi Rosenblatt a répondu : "amour, espoir, désespoir". La réponse de Rosenblatt est "amour, espoir, désespoir". La notoriété de Rosenblatt grandit, et sa personnalité flamboyante lui vaut de se faire des ennemis un peu partout, dont le plus célèbre est un autre géant de l'intelligence artificielle, Marvin Minsky. Minsky était l'organisateur de la conférence de Dartmouth et l'un des fondateurs de l'IA. En 1969, il a publié son livre Perceptual Machines, qui identifiait clairement les failles des machines perceptives. Il a d'abord démontré mathématiquement que les machines perceptives ne pouvaient pas traiter les problèmes de classification non linéaire tels que l'hétéroscédasticité, puis que la complexité des machines perceptives multicouches entraînait une expansion spectaculaire des données connectées en l'absence de méthode d'apprentissage appropriée. Minsky a remporté le quatrième prix Turing l'année de la publication du livre, et l'immense prestige de son jugement sur les machines perceptives a condamné à mort la recherche sur les réseaux neuronaux. Le connexionnisme a été battu à plate couture et la recherche symboliste s'est imposée dans le domaine de l'IA.

Il existe deux grandes écoles de pensée dans le domaine de l'intelligence artificielle : le connexionnisme et le symbolisme, un peu comme la secte de l'épée et la secte du qi dans les romans d'arts martiaux, qui s'affrontent depuis longtemps. Le connectivisme développe l'IA en modélisant le cerveau humain pour construire des réseaux neuronaux, en stockant les connaissances dans un grand nombre de connexions et en apprenant sur la base de données. Le symbolisme, quant à lui, estime que la connaissance et le raisonnement doivent être représentés par des symboles et des règles, c'est-à-dire un grand nombre de définitions de règles "si-alors" pour générer des décisions et des raisonnements, et développe l'IA sur la base de règles et de la logique. La première est représentée par les réseaux neuronaux et la seconde par les systèmes experts.

III Apprentissage en profondeur

Avec l'échec de la machine à percevoir, les investissements gouvernementaux dans le domaine de l'IA ont diminué, et l'IA est entrée dans sa première période hivernale. Dans les années 1980, le symbolisme, représenté par les systèmes experts, est devenu le courant dominant de l'IA, déclenchant la deuxième vague de l'IA, tandis que la recherche sur les réseaux neuronaux était laissée pour compte. Comme nous l'avons déjà mentionné, une seule personne persiste, Jeffrey Hinton.

Les contributions pionnières de Sinton au domaine des réseaux neuronaux ont donné vie au domaine, bien que le courant principal du domaine de l'intelligence artificielle des années 1980 au début du siècle ait encore été la base de connaissances et l'analyse statistique, et les différentes techniques de réseaux neuronaux ont commencé à percer, avec des exemples représentatifs tels que les réseaux neuronaux convolutionnels (CNN), les réseaux de mémoire à long terme à court terme (LSTM), etc. à long terme (LSTM), etc. En 2006, Hinton a proposé les réseaux de croyance profonde, qui ont ouvert l'ère de l'apprentissage profond.

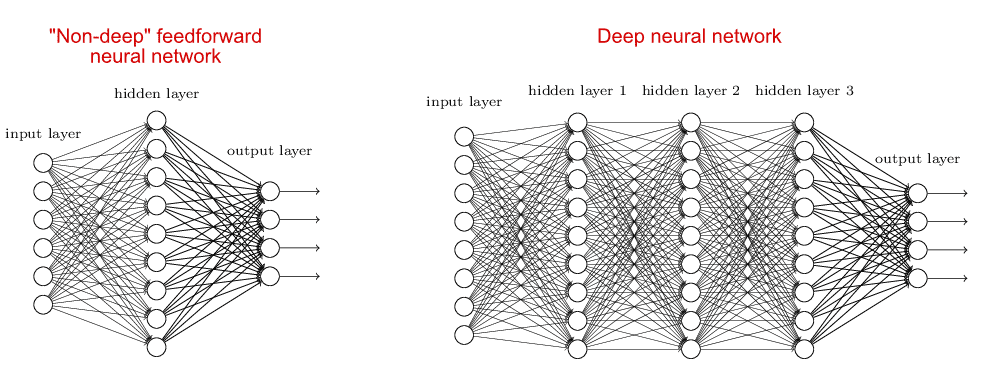

Le modèle de réseau neuronal correspondant à l'apprentissage profond est appelé réseau neuronal profond, par rapport aux réseaux neuronaux peu profonds. Pour les réseaux neuronaux peu profonds, il n'y a généralement qu'une seule couche cachée (ou couche intermédiaire), plus les couches d'entrée et de sortie, soit un total de trois couches. Les réseaux neuronaux profonds, quant à eux, comportent plus d'une couche cachée, ce qui permet de comparer les deux types de réseaux neuronaux :

La raison pour laquelle les gens se sont concentrés sur les réseaux neuronaux peu profonds avant l'apprentissage profond est que l'augmentation du nombre de couches du réseau neuronal entraîne une augmentation de la difficulté de la formation, d'une part, il n'y a pas de support arithmétique suffisant, et d'autre part, il n'y a pas de bon algorithme. Le réseau de croyance profond proposé par Hinton résout ce problème de formation en utilisant un algorithme de rétropropagation des erreurs et en effectuant un pré-entraînement couche par couche. Après le réseau de croyance profond, le réseau neuronal profond devient le modèle principal de l'apprentissage automatique, les modèles populaires actuels GPT, Llama et autres grands modèles sont construits à partir d'un ou de plusieurs réseaux neuronaux profonds.

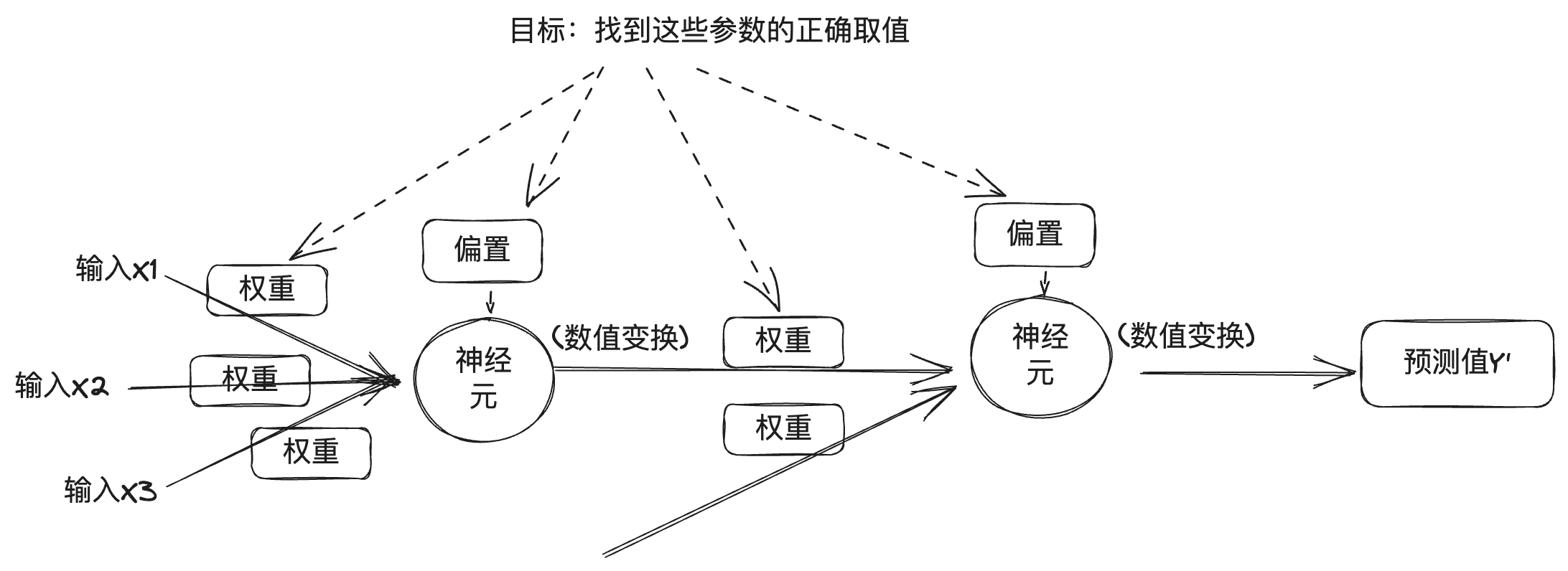

Pour comprendre les réseaux neuronaux profonds, vous pouvez vous référer à l'introduction du principe de la machine perceptuelle ci-dessus, le réseau neuronal profond est considéré comme une combinaison de plusieurs neurones en plusieurs couches, d'après la section précédente, chaque couche de la sortie est liée au poids, au biais et à la fonction d'activation, et pour la sortie du réseau neuronal profond est également liée au nombre de couches et à d'autres valeurs numériques. Dans les réseaux neuronaux profonds, ces valeurs peuvent être divisées en deux catégories : d'une part, le nombre de couches, la fonction d'activation, l'optimiseur, etc., appelés hyperparamètres, qui sont définis par l'ingénieur ; d'autre part, le poids et le biais, appelés paramètres, qui sont obtenus automatiquement au cours du processus de formation des réseaux neuronaux profonds, et la recherche du bon paramètre est l'objectif de l'apprentissage profond.

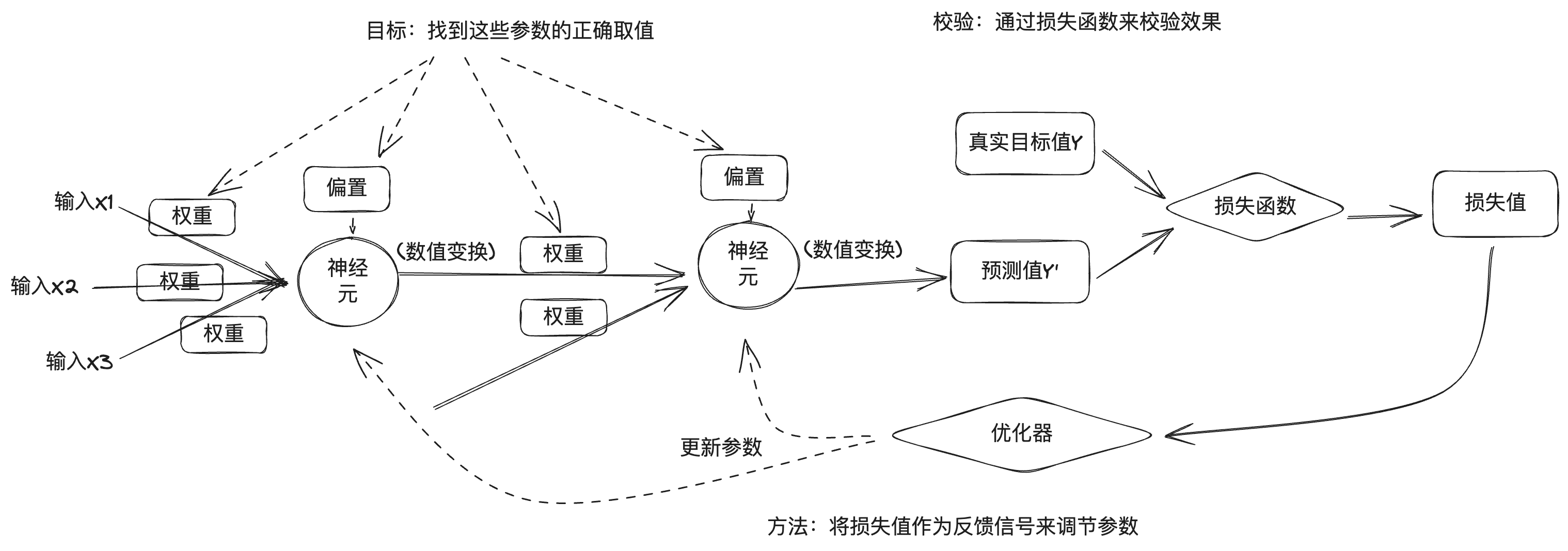

Mais le problème est qu'un réseau neuronal profond contient un très grand nombre de paramètres, et que la modification d'un paramètre affectera le comportement des autres, de sorte que trouver les valeurs correctes pour ces paramètres est une tâche difficile. Pour trouver les valeurs correctes des paramètres et obtenir un résultat précis du modèle, nous avons besoin d'un moyen de mesurer l'écart entre le résultat du modèle et le résultat souhaité. C'est pourquoi l'apprentissage profond est mesuré à l'aide d'une fonction de perte, également connue sous le nom de fonction objective ou de fonction de coût. La fonction de perte indique dans quelle mesure le modèle de réseau neuronal est bon ou mauvais sur cet échantillon de formation en comparant la valeur prédite par le réseau neuronal profond à la véritable valeur cible pour obtenir la valeur de perte.

L'approche d'apprentissage profond utilise les valeurs de perte comme signaux de retour pour affiner les paramètres afin de réduire les valeurs de perte pour l'échantillon de formation actuel. Ce réglage est réalisé par un optimiseur, qui met en œuvre des algorithmes d'optimisation tels que la descente de gradient pour mettre à jour les paramètres des nœuds de neurones dans chaque couche par rétropropagation.

Au début, les paramètres du réseau neuronal sont attribués de manière aléatoire, un lot de données d'apprentissage est introduit, et après avoir obtenu la sortie prédite du réseau à travers la couche d'entrée et la couche cachée jusqu'à la couche de sortie, la valeur de perte est calculée en fonction de la fonction de perte, ce qui constitue le processus de propagation vers l'avant ; ensuite, en partant de la couche de sortie, le gradient des paramètres est calculé dans le sens inverse le long de chaque couche jusqu'à la couche d'entrée et les paramètres du réseau sont mis à jour à l'aide de l'algorithme d'optimisation basé sur le gradient, ce qui constitue le processus de propagation vers l'arrière. . À chaque lot d'échantillons d'entraînement traités par le réseau neuronal, les paramètres sont affinés dans la bonne direction et les valeurs de perte sont réduites, ce qui constitue le cycle d'entraînement. Un nombre suffisant de cycles de formation permet d'obtenir des paramètres qui minimisent la fonction de perte, ce qui donne un bon modèle de réseau neuronal.

Bien entendu, le processus d'apprentissage en profondeur est beaucoup plus complexe que cela, c'est pourquoi nous ne donnons ici qu'un bref aperçu du processus général.

En 2012, M. Hinton a dirigé deux de ses étudiants, Alex Krizhevsky et Ilya Sutskever, pour développer le réseau neuronal AlexNet, qui a participé au concours de reconnaissance d'images ImageNet et a remporté le championnat, avec un taux de précision bien plus élevé que celui du deuxième finaliste. M. Hinton et ses étudiants ont ensuite fondé DNNResearch, Inc. pour se concentrer sur les réseaux neuronaux profonds. L'entreprise n'avait ni produits ni actifs, mais le succès d'AlexNet a attiré plusieurs géants de l'internet. Au cours de l'hiver 2012, une vente aux enchères secrète a eu lieu au lac Tahoe, à la frontière entre les États-Unis et le Canada : l'objet de la vente était DNNResearch, récemment fondée, et les acheteurs étaient Google, Microsoft, DeepMind et Baidu. Finalement, alors que Google et Baidu faisaient encore monter les enchères, Hinton a annulé la vente et a choisi de la vendre à Google pour 44 millions de dollars.En 2014, Google a empoché DeepMind.En 2016, AlphaGo, qui utilise une combinaison de recherche classique par arbre de Monte Carlo et de réseaux neuronaux profonds, a battu Lee Sedol, puis, l'année suivante, a battu le joueur numéro 1 du classement mondial de Go, Ke Jie.AlphaGo a repoussé les limites de l'intelligence artificielle et de l'apprentissage profond à un nouveau niveau. de l'intelligence artificielle et de l'apprentissage profond.

IV. les grands modèles

En 2015, Musk, Greg Brockman, directeur technique de Stripe, Sam Altman et Ilya Sutskever, PDG de YC Ventures, et d'autres personnes se sont réunis à l'hôtel Resewood en Californie pour discuter de la création d'un laboratoire d'IA afin de contrer le contrôle de la technologie de l'IA par les grandes sociétés Internet. Greg Brockman a ensuite réuni un groupe de chercheurs de Google, Microsoft et d'autres entreprises pour créer un nouveau laboratoire appelé OpenAI. Greg Brockman, Sam Altman et Ilya Sutskever en sont respectivement le président, le directeur général et le scientifique en chef.

À l'origine, Musk et Sam Altman ont imaginé OpenAI comme une organisation à but non lucratif qui ouvrirait la technologie de l'IA à tous afin de contrer les dangers posés par le contrôle de la technologie de l'IA par les grandes entreprises de l'internet. La technologie d'apprentissage profond de l'IA étant en pleine explosion, personne ne pouvait prédire si elle constituerait une menace pour l'humanité à l'avenir, et l'ouverture pourrait être le meilleur moyen d'y remédier. Plus tard en 2019, OpenAI a choisi de créer une filiale rentable afin de financer le développement de sa technologie et de fermer la source de sa technologie de base, qui n'était qu'une réflexion après coup.

En 2017, des ingénieurs de Google ont publié un article intitulé Attention is all you need, dans lequel il était proposé que le Transformateur Architecture de réseau neuronal, qui se caractérise par l'introduction de mécanismes d'attention humaine dans les réseaux neuronaux. La reconnaissance d'images mentionnée plus haut est un scénario d'apprentissage profond, dans lequel les données d'images sont des données discrètes sans corrélation entre elles. Dans la vie réelle, il existe un autre scénario, qui consiste à traiter des données temporelles, telles que du texte, dont le contexte est lié, ainsi que des données vocales, vidéo, etc. Ces données ordonnées dans le temps sont appelées séquence (séquence), et la tâche réelle est souvent une séquence dans une autre séquence, comme la traduction, un paragraphe de chinois en un paragraphe d'anglais, ainsi que les questions-réponses robotisées, un paragraphe de la question en un paragraphe de réponses générées intelligemment, et donc l'utilisation du convertisseur (Transformer), qui est à l'origine du nom Transformer. C'est de là que vient le nom de Transformateur. Comme indiqué précédemment, l'excitation d'un neurone est déterminée par la somme pondérée des données d'entrée auxquelles il est connecté, et le poids représente la force de la connexion. Dans le cas des données de séries temporelles, le poids de chaque élément est différent, ce qui correspond à notre expérience quotidienne, par exemple dans le passage suivant :

Des recherches ont montré que l'ordre des caractères chinois n'a pas toujours d'incidence sur la lecture. Par exemple, lorsque vous finissez de lire cette phrase, vous constatez que tous les caractères sont en désordre.

Cela est vrai non seulement pour les caractères chinois, mais aussi pour d'autres langues humaines comme l'anglais. Les ingénieurs de Google ont introduit le mécanisme d'attention dans le modèle de réseau neuronal, utilisé dans le traitement du langage naturel, afin que la machine puisse "comprendre" l'intention du langage humain. Par la suite, en 2018, OpenAI a publié GPT-1 basé sur l'architecture Transformer, GPT-2 en 2019, GPT-3 en 2020, et ChatGPT AI Q&A programme basé sur GPT-3.5 à la fin de 2022, ce qui est choquant en termes de capacité de dialogue, et l'IA a fait un grand pas en avant dans la direction de l'AGI.

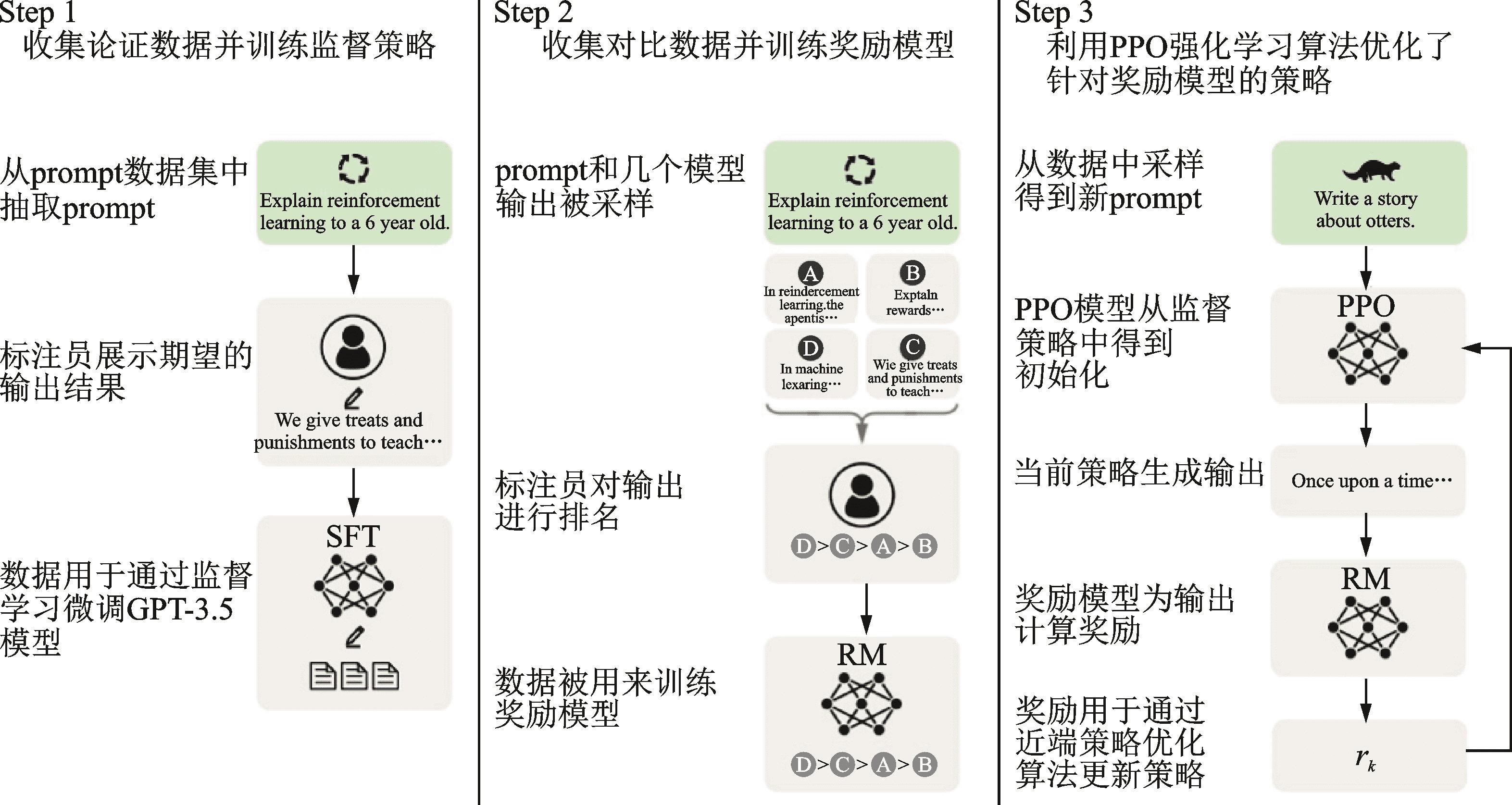

Le nom complet de GPT est Generative Pre-trained Transformer, Generative indiquant sa capacité à générer de nouveaux contenus, Transformer étant son infrastructure, et Pre-trained au milieu indiquant que sa méthode de formation est la préformation. Pourquoi l'appelle-t-on "pré-entraîné" ? Parce que, à partir d'AlexNet, les gens ont commencé à utiliser des données plus importantes et davantage de paramètres dans la formation des réseaux neuronaux afin d'obtenir de meilleurs résultats, ce qui signifie que la formation est devenue plus coûteuse en ressources et en temps. Ce coût est un peu élevé pour la formation à des tâches spécifiques et c'est un peu du gaspillage car il ne peut pas être partagé avec d'autres réseaux neuronaux. C'est pourquoi l'industrie a commencé à adopter une approche de préformation + mise au point pour former les modèles de réseaux neuronaux, c'est-à-dire qu'il faut d'abord terminer la formation d'un grand modèle général sur un grand ensemble de données, puis terminer la mise au point du modèle avec un ensemble de données plus petit pour des scénarios de tâches spécifiques.ChatGPT utilise l'apprentissage par renforcement à partir du feedback humain (RLHF), qui est une méthode de formation des modèles de réseaux neuronaux. ChatGPT utilise l'apprentissage par renforcement à partir du retour d'information humain (RLHF) pour le pré-entraînement et le réglage fin, qui est divisé en trois étapes : la première étape consiste à pré-entraîner un modèle linguistique (LM) ; la deuxième étape consiste à collecter des données de questions-réponses et à entraîner un modèle de récompense (RM) ; et la troisième étape consiste à régler finement le modèle linguistique (LM) avec l'apprentissage par renforcement (RL). Ce modèle de récompense contient un retour d'information humain, c'est pourquoi le processus de formation est appelé RLHF.

Les utilisateurs sont impressionnés par la capacité de dialogue à plusieurs reprises et par sa précision lors de l'utilisation de ChatGPT. Selon l'exploration sous-jacente des réseaux neuronaux, chaque processus d'inférence va de l'entrée à la sortie en passant par la pondération et l'activation de chaque neurone, et il n'y a pas de capacité de mémoire. La raison pour laquelle ChatGPT fonctionne bien avec le dialogue à plusieurs tours est qu'il utilise la technologie de Prompt Engineering dans la gestion du dialogue.

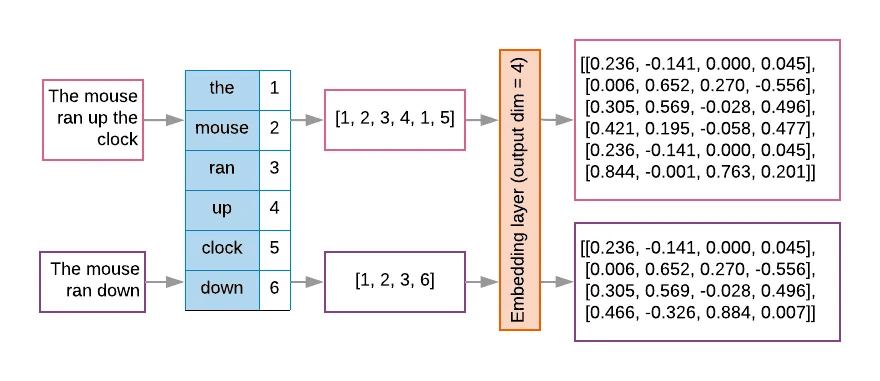

Pour les grands modèles linguistiques tels que ChatGPT, l'entrée est un jeton après la conversion d'une chaîne de texte, et les grands modèles conçoivent généralement une fenêtre contextuelle fixe pour limiter le nombre de jetons d'entrée en raison de l'efficacité du calcul et des contraintes de mémoire. Le texte sera d'abord subdivisé par le tokenizer et numéroté par la table de recherche, puis incorporé dans la matrice en un vecteur d'espace à haute dimension, ce qui constitue le processus de vectorisation du texte, comme le montre la figure suivante.

En raison des limitations du nombre de jetons, il est nécessaire d'utiliser des techniques d'ingénierie des invites afin de fournir au grand modèle des informations plus complètes dans une fenêtre contextuelle limitée. L'ingénierie des invites utilise un certain nombre de stratégies pour optimiser les entrées du modèle afin que celui-ci produise des résultats qui correspondent mieux aux attentes.

OpenAI croit que les efforts vigoureux produisent des miracles, et a continuellement élargi les paramètres de GPT, avec GPT-1 ayant 117 millions de paramètres de modèle, GPT-2 ayant augmenté à 1,5 milliard de paramètres de modèle, GPT-3 atteignant 175 milliards, et les paramètres de modèle de GPT-4 ayant prétendument 1,8 trillion. Plus de paramètres de modèle signifie plus de puissance de calcul pour soutenir la formation, OpenAI a donc résumé la "loi d'échelle", qui dit que la performance du modèle est liée à la taille du modèle, au volume de données et aux ressources informatiques, en d'autres termes, plus le modèle est grand, plus le volume de données est grand et plus les ressources informatiques sont grandes, meilleure est la performance du modèle. Rich Sutton, le père de l'apprentissage par renforcement, a exprimé un point de vue similaire dans son article "The Bitter Lesson" (la leçon amère), passant en revue le développement de l'intelligence artificielle au cours des dernières décennies, il a conclu qu'à court terme, les gens essaient toujours d'améliorer les performances du corps intelligent en construisant des connaissances, mais qu'à long terme, c'est la puissance arithmétique qui est reine.

La capacité des grands modèles est également passée de changements quantitatifs à des changements qualitatifs, ce que Jeff Dean, scientifique en chef de Google, a appelé les "capacités émergentes" (capacités émergentes) des grands modèles. Le marché voit cette opportunité, d'une part, les principaux fournisseurs de grands modèles investissent dans la course aux armements, d'autre part, les grands modèles de l'écologie de l'open source sont également en plein essor.

V Visage étreint

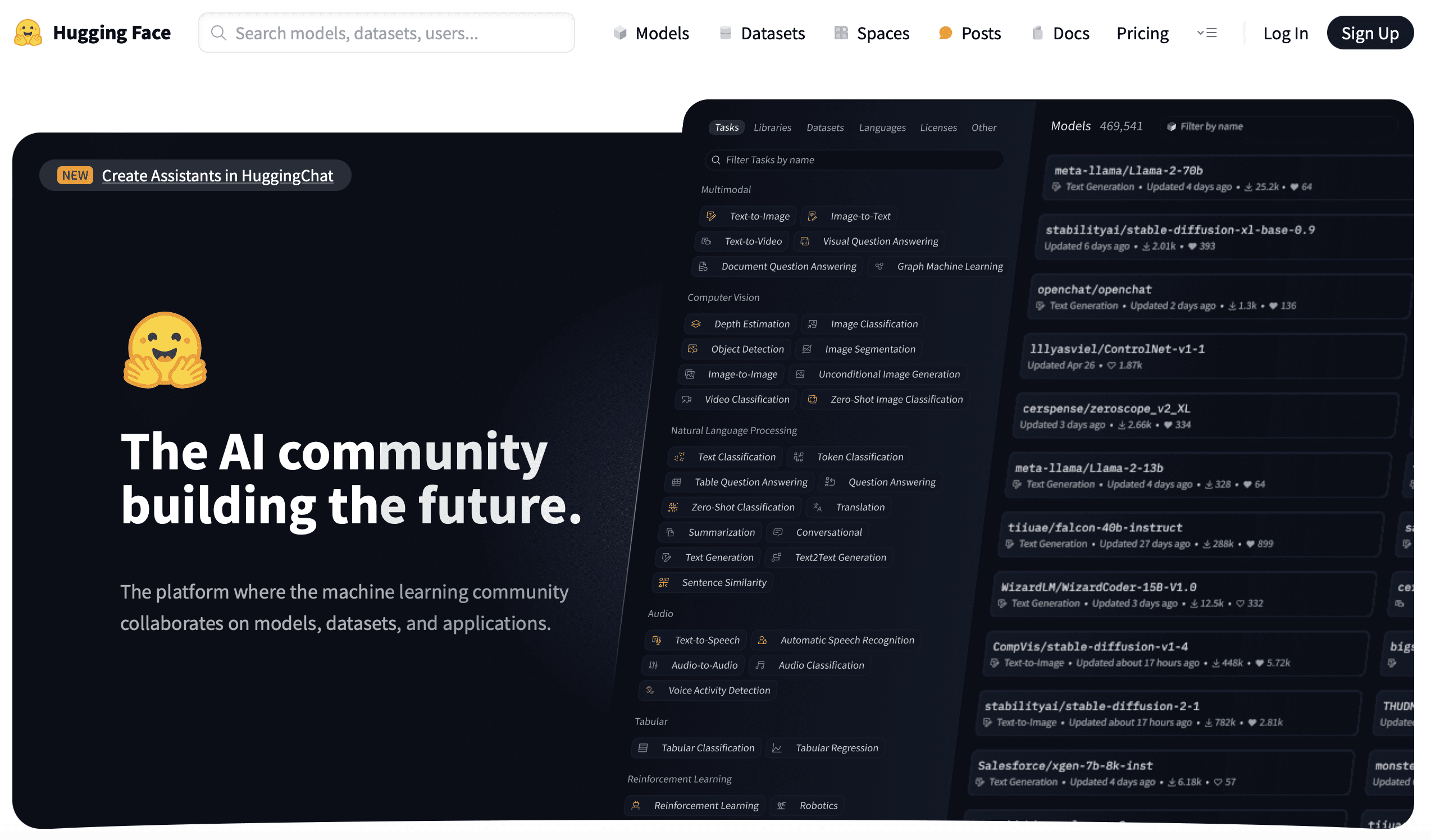

En 2016, les Français Clément Delangue, Julien Chaumond et Thomas Wolf ont fondé une entreprise appelée Hugging Face, avec l'icône emoji comme logo, qui a commencé par développer des chatbots intelligents pour les jeunes, puis a développé certains outils d'entraînement de modèles et les a mis en open-source dans le processus d'entraînement de modèles. Plus tard, elle a développé des outils de formation de modèles et les a mis en libre accès. Plus tard, elle s'est même concentrée sur ces derniers, une approche apparemment "non professionnelle" qui l'a conduite à une nouvelle voie et à un rôle indispensable dans le domaine de l'apprentissage en profondeur.

Silicon Valley a beaucoup d'entreprises sont dans l'activité secondaire pour faire des réalisations, comme Slack initialement développé des jeux, l'équipe de l'entreprise est distribuée dans de nombreux endroits, dans le processus d'exploitation a développé un outil de communication résulte dans l'incendie accidentel, c'est, Slack. et le tour de Hugging Face est également similaire, mais aussi afin de résoudre leurs propres points de douleur, en 2018, Google a publié le grand modèle BERT, et Hugging. Face ont alors utilisé leur cadre familier Pytorch pour mettre en œuvre BERT, ont nommé le modèle pytorch-pretrained-bert, et l'ont mis en open-source sur GitHub. plus tard, avec l'aide de la communauté, un groupe de modèles tels que GPT, GPT-2, et Transformer-XL ont été introduits, et le projet a été rebaptisé. Dans le domaine de l'apprentissage profond, les deux frameworks Pytorch et TensorFlow se font concurrence, et les chercheurs passent souvent d'un framework à l'autre afin de comparer leurs avantages et leurs inconvénients ; le projet open-source a donc ajouté la fonction de passage d'un framework à l'autre, et le nom du projet a également été modifié en Transformers. Transformers est également devenu le projet à la croissance la plus rapide sur GitHub.

Hugging Face continue de développer et d'ouvrir une série d'autres outils d'apprentissage automatique : Datasets, Tokenizer, Diffusers ...... Ces outils normalisent également le processus de développement de l'IA. Avant Hugging Face, on pourrait dire que le développement de l'IA était dominé par des chercheurs sans approche d'ingénierie standardisée. Hugging Face fournit un ensemble complet d'outils d'IA et établit un ensemble de normes de facto, ce qui permet également à davantage de développeurs d'IA et même à des praticiens non spécialistes de l'IA de se lancer rapidement et d'entraîner des modèles.

Hugging Face a ensuite lancé le Hugging Face Hub pour l'hébergement de modèles, d'ensembles de données et d'applications d'IA basés sur les technologies Git et Git LFS. Jusqu'à présent, 350 000 modèles, 75 000 ensembles de données et 150 000 exemples d'applications d'IA ont été hébergés sur la plateforme. Le travail d'hébergement et d'ouverture de modèles et d'ensembles de données, ainsi que l'établissement d'un centre mondial de dépôt de sources ouvertes, sont novateurs et d'une grande portée. Alors que l'approche de pré-entraînement et de réglage fin mentionnée ci-dessus facilite le partage des ressources d'entraînement des réseaux neuronaux, le Hugging Face Hub va encore plus loin en permettant aux développeurs d'IA de réutiliser facilement les résultats les plus récents et de les compléter, rendant ainsi possible la démocratisation de l'IA pour que tout le monde puisse l'utiliser et la développer. GitHub, ou comme le dit son slogan : construire la communauté de l'IA du futur. J'ai déjà écrit deux articles, l'un sur lesUn changement de code qui a changé le mondeIntroducing Git, un article dansDe zéro à 10 milliards de dollarsEn présentant GitHub, et Git, GitHub, Hugging Face, je pense qu'il y a une sorte d'héritage entre eux, un héritage de hacking qui change le monde pour construire l'avenir, et c'est l'une des choses qui m'a poussé à écrire ce billet.

VI. post-scriptum

Alors que j'approchais de la fin de cet article, j'ai regardé une conférence que Hinton a récemment donnée à l'Université d'Oxford. Dans cette conférence, Hinton a présenté deux grandes écoles de pensée dans le domaine de l'intelligence artificielle, l'une qu'il a appelée l'approche logique, ou symbolisme, et l'autre qu'il a appelée l'approche biologique, ou connexionnisme des réseaux neuronaux, qui simule le cerveau humain. L'approche biologique s'est avérée être un vainqueur incontestable de l'approche logique. Les réseaux neuronaux sont des modèles conçus pour imiter la compréhension du cerveau humain, et les grands modèles fonctionnent et comprennent comme le cerveau. M. Hinton est convaincu qu'une intelligence artificielle dépassant le cerveau humain verra le jour à l'avenir, et bien plus tôt que nous ne le prévoyons.

Annexe 1 Chronologie des événements

En 1943, McCulloch et Pitts ont publié le "modèle de neurones M-P", qui utilise la logique mathématique pour expliquer et simuler les unités de calcul du cerveau humain, et a introduit le concept de réseaux neuronaux.

Le terme "intelligence artificielle" a été inventé pour la première fois lors de la conférence de Dartmouth en 1956.

En 1957, Rosenblatt a proposé le modèle du "perceptron" et, deux ans plus tard, a réussi à construire le Mark-1, un perceptron matériel capable de reconnaître l'alphabet anglais.

En 1969, Minsky a publié Perceptual Machines, et les défauts des machines perceptives soulignés dans le livre ont porté un coup dur à la recherche sur les machines perceptives et même sur les réseaux neuronaux.

En 1983, Hinton a inventé la machine de Boltzmann.

En 1986, Hinton a inventé l'algorithme de rétropropagation des erreurs.

En 1989, Yann LeCun a inventé le réseau neuronal convolutif (CNN).

En 2006, M. Hinton a proposé le Deep Belief Network (réseau de croyance profond), inaugurant ainsi l'ère de l'apprentissage profond.

L'apprentissage profond a été pris au sérieux par l'industrie en 2012, lorsque M. Hinton et deux de ses étudiants ont conçu AlexNet, qui a remporté haut la main le concours ImageNet.

En 2015, DeepMind, une entreprise rachetée par Google, a lancé AlphaGo, qui a battu Lee Sedol en 2016 et Ke Jie en 2017.OpenAI a été fondée.

Hugging Face a été fondé en 2016.

En 2017, Google a publié le document de référence du Transformer.

En 2018, OpenAI a publié GPT-1 basé sur l'architecture Transformer. Hugging Face a publié le projet Transformers.

En 2019, OpenAI publie GPT-2.

En 2020, OpenAI publie GPT-3 et Hugging Face lance Hugging Face Hub.

En 2022, OpenAI lance ChatGPT.

Annexe 2 Références

Livres :

Frontiers of Intelligence : from Turing Machines to Artificial Intelligence par Zhou Zhiming (Auteur) Mechanical Industry Press Octobre 2018

La révolution de l'apprentissage profond par Cade Metz Shuguang Du CITIC Press Janvier 2023

Deep Learning in Python (2ème édition) François Chollet (Auteur) Liang Zhang (Traducteur) People's Posts and Telecommunications Publishing House Août 2022

Introduction à l'apprentissage profond : théorie et mise en œuvre en Python par Yasui Saito (Auteur) Yujie Lu (Traducteur) Maison d'édition des Postes et Télécommunications du Peuple 2018

Deep Learning Advanced : Natural Language Processing par Yasuyoshi Saito (Auteur) Yujie Lu (Traducteur) People's Posts and Telecommunications Publishing House Octobre 2020

This is ChatGPT Stephen Wolfram (Auteur) WOLFRAM Media Chinese Group (Traducteur) People's Posts and Telecommunications Publishing House Juillet 2023

Generative Artificial Intelligence par Ding Lei (Auteur) CITIC Press Mai 2023

Huggingface Natural Language Processing Explained par Li Fulin (Auteur) Tsinghua University Press Avril 2023

Article :

Introduction aux réseaux neuronaux par Yifeng Nguyen

2012, 180 jours qui ont changé le destin de l'humanité" Enkawa Research Institute

Evolution de la famille GPT MetaPost

Transformateur - L'attention est tout ce dont vous avez besoin".

Développement de modèles linguistiques pré-entraînés.

Guide de l'ingénierie des conseils

ChatGPT derrière le "crédit" - Explication détaillée de la technologie RLHF.

Développement et application des techniques de modélisation ChatGPT Large.

La leçon amère, Rich Sutton.

Entretien avec le directeur technique de HuggingFace : l'essor de l'Open Source, les histoires de startups et la démocratisation de l'IA".

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...