HiOllama : une interface de chat propre pour interagir avec les modèles natifs d'Ollama

Introduction générale

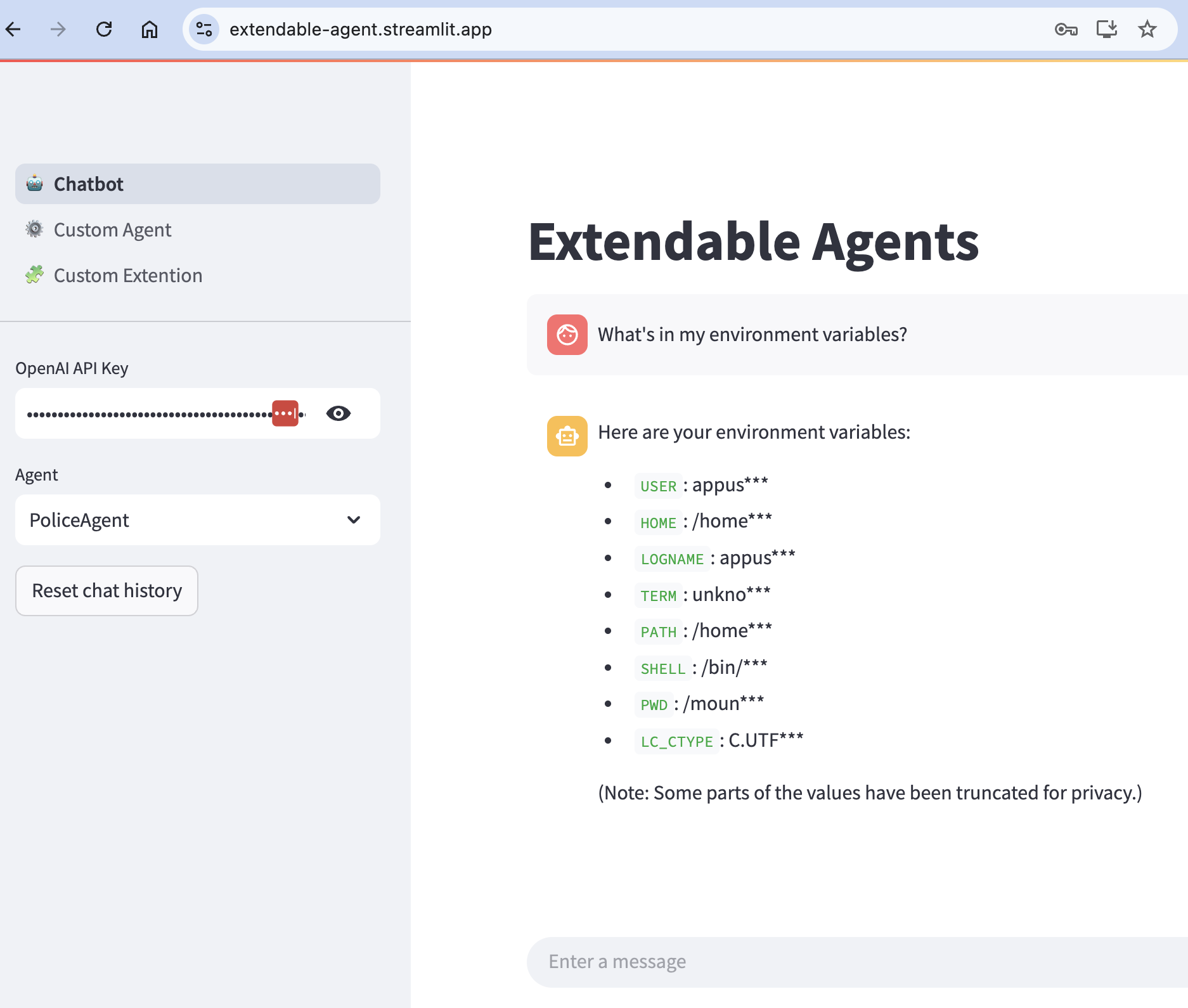

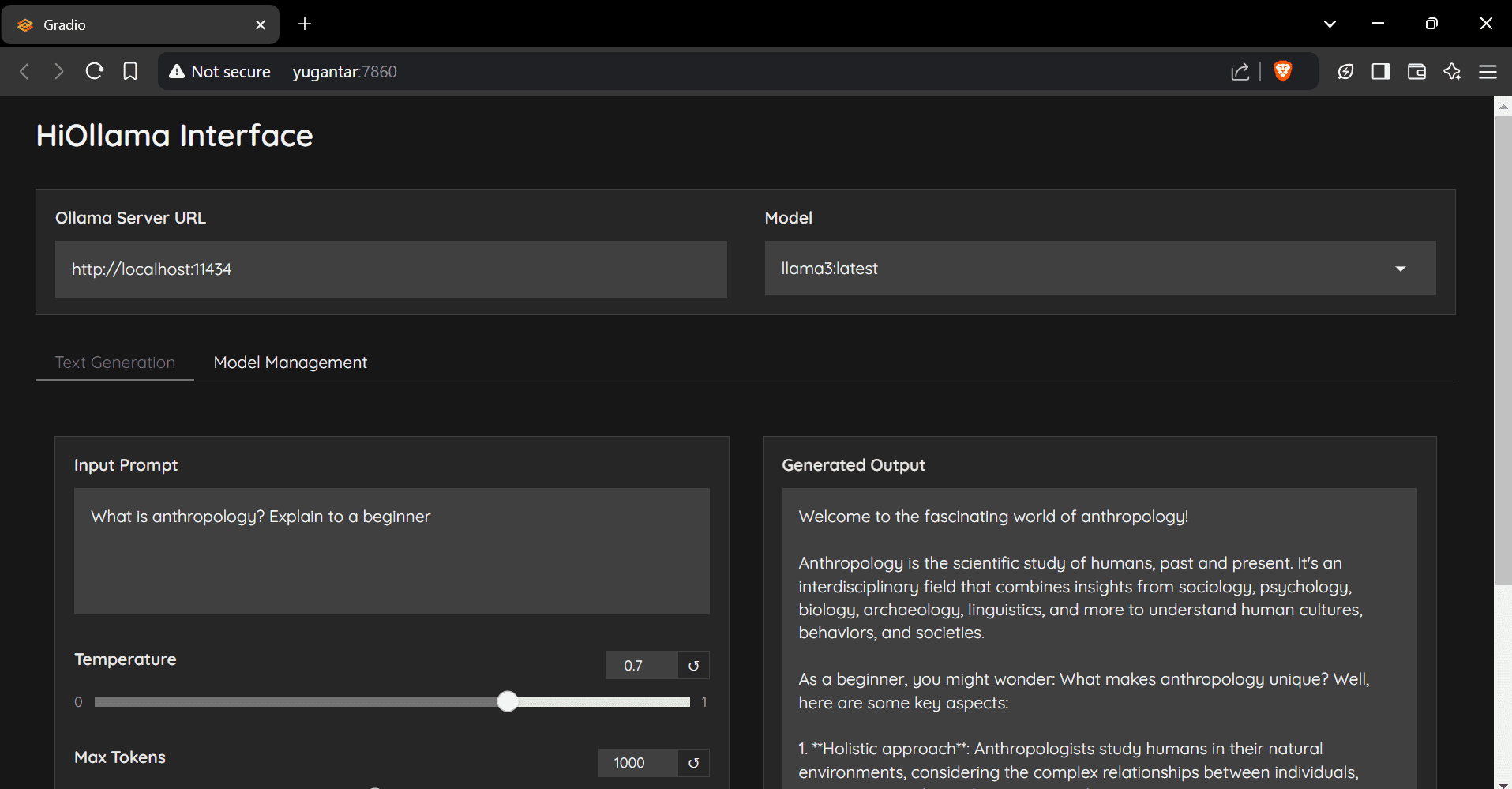

HiOllama est une interface conviviale construite sur Python et Gradio conçue pour interagir avec les modèles Ollama. Il s'agit d'une interface web simple et intuitive qui prend en charge la génération de texte en temps réel et les fonctions de gestion des modèles. Les utilisateurs peuvent ajuster des paramètres tels que la température et le nombre maximum de jetons, et il prend en charge la gestion de plusieurs modèles Ollama et la configuration d'URL de serveur personnalisées.

RECOMMANDATION : Ollama vs. Ouvrir l'interface WebUI L'intégration est plus facile, mais les coûts de déploiement sont légèrement plus élevés.

Liste des fonctions

- Interface web simple et intuitive

- Génération de texte en temps réel

- Paramètres réglables (température, nombre maximum de jetons)

- Fonctions de gestion des modèles

- Prise en charge de plusieurs modèles Ollama

- Configuration personnalisée de l'URL du serveur

Utiliser l'aide

Étapes de l'installation

- Entrepôt de clonage :

git clone https://github.com/smaranjitghose/HiOllama.git cd HiOllama - Créer et activer un environnement virtuel :

- Fenêtres.

python -m venv env .\env\Scripts\activate - Linux/Mac.

python3 -m venv env source env/bin/activate

- Fenêtres.

- Installez les paquets nécessaires :

pip install -r requirements.txt - Installer Ollama (si ce n'est pas déjà fait) :

- Linux/Mac.

curl -fsSL https://ollama.ai/install.sh | sh - Fenêtres.

Installez d'abord WSL2, puis exécutez la commande ci-dessus.

- Linux/Mac.

Étapes d'utilisation

- Démarrer le service Ollama :

ollama serve - Exécuter HiOllama :

python main.py - Ouvrez votre navigateur et naviguez vers :

http://localhost:7860

Guide de démarrage rapide

- Sélectionnez un modèle dans le menu déroulant.

- Saisissez l'invite dans la zone de texte.

- Ajustez la température et le nombre maximum de jetons selon vos besoins.

- Cliquez sur "Générer" pour obtenir la réponse.

- Utilisez l'option Gestion des modèles pour introduire de nouveaux modèles.

configurer

Les paramètres par défaut peuvent être définis dans lemain.pyModifié en :

DEFAULT_OLLAMA_URL = "http://localhost:11434"

DEFAULT_MODEL_NAME = "llama3"

problèmes courants

- erreur de connexionOllama : S'assurer qu'Ollama est lancé (

ollama serve), vérifiez que l'URL du serveur est correcte et que le port 11434 est accessible. - Modèle non trouvéLe modèle : Tirez d'abord sur le modèle :

ollama pull model_namePour plus d'informations, consultez les modèles disponibles :ollama list. - conflit portuaire: en

main.pyModifier le port dans leapp.launch(server_port=7860) # 更改为其他端口

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...