Google lance le modèle Gemma 3 QAT : les modèles d'IA les plus performants sont désormais disponibles sur les GPU grand public.

Après le lancement d'une nouvelle génération de modèles ouverts le mois dernier Gemma 3 Google a récemment élargi son écosystème de modèles avec une nouvelle version optimisée pour le Quantization-Aware Training (QAT). Gemma 3 a déjà été utilisé dans BF16 La précision est inférieure à celle d'un seul GPU haut de gamme (par ex. NVIDIA H100La version QAT est conçue pour réduire de manière significative les besoins en mémoire des modèles tout en maintenant la plus haute qualité de sortie possible, permettant ainsi à des modèles d'IA puissants de fonctionner sur du matériel plus grand public. La version QAT est conçue pour réduire de manière significative les besoins en mémoire des modèles tout en maintenant la plus haute qualité de sortie possible, permettant ainsi à des modèles d'IA puissants de fonctionner sur du matériel plus grand public.

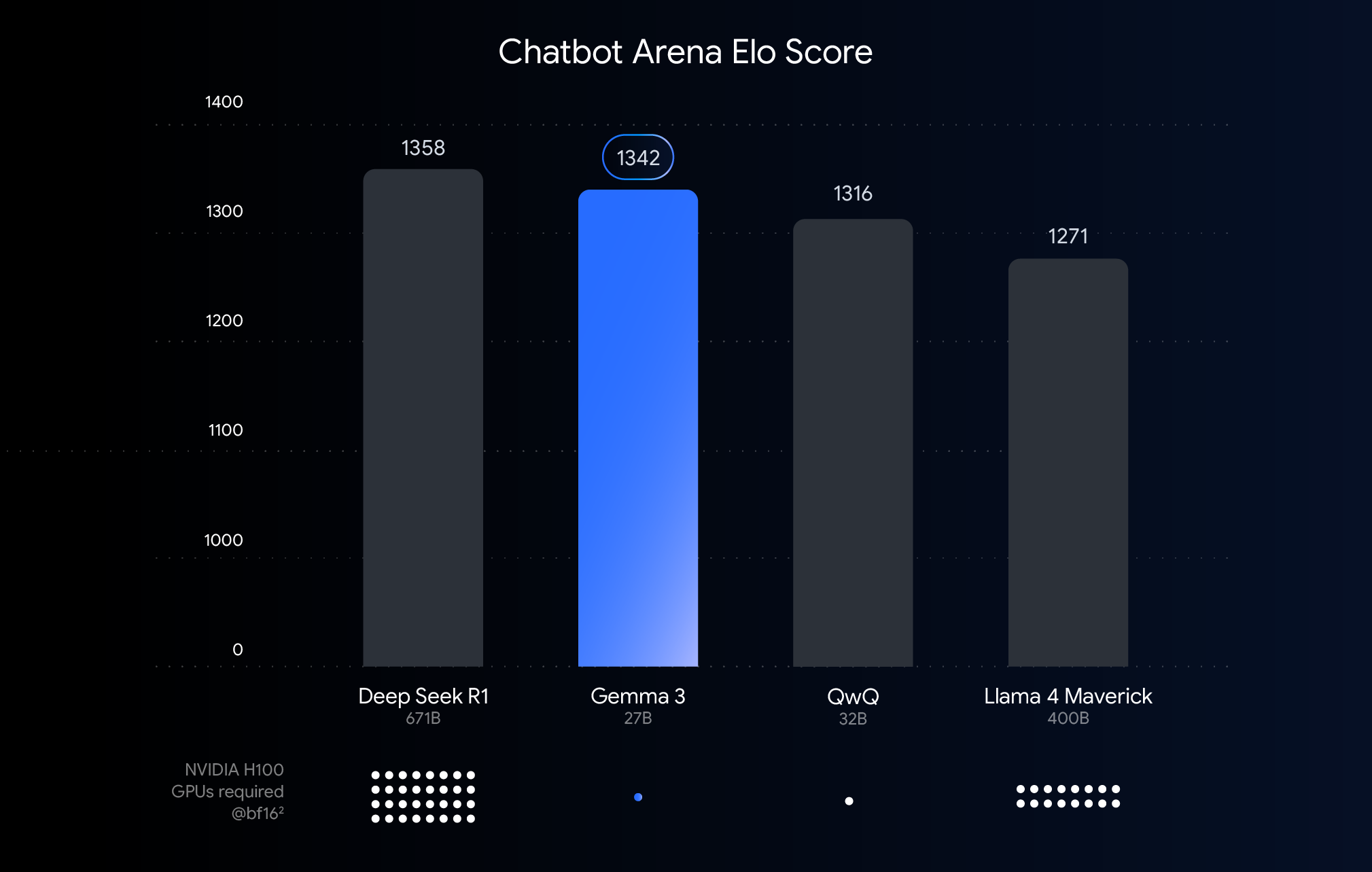

Ce graphique classe les modèles d'IA en fonction des scores Elo de Chatbot Arena, les scores les plus élevés représentant une plus grande préférence de la part des utilisateurs. Les points indiquent ce dont le modèle a besoin pour fonctionner NVIDIA H100 Le nombre estimé de GPU.

Comprendre les seuils de performance, de précision et de quantification

Le graphique ci-dessus présente une comparaison des performances (scores Elo) des grands modèles linguistiques récemment publiés. Les barres plus hautes signifient que les modèles sont plus performants dans les comparaisons anonymes côte à côte effectuées par des évaluateurs humains. La partie inférieure du graphique indique les performances sur le BF16 nécessaires pour faire fonctionner chaque modèle sous le type de données NVIDIA H100 Nombre estimé de GPU.

option BF16 La comparaison est faite parce qu'il s'agit d'un format numérique couramment utilisé pour de nombreuses inférences de modèles à grande échelle, représentant des paramètres de modèles stockés avec une précision de 16 bits. Dans le cas du modèle unifié BF16 Les comparaisons dans le cadre de la configuration permettent d'évaluer les capacités inhérentes du modèle lui-même dans la même configuration d'inférence, en excluant les variables introduites par un matériel différent ou des techniques d'optimisation telles que la quantification.

Il convient de noter que, bien que le graphique utilise les données de l BF16 permet une comparaison équitable, mais dans le cadre du déploiement réel de très grands modèles, il est souvent nécessaire d'utiliser un système tel que le FP8 et d'autres formats de moindre précision, ce qui peut nécessiter un compromis entre performance et faisabilité.

Faire tomber les barrières matérielles : rendre l'IA plus accessible

Bien que Gemma 3 fonctionne bien sur du matériel haut de gamme pour les déploiements dans le nuage et les scénarios de recherche, les commentaires des utilisateurs indiquent clairement que le marché s'attend à pouvoir utiliser les capacités de Gemma 3 sur du matériel existant. L'adoption de technologies d'IA puissantes signifie que les modèles doivent être exécutés efficacement sur des GPU grand public que l'on trouve couramment sur les ordinateurs de bureau, les ordinateurs portables et même les appareils mobiles. L'exécution locale de modèles volumineux permet non seulement d'améliorer la confidentialité des données, de réduire la latence du réseau et de prendre en charge les applications hors ligne, mais aussi de laisser plus de place à la personnalisation par l'utilisateur.

Technologie QAT : la clé pour concilier performance et accessibilité

Les techniques de quantification sont essentielles pour atteindre cet objectif. Dans la modélisation de l'IA, la quantification vise à réduire la précision des nombres (c'est-à-dire les paramètres du modèle) utilisés dans le stockage et le calcul du modèle. Cela s'apparente à la compression d'une image en réduisant le nombre de couleurs utilisées dans l'image. Par rapport à l'utilisation de 16 bits par nombre (BF16), la quantification peut utiliser moins de bits, par exemple 8 bits (int8) ou même 4 bits (int4).

adoption int4 Cela signifie que chaque chiffre n'est représenté que par 4 bits et que la taille des données est inférieure à la taille de la carte. BF16 Réduit d'un facteur 4. Les méthodes de quantification traditionnelles (par exemple la quantification post-entraînement PTQ) sont généralement appliquées après l'entraînement du modèle, ce qui est facile à mettre en œuvre mais peut entraîner une dégradation significative des performances. La technique QAT utilisée par Google est différente.

QAT introduit une étape de quantification pendant l'apprentissage du modèle afin de simuler des opérations de faible précision. Cette approche permet au modèle de s'adapter à l'environnement de faible précision tout en restant en formation, ce qui lui permet de mieux maintenir la précision lors de la quantification ultérieure, permettant ainsi d'obtenir des modèles plus petits et plus rapides. Plus précisément, Google a appliqué environ 5 000 étapes de QAT au modèle Gemma 3, en ciblant la probabilité d'un point de contrôle non quantifié. De cette manière, il est affirmé qu'après avoir quantifié jusqu'à Q4_0 La perplexité, une mesure du pouvoir prédictif du modèle, diminue de 54% lorsque le format (en utilisant le modèle llama.cpp (évaluation).

Effet significatif : l'utilisation de la VRAM est considérablement réduite.

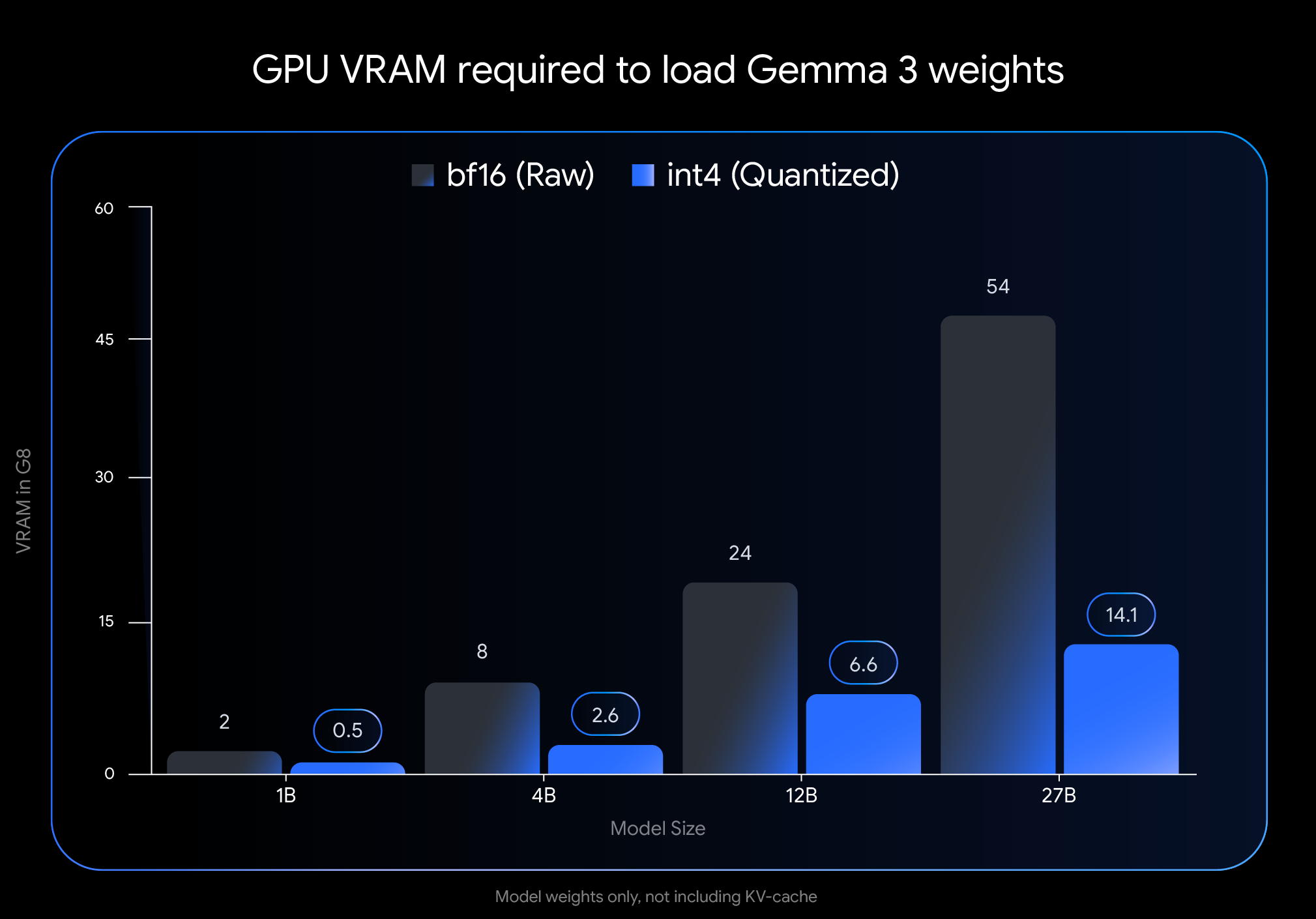

int4 L'impact de la quantification est significatif, notamment en termes de quantité de mémoire vidéo (VRAM) nécessaire pour charger les poids du modèle :

- Gemma 3 27B. A partir de 54 GB (

BF16) à 14.1 GB (int4) - Gemma 3 12B. A partir de 24 GB (

BF16) Réduction à 6,6 GO (int4) - Gemma 3 4B. À partir de 8 Go (

BF16) Réduit à 2.6 GB (int4) - Gemma 3 1B. A partir de 2 GB (

BF16) à 0.5 GB (int4)

Attention. Ces données ne représentent que la VRAM nécessaire pour charger les poids du modèle. L'exécution du modèle nécessite également de la VRAM supplémentaire pour le cache KV, qui stocke les informations relatives au contexte du dialogue, dont la taille dépend de la longueur du contexte.

Lancez Gemma 3 sur votre appareil !

La réduction considérable des besoins en mémoire graphique permet d'exécuter des modèles plus grands et plus puissants sur du matériel grand public largement disponible :

- Gemma 3 27B (

int4): Il est désormais facile de l'exécuter sur une simple classe d'ordinateur de bureau de 24 Go de VRAM.NVIDIA RTX 3090ou des cartes graphiques similaires, les utilisateurs ont pu faire tourner localement la plus grande variante Gemma 3 de Google. - Gemma 3 12B (

int4): La possibilité de fonctionner avec des GPU d'ordinateurs portables dotés de 8 Go de VRAM (tels que leNVIDIA RTX 4060 Laptop GPUL'entreprise apporte également de puissantes capacités d'IA aux appareils portables. - Modèles plus petits (4B, 1B). Il offre une plus grande accessibilité aux systèmes dont les ressources sont plus limitées, y compris à certains appareils mobiles.

Intégration facile avec les outils courants

Afin de faciliter l'utilisation de ces modèles par les utilisateurs dans leurs propres flux de travail, Google a mis à leur disposition le module Hugging Face répondre en chantant Kaggle L'officiel int4 répondre en chantant Q4_0 Modèles d'EQR non quantifiés. Parallèlement, Google s'est associé à plusieurs outils de développement populaires pour permettre aux utilisateurs d'essayer en toute transparence les points de contrôle quantifiés basés sur l'EAQ :

- Ollama. Tous les modèles Gemma 3 QAT sont pris en charge de manière native et peuvent être exécutés rapidement à l'aide d'une simple commande.

- LM Studio. Fournit une interface conviviale pour télécharger et exécuter facilement les modèles QAT de Gemma 3 sur votre bureau.

- MLX. utiliser

MLXLe cadre est enApple SiliconInférence efficace et optimale des modèles QAT de Gemma 3 sur la base des données de la base de données. - Gemma.cpp. Une implémentation C++ dédiée de Google pour une inférence efficace sur l'unité centrale.

- llama.cpp. Prise en charge native des modèles QAT au format GGUF pour une intégration aisée dans les flux de travail existants.

Plus d'options quantitatives dans le Gemmaverse Ecologie

En plus du modèle de TAQ publié officiellement, des Gemmaverse La communauté propose également de nombreuses alternatives. Ces systèmes utilisent généralement des techniques de quantification post-formation (PTQ), qui sont utilisées par l'Agence européenne pour la sécurité et la santé au travail (ESA). Bartowski, Unsloth, GGML et d'autres contributions des membres de la communauté, et en Hugging Face Disponible le . L'exploration de ces options communautaires offre aux utilisateurs un plus large éventail de choix pour les compromis entre la taille du modèle, la vitesse et la qualité afin de répondre à des besoins spécifiques.

Commencez dès maintenant !

La démocratisation du développement de l'IA passe par l'intégration de performances d'IA de pointe dans du matériel facilement accessible. Grâce aux modèles Gemma 3 optimisés par QAT, les utilisateurs peuvent désormais exploiter des capacités d'IA de pointe sur leur propre ordinateur de bureau ou portable. Cela permet non seulement aux développeurs et aux chercheurs d'explorer les modèles de langage à grande échelle, mais aussi d'envisager des applications d'IA de pointe plus puissantes.

Explorer les modèles quantitatifs et commencer à les construire :

- Utilisation sur un PC

OllamaLa course à pied :https://ollama.com/library/gemma3 - existent

Hugging Facerépondre en chantantKaggleRecherchez le modèle sur : - Fonctionne sur les appareils mobiles (via

Google AI Edge) :https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...