GLM-4.1V-Thinking - une famille de modèles de langage visuel open source de Smart Spectrum AI

Qu'est-ce que le GLM-4.1V-Pensée ?

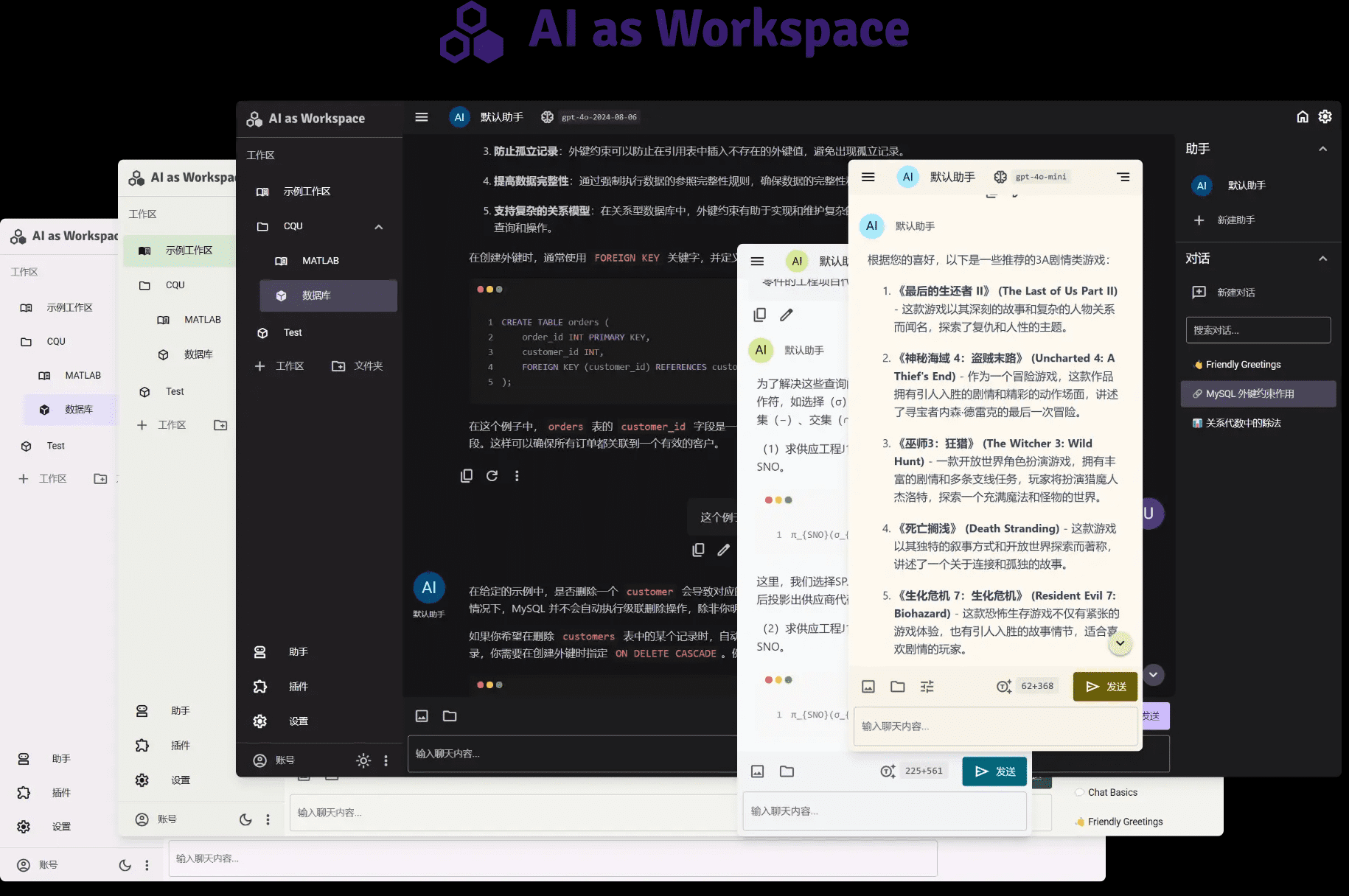

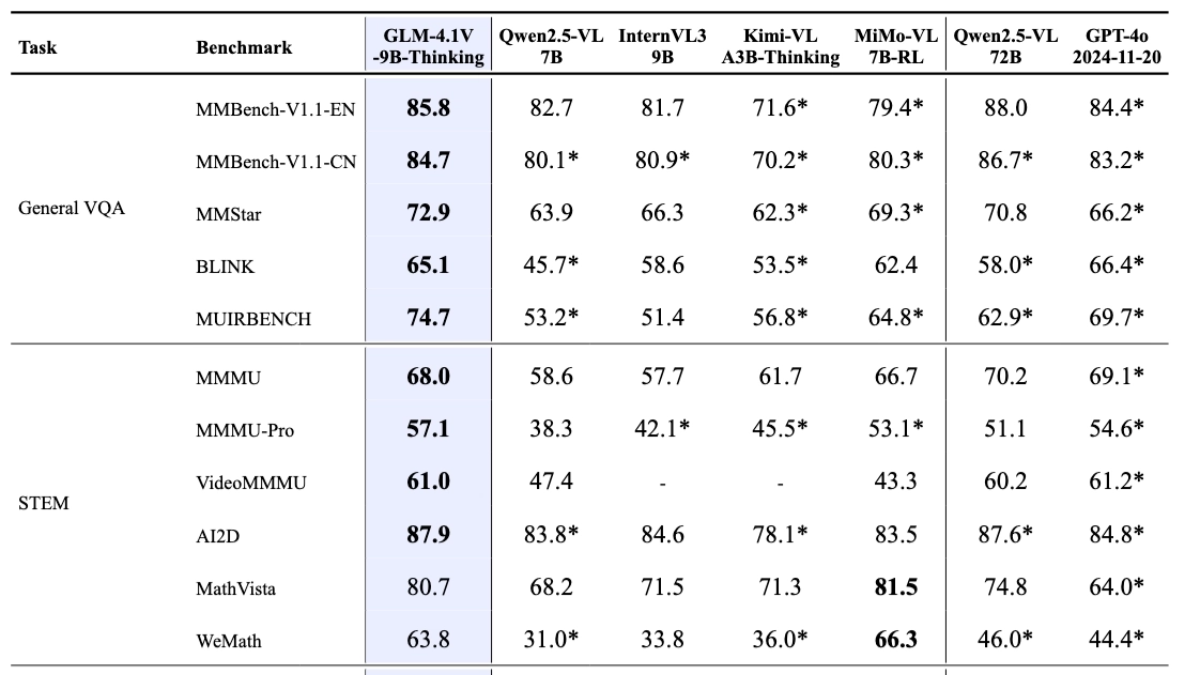

GLM-4.1V-Thinking est un modèle de langage visuel open source lancé par Smart Spectrum AI, conçu pour les tâches cognitives complexes. GLM-4.1V-Thinking prend en charge les entrées multimodales, y compris les images, les vidéos et les documents. Basé sur l'architecture GLM-4V, le modèle introduit un mécanisme de raisonnement en chaîne, renforce les stratégies d'apprentissage avec l'échantillonnage de cours, et améliore considérablement le raisonnement causal multimodal et la stabilité. La version allégée de GLM-4.1V-9B-Thinking (GLM-4.1V-9B-Base modèle de base et GLM-4.1V-9B-Thinking avec capacité de réflexion et de raisonnement profonds) compte 10B paramètres et a obtenu le meilleur score des modèles de niveau 10B dans 23 des 28 revues faisant autorité, dont 18 sont égales au nombre de paramètres de 72B de Qwen- 2.5-VL, ce qui démontre pleinement l'excellente performance du modèle de petite taille. Le modèle a un large éventail de perspectives d'application dans divers domaines tels que l'orientation éducative, la création de contenu, l'interaction intelligente, les applications industrielles, ainsi que le divertissement et la vie.

Caractéristiques principales de GLM-4.1V-Thinking

- Forte compréhension visuelleLes tâches de classification d'images plus complexes ou les quiz visuels qui nécessitent une compréhension globale de l'image et la réponse à des questions.

- Niveau élevé de traitement vidéoLes fonctionnalités d'analyse de la synchronisation et de modélisation de la logique des événements sont excellentes et permettent un traitement approfondi des entrées vidéo pour la compréhension de la vidéo, la génération de descriptions vidéo précises et la réponse aux questions relatives au contenu vidéo.

- Analyse complète des documentsIl permet le traitement simultané des images et du contenu textuel des documents, la compréhension des documents longs, l'analyse précise des diagrammes et des graphiques, ainsi que les questions-réponses basées sur le contenu du document, le tout de manière efficace.

- Excellentes capacités de raisonnementEn mathématiques et en sciences, résoudre des problèmes de raisonnement complexes, y compris la résolution de problèmes mathématiques à plusieurs étapes, la compréhension des formules et le raisonnement logique en sciences, en apportant un soutien solide à l'apprentissage et à la recherche dans des disciplines connexes.

- Le raisonnement logique est précisLes utilisateurs peuvent ainsi mieux comprendre et analyser un large éventail de situations complexes.

- Le raisonnement multimodal est efficaceLe programme d'apprentissage de l'anglais pour les enfants et les adolescents : il combine organiquement les informations visuelles et verbales pour un raisonnement multimodal efficace, en accomplissant des tâches telles que la compréhension graphique, les interrogations visuelles et l'ancrage visuel, et en fournissant un soutien puissant pour le traitement intégré des informations multimodales.

Avantages des performances du GLM-4.1V-Thinking

Dans 28 évaluations faisant autorité, telles que MMStar, MMMU-Pro, ChartQAPro, OSWorld, etc., GLM-4.1V-Thinking a obtenu d'excellents résultats, dont 23 éléments ont atteint les meilleures performances des modèles de classe 10B, et 18 éléments sont égaux ou même dépassés par Qwen-2.5-VL, dont le nombre de paramètres atteint 72B, ce qui démontre pleinement les puissantes performances des modèles de petit volume. Cela démontre pleinement la puissance des performances d'un petit modèle.

Adresse du site officiel de GLM-4.1V-Thinking

- Dépôt GitHub: : https://github.com/THUDM/GLM-4.1V-Thinking

- Bibliothèque de modèles HuggingFace: : https://huggingface.co/collections/THUDM/glm-41v-thinking-6862bbfc44593a8601c2578d

- Document technique arXiv: : https://arxiv.org/pdf/2507.01006v1

- Démonstration de l'expérience en ligne: : https://huggingface.co/spaces/THUDM/GLM-4.1V-9B-Thinking-Demo

Comment utiliser le GLM-4.1V - Réflexion

- Utilisation de l'interface API: :

- Obtenir la clé de l'APIPour plus d'informations sur la plateforme Smart Spectrum AI, consultez le site : https://bigmodel.cn/注册账号.

- Appeler l'APIPour ce faire, vous devez : selon la documentation de l'API, appeler l'interface du modèle avec une requête HTTP pour envoyer des données d'entrée (par exemple, des URL d'images ou des données encodées en Base64, du texte, etc. Par exemple, appeler avec un code Python :

import requests

import json

api_url = "https://api.zhipuopen.com/v1/glm-4.1v-thinking"

api_key = "your_api_key"

input_data = {

"image": "image_url_or_base64_encoded_data",

"text": "your_input_text"

}

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

response = requests.post(api_url, headers=headers, data=json.dumps(input_data))

result = response.json()

print(result)- Utilisation d'un modèle open source: :

- Télécharger les modèlesPour cela, il faut : visiter la plateforme Hugging Face, trouver la page GLM-4.1V-Thinking Models, et télécharger les fichiers de modèles nécessaires.

- Modèles de chargementChargement du modèle téléchargé avec un cadre d'apprentissage profond tel que PyTorch : Chargement du modèle téléchargé avec un cadre d'apprentissage profond tel que PyTorch. Exemple :

from transformers import AutoModelForVision2Seq, AutoProcessor

import torch

model_name = "THUDM/glm-4.1v-thinking"

model = AutoModelForVision2Seq.from_pretrained(model_name)

processor = AutoProcessor.from_pretrained(model_name)- tirer des conclusionsLe modèle est un outil qui permet de prétraiter les données d'entrée (par exemple, les chemins d'accès aux images ou les adresses URL, le texte, etc. ) dans le modèle et obtenir la sortie du modèle. Exemple :

image_url = "image_url_or_image_path"

text = "your_input_text"

inputs = processor(images=image_url, text=text, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

result = processor.decode(outputs.logits[0], skip_special_tokens=True)

print(result)- Utilisation de la plateforme d'expérience en ligne: :

- Accès à l'expérience LiensPour en savoir plus : Visitez la page de l'expérience GLM-4.1V-Thinking directement sur la plateforme Hugging Face.

- données d'entréeLes services d'aide à l'enfance : télécharger des données telles que des images ou saisir du texte sur une page web.

- Obtenir des résultatsCliquez sur le bouton "Exécuter", attendez que le modèle soit traité et visualisez le résultat, sans avoir à écrire un code complexe ni à déployer un modèle.

Principaux avantages du GLM-4.1V-Thinking

- Aide à la saisie multimodaleLe système de gestion de l'information : il prend en charge des entrées multiples telles que des images, des vidéos, des documents, etc., et peut traiter de manière exhaustive des informations de sources multiples afin de répondre aux besoins de tâches complexes.

- Un raisonnement solideLe projet : Introduction d'un mécanisme de raisonnement en chaîne qui génère un processus de raisonnement détaillé avec une réflexion étape par étape afin d'améliorer la performance et l'interprétabilité d'une tâche complexe.

- Stratégies de formation efficaces: Une stratégie d'apprentissage par renforcement de l'échantillonnage basée sur le cours qui ajuste dynamiquement la difficulté de l'entraînement et combine un pré-entraînement à grande échelle avec un réglage fin afin d'améliorer les performances et l'efficacité.

- Excellente performanceLe compteur de paramètres 10B est un modèle à faible encombrement qui s'est distingué dans plusieurs études faisant autorité, en faisant preuve d'une grande efficacité et d'une grande stabilité.

- Source ouverte et facilité d'utilisationLa fonction "open source" abaisse le seuil d'utilisation et fournit une variété de façons de l'utiliser, ce qui permet aux développeurs de l'intégrer rapidement et de la développer deux fois.

Personnes auxquelles s'adresse GLM-4.1V-Thinking

- Conseils en matière d'éducationL'enseignement assisté par l'enseignant, qui fournit aux étudiants des ressources d'apprentissage plus riches et des étapes de résolution de problèmes plus détaillées.

- créateur de contenuLes rédacteurs publicitaires, les opérateurs de médias sociaux, les journalistes et d'autres personnes génèrent un contenu créatif en combinant des images et du texte afin d'améliorer l'efficacité et la qualité de la création.

- Entreprises et développeursLes entreprises intègrent des modèles dans les systèmes de service à la clientèle intelligents afin d'améliorer la qualité du service à la clientèle, de prendre en charge la saisie multimodale, de mieux comprendre les besoins de l'utilisateur et de fournir des réponses précises.

- Développement d'applications industriellesLes professionnels de la finance, de la santé et de l'industrie effectuent des tâches telles que l'analyse des données, la création de rapports et la surveillance des équipements afin d'améliorer l'efficacité et la précision.

- chercheur (scientifique)Les chercheurs effectuent l'analyse et le traitement de données multimodales afin de soutenir des tâches de raisonnement complexes et de faire progresser la recherche dans des domaines connexes.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...