FunASR : boîte à outils de reconnaissance vocale open source, séparation du locuteur / reconnaissance vocale de dialogues multi-personnes

Introduction générale

FunASR est une boîte à outils de reconnaissance vocale open source développée par l'Institut Dharma d'Alibaba pour faire le lien entre la recherche universitaire et les applications industrielles. Il prend en charge un large éventail de fonctions de reconnaissance vocale, notamment la reconnaissance de la parole (ASR), la détection des terminaisons vocales (VAD), la récupération de la ponctuation, la modélisation du langage, la vérification du locuteur, la séparation du locuteur et la reconnaissance vocale des dialogues multi-personnes.

Prend en charge une variété de formats d'entrée audio et vidéo, peut identifier des dizaines d'heures de long audio et vidéo en texte avec ponctuation, prend en charge des centaines de demandes de transcription simultanée. Prend en charge le chinois, l'anglais, le japonais, le cantonais et le coréen.

Expérience en ligne : https://www.funasr.com/

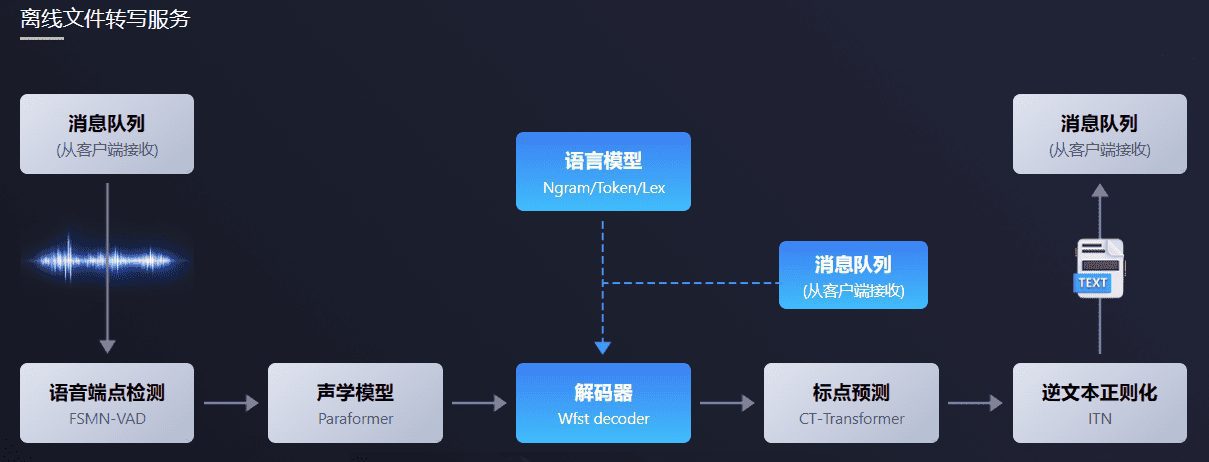

Le logiciel de transcription de fichiers hors ligne FunASR fournit un puissant service de transcription de fichiers hors ligne. Grâce à un lien de reconnaissance vocale complet, combinant la détection des terminaisons vocales, la reconnaissance vocale, la ponctuation et d'autres modèles, il peut reconnaître des dizaines d'heures de longs fichiers audio et vidéo sous forme de texte ponctué, et prend en charge des centaines de demandes de transcription simultanées. Le résultat est un texte ponctué avec des horodatages au niveau des mots et prend en charge les ITN et les mots clés définis par l'utilisateur. Intégration côté serveur avec ffmpeg, prise en charge d'une variété de formats d'entrée audio et vidéo. Le logiciel fournit des clients en html, python, c++, java et c# et d'autres langages de programmation, que l'utilisateur peut utiliser directement et développer ultérieurement.

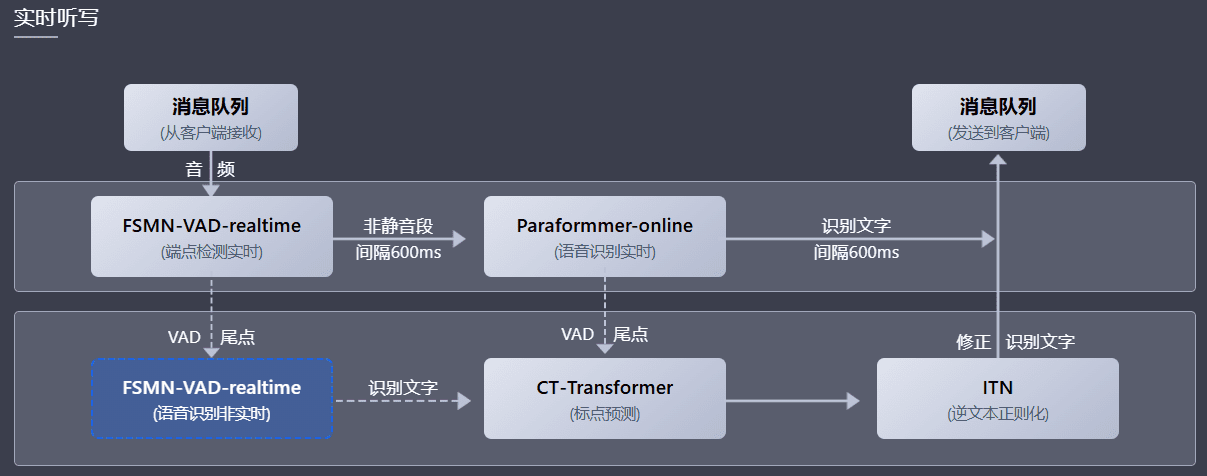

Le logiciel de dictée vocale en temps réel FunASR intègre des versions en temps réel de modèles de détection des terminaisons vocales, de reconnaissance vocale, de modèles de prédiction de la ponctuation, etc. Grâce à la synergie de plusieurs modèles, il peut non seulement effectuer la conversion de la parole en texte en temps réel, mais aussi corriger le texte de sortie avec une transcription de haute précision à la fin de la phrase, le texte de sortie avec la ponctuation, et prendre en charge des demandes multiples. En fonction des différents scénarios d'utilisation, il prend en charge trois modes de service : le service de dictée vocale en temps réel (en ligne), la transcription de phrases en temps différé (hors ligne) et la collaboration intégrée en temps réel et en temps différé (2pass). Le progiciel fournit une variété de langages de programmation tels que html, python, c++, java et le client c#, que les utilisateurs peuvent utiliser directement et développer davantage.

Liste des fonctions

- Reconnaissance vocale (ASR) : permet la reconnaissance vocale en ligne et en temps réel.

- Voice Endpoint Detection (VAD) : détecte le début et la fin du signal vocal.

- Récupération de la ponctuation : ajoute automatiquement la ponctuation pour améliorer la lisibilité du texte.

- Modèles linguistiques : permet l'intégration de plusieurs modèles linguistiques.

- Vérification du locuteur : vérification de l'identité du locuteur.

- Séparation des locuteurs : distinction de la parole de différents locuteurs.

- Reconnaissance vocale pour plusieurs conversations : prend en charge la reconnaissance vocale pour plusieurs conversations simultanées.

- Inférence et réglage fin du modèle : fournit des fonctions d'inférence et de réglage fin pour les modèles pré-entraînés.

Utiliser l'aide

Processus d'installation

- Préparation de l'environnement: :

- Assurez-vous que Python 3.7 ou supérieur est installé.

- Installer les bibliothèques de dépendances nécessaires :

pip install -r requirements.txt

- Télécharger les modèles: :

- Téléchargez des modèles pré-entraînés à partir de ModelScope ou HuggingFace :

git clone https://github.com/modelscope/FunASR.git cd FunASR

- Téléchargez des modèles pré-entraînés à partir de ModelScope ou HuggingFace :

- Environnement de configuration: :

- Configurer les variables d'environnement :

export MODEL_DIR=/path/to/your/model

- Configurer les variables d'environnement :

Processus d'utilisation

- reconnaissance vocale: :

- Utiliser la ligne de commande pour la reconnaissance vocale :

python recognize.py --model paraformer --input your_audio.wav - Reconnaissance vocale à l'aide du code Python :

from funasr import AutoModel model = AutoModel.from_pretrained("paraformer") result = model.recognize("your_audio.wav") print(result)

- Utiliser la ligne de commande pour la reconnaissance vocale :

- détection des terminaux vocaux: :

- Utilisez la ligne de commande pour la détection des terminaux vocaux :

python vad.py --model fsmn-vad --input your_audio.wav - Détection des terminaux vocaux à l'aide d'un code Python :

from funasr import AutoModel vad_model = AutoModel.from_pretrained("fsmn-vad") vad_result = vad_model.detect("your_audio.wav") print(vad_result)

- Utilisez la ligne de commande pour la détection des terminaux vocaux :

- Récupération de la ponctuation: :

- Utilisez la ligne de commande pour récupérer la ponctuation :

python punctuate.py --model ct-punc --input your_text.txt - Récupération de la ponctuation à l'aide du code Python :

from funasr import AutoModel punc_model = AutoModel.from_pretrained("ct-punc") punc_result = punc_model.punctuate("your_text.txt") print(punc_result)

- Utilisez la ligne de commande pour récupérer la ponctuation :

- Vérification des orateurs: :

- Utilisez la ligne de commande pour la vérification de l'orateur :

python verify.py --model speaker-verification --input your_audio.wav - Vérification du locuteur à l'aide d'un code Python :

from funasr import AutoModel verify_model = AutoModel.from_pretrained("speaker-verification") verify_result = verify_model.verify("your_audio.wav") print(verify_result)

- Utilisez la ligne de commande pour la vérification de l'orateur :

- Reconnaissance vocale multi-talk: :

- Reconnaissance vocale pour les dialogues multijoueurs utilisant la ligne de commande :

python multi_asr.py --model multi-talker-asr --input your_audio.wav - Reconnaissance vocale pour les conversations entre plusieurs personnes à l'aide d'un code Python :

from funasr import AutoModel multi_asr_model = AutoModel.from_pretrained("multi-talker-asr") multi_asr_result = multi_asr_model.recognize("your_audio.wav") print(multi_asr_result)

- Reconnaissance vocale pour les dialogues multijoueurs utilisant la ligne de commande :

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...