FireRedASR : Un modèle Open Source pour la reconnaissance vocale multilingue de haute précision

Introduction générale

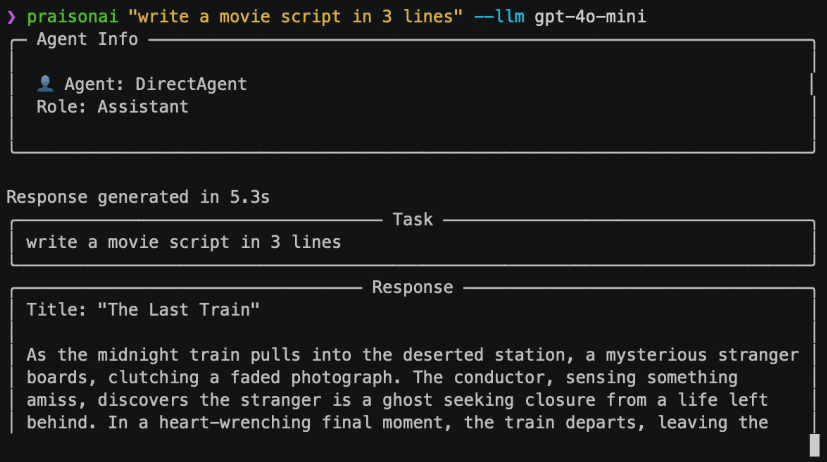

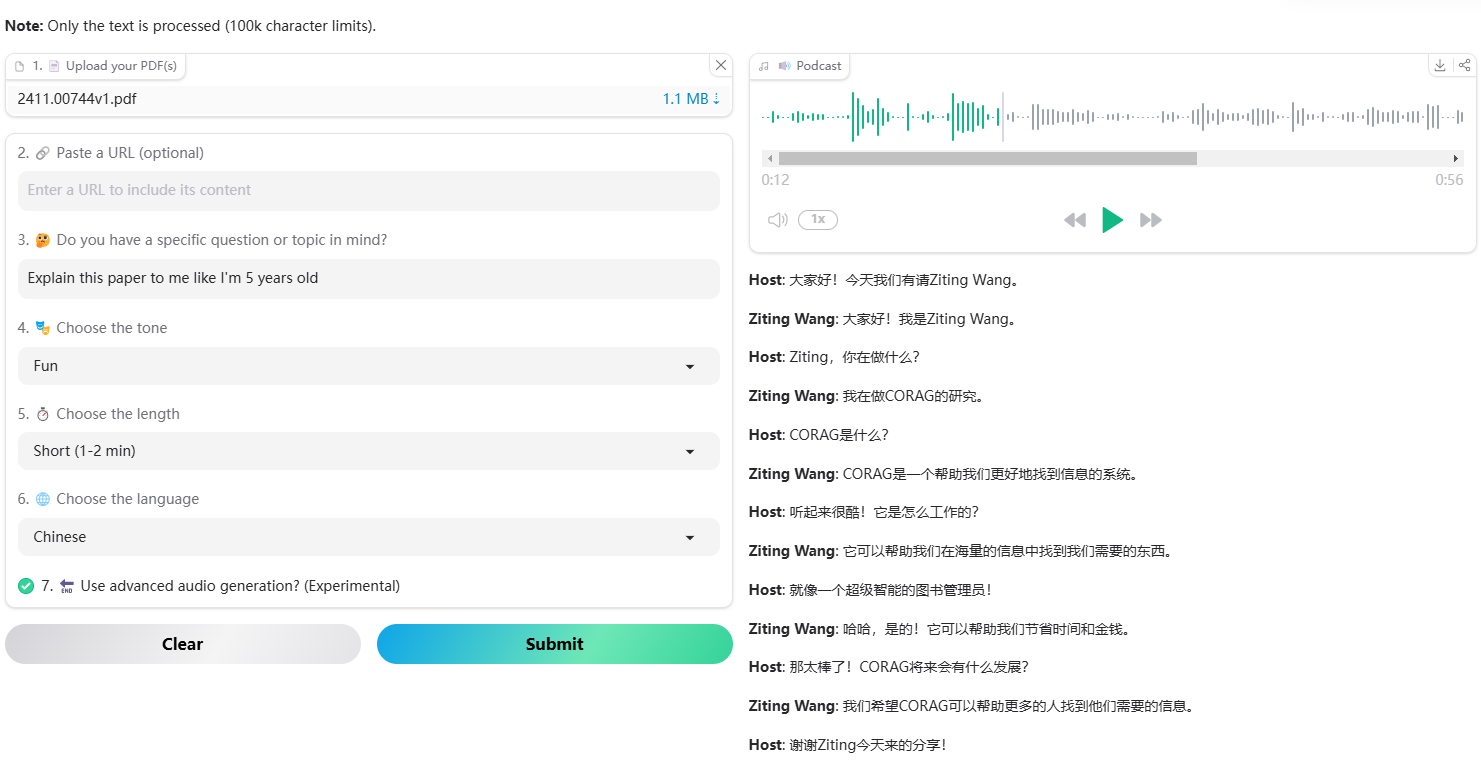

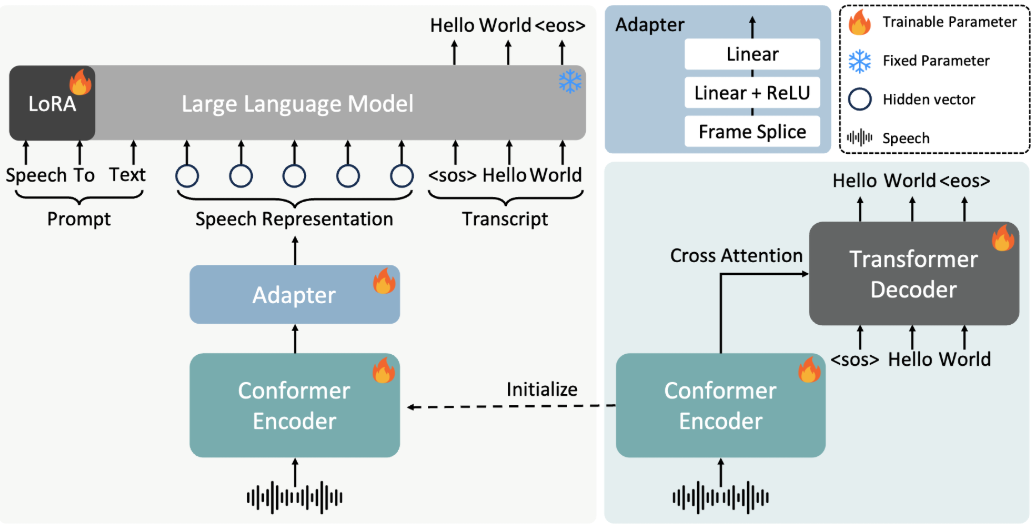

FireRedASR est un modèle de reconnaissance vocale développé par l'équipe du Little Red Book FireRed, dont l'objectif est de fournir un support multilingue de haute précision pour les solutions de reconnaissance vocale automatique (ASR). Hébergé sur GitHub, le projet s'adresse aux développeurs et aux chercheurs et propose un modèle de qualité industrielle qui prend en charge des scénarios tels que la reconnaissance du mandarin, des dialectes chinois, de l'anglais et des paroles.FireRedASR est divisé en deux versions principales : FireRedASR-LLM vise une précision extrême et convient aux besoins professionnels ; FireRedASR-AED équilibre l'efficacité et la performance et convient aux applications en temps réel. En 2025, le modèle a établi le record optimal dans le test du chinois mandarin (CER 3.05%) et a obtenu de bons résultats dans les tests multi-scénarios, ce qui est largement applicable aux assistants intelligents, à la génération de sous-titres vidéo et à d'autres domaines.

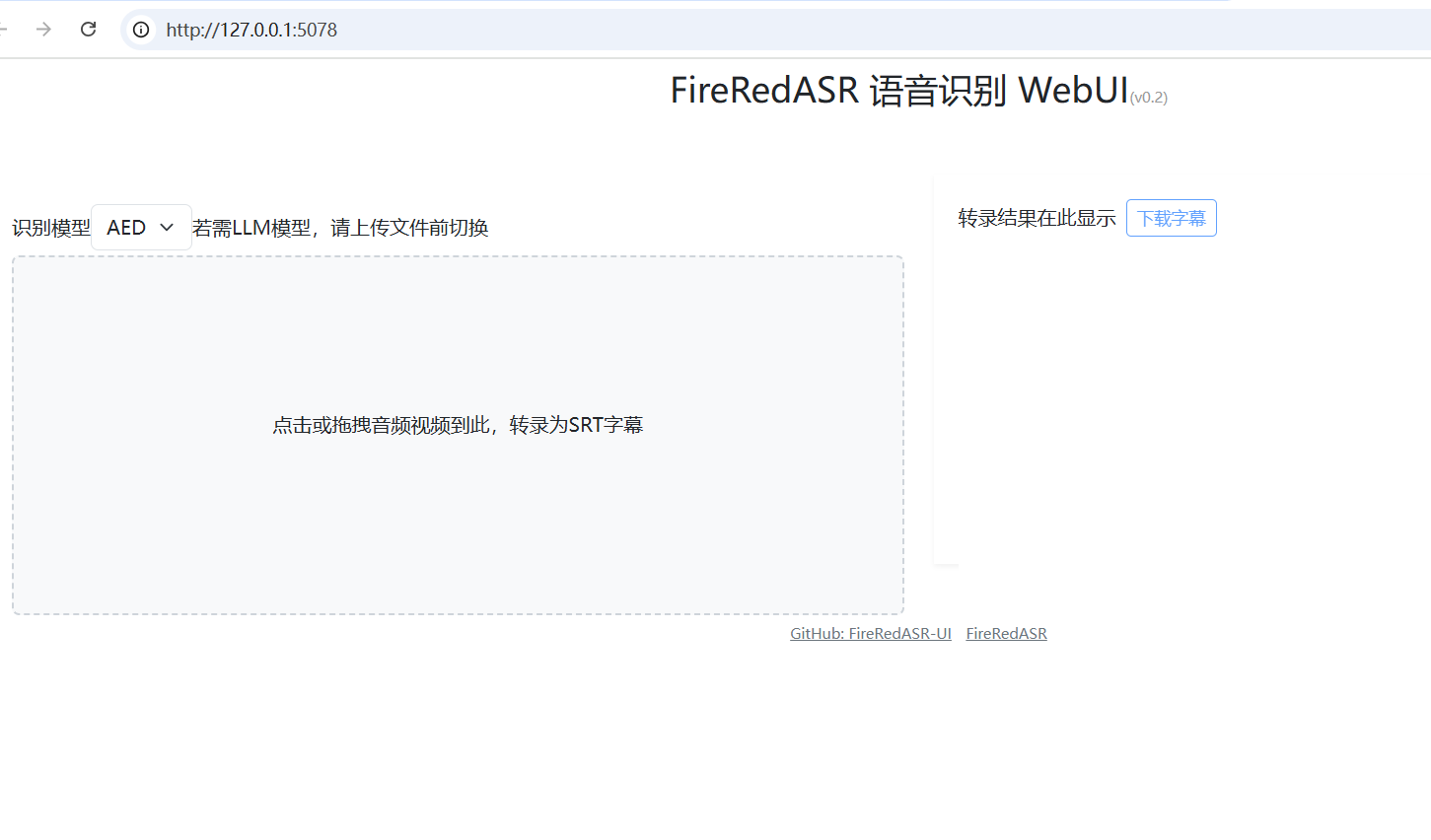

FireRedASR : WebUI one-click installer : https://github.com/jianchang512/fireredasr-ui

Liste des fonctions

- Prend en charge la synthèse vocale en mandarin, en dialectes chinois et en anglais, avec une précision de reconnaissance inégalée dans l'industrie.

- Offre une fonction de reconnaissance des paroles, particulièrement adaptée au traitement des contenus multimédias.

- Deux versions, FireRedASR-LLM et FireRedASR-AED, sont incluses pour satisfaire les besoins d'inférence de haute précision et de haute efficacité, respectivement.

- Des modèles et un code de raisonnement en libre accès pour soutenir le développement secondaire de la communauté et les applications personnalisées.

- Il peut prendre en charge une grande variété de scénarios d'entrée audio, tels que les vidéos courtes, la diffusion en direct, l'entrée vocale, etc.

- Prise en charge du traitement audio par lots, adapté aux tâches de transcription de données à grande échelle.

Utiliser l'aide

Processus d'installation

FireRedASR nécessite certaines configurations de l'environnement de développement pour fonctionner, voici les étapes détaillées de l'installation :

1.Clonage de l'entrepôt de projets

Ouvrez un terminal et entrez la commande suivante pour cloner le projet FireRedASR localement :

git clone https://github.com/FireRedTeam/FireRedASR.git

Lorsque vous avez terminé, accédez au catalogue de projets :

cd FireRedASR

- Création d'un environnement Python

Il est recommandé de créer un environnement Python distinct à l'aide de Conda afin de garantir l'isolation des dépendances. Exécutez la commande suivante :

conda create --name fireredasr python=3.10

Activer l'environnement :

conda activate fireredasr

- Installation des dépendances

Le projet prévoit unerequirements.txtcontenant toutes les dépendances nécessaires. La commande d'installation est la suivante :

pip install -r requirements.txt

Attendez que l'installation soit terminée, assurez-vous que le réseau est fluide, vous pouvez avoir besoin d'un outil Internet scientifique pour accélérer le téléchargement.

- Télécharger le modèle pré-entraîné

- Rouge feuASR-AED-L: Téléchargez le modèle pré-entraîné directement depuis GitHub ou Hugging Face, mettez-le dans le fichier

pretrained_models/FireRedASR-AED-LDossier. - Rouge feuASR-LLM-LLe modèle Qwen2-7B-Instruct doit également être téléchargé dans la base de données du site Web de la Commission européenne.

pretrained_modelset dans le dossierFireRedASR-LLM-Lpour créer des liaisons douces :

ln -s ../Qwen2-7B-Instruct

- Vérifier l'installation

Exécutez la commande suivante pour vérifier si l'installation a réussi :

python speech2text.py --help

Si un message d'aide s'affiche, l'environnement est correctement configuré.

Comment l'utiliser

FireRedASR offre deux façons d'utiliser la ligne de commande et l'API Python. Voici une description détaillée des principales fonctions du processus d'exploitation.

opération en ligne de commande

- Transcription d'un seul fichier (modèle AED)

Utilisez le FireRedASR-AED-L pour traiter des fichiers audio (jusqu'à 60 secondes) :

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "aed" --model_dir pretrained_models/FireRedASR-AED-L

--wav_path: Spécifie le chemin d'accès au fichier audio.--asr_typeSélectionnez le type de modèle, en l'occurrence "aed".--model_dir: Spécifie le dossier du modèle.

La sortie est affichée dans le terminal, par exemple le contenu d'un texte transcrit.

- Transcription d'un seul fichier (modèle LLM)

Utilisez FireRedASR-LLM-L pour traiter l'audio (jusqu'à 30 secondes) :

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L

La signification du paramètre est la même que ci-dessus, et le résultat est un texte transcrit.

Opérations de l'API Python

- Chargement du modèle et transcription

Appeler le modèle FireRedASR dans un script Python :

from fireredasr.models.fireredasr import FireRedAsr

# 初始化 AED 模型

model = FireRedAsr.from_pretrained("aed", "pretrained_models/FireRedASR-AED-L")

batch_uttid = ["BAC009S0764W0121"]

batch_wav_path = ["examples/wav/BAC009S0764W0121.wav"]

results = model.transcribe(

batch_uttid, batch_wav_path,

{"use_gpu": 1, "beam_size": 3, "nbest": 1, "decode_max_len": 0}

)

print(results)

- de_pretrainedChargement du modèle spécifié : Chargement du modèle spécifié.

- transcrire: Effectue une tâche de transcription et renvoie le résultat sous la forme d'une liste de textes.

- Ajustement des paramètres pour optimiser les résultats

- use_gpu: La valeur 1 permet d'utiliser l'accélération GPU, la valeur 0 permet d'utiliser l'accélération CPU.

- taille_du_faisceau: La largeur du faisceau de recherche, plus elle est grande, plus la précision est grande, mais plus elle prend de temps, valeur par défaut 3.

- meilleur: renvoie le nombre optimal de résultats, par défaut 1.

Fonction en vedette Fonctionnement

- reconnaissance des paroles

Le FireRedASR-LLM excelle dans la reconnaissance des paroles. Introduisez l'audio de la chanson (assurez-vous qu'elle ne dure pas plus de 30 secondes), exécutez :python speech2text.py --wav_path your_song.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L**Sortie sous forme de texte de chanson avec des taux de reconnaissance inégalés dans l'industrie. **

- Prise en charge multilingue

Pour le dialecte ou l'audio anglais, utilisez directement les commandes ou API ci-dessus et le modèle sera adapté automatiquement. Par exemple, traitement de l'audio anglais :model = FireRedAsr.from_pretrained("llm","pretrained_models/FireRedASR-LLM-L") results = model.transcribe(["english_audio"],["path/to/english.wav"],{"use_gpu":1}) print(results)

mise en garde

- Limite de longueur de l'audioLes résultats de l'étude sont les suivants : AED pris en charge jusqu'à 60 secondes, au-delà desquelles des problèmes hallucinatoires peuvent survenir ; LLM pris en charge pendant 30 secondes, avec un comportement extra-long indéfini.

- fichier de lotLes performances de l'appareil ne sont pas affectées par le fait que les longueurs des signaux audio d'entrée sont similaires.

- exigences en matière de matérielIl est recommandé d'utiliser le GPU pour exécuter des modèles de grande taille, car l'unité centrale peut être plus lente.

Grâce aux étapes ci-dessus, les utilisateurs peuvent facilement commencer à utiliser FireRedASR et compléter l'ensemble du processus, de l'installation à l'utilisation, ce qui est applicable à une variété de scénarios de reconnaissance vocale.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...