DragAnything : génération de vidéos basées sur le silicium pour les objets solides dans les images

Introduction générale

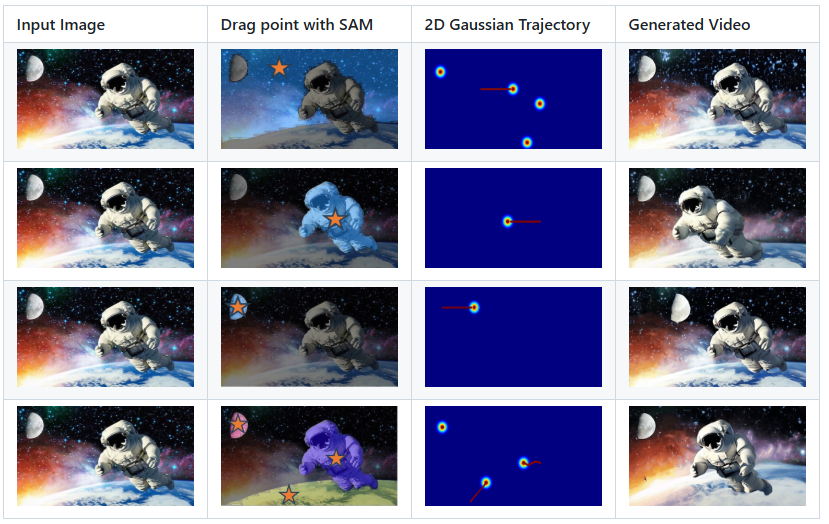

DragAnything est un projet open source qui vise à contrôler le mouvement d'objets arbitraires par le biais de la représentation d'entités. Développé par l'équipe Showlab et accepté par ECCV 2024, DragAnything offre un moyen convivial d'interagir avec des objets en dessinant simplement une ligne de trajectoire pour contrôler leur mouvement. Le projet prend en charge le contrôle simultané du mouvement de plusieurs objets, y compris le mouvement du premier plan, de l'arrière-plan et de la caméra. DragAnything surpasse les méthodes de pointe existantes dans un certain nombre de métriques, en particulier pour le contrôle du mouvement des objets.

Liste des fonctions

- Représentation d'entités : utiliser l'intégration de champs ouverts pour représenter n'importe quel objet.

- Contrôle de la trajectoire : le contrôle du mouvement de l'objet est réalisé en traçant des lignes de trajectoire.

- Contrôle multi-objets : permet de contrôler simultanément les mouvements du premier plan, de l'arrière-plan et de la caméra.

- Démonstrations interactives : prise en charge des démonstrations interactives à l'aide de Gradio.

- Prise en charge des ensembles de données : Prise en charge des ensembles de données VIPSeg et Youtube-VOS.

- Haute performance : excellente dans les études FVD, FID et utilisateur.

Utiliser l'aide

Processus d'installation

- Cloner le code du projet :

git clone https://github.com/showlab/DragAnything.git

cd DragAnything

- Créer et activer un environnement Conda :

conda create -n DragAnything python=3.8

conda activate DragAnything

- Installer la dépendance :

pip install -r requirements.txt

- Préparer le jeu de données :

- Télécharger les ensembles de données VIPSeg et Youtube-VOS sur

./dataCatalogue.

- Télécharger les ensembles de données VIPSeg et Youtube-VOS sur

Utilisation

- Organisez une démonstration interactive :

python gradio_run.py

Ouvrez votre navigateur et visitez l'adresse locale fournie pour démarrer la démo interactive.

- Contrôle le mouvement de l'objet :

- Tracez une ligne de trajectoire sur l'image d'entrée et sélectionnez l'objet que vous souhaitez contrôler.

- Exécutez le script pour générer la vidéo :

python demo.py --input_image <path_to_image> --trajectory <path_to_trajectory>- La vidéo générée sera enregistrée dans le répertoire spécifié.

- Personnaliser la trajectoire du mouvement :

- Utilisez l'outil Co-Track pour traiter vos propres fichiers d'annotation de la piste de mouvement.

- Placez les fichiers traités dans le répertoire spécifié et exécutez le script pour générer la vidéo.

Principales fonctions

- représentation physiqueReprésenter n'importe quel objet grâce à l'incorporation en champ libre, sans que l'utilisateur n'ait besoin d'annoter manuellement l'objet.

- Contrôle de la trajectoireL'utilisateur peut contrôler le mouvement d'un objet en dessinant simplement une ligne de trajectoire sur l'image d'entrée.

- contrôle de plusieurs objetsLa fonction de contrôle des mouvements : permet de contrôler le mouvement de plusieurs objets en même temps, y compris le premier plan, l'arrière-plan et la caméra.

- Présentation interactiveLes effets du contrôle des mouvements : Grâce à l'interface interactive fournie par Gradio, les utilisateurs peuvent visualiser les effets du contrôle des mouvements en temps réel.

- haute performanceExcellente performance dans les études FVD, FID et utilisateur, en particulier dans le contrôle des mouvements d'objets.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...