DeepSeek-VL2 : un modèle expert de langage visuel pour une compréhension multimodale avancée

Introduction générale

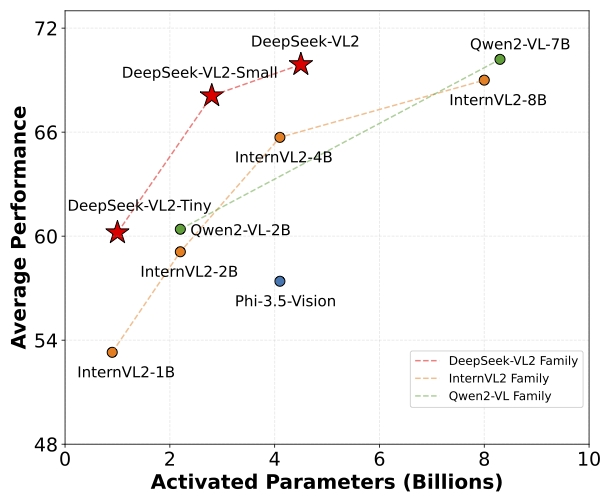

DeepSeek-VL2 est une série de modèles de langage visuel avancés à base de mélanges d'experts (MoE) qui améliorent considérablement les performances de son prédécesseur, DeepSeek-VL. Les modèles excellent dans des tâches telles que la reconnaissance visuelle de questions-réponses, la compréhension de documents/tables/diagrammes et la localisation visuelle. Les modèles excellent dans des tâches telles que la réponse à des questions visuelles, la reconnaissance optique de caractères, la compréhension de documents/tableaux/diagrammes et la localisation visuelle. La famille DeepSeek-VL2 se compose de trois variantes : DeepSeek-VL2-Tiny, DeepSeek-VL2-Small et DeepSeek-VL2, qui ont respectivement 1,0 milliard, 2,8 milliards et 4,5 milliards de paramètres d'activation. paramètres d'activation, respectivement. Les modèles atteignent des performances comparables ou supérieures à celles des modèles denses et MoE à source ouverte existants avec un nombre de paramètres similaire ou inférieur.

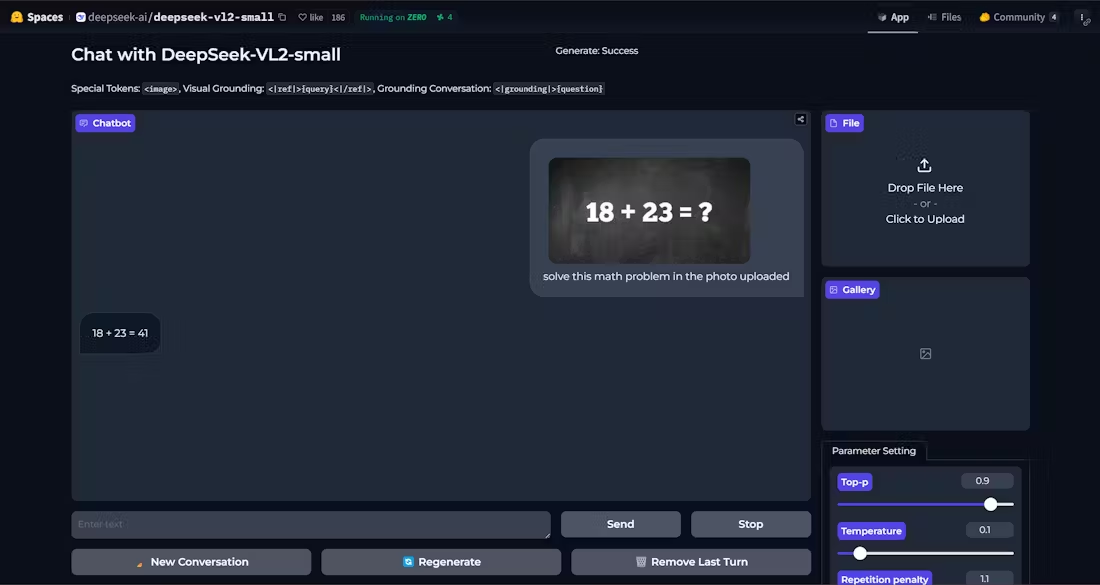

Démonstration : https://huggingface.co/spaces/deepseek-ai/deepseek-vl2-small

Liste des fonctions

- Questions-réponses visuellesLes réponses à des quiz visuels complexes sont précises.

- Reconnaissance optique de caractères (OCR): Reconnaissance efficace du contenu textuel dans les images.

- Compréhension du documentLes tâches sont multiples : analyse et compréhension de la structure et du contenu de documents complexes, analyse et compréhension de la structure et du contenu de documents complexes.

- Compréhension des formesLes données tabulaires : Identifier et traiter les données tabulaires afin d'en extraire des informations utiles.

- Compréhension graphiqueLes résultats de l'analyse des données et des tendances sont présentés sous forme de graphiques et de tableaux.

- l'orientation visuelleLes images de l'appareil photo numérique sont très précises et permettent de localiser avec exactitude l'objet cible dans l'image.

- Support multi-variantLes modèles Tiny, Small et Standard sont disponibles pour répondre à différents besoins.

- Haute performanceLe système d'activation de l'ordinateur : réduit le nombre de paramètres d'activation tout en conservant des performances élevées.

Utiliser l'aide

Processus d'installation

- Assurez-vous que la version de Python est >= 3.8.

- Clonage du dépôt DeepSeek-VL2 :

git clone https://github.com/deepseek-ai/DeepSeek-VL2.git

- Allez dans le répertoire du projet et installez les dépendances nécessaires :

cd DeepSeek-VL2

pip install -e .

exemple d'utilisation

Exemple de raisonnement simple

Vous trouverez ci-dessous un exemple de code pour une inférence simple utilisant DeepSeek-VL2 :

import torch

from transformers import AutoModelForCausalLM

from deepseek_vl2.models import DeepseekVLV2Processor, DeepseekVLV2ForCausalLM

from deepseek_vl2.utils.io import load_pil_images

# 指定模型路径

model_path = "deepseek-ai/deepseek-vl2-tiny"

vl_chat_processor = DeepseekVLV2Processor.from_pretrained(model_path)

vl_model = DeepseekVLV2ForCausalLM.from_pretrained(model_path)

# 加载图像

images = load_pil_images(["path_to_image.jpg"])

# 推理

inputs = vl_chat_processor(images=images, return_tensors="pt")

outputs = vl_model.generate(**inputs)

print(outputs)

Fonction détaillée du déroulement des opérations

- Questions-réponses visuelles: :

- Charger les modèles et les processeurs.

- Saisissez une image et une question et le modèle vous renverra la réponse.

- Reconnaissance optique de caractères (OCR): :

- utiliser

DeepseekVLV2ProcessorCharger l'image. - Le modèle est appelé pour l'inférence afin d'extraire le texte de l'image.

- utiliser

- Compréhension du document: :

- Charge l'entrée contenant l'image du document.

- Le modèle analyse la structure du document et renvoie le résultat de l'analyse.

- Compréhension des formes: :

- Saisir une image contenant le formulaire.

- Le modèle reconnaît la structure et le contenu du formulaire et en extrait les informations clés.

- Compréhension graphique: :

- Charger l'image du graphique.

- Le modèle analyse les données graphiques et fournit une interprétation et une analyse des tendances.

- l'orientation visuelle: :

- Saisissez une description et une image de l'objet cible.

- Le modèle localise l'objet cible dans l'image et renvoie les coordonnées de la position.

Avec les étapes ci-dessus, les utilisateurs peuvent profiter pleinement de la puissance de DeepSeek-VL2 pour accomplir une variété de tâches complexes de langage visuel.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...