DeepSeek-V3/R1 Aperçu des systèmes de raisonnement (DeepSeek Open Source Week Day 6)

Principes de conception des systèmes

L'objectif d'optimisation du service d'inférence DeepSeek-V3/R1 est le suivant :Un débit plus élevé et une latence plus faible.

Afin d'optimiser ces deux objectifs, DeepSeek utilise une solution appelée parallélisme expert (EP) entre nœuds.

- Tout d'abord, EP augmente considérablement la taille des lots, ce qui améliore l'efficacité du calcul matriciel par le GPU et augmente le débit.

- Deuxièmement, EP réduit la latence en répartissant les experts sur plusieurs GPU, chaque GPU ne traitant qu'une petite partie des experts (ce qui réduit les besoins d'accès à la mémoire).

Cependant, l'EP accroît la complexité du système de deux manières principales :

- L'EP introduit la communication entre les nœuds. Afin d'optimiser le débit, des flux de travail informatiques appropriés doivent être conçus pour faire coïncider la communication et le calcul.

- L'EP implique plusieurs nœuds et nécessite donc le parallélisme des données (DP) lui-même et l'équilibrage de la charge entre les différentes instances DP.

Cet article se concentre sur DeepSeek Comment relever ces défis en :

- Utiliser EP pour augmenter la taille du lot.

- dissimuler les délais de communication derrière les calculs, et

- Effectuer l'équilibrage de la charge.

Parallélisme expert à grande échelle entre nœuds (EP)

En raison du grand nombre d'experts dans DeepSeek-V3/R1 (seuls 8 des 256 experts par couche sont activés), la grande dispersion du modèle nécessite une taille de lot totale très importante. Cela garantit une taille de lot suffisante par expert, ce qui se traduit par un débit plus élevé et une latence plus faible. L'EP à grande échelle entre nœuds est crucial.

Comme DeepSeek utilise une architecture de séparation pré-population-décodage, différents niveaux de parallélisme sont utilisés dans les phases de pré-population et de décodage :

- Phase de prépeuplement [Routing Expert EP32, MLA/Shared Expert DP32]Chaque unité de déploiement s'étend sur 4 nœuds et dispose de 32 experts en routage redondants, chaque GPU gérant 9 experts en routage et 1 expert partagé.

- Phase de décodage [Routing Expert EP144, MLA/Sharing Expert DP144]Chaque unité de déploiement s'étend sur 18 nœuds et dispose de 32 experts en routage redondants, chaque GPU gérant 2 experts en routage et 1 expert partagé.

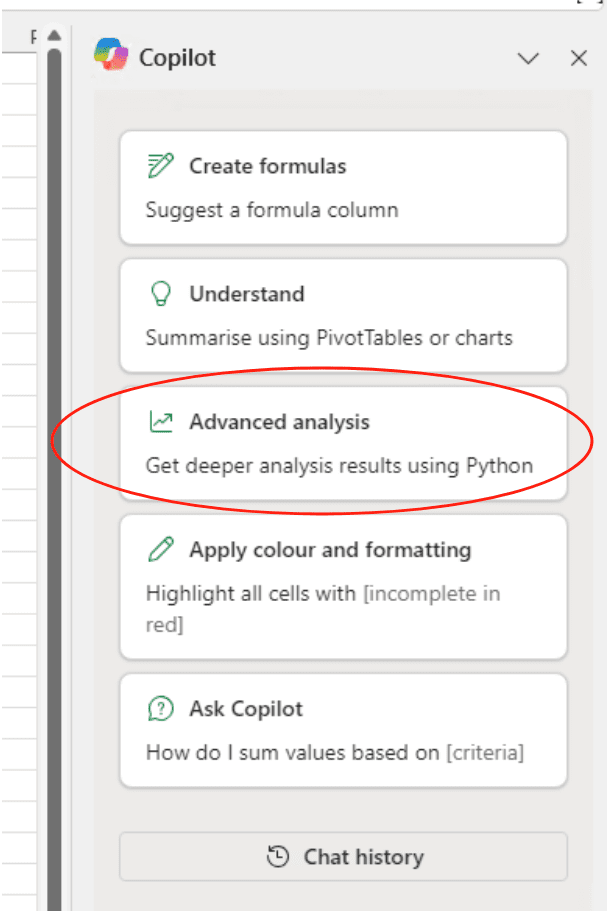

chevauchement informatique-communications

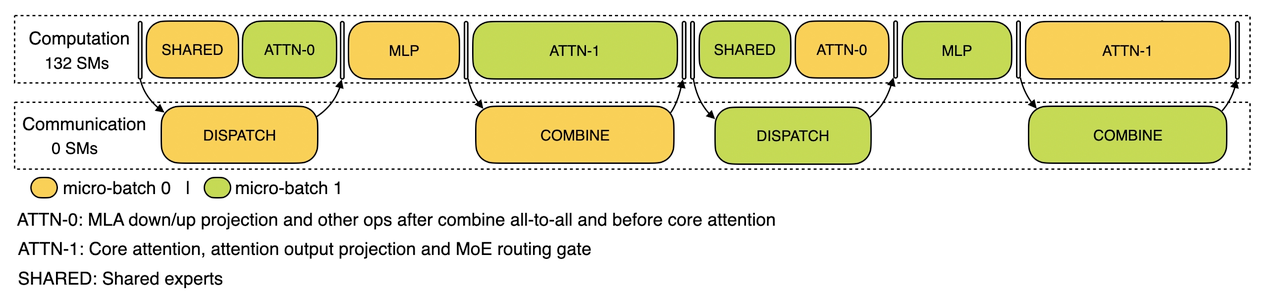

L'EP à grande échelle entre les nœuds introduit un surcoût de communication important. Pour atténuer ce problème, DeepSeek utilise une stratégie de chevauchement de deux lots pour masquer le coût de communication et améliorer le débit global en divisant un lot de demandes en deux micro-lots. Dans la phase de prépeuplement, ces deux micro-lots sont exécutés alternativement, et le coût de communication d'un micro-lot est caché derrière le calcul de l'autre.

Calcul de la phase de prépopulation - chevauchement des communications

Dans la phase de décodage, le temps d'exécution des différentes étapes est inégal. C'est pourquoi DeepSeek subdivise la couche d'attention en deux étapes et utilise un pipeline à cinq phases pour réaliser un chevauchement transparent entre le calcul et la communication.

Chevauchement calcul-communication dans la phase de décodage

Pour plus de détails sur le mécanisme de chevauchement des calculs et des communications de DeepSeek, consultez le site suivant https://github.com/deepseek-ai/profile-data.

Réaliser un équilibrage optimal de la charge

Le parallélisme massif (y compris DP et EP) pose un problème majeur : si un seul GPU est surchargé de calculs ou de communications, il devient un goulot d'étranglement des performances, ralentissant l'ensemble du système alors que les autres GPU sont inactifs. Pour maximiser l'utilisation des ressources, DeepSeek s'efforce d'équilibrer la charge de calcul et de communication entre tous les GPU.

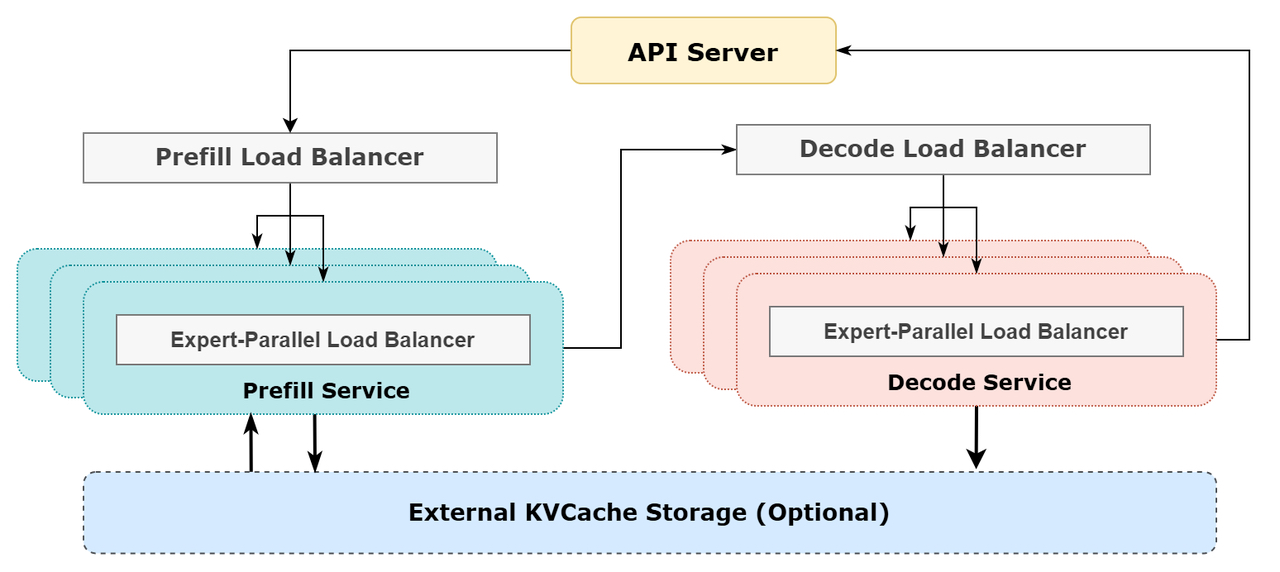

1) Équilibreur de charge prérempli

- Problème majeur : les différences de nombre de demandes et de longueur des séquences entre les instances du PDD entraînent un déséquilibre dans la charge de calcul de l'attention centrale et de l'envoi de l'ordonnancement.

- Objectifs d'optimisation :

- Équilibrer le calcul de l'attention centrale entre les GPU (équilibrage de la charge du calcul de l'attention centrale).

- Egalisation des entrées de chaque GPU Jeton (scheduling send load balancing) afin d'éviter des temps de traitement trop longs sur certains GPU.

2. décoder les répartiteurs de charge

- Problème principal : l'inégalité du nombre de demandes et de la longueur des séquences entre les instances DP entraîne des différences dans le calcul de l'attention centrale (lié à l'utilisation du KVCache) et dans la charge d'envoi de l'ordonnancement.

- Objectifs d'optimisation :

- Équilibrer l'utilisation de KVCache entre les GPU (équilibrage de la charge de Core Attention Computing).

- Équilibrer le nombre de requêtes par GPU (scheduling send load balancing).

3. équilibreur de charge parallèle expert

- Problème majeur : pour un modèle MoE donné, la charge de travail des experts est intrinsèquement élevée, ce qui entraîne un déséquilibre de la charge de calcul des experts entre les différents GPU.

- Objectifs d'optimisation :

- Équilibrer le calcul de l'expert sur chaque GPU (c'est-à-dire minimiser la charge maximale de réception de l'ordonnancement sur tous les GPU).

Schéma du système de raisonnement en ligne DeepSeek

Schéma du système de raisonnement en ligne DeepSeek

Statistiques du service en ligne DeepSeek

Tous les services d'inférence DeepSeek-V3/R1 sont fournis sur les GPU H800 avec une précision conforme à la formation. Plus précisément, la multiplication matricielle et les transferts d'ordonnancement sont au format FP8, conformément à la formation, tandis que les calculs MLA de base et les transferts combinatoires utilisent le format BF16 pour garantir une performance optimale du service.

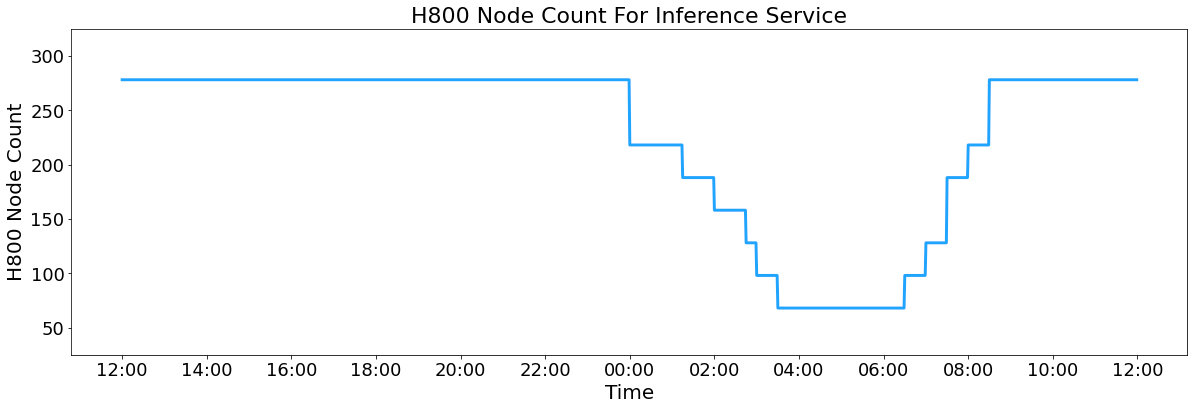

En outre, en raison de la forte charge de service pendant la journée et de la faible charge pendant la nuit, DeepSeek a mis en place un mécanisme pour déployer le service d'inférence sur tous les nœuds pendant les heures de pointe de la journée. Pendant les heures de faible charge la nuit, DeepSeek réduit les nœuds d'inférence et alloue les ressources à la recherche et à la formation. Au cours des dernières 24 heures (de 12h00 UTC+8 le 27 février 2025 à 12h00 UTC+8 le 28 février 2025), l'occupation maximale des nœuds pour les services d'inférence V3 et R1 s'est élevée à 278 nœuds, avec une occupation moyenne de 226,75 nœuds (chacun contenant 8 GPU H800). En supposant un coût de location de 2 $ par heure pour un GPU H800, le coût journalier total est de 87 072 $.

H800 Nombre de nœuds de service d'inférence

V3 et R1 pendant la période statistique de 24 heures (12h00 UTC+8 27 février 2025 à 12h00 UTC+8 28 février 2025) :

- Total des jetons d'entrée : 608B, dont 342B jetons (56.3%) ont atteint le cache KV sur le disque.

- Total des jetons de sortie : 168 B. La vitesse moyenne de sortie est de 20-22 jetons par seconde, et la longueur moyenne du kvcache de chaque jeton de sortie est de 4 989 jetons.

- Chaque nœud H800 fournit en moyenne un débit d'entrée de ~73,7k Token/s (y compris les hits de cache) pendant la pré-population ou un débit de sortie de ~14,8k Token/s pendant le décodage.

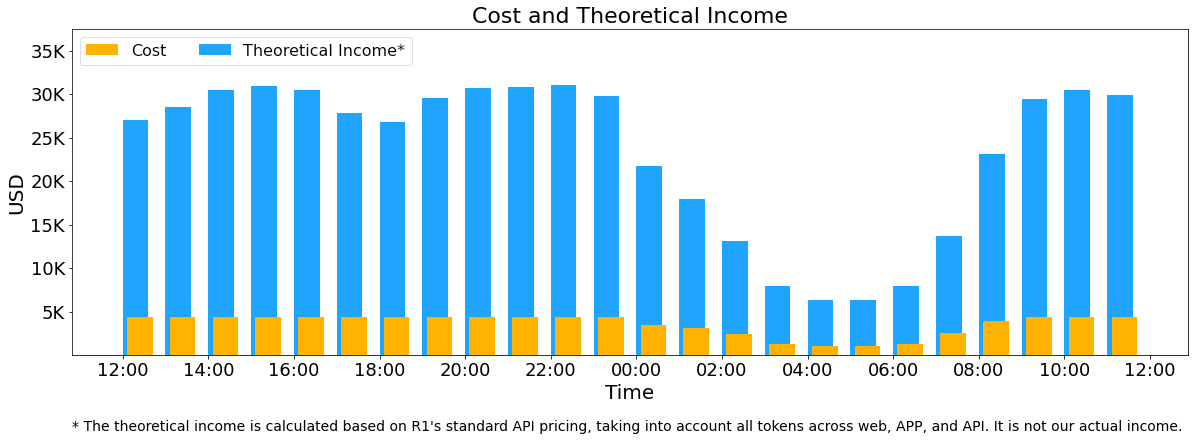

Les statistiques ci-dessus incluent toutes les demandes des utilisateurs à partir du web, de l'application et de l'API. Si tous les jetons sont conformes à la norme Profondeur de l'eau-R1 Le revenu journalier total est de 562 027 $ avec une marge de coût de 545% sur la base de la facturation des prix (*).

() Prix R1 : 0,14 $/M pour le jeton d'entrée (cache hit), 0,55 $/M pour le jeton d'entrée (cache miss), 2,19 $/M pour le jeton de sortie.

Cependant, les revenus réels de DeepSeek sont bien inférieurs pour les raisons suivantes :

- Le prix du DeepSeek-V3 est bien inférieur à celui du R1, du

- Seuls certains services sont payants (l'accès au Web et à l'APP reste gratuit).

- Les réductions nocturnes sont automatiquement appliquées pendant les heures creuses.

Coûts et revenus théoriques

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...