Débat sur DeepSeek : le leadership de la Chine en matière de coûts, les coûts réels de formation et l'impact sur les bénéfices des modèles à source fermée

Mots clés : flambée des prix du h100, prix inférés subventionnés, contrôles à l'exportation, MLAs

Le récit de DeepSeek prend le monde d'assaut

DeepSeek Le monde est pris d'assaut. Depuis une semaine, DeepSeek est le seul sujet dont tout le monde veut parler. Actuellement, DeepSeek a bien plus de trafic quotidien que Claude, Perplexity ou même Gemini.

Mais pour ceux qui suivent le domaine de près, il ne s'agit pas vraiment d'une "nouvelle". Nous parlons de DeepSeek depuis des mois (chaque lien est un exemple). L'entreprise n'est pas nouvelle, mais le battage médiatique l'est, et SemiAnalysis soutient depuis longtemps que DeepSeek est très talentueuse et que le grand public américain s'en moque. Lorsque le monde a finalement prêté attention, il l'a fait dans un battage médiatique frénétique qui ne reflétait pas la réalité.

Nous tenons à souligner que cette déclaration a changé par rapport au mois dernier, lorsque les lois d'échelle ont été brisées et que nous avons dissipé l'idée fausse selon laquelle les algorithmes s'améliorent désormais trop rapidement, ce qui, d'une certaine manière, est également mauvais pour Nvidia et les GPU.

Contexte : 11 décembre 2024 Lois de mise à l'échelle - Architecture O1 Pro, infrastructure de formation à l'inférence, Orion et Claude 3.5 Opus "échecs"

Le discours actuel est que DeepSeek est tellement efficace que nous n'avons pas besoin de plus de calculs et qu'il y a maintenant une énorme surcapacité dans tous les domaines en raison des changements de modèles. Si le paradoxe de Jevons est également surestimé, Jevons est plus proche de la réalité, et ces modèles ont induit une demande qui a eu un impact tangible sur le prix du H100 et du H200.

DeepSeek et High-Flyer

High-Flyer est un fonds spéculatif chinois qui a adopté très tôt l'utilisation de l'IA dans ses algorithmes de négociation. Il a réalisé très tôt le potentiel de l'IA en dehors de la finance et les enseignements clés de la mise à l'échelle. En conséquence, il a augmenté son approvisionnement en GPU. Après avoir expérimenté des modèles utilisant des grappes de milliers de GPU, High Flyer a investi dans 10 000 GPU A100 en 2021 * avant toute restriction à l'exportation. * Cela a porté ses fruits. Au fur et à mesure que High-Flyer s'améliorait, l'entreprise a réalisé qu'il était temps de se séparer de "DeepSeek" en mai 2023, dans le but de développer des capacités d'IA de manière plus ciblée. High-Flyer a autofinancé l'entreprise, car l'IA suscitait peu d'intérêt à l'époque de la part des investisseurs extérieurs, l'absence de modèle d'entreprise étant le principal sujet de préoccupation. Aujourd'hui, High-Flyer et DeepSeek partagent souvent leurs ressources, tant humaines que informatiques.

DeepSeek est aujourd'hui une entreprise sérieuse et collaborative qui est loin d'être la "petite affaire" que de nombreux médias prétendent qu'elle est. Nous pensons que leur investissement dans le GPU dépasse les 500 millions de dollars, même en tenant compte des contrôles à l'exportation.

Source : SemiAnalysis, Lennart Heim.

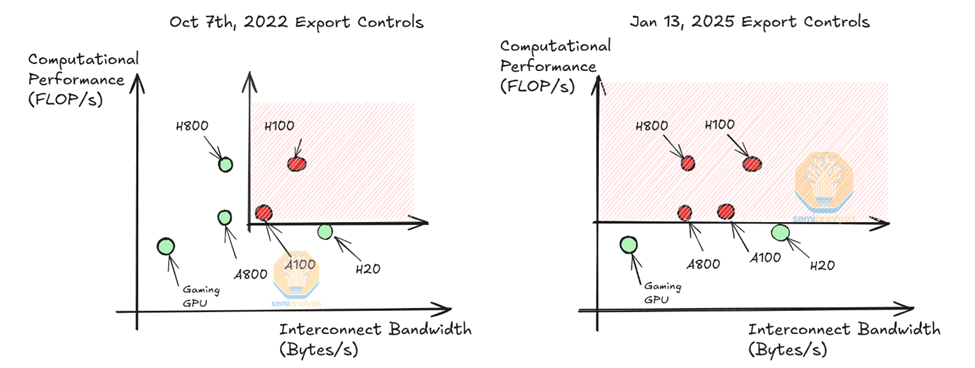

Situation du GPU

Nous pensons qu'ils pourraient en utiliser environ 50 000. Trémie GPUIl ne s'agit pas des 50 000 H100 que certains prétendent. Nvidia fabrique différents modèles de H100 pour se conformer à différentes réglementations (H800, H20) et, actuellement, seul le H20 est disponible pour les fournisseurs de modèles en Chine. Notez que le H800 a la même puissance de calcul que le H100, mais avec une bande passante réseau plus faible.

Nous pensons que DeepSeek pourrait utiliser environ 10 000 H800 et 10 000 H100. En outre, ils ont commandé plus de H20, et Nvidia a produit plus d'un million de GPU spécifiques à la Chine au cours des neuf derniers mois. Ces GPU sont partagés entre High-Flyer et DeepSeek, et sont en quelque sorte géo-distribués. Ils sont utilisés pour le commerce, l'inférence et la formation. Ils sont utilisés pour le commerce, l'inférence, la formation et la recherche. Pour une analyse plus spécifique et détaillée, voir notre modèle d'accélérateur.

Source : SemiAnalysis

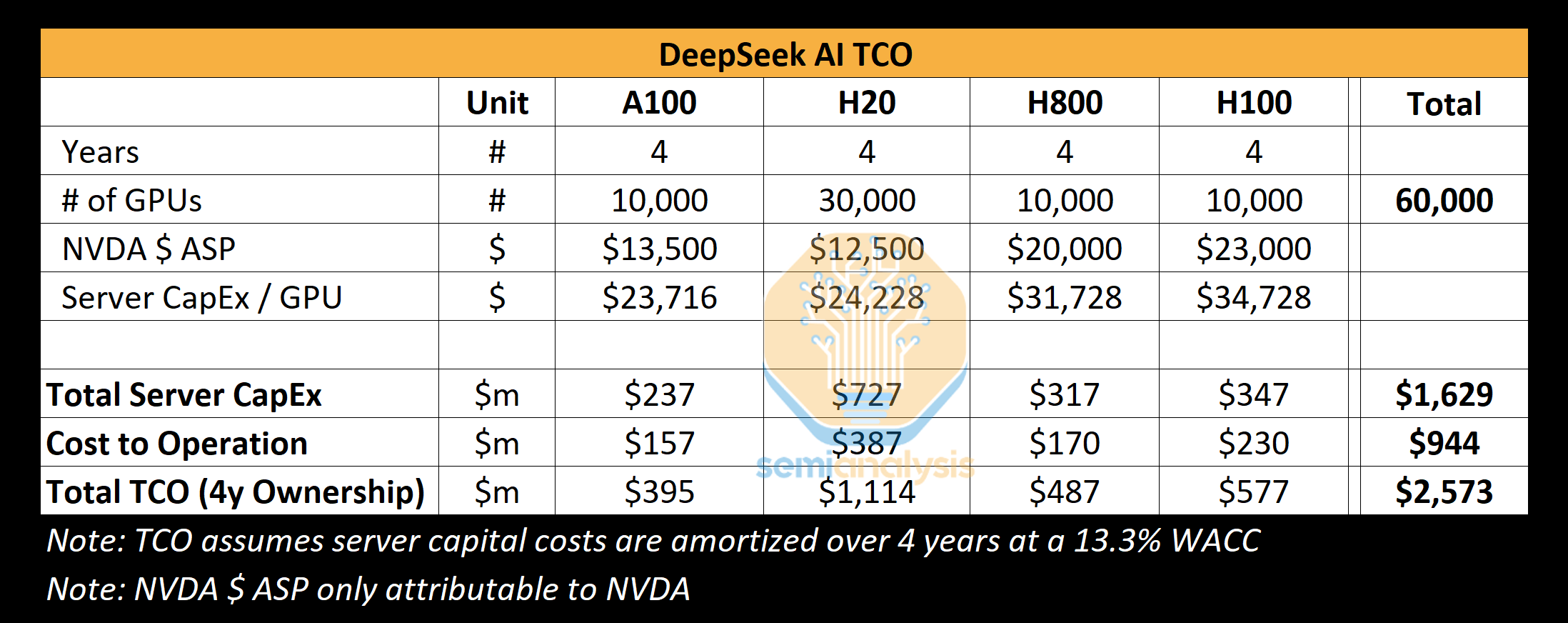

Notre analyse montre que les dépenses totales en serveurs de DeepSeek s'élèvent à environ 1,6 milliard de dollars, les coûts associés à l'exploitation de ces clusters pouvant atteindre 944 millions de dollars. De même, tous les laboratoires d'IA et les hyperscalers disposent de plus de GPU pour diverses tâches, y compris la recherche et la formation, qu'ils n'en utilisent pour une seule formation, car la mise en commun des ressources est un défi. x.AI est un laboratoire d'IA unique en son genre, qui dispose de tous ses GPU en un seul endroit.

DeepSeek se spécialise dans la recherche de talents en Chine, indépendamment de leurs qualifications antérieures, en mettant l'accent sur les compétences et la curiosité, et organise régulièrement des événements de recrutement dans les meilleures universités telles que Peking et Zhejiang, où bon nombre de ses employés ont obtenu leur diplôme. Les postes ne sont pas nécessairement prédéfinis et les recruteurs bénéficient d'une certaine flexibilité, les offres d'emploi se targuant même d'un accès à plus de 10 000 GPU sans limite d'utilisation. L'entreprise est extrêmement compétitive : elle offrirait des salaires supérieurs à 1,3 million de dollars aux candidats prometteurs, soit bien plus que les grandes entreprises technologiques chinoises et les laboratoires d'IA tels que Moonshot. Elle compte environ 150 employés, mais se développe rapidement.

L'histoire a montré qu'une petite startup bien financée et ciblée peut souvent repousser les limites du possible. deepSeek n'a pas la bureaucratie d'un Google et, parce qu'elle est autofinancée, elle peut faire avancer les idées rapidement. Toutefois, à l'instar de Google, DeepSeek gère (pour l'essentiel) son propre centre de données et ne dépend pas de parties ou de fournisseurs externes. Cela laisse plus de place à l'expérimentation et permet à l'entreprise d'innover sur l'ensemble de la pile de données.

Nous pensons qu'il s'agit du meilleur laboratoire "open weights" actuel, devançant Meta's Llama, Mistral et d'autres.

Coût et performance de DeepSeek

Les prix et l'efficacité de DeepSeek ont suscité une frénésie cette semaine, le principal titre étant le coût de formation de DeepSeek V3, qui s'élève à "6 millions de dollars". Cette affirmation est erronée. Cela revient à pointer du doigt une partie spécifique de la nomenclature d'un produit et à l'attribuer à l'ensemble du coût. Les coûts de préformation ne représentent qu'une infime partie du coût total.

Coûts de formation

Nous pensons que les chiffres de pré-entraînement sont très éloignés des dépenses réelles consacrées au modèle. Nous pensons que l'entreprise a dépensé bien plus que 500 millions de dollars en matériel au cours de son histoire. Afin de développer de nouvelles innovations architecturales, des dépenses considérables sont consacrées au test de nouvelles idées, de nouvelles idées architecturales et à l'ablation pendant le développement du modèle. L'attention latente à plusieurs têtes, une innovation clé de DeepSeek, a pris des mois à développer et a coûté à toute l'équipe de la main d'œuvre et du temps de GPU.

Le coût de 6 millions de dollars mentionné dans l'article n'est imputable qu'au coût du GPU pour les cycles de pré-entraînement, qui ne représente qu'une fraction du coût total du modèle. Il n'inclut pas des éléments importants du puzzle, tels que la R&D et le coût total de possession du matériel lui-même. Pour référence, Claude 3.5 Sonnet a coûté des dizaines de millions de dollars pour s'entraîner, et si c'était tout ce dont Anthropic avait besoin, l'entreprise ne récolterait pas des milliards de dollars auprès de Google et des dizaines de milliards de dollars auprès d'Amazon. En effet, l'entreprise doit expérimenter, proposer de nouvelles architectures, collecter et nettoyer les données, payer ses employés, etc.

Comment DeepSeek peut-il donc disposer d'une grappe aussi importante ? Le retard dans les contrôles des exportations est essentiel et sera abordé dans la section sur les exportations ci-dessous.

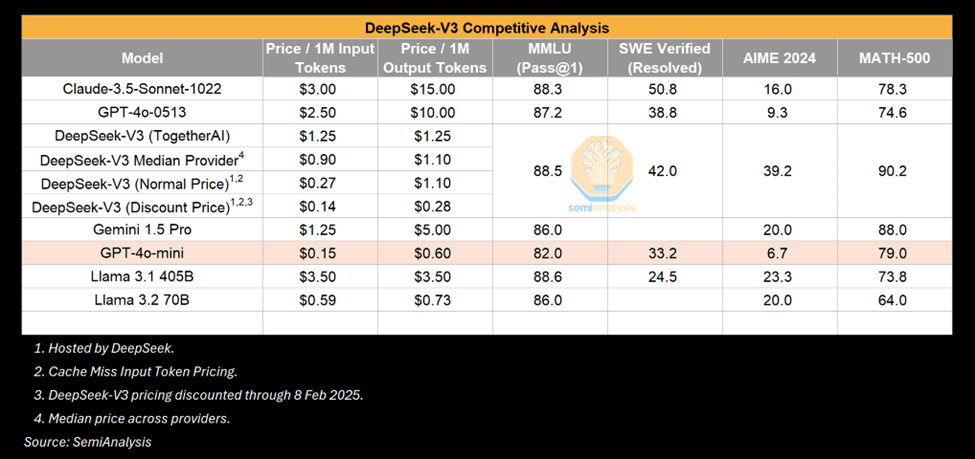

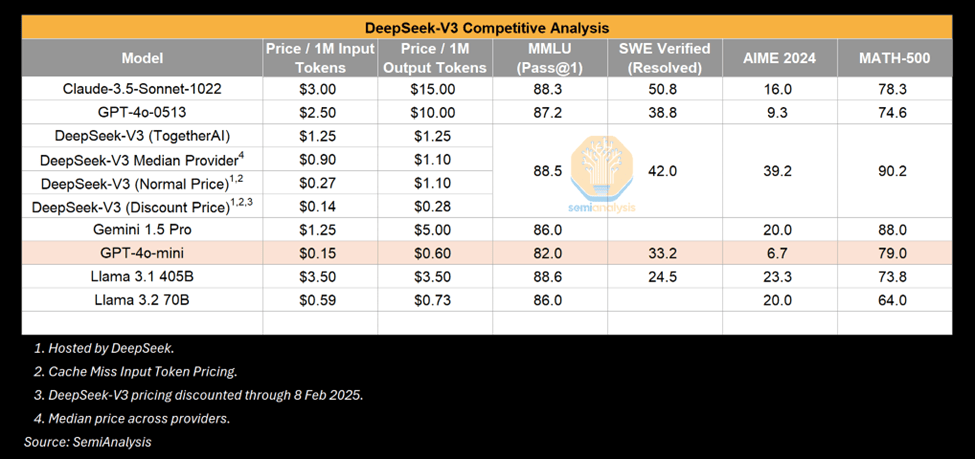

Combler le fossé - V3 Performance

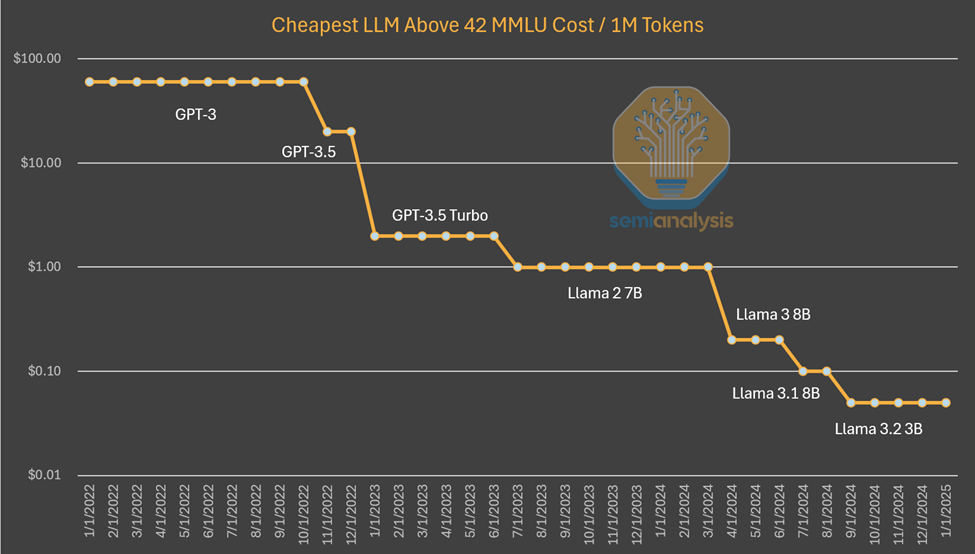

Le V3 est sans aucun doute un modèle impressionnant, mais il convient de souligner que Par opposition à ce qui est impressionnant.. Nombreux sont ceux qui ont comparé le V3 au GPT-4o et ont souligné que le V3 surpassait les performances du 4o. C'est vrai, mais le GPT-4o est sur la liste des produits les plus performants. mai 2024L'IA libérée évolue rapidement et mai 2024 est une nouvelle ère en termes d'améliorations algorithmiques. D'ailleurs, nous ne sommes pas surpris de voir une puissance comparable ou supérieure atteinte avec moins de calculs au bout d'un temps donné. L'effondrement des coûts d'inférence est un signe d'amélioration de l'IA.

Source : SemiAnalysis

Par exemple, les petits modèles qui peuvent être exécutés sur des ordinateurs portables ont des performances comparables à celles de GPT-3, qui nécessite un superordinateur pour la formation et plusieurs GPU pour l'inférence. En d'autres termes, les améliorations algorithmiques permettent de réduire le nombre de calculs pour former et raisonner sur des modèles ayant les mêmes capacités, et ce schéma fonctionne encore et encore. Cette fois-ci, le monde l'a remarqué parce qu'il provenait de l'Institut de recherche en sciences naturelles et en génie de l'Union européenne. sino d'un laboratoire. Mais l'amélioration des petits modèles n'est pas une nouveauté.

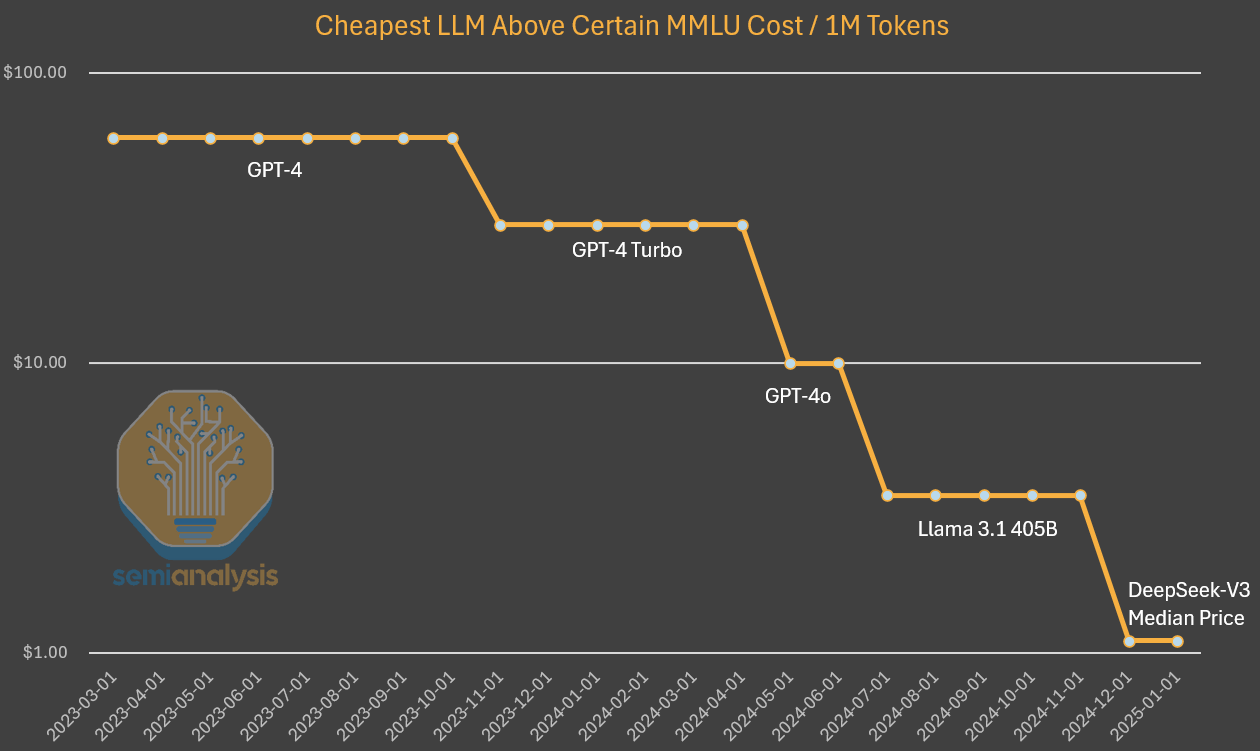

Sources : SemiAnalysis, Artificialanalysis.ai, Anakin.ai, a16z

La tendance observée jusqu'à présent est que les laboratoires d'IA dépensent plus d'argent en valeur absolue pour obtenir des résultats. plus L'intelligence d'Anthropic. Le progrès algorithmique est estimé à 4 fois par an, ce qui signifie que chaque année qui passe nécessite 4 fois moins de calculs pour atteindre la même capacité. Dario, le PDG d'Anthropic, pense que le progrès algorithmique est encore plus rapide, avec une amélioration de 10 fois. Dans le cas de la tarification de l'inférence de qualité GPT-3, le coût a été divisé par 1200.

Lorsque l'on étudie les coûts du GPT-4, on constate une diminution similaire des coûts, mais plus tôt dans la courbe. La diminution de la différence de coût au fil du temps peut s'expliquer par le fait que la capacité n'est plus maintenue constante comme dans le graphique ci-dessus. Dans ce cas, nous constatons que les améliorations et optimisations algorithmiques ont permis de diviser les coûts par 10 et d'augmenter la capacité par 10.

Sources : SemiAnalysis, OpenAI, Ensemble.ai

Pour être clair, DeepSeek est unique en ce qu'il a atteint ce niveau de coût et de capacité en premier lieu. Il est unique en ce qu'il publie des poids ouverts, mais les précédents projets de Mistral DeepSeek a atteint ce niveau de coût, mais ne soyez pas surpris si le coût diminue encore de 5 fois d'ici la fin de l'année.

Les performances de R1 sont-elles comparables à celles de o1 ?

En revanche, R1 a pu obtenir des résultats comparables à o1, qui n'a été annoncé qu'en septembre. comment DeepSeek a-t-il pu rattraper son retard si rapidement ?

La réponse est que l'inférence est un nouveau paradigme avec des itérations plus rapides et des objectifs plus faciles à atteindre, où une petite quantité de calcul peut produire des gains significatifs par rapport aux paradigmes précédents. Comme décrit dans notre rapport "Scaling Laws", les paradigmes précédents reposaient sur le pré-entraînement, qui devient de plus en plus coûteux et difficile à réaliser pour obtenir des gains solides.

Le nouveau paradigme se concentre sur les capacités d'inférence grâce à la génération de données synthétiques et à l'apprentissage par renforcement en post-entraînement sur les modèles existants, ce qui permet d'obtenir des gains plus rapides à un prix plus bas. La faible barrière à l'entrée associée à des optimisations simples signifie que DeepSeek est capable de reproduire l'approche o1 plus rapidement que d'habitude. Au fur et à mesure que les participants trouveront le moyen de s'adapter à ce nouveau paradigme, nous nous attendons à ce que l'écart entre les capacités d'appariement s'accroisse.

Veuillez noter que le document R1 Non mentionné de calculs utilisés. Ce n'est pas un hasard - il faut beaucoup de calculs pour générer les données synthétiques utilisées pour le post-entraînement de R1. Cela n'inclut pas l'apprentissage par renforcement. r1 est un très bon modèle, nous ne le contestons pas, et rattraper l'avantage de l'inférence aussi rapidement est objectivement impressionnant. le fait que DeepSeek soit chinois et qu'il ait rattrapé son retard avec moins de ressources rend la chose encore plus impressionnante.

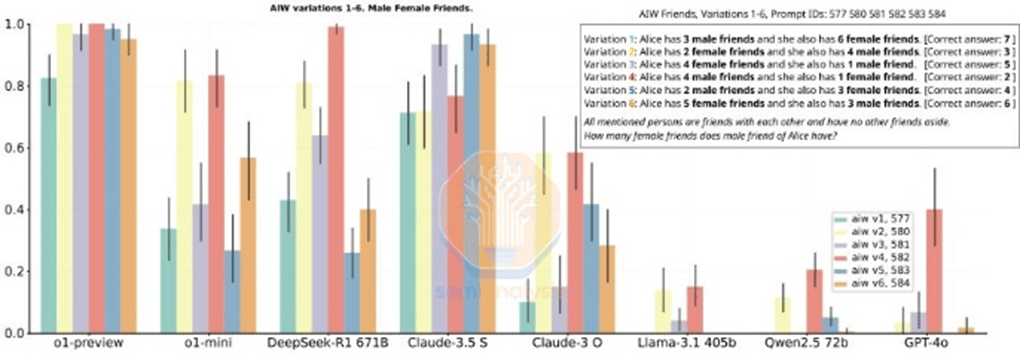

Mais certains des critères de référence mentionnés par R1 sont également trompeur. Comparer R1 à o1 est délicat car R1 ne mentionne pas spécifiquement les benchmarks où il n'est pas en tête. Bien que R1 soit à la hauteur en termes de performance d'inférence, il n'est pas un vainqueur clair dans chaque mesure, et dans de nombreux cas, il est moins bon que o1.

Source : (Encore) une autre histoire d'ascension et de chute. DeepSeek R1

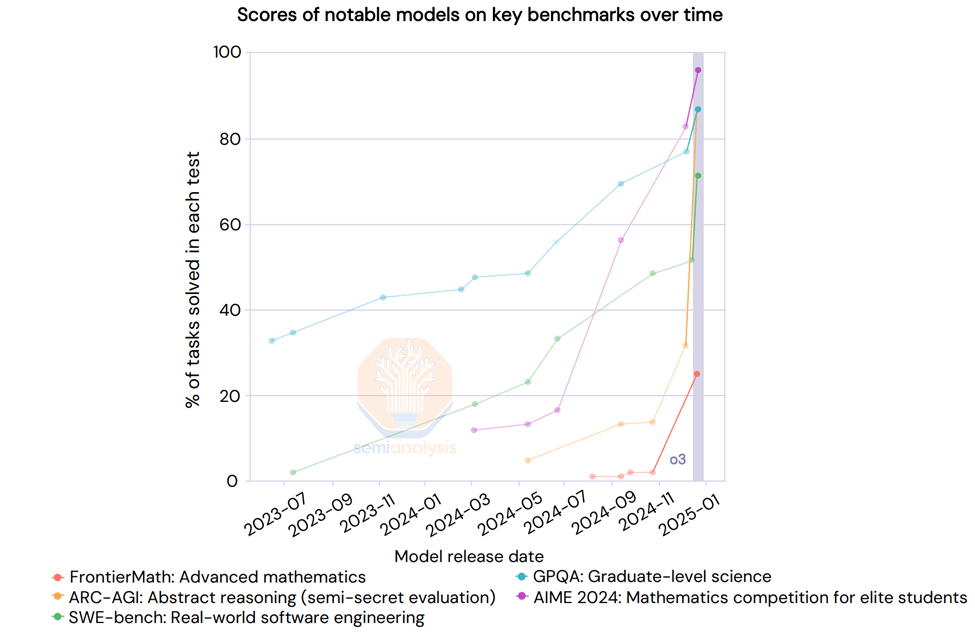

Nous n'avons pas encore mentionné o3. o3 est nettement plus performant que R1 ou o1. en fait, OpenAI a récemment partagé des résultats pour o3 où le benchmark Scaling était vertical. "L'apprentissage profond est au pied du mur, mais d'une manière différente.

Source : Sommet d'action sur l'IA

Le modèle d'inférence de Google est aussi bon que R1

Alors que R1 a fait l'objet d'un battage médiatique frénétique, une entreprise américaine pesant 2,5 billions de dollars a publié il y a un mois un modèle d'inférence moins coûteux : le modèle de Google. Gémeaux Flash 2.0 Pensée. le modèle est disponible et accessible via l'API Beaucoup moins cher que le R1.même si la longueur du contexte du modèle est plus importante.

Flash 2.0 Thinking bat le R1 dans les benchmarks rapportés, bien que les benchmarks ne disent pas tout. Google n'a publié que 3 benchmarks, c'est donc une image incomplète. Néanmoins, nous pensons que le modèle de Google est robuste et peut rivaliser avec le R1 à bien des égards, mais qu'il ne fait pas l'objet d'un battage médiatique. Cela pourrait être dû à l'absence de stratégie d'entrée sur le marché de Google et à une expérience utilisateur médiocre, mais le R1 a également été une surprise en Chine.

Source : SemiAnalysis

Pour être clair, rien de tout cela ne diminue l'excellence de DeepSeek, dont la structure en tant que startup à croissance rapide, bien financée, intelligente et ciblée est telle qu'elle surpasse les chances en termes de publication de modèles d'inférence Méta et d'autres géants pour une raison louable.

Réalisations techniques

DeepSeek a déchiffré le code et débloqué des innovations qui n'ont pas encore été réalisées par les principaux laboratoires. Nous nous attendons à ce que toutes les améliorations publiées par DeepSeek soient reproduites par les laboratoires occidentaux presque immédiatement.

Quelles sont ces améliorations ? La plupart des réalisations architecturales sont spécifiquement liées à la V3, qui est également le modèle de base de la R1. Décrivons ces innovations plus en détail.

Formation (avant et après la formation)

DeepSeek V3 tire parti de l'échelle sans précédent des systèmes d'information multiples. Jeton Les modules d'attention ajoutée qui prédisent les quelques jetons suivants au lieu d'un seul jeton améliorent les performances du modèle pendant l'apprentissage et peuvent être supprimés pendant l'inférence. Il s'agit d'un exemple d'innovation algorithmique qui permet d'améliorer les performances tout en réduisant l'effort de calcul.

Il existe d'autres réserves, telles que la précision du FP8 dans la formation, mais les principaux laboratoires américains assurent la formation au FP8 depuis un certain temps.

DeepSeek v3 est également un modèle expert hybride, c'est-à-dire un grand modèle composé de nombreux autres experts plus petits qui se spécialisent dans des domaines différents, une sorte de comportement émergent. L'un des défis auxquels est confronté le modèle MoE est de savoir comment déterminer quel jeton va à quel sous-modèle ou "expert". DeepSeek met en œuvre un "réseau à portes" qui achemine les jetons vers l'expert approprié de manière équilibrée sans affecter les performances du modèle. Cela signifie que le routage est très efficace et que chaque jeton ne modifie que quelques paramètres pendant la formation par rapport à la taille globale du modèle. Cela augmente l'efficacité de la formation et réduit les coûts d'inférence.

Malgré les craintes que les gains d'efficacité des experts hybrides (MoE) ne réduisent l'investissement, Dario souligne que les économies réalisées grâce à des modèles d'IA plus puissants sont si importantes qu'elles sont rapidement réinvesties dans la construction de modèles plus vastes. Ces entreprises se concentrent sur la mise à l'échelle des modèles pour un plus grand nombre de calculs et pour les rendre plus efficaces grâce aux algorithmes.

Dans le cas de R1, il a bénéficié d'un modèle de base solide (v3), en partie grâce à l'apprentissage par renforcement (AR). Cela est dû en partie à l'apprentissage par renforcement (AR), qui a deux objectifs principaux : la mise en forme (pour s'assurer qu'il fournit un résultat cohérent) et l'utilité et l'innocuité (pour s'assurer que le modèle est utile). Le pouvoir de raisonnement émerge sur un ensemble de données synthétiques pendant la mise au point du modèle. Ceci.Comme décrit dans notre article sur les lois de mise à l'échelleC'est ce qui s'est passé avec o1. Notez qu'il n'y a aucune mention de calcul dans l'article R1, parce que le fait de mentionner la quantité de calcul utilisée indiquerait qu'ils avaient plus de GPU que leur récit ne le laisse supposer. Le RL à cette échelle nécessite beaucoup de calculs, en particulier pour générer des données synthétiques.

En outre, certaines des données utilisées par DeepSeek semblent provenir des modèles d'OpenAI, ce qui, selon nous, aura un impact sur la stratégie d'extraction des résultats. Cela est déjà illégal dans les CGU, mais à l'avenir, une nouvelle tendance pourrait être une forme de KYC (Know Your Customer) pour bloquer les extractions.

En parlant d'extraction, la partie la plus intéressante du document R1 est peut-être la possibilité d'affiner les mini-modèles de non-inférence en utilisant les sorties des modèles d'inférence pour les transformer en modèles d'inférence. La gestion de l'ensemble de données contient un total de 800 000 échantillons, et tout le monde peut désormais créer ses propres ensembles de données en utilisant les sorties CoT de R1 et créer des modèles d'inférence à l'aide de ces sorties. Il est probable qu'un plus grand nombre de petits modèles démontrent des capacités d'inférence, améliorant ainsi la performance des petits modèles.

Attention à plusieurs niveaux (MLA)

MLA est une innovation clé qui a conduit à une réduction significative du prix de l'inférence de DeepSeek. En effet, par rapport à l'attention standard, MLA réduit la quantité de mise en cache KV requise par requête d'environ 93.3%Le cache KV est Transformateur Un mécanisme de mémoire dans le modèle pour stocker les données qui représentent le contexte d'un dialogue, réduisant ainsi les calculs inutiles.

Comme nous l'avons expliqué dans notre article sur les lois d'échelonnement, le cache KV s'accroît à mesure que le contexte de dialogue se développe et crée une limite de mémoire considérable. Une réduction significative de la quantité de cache KV requise par requête permettrait de réduire la quantité de matériel requise par requête, et donc de réduire les coûts. Cependant, nous pensons que DeepSeek propose l'inférence au prix coûtant pour gagner des parts de marché sans réellement gagner d'argent. google Gemini Flash 2 Thinking est toujours moins cher et il est peu probable que Google le propose au prix coûtant. le MLA en particulier a attiré l'attention de nombreux laboratoires américains de premier plan. le MLA est en mai 2024. L'AML est intégré à DeepSeek V2, dont la sortie est prévue en mai 2024. DeepSeek bénéficie également d'une plus grande efficacité de la charge de travail d'inférence avec le H20 par rapport au H100 en raison de la bande passante et de la capacité de mémoire plus élevées du H20. La société a également annoncé un partenariat avec Huawei, mais jusqu'à présent, il y a eu très peu de travail sur l'informatique Ascend.

Les implications que nous trouvons les plus intéressantes sont en particulier l'impact sur les marges et ce que cela signifie pour l'écosystème dans son ensemble. Nous examinons ci-dessous la future structure des prix dans le secteur de l'IA et expliquons en détail pourquoi nous pensons que DeepSeek subventionne les prix et pourquoi nous voyons les premiers signes de l'entrée en jeu du paradoxe de Jevons. Nous commentons les implications pour les contrôles à l'exportation, la façon dont les contreparties centrales pourraient réagir à mesure que la domination de DeepSeek s'accroît, et plus encore.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...