DeepSeek a publié la première version open source de son modèle v3, désormais doté de la capacité de codage la plus forte (en Chine).

DeepSeek-V3 est un puissant modèle linguistique de mélange d'experts (MoE) avec 671 milliards de paramètres totaux et 3,7 milliards de paramètres activés pour chaque token. Le modèle utilise une architecture innovante Multi-head Latent Attention (MLA) ainsi que l'architecture éprouvée DeepSeekMoE. CogAgent met en œuvre une stratégie d'équilibrage de charge sans perte auxiliaire et propose un objectif d'entraînement de prédiction multi-token pour améliorer de manière significative la performance du modèle. Il est pré-entraîné sur 14,8 millions de tokens divers et de haute qualité et subit des phases de réglage fin supervisé et d'apprentissage par renforcement afin d'exploiter tout son potentiel.

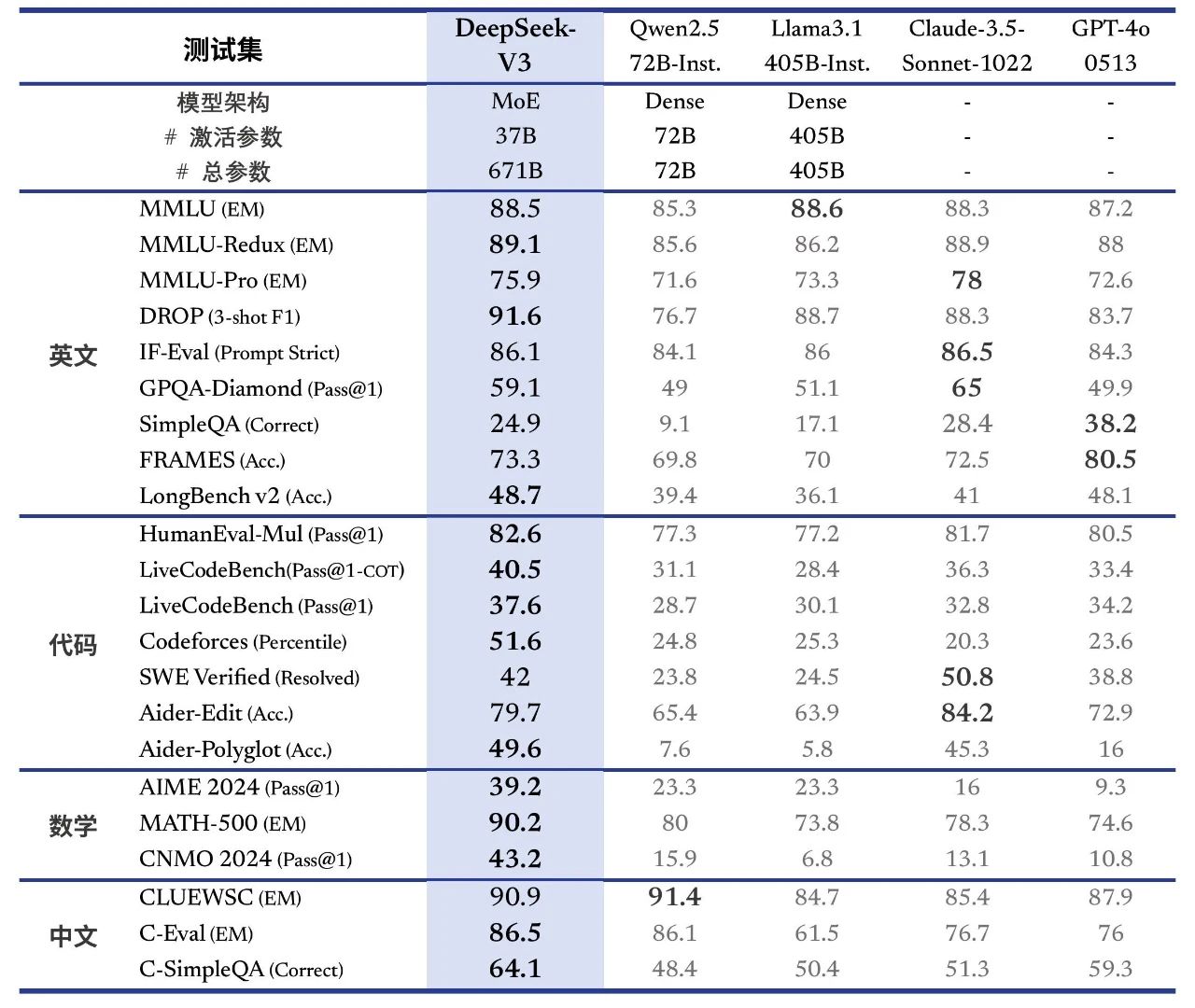

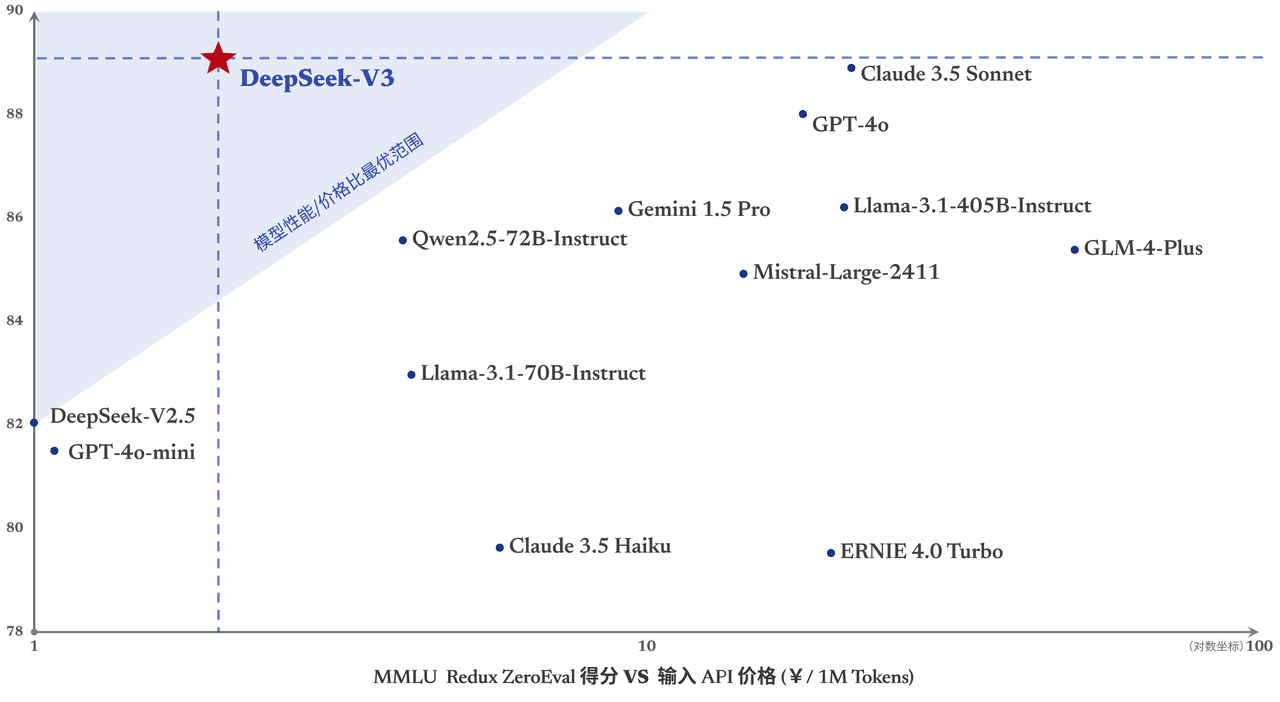

DeepSeek-V3 obtient de bons résultats dans de nombreux benchmarks standard, en particulier pour les tâches mathématiques et de codage, ce qui en fait le modèle de base open-source le plus solide actuellement disponible, avec des coûts de formation faibles, et sa stabilité tout au long de la formation est hautement reconnue.

Hier, la première version de la nouvelle série de modèles DeepSeek, DeepSeek-V3, a été publiée et mise en libre accès en même temps. Vous pouvez discuter avec la dernière version du modèle V3 en vous connectant à chat.deepseek.com. Le service API a été mis à jour simultanément, il n'est donc pas nécessaire de modifier la configuration de l'interface. La version actuelle de DeepSeek-V3 ne prend pas en charge les entrées et sorties multimodales.

Alignement des performances Leader d'outre-mer Modèles à source fermée

DeepSeek-V3 est un modèle MoE maison avec 671B paramètres et 37B activations à 14,8T. jeton Une formation préalable a été dispensée sur le

Lien vers l'article :

https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

DeepSeek-V3 surpasse d'autres modèles open-source tels que Qwen2.5-72B et Llama-3.1-405B dans plusieurs évaluations, et ses performances sont comparables à celles des meilleurs modèles fermés au monde, GPT-4o et Claude-3.5-Sonnet.

- connaissance encyclopédiqueLe niveau de DeepSeek-V3 sur les tâches basées sur la connaissance (MMLU, MMLU-Pro, GPQA, SimpleQA) est significativement amélioré par rapport à son prédécesseur, DeepSeek-V2.5, et est proche du modèle le plus performant actuellement, Claude-3.5-Sonnet-1022.

- texte descriptifEn moyenne, DeepSeek-V3 surpasse les autres modèles sur DROP, FRAMES, et LongBench v2 sur les mesures de texte long.

- codification: :DeepSeek-V3 devance de loin tous les modèles non-o1 disponibles sur le marché en termes de force de code algorithmique.; et se rapproche de Claude-3.5-Sonnet-1022 dans le scénario du code de la classe d'ingénierie (SWE-Bench Verified).

- mathématiquesDeepSeek-V3 a largement surpassé tous les modèles à source ouverte et à source fermée lors de la compétition américaine de mathématiques (AIME 2024, MATH) et de la ligue nationale de mathématiques des lycées (CNMO 2024).

- Connaissance de la langue chinoiseDeepSeek-V3 obtient des résultats similaires à ceux de Qwen2.5-72B sur les ensembles d'évaluation C-Eval et Désambiguïsation des pronoms dans le domaine de l'éducation, mais est plus avancé sur C-SimpleQA dans le domaine de la connaissance des faits.

Génération jusqu'à 3 fois plus rapide

Grâce à des innovations algorithmiques et techniques, DeepSeek-V3 augmente considérablement la vitesse de génération des mots, qui passe de 20 TPS à 60 TPS, soit une augmentation de 3 fois par rapport au modèle V2.5, ce qui permet aux utilisateurs de bénéficier d'une expérience plus rapide et plus fluide.

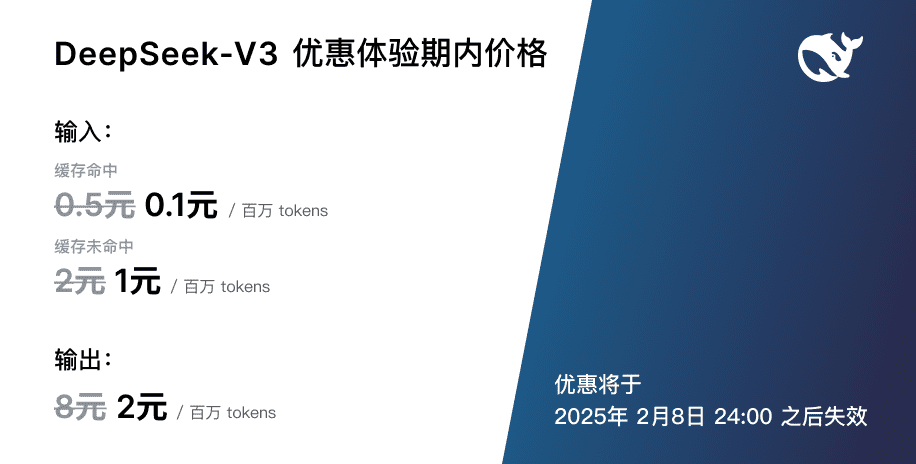

Ajustement du prix du service API

Avec la mise à jour plus puissante et plus rapide de DeepSeek-V3, la tarification de notre service d'API modèle sera également ajustée.0,5 par million de jetons d'entrée (hits du cache) / 2 (misses du cache), 8 $ par million de jetons de sortieL'objectif est d'être en mesure de fournir en permanence de meilleurs services de modélisation à tous.  En même temps, nous avons décidé de proposer le nouveau modèle pendant 45 jours : à partir de maintenant et jusqu'au 8 février 2025, le prix du service API de DeepSeek-V3 restera au prix habituel de0,1 par million de jetons d'entrée (occurrences dans le cache) / 1 $ (échecs dans le cache), 2 $ par million de jetons de sortieLes tarifs réduits ci-dessus sont disponibles pour les utilisateurs existants et les nouveaux utilisateurs qui s'inscrivent pendant cette période.

En même temps, nous avons décidé de proposer le nouveau modèle pendant 45 jours : à partir de maintenant et jusqu'au 8 février 2025, le prix du service API de DeepSeek-V3 restera au prix habituel de0,1 par million de jetons d'entrée (occurrences dans le cache) / 1 $ (échecs dans le cache), 2 $ par million de jetons de sortieLes tarifs réduits ci-dessus sont disponibles pour les utilisateurs existants et les nouveaux utilisateurs qui s'inscrivent pendant cette période.

Pondérations open source et déploiement local

DeepSeek-V3 utilise l'entraînement FP8 et les poids natifs FP8 en open source. Grâce au soutien de la communauté open source, SGLang et LMDeploy supportent pour la première fois l'inférence native en FP8 du modèle V3, tandis que TensorRT-LLM et MindIE implémentent l'inférence en BF16. En outre, nous fournissons des scripts de conversion de FP8 à BF16 pour permettre à la communauté d'adapter et d'étendre les scénarios d'application.

Le téléchargement des poids des modèles et des informations sur le déploiement local sont disponibles à l'adresse suivante :

https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...