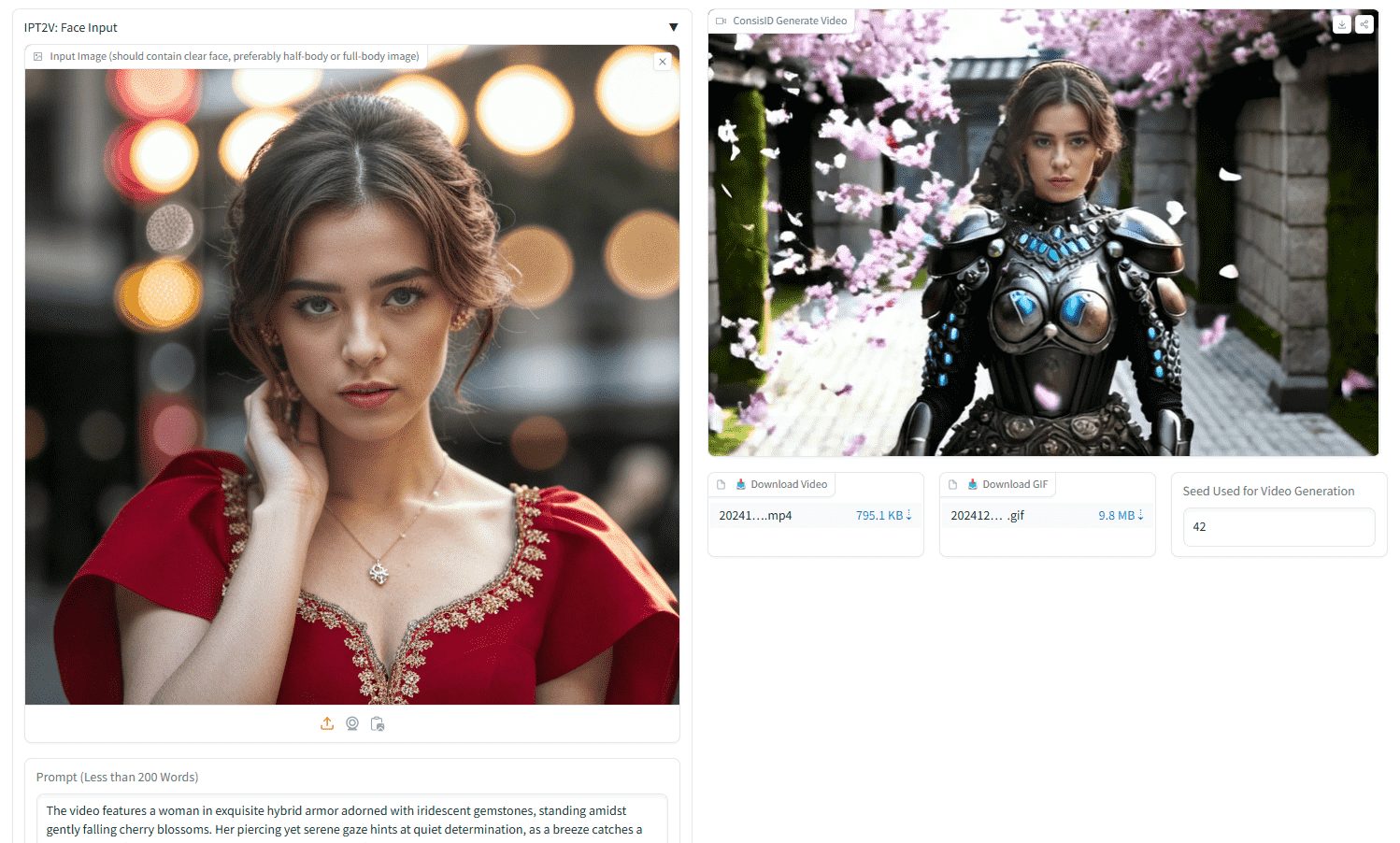

ConsisID : une carte de référence de portrait pour générer des vidéos cohérentes avec les caractères, une intégration multi-terminale rapide

Introduction générale

ConsisID est un projet open source développé par le groupe de Yuan Rong à l'Université de Pékin, visant à réaliser une génération de texte-vidéo cohérente sur le plan de l'identité (IPT2V) par le biais de techniques de décomposition de fréquence. Le cœur du projet est un modèle basé sur DiT (Diffusion Transformer), qui est capable de maintenir la cohérence de l'identité des caractères lors de la génération de vidéos. Le projet ConsisID fournit non seulement le code complet et l'ensemble des données, mais inclut également des directives d'installation et d'utilisation détaillées afin de permettre aux utilisateurs de démarrer rapidement. Ce projet revêt une grande importance dans le domaine de la génération de vidéos, en particulier dans les scénarios d'application où la cohérence des personnages doit être maintenue, tels que la production cinématographique et télévisuelle, la réalité virtuelle, etc.

Liste des fonctions

- Génération de vidéos cohérentes avec l'identitéLa technique de décomposition en fréquence est utilisée pour générer des vidéos qui sont cohérentes avec la description du texte d'entrée et qui conservent l'identité des caractères.

- Code source ouvert et ensembles de donnéesLes codes complets et les ensembles de données partiels sont fournis pour faciliter le développement secondaire et la recherche.

- Support multiplateformeLes applications de l'application sont les suivantes : prise en charge de l'exécution sur les systèmes Windows et Linux, avec les extensions Jupyter Notebook et ComfyUI.

- Optimisation pour des messages de haute qualitéOptimiser la saisie des mots de l'invite textuelle à l'aide de GPT-4o afin d'améliorer la qualité de la vidéo générée.

- Optimisation de la mémoire du GPULe système d'optimisation de la mémoire du GPU : il offre diverses options d'optimisation de la mémoire du GPU afin de s'adapter aux différentes configurations matérielles.

- Contributions communautairesLes services d'information et de communication : soutenir les plug-ins et les extensions développés par la communauté qui améliorent les fonctionnalités et l'expérience d'utilisation.

Utiliser l'aide

Configuration de l'environnement

- Cloner le code du projet :

git clone --depth=1 https://github.com/PKU-YuanGroup/ConsisID.git

cd ConsisID

- Créer et activer un environnement virtuel :

conda create -n consisid python=3.11.0

conda activate consisid

- Installer la dépendance :

pip install -r requirements.txt

Télécharger le modèle de poids

- Télécharger les poids de HuggingFace :

huggingface-cli download --repo-type model BestWishYsh/ConsisID-preview --local-dir ckpts

- Ou téléchargez-le à partir de WiseModel :

git lfs install

git clone https://www.wisemodel.cn/SHYuanBest/ConsisID-Preview.git

exemple de fonctionnement

- Exécutez l'exemple de l'interface Web :

python app.py

- Exécuter un raisonnement en ligne de commande :

python infer.py --model_path BestWishYsh/ConsisID-preview

Optimisation des mots clés

Utilisez GPT-4o pour optimiser la saisie des mots-guides, par exemple : Mot-guide original : "Un homme joue de la guitare". Mot-clé optimisé : "La vidéo montre un homme debout à côté d'un avion, en train de parler sur son téléphone portable. Il porte des lunettes de soleil, un haut noir et affiche une expression sérieuse. L'avion a une bande verte sur le côté et un gros moteur à l'arrière."

Optimisation de la mémoire du GPU

Si vous ne disposez pas de plusieurs GPU ou d'une mémoire GPU suffisante, vous pouvez activer les options suivantes :

pipe.enable_model_cpu_offload()

pipe.enable_sequential_cpu_offload()

pipe.vae.enable_slicing()

pipe.vae.enable_tiling()

Note : L'activation de ces options augmente le temps d'inférence et peut réduire la qualité de la génération.

Prétraitement des données

Veuillez vous référer au guide de prétraitement des données du projet pour connaître les données nécessaires à l'apprentissage de ConsisID. Si vous avez besoin d'entraîner des modèles de génération de texte à image et de vidéo, vous devez organiser l'ensemble de données dans le format suivant :

datasets/

├── captions/

│ ├── dataname_1.json

│ ├── dataname_2.json

├── dataname_1/

│ ├── refine_bbox_jsons/

│ ├── track_masks_data/

│ ├── videos/

├── dataname_2/

│ ├── refine_bbox_jsons/

│ ├── track_masks_data/

│ ├── videos/

├── ...

├── total_train_data.txt

formation au modèle

- Définir les hyperparamètres :

bash train_single_rank.sh

- Lancer la formation :

bash train_multi_rank.sh

Contributions communautaires

Merci aux développeurs de la communauté pour les plugins et les extensions :

- ComfyUI-ConsisIDWrapper

- Jupyter-ConsisID

- Windows-ConsisID

Intégration rapide de ConsisID

Expérience en ligne :Visage étreint

Installateur Windows :Visage étreintDébut de l'intelligence AI

Nœud ComfyUI :ComfyUI-CogVideoXWrapper openart : https://openart.ai/workflows/TxIQ6lwGkRx2zQiYjvE5

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...