Commande R7B : Recherche et raisonnement améliorés, support multilingue, IA générative rapide et efficace

Le plus petit modèle de notre famille R offre une vitesse, une efficacité et une qualité de premier ordre pour créer de puissantes applications d'IA sur les GPU courants et les appareils périphériques.

Aujourd'hui, nous avons le plaisir de publier Commandement R7B, le plus petit, le plus rapide et le dernier modèle de notre série R de grands modèles de langage (LLM) développés spécifiquement pour l'entreprise. Command R7B offre des performances inégalées dans sa catégorie de modèles à pondération ouverte capables de traiter des tâches du monde réel qui importent aux utilisateurs. Le modèle est conçu pour les développeurs et les entreprises qui ont besoin d'optimiser la vitesse, la rentabilité et les ressources informatiques.

Comme les autres modèles de la famille R, Command R7B offre une longueur de contexte de 128k et excelle dans plusieurs scénarios d'application commerciale importants. Il combine un support multilingue solide, une génération augmentée de récupération (RAG) validée par référence, un raisonnement, une utilisation d'outils et un comportement d'agent. Grâce à sa taille compacte et à son efficacité, il peut fonctionner sur des GPU bas de gamme, des MacBooks et même des CPU, ce qui réduit considérablement le coût de mise en production des applications d'IA.

Des performances élevées dans un petit boîtier

Un modèle complet

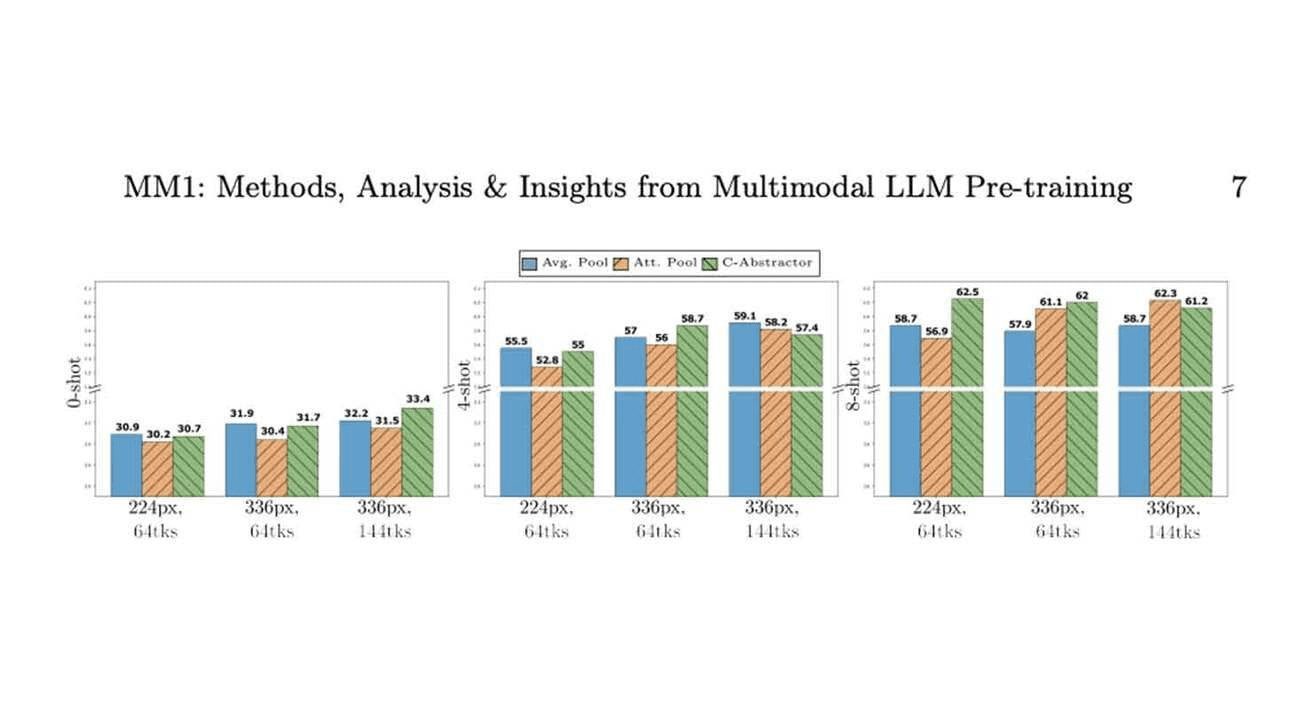

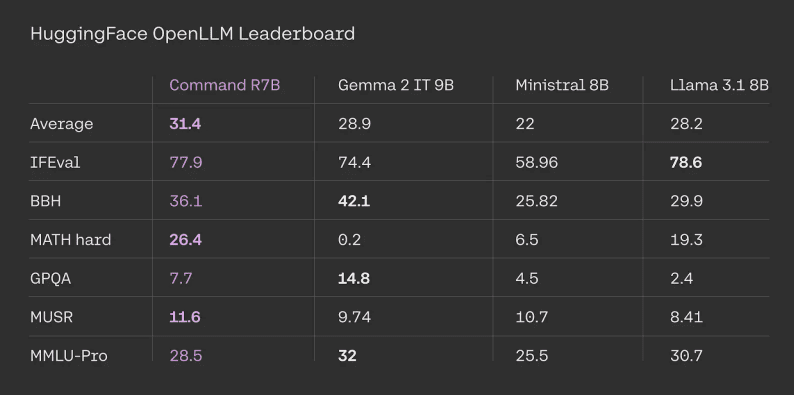

La Command R7B obtient de bons résultats dans des tests de référence normalisés et vérifiables de l'extérieur, tels que Classement de l'Open LLM HuggingFace. La commande R7B s'est classée première en moyenne pour toutes les tâches, avec de bonnes performances par rapport à d'autres modèles de pondération ouverts comparables.

Résultats de l'évaluation du leaderboard de HuggingFace. Les chiffres des concurrents sont tirés des classements officiels. Les résultats pour Command R7B sont calculés par nos soins sur la base des astuces et des codes d'évaluation fournis par le site officiel HuggingFace.

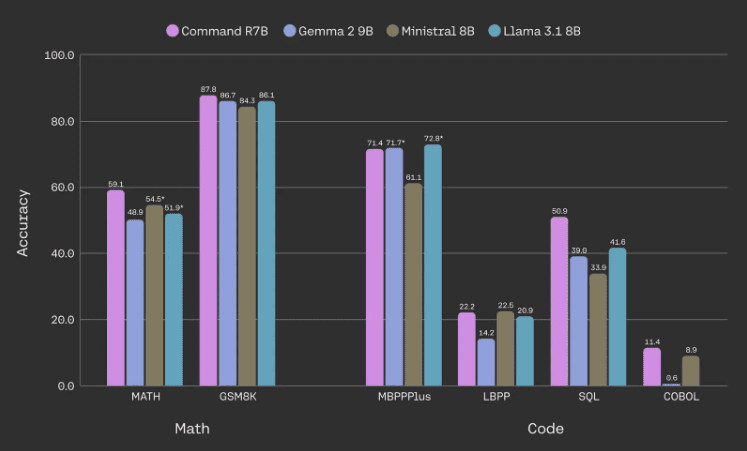

Gains d'efficacité dans les tâches de mathématiques, de codage et de raisonnement

L'un des principaux objectifs de la commande R7B est d'améliorer les performances en matière de mathématiques et de raisonnement, d'écriture de code et de tâches multilingues. En particulier, le modèle est capable d'égaler ou de dépasser les performances de modèles comparables à pondération ouverte sur des critères de référence courants en mathématiques et en code, tout en utilisant moins de paramètres.

Performances du modèle en mathématiques et étalonnage des codes. Toutes les données proviennent d'évaluations internes, les chiffres marqués d'un astérisque correspondent à des résultats plus élevés rapportés en externe. Nous utilisons la version de base de MBPPPlus, la moyenne de LBPP est calculée sur 6 langages, la moyenne de SQL est calculée sur 3 ensembles de données (sections de difficulté élevée et très élevée de SpiderDev et Test only, BirdBench, et un ensemble de données interne), et COBOL est un ensemble de données que nous avons développé en interne.

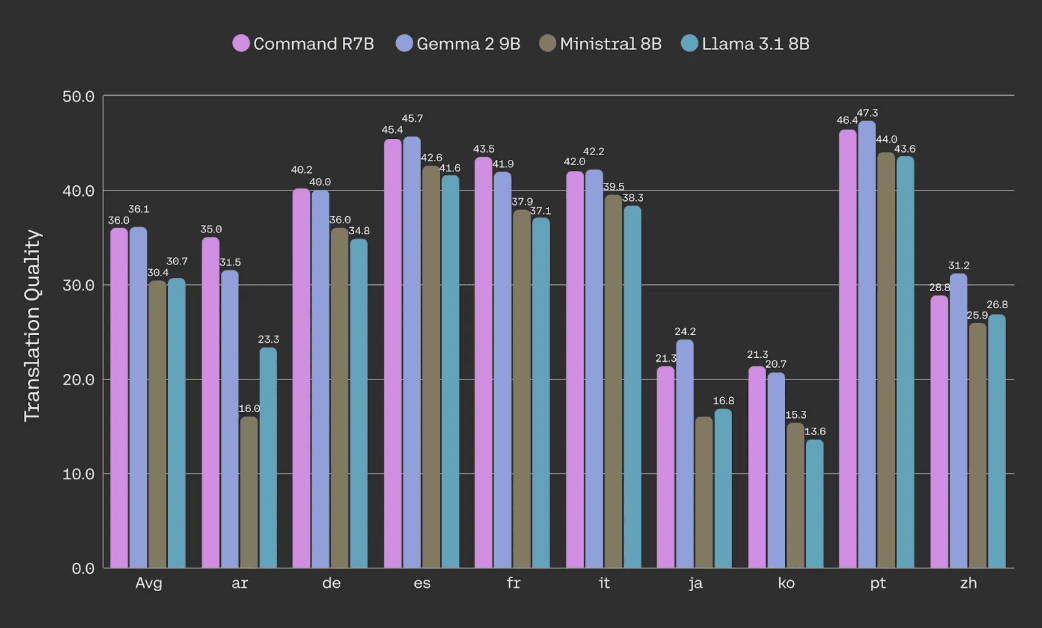

Qualité de la traduction des documents évaluée à l'aide de l'ensemble de données NTREX (via les métriques spBLEU du corpus).

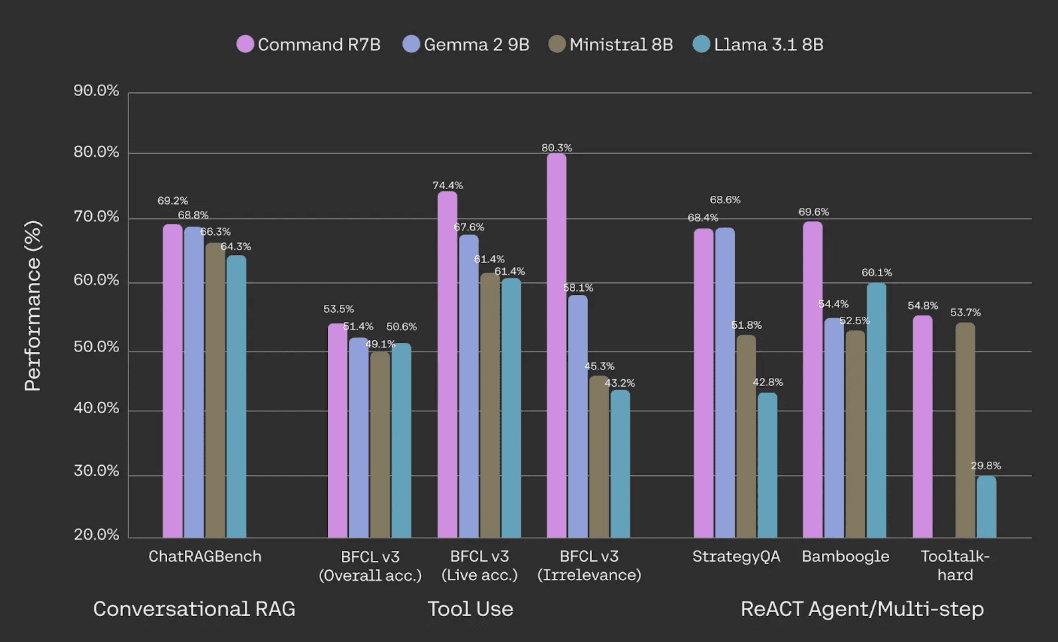

Meilleur RAG de sa catégorie, utilisation d'outils et intelligentsia

Command R7B surpasse les autres modèles de pondération ouverts de taille comparable dans le traitement des utilisations commerciales de base telles que le RAG, l'utilisation d'outils et les intelligences de l'IA. Il est idéal pour les organisations qui recherchent un modèle rentable basé sur des documents et des données internes. Comme pour les autres modèles de la série R, notre RAG Des références locales en ligne sont fournies, ce qui réduit considérablement les illusions et facilite la vérification des faits.

Évaluation des performances sur ChatRAGBench (moyenne sur 10 ensembles de données), BFCL-v3, StrategyQA, Bamboogle et Tooltalk-hard. Voir la note de bas de page [1] ci-dessous pour la méthodologie et plus de détails.

En ce qui concerne l'utilisation des outils, nous constatons que, par rapport à des modèles réduits comparables, la Command R7B est plus efficace en termes d'utilisation des outils standard de l'industrie. Tableau de classement des appels de fonctions de Berkeley Cela montre que la Command R7B est particulièrement douée pour l'utilisation d'outils dans des environnements divers et dynamiques du monde réel et qu'elle est capable d'éviter d'appeler inutilement des outils, un aspect important de l'utilisation d'outils dans les applications du monde réel. Cela montre que la Command R7B est particulièrement douée pour l'utilisation d'outils dans des environnements divers et dynamiques du monde réel et qu'elle est capable d'éviter de faire appel à des outils inutilement, ce qui est un aspect important de l'utilisation d'outils dans les applications du monde réel.

Optimisation pour les cas d'utilisation en entreprise

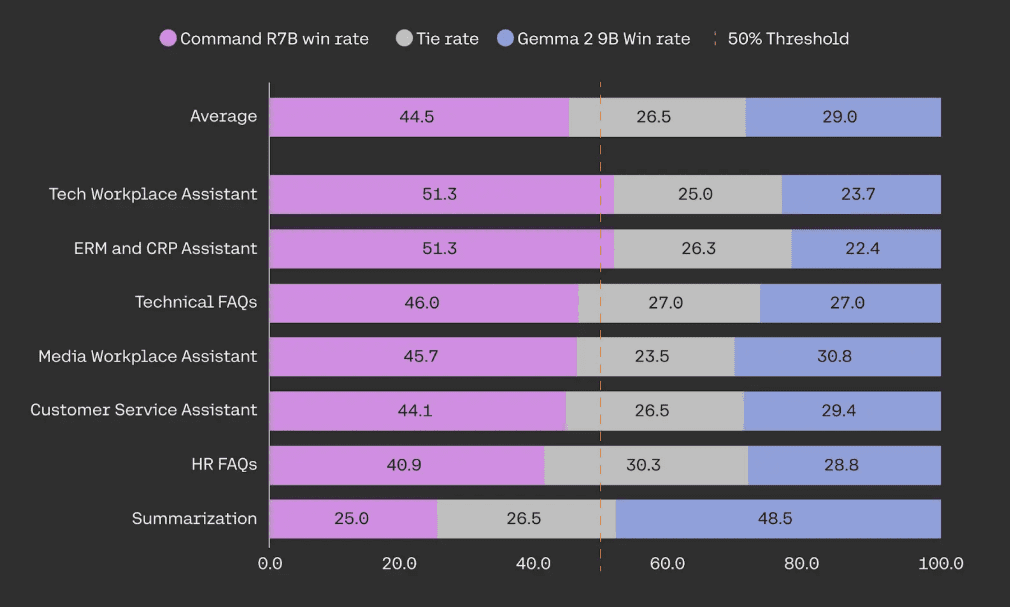

Nos modèles sont optimisés pour répondre aux capacités dont les organisations ont besoin lorsqu'elles déploient des systèmes d'IA dans le monde réel.La série R offre un équilibre inégalé entre l'efficacité et la robustesse des performances. Command R7B surpasse des modèles de taille similaire, à pondération ouverte, dans des tests en tête-à-tête à l'aveugle sur des cas d'utilisation RAG pour la création d'assistants IA qui intéressent les clients, tels que le service client, les RH, la conformité et les fonctions d'assistance informatique.

Dans l'évaluation humaine, Command R7B a été testé par rapport à Gemma 2 9B sur un échantillon de 949 cas d'utilisation de RAG d'entreprise. Tous les exemples ont été annotés au moins en triple aveugle par des annotateurs humains spécialement formés pour évaluer la fluidité, la fidélité et l'utilité des réponses.

Efficace et rapide

La taille compacte de la Command R7B offre une empreinte de service réduite pour un prototypage et une itération rapides. Elle excelle dans les cas d'utilisation en temps réel à haut débit tels que les chatbots et les assistants de code. Il prend également en charge le raisonnement côté appareil en réduisant considérablement le coût de déploiement de l'infrastructure, comme les GPU et les CPU grand public.

Nous n'avons fait aucun compromis sur nos normes de sécurité et de confidentialité au niveau de l'entreprise au cours de ce processus afin de garantir la protection des données de nos clients.

démarrage rapide

La Command R7B est disponible dès aujourd'hui à l'adresse suivante Plate-forme Cohere Il peut également être utilisé sur le Visage étreint Sur l'accès. Nous sommes heureux de publier les poids du modèle afin d'offrir à la communauté des chercheurs en IA un accès plus large aux technologies de pointe.

| Cohère Prix de l'API | importation Jeton | Jeton de sortie |

|---|---|---|

| Commande R7B | $0.0375 / 1M | $0.15 / 1M |

[1] Conversational RAG : un test de performance moyen sur le benchmark ChatRAGBench sur 10 ensembles de données, testant la capacité à générer des réponses dans une variété d'environnements, y compris des tâches conversationnelles, le traitement de longues entrées, l'analyse de formulaires, et l'extraction et la manipulation d'informations de données dans un environnement financier. Nous avons amélioré la méthodologie d'évaluation en utilisant l'intégration du discriminateur PoLL (Verga et al., 2024) en combinaison avec Haiku, GPT3.5 et Command R, ce qui a permis d'obtenir une meilleure cohérence (kappa de Fleiss = 0,74 par rapport à 0,57 dans la version originale, sur la base de 20 000 évaluations manuelles). Utilisation de l'outil : performance sur le benchmark BFCL-v3 du 12 décembre 2024. Tous les scores disponibles proviennent de classements publics, sinon d'évaluations internes utilisant la base de code officielle. Pour les concurrents, nous indiquons le score le plus élevé de leur BFCL "prompted" ou "function-calling". Nous indiquons le score global, le score du sous-ensemble en temps réel (testant l'utilisation d'outils dans des environnements réels, divers et dynamiques) et le score du sous-ensemble non pertinent (testant la manière dont le modèle évite d'appeler des outils inutilement).REACT Agent/Multi-étapes : Nous avons évalué LangChain REACT La capacité des intelligences connectées à Internet à décomposer des problèmes complexes et à élaborer des plans pour mener à bien des recherches a été évaluée à l'aide de Bamboogle et de StrategyQA. Bamboogle a été évalué à l'aide de l'intégration PoLL, et StrategyQA a été évalué en déterminant si le modèle a suivi les instructions du format et a finalement répondu "oui" ou "non" pour porter un jugement. ou "Non" pour émettre un jugement. Nous utilisons les jeux de tests de Chen et al. (2023) et Press et al. (2023).ToolTalk met le modèle au défi d'effectuer un raisonnement complexe et de rechercher activement des informations auprès de l'utilisateur afin de réaliser des tâches complexes telles que la gestion de compte, l'envoi de courriels et la mise à jour de calendriers.ToolTalk-hard est évalué en utilisant le taux de réussite soft de la bibliothèque officielle ToolTalk. ToolTalk exige que le modèle expose une API d'appel de fonction, ce que Gemma 2 9B ne possède pas.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...