Snowflake lance le modèle vectoriel multilingue Arctic Embed 2.0 pour une recherche de haute qualité en chinois

Snowflake a le plaisir d'annoncer la sortie de Arctic Embed L 2.0 répondre en chantant Arctic Embed M 2.0 Arctic Embed 2.0, qui est la prochaine itération de notre modèle d'intégration de pointe, peut désormais prendre en charge la recherche multilingue. Alors que nos versions précédentes ont été bien accueillies par les clients, les partenaires et la communauté open source, et ont atteint des millions de téléchargements, nous avons reçu une demande : pouvez-vous rendre ce modèle multilingue ? Arctic Embed 2.0 s'appuie sur la base solide de nos versions précédentes, ajoutant la prise en charge multilingue sans sacrifier la performance ou l'évolutivité en langue anglaise pour répondre aux besoins d'une communauté d'utilisateurs plus large, qui couvre un large éventail de langues et d'applications. qui couvre un large éventail de langues et d'applications.

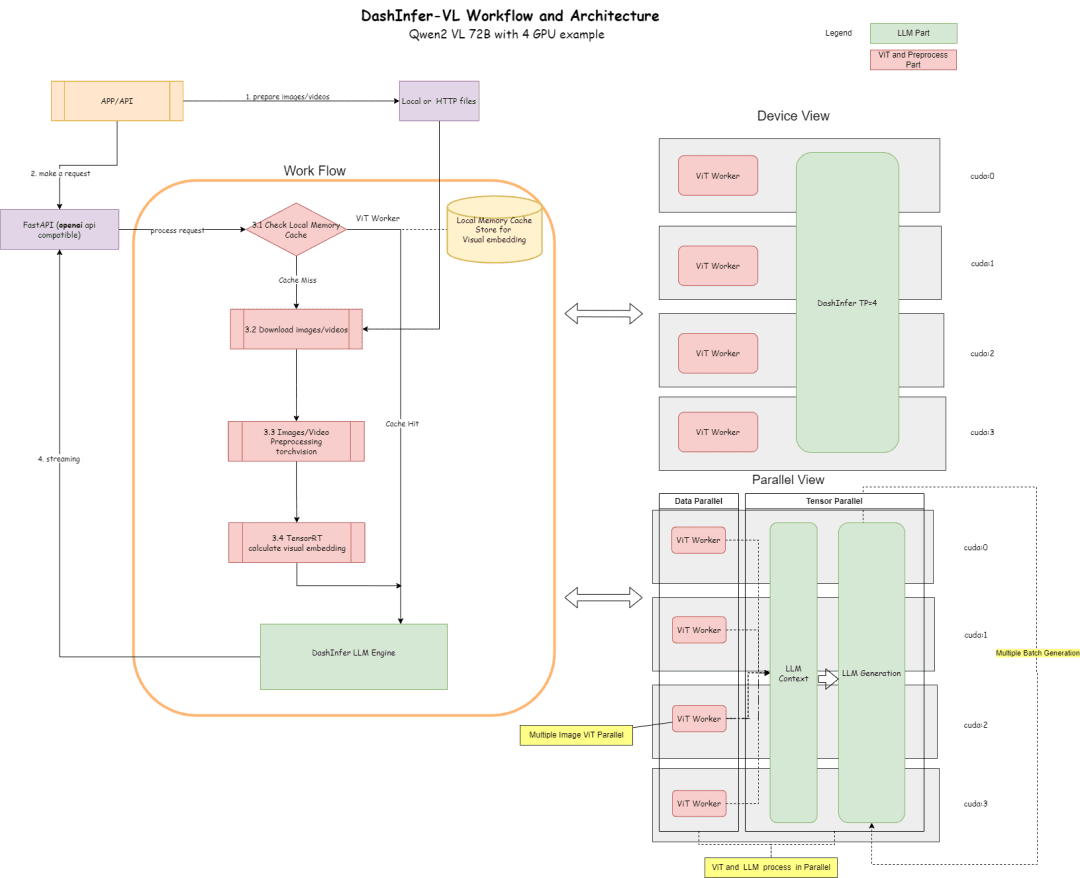

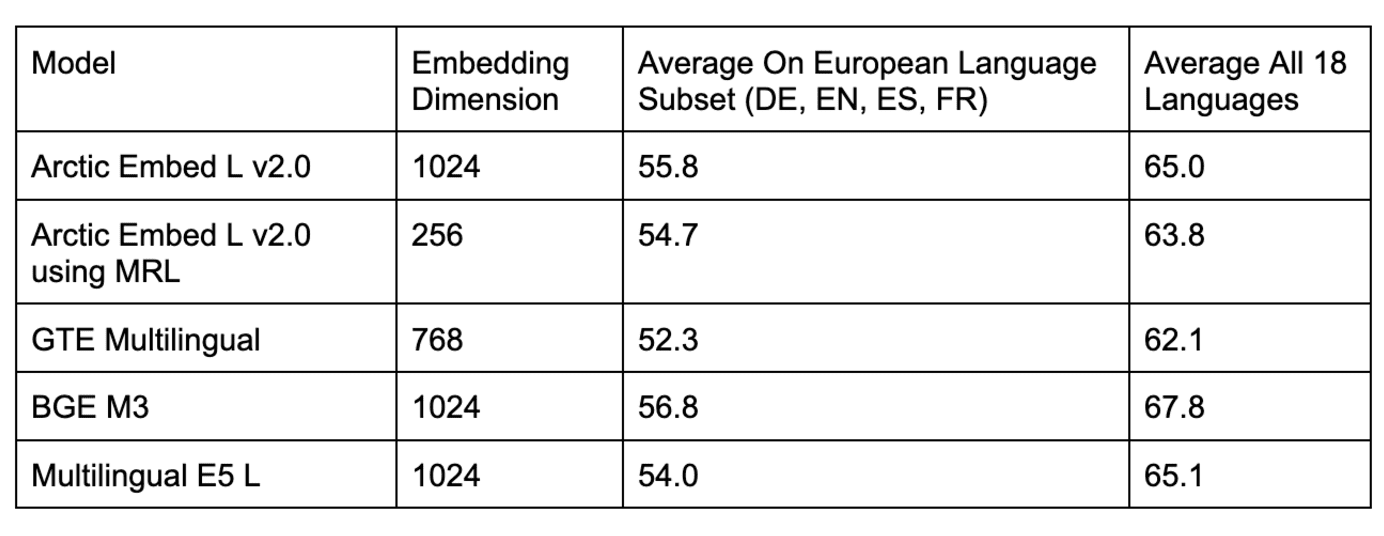

Fig. 1 : Performances de recherche unidirectionnelle à forte intensité de volume d'un modèle d'intégration multilingue à source ouverte avec moins d'un milliard de paramètres. Les scores sont MTEB Récupération et le nDCG@10 moyen sur le sous-ensemble CLEF (ELRA, 2006) (couvrant l'anglais, le français, l'espagnol, l'italien et l'allemand).

Le multilinguisme sans compromis

Dans cette version 2.0 d'Arctic Embed, nous proposons deux variantes, une variante moyenne axée sur l'efficacité de l'inférence, qui s'appuie sur le système de gestion des données d'Alibaba. GTE-multilingue En outre, avec 305 millions de paramètres (dont 113 millions ne sont pas intégrés), une autre variante importante se concentre sur la qualité de l'extraction et s'appuie sur la base de données de Facebook. XMLR-Large en plus de la variante à contexte long avec 568 millions de paramètres (dont 303 millions ne sont pas intégrés). Les deux tailles prennent en charge jusqu'à 8 192 Jeton la longueur du contexte. Lors de l'élaboration d'Arctic Embed 2.0, nous avons pris conscience d'un problème auquel sont confrontés de nombreux modèles multilingues existants : l'optimisation pour plusieurs langues finit souvent par sacrifier la qualité d'extraction de l'anglais. Cela a conduit de nombreux modèles à avoir deux variantes pour chaque version : anglaise et multilingue. Les modèles Arctic Embed 2.0 sont différents. Ils offrent des performances optimales dans les langues autres que l'anglais, telles que l'allemand, l'espagnol et le français, tout en surpassant leurs prédécesseurs exclusivement anglophones dans la recherche en anglais. Arctic Embed M 1.5.

En équilibrant soigneusement le besoin de multilinguisme et l'engagement de Snowflake en faveur de l'excellence dans la recherche en langue anglaise, nous avons conçu Arctic Embed 2.0 comme un modèle universel pour une large gamme de cas d'utilisation à l'échelle mondiale. Dans le présent document, toutes les évaluations qualitatives font référence aux scores moyens du NDCG@10 pour l'ensemble des tâches, sauf indication contraire.

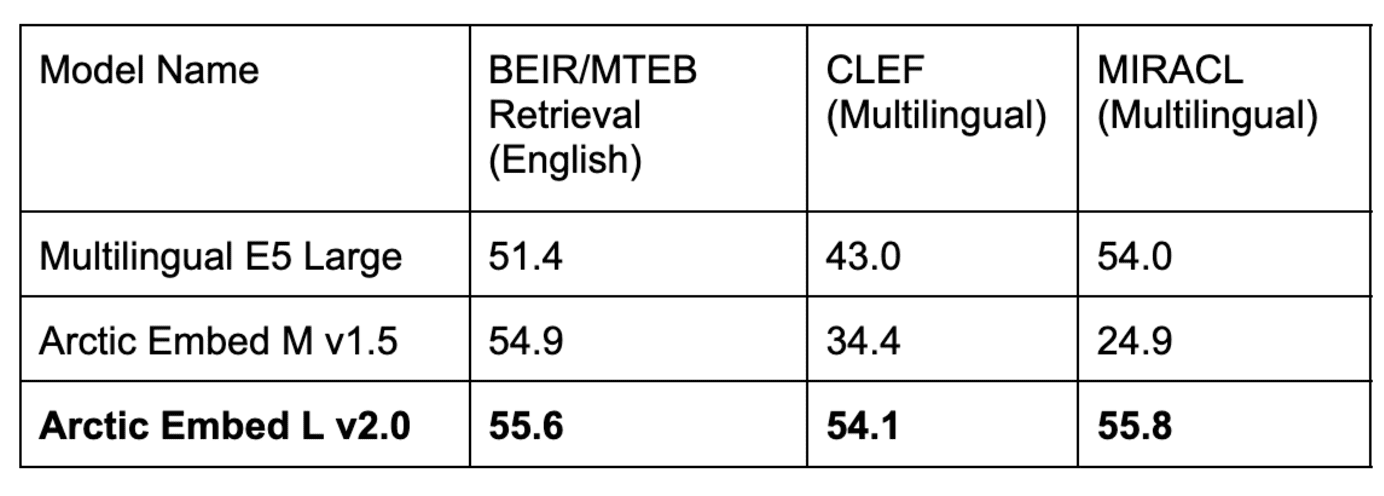

Tableau 1. notre modèle Arctic Embed L v2.0 obtient des scores élevés dans le populaire benchmark anglais MTEB Retrieval, ainsi qu'une qualité de récupération élevée dans plusieurs benchmarks multilingues. les itérations précédentes d'Arctic Embed ont obtenu de bons résultats en anglais mais de mauvais résultats en multilingue, tandis que les modèles multilingues populaires à source ouverte ont baissé leurs performances en anglais. Les performances en anglais ont baissé. Tous les scores des modèles et des ensembles de données reflètent la moyenne NDCG@10. Les scores CLEF et MIRACL reflètent la moyenne de l'allemand (DE), de l'anglais (EN), de l'espagnol (ES), du français (FR) et de l'italien (IT).

L'ensemble des fonctionnalités diverses et puissantes d'Arctic Embed 2.0

- Débit et efficacité de niveau entreprise : Le modèle Arctic Embed 2.0 est conçu pour répondre aux besoins des entreprises à grande échelle. Même notre "grand" modèle a des paramètres bien inférieurs à un milliard et offre une intégration rapide et à haut débit. D'après des tests internes, il traite facilement plus de 100 documents par seconde (en moyenne) sur les GPU NVIDIA A10 et atteint moins de 10 millisecondes de latence d'intégration des requêtes, ce qui permet un déploiement dans le monde réel sur du matériel abordable.

- Une qualité de recherche sans compromis entre l'anglais et le non-anglais : Malgré leur taille compacte, les deux modèles Arctic Embed 2.0 ont obtenu des scores NDCG@10 impressionnants sur une variété d'ensembles de données de référence anglaises et non anglaises, démontrant leur bonne capacité de généralisation même pour les langues non incluses dans la solution d'entraînement. Ces scores impressionnants font d'Arctic Embed L 2.0 un leader parmi les modèles de recherche de pointe.

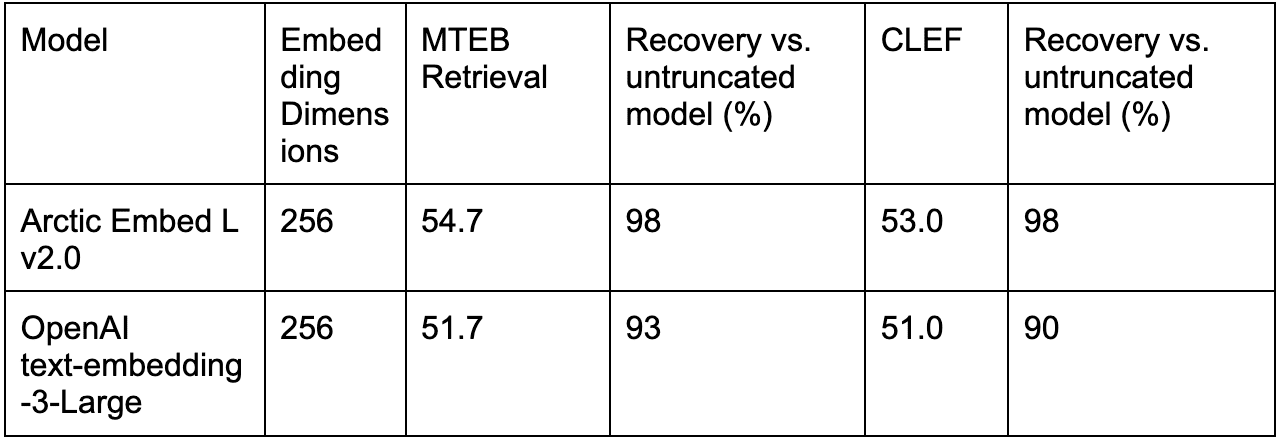

- Récupération évolutive via l'apprentissage de la représentation de Matryoshka (MRL) : La version 2.0 d'Arctic Embed inclut la même fonctionnalité MRL, favorable à la quantification, introduite dans Arctic Embed 1.5, permettant aux utilisateurs de réduire les coûts et d'optimiser la taille lorsqu'ils effectuent des recherches sur de grands ensembles de données. Avec deux tailles de modèle, les utilisateurs peuvent réaliser des recherches de haute qualité en utilisant seulement 128 octets par vecteur (96 fois plus petit que l'incorporation non compressée du modèle populaire text-embedding-3-large d'OpenAI ^1^). Comme Arctic Embed 1.5, le modèle Arctic Embed 2.0 est également plus performant que plusieurs de ses homologues compatibles MRL dans un état compressé, avec une dégradation de la qualité nettement inférieure et des scores de référence plus élevés.

- Véritablement open source : Le modèle Arctic Embed 2.0 est publié sous la généreuse licence Apache 2.0.

La flexibilité de l'Open Source rencontre la fiabilité de l'entreprise

Comme leurs prédécesseurs, les modèles Arctic Embed 2.0 sont publiés sous la généreuse licence Apache 2.0, ce qui permet aux organisations de les modifier, de les déployer et de les étendre dans le cadre de licences familières. Ces modèles fonctionnent prêts à l'emploi, prennent en charge des applications verticales grâce à une intégration multilingue fiable et présentent de bonnes capacités de généralisation.

Clément Delangue, PDG de Hugging Face, a déclaré : "Les modèles d'intégration multilingues sont essentiels pour permettre aux personnes du monde entier, et pas seulement aux anglophones, de devenir des constructeurs d'IA. En publiant ces modèles de pointe en open source sur Hugging Face, Snowflake apporte une contribution considérable à l'IA et au monde."

En fait, parmi les options open source, la famille Arctic Embed 2.0 mérite une attention particulière pour ses capacités de généralisation observées dans les tests de recherche multilingue. En accordant une licence à Suite de tests du Forum d'évaluation des langues croisées (CLEF) 2000-2003Notre équipe a pu mesurer la qualité de l'extraction hors domaine de divers modèles open source et a constaté une tendance fâcheuse en ce qui concerne l'extraction dans le domaine. MIRACL des performances médiocres par rapport aux scores obtenus sur l'ensemble d'évaluation. Nous émettons l'hypothèse que certains des premiers développeurs de modèles à source ouverte ont pu, par inadvertance, surajuster leurs scénarios d'entraînement pour améliorer les performances de MIRACL au détriment de l'amélioration des performances de MIRACL, et ont donc pu surajuster les données d'entraînement de MIRACL. Restez à l'écoute pour un prochain rapport technique sur la façon dont le modèle Arctic Embed 2.0 a été entraîné et sur ce que nous avons appris au cours du processus d'entraînement.

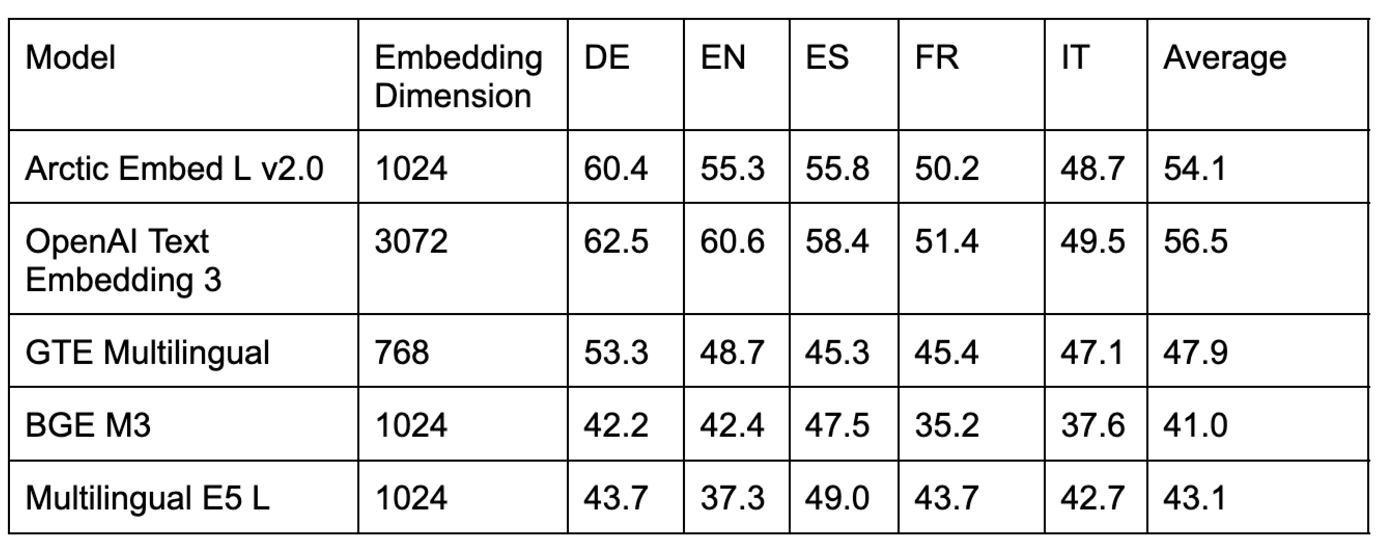

Tableau 2 : Comparaison des modèles de recherche multilingue sur plusieurs ensembles de données provenant de l'évaluation comparative CLEF hors domaine.

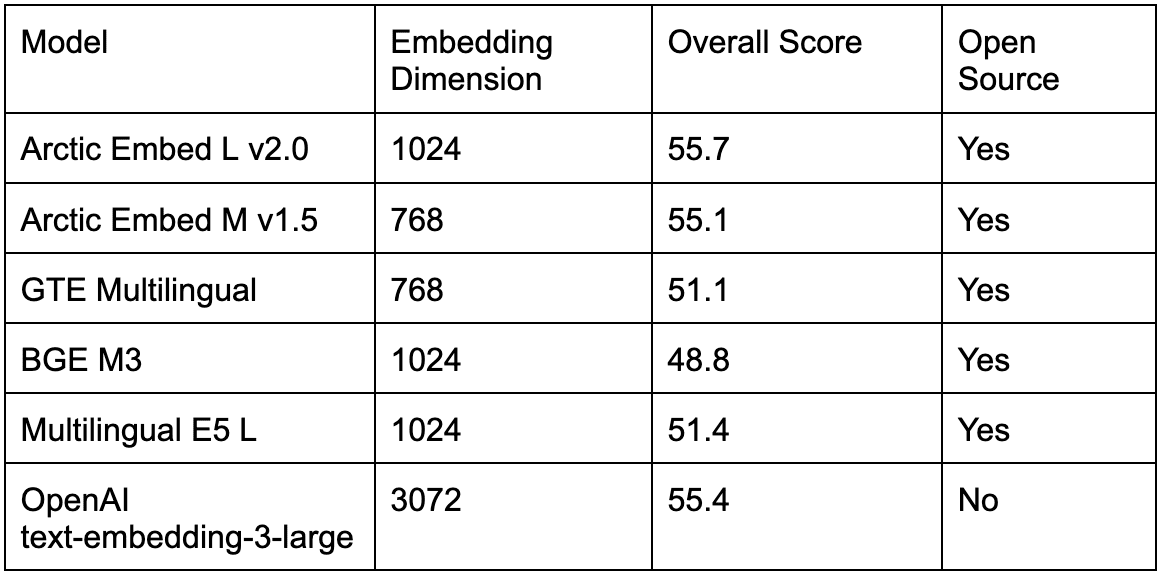

Tableau 3 : Comparaison de plusieurs modèles de recherche multilingue à source ouverte dans le cadre de l'évaluation comparative MIRACL dans le domaine.

Comme le montrent les tableaux 2 et 3, plusieurs modèles populaires à source ouverte pour l'évaluation intra-domaine de MIRACL sont comparés à l'approche de l'évaluation intra-domaine. Arctic Embed L 2.0 sont comparables, mais ses performances sont médiocres dans les évaluations CLEF hors domaine. Nous avons également comparé des modèles fermés populaires (par exemple, le modèle text-embedding-3-large d'OpenAI) et constaté que les performances d'Arctic L 2.0 étaient conformes à celles des principaux modèles propriétaires.

Comme le montre le tableau 4, les modèles multilingues à source ouverte existants sont également plus performants dans le test de référence MTEB Retrieval en anglais que les modèles à source ouverte. Arctic Embed L 2.0 Le modèle Arctic Embed 2.0 était encore pire, car il obligeait les utilisateurs qui voulaient prendre en charge plusieurs langues à choisir entre une qualité de recherche inférieure en anglais et la complexité opérationnelle accrue liée à l'utilisation d'un deuxième modèle pour la recherche en anglais uniquement. Avec la sortie d'Arctic Embed 2.0, les praticiens peuvent désormais passer à un seul modèle open source sans sacrifier la qualité de la recherche en anglais.

Tableau 4 : Comparaison de plusieurs modèles de recherche multilingue à source ouverte et à source fermée dans le cadre de l'évaluation comparative de la recherche MTEB dans le domaine.

Compression et efficacité sans compromis

Snowflake continue de donner la priorité à l'efficacité et à l'échelle dans la conception de ses modèles intégrés. Avec l'aide de Arctic Embed L 2.0Cela permet aux utilisateurs de comprimer les caractéristiques de qualité des grands modèles dans des encastrements compacts qui ne nécessitent que 128 octets de stockage par vecteur. Il est ainsi possible de fournir des services de recherche pour des millions de documents à faible coût sur du matériel bas de gamme. Nous avons également réalisé des gains d'efficacité en termes de débit d'intégration en comprimant l'impressionnante qualité de recherche d'Arctic Embed 2.0 en 100 millions et 300 millions de paramètres non intégrés pour ses deux tailles (moyenne et grande) respectivement - ce qui ne représente qu'une légère augmentation par rapport à notre version antérieure uniquement en anglais.

En effet, les mécanismes axés sur l'échelle sont Arctic Embed L 2.0 Là où il brille vraiment, c'est qu'il obtient une meilleure qualité sous compression par rapport à d'autres modèles entraînés par MRL (par exemple, le modèle text-embedding-3-large de l'OpenAI).

Le tableau 5 compare les performances de l'encodage de texte 3-large d'OpenAI avec l'encodage tronqué d'Arctic Embed L 2.0 pour l'anglais uniquement (MTEB Retrieval) et le multilingue (CLEF).

Conclusion : une nouvelle norme pour une recherche multilingue efficace

Avec Arctic Embed 2.0, Snowflake a établi une nouvelle norme pour les modèles d'intégration multilingues et efficaces. En outre, nous avons repoussé les limites de la qualité de l'incorporation de texte, non seulement en termes d'efficacité, mais aussi en termes de liberté d'accès à l'open source. Que votre objectif soit d'étendre votre portée aux utilisateurs multilingues, de réduire les coûts de stockage ou d'intégrer des documents sur du matériel accessible, Arctic Embed 2.0 offre les fonctionnalités et la flexibilité nécessaires pour répondre à vos besoins.

Nos prochains rapports techniques approfondiront les innovations qui sous-tendent Arctic Embed 2.0. En attendant, nous vous invitons à commencer à intégrer Snowflake dès aujourd'hui.

^1^ Ce calcul utilise le format float32 pour la ligne de base non comprimée, c'est-à-dire 3 072 nombres de 32 bits chacun, pour un total de 98 304 bits par vecteur, ce qui est exactement 96 fois plus grand que les 1 024 bits par vecteur (équivalant à 128 octets par vecteur) utilisés lors du stockage des vecteurs à 256 dimensions tronqués par MRL dans le modèle Arctic Embed 2.0 au format int4.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...