Installer Dify et intégrer Ollama et Xinference

Cet article décrit l'installation de Dify via Docker, puis l'intégration de l'application Ollama et XInference, et en utilisant le Dify Créez rapidement une application basée sur une base de connaissances et un quiz.

- I. Introduction à Dify

- Installation de Dify

- Dify ajoute le modèle Ollama aux questions-réponses

- Quiz basé sur la base de connaissances de Dify

- V. Liens de documentation

I. Introduction à Dify

Dify est une plateforme de développement d'applications LLM (Large Language Modelling) open source conçue pour aider les développeurs à créer et déployer rapidement des applications d'IA générative. Voici les principales caractéristiques et fonctionnalités de Dify [1] :

- Fusion des concepts de Backend as Service et de LLMOps Dify combine les concepts de Backend as Service et de LLMOps pour permettre aux développeurs de créer rapidement des applications d'IA générative de niveau production.

- Prise en charge de plusieurs modèles Dify prend en charge des centaines de modèles LLM propriétaires et open source, dont GPT, Mistral, Llama3, et bien d'autres encore, en intégrant de manière transparente des modèles provenant de multiples fournisseurs d'inférence et de solutions auto-hébergées.

- Interface intuitive d'orchestration des messages Dify propose un IDE intuitif pour la rédaction de messages-guides, la comparaison des performances des modèles et l'ajout de fonctionnalités supplémentaires telles que la conversion vocale pour les applications basées sur le dialogue en ligne.

- Moteur RAG de haute qualité Dify : Dify dispose d'une large gamme de RAG Fonctionnalité qui couvre tous les aspects de l'ingestion et de la récupération de documents et qui prend en charge l'extraction de texte à partir de formats de documents courants tels que PDF, PPT, etc.

- Intégration du cadre de l'agent L'utilisateur peut baser l'appel de la fonction LLM ou l'appel de la fonction ReAct Dify offre plus de 50 outils intégrés tels que Google Search, DELL-E, Stable Diffusion et WolframAlpha.

- Organisation flexible des processus Dify : Dify fournit un canevas visuel puissant pour construire et tester des flux de travail d'IA robustes, permettant aux développeurs de concevoir et d'optimiser intuitivement leurs processus d'IA.

- Outils complets de suivi et d'analyse Dify fournit des outils pour surveiller et analyser les journaux d'application et les performances, et les développeurs peuvent continuellement améliorer les indices, les ensembles de données et les modèles en fonction des données de production et des annotations.

- back-end en tant que service Les fonctionnalités de Dify sont assorties d'une API, de sorte qu'il est facile d'intégrer Dify dans votre propre logique d'entreprise.

Installation de Dify

Copiez le code Github de Dify localement [2].

git clone https://github.com/langgenius/dify.git

Allez dans le répertoire docker du code source de dify et copiez les variables d'environnement.

cd dify/docker

cp .env.example .env

Installer l'application via docker compose.

docker compose up -d

Entrez dans le conteneur ollama et lancez le programmeqwen2:7bModèles.

root@ip-172-31-30-167:~/dify/docker# docker pull ollama/ollama

root@ip-172-31-83-158:~/dify/docker# docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama --restart always -e OLLAMA_KEEP_ALIVE=-1 ollama/ollama

root@ip-172-31-83-158:~/dify/docker# docker exec -it ollama bash

root@b094349fc98c:/# ollama run qwen2:7b

Dify ajoute le modèle Ollama aux questions-réponses

Connectez-vous à la page d'accueil de Dify via l'adresse IP publique de l'EC2 et le port 80 et créez un compte administrateur.

Se connecter via le compte administrateur.

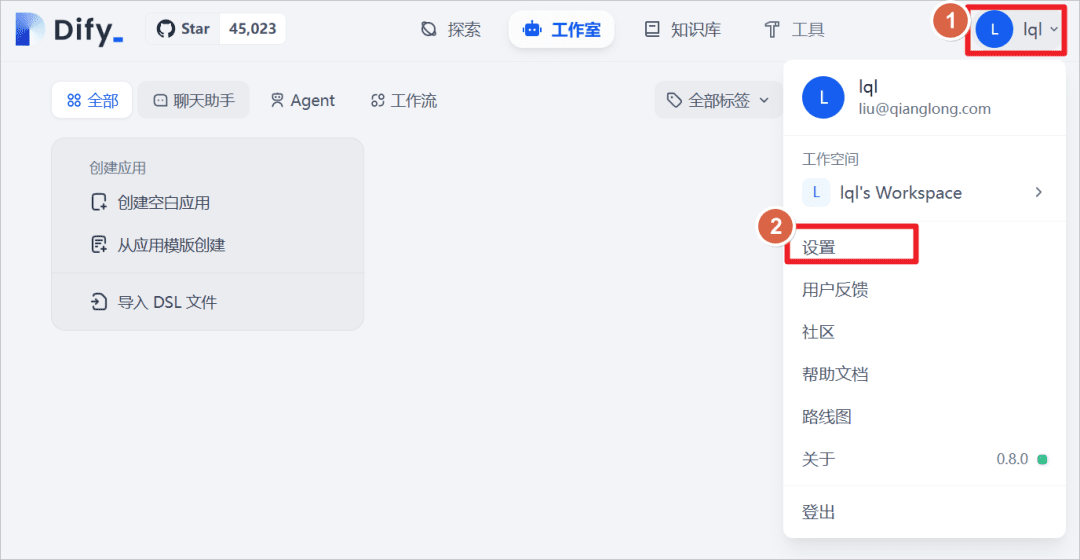

Cliquez sur Utilisateur - Paramètres.

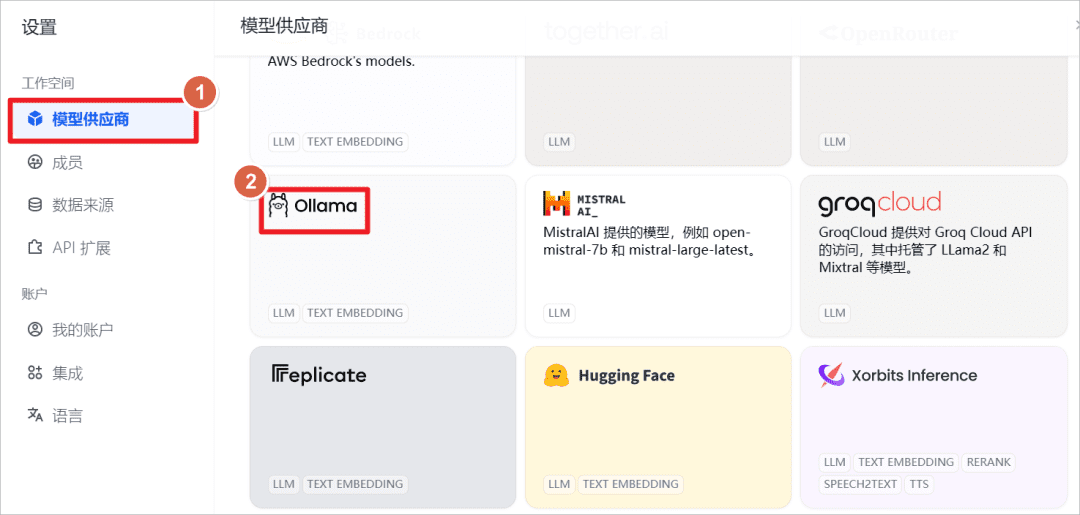

Ajouter le modèle Ollama.

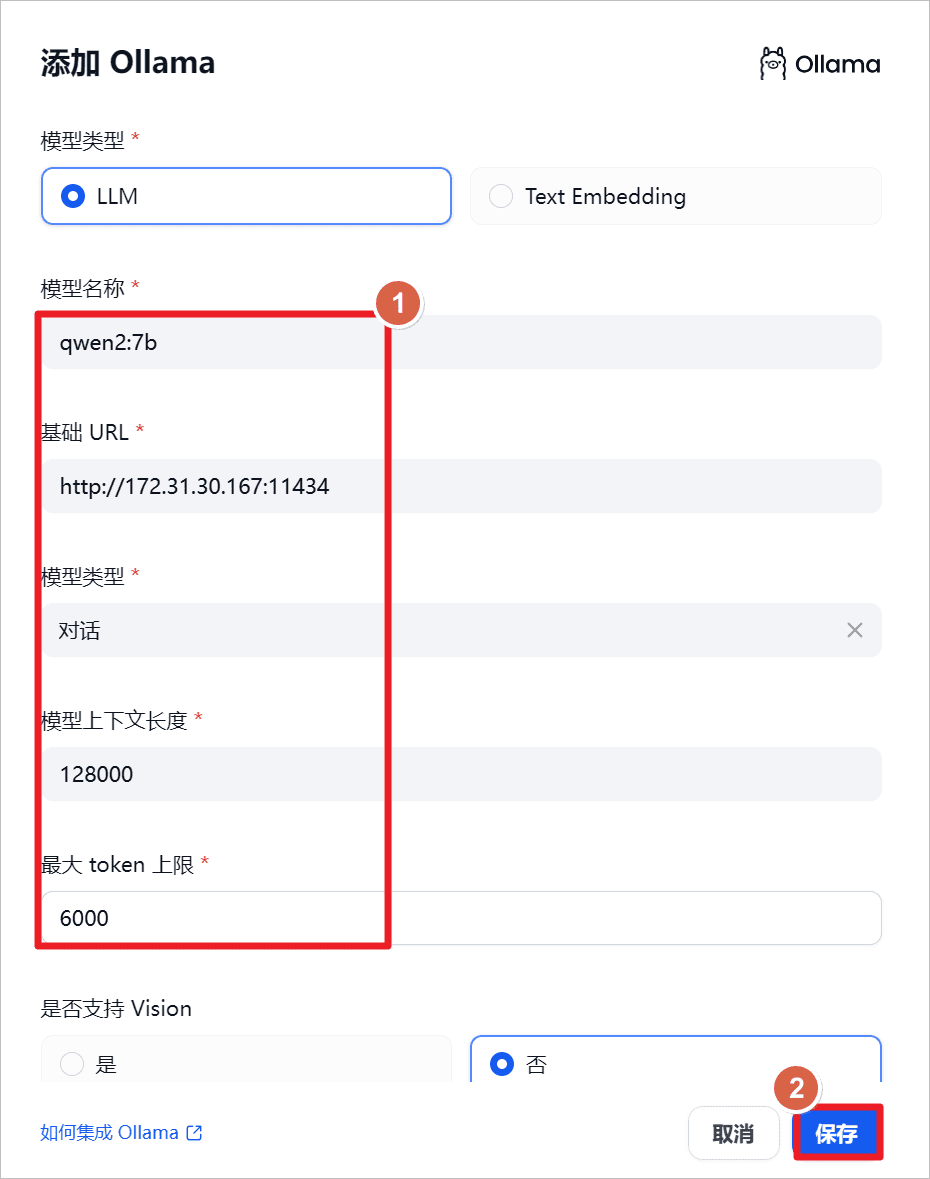

augmenterqwen2:7bpuisque Ollama est lancé localement, mettre l'URL à l'adresse IP locale et le port à l'adresse114341(math.) genre

"qwen2-7b-instruct prend en charge 131 072 tokens de contextes utilisant YARN, une technique d'extrapolation de la longueur du modèle augmenté, et afin de garantir une utilisation normale et une sortie correcte, il est recommandé que l'API limite l'entrée de l'utilisateur à 128 000 et la sortie à un maximum de 6 144[3].

"

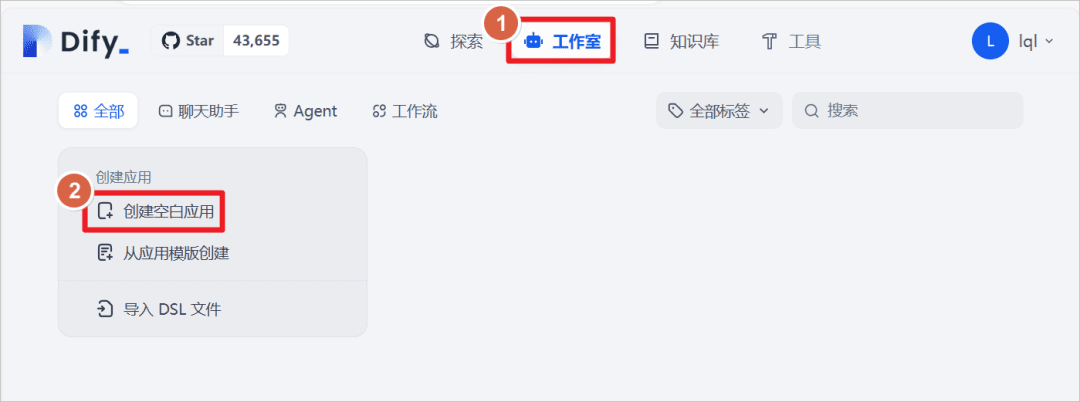

Cliquez sur Studio - Créer une application vierge

Créez une application de type "Chat Assistant" et donnez-lui le nom suivantQwen2-7B, cliquez sur Créer.

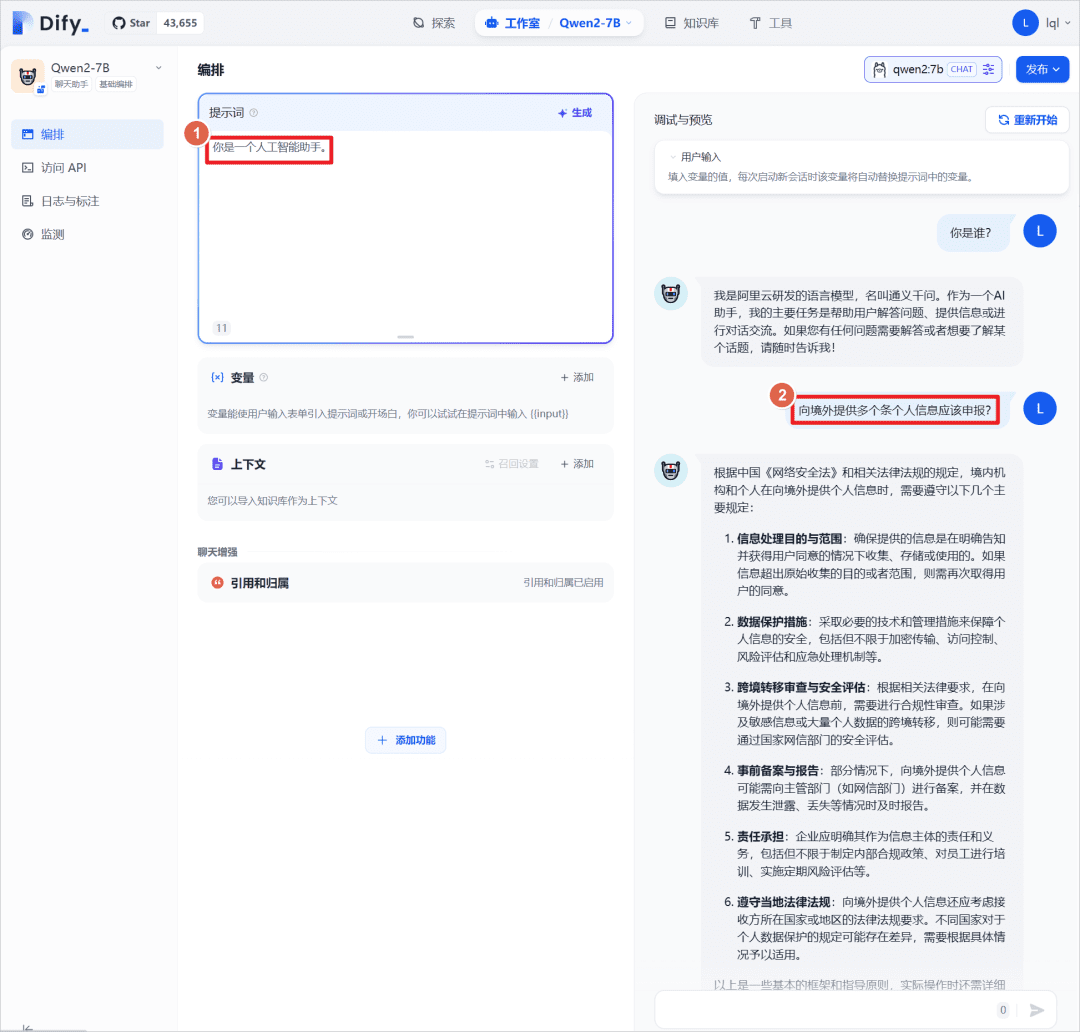

La définition de l'invite "Vous êtes un assistant IA" pour l'application peut être utilisée en conjonction avec l'option "Vous êtes un assistant IA" de l'application.Qwen2:7BEffectuer un test de dialogue, ici avec le grand modèle lui-même, sans introduire une base de connaissances externe, qui sera introduite plus tard pour comparer les résultats des réponses.

Quiz basé sur la base de connaissances de Dify

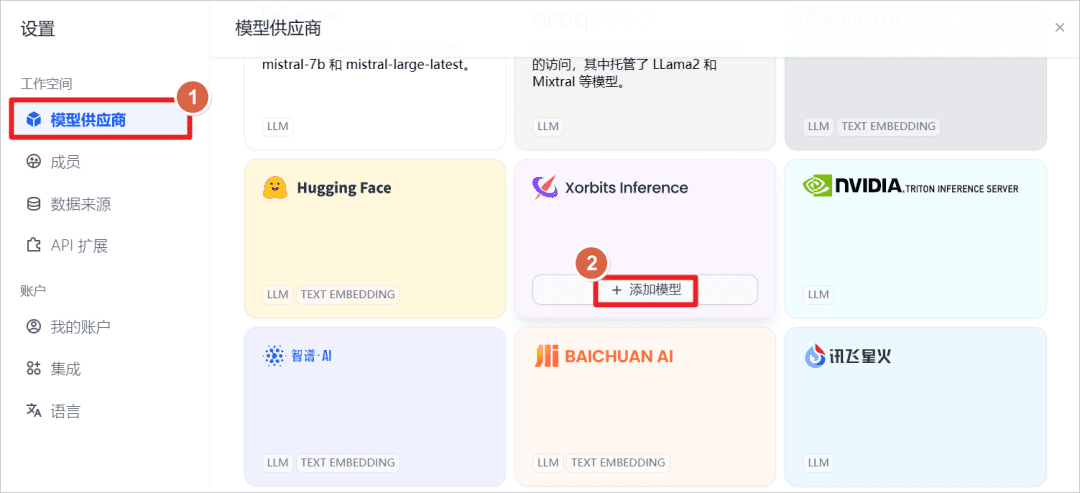

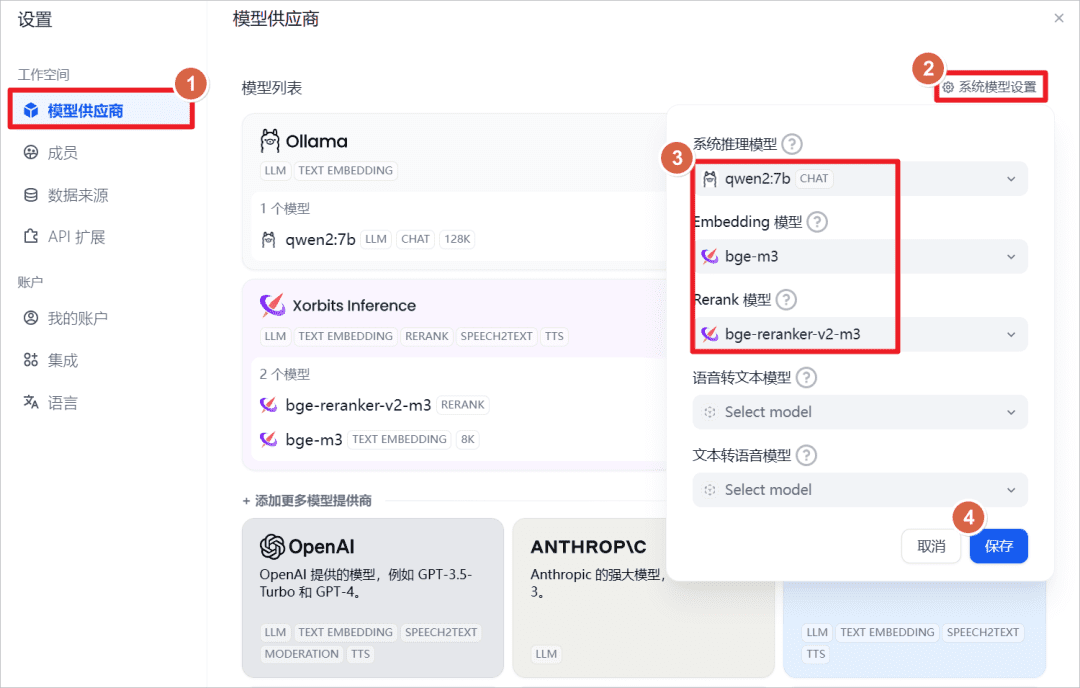

augmenterXorbits InferenceModèles fournis.

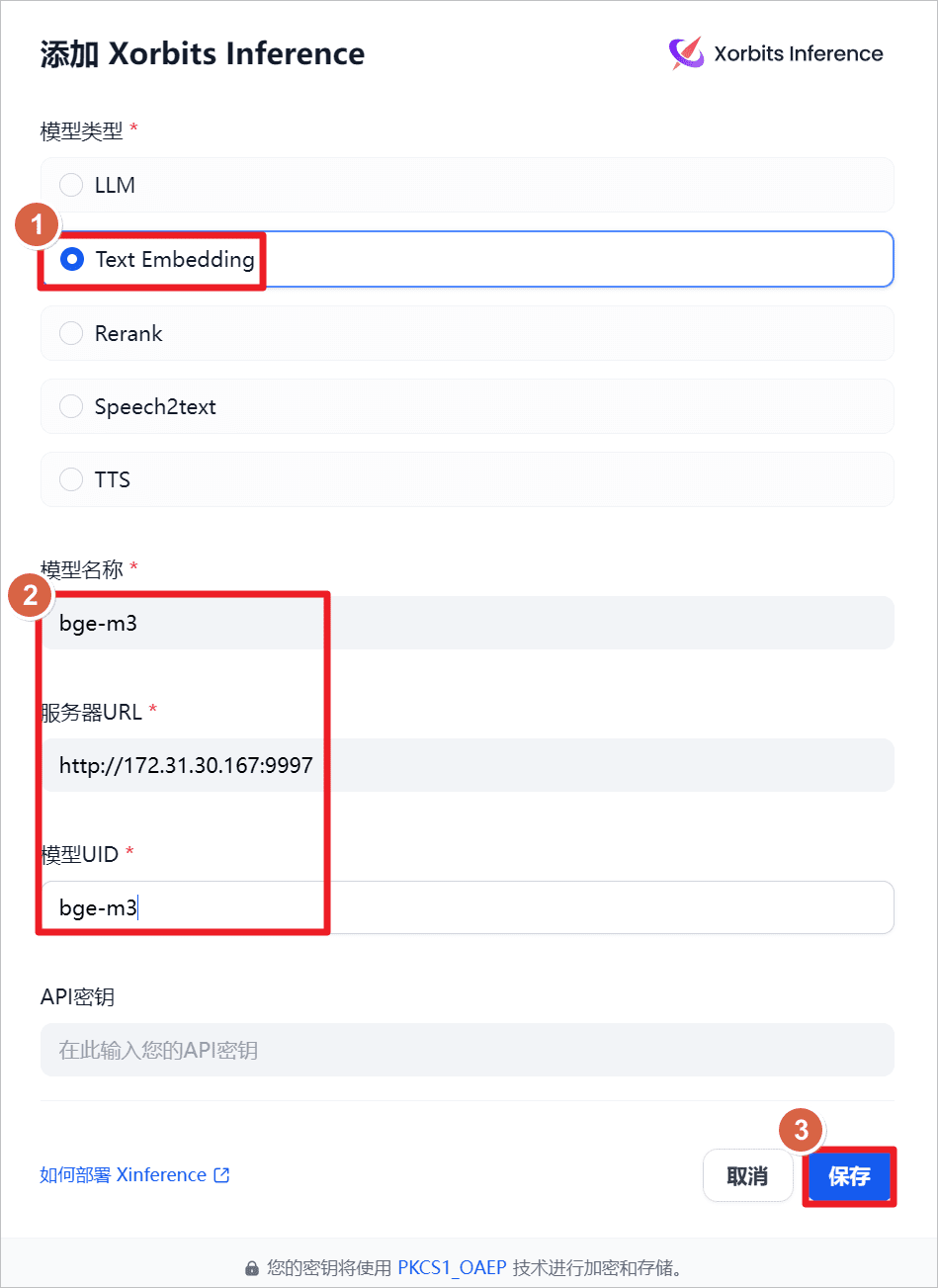

augmenterText Embeddingc'est-à-dire le modèle d'intégration de texte, le nom du modèle estbge-m3L'URL du serveur esthttp://172.31.30.167:9997(il s'agit de l'IP de la machine locale, il peut également être installé sur d'autres machines, il suffit que le réseau et le port soient accessibles), a démarré XInference sur la machine locale à l'avance, et a démarré l'applicationbge-m3(voir l'article précédent).

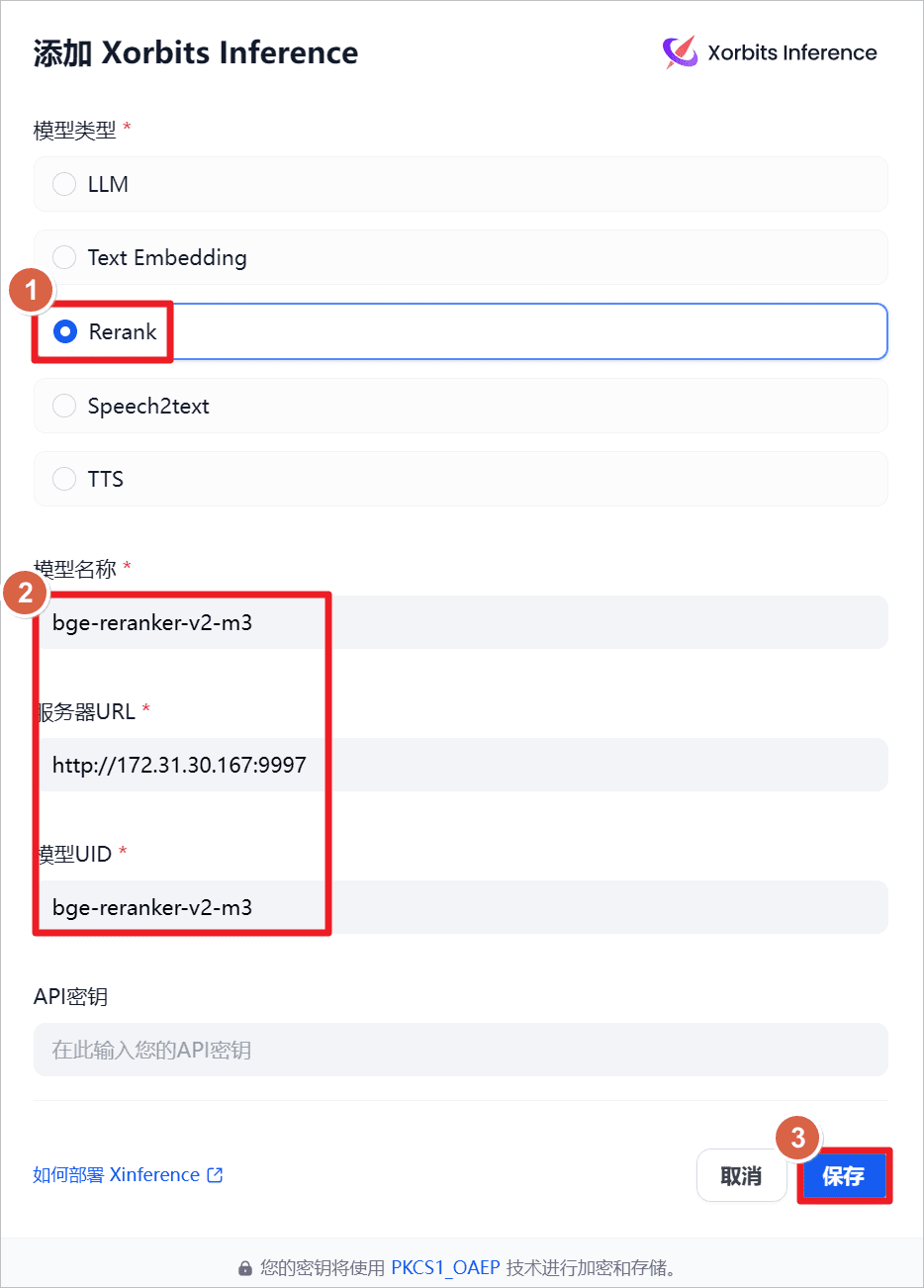

augmenterRerankc'est-à-dire le modèle de réarrangement, le nom du modèle estbge-reraker-v2-m3L'URL du serveur esthttp://172.31.30.167:9997(il s'agit de l'IP de la machine locale, il peut également être installé sur d'autres machines, il suffit que le réseau et le port soient accessibles), a démarré XInference sur la machine locale à l'avance, et a démarré l'applicationbge-reraker-v2-m3(voir l'article précédent).

Afficher les paramètres par défaut du système.

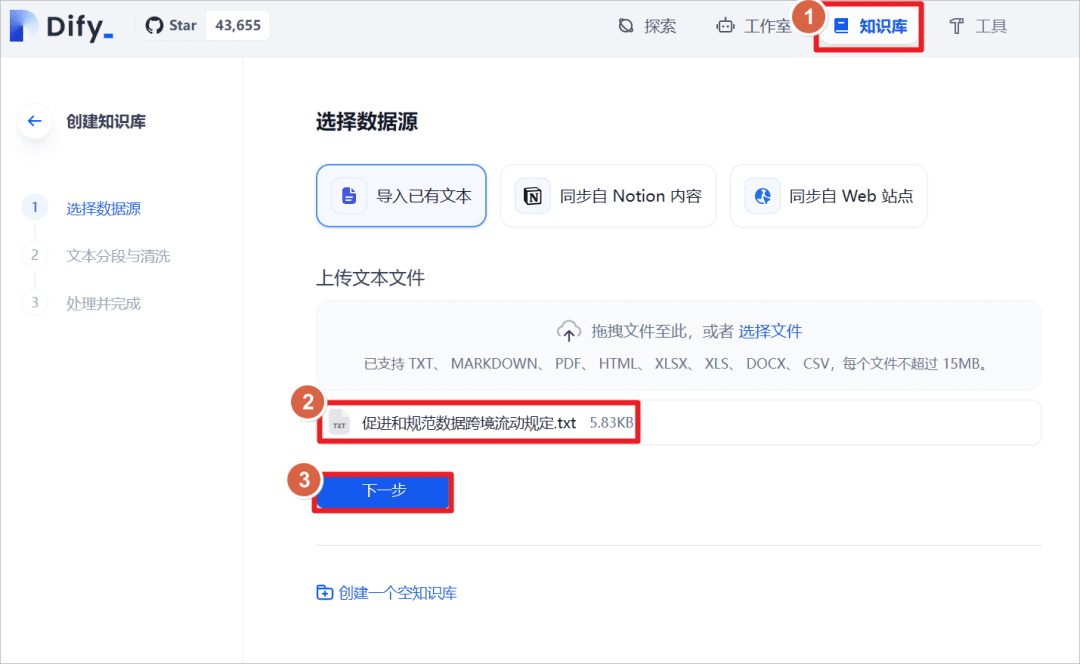

Cliquez sur "Base de connaissances" - "Importer un texte existant" - "Charger un fichier texte" - sélectionnez le document "Dispositions relatives à la facilitation et à la régulation du flux transfrontalier de données".

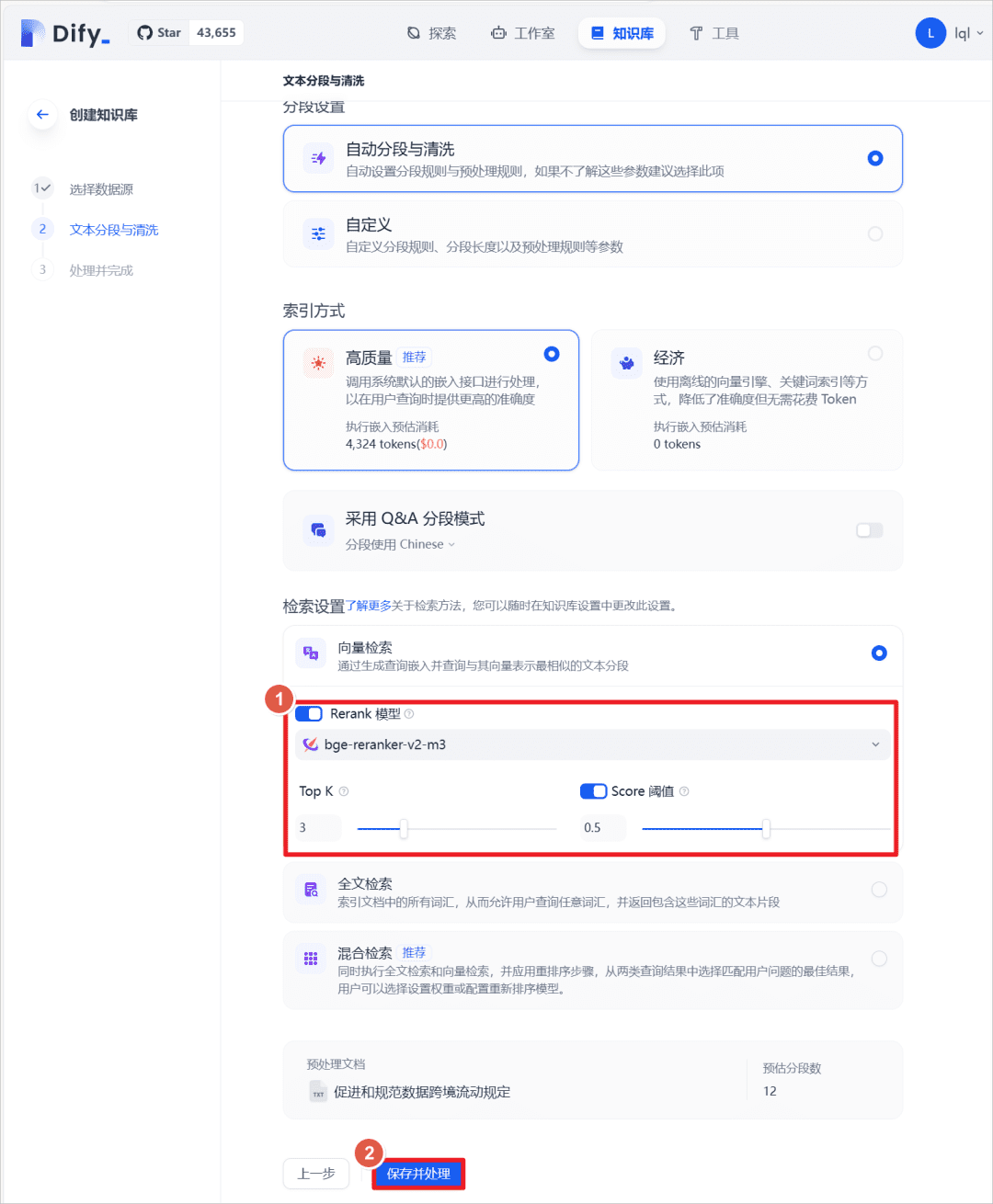

Une fois l'importation réussie, définissez la méthode d'extraction du texte et activez l'optionReranksélectionnerbge-reranker-v2-m3activer le modèle par défautScoreLe seuil est de 0,5 (c'est-à-dire que les correspondances de texte inférieures à un score de 0,5 ne sont pas rappelées et ne sont pas ajoutées au contexte du modèle plus large).

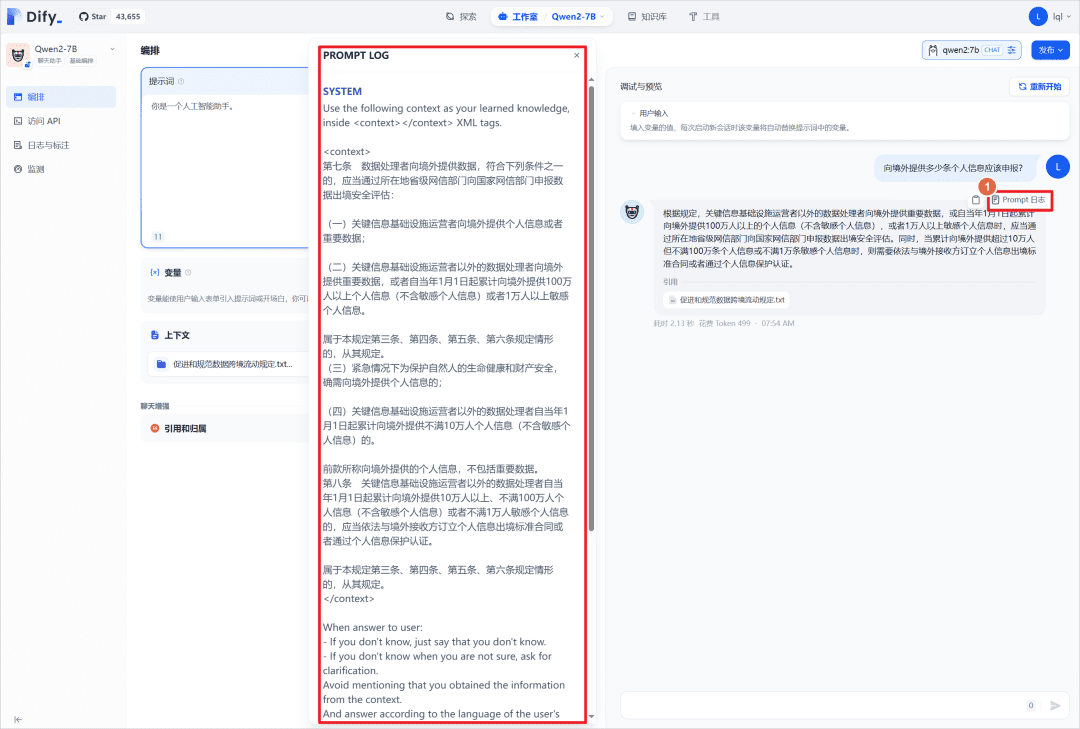

Dans l'application de chat précédente, ajoutez la base de connaissances créée ci-dessus et posez à nouveau la même question au grand modèle. Vous pouvez voir que le modèle a répondu en conjonction avec la base de connaissances.

Vous pouvez cliquer sur "Journal de l'invite" pour afficher le fichier journal, et vous pouvez afficher les invites du système, qui placent le contenu de la base de connaissances correspondante dans le fichier de la base de connaissances.<context></context>Au milieu.

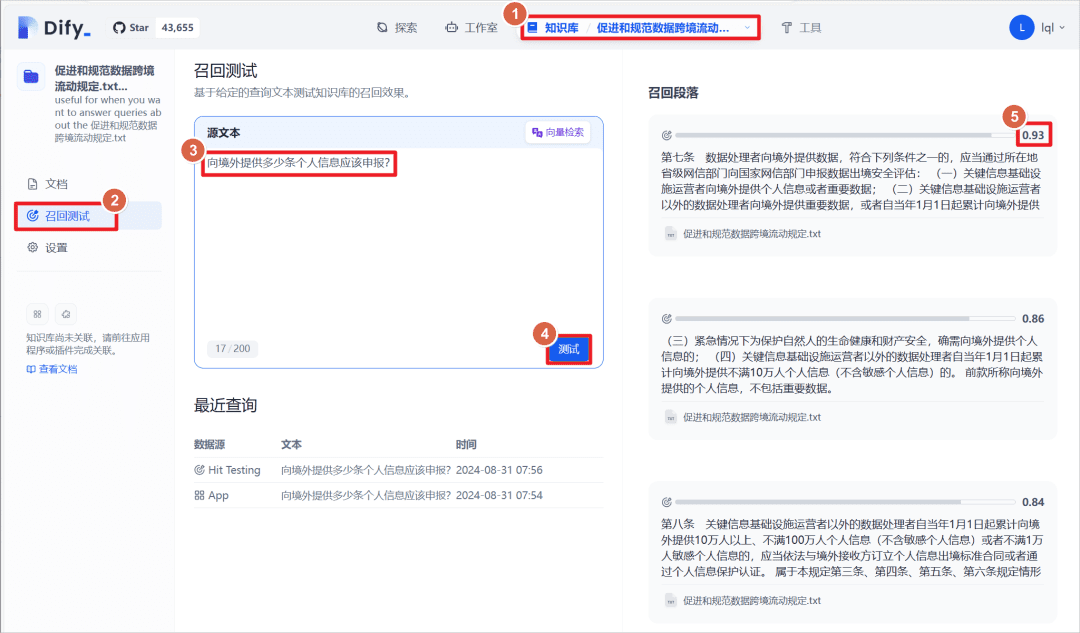

Cliquez sur la base de connaissances créée - cliquez sur le "test de rappel", vous pouvez entrer un paragraphe de texte pour faire correspondre le texte dans la base de connaissances avec le texte correspondant, le texte correspondant a un score de pondération, le seuil fixé ci-dessus est de 0,5, c'est-à-dire que, plus que ce score sera affiché en tant que "paragraphe de rappel ".

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...