AI full-stack tool open source ! Prenez avec Ollama+Qwen2.5-Code runbolt.new, un clic pour générer un site web !

Les outils de programmation d'IA ont connu un grand succès ces derniers temps, depuis Cursor, V0, Bolt.new et plus récemment Windsurf.

Dans ce billet, nous commencerons par parler de la solution open source - Bolt.new - qui a généré un chiffre d'affaires de 4 millions de dollars en seulement quatre semaines depuis que le produit a été mis en service.

Le site n'est pas très utileLimitation de la vitesse d'accès au territoire nationaletLe quota de jetons gratuits est limité.

La mission de Monkey consiste à déterminer comment l'exploiter localement afin que davantage de personnes puissent l'utiliser et accélérer la mise en place de l'IA.

L'action d'aujourd'hui.Vous emmène à travers un grand modèle déployé avec l'Ollama local, en conduisant le boulon.nouveauqui permet la programmation de l'IA Jeton Liberté.

1) Introduction à Bolt.new

Boulon.nouveau Il s'agit d'une plateforme de codage d'IA basée sur SaaS avec des intelligences sous-jacentes pilotées par LLM, combinée à la technologie WebContainers, qui permet le codage et l'exécution dans le navigateur, avec les avantages suivants :

- Prendre en charge simultanément le développement du front-end et du back-end. ;

- Visualisation de la structure des dossiers du projet. ;

- Environnement auto-hébergé avec installation automatique des dépendances (par exemple Vite, Next.js, etc.). ;

- Exécuter un serveur Node.js du déploiement à la production

BoulonL'objectif de .new est de rendre le développement d'applications web plus accessible à un plus grand nombre de personnes, de sorte que même les novices en programmation puissent concrétiser leurs idées par le biais d'un langage naturel simple.

Le projet a été officiellement mis en open source : https://github.com/stackblitz/bolt.new

Cependant, la source ouverte officielle bolt.new ne prend en charge qu'un nombre limité de modèles, et nombre de nos partenaires nationaux ne sont pas en mesure d'appeler l'API LLM d'outre-mer.

Il y a un dieu dans la communauté. bolt.new-any-llmLe soutien local est disponible. Ollama et nous vous proposons de découvrir ci-dessous les fonctionnalités de ce modèle.

2. déploiement local du code Qwen2.5

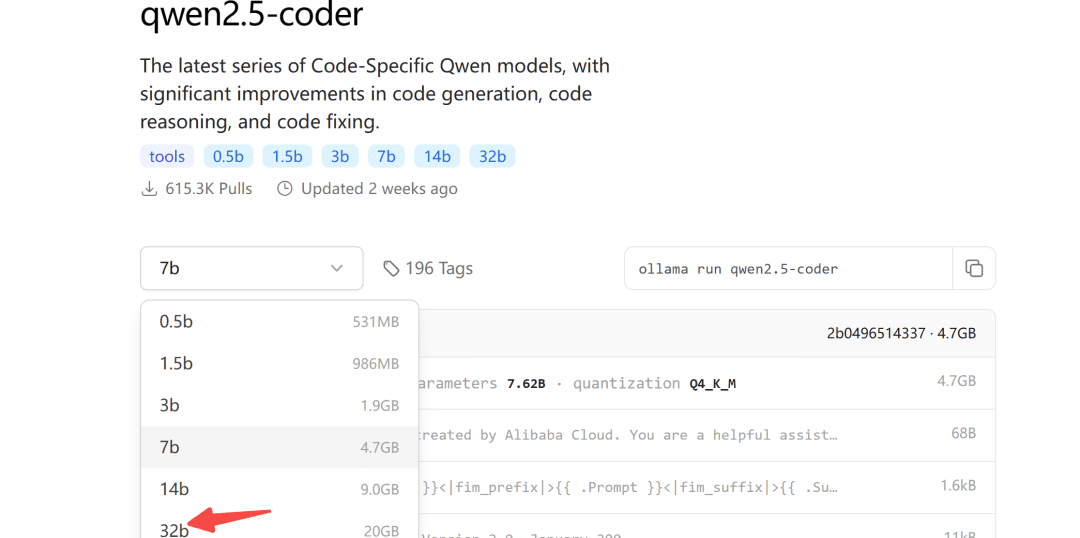

Il y a quelque temps, Ali a mis en libre accès la série de modèles Qwen2.5-Coder, dont le modèle 32B a obtenu les meilleurs résultats en libre accès dans plus de dix évaluations comparatives.

Il mérite d'être le modèle open source le plus puissant au monde, surpassant même le GPT-4o dans un certain nombre de capacités clés.

Le dépôt de modèles Ollama est également en ligne pour qwen2.5-coder :

Ollama est un outil facile à utiliser pour déployer de grands modèles.

2.1 Téléchargement du modèle

En ce qui concerne la taille du modèle à télécharger, vous pouvez la choisir en fonction de votre propre mémoire vidéo. Une mémoire vidéo d'au moins 24G est garantie pour le modèle 32B.

Nous le démontrons ci-dessous avec le modèle 7b :

ollama pull qwen2.5-coder

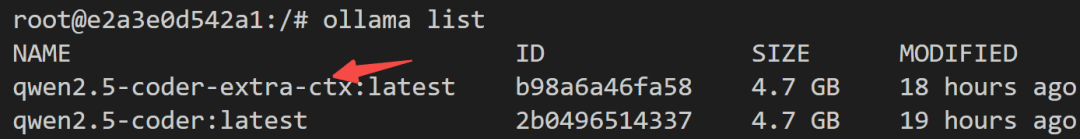

2.2 Modifications du modèle

Le résultat maximal par défaut d'Ollama étant de 4096 tokens, il est clairement insuffisant pour les tâches de génération de code.

Pour ce faire, les paramètres du modèle doivent être modifiés afin d'augmenter le nombre de jetons de contexte.

Tout d'abord, créez un nouveau fichier Modelfile et remplissez-le :

FROM qwen2.5-coder

PARAMETER num_ctx 32768

Ensuite, la transformation du modèle commence :

ollama create -f Modelfile qwen2.5-coder-extra-ctx

Après une conversion réussie, affichez à nouveau la liste des modèles :

2.3 Exécution du modèle

Enfin, vérifiez du côté du serveur si le modèle peut être appelé avec succès :

def test_ollama():

url = 'http://localhost:3002/api/chat'

data = {

"model": "qwen2.5-coder-extra-ctx",

"messages": [

{ "role": "user", "content": '你好'}

],

"stream": False

}

response = requests.post(url, json=data)

if response.status_code == 200:

text = response.json()['message']['content']

print(text)

else:

print(f'{response.status_code},失败')

S'il n'y a pas de problème, vous pouvez l'appeler dans bolt.new.

3. Bolt.new exécuté localement

3.1 Déploiement local

étape1Télécharger bolt.new-any-llm qui prend en charge les modèles locaux :

git clone https://github.com/coleam00/bolt.new-any-llm

étape2Copie des variables d'environnement : Faire une copie des variables d'environnement :

cp .env.example .env

étape3Modifier la variable d'environnement enOLLAMA_API_BASE_URLRemplacez-la par la vôtre :

# You only need this environment variable set if you want to use oLLAMA models

# EXAMPLE http://localhost:11434

OLLAMA_API_BASE_URL=http://localhost:3002

étape4Installation des dépendances (avec node installé localement)

sudo npm install -g pnpm # pnpm需要全局安装

pnpm install

étape5Fonctionnement en un seul clic

pnpm run dev

L'affichage de la sortie suivante indique que le démarrage a réussi :

➜ Local: http://localhost:5173/

➜ Network: use --host to expose

➜ press h + enter to show help

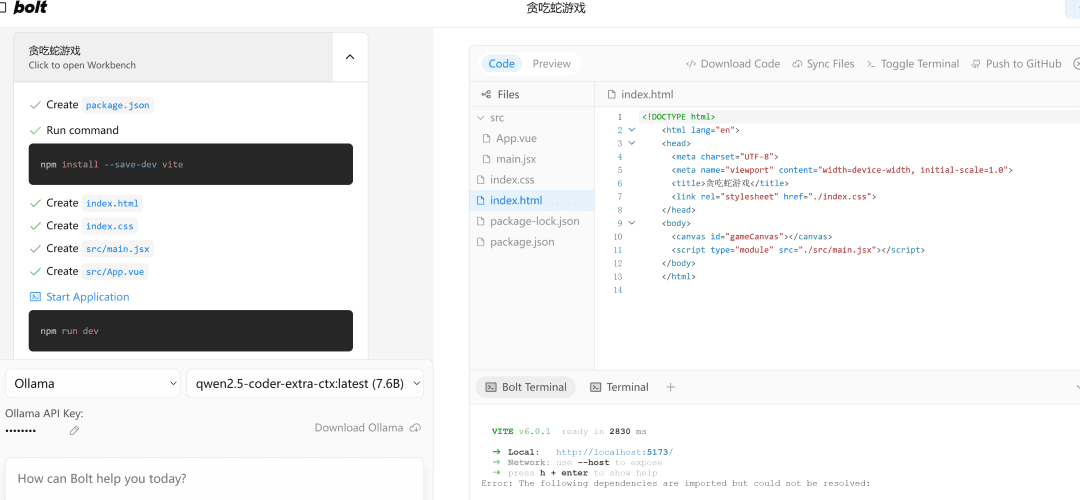

3.2 Démonstration des effets

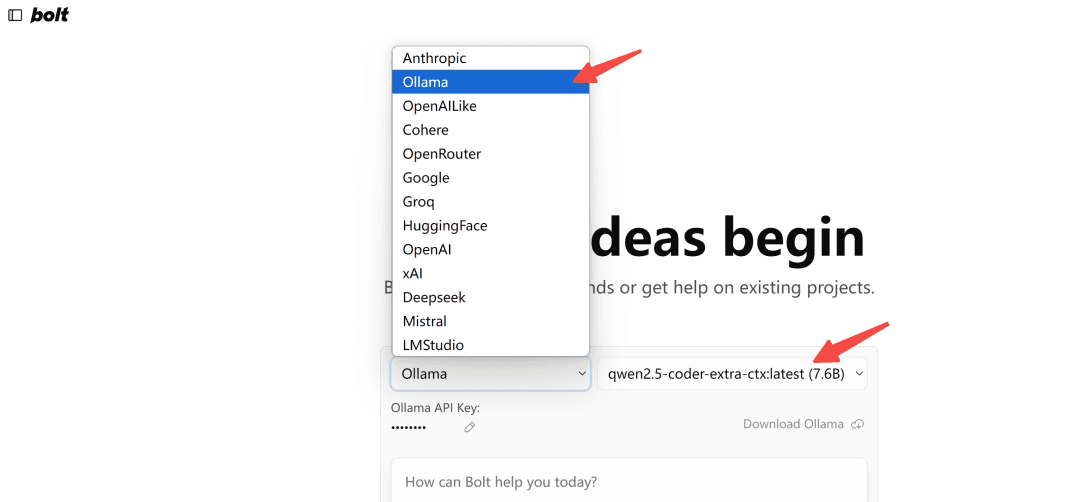

Ouvrir dans le navigateurhttp://localhost:5173/Le modèle de type Ollama est sélectionné :

Note : Lors du premier chargement, si le modèle n'apparaît pas dans Ollama, rafraîchissez-le plusieurs fois pour voir à quoi il ressemble.

Mettons-le à l'épreuve.

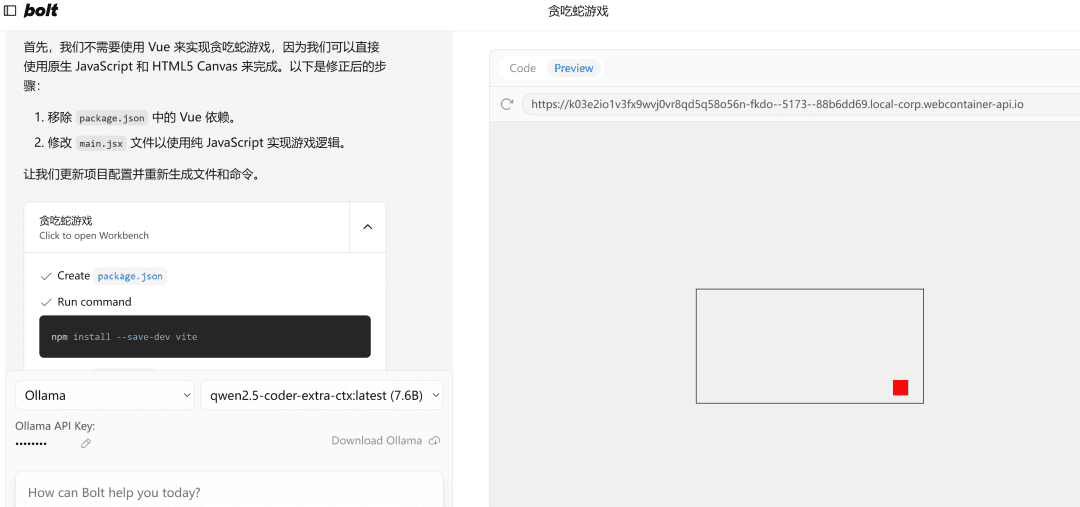

写一个网页端贪吃蛇游戏

A gauche.流程执行et, à droite, l'espace代码编辑au-dessous de laquelle se trouve la终端Domaine. Écrire du code, installer des dépendances, des commandes de terminal - l'IA fait tout cela pour vous !

S'il rencontre une erreur, il suffit de lui envoyer l'erreur, de l'exécuter à nouveau, et s'il n'y a pas de problème, le côté droitPreviewLa page s'ouvrira avec succès.

Note : Comme l'exemple utilise un petit modèle 7b, si nécessaire, vous pouvez essayer d'utiliser un modèle 32b, l'effet sera considérablement amélioré.

écrire à la fin

Cet article vous présente un déploiement local du modèle de code qwen2.5 et une utilisation réussie de l'outil de programmation de l'IA bolt.new.

L'utiliser pour développer le projet front-end est encore assez puissant, bien sûr, pour bien l'utiliser, connaître quelques concepts front-end et back-end de base, sera deux fois plus efficace.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...