AI College of Engineering : évaluation des systèmes 2.5 RAG

bref

L'évaluation est un élément clé du développement et de l'optimisation des systèmes de Génération Augmentée de Récupération (GAR). L'évaluation implique un examen des RAG Tous les aspects du processus sont mesurés en termes de performance, de précision et de qualité, y compris la pertinence et l'authenticité, depuis l'efficacité de la recherche jusqu'à la génération de la réponse.

Importance de l'évaluation RAG

Une évaluation efficace du système RAG est importante parce qu'elle :

- Permet d'identifier les forces et les faiblesses du processus d'extraction et de génération.

- Guider l'amélioration et l'optimisation de l'ensemble du processus RAG.

- Veiller à ce que le système réponde aux normes de qualité et aux attentes des utilisateurs.

- Facilite la comparaison de différentes mises en œuvre ou configurations de RAG.

- Permet de détecter des problèmes tels que des hallucinations, des préjugés ou des réponses non pertinentes.

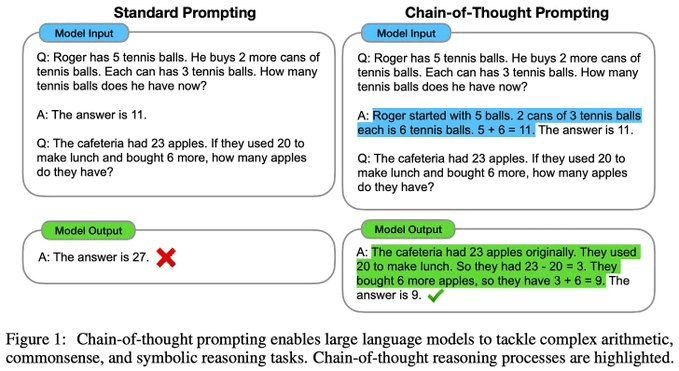

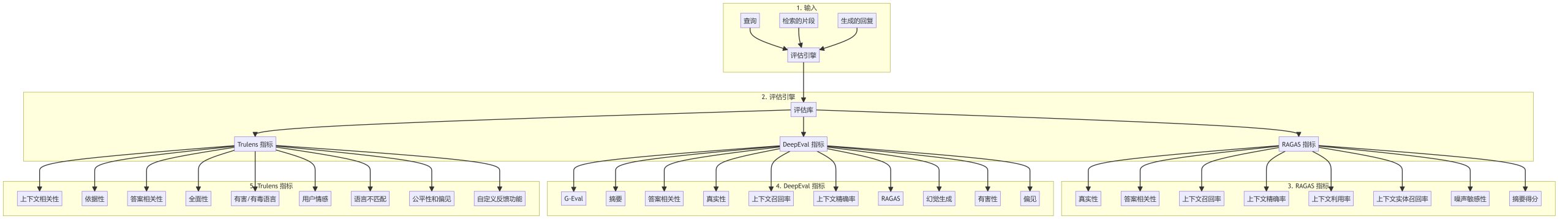

Processus d'évaluation RAG

L'évaluation d'un système RAG comprend généralement les étapes suivantes :

Indicateurs d'évaluation de base

Indicateurs RAGAS

- validitéLa cohérence de la réponse générée avec le contexte d'extraction : mesure la cohérence de la réponse générée avec le contexte d'extraction.

- Pertinence des réponsesLes réponses à la requête : évaluer la pertinence de la réponse par rapport à la requête.

- rappel de contexte (informatique)Les informations extraites de la base de données sont ensuite analysées pour déterminer si elles couvrent les informations nécessaires pour répondre à la demande de renseignements.

- Précision contextuelle: Mesure de la proportion d'informations pertinentes dans les morceaux retrouvés.

- Utilisation du contexteLes réponses aux questions de l'évaluation : Évaluer l'efficacité avec laquelle la réponse générée utilise le contexte fourni.

- rappel d'entités contextuellesLa réponse à la question de savoir si les entités importantes du contexte sont couvertes par la réponse.

- sensibilité au bruitLe système d'information sur la santé (SIS) est une mesure de la robustesse d'un système face à des informations non pertinentes ou bruyantes.

- Score abstraitLa qualité du résumé de la réponse : évaluer la qualité du résumé de la réponse.

Indicateurs DeepEval

- G-EvalLe projet de loi sur la protection des droits de l'homme et des libertés fondamentales a été adopté par l'Assemblée nationale.

- résumésLes résultats de l'évaluation de la qualité des résumés de texte : évaluer la qualité des résumés de texte.

- Pertinence des réponses: Mesure de la qualité de la réponse apportée à la requête.

- validitéLes résultats de l'évaluation de la qualité de la réponse et de l'information de base : évaluer l'exactitude de la réponse et de l'information de base.

- Rappel et précision contextuels: Mesure de l'efficacité de la recherche contextuelle.

- Détection des hallucinationsLes réponses à des questions sont souvent fausses ou inexactes.

- toxicologiqueDétecter les contenus potentiellement nuisibles ou offensants dans la réponse.

- biaisIdentifier les préférences ou les tendances injustes dans le contenu généré.

Indicateurs Trulens

- pertinence contextuelleLe contexte d'extraction : évaluer dans quelle mesure le contexte d'extraction correspond à la requête.

- mis à la terreLa réponse à la question de savoir si la réponse est étayée par les informations extraites est une mesure qui permet de savoir si la réponse est étayée par les informations extraites.

- Pertinence des réponsesLa qualité de la réponse : évaluer la qualité de la réponse à la requête.

- exhaustivité: Mesure l'exhaustivité de la réponse.

- Langage préjudiciable/offensifIdentifier les contenus potentiellement offensants ou dangereux.

- sentiment des utilisateurs: Analyse de la tonalité émotionnelle dans les interactions avec les utilisateurs.

- incompatibilité linguistiqueDétecter les incohérences dans l'utilisation de la langue entre la requête et la réponse.

- Équité et partialitéLe traitement équitable des différents groupes dans le système : évaluer le traitement équitable des différents groupes dans le système.

- Fonctions de retour d'information personnaliséesLe système d'évaluation de la qualité : permet de développer des mesures d'évaluation personnalisées pour des cas d'utilisation spécifiques.

Bonnes pratiques pour l'évaluation du RAG

- Évaluation globaleLe système RAG : Combinaison de plusieurs indicateurs pour évaluer différents aspects du système RAG.

- Analyse comparative régulièreLes systèmes de gestion de l'information : évaluer en permanence le système au fur et à mesure que les processus évoluent.

- Participation humaineAnalyse complète combinant des évaluations manuelles et des indicateurs automatisés.

- Indicateurs spécifiques à un domaineLes mesures de la qualité de l'air : développer des mesures personnalisées liées à des cas d'utilisation ou à des domaines spécifiques.

- analyse des erreursLes élèves doivent être en mesure d'analyser les tendances dans les réponses mal notées et d'identifier les domaines à améliorer.

- Évaluation comparativeL'analyse comparative de votre système RAG par rapport à des modèles de référence et à d'autres mises en œuvre.

rendre un verdict

Un cadre d'évaluation solide est essentiel au développement et à la maintenance d'un système RAG de haute qualité. En utilisant un large éventail de mesures et en suivant les meilleures pratiques, les développeurs peuvent s'assurer que leur système RAG fournit des réponses précises, pertinentes et crédibles, tout en améliorant continuellement les performances.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...