¿Cuál es la mejor versión para ejecutar los modelos grandes de DeepSeek-R1 con una tarjeta gráfica RTX 4090?

Ejecutando DeepSeek-R1 con una tarjeta gráfica RTX 4090.Preferencia recomendada para la versión Q4_K_M quantised 671B full-bloodedseguido de una versión cuantificada de 14B o 32B, siempre y cuando se base en KTransformers, y si es un coñazo aprenderse el programa Desenredar Se introdujo una versión cuantitativa, y aquí hay otra Ollama Tutorial de instalación DeepSeek R1 671B Tutorial de despliegue local: basado en Ollama y cuantificación dinámicaDepende de si sus necesidades son de "potencia extrema" o de "más velocidad". Depende de si tus necesidades son de "potencia extrema" o de "más velocidad".

1️⃣ RTX 4090 La versión completa (671B) también funciona?

¡Sí! El equipo de Tsinghua KTransformers Deja que una sola tarjeta gráfica 4090 ejecute la versión completa.

- Requisitos de memoria VGAEl Q4_K_M Quantised Edition sólo necesita 14 GB de memoria de vídeo, y los 24 GB del 4090 son perfectamente suficientes.

- paso: Las velocidades de preprocesamiento de hasta 286 palabras/segundo y las velocidades de generación de unas 14 palabras/segundo ya son demasiado para el ciudadano medio.

- Escenario: Tareas que requieren un razonamiento complejo, como escribir código, diálogos de varias rondas.

2️⃣ ¿Si es demasiado lento? Pruebe con una versión más pequeña

Si 14 palabras/segundo le parece demasiado lento, puede elegir un modelo más pequeño:

- 14B versión cuantificada: El requisito de memoria gráfica es de unos 6,5 GB, lo que genera velocidades más rápidas para la escritura y traducción diarias.

- 32B versión cuantificada: Requiere 14,9 GB de memoria de vídeo y admite el procesamiento de textos largos (por ejemplo, el análisis de artículos enteros).

3️⃣ ¿Por qué corre en su lugar la versión completa?

He aquí un truco técnico:Descarga cuantitativa + computacional.

- cuantificableLa "compresión" del modelo a un tamaño más pequeño, por ejemplo, la cuantificación de 4 bits (Q4) reduce la huella de memoria en 70%.

- Calcular la descarga: Deja que la CPU se encargue de las tareas de cálculo sin importancia y deja que la GPU haga lo que mejor sabe hacer.

4️⃣ Comparación con otras soluciones gráficas

De nuevo, ejecuta la versión completa:

- Clúster gráfico H100El coste es de cientos de miles de dólares y es más rápido, pero no asequible para el ciudadano medio.

- tarjeta gráfica propia: La compatibilidad no es suficiente y es fácil pisar el charco.

llegar a un veredictoLa 4090 es, con diferencia, la opción más rentable.

5️⃣ Consejos de implantación

- gasto o desembolso

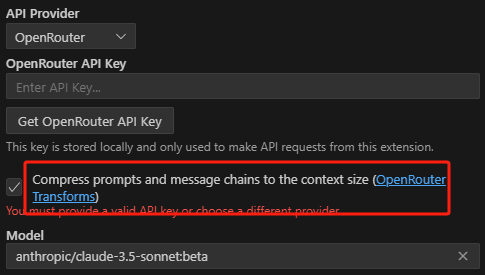

KTransformersEl marco puede desplegarse con un solo clic y viene con la misma interfaz que ChatGPT. - Si te estás quedando sin memoria, puedes probar el modo "activar sólo 6 expertos", que es un poco más rápido.

Para la IA más inteligente elige el 671B Quantized, para un diálogo fluido elige el 14B/32B, ¡el 4090 lo tiene todo!

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...