XTuner V1 - Motor de entrenamiento de grandes modelos de código abierto de Shanghai AI Lab

Últimos recursos sobre IAPublicado hace 6 meses Círculo de intercambio de inteligencia artificial 33.4K 00

¿Qué es XTuner V1?

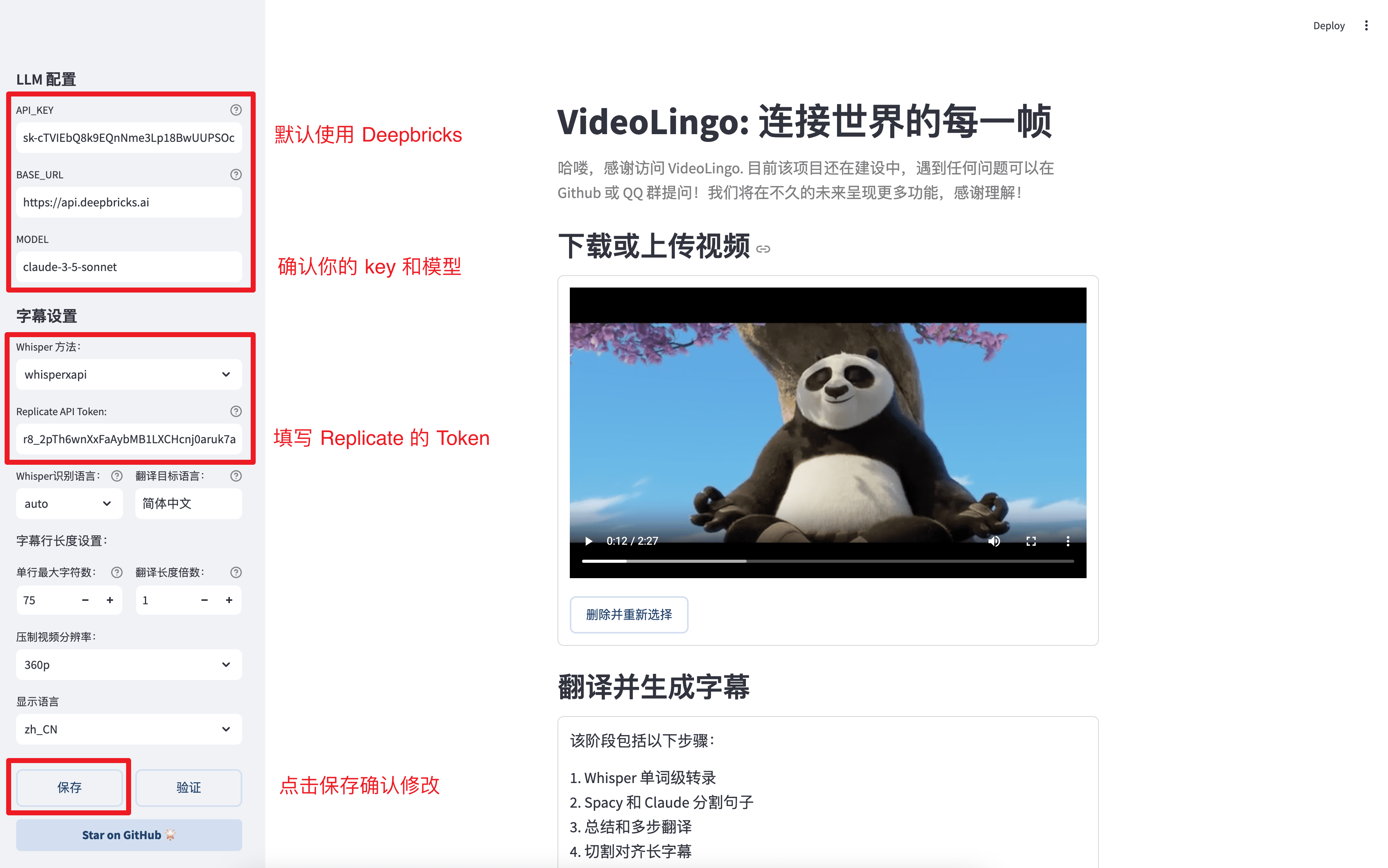

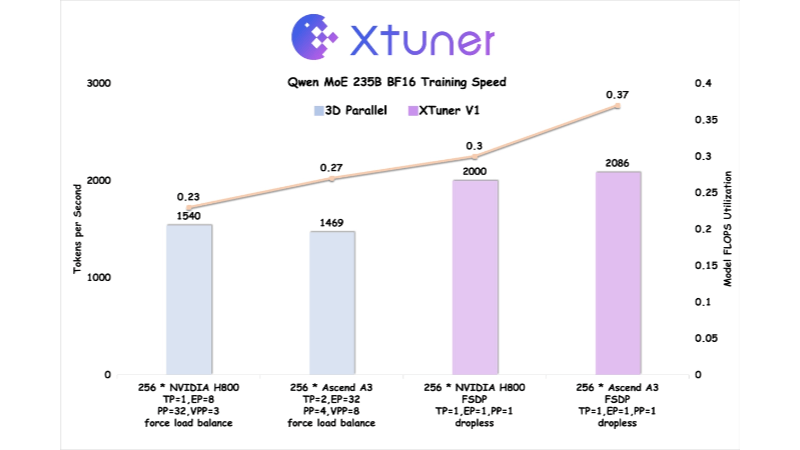

XTuner V1 es un motor de entrenamiento de modelos de gran tamaño de nueva generación y de código abierto del Laboratorio de Inteligencia Artificial de Shanghái, diseñado para el entrenamiento de modelos de Expertos Mixtos (MoE) dispersos a gran escala. Desarrollado sobre la base de PyTorch FSDP, XTuner V1 logra un entrenamiento de alto rendimiento mediante la optimización multidimensional de la memoria, la comunicación y la carga, etc. XTuner V1 admite el entrenamiento de modelos MoE con hasta 1 billón de parámetros, y por primera vez supera la solución paralela 3D tradicional en términos de rendimiento de entrenamiento en modelos de más de 200.000 millones de escalas. Admite el entrenamiento de secuencias largas de 64k sin tecnología de paralelismo de secuencias, lo que reduce significativamente la dependencia del paralelismo experto y mejora la eficiencia del entrenamiento de secuencias largas.

Características de XTuner V1

- formación no destructivaLos modelos MoE a escala de 200.000 millones pueden entrenarse sin paralelismo experto, y los modelos de 600.000 millones sólo requieren paralelismo experto en el nodo.

- Soporte para secuencias largasAdmite el entrenamiento de secuencias de 64 k de longitud de 200.000 millones de modelos MoE sin paralelismo de secuencias.

- alto rendimientoAdmite el entrenamiento de modelos MoE con 1 billón de parámetros y un rendimiento de entrenamiento de modelos superior a 200.000 millones en comparación con el paralelismo 3D tradicional.

- Optimización de la memoria de vídeoReduce los picos de memoria gráfica mediante el mecanismo automático Chunk Loss y la tecnología Async Checkpointing Swap.

- cobertura de comunicaciones: Enmascara el consumo de tiempo de comunicación mediante la optimización de la memoria y la tecnología Intra-Node Domino-EP.

- Equilibrio de carga DP: Mitigar el problema de la burbuja vacía computacional causada por la atención de longitud variable y mantener el equilibrio de carga en la dimensión paralela de los datos.

- Cooptimización del hardware: Optimizado en Ascend A3 NPU supernode en colaboración con Huawei Rise, la eficiencia de entrenamiento supera a NVIDIA H800.

- Código abierto y compatibilidad con cadenas de herramientas: XTuner V1, DeepTrace y ClusterX de código abierto, que proporcionan una gama completa de soporte.

Principales ventajas de XTuner V1

- Formación eficazAdmite el entrenamiento de modelos MoE para hasta 1 billón de parámetros, con un rendimiento de entrenamiento que supera el de las soluciones 3D paralelas tradicionales para modelos a escala de más de 200.000 millones.

- Procesamiento de secuencias largas: entrenamiento de secuencias de 64k de longitud de 200 mil millones de modelos MoE sin paralelismo de secuencias, adecuado para escenarios de procesamiento de textos largos como el aprendizaje por refuerzo.

- baja necesidad de recursos200.000 millones de modelos paramétricos no requieren paralelismo experto, y 600.000 millones de modelos sólo requieren paralelismo experto en el nodo, lo que reduce las necesidades de recursos de hardware.

- Optimización de la memoria de vídeoLa última incorporación al sistema es una nueva tecnología que reduce significativamente los picos de memoria y admite el entrenamiento de modelos más grandes mediante un mecanismo automático de pérdida de trozos y la tecnología Async Checkpointing Swap.

- optimización de las comunicacionesReducir el impacto de la sobrecarga de comunicación en la eficiencia del entrenamiento enmascarando el consumo de tiempo de comunicación mediante la optimización de la memoria y técnicas Intra-Node Domino-EP.

- equilibrio de carga: Mitigar el problema de la burbuja nula computacional causada por la atención de longitud variable, garantizar el equilibrio de la carga en la dimensión paralela de los datos y mejorar la eficacia de la formación.

¿Cuál es la web oficial de XTuner V1?

- Página web del proyecto:: https://xtuner.readthedocs.io/zh-cn/latest/

- Repositorio GitHub:: https://github.com/InternLM/xtuner

Personas a las que va dirigido XTuner V1

- Grandes investigadores modeloXTuner V1 ofrece un motor de entrenamiento de alto rendimiento que permite entrenar modelos con hasta un billón de parámetros a los investigadores que necesitan entrenar modelos Mixed Expertise (MoE) dispersos a gran escala.

- Ingeniero de aprendizaje profundoPara los ingenieros que trabajan en formación distribuida a gran escala, XTuner V1 ofrece funciones optimizadas de comunicación y gestión de memoria para mejorar significativamente la eficacia de la formación.

- Desarrolladores de infraestructuras de IAPara los desarrolladores centrados en la cooptimización del hardware y la informática de alto rendimiento, XTuner V1 trabaja con el equipo de tecnología Rise de Huawei para proporcionar optimizaciones profundas específicas del hardware.

- Colaboradores de la Comunidad de Código AbiertoEl código fuente abierto de XTuner V1 ofrece numerosas posibilidades de desarrollo y optimización a los desarrolladores interesados en proyectos de código abierto que deseen contribuir.

- Equipo de IA empresarialXTuner V1 proporciona un soporte de cadena de herramientas fácil de usar y de alto rendimiento para equipos empresariales que necesitan una solución eficaz y de bajo umbral para entrenar modelos de gran tamaño.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...