XRAG: una herramienta de evaluación visual para optimizar los sistemas de generación de mejoras de la recuperación

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 55.8K 00

Introducción general

XRAG (eXamining the Core) es un marco de evaluación comparativa diseñado para evaluar los componentes subyacentes de los sistemas avanzados de generación de aumento de la recuperación (RAG). Mediante el perfilado y análisis de cada módulo central, XRAG proporciona información sobre cómo afectan las distintas configuraciones y componentes al rendimiento global de un sistema RAG. El marco admite múltiples métodos de recuperación y métricas de evaluación y está diseñado para ayudar a investigadores y desarrolladores a optimizar y mejorar todos los aspectos de los sistemas RAG.

XRAG es compatible con la evaluación completa de RAG Benchmark y Toolkit, que cubre más de 50 métricas de prueba y evaluación completa de RAG y optimización de puntos de fallo, soporta la comparación de 4 tipos de módulos RAG avanzados (Reconstrucción de consultas, Recuperación avanzada, Modelos de preguntas y respuestas, y Post-procesamiento), integra múltiples implementaciones específicas dentro de los módulos, y es compatible con OpenAI Big Model API. La versión 1.0 de XRAG también ofrece una sencilla demostración de interfaz de usuario web, una ligera carga interactiva de datos y un formato estándar unificado, e integra métodos de detección de fallos y optimización de RAG. El artículo y el código son ahora de código abierto.

Lista de funciones

- Marco integrado de evaluación: Soporte para evaluaciones multidimensionales, incluyendo evaluaciones basadas en LLM, evaluaciones en profundidad y métricas tradicionales.

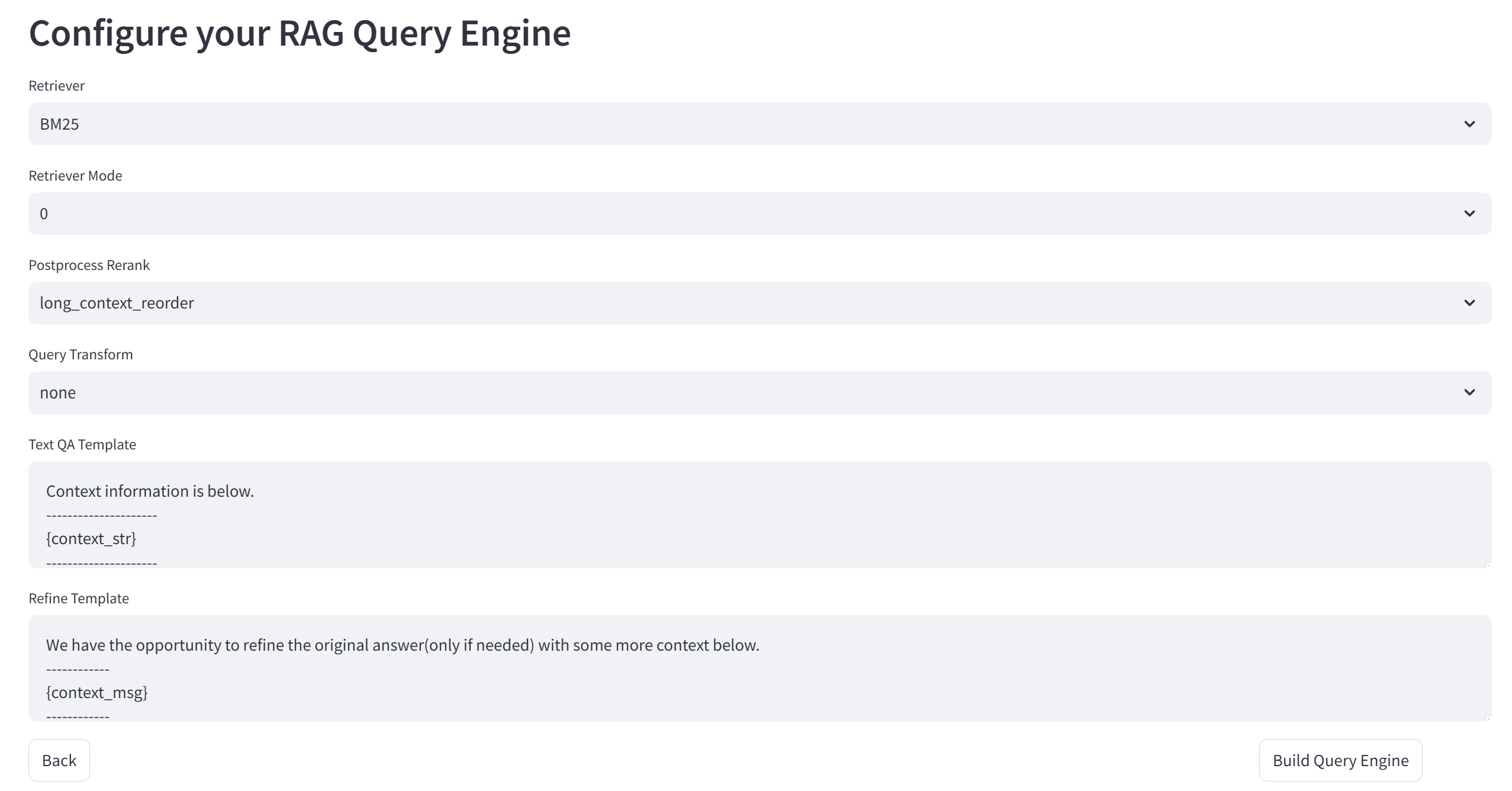

- Arquitectura flexible: Diseño modular para admitir múltiples métodos de búsqueda y estrategias de búsqueda personalizadas.

- Soporte Multi-LLMIntegración perfecta con modelos OpenAI y compatibilidad con modelos nativos (por ejemplo, Qwen, LLaMA, etc.).

- Amplio conjunto de indicadores de evaluación:: Incluye métricas tradicionales (F1, EM, MRR, etc.) y métricas basadas en LLM (veracidad, relevancia, etc.).

- Métodos de búsqueda avanzadaSoporte BM25, búsqueda semántica vectorial, búsqueda en estructura de árbol y otros métodos de búsqueda.

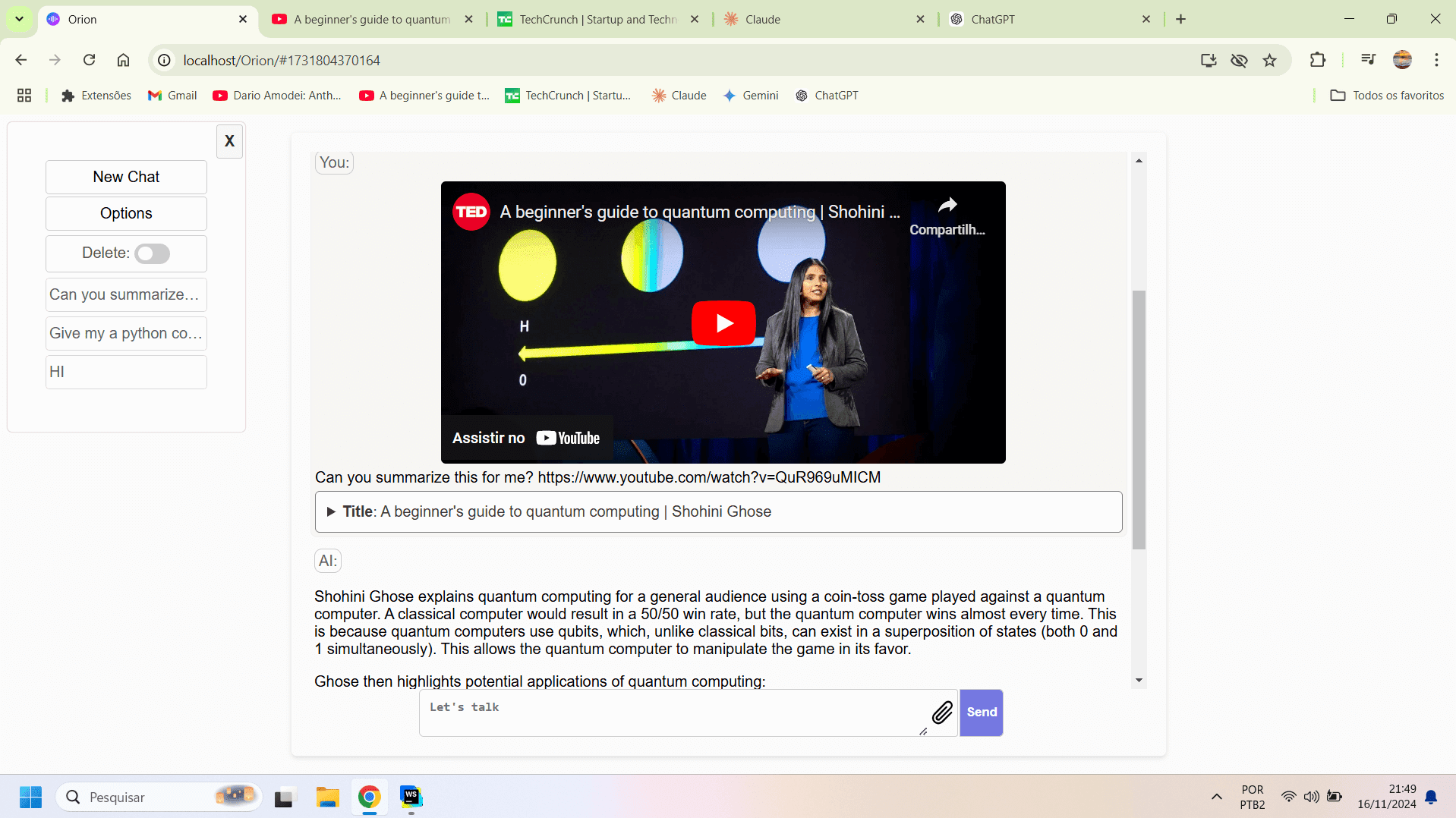

- interfaz fácil de usarInterfaz de línea de comandos e interfaz de usuario web para la evaluación y visualización interactivas.

Utilizar la ayuda

Proceso de instalación

- almacén de clones::

git clone https://github.com/DocAILab/XRAG.git

cd XRAG

- Instalación de dependencias::

pip install -r requirements.txt

- Entorno de configuración: Modificado según las necesidades

config.tomlpara configurar los parámetros del modelo y los ajustes de la API.

Normas de uso

- Iniciar la interfaz web::

xrag-cli webui

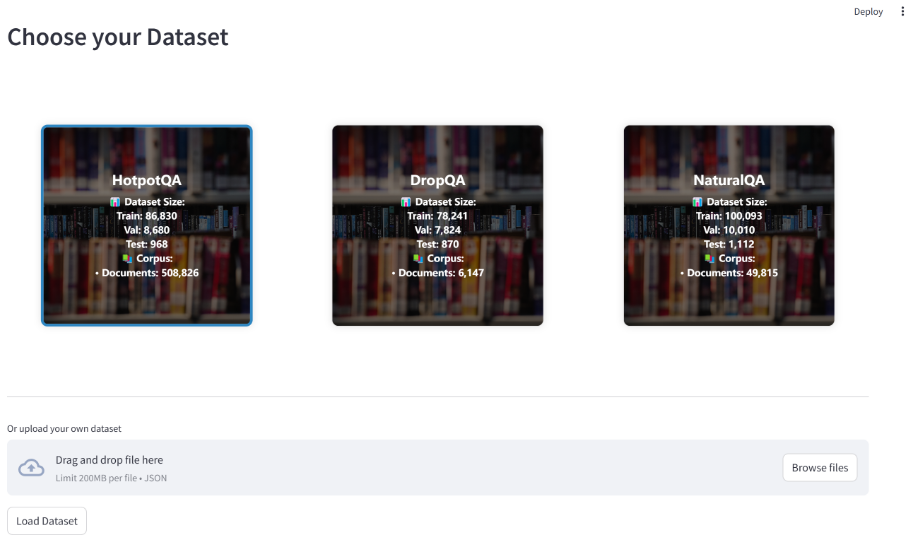

Carga y configuración de conjuntos de datos a través de la interfaz web, compatible con varios conjuntos de datos de referencia (por ejemplo, HotpotQA, DropQA, NaturalQA).

- Evaluación operativaEjecute la evaluación utilizando la herramienta de línea de comandos:

xrag-cli evaluate --dataset <dataset_path> --config <config_path>

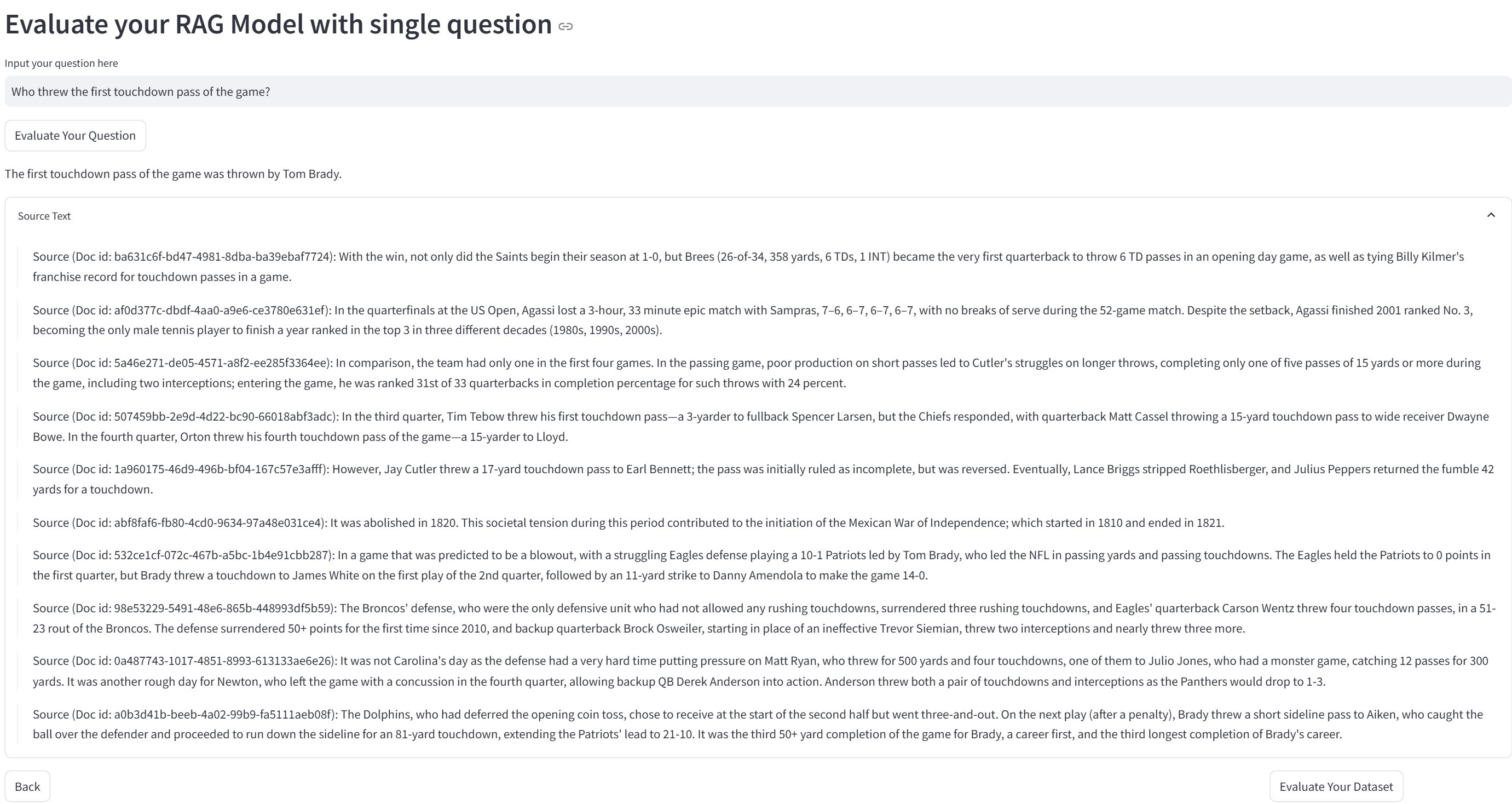

Se generan informes detallados y gráficos de visualización de los resultados de la evaluación.

- Estrategias de búsqueda personalizadasModificación

src/xragpara añadir o ajustar estrategias de búsqueda y modelos de evaluación.

Funciones principales

- Carga y configuración de conjuntos de datosCarga el conjunto de datos a través de la interfaz web y configúralo según sea necesario.

- Ejecuciones de evaluación: Seleccione los indicadores de evaluación y los métodos de búsqueda, ejecute la evaluación y visualice los resultados.

- Análisis de los resultados: Analice los resultados de la evaluación y optimice el rendimiento del sistema mediante informes generados y diagramas visuales.

El marco Ollama: permitir un razonamiento eficiente de recuperación localizada en XRAG

Ollama desempeña un papel crucial en el marco de inferencia de recuperación localizada XRAG-Ollama. Como marco de código abierto y fácil de usar para ejecutar grandes modelos locales, Ollama proporciona a XRAG potentes capacidades de inferencia de recuperación localizada, lo que permite a XRAG aprovechar al máximo su generación de mejoras de recuperación.

¿Por qué localizar el despliegue de XRAG?

- Reducción del riesgo externo: El uso de la implantación local reduce la dependencia de servicios externos y disminuye los riesgos potenciales asociados a la inestabilidad de los servicios de terceros o a la fuga de datos.

- Disponibilidad fuera de líneaEl sistema RAG localizado no depende de una conexión a Internet y puede funcionar con normalidad incluso en caso de interrupción de la red, lo que garantiza la continuidad y estabilidad del servicio.

- Gestión autónoma de datosLa implantación local ofrece a los usuarios un control total sobre la forma en que se almacenan, gestionan y procesan los datos, por ejemplo mediante la incorporación de datos privados en bases de datos de vectores locales, garantizando que los datos se procesan de acuerdo con las normas de seguridad y los requisitos empresariales propios de la organización.

- Privacidad y seguridad de los datosLa ejecución de un sistema GAR en un entorno local evita el riesgo de que los datos sensibles se vean comprometidos al transmitirlos por la red y garantiza que los datos estén siempre bajo control local. Esto es especialmente importante para las organizaciones que manejan información confidencial.

¿Por qué Ollama?

Ollama es un marco ligero y extensible para construir y ejecutar modelos lingüísticos a gran escala (LLM) en la máquina local. Proporciona una API sencilla para crear, ejecutar y gestionar modelos, así como una biblioteca de modelos preconstruidos que pueden utilizarse fácilmente en diversas aplicaciones. No sólo es compatible con una amplia gama de modelos, como DeepSeek, Llama 3.3, Phi 3, Mistral, Gemma 2, etc., sino que también es capaz de aprovechar la computación acelerada por hardware moderno, proporcionando así soporte de inferencia de alto rendimiento para XRAG. Además, Ollama ofrece soporte para la cuantificación de modelos, lo que puede reducir significativamente los requisitos de memoria gráfica. Por ejemplo, la cuantificación de 4 bits comprime los parámetros de peso de precisión FP16 a precisión entera de 4 bits, lo que reduce significativamente el volumen de peso del modelo y la memoria gráfica necesaria para la inferencia. Esto permite ejecutar modelos de gran tamaño en un ordenador doméstico medio.

Al combinarse con Ollama, XRAG es capaz de ejecutar eficazmente modelos lingüísticos a gran escala de forma local sin depender de complejas configuraciones del entorno ni de grandes cantidades de recursos computacionales, lo que reduce enormemente los costes de despliegue y operación. Al mismo tiempo, la solución de despliegue local ofrece a los desarrolladores un control total sobre el procesamiento de los datos, soportando toda la cadena de personalización desde la limpieza de los datos brutos, el procesamiento vectorizado (por ejemplo, la construcción de una base de conocimiento privada a través de ChromaDB) hasta la implementación final de la aplicación. Su arquitectura de despliegue basada en la infraestructura local es naturalmente capaz de funcionar sin conexión, lo que no sólo garantiza la continuidad del servicio, sino que también cumple los estrictos requisitos de fiabilidad del sistema en entornos especiales (por ejemplo, redes clasificadas, etc.).

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...