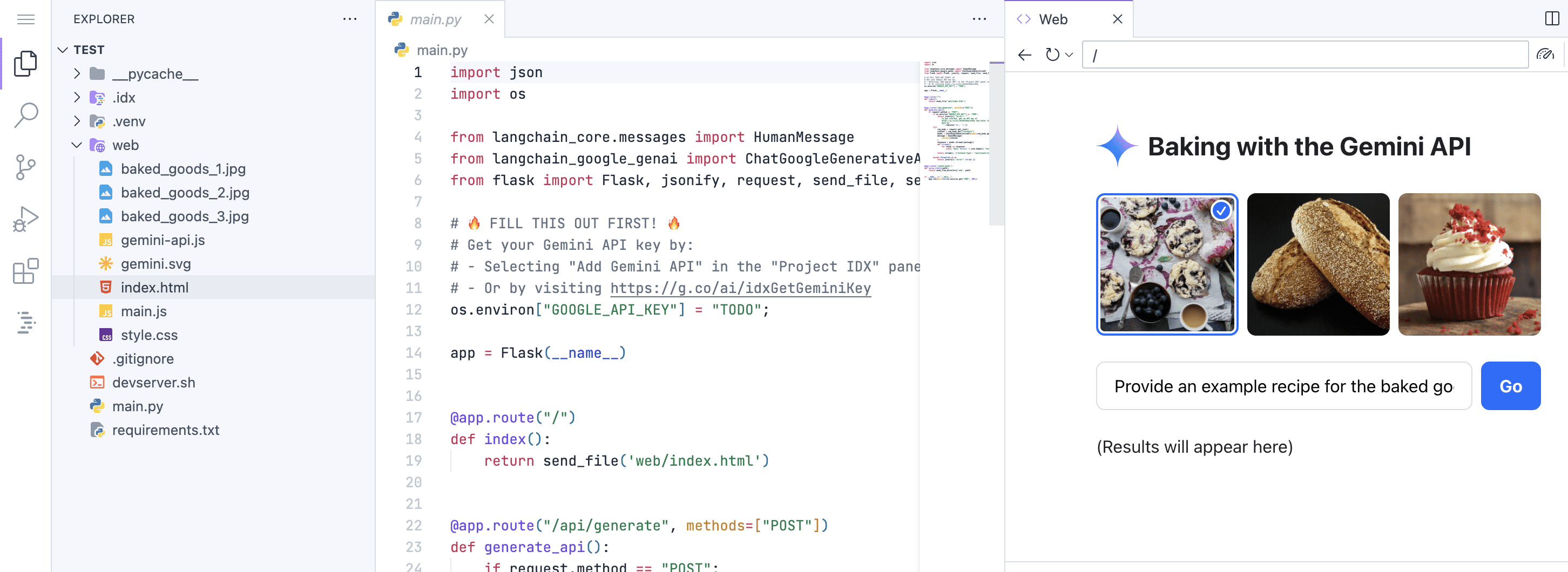

¿Qué es la arquitectura de los transformadores en un artículo?

Definición de la arquitectura del transformador

Transformador La arquitectura es un modelo de aprendizaje profundo diseñado para procesar tareas de secuencia a secuencia, como la traducción automática o el resumen de textos. Propuesta en 2017 por el artículo Attention Is All You Need, la principal innovación de la arquitectura es que se basa exclusivamente en el mecanismo de autoatención, evitando las estructuras circulares o convolucionales tradicionales. Al permitir que el modelo procese todos los elementos de una secuencia en paralelo, mejora drásticamente la eficiencia del entrenamiento y captura eficazmente las dependencias a larga distancia.

La arquitectura consta de dos partes, el codificador y el decodificador, ambas compuestas de múltiples capas. El codificador transforma la secuencia de entrada en una representación rica en contexto, y cada capa contiene una subcapa de autoatención multicapa y una subcapa de red neuronal feed-forward, utilizando la concatenación residual con normalización de capas para garantizar la estabilidad del entrenamiento. La estructura del decodificador es similar, pero con una capa adicional de atención codificador-decodificador para centrarse en las partes relevantes de la secuencia de entrada al generar la salida. Dado que el mecanismo de autoatención no es inherentemente consciente de la posición, el modelo inyecta información sobre el orden de la secuencia a través de la codificación de la posición, normalmente implementada mediante funciones seno y coseno.Transformer se ha convertido en una base en el campo del procesamiento del lenguaje natural, impulsando el desarrollo de modelos de vanguardia como BERT y GPT, y expandiéndose a tareas multimodales como la visión por ordenador, el procesamiento del habla, etc., y ha demostrado una excelente versatilidad y extensibilidad.

Evolución histórica de la arquitectura de los transformadores

- Orígenes y antecedentesLa arquitectura Transformer nació de una reflexión sobre las limitaciones de los modelos de secuencias tradicionales. Antes de 2017, las redes neuronales recurrentes y las redes de memoria a largo y corto plazo dominaban las tareas de procesamiento de secuencias, pero estos modelos adolecían de lentitud de entrenamiento y dificultades para captar dependencias de largo alcance. Los investigadores buscaban una alternativa más eficiente, y los mecanismos de atención se han utilizado como complemento para mejorar el rendimiento de las redes neuronales recurrentes, pero Transformer los eleva a un componente central.

- Principales documentos y comunicadosEn 2017, un equipo de investigación de Google propuso formalmente la arquitectura Transformer en el artículo Attention Is All You Need. Este documento describía en detalle el diseño basado en la autoatención y demostraba su superioridad mediante experimentos de traducción automática, lo que atrajo rápidamente la atención del mundo académico y de la industria.

- Primeras aplicaciones e impactosEn la fase inicial, Transformer se aplicó a tareas de traducción automática y obtuvo los mejores resultados en el conjunto de datos WMT. Su capacidad de paralelización permitió entrenar modelos a gran escala, sentando las bases para la posterior oleada de modelos preentrenados.

- Comunidad y promoción del código abiertoLa integración de implementaciones de código abierto como TensorFlow y PyTorch ha acelerado la popularidad de Transformer. Los investigadores y desarrolladores no han tardado en adoptar la arquitectura y contribuir con versiones mejoradas, como la optimización del cálculo de la atención y los modelos de escalado.

- Evolución e hitosTransformer: Con el tiempo, Transformer ha dado lugar a múltiples variantes, como BERT para el modelado bidireccional del lenguaje y GPT para tareas generativas. Estos avances han consolidado la posición central de Transformer en el procesamiento del lenguaje natural y han estimulado las aplicaciones interdisciplinares.

Componentes básicos de la arquitectura del transformador

- Mecanismo de autoatenciónAutoatención: la autoatención es el núcleo de Transformer, ya que permite al modelo evaluar la relevancia de cada elemento de una secuencia con respecto a otros elementos. Al calcular los vectores de consulta, clave y valor, el modelo genera pesos de atención que se centran dinámicamente en las partes importantes para captar las dependencias globales.

- Atención prolongada:: Para mejorar la representación del modelo, la atención multicabezal descompone el proceso de autoatención en múltiples "cabezas", cada una de las cuales aprende un aspecto diferente de la representación. Las salidas de estas cabezas se empalman y transforman linealmente para integrar información contextual diversa.

- código de posiciónCodificación posicional: Dado que la autoatención en sí no contiene información posicional, la codificación posicional inyecta orden de secuencia añadiendo vectores basados en funciones seno y coseno. Esto permite al modelo distinguir entre las posiciones de los elementos y evitar que se pierda la estructura de la secuencia.

- red neuronal feed-forwardCapa de atención: Cada capa de atención va seguida de una red neuronal feed-forward, que suele constar de dos transformaciones lineales y una función de activación. Este componente realiza transformaciones no lineales para mejorar la expresividad del modelo.

- Enlace residual y normalización de capasLa concatenación residual ayuda a mitigar el problema de desaparición del gradiente añadiendo entradas a las salidas. La normalización de las capas estabiliza el proceso de entrenamiento y garantiza una distribución coherente de las salidas en cada capa, lo que aumenta la velocidad de convergencia.

Cómo funciona la arquitectura de los transformadores

- etapa de tratamiento de la entradaLa secuencia de entrada se convierte primero en un vector de incrustación con codificación de posición. Este paso transforma los tokens discretos en una representación continua conservando la información posicional.

- Funcionamiento del codificadorEl codificador consta de varias capas idénticas apiladas unas sobre otras. Cada capa realiza un cálculo de autoatención multicabezal, seguido de un procesamiento de red feed-forward, concatenación residual y normalización de capas aplicada a cada subcapa. El codificador genera una secuencia de representaciones ricas en contexto.

- Funcionamiento del descodificadorEl decodificador también contiene varias capas, pero además incluye una capa de atención codificador-decodificador. En la subcapa de autoatención, el descodificador utiliza un mecanismo de enmascaramiento para evitar futuras fugas de información y garantizar la generación autorregresiva. La atención codificador-decodificador ayuda al decodificador a centrarse en la secuencia de entrada.

- Proceso de cálculo de la atenciónFunción de atención: La función de atención se basa en escalar la atención del producto punto, calcular el producto punto de la consulta y la clave, aplicar softmax para obtener los pesos tras el escalado y ponderar el vector suma. Este proceso consigue una focalización dinámica.

- ProducciónLa capa final genera distribuciones de probabilidad de salida mediante transformación lineal y softmax, por ejemplo, en traducción automática para generar tokens del idioma de destino uno a uno. La coerción del maestro se utiliza para el entrenamiento y la búsqueda de paquetes o la descodificación codiciosa para la inferencia.

Ámbitos de aplicación de la arquitectura Transformer

- procesamiento del lenguaje natural (PLN)Transformer se utiliza en una amplia gama de aplicaciones de procesamiento del lenguaje natural, como traducción automática, categorización de textos, análisis de sentimientos y sistemas de preguntas y respuestas. Modelos como las series BERT y GPT se basan en Transformer y han logrado grandes avances en varias pruebas de referencia.

- procesamiento del hablaLa arquitectura se adapta al reconocimiento y la síntesis del habla para procesar secuencias de audio. Por ejemplo, el modelo Speech-Transformer mejora las tareas de traducción de lenguaje hablado.

- visión por ordenadorVisual Transformer divide las imágenes en trozos y las trata como secuencias, destacando en la clasificación de imágenes y la detección de objetivos y desafiando el dominio de las redes neuronales convolucionales.

- tarea multimodalTransformer se encarga de tareas que combinan texto e imágenes, como la descripción de imágenes o el cuestionario visual. Modelos como CLIP utilizan Transformer para codificar entradas multimodales.

- bioinformática: En el análisis de secuencias genómicas y la predicción de estructuras proteicas, Transformer capta las dependencias de secuencias biológicas de largo alcance para impulsar la medicina personalizada.

Características ventajosas de la arquitectura Transformer

- Eficacia de la paralelizaciónGracias a la eliminación de la estructura recurrente, Transformer puede procesar secuencias en paralelo, lo que reduce drásticamente el tiempo de entrenamiento. En comparación con las redes neuronales recurrentes tradicionales, su entrenamiento es varias veces más rápido, lo que la hace especialmente adecuada para datos a gran escala.

- Captura dependiente de largo alcanceEl mecanismo de autoatención modela directamente la relación entre elementos a distancias arbitrarias en una secuencia, evitando el problema de desaparición de gradiente de las redes neuronales recurrentes. Esto hace que el modelo sea más eficaz cuando se trata de documentos largos o secuencias complejas.

- Escalabilidad y flexibilidadEl diseño arquitectónico permite escalar fácilmente los tamaños de los modelos y los volúmenes de datos. El rendimiento sigue mejorando mediante la adición de capas o cabezales para admitir implantaciones desde dispositivos móviles a la nube.

- rendimiento superiorEl modelo de base Transformer obtiene los mejores resultados en varias tareas. Por ejemplo, en traducción automática, la calidad de las traducciones mejora notablemente; en generación de textos, el resultado es más coherente y relevante desde el punto de vista contextual.

- interpretabilidadLos pesos de atención proporcionan información visual sobre los componentes de entrada a los que se presta atención en la toma de decisiones del modelo. Esto aumenta la transparencia y facilita la depuración y la auditoría ética.

Retos y limitaciones de la arquitectura de transformadores

- Recursos informáticos necesariosLos modelos de transformadores suelen requerir una gran cantidad de memoria y potencia de cálculo, sobre todo en el caso de modelos preentrenados de gran tamaño. Los elevados costes de formación pueden limitar las aplicaciones en entornos con recursos limitados.

- riesgo de sobreajusteEl sobreajuste se convierte en un problema a medida que aumentan los parámetros del modelo. Para mitigarlo se necesitan técnicas de regularización como los métodos de descarte o grandes cantidades de datos, pero la recogida de datos en sí puede resultar difícil.

- Explicaciones insuficientesAunque los pesos de la atención pueden visualizarse, el proceso de toma de decisiones dentro del modelo permanece en la sombra.

- Adaptación del dominioTransformer: puede sufrir una degradación del rendimiento debido al sesgo de los datos de entrenamiento en dominios específicos como el texto médico o jurídico. El aprendizaje por migración ayuda, pero requiere un ajuste específico para cada dominio.

Proceso de formación de la arquitectura Transformer

- Preparación de datosAl principio del entrenamiento, las secuencias de entrada se dividen en segmentos y se convierten en incrustaciones. Una vez añadida la codificación posicional, los datos se procesan por lotes para optimizar el uso del procesador gráfico. Los conjuntos de datos más habituales son WMT para traducción o Wikipedia para preentrenamiento.

- Selección de la función de pérdidaPara tareas secuenciales, la pérdida de entropía cruzada se utiliza habitualmente para calcular la diferencia entre la salida predicha y la etiqueta verdadera. En el preentrenamiento autosupervisado, se emplean pérdidas de modelos lingüísticos enmascarados, como el modelo lingüístico enmascarado de BERT.

- Uso del optimizadorEl optimizador Adam es muy popular, ya que combina la programación del ritmo de aprendizaje, como los pasos de calentamiento y el decaimiento. Esto estabiliza el entrenamiento, mejora la convergencia y es especialmente adecuado para modelos a gran escala.

- técnica de regularizaciónMétodo de descarte aplicado a la ponderación de la atención y a las redes feedforward para evitar el sobreajuste. El recorte de gradiente evita la explosión de gradiente y garantiza la estabilidad del entrenamiento.

- Evaluación y validaciónMétricas como la perplejidad o la precisión se controlan en el conjunto de validación durante el entrenamiento. Las estrategias de parada temprana evitan el sobreajuste y los puntos de control del modelo conservan la mejor versión.

Variantes y mejoras de la arquitectura del transformador

- Variante BERTBERT introduce el preentrenamiento bidireccional, pero modelos como RoBERTa optimizan la estrategia de entrenamiento y ALBERT reduce la compartición de parámetros para mejorar la eficiencia. Estas variantes impulsan aún más el rendimiento en tareas de procesamiento del lenguaje natural.

- Serie GPTEl modelo GPT se centra en la generación autorregresiva, y GPT-2 y GPT-3 se amplían para demostrar capacidades de aprendizaje con menos muestras. Las mejoras incluyen un cálculo más eficiente de la atención y una mayor longitud del contexto.

- Transformador eficientePara reducir la sobrecarga computacional, variantes como Linformer reducen la complejidad atencional y Reformer introduce hashing localmente sensible. Esto hace que Transformer sea más adecuado para escenarios con recursos limitados.

- Extensiones multimodalesModelos como Visual Transformer para visión, DALL-E para generación de imágenes, ampliación de Transformer a dominios no textuales. Integrar múltiples tipos de datos para impulsar un marco unificado para la IA.

- Mejora de la ética y la seguridadLa investigación se centra en la interpretabilidad y la generación controlada para promover una IA responsable. La investigación se centra en la interpretabilidad y la generación controlada para promover una IA responsable.

Futuro de la arquitectura de transformadores

- Optimización de la eficienciaEl trabajo futuro se centrará en reducir los requisitos de cálculo y memoria, ya sea mediante la compresión de modelos, la destilación de conocimientos o el codiseño de hardware. El objetivo es que Transformer sea viable en dispositivos de última generación.

- Integración entre camposTransformer prevé una integración más profunda en ámbitos científicos como la modelización del clima o el descubrimiento de fármacos. Procesa flujos de datos multimodales para una IA más generalizada.

- inteligencia artificial (IA) interpretableMejorar la transparencia de los modelos desarrollando herramientas para visualizar los mecanismos de atención y las vías de decisión. Esto genera confianza en el usuario y cumple los requisitos normativos.

- aprendizaje adaptativo: Estudio de arquitecturas dinámicas que ajustan parámetros o patrones de atención en función de la tarea. Los modelos adaptativos pueden reducir el ajuste manual de los parámetros y aumentar la automatización.

- Ética e impacto socialPreocupación por las implicaciones éticas de Transformer, incluida la mitigación de prejuicios y la protección de la privacidad. La comunidad promoverá el establecimiento de normas para garantizar que la tecnología beneficie a la sociedad.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...