Qué es una red neuronal (Neural Network), un artículo para leer y entender

Definición de red neuronal

Una red neuronal (NN) es un modelo computacional inspirado en el funcionamiento de las neuronas en el cerebro biológico. En el sistema nervioso biológico, cientos de millones de neuronas están conectadas por sinapsis para formar una compleja red que procesa la información y responde a ella. Las redes neuronales artificiales imitan esta estructura y están formadas por un gran número de unidades de procesamiento interconectadas, llamadas neuronas artificiales o nodos, que trabajan de forma concertada para resolver diversos problemas, como el reconocimiento de imágenes, el procesamiento del habla y el análisis predictivo. Cada neurona recibe una señal de entrada, realiza un cálculo sencillo y produce salidas mediante una función de activación, que a su vez sirven de entrada a otras neuronas. La red aprende a extraer patrones de los datos ajustando los pesos de las conexiones entre neuronas, lo que mejora gradualmente su rendimiento.

El núcleo de las redes neuronales es su capacidad para aprender características automáticamente a través del proceso de entrenamiento, sin programar explícitamente todas las reglas. Esta capacidad de aprendizaje ha permitido a las redes neuronales sobresalir en el manejo de datos no lineales y de alta dimensión, convirtiéndolas en una parte importante del campo del aprendizaje automático. Desde sencillas tareas de clasificación hasta complejos modelos generativos, las redes neuronales tienen una amplia gama de aplicaciones que siguen impulsando el desarrollo de la tecnología de IA. Las redes neuronales son una potente herramienta para modelizar relaciones complejas y aproximar funciones desconocidas mediante optimización iterativa.

Evolución histórica de las redes neuronales

La evolución de las redes neuronales ha estado repleta de avances y retos, reflejo de la continua búsqueda de la simulación inteligente por parte de la humanidad.

- Los primeros conceptos germinaron en la década de 1940, cuando Warren McCulloch y Walter Pitts propusieron el primer modelo matemático que describía cómo las neuronas procesan la información mediante operaciones lógicas. Este modelo sentó las bases de investigaciones posteriores, pero se vio limitado por la tecnología disponible en la época y no logró alcanzar una aplicación práctica.

- En la década de 1950, Frank Rosenblatt desarrolló el perceptrón, una red neuronal monocapa capaz de reconocer patrones sencillos. La aparición de la máquina perceptrón estimuló un interés generalizado, pero Marvin Minsky y Seymour Papert señalaron sus limitaciones en 1969, como su incapacidad para resolver problemas linealmente indivisibles, lo que provocó un retroceso en la investigación.

- En la década de 1980, el redescubrimiento y la ampliación del algoritmo de retropropagación resolvieron el problema del entrenamiento de redes multicapa, y el trabajo de investigadores como Geoffrey Hinton permitió a las redes neuronales manejar tareas más complejas, mientras que los avances en hardware proporcionaron soporte computacional, y el estudio de las redes neuronales se recuperó gradualmente.

- Con el auge de tecnologías competidoras como las máquinas de vectores soporte en la década de 1990 y principios de la de 2000, las redes neuronales se desarrollaron con relativa lentitud, pero la teoría subyacente siguió acumulándose en preparación de la explosión posterior.

- En la década de 2010, comenzó la revolución del aprendizaje profundo. La popularidad de los macrodatos y la computación acelerada por GPU permitieron a las redes neuronales profundas realizar grandes avances en los dominios de la imagen y el habla. La victoria de AlexNet en el concurso ImageNet de 2012 marcó una nueva era en la que las redes neuronales se convirtieron en una tecnología dominante en la inteligencia artificial.

Componentes básicos de las redes neuronales

La estructura de una red neuronal consta de múltiples componentes, cada uno de los cuales desempeña un papel específico y trabaja conjuntamente para lograr la función de aprendizaje.

- La capa de entrada se encarga de recibir datos en bruto, como píxeles de imágenes o secuencias de texto, y de pasar la información a las capas siguientes. Esta capa no realiza cálculos complejos y sólo sirve como punto de entrada de datos.

- La capa oculta se sitúa entre las capas de entrada y salida y realiza la mayor parte del procesamiento de datos. Las redes profundas contienen múltiples capas ocultas, y cada capa extrae características cada vez más abstractas, como el reconocimiento de bordes a formas.

- La capa de salida produce resultados finales como etiquetas de clasificación o valores predichos. El diseño depende del tipo de tarea, por ejemplo, la función softmax se utiliza para la distribución de probabilidad de salida de multiclasificación.

- Las neuronas son las unidades básicas, cada una de las cuales calcula sumas ponderadas de entrada y aplica una función de activación como ReLU o sigmoide, que introduce capacidades no lineales que permiten a la red aprender patrones complejos.

- Los parámetros de peso y sesgo definen la fuerza de las conexiones entre neuronas y, ajustando estos parámetros a lo largo del proceso de entrenamiento, la red optimiza progresivamente su rendimiento. Los pesos controlan la importancia de la señalización y los sesgos proporcionan flexibilidad para adaptarse a distintas distribuciones de datos.

Cómo funcionan las redes neuronales

Las redes neuronales procesan la información mediante una serie de pasos para lograr un mapeo de la entrada a la salida, centrado en un mecanismo de aprendizaje.

- El proceso de propagación hacia delante hace pasar los datos de entrada por las capas de la red, y las neuronas de cada capa calculan sumas ponderadas y aplican una función de activación para generar finalmente la salida. Este proceso es similar al flujo de información, en el que las características se extraen y transforman gradualmente.

- Las funciones de activación como ReLU o tanh introducen la no linealidad y permiten a la red aproximarse a funciones complejas arbitrarias. Sin una función de activación, la red degeneraría en un modelo lineal y no podría manejar las relaciones complejas del mundo real.

- La función de pérdida mide la diferencia entre la salida de la red y el valor verdadero, por ejemplo, el error cuadrático medio para tareas de regresión y la entropía cruzada para clasificación. El valor de la pérdida guía la dirección del aprendizaje y el objetivo es minimizar este valor.

- El algoritmo de retropropagación calcula el gradiente de la pérdida en función de los pesos y retropropaga el error de la capa de salida a la capa de entrada utilizando la regla de la cadena. Este paso identifica la contribución de cada parámetro al error, proporcionando una base para la optimización.

- Optimizadores como Gradient Descent o Adam utilizan la información del gradiente para actualizar los pesos y los sesgos, reduciendo gradualmente las pérdidas. La tasa de aprendizaje controla el tamaño del paso de actualización, equilibrando la velocidad de convergencia y la estabilidad para garantizar que la red aprende de forma eficaz.

Tipos de redes neuronales

Existen varias arquitecturas de redes neuronales, cada una diseñada para una tarea específica y adaptada a diferentes características de los datos.

- Las redes neuronales de avance son el tipo más básico, con un flujo unidireccional de información de entrada a salida y sin conexiones recurrentes. Se utilizan mucho para problemas sencillos de clasificación y regresión, pero su capacidad para manejar datos secuenciales es limitada.

- Las redes neuronales convolucionales están diseñadas para el procesamiento de imágenes y utilizan capas convolucionales para extraer características espaciales y capas de agrupamiento para reducir la dimensionalidad. Las redes neuronales convolucionales dominan el campo de la visión por ordenador, como el reconocimiento de objetos o rostros, gracias a la compartición de parámetros y la eficiencia de la conectividad local.

- Las redes neuronales recurrentes procesan datos secuenciales, como series temporales o lenguaje natural, manteniendo estados ocultos y capturando dependencias temporales mediante conexiones recurrentes. Variantes como las redes de memoria a corto y largo plazo y las unidades recurrentes con compuerta resuelven el problema de la desaparición del gradiente y mejoran el procesamiento de secuencias largas.

- Las redes generativas adversariales consisten en generadores y discriminadores que generan nuevos datos, como imágenes o audio, mediante entrenamiento adversarial. Las redes generativas adversariales destacan en tareas creativas como la generación de arte o la mejora de datos.

- Los autocodificadores se utilizan para reducir la dimensionalidad y aprender características, los codificadores comprimen la entrada y los decodificadores reconstruyen la salida. Los autocodificadores variacionales se amplían para generar modelos, aprender distribuciones de datos y aplicarse a la detección de anomalías o la eliminación de ruido.

Ejemplos de aplicaciones de las redes neuronales

Las redes neuronales han penetrado en varios campos para resolver problemas del mundo real y mejorar la vida y la productividad humanas.

- En los sistemas de reconocimiento de imágenes, las redes neuronales analizan fotos o vídeos para identificar objetos, escenas o actividades. Por ejemplo, los coches autónomos utilizan redes neuronales convolucionales para detectar peatones, vehículos y señales de tráfico en tiempo real y mejorar así la seguridad.

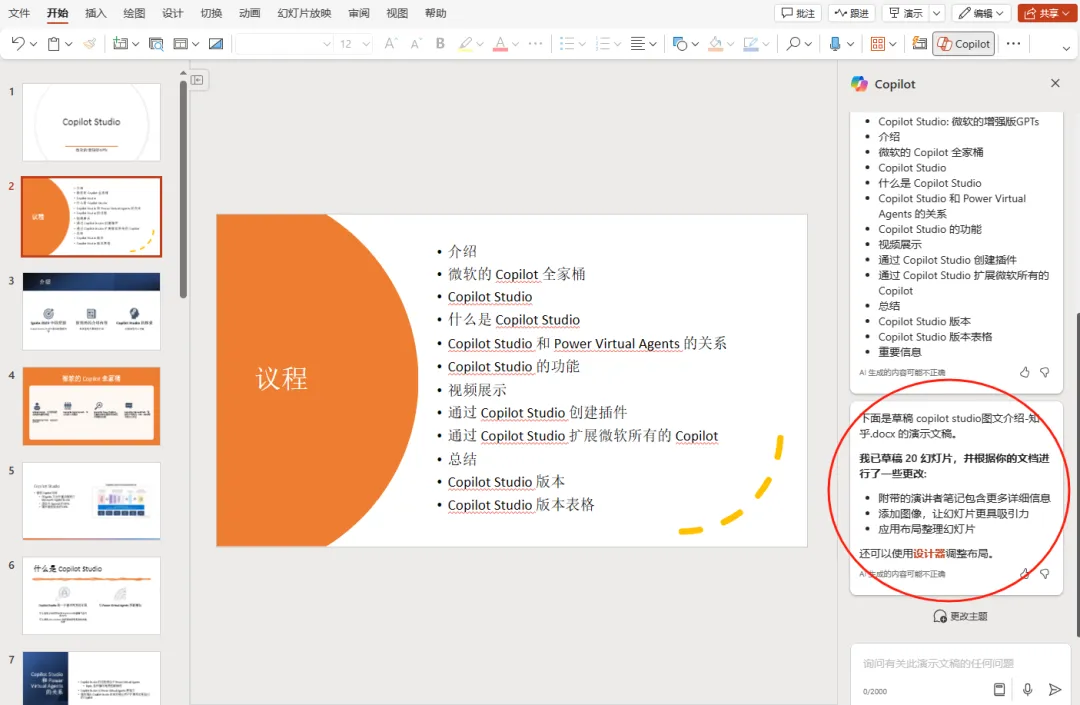

- En las tareas de procesamiento del lenguaje natural, las redes neuronales procesan datos textuales para permitir la traducción automática, el análisis de sentimientos o los chatbots.Las arquitecturas transformadoras como BERT mejoran la comprensión del lenguaje y sirven de apoyo a motores de búsqueda o asistentes virtuales.

- Las aplicaciones de diagnóstico médico utilizan redes neuronales para analizar imágenes médicas, como radiografías o resonancias magnéticas, para ayudar a los médicos a detectar los primeros signos de enfermedad. Los modelos de aprendizaje profundo logran una precisión de nivel experto en la detección del cáncer o el análisis de patologías.

- El campo de la IA de juegos se caracteriza por redes neuronales que dominan juegos complejos mediante el aprendizaje por refuerzo, como en el caso de AlphaGo, que derrotó al campeón humano. Estos sistemas aprenden estrategias y decisiones que impulsan los avances de la IA en entornos simulados.

- El sector financiero utiliza redes neuronales para la detección de fraudes, la evaluación de riesgos o la negociación algorítmica. Los modelos analizan datos históricos para predecir tendencias de mercado o identificar operaciones anómalas para mejorar el apoyo a la toma de decisiones.

Ventajas de las redes neuronales

Las redes neuronales tienen varias ventajas que las convierten en una tecnología básica de la IA moderna para diversos escenarios.

- Gran capacidad para manejar datos complejos de alta dimensión, como imágenes, audio o texto, extrayendo características automáticamente y reduciendo la necesidad de ingeniería manual de características. Esta capacidad se deriva de una estructura multicapa que aprende representaciones abstractas paso a paso.

- Los mecanismos de aprendizaje adaptativo permiten a la red mejorar iterativamente a partir de los datos sin programar explícitamente reglas. Mediante el entrenamiento, la red ajusta sus parámetros para adaptarse a nuevos patrones y mejorar el rendimiento de la generalización.

- Las capacidades de procesamiento paralelo se benefician de un diseño arquitectónico que se presta a la aceleración del procesador gráfico, lo que aumenta drásticamente la eficiencia computacional. El entrenamiento de redes a gran escala se completa en un tiempo razonable, lo que permite el despliegue de aplicaciones en tiempo real.

- La ventaja del modelado no lineal permite a la red aproximarse a funciones complejas y resolver problemas difíciles de tratar con métodos tradicionales, como los sistemas caóticos o la semántica del lenguaje natural.

- La robustez es buena y tolera el ruido de entrada o la ausencia parcial de datos. La red gestiona la incertidumbre mediante la representación distribuida y mantiene una salida estable.

Limitaciones de las redes neuronales Retos

A pesar de su potencia, las redes neuronales se enfrentan a algunas limitaciones y deben tratarse con cautela en las aplicaciones.

- La dependencia de los datos es elevada, ya que se necesitan grandes cantidades de datos etiquetados para el entrenamiento. La calidad deficiente o sesgada de los datos puede degradar el rendimiento del modelo e incluso amplificar el sesgo social y afectar a la equidad.

- Los recursos informáticos están muy solicitados y el entrenamiento de redes profundas consume grandes cantidades de memoria y potencia de procesamiento, lo que limita su despliegue en entornos con recursos limitados. Las emisiones de carbono y los costes energéticos también se han convertido en preocupaciones medioambientales.

- Destacan las cajas negras y los procesos de toma de decisiones son difíciles de explicar, lo que reduce la transparencia. En ámbitos críticos como la sanidad o el derecho, la falta de interpretabilidad puede obstaculizar la confianza y la adopción.

- El riesgo de sobreajuste existe y el modelo funciona bien con los datos de entrenamiento, pero generaliza mal con los nuevos datos. Las técnicas de regularización, como el descarte aleatorio, mitigan el problema pero no lo eliminan por completo.

- La inestabilidad del entrenamiento, la desaparición del gradiente o los problemas de explosión afectan a la convergencia de las redes profundas. Los algoritmos de optimización y las mejoras arquitectónicas abordan estos problemas, pero es necesario seguir investigando.

Perspectivas futuras de las redes neuronales

El campo de las redes neuronales sigue evolucionando, y las orientaciones futuras se centran en innovaciones y mejoras que amplíen los límites de las aplicaciones.

- Mejora de la eficiencia algorítmica Reducir el número de parámetros y disminuir la carga computacional mediante nuevos métodos de optimización o diseños arquitectónicos. Por ejemplo, las arquitecturas neuronales buscan diseños de red automatizados para mejorar el rendimiento.

- La investigación sobre interpretabilidad se refuerza con el desarrollo de herramientas para visualizar el proceso de toma de decisiones y generar confianza. Los métodos interpretables de IA ayudan a los usuarios a comprender el comportamiento de los modelos y promueven un despliegue responsable.

- La convergencia entre dominios se acelera, y las redes neuronales se combinan con la biología, la física o el arte para producir aplicaciones emergentes. La computación inspirada en el cerebro explora modelos más biológicamente racionales para ampliar las fronteras de la inteligencia artificial.

- Se refuerzan la ética y la gobernanza y se elaboran directrices para garantizar la equidad, la privacidad y la seguridad. El discurso social influye en el desarrollo tecnológico para evitar usos indebidos o impactos negativos.

- Desarrollo de sistemas de aprendizaje adaptativo para el aprendizaje permanente y la adaptación a entornos dinámicos. Las técnicas de metaaprendizaje o aprendizaje sin muestras reducen los requisitos de datos y aumentan la flexibilidad.

Proceso de entrenamiento de una red neuronal

Entrenar una red neuronal implica múltiples pasos para garantizar que el modelo aprenda eficazmente de los datos y alcance el rendimiento deseado.

- La fase de preparación de los datos incluye su recogida, limpieza y etiquetado, así como la división del conjunto de entrenamiento, el conjunto de validación y el conjunto de prueba. Las técnicas de mejora de datos aumentan la diversidad y mejoran la generalización.

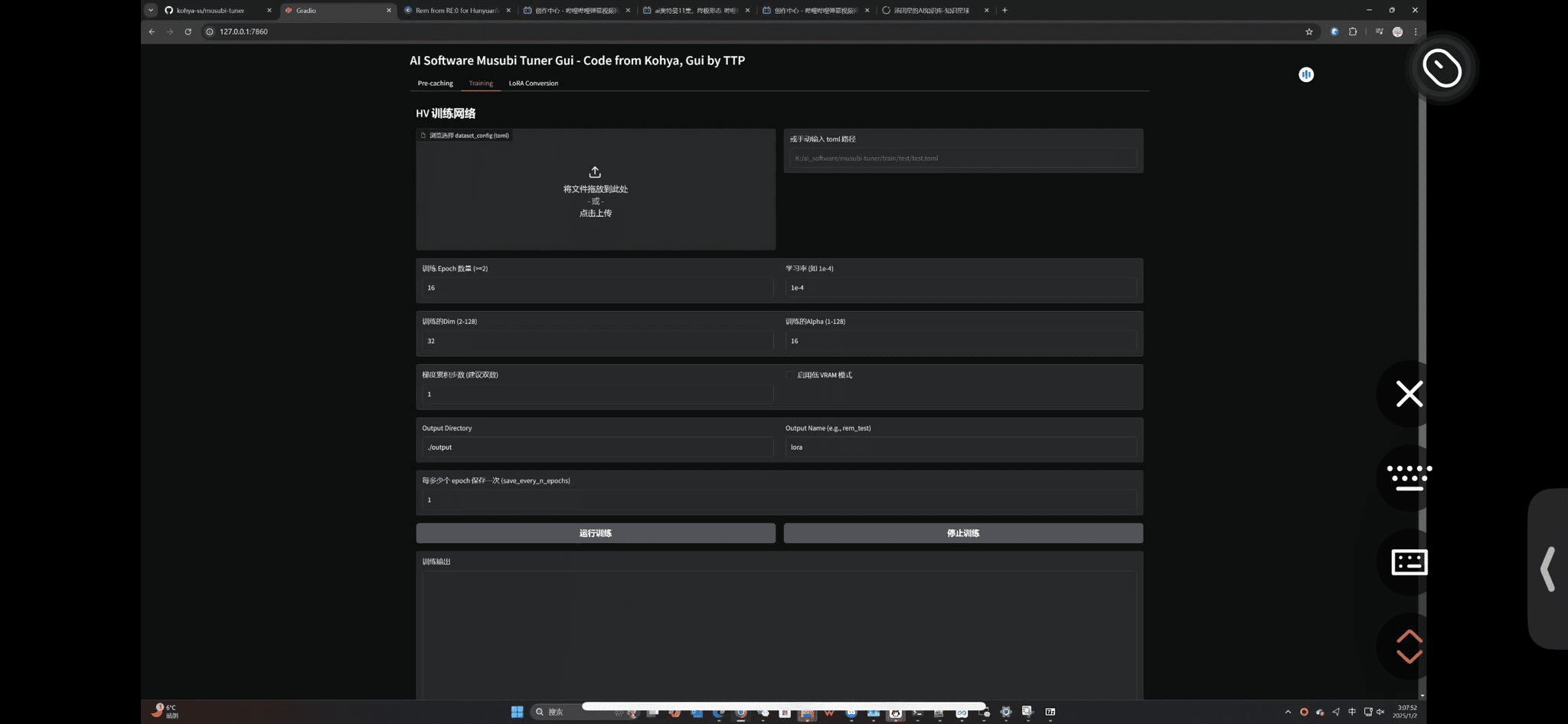

- La selección del modelo se basa en los requisitos de la tarea, determinando la arquitectura de la red, el número de capas y la inicialización de los parámetros. Los hiperparámetros, como la tasa de aprendizaje o el tamaño del lote, se optimizan mediante ajuste experimental.

- El bucle de entrenamiento realiza iterativamente la propagación hacia delante, el cálculo de pérdidas y la retropropagación para actualizar los pesos. Un mecanismo de parada temprana o punto de control evita el sobreajuste y preserva el mejor modelo.

- La fase de validación controla el rendimiento en el conjunto de validación y ajusta los hiperparámetros o la arquitectura. Las técnicas de validación cruzada proporcionan una evaluación sólida y reducen el impacto de la aleatoriedad.

- Las pruebas evalúan el rendimiento del modelo final en datos no vistos, informando de métricas como la precisión o las puntuaciones F1. Tras la implantación, la supervisión y actualización continuas se adaptan a los nuevos datos y mantienen la relevancia.

Datos necesarios para las redes neuronales

Los datos son la base del entrenamiento de las redes neuronales, y la calidad y la gestión afectan directamente al éxito del modelo.

- La cantidad de datos debe ser suficiente, y las redes profundas suelen necesitar millones de muestras para aprender una representación eficaz. Los escenarios de datos pequeños utilizan el aprendizaje por migración para preentrenar modelos que se adapten a nuevas tareas.

- La calidad de los datos es fundamental: el ruido, los errores o los valores omitidos merman el rendimiento. El proceso de limpieza corrige las anomalías, garantiza la coherencia y la precisión del etiquetado, y evita el aprendizaje engañoso.

- La diversidad de datos cubre una amplia gama de escenarios y evita los sesgos. Los conjuntos de datos equilibrados representan diferentes categorías, lo que mejora la solidez del modelo frente a los cambios del mundo real.

- Preprocesamiento de datos para estandarizar o normalizar las entradas y acelerar la convergencia. Escalado o codificación de características para procesar distintos tipos de datos, como el redimensionamiento de imágenes o la división de palabras de texto.

- La seguridad de los datos y la protección de la privacidad son importantes, especialmente en el caso de la información sensible. Las técnicas de anonimización o privacidad diferencial evitan filtraciones, cumplen normativas como el Reglamento General de Protección de Datos y establecen normas éticas de uso.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...