VTP - La tecnología de modelado generativo visual de código abierto del equipo de vídeo MiniMax Conch

Últimos recursos sobre IAPublicado hace 2 meses Círculo de intercambio de inteligencia artificial 23.4K 00

¿Qué es VTP?

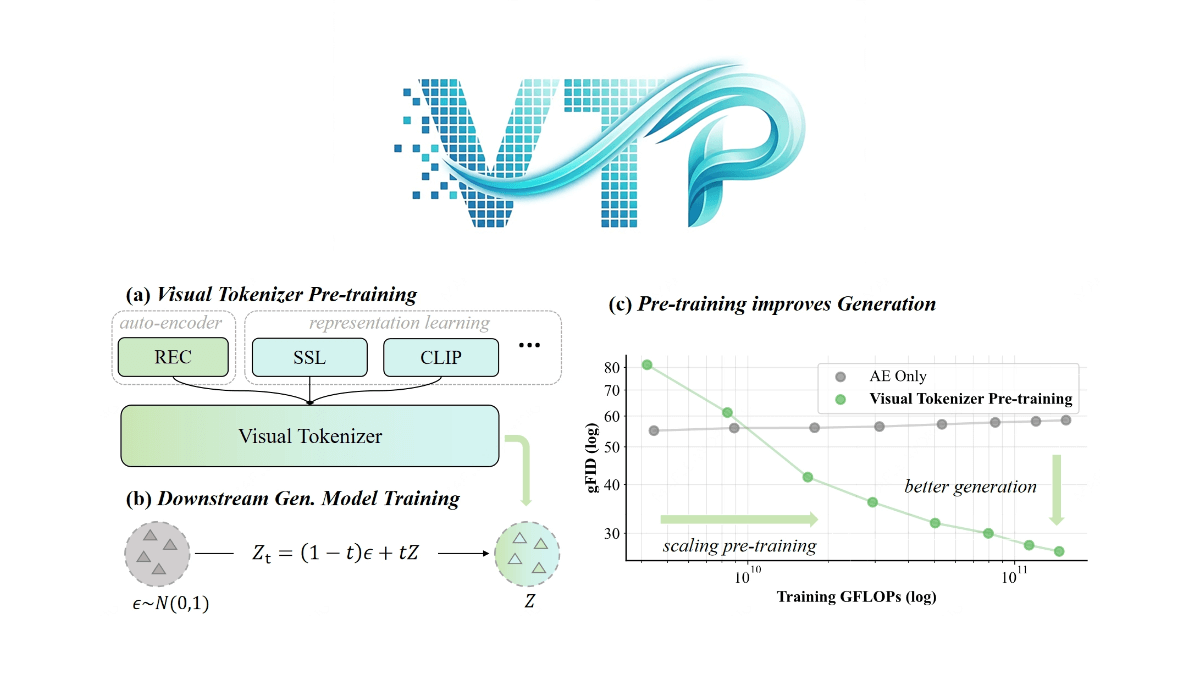

VTP (Visual Tokenizer Pre-training) es una tecnología clave para los modelos de generación visual propuesta por el equipo de MiniMax Conch Video, que mejora el rendimiento del sistema de generación perfeccionando el método de preentrenamiento del tokenizador visual (tokenizer). En los métodos tradicionales, el tokenizador sólo se centra en la reconstrucción de la imagen, pero VTP introduce de forma innovadora la capacidad de comprensión semántica como motor central de la calidad de la generación. El marco adopta la arquitectura Vision Transformer y, mediante una estrategia de entrenamiento en dos fases (fase de preentrenamiento para optimizar el aprendizaje de la representación y fase de ajuste para mejorar la calidad de la imagen) y objetivos multitarea (reconstrucción, autosupervisión y comparación gráfica), logra por primera vez el escalado del tokenizador, es decir, el efecto de generación se mejora simultáneamente al aumentar la potencia computacional y la cantidad de datos. Los experimentos muestran que el VTP supera significativamente al VAE tradicional con el mismo presupuesto computacional, proporcionando un pedestal visual más eficiente para modelos de difusión y macromodelos multimodales.

Características de VTP

- Cooptimización multitarea: VTP permite el entrenamiento conjunto multitarea combinando el aprendizaje por contraste imagen-texto, el aprendizaje autosupervisado (por ejemplo, autodestilación y modelado de imágenes enmascaradas) y los objetivos de reconstrucción a nivel de píxel para mejorar la comprensión semántica y la percepción espacial del modelo.

- Escalabilidad eficienteVTP demuestra una excelente escalabilidad, y su rendimiento de generación mejora constantemente a medida que aumenta la cantidad de cálculos de entrenamiento (FLOPs), los parámetros del modelo y el tamaño del conjunto de datos, rompiendo el cuello de botella de rendimiento de los autocodificadores tradicionales durante el pre-entrenamiento a gran escala.

- Excelente rendimiento de generaciónEn ImageNet, VTP alcanza una precisión de clasificación de muestra cero de 78,21 TP3T y un rFID de 0,36, lo que supera significativamente a otros métodos, y funciona bien en tareas generativas posteriores, en las que la calidad de la generación puede mejorarse significativamente aumentando únicamente la cantidad de cálculo de preentrenamiento.

- convergencia rápidaVTP: VTP se ha rediseñado desde la fase de preentrenamiento para lograr un límite superior de rendimiento y una convergencia 4,1 veces más rápida en comparación con los métodos basados en modelos de base de destilación, lo que mejora enormemente la eficacia del entrenamiento.

- Código abierto y facilidad de uso: VTP proporciona directrices detalladas de instalación y uso, incluidas descargas de pesos preentrenados y scripts de inicio rápido, para facilitar a investigadores y desarrolladores su rápida puesta en marcha y aplicación en proyectos reales.

Principales ventajas de VTP

- Integración del aprendizaje multitarea: VTP integra el aprendizaje por contraste imagen-texto, el aprendizaje autosupervisado y los objetivos de reconstrucción a nivel de píxel, y permite al modelo mejorar significativamente su comprensión semántica y sus capacidades generativas mediante la cooptimización multitarea.

- Gran escalabilidadVTP demuestra una excelente escalabilidad en la fase de preentrenamiento, y su rendimiento de generación mejora constantemente con el aumento del cálculo, los parámetros del modelo y el tamaño del conjunto de datos, superando las limitaciones de los autocodificadores tradicionales.

- Excelente calidad de generaciónEn puntos de referencia como ImageNet, VTP alcanza una precisión de clasificación de muestra cero de 78,21 TP3T y un rFID de 0,36, superando significativamente a otros métodos en términos de calidad de generación y obteniendo buenos resultados en tareas de generación posteriores.

- Capacidad de convergencia rápidaVTP: VTP se ha rediseñado desde la fase de preentrenamiento para lograr un límite superior de rendimiento y una convergencia 4,1 veces más rápida en comparación con los métodos tradicionales, lo que mejora enormemente la eficacia del entrenamiento.

- Código abierto y facilidad de uso: VTP proporciona guías de instalación detalladas y pesos de formación previa para que los usuarios puedan iniciarse rápidamente y aplicarlos a proyectos reales, lo que reduce el umbral de uso.

- Paradigmas innovadores de formación previaVTP: propone un nuevo paradigma de preentrenamiento para desambiguadores visuales, que mejora la capacidad generativa mediante el aprendizaje multitarea, y aporta nuevas ideas y métodos para el campo de la generación visual.

¿Cuál es el sitio web oficial de VTP?

- Repositorio GitHub:: https://github.com/MiniMax-AI/VTP

- Biblioteca de modelos HuggingFace:: https://huggingface.co/collections/MiniMaxAI/vtp

- Documento técnico arXiv:: https://arxiv.org/pdf/2512.13687v1

Personas para las que está indicado el VTP

- Investigadores del aprendizaje profundo: Los investigadores interesados en el modelado generativo visual y que deseen explorar nuevos métodos de preentrenamiento para mejorar la calidad de la generación y la comprensión semántica, VTP proporciona nuevos marcos técnicos e ideas experimentales.

- Ingeniero en visión por ordenadorLos ingenieros que trabajan en aplicaciones de generación de visión de alta calidad (por ejemplo, generación de imágenes, generación de vídeo, etc.) pueden implementar y optimizar rápidamente sus tareas de generación gracias a la eficaz escalabilidad y el excelente rendimiento de VTP.

- experto en procesamiento del lenguaje natural (PLN): Investigador centrado en el aprendizaje intermodal y la fusión multimodal, VTP aporta nuevas perspectivas y herramientas para el modelado conjunto de la visión y el lenguaje mediante técnicas como el aprendizaje del contraste imagen-texto.

- Desarrollador de aprendizaje automáticoPara los desarrolladores que deseen implantar y aplicar rápidamente modelos preentrenados en proyectos reales, el código fuente abierto de VTP y su detallada guía de usuario reducen la barrera de uso y facilitan una rápida integración en los proyectos.

- Investigadores universitarios: Los investigadores académicos que trabajan en campos relacionados con la inteligencia artificial, la visión por ordenador y el procesamiento del lenguaje natural, VTP les proporciona nuevas direcciones de investigación y plataformas experimentales, que ayudan a promover el progreso académico en campos relacionados.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...