VITA: modelos lingüísticos multimodales de código abierto para la interacción visual y verbal en tiempo real

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 84.2K 00

Introducción general

VITA es un proyecto líder de modelado de grandes lenguajes multimodales interactivos de código abierto, pionero en la capacidad de lograr una verdadera interacción multimodal completa. El proyecto lanzó VITA-1.0 en agosto de 2024, siendo pionero en el primer gran modelo de lenguaje multimodal interactivo de código abierto, y en diciembre de 2024, el proyecto lanzó una importante versión de actualización, VITA-1.5, que mejora significativamente la experiencia de interacción y el rendimiento.El modelo VITA soporta entradas y salidas multimodales, como imagen, vídeo y audio, y está equipado con capacidades de interacción en tiempo real, reduciendo significativamente la latencia de la interacción de voz de extremo a extremo de 4 segundos a 1,5 segundos. El modelo VITA admite entradas y salidas multimodales, como imagen, vídeo y audio, y está dotado de capacidad de interacción en tiempo real, lo que reduce significativamente la latencia de la interacción de voz de extremo a extremo de 4 segundos a 1,5 segundos, mejorando enormemente la experiencia del usuario. Como proyecto de código abierto, VITA ofrece una plataforma ideal para que investigadores y desarrolladores exploren la IA multimodal.

Lista de funciones

- Procesamiento de entrada multimodal: admite imagen, vídeo, audio y otras formas de entrada.

- Interacción de voz en tiempo real: latencia de la interacción de voz de extremo a extremo de sólo 1,5 segundos.

- Funciones de análisis visual: potentes funciones de comprensión y análisis de imágenes y vídeos

- Procesamiento de audio: admite reconocimiento y síntesis de voz

- Comprensión multimodal: hacia una correlación inteligente entre texto, imagen y audio

- Soporte de código abierto: todo el código de formación e inferencia es abierto

- Modelos preformados: existen varias versiones de modelos preformados.

- Opciones de implantación flexibles: admite múltiples implantaciones de plataformas de hardware

Visión general de VITA-1.5

El 12 de agosto de 2024, publicamos el VITA-1.0Esto es El primer modelo de macrolenguaje multimodal interactivo todo en uno de código abierto. Y ahora (20 de diciembre de 2024), les traemos el Nueva versión VITA-1.5¡!

Novedades de VITA-1.5

Nos complace presentar VITA-1.5que introdujo una serie de avances:

- Reducción significativa de la latencia de interacción.. La latencia de la interacción vocal de extremo a extremo ha aumentado de Aprox. 4 segundos Reducción a 1,5 segundoslo que permite una interacción casi instantánea y mejora enormemente la experiencia del usuario.

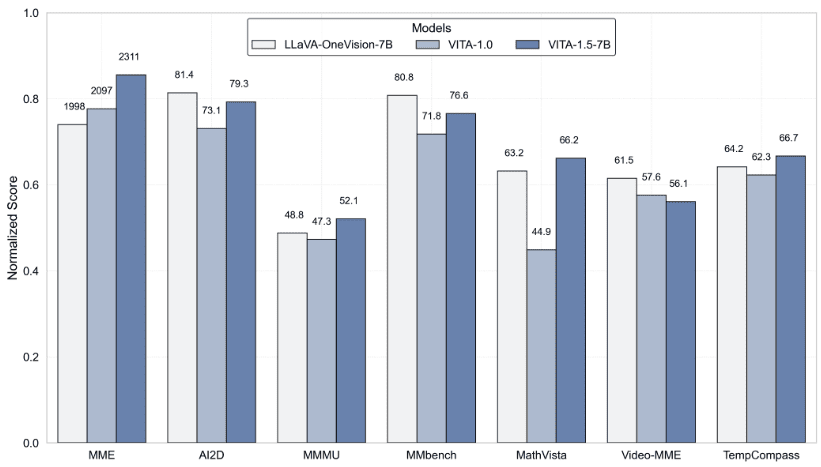

- Rendimiento multimodal mejorado. En MMEyMMBench responder cantando MathVista El rendimiento medio en puntos de referencia multimodales, como el 59.8 elevarlo a 70.8.

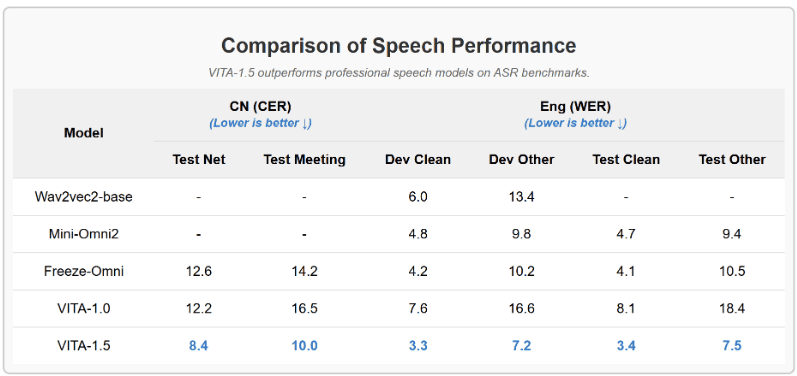

- Mejora de la capacidad de procesamiento del habla.. Se alcanzó un nuevo nivel de potencia de procesamiento del habla, con un ASR WER (Word Error Rate, Test Other) que se incrementó del 18.4 Disminución a 7.5. Además, utilizamos Módulo TTS de extremo a extremo Sustituye al módulo TTS autónomo de VITA-1.0, que acepta como entrada la incrustación de grandes modelos lingüísticos.

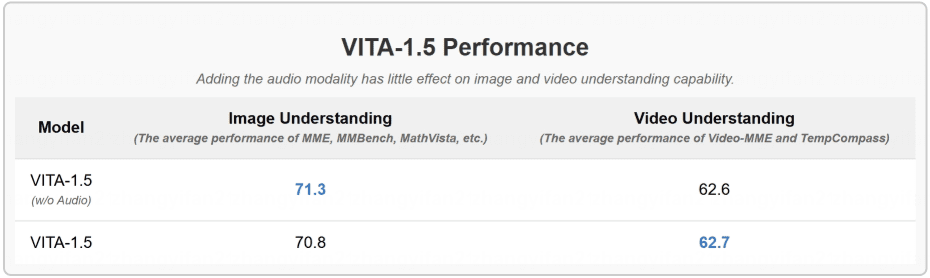

- Estrategias de entrenamiento progresivo. De este modo, la inclusión del módulo del habla tiene poco efecto en el otro rendimiento multimodal (visual-verbal). El rendimiento medio de la comprensión de imágenes sólo disminuyó de 71,3 a 70,8.

Resultados

- Evaluación de pruebas comparativas de comprensión de imágenes y vídeos

- VITA-1.5 supera a los modelos profesionales en las pruebas de ASR

- La inclusión de la modalidad de audio tiene poco efecto en la comprensión de imágenes y vídeos

Utilizar la ayuda

1. Configuración e instalación del entorno

1.1 Requisitos básicos:

- Entorno Python

- Marco de trabajo PyTorch

- Compatibilidad con CUDA (se recomienda aceleración en la GPU)

1.2 Pasos de la instalación:

# 克隆项目仓库

git clone https://github.com/VITA-MLLM/VITA.git

cd VITA

# 安装依赖

pip install -r requirements.txt

2. Utilización de modelos

2.1 Carga del modelo preentrenado:

from vita.model.builder import load_pretrained_model

from vita.conversation import conv_templates

from vita.util.mm_utils import get_model_name_from_path

# 加载模型

model_path = 'VITA/vita'

model_name = get_model_name_from_path(model_path)

tokenizer, model, image_processor, _ = load_pretrained_model(

model_path,

None,

model_name,

model_type='mixtral-8x7b',

device_map='auto'

)

2.2 Configuración del procesamiento de audio:

# 初始化音频编码器

audio_encoder = model.get_audio_encoder()

audio_encoder.to(dtype=torch.float16)

audio_processor = audio_encoder.audio_processor

3. Funciones interactivas en tiempo real

- Admite entrada y respuesta de voz en tiempo real

- Reconocimiento y análisis de imágenes integrados

- Admite interacciones de diálogo en varias rondas

- Proporcionar un sistema completo de plantillas de diálogo

4. Utilización de funciones avanzadas

4.1 Tratamiento multimodal de la información:

- Admite el procesamiento de imágenes por lotes

- Análisis en tiempo real de secuencias de vídeo

- Procesamiento y síntesis de secuencias de audio

4.2 Entrenamiento y ajuste del modelo:

- Proporciona guiones de formación completos

- Funciones de aprendizaje continuo

- Apoyo a la formación de conjuntos de datos personalizados

5. Evaluación y pruebas

- Apoyo a los principales criterios de evaluación multimodal

- Herramienta de evaluación VLMEvalKit integrada

- Proporciona métricas detalladas de las pruebas de rendimiento

6. Precauciones

- Se recomiendan las GPU para la inferencia de modelos

- Prestar atención a la gestión de la memoria, especialmente cuando se trabaja con grandes entradas multimodales.

- Compruebe periódicamente las actualizaciones del proyecto para conocer las últimas funciones y optimizaciones.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...