VideoMind: proyecto de código abierto de posicionamiento de vídeos por marcas de tiempo y preguntas y respuestas

Últimos recursos sobre IAActualizado hace 9 meses Círculo de intercambio de inteligencia artificial 53.6K 00

Introducción general

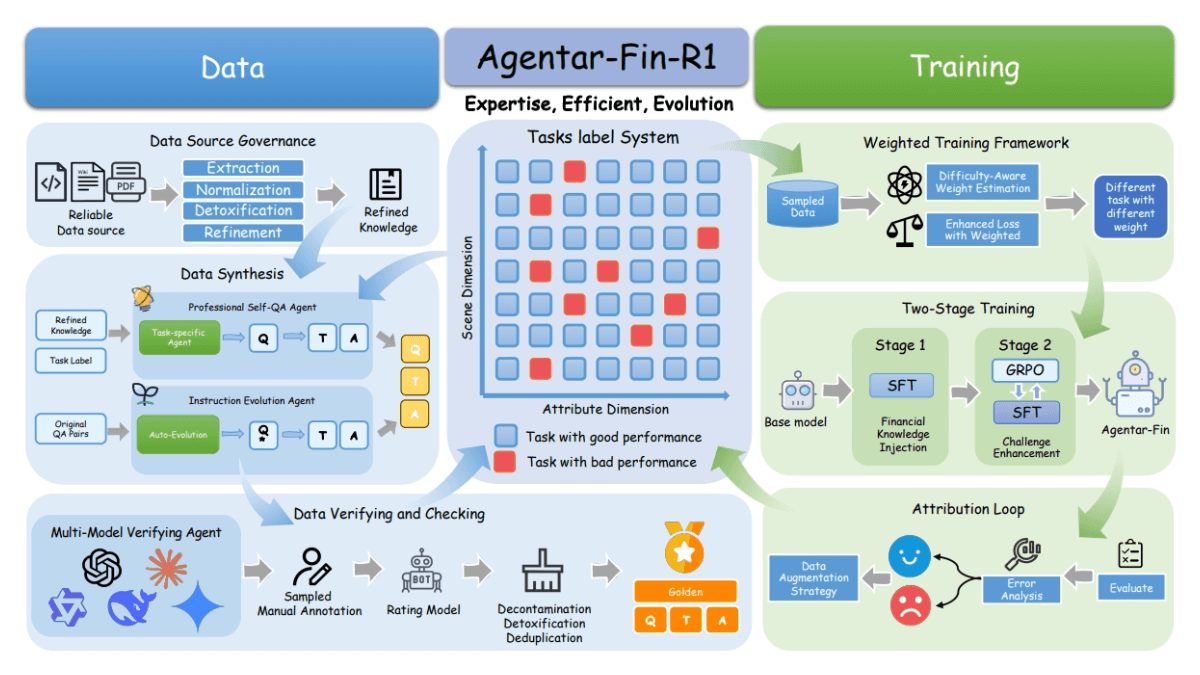

VideoMind es una herramienta de IA multimodal de código abierto que se centra en la inferencia, las preguntas y respuestas y la generación de resúmenes para vídeos largos. Ha sido desarrollada por Ye Liu, de la Universidad Politécnica de Hong Kong, y un equipo del Show Lab de la Universidad Nacional de Singapur. La herramienta imita la forma en que los humanos entienden los vídeos, dividiendo la tarea en pasos como planificar, posicionar, verificar y responder para resolver el problema paso a paso. La tecnología central es Chain-of-LoRA, que cambia entre roles a través de un modelo base, que es eficiente y consume pocos recursos.VideoMind publica oficialmente el código, el modelo y el conjunto de datos el 21 de marzo de 2024, y el informe técnico se actualiza el 17 de marzo de 2025.VideoMind está disponible en GitHub o a través de GitHub. Los usuarios pueden acceder a los recursos a través de GitHub o Hugging Face.

El proyecto no extrae audio a texto para entender el contenido, sino puramente gráfico y de acuerdo con la marca de tiempo para entender con precisión el contenido del vídeo, se puede utilizar para el ajuste automático de vídeo, escenarios de enseñanza, ¡muy práctico!

Experiencia: https://huggingface.co/spaces/yeliudev/VideoMind-2B

Lista de funciones

- Segmentación temporal de vídeos largos: busque el periodo de tiempo del vídeo que sea relevante para la pregunta.

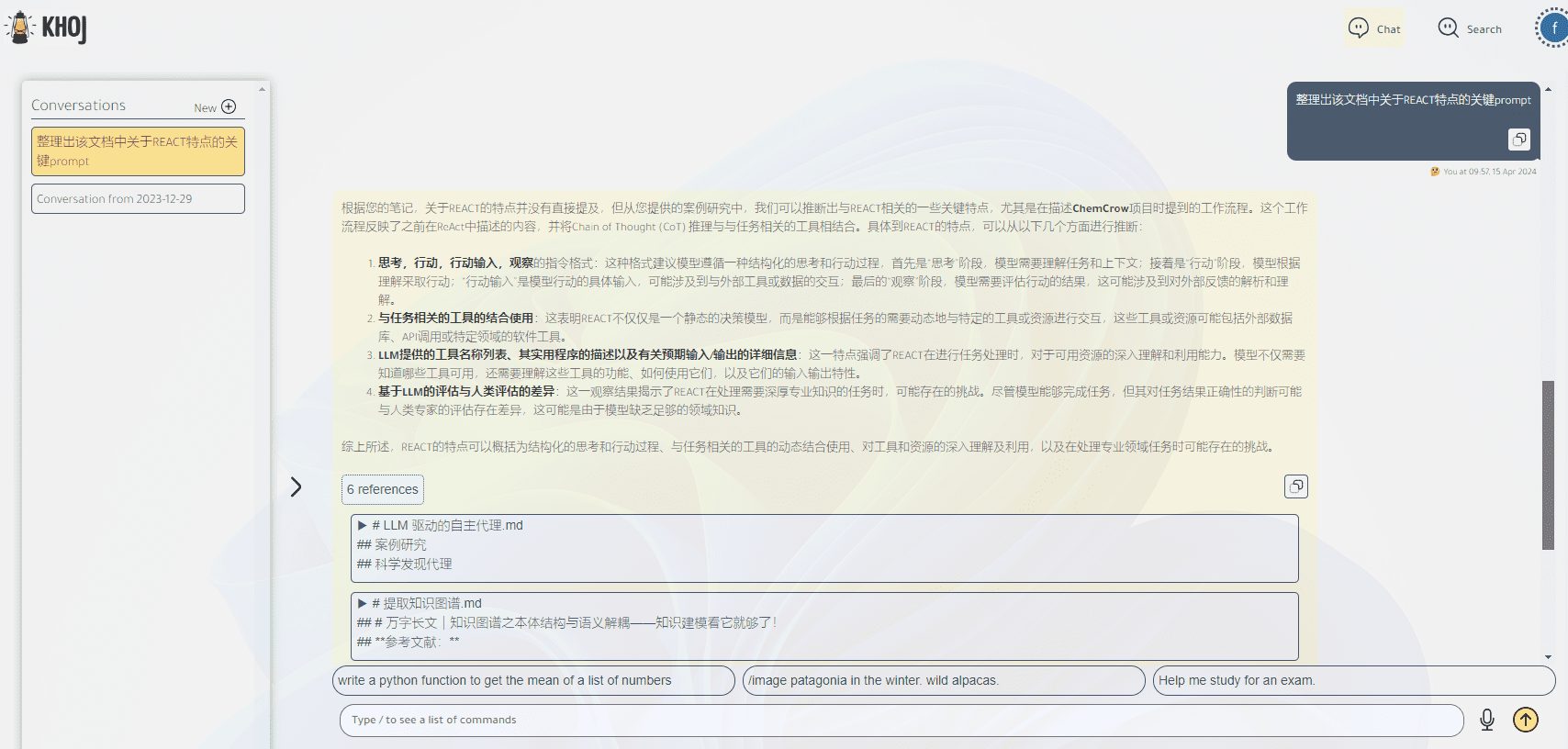

- Función de preguntas y respuestas en vídeo: extrae respuestas precisas de los vídeos en función de las preguntas de los usuarios.

- Generación de resúmenes de vídeo: Destile el contenido clave del vídeo para generar un resumen conciso.

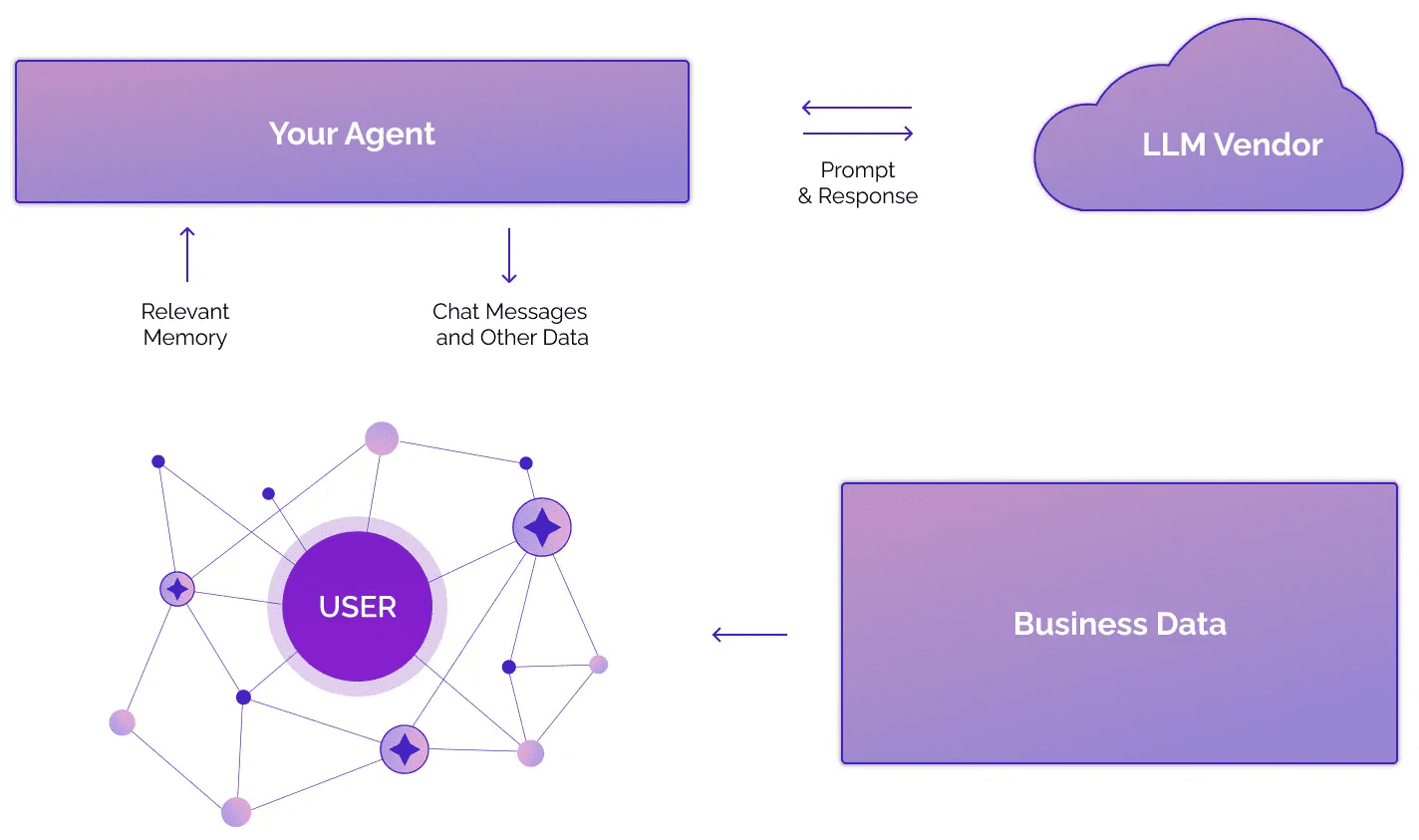

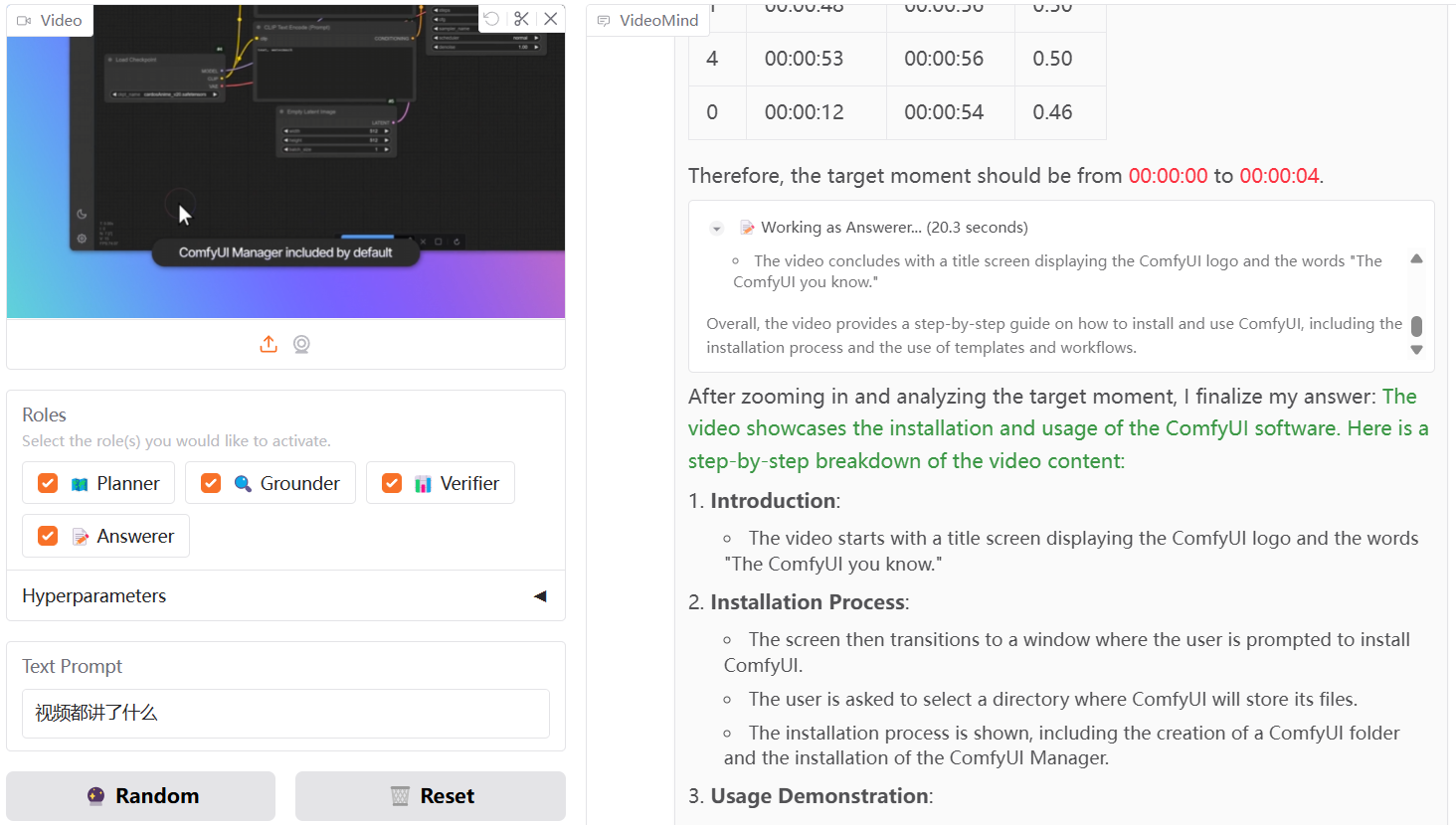

- Marco de agentes multimodales: incluye planificadores, localizadores, validadores y respondedores que colaboran en las tareas.

- Tecnología Chain-of-LoRA: multifuncionalidad con un solo modelo y menor consumo de recursos.

- Soporte de hardware múltiple: funciona con GPUs NVIDIA o NPUs Ascend.

- Apoyo eficaz a la formación: integración de DeepSpeed, LoRA, FlashAttention2 y otras tecnologías.

- Demostración en línea: Experimente rápidamente la funcionalidad a través de la interfaz de Gradio.

Utilizar la ayuda

VideoMind es un proyecto de código abierto, los usuarios necesitan descargar el código y configurar el entorno para utilizarlo. La siguiente es una guía detallada que cubre la instalación y el uso de las funciones.

Proceso de instalación

- Repositorio de código clonado

Ejecute el siguiente comando en el terminal para descargar el código fuente de VideoMind:

git clone https://github.com/yeliudev/VideoMind.git

Vaya al catálogo de proyectos:

cd VideoMind

- Configuración del entorno Python

Crea un entorno virtual usando conda (Python 3.12 recomendado):

conda create -n videomind python=3.12 -y

conda activate videomind

- Instalación de bibliotecas dependientes

Ejecute el siguiente comando para instalar las dependencias necesarias:

pip install -r requirements.txt

Para una formación eficaz, instale DeepSpeed:

pip install deepspeed

- Descargar modelos y conjuntos de datos

- Visite https://huggingface.co/collections/yeliudev/videomind-67dd41f42c57f0e7433afb36 para descargar modelos preentrenados (p. ej.

VideoMind-2B), descomprímalo en la carpetamodelsCarpeta. - Los conjuntos de datos están disponibles en https://huggingface.co/datasets/yeliudev/VideoMind-Dataset下载 e incluyen 27 conjuntos de datos de vídeo y VideoMind-SFT (481K datos de entrenamiento) colocados en el

dataCatálogo.

- instalación de prueba

Ejecute el script de prueba para confirmar que el entorno es correcto:

python test.py

Funciones principales

1. Posicionamiento temporal del vídeo de formato largo

- Preparar el vídeo: Coloque el archivo de vídeo en el

data/videosCatálogo, soporta MP4, AVI y otros formatos. - Ejecutar comando::

python run_grounding.py --video_path data/videos/sample.mp4 --query "找到讨论AI的部分"

- Resultado: Devuelve el intervalo de tiempo, por ejemplo "00:05:12 - 00:07:34".

2. Concurso de vídeo

- Cuestiones de entrada: Nuevo

query.txtEscribe preguntas como "¿Quién es el protagonista del vídeo?". . - ejecutar un comando::

python run_qa.py --video_path data/videos/sample.mp4 --query_file query.txt

- Obtener respuestasEl terminal muestra resultados como "El protagonista es Li Ming".

3. Generación de vídeos de síntesis

- Ejecutar comando::

python run_summary.py --video_path data/videos/sample.mp4

- Ver resumenLos resultados se guardan como

summary.txtPor ejemplo: "El vídeo introduce una conferencia sobre ciencia y tecnología".

Función destacada Operación

Tecnología de cadena de LoRA

- VideoMind utiliza un único modelo para conmutar roles a través de adaptadores LoRA. Los archivos de configuración están disponibles en

config/lora.yamlAjustablerankEfecto potenciador de los parámetros:

lora:

rank: 16

Demostración en línea

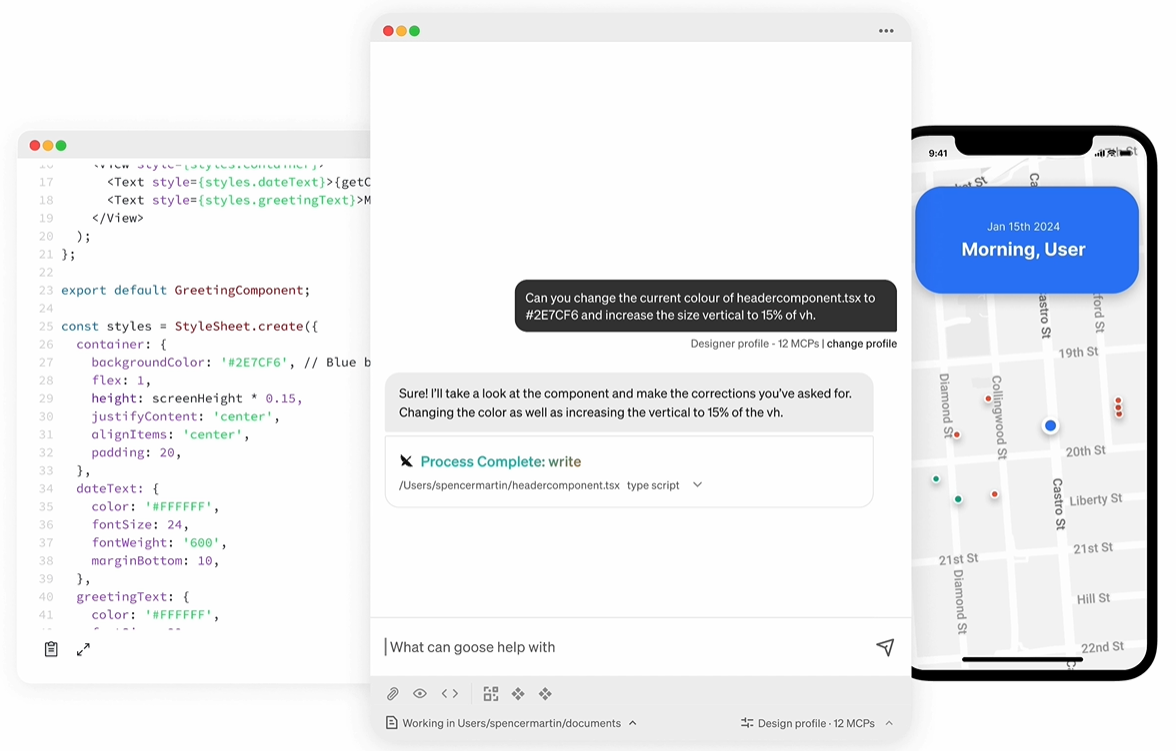

- No es necesaria una instalación local, por lo que puede visitar https://huggingface.co/spaces/yeliudev/VideoMind-2B, cargar un vídeo e introducir su pregunta para experimentar directamente la funcionalidad. Para más información, consulte

docs/DEMO.md.

Modelos de formación

- Preparar los datos: Uso

VideoMind-SFTu otros 27 conjuntos de datos, colocados en eldataCatálogo. - formación inicialCorre:

python train.py --dataset data/VideoMind-SFT --model models/VideoMind-2B

- Supervisar la formación: Soporte para Tensorboard o Wandb para ver el progreso, ver configuración para más detalles.

docs/TRAIN.md.

advertencia

- Cuando el archivo de vídeo es demasiado grande, se recomienda procesarlo en segmentos para evitar el desbordamiento de la memoria.

- Los usuarios de la NPU Ascend deben instalar el controlador Ascend y añadir los parámetros cuando se ejecute.

--device ascend. - Para más información sobre la puesta en marcha, consulte

docs/EVAL.mdincluyendo directrices de evaluación comparativa.

Con estos pasos, los usuarios pueden instalar y utilizar rápidamente VideoMind para manejar largas tareas de vídeo.

escenario de aplicación

- Análisis del contenido de los vídeos

Los usuarios pueden utilizar VideoMind para analizar vídeos largos de YouTube, localizar clips clave o generar resúmenes para ahorrar tiempo de visionado. - Educación e investigación

Los estudiantes o investigadores que trabajen con vídeos de conferencias pueden preguntar "¿Qué algoritmos se trataron?" y obtener las respuestas, organizando los apuntes de forma más eficiente. - Auditoría de contenidos

Los administradores de plataformas lo utilizan para verificar que el contenido de vídeo es conforme, por ejemplo, para comprobar si hay clips infractores.

CONTROL DE CALIDAD

- ¿Qué longitud de vídeo puede manejar VideoMind?

Dependiendo del hardware, 16 GB de RAM pueden gestionar una hora de vídeo, y 32 GB admiten contenidos más largos. - ¿Cuál es la diferencia entre una demostración en línea y una implantación local?

La versión en línea no requiere instalación pero tiene funciones limitadas; la versión local admite formación personalizada y procesamiento a gran escala. - ¿Cómo se utilizan los conjuntos de datos?

Se utilizaron 27 conjuntos de datos para el entrenamiento y la evaluación, y VideoMind-SFT fue adecuado para optimizar los modelos, como se describe en https://huggingface.co/datasets/yeliudev/VideoMind-Dataset.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...