Romper los silos de información: Dify añade la búsqueda conectada al asistente de IA DeepSeek localizado

Tutoriales prácticos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 57.9K 00

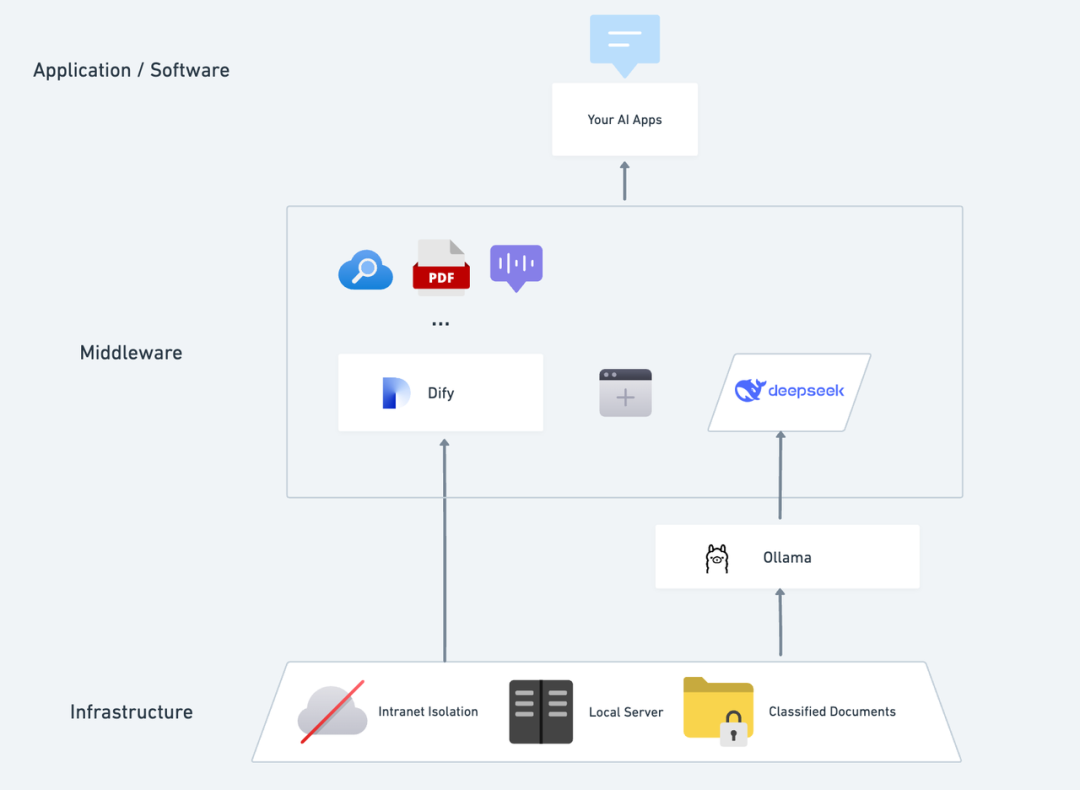

Imagina cómo sería tener una aplicación privada de IA que fuera autónoma, confidencial y capaz de analizar texto local, ofrecer conversaciones precisas en cualquier momento y tener la capacidad de realizar búsquedas a través de Internet. En este artículo, te llevaremos paso a paso a través del proceso de construcción de una. DeepSeek + Ollama + Dify El Asistente AI es un asistente AI privatizado con todas las funciones que puede desplegarse rápidamente.

DeepSeek Se trata de un revolucionario modelo de lenguaje de código abierto de gran tamaño, su avanzada arquitectura algorítmica y su capacidad de "cadena reflexiva", hacen que la interacción de diálogo AI sea más inteligente y natural. Con el despliegue privado, puede controlar totalmente la seguridad de sus datos y ajustar de forma flexible el plan de despliegue según sus necesidades, creando su propio... "Sistema operativo de IA" .

Dify Como la misma plataforma de desarrollo de aplicaciones de IA de código abierto, también proporciona una completa solución de despliegue privado y un potente soporte de herramientas de terceros. Incluye búsqueda en la red, funciones de análisis de documentos, etc. Dify soporta 1000+ modelos open-source o closed-source de todo el mundo). Al mismo tiempo, Dify soporta 1000+ modelos de código abierto o cerrado de todo el mundo, por lo que puede llamar a cualquier modelo para potenciar sus aplicaciones de IA.

La perfecta integración de DeepSeek en la plataforma Dify no solo garantiza la privacidad de los datos, sino que también facilita a los desarrolladores la puesta en marcha y la creación de potentes aplicaciones de IA en servidores locales, lo que permite a las empresas o equipos aprovechar realmente la potencia de DeepSeek. "Autonomía de los datos" y "personalización flexible" . Si ha desplegado entreDespliegue privado de DeepSeek + Dify: creación de un sistema local de asistente de inteligencia artificial seguro y controlable puede ir directamente a la sección de búsqueda de redes.

Dify X DeepSeek Ventajas del despliegue privado:

- Llame a más de 1000 capacidades de modelos: Dify es una plataforma de modelo neutral que hace pleno uso de las capacidades de inferencia de diferentes grandes modelos (PS: puede ser llamado usando múltiples plataformas MaaS soportadas por Dify). DeepSeek R1 para resolver el problema de la inestabilidad de las llamadas oficiales a la API, consulte el final del método detallado de configuración)

- Excelente rendimiento: Una experiencia de diálogo comparable a un modelo de negocio que maneja con facilidad diversos escenarios complejos.

- Aislamiento ambiental: Funciona completamente offline, eliminando cualquier riesgo de fuga de datos.

- Los datos pueden controlarse: Usted elige, tiene el control total de los datos y cumple los requisitos de la industria.

preposicionamientoAdquiera un servidor (VPS o VDS) que cumpla las siguientes condiciones:Entorno de hardware:

preposicionamientoAdquiera un servidor (VPS o VDS) que cumpla las siguientes condiciones:Entorno de hardware:

- CPU >= 2 núcleos

- Memoria de vídeo/RAM ≥ 16 GiB (recomendado)

Entorno de software:

- Docker

- Docker Compose

- Ollama

- Edición comunitaria de Dify

Inicio de la implantación 1. Instale Ollama

Del mismo modo que los teléfonos móviles suelen tener una tienda de aplicaciones para ayudarte a encontrar y descargar aplicaciones rápidamente, los modelos de IA tienen su propia "tienda de aplicaciones" dedicada.

Ollama es un cliente de gestión de grandes modelos de código abierto multiplataforma (macOS, Windows, Linux) diseñado para desplegar sin problemas grandes modelos lingüísticos (LLM) como DeepSeek, Llama, Mistral y otros.

Los modelos de gran tamaño pueden instalarse y desplegarse con un solo comando, y todos los datos de uso de LLM se almacenan localmente en la máquina, lo que proporciona una total privacidad y seguridad de los datos para cumplir los requisitos de conformidad.

Visite el sitio web de Ollama (https://ollama.com/) y siga las instrucciones de la página web para descargar e instalar el cliente Ollama. Una vez finalizada la instalación, ejecute ollama -v en el terminal para obtener el número de versión.

~ ollama -v

ollama version is 0.5.5

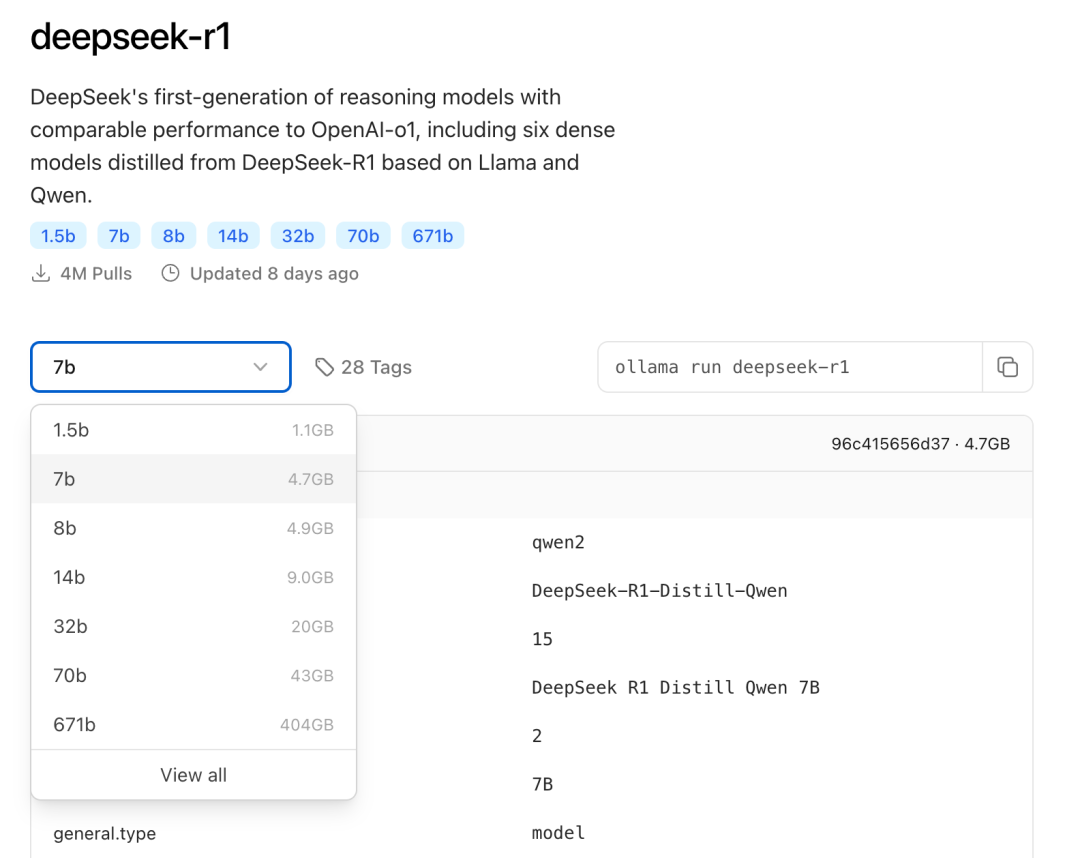

Seleccione el modelo de tamaño de DeepSeek adecuado para la implantación en función de la configuración real del entorno. Se recomienda el modelo de tamaño 7B para la instalación inicial.

El sufijo B indica los parámetros de entrenamiento del modelo. En teoría, cuanto mayor sea el parámetro, más inteligente será el rendimiento del modelo y mayor será la memoria gráfica necesaria.

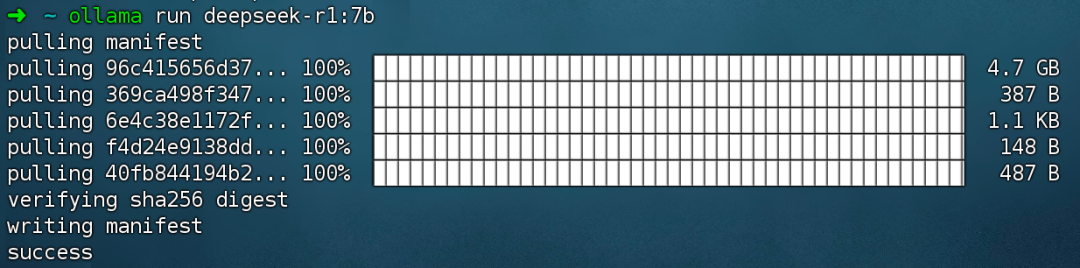

Ejecutar comando ollama run deepseek-r1:7b Instale el modelo DeepSeek R1.

2. Instale Dify Community Edition

Al igual que una casa necesita fontanería y electricidad, también necesita una cocina que funcione a pleno rendimiento para que el chef produzca comida deliciosa, y ahí es donde entra Dify. Como popular proyecto de código abierto de GitHub, Dify tiene una cadena de herramientas integrada que abarca toda la gama de lo que se necesita para crear una aplicación de IA. Con las potentes capacidades de modelado de DeepSeek, cualquiera puede crear rápidamente la aplicación de IA que desee sin necesidad de tener conocimientos complejos de código.

Visite la dirección del proyecto GitHub de Dify y ejecute los siguientes comandos para completar el repositorio de código y el proceso de instalación.

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -d # 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

Tras ejecutar el comando, el terminal mostrará automáticamente el estado y la asignación de puertos de todos los contenedores. Si se producen interrupciones o errores, asegúrese de que Docker y Docker Compose están instalados. para obtener instrucciones detalladas, consulte lo siguiente.

Despliegue Dify Community Edition:

https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/docker-compose

Dify Community Edition utiliza el puerto 80 por defecto, y su plataforma privatizada Dify se puede acceder mediante la vinculación a http://your_server_ip.

Para conmutar los puertos de acceso, consulte este documento: https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/faq#id-5.-ru-he-xiu-gai-ye-mian-duan-kou

3. Conexión de DeepSeek a Dify

Después de desplegar el modelo DeepSeek con Dify Community Edition, haga clic en el enlace http://your_server_ip para entrar en la plataforma Dify, a continuación, haga clic en la esquina superior derecha Avatar → Configuración → Proveedor de modelos. Seleccione Ollama y pulse Añadir modelo.

Seleccione el tipo de modelo LLM.

- Nombre del modelo, introduzca el nombre del modelo desplegado. El modelo desplegado anteriormente es deepseek-r1 7b, por lo que introduzca: deepseek-r1:7b.

- URL base, introduzca la dirección donde se ejecuta el cliente Ollama, normalmente http://your_server_ip:11434. En caso de problemas de conexión, lea las FAQ al final de este artículo.

- Todas las demás opciones se dejan en sus valores por defecto. Según la descripción del modelo DeepSeek, la longitud máxima generada es de 32.768 tokens.

Empezar a crear aplicaciones de IA

Las siguientes secciones muestran cómo crear distintos tipos de aplicaciones de IA:

- Aplicación de diálogo simple

- Aplicaciones de diálogo sencillas con capacidad de análisis de documentos

- Aplicaciones programables con búsqueda en red

DeepSeek AI Chatbot (aplicación sencilla)

- Toca "Crear una aplicación en blanco" en el lado izquierdo de la página principal de la plataforma Dify, selecciona el tipo de aplicación "Asistente de Chat" y nómbrala simplemente.

- En la esquina superior derecha, en Tipo de aplicación, seleccione el framework Ollama dentro de la sección

deepseek-r1:7bModelos.

- Compruebe que la aplicación AI funciona introduciendo contenido en el cuadro de diálogo de vista previa. La generación de una respuesta significa que la construcción de la aplicación AI se ha completado.

- Pulsa el botón Publicar en la parte superior derecha de la aplicación para obtener un enlace a la aplicación de IA y compartirla con otros o incrustarla en otro sitio web.

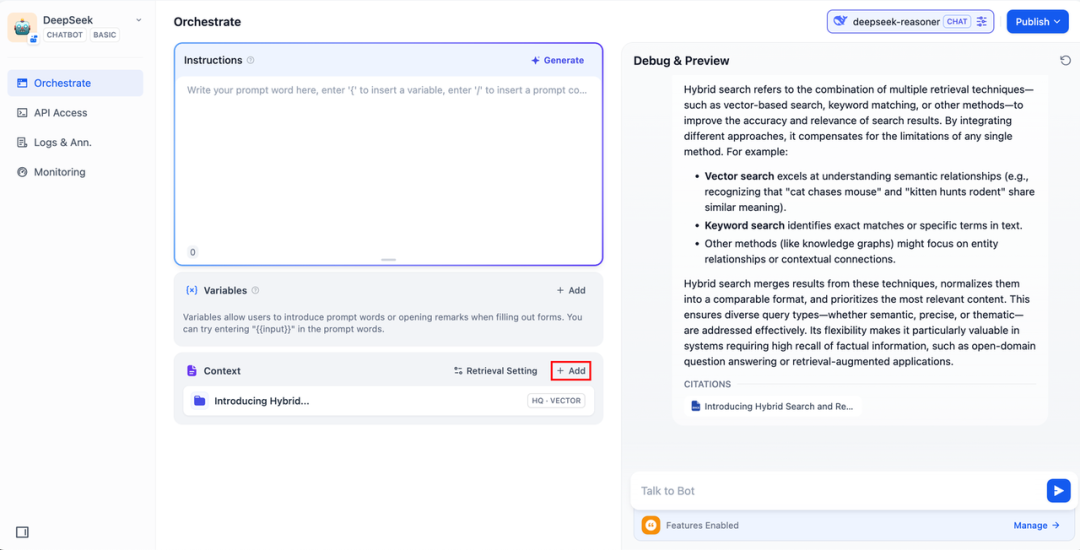

DeepSeek AI Chatbot + Base de conocimientos

Un reto importante para la modelización lingüística a gran escala (LLM) es que los datos de entrenamiento no se actualizan en tiempo real y la cantidad de datos puede ser insuficiente, lo que puede llevar a que el modelo genere respuestas "fantasma".

Para resolver este problema ha surgido la tecnología de Generación Aumentada por Recuperación (RAG). Al recuperar los conocimientos pertinentes y proporcionar al modelo la información contextual necesaria, esta información se incorpora al proceso de generación de contenidos, mejorando así la precisión y profesionalidad de la respuesta.

En la práctica, cuando usted carga documentos internos o información profesional, la función de base de conocimientos de Dify puede asumir el papel de RAG para ayudar a LLM a proporcionar respuestas más específicas basadas en información especializada, compensando así la falta de datos de entrenamiento del modelo.

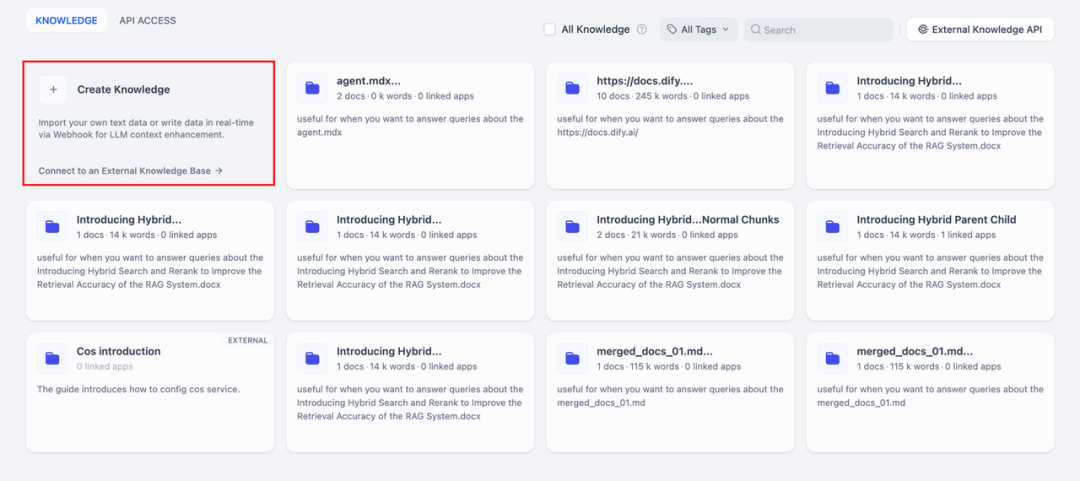

1. Crear una base de conocimientos

Cargue documentos en la Base de Conocimientos que deban ser analizados por la IA. Para asegurarse de que el modelo DeepSeek entiende con precisión el contenido del documento, se recomienda procesar el texto utilizando un modelo de "segmentación padre-hijo" - este modelo preserva mejor la estructura jerárquica y el contexto del documento.

Para conocer los pasos detallados de configuración, consulte este documento:

https://docs.dify.ai/zh-hans/guides/knowledge-base/create-knowledge-and-upload-documents

2. Integración de la base de conocimientos en aplicaciones de IA

Añada una base de conocimientos al "contexto" de la aplicación de IA e introduzca la pregunta pertinente en el cuadro de diálogo. lLM tomará primero de la base de conocimientos el contexto relevante para la pregunta y, a continuación, lo resumirá y proporcionará una respuesta de mayor calidad.

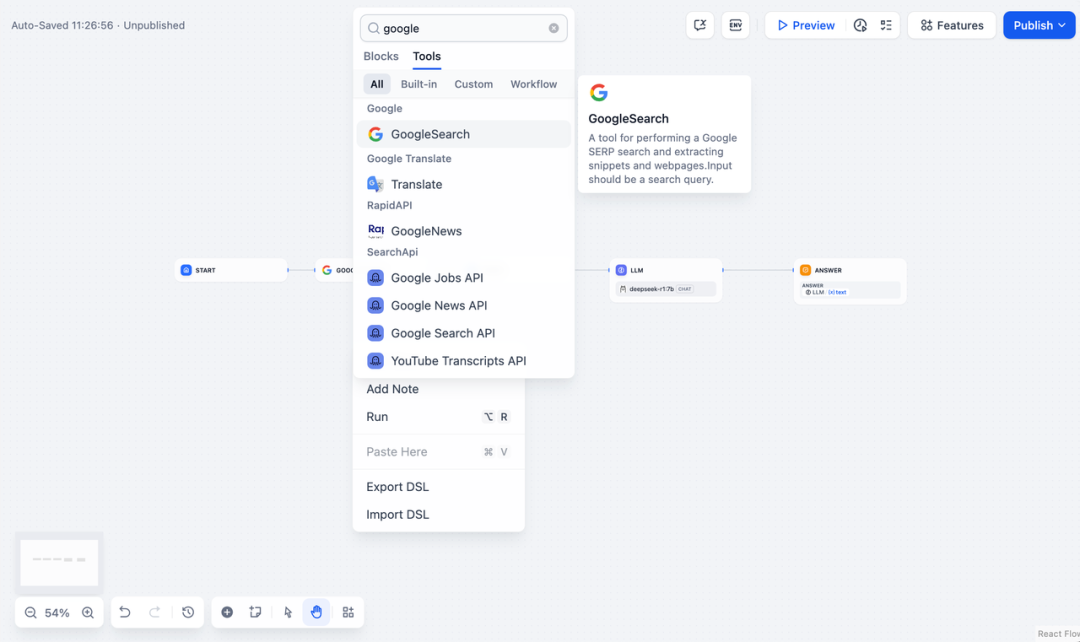

DeepSeek AI Chatflow / Workflow (búsqueda en red)

Chatflow / Flujo de trabajo Las aplicaciones pueden ayudarle a orquestar y crear aplicaciones de IA con funciones más complejas, como dotar a DeepSeek de la capacidad de realizar búsquedas en red, reconocimiento de archivos, reconocimiento de voz, etc. Por motivos de espacio, en las siguientes secciones se muestra cómo dotar a DeepSeek de la capacidad de realizar búsquedas en red, reconocimiento de archivos, reconocimiento de voz, etc. Habilitar las funciones de búsqueda en red .

Para utilizar la aplicación directamente, puede descargar el archivo DSL haciendo clic en el siguiente enlace e importarlo a la plataforma Dify.

Dirección de descarga del archivo DSL de la aplicación:

https://assets-docs.dify.ai/2025/02/41a3564694dd3f2803ad06a29f5b3fef.yml

- Pulse "Crear una aplicación en blanco" en el lado izquierdo de la página principal de la plataforma Dify, seleccione una aplicación de tipo "Chatflow" o "Workflow" y simplemente nómbrela.

2. AñadirBúsqueda en Internetrellene la clave API para activar la funcionalidad del nodo. Rellene el campo Consulta con la clave API proporcionada por el nodo inicial. {{#sys.query#}} Variables.

Visite el siguiente sitio web para obtener una clave API:

https://serpapi.com/users/sign_in

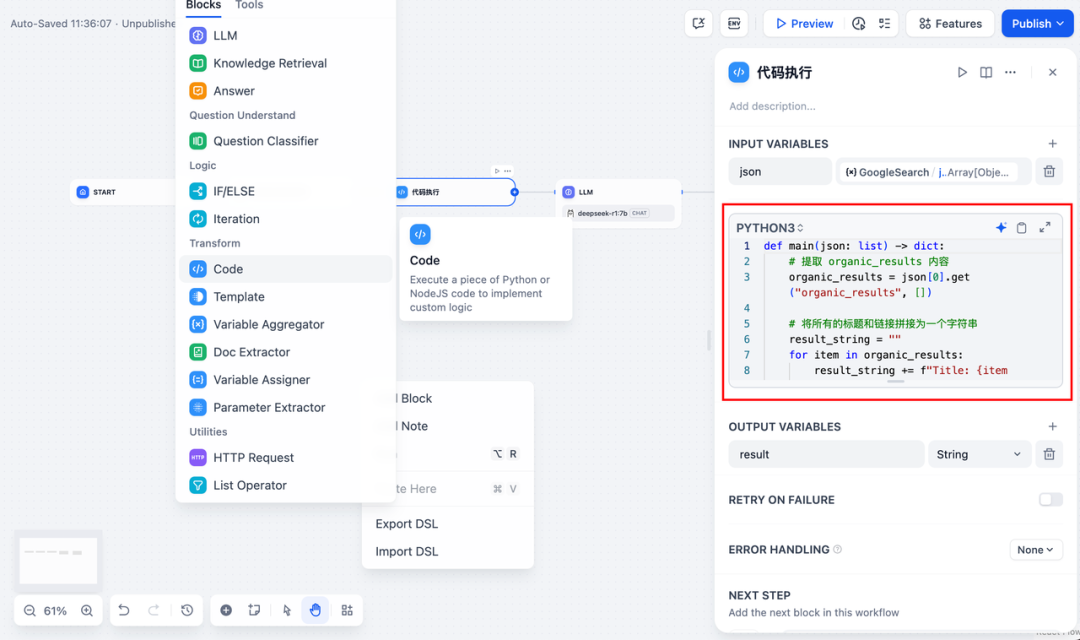

3. Añadaejecución de códigonodo. Dado que la salida de la herramienta de búsqueda es un fragmento de código JSON, es necesario añadir un nodo de ejecución de código para extraer el contenido necesario. Rellene la variable de entrada con la variable de salida JSON de la herramienta de búsqueda y rellene el siguiente código en el nodo de ejecución de código:

def main(json: list) -> dict:

# 提取 organic_results 内容

organic_results = json[0].get("organic_results", [])

# 将所有的标题和链接拼接为一个字符串

result_string = ""

for item in organic_results:

result_string += (

f"Title: {item['title']}\n"

f"Link: {item['link']}\n"

f"Snippet: {item['snippet']}\n\n"

)

# 返回拼接后的字符串作为 result

return {

"result": result_string,

}

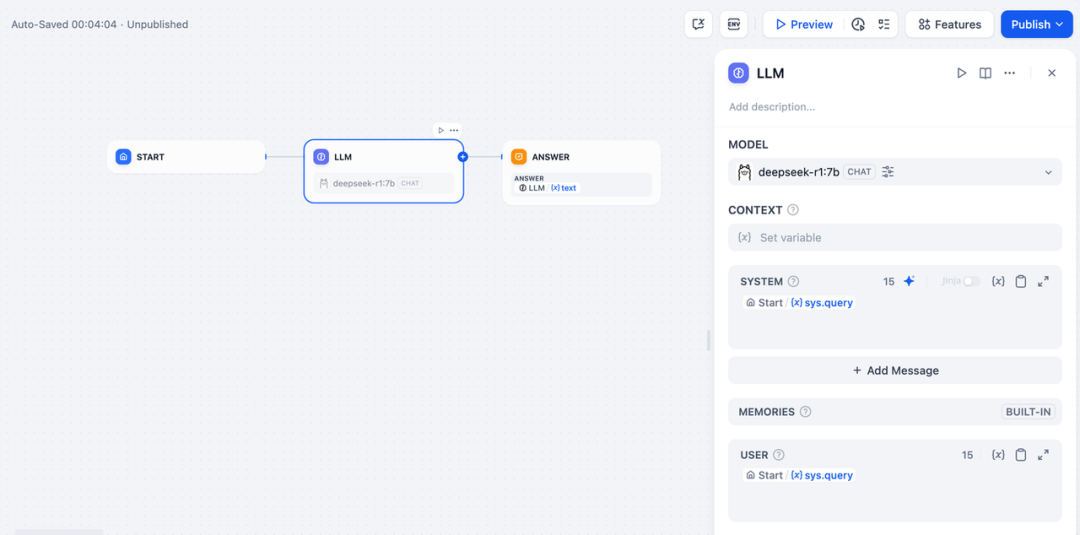

- Para añadir un nodo LLM, seleccione el marco Ollama en la sección

deepseek-r1:7by añada la palabra de aviso del sistema dentro del{{#sys.query#}}para procesar los comandos del nodo de inicio introducidos por el usuario.

En caso de anomalía de la API, puede gestionarse de forma flexible mediante la función de equilibrio de carga o el nodo de gestión de anomalías.

equilibrio de cargaLas solicitudes de API pueden distribuirse entre varios puntos finales de API, como se describe detalladamente en https://docs.dify.ai/zh-hans/guides/model-configuration/load-balancing.

Mecanismo de gestión de excepcionesPosibilidad de lanzar mensajes de fallo en caso de errores de nodo sin interrumpir el proceso principal. Para una descripción detallada, consulte: https://docs.dify.ai/zh-hans/guides/workflow/error-handling

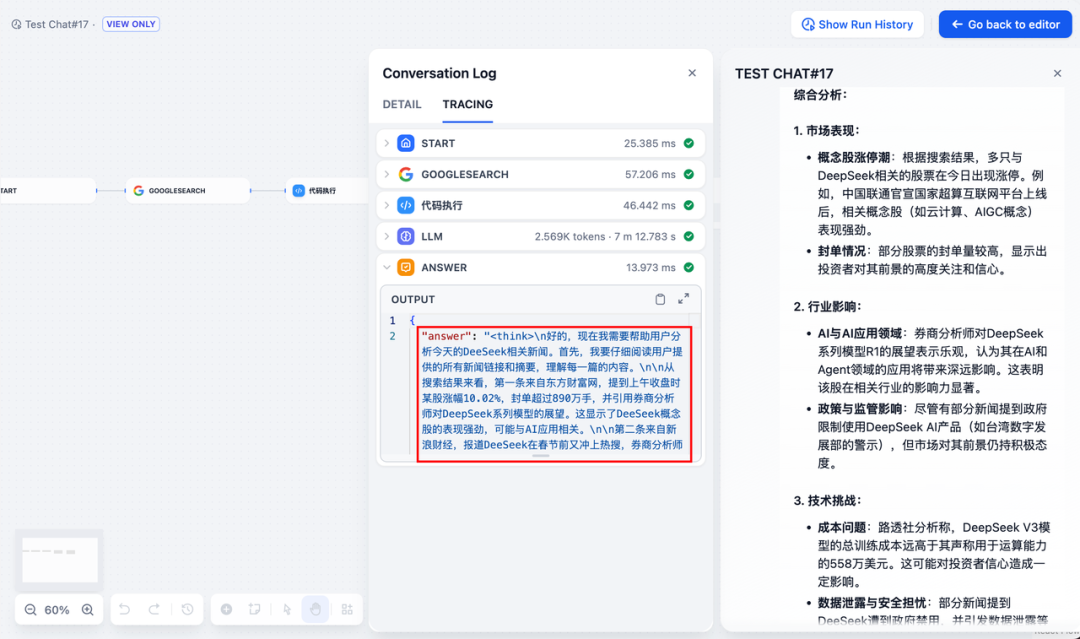

- Añada el nodo final, haga referencia a las variables de salida del nodo LLM y complete la configuración. Puedes introducir contenido en el cuadro de vista previa para realizar pruebas. Generar una respuesta significa que la construcción de la aplicación AI está completa y puedes ver el proceso de razonamiento de LLM dentro del log.

problemas comunes

1. Errores de conexión durante el despliegue de Docker

Los siguientes errores pueden ser encontrados al desplegar Dify y Ollama con Docker:

HTTPConnectionPool(host=127.0.0.1, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

HTTPConnectionPool(host=localhost, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

Causa del error: Este error se produce porque el servicio Ollama no es accesible en el contenedor Docker. localhost suele apuntar al propio contenedor, no al host o a otro contenedor. Para resolver este problema, debe exponer el servicio Ollama a la red.

Método de configuración del entorno macOS:

Si Ollama se ejecuta como una aplicación de macOS, es necesario establecer las variables de entorno mediante launchctl:

- Establezca las variables de entorno llamando a launchctl setenv:

launchctl setenv OLLAMA_HOST "0.0.0.0" - Reinicie la aplicación Ollama.

- Si los pasos anteriores no funcionan, puede utilizar el siguiente método: el problema es que dentro de docker, debe conectarse a host.docker.internal para acceder al host de docker, por lo que sustituir localhost por host.docker.internal service funcionará: http://host. docker.internal:11434

Método de configuración del entorno Linux: Si Ollama se ejecuta como un servicio systemd, debe utilizar el comando s ystemctl Configuración de variables de entorno:

- Esto se consigue llamando a la función

systemctl edit ollama.serviceEdita el servicio systemd. Esto abrirá un editor. - Para cada variable de entorno, el

[Service]Añada una línea debajo de la secciónEnvironment::[Service] Environment="OLLAMA_HOST=0.0.0.0" - Guardar y salir.

- Recarga systemd y reinicia Ollama:

systemctl daemon-reload systemctl restart ollama

Método de configuración del entorno Windows:

En Windows, Ollama hereda las variables de entorno del usuario y del sistema.

- En primer lugar, haga clic en Ollama en la barra de tareas para salir del programa.

- Editar las variables de entorno del sistema desde el panel de control

- Edite o cree nuevas variables para su cuenta de usuario, tales como

OLLAMA_HOSTyOLLAMA_MODELSetc. - Haga clic en OK / Aplicar para guardar

- Ejecutar en una nueva ventana de terminal

ollama

2. ¿Cómo puedo cambiar la dirección y el número de puerto del servicio Ollama?

Ollama Encuadernación por defecto 127.0.0.1 puerto 11434, al que puede acceder a través de la dirección OLLAMA_HOST Las variables de entorno modifican la dirección de enlace.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...