¿Qué es Transformer?

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 55.1K 00

Transformer es una arquitectura de modelo de aprendizaje profundo para el procesamiento del lenguaje natural (PLN), propuesta por Vaswani et al. en 2017. Se utiliza principalmente para procesar tareas de secuencia a secuencia, como la traducción automática, la generación de texto, etc.

En términos sencillos, el modelo Transformer de generación de texto funciona según el principio de "predicción de la palabra siguiente".

Dado un texto (prompt) por el usuario, el modelo predice cuál es más probable que sea la siguiente palabra. La principal innovación y potencia de los Transformers es su uso del mecanismo de autoatención, que les permite procesar secuencias enteras y captar dependencias a larga distancia de forma más eficiente que las arquitecturas anteriores (RNNs).

Además, huggingface/transformers en GitHub es un repositorio de la implementación de HuggingFace del Transformer, incluyendo la implementación del Transformer y un gran número de modelos pre-entrenados.

Los LLM actuales se basan básicamente en la arquitectura Transformer, con técnicas de optimización y métodos de entrenamiento mejorados.

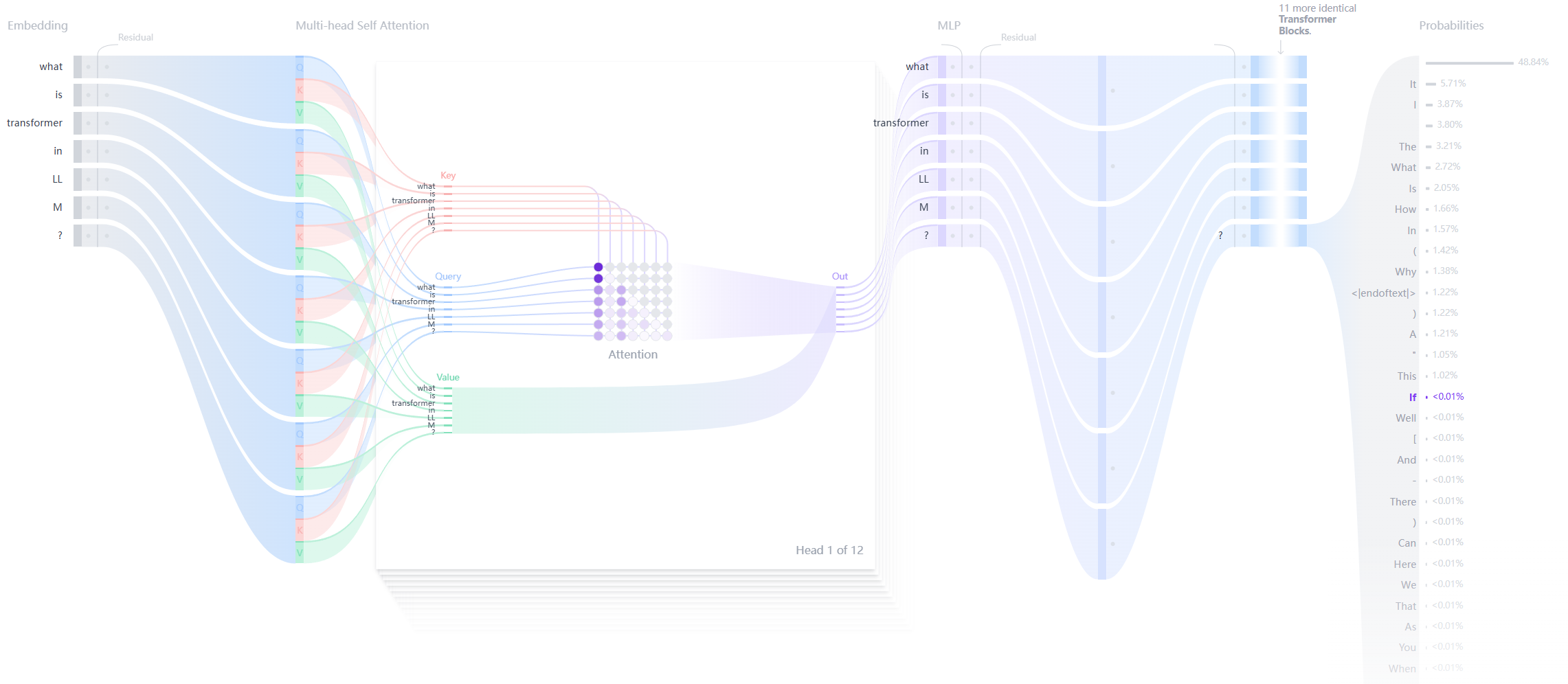

Estructura del transformador

Cada Transformador de Generación de Texto consta de tres componentes clave:

Capa de incrustación (Embedding) ::

- La entrada de texto se divide en unidades más pequeñas llamadas tokens, que pueden ser palabras o subpalabras.

- Estos elementos léxicos se convierten en vectores numéricos denominados incrustaciones.

- Estos vectores de incrustación captan el significado semántico de las palabras

Bloque transformador ::

Se trata del bloque básico para que el modelo procese y transforme los datos de entrada. Cada bloque consta de:

- Mecanismo de atención ::

- Componentes del núcleo del bloque Transformador

- Permitir que los elementos léxicos se comuniquen entre sí

- Captación de información contextual y relaciones entre palabras

- Capa Perceptrón Multicapa (MLP) ::

- Una red feed-forward que procesa cada elemento léxico de forma independiente.

- El objetivo de la capa atencional es dirigir la información entre los elementos léxicos

- El objetivo de MLP es optimizar la representación de cada elemento léxico

Probabilidades de salida ::

- Capas finales lineal y softmax

- Conversión de incrustaciones procesadas en probabilidades

- Permite al modelo predecir el siguiente elemento léxico de la secuencia

Ventajas del transformador:

- paralelización A diferencia de las RNN, los Transformers no necesitan procesar datos secuencialmente, por lo que pueden aprovechar mejor las GPU para el cálculo paralelo y mejorar la velocidad de entrenamiento.

- dependencia a larga distancia El mecanismo de autoatención permite al Transformer capturar eficazmente las dependencias de largo alcance en las secuencias.

- destreza Transformer puede ampliarse fácilmente a modelos más grandes (por ejemplo, BERT, GPT, etc.) y funciona bien en diversas tareas de PLN.

Desventajas del transformador:

- Alta complejidad computacional La complejidad computacional del mecanismo de autoatención es O(n^2), que consume más recursos computacionales cuando la longitud de la secuencia de entrada es larga.

- Gran demanda de datos Los transformadores suelen requerir una gran cantidad de datos para su entrenamiento con el fin de explotar plenamente su rendimiento.

- Falta de información de secuencia intrínseca El mecanismo de procesamiento de secuencias: Dado que no existe un mecanismo de procesamiento de secuencias incorporado (por ejemplo, pasos temporales en las RNN), se necesitan mecanismos adicionales (por ejemplo, codificación de posición) para introducir información de secuencias.

Referencias

La primera de estas dos referencias es el documento clásico sobre transformadores, Attention Is All You Need, en el que se propuso por primera vez el transformador.

La segunda es una explicación visual del transformador, para que pueda ver su estructura interna.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...