La necesidad de la ingeniería de indicios en la modelización de grandes lenguajes

Base de conocimientos de IAPublicado hace 2 años Círculo de intercambio de inteligencia artificial 29.1K 00

A continuación nos centraremos en la idea básica de la ingeniería de indicios y en cómo puede mejorar el rendimiento de los grandes modelos lingüísticos (LLM)...

Interfaz de LLM:Una de las razones clave por las que los grandes modelos lingüísticos están tan de moda es que sus interfaces de texto a texto permiten una experiencia operativa minimalista. En el pasado, la resolución de tareas con aprendizaje profundo normalmente requería que afináramos al menos algunos de los datos para enseñar al modelo a resolver la tarea correspondiente. Sin embargo, la mayoría de los modelos solo tenían profundidad experta en tareas específicas. Pero ahora, gracias a las excelentes capacidades de aprendizaje contextual de LLM, podemos resolver una gran variedad de problemas con una sola pista textual. El complejo proceso original de resolución de problemas ha sido abstraído por el lenguaje.

"La ingeniería de prompts es una disciplina relativamente nueva que se centra en el uso eficiente de modelos lingüísticos para desarrollar y optimizar prompts para una variedad de aplicaciones y temas de investigación." - Citado en [1]

¿Qué es el Proyecto Tip?La simplicidad de LLM lo hace accesible a más gente. No es necesario ser un científico de datos o un ingeniero de aprendizaje automático para utilizar LLM, basta con entender inglés (o cualquier idioma de tu elección) y podrás utilizar LLM para resolver problemas relativamente complejos. Sin embargo, cuando se permite que LLM resuelva problemas, los resultados a menudo dependen en gran medida de las pistas textuales que damos al modelo. Como resultado, la ingeniería de pistas (es decir, el método de utilizar la experiencia para probar diferentes pistas con el fin de optimizar el rendimiento de LLM) se ha hecho muy popular y ha tenido una gran influencia, lo que nos ha llevado a una serie de técnicas y mejores prácticas.

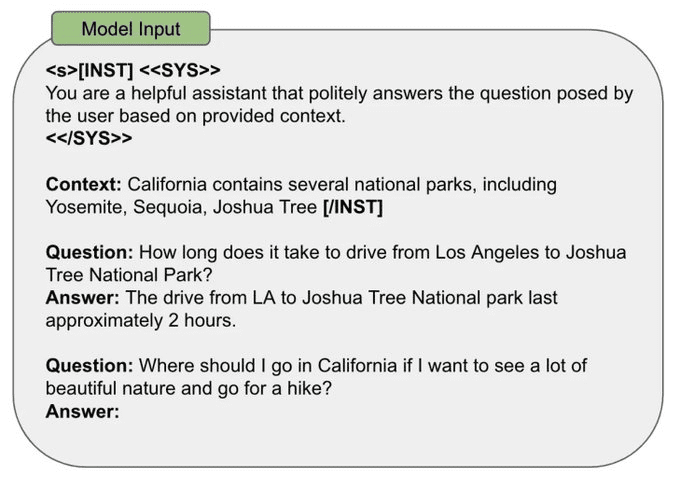

Cómo diseñar un aviso:Hay muchas maneras de diseñar las pistas LLM. Sin embargo, la mayoría de las estrategias de pistas comparten algunos puntos en común:

- Datos de entrada: los datos reales que LLM necesita procesar (por ejemplo, frases que traducir o categorizar, documentos que resumir, etc.).

- Ejemplos: Ejemplos de los pares correctos de entrada-salida que deben incluirse en el aviso.

- Instrucción: Descripción textual de los resultados esperados del modelo.

- Etiquetas (Indicadores): Etiquetas o elementos de formato que crean estructura en el aviso.

- Contexto: cualquier información adicional proporcionada al LLM en el aviso.

En la siguiente ilustración, damos un ejemplo de cómo se pueden fusionar todos los elementos de señalización antes mencionados en una única señal de categorización de frases.

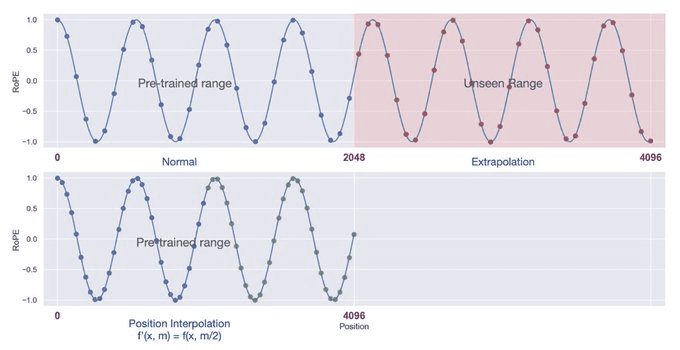

Ventana de contexto:Durante el preentrenamiento, el LLM ve secuencias de entrada de una longitud específica. Durante el preentrenamiento, elegimos esta longitud de secuencia como la "longitud de contexto" del modelo, que es la longitud de secuencia máxima que el modelo puede manejar. Si un texto es mucho más largo que la longitud de contexto preestablecida, el modelo puede reaccionar de forma impredecible y producir resultados incorrectos. En la práctica, sin embargo, existen métodos -como la autoexpansión [2] o la interpolación posicional [3]- que pueden utilizarse para ampliar la ventana de contexto del modelo.

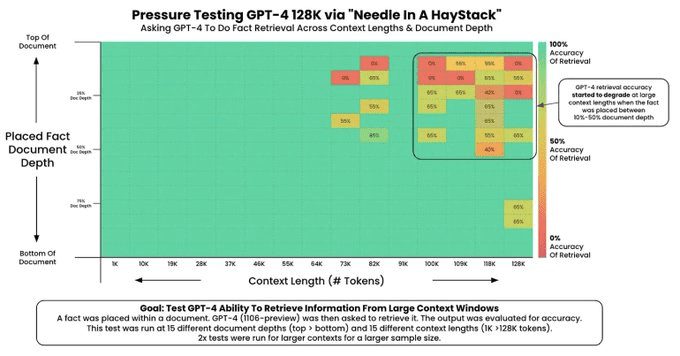

Las investigaciones recientes sobre los LLM han hecho hincapié en la creación de ventanas de contexto largas, que permiten al modelo procesar más información por pista (por ejemplo, más ejemplos o más contexto). Sin embargo, ¡no todos los LLM son capaces de procesar perfectamente la información contextual! La capacidad de un LLM para procesar información en una ventana de contexto larga suele evaluarse mediante la "prueba de la aguja en el pajar" [4], que.

1. Introducir un dato aleatorio en el contexto.

2. El modelo es necesario para constatar este hecho.

3. Repita esta prueba en una variedad de longitudes de contexto y ubicaciones de los hechos en el contexto.

Esta prueba genera una imagen como la siguiente (fuente [4]), en la que podemos detectar fácilmente los problemas con la ventana contextual.

Mi estrategia de ingeniería del taco:Los detalles de la ingeniería del taco variarán en función del modelo utilizado. Sin embargo, hay algunos principios generales que también pueden servir de guía en el proceso de ingeniería del taco:

- Enfoque empírico: el primer paso en la ingeniería de pistas es establecer una forma fiable de evaluar la pista (por ejemplo, mediante casos de prueba, evaluaciones humanas o LLM como rúbrica) para medir de forma sencilla las modificaciones de la pista.

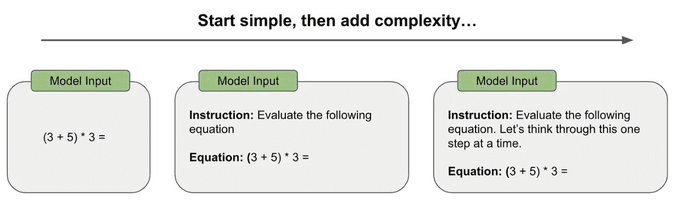

- Pasar de lo sencillo a lo complejo: los primeros intentos de incitación deben ser lo más sencillos posible, en lugar de intentar desde el principio incitaciones complejas de pensamiento en cadena u otras técnicas de incitación especializadas. La mayoría de los estímulos iniciales deben ser sencillos, y luego ir aumentando gradualmente su complejidad mientras se miden los cambios en el rendimiento para juzgar si es necesario añadir más complejidad.

- Sea lo más específico y directo posible: procure eliminar la ambigüedad en las instrucciones y sea lo más conciso, directo y específico posible al describir los resultados esperados.

- Incluya ejemplos: si le resulta difícil describir los resultados esperados, incluya ejemplos en la pregunta. Los ejemplos ofrecen ejemplos concretos de los resultados esperados y pueden eliminar la ambigüedad.

- Evitar la complejidad siempre que sea posible: a veces son necesarias estrategias complejas de incitación (por ejemplo, para resolver problemas de razonamiento de varios pasos), pero hay que pensárselo dos veces antes de adoptar este enfoque. Adopte un punto de vista empírico y utilice estrategias de evaluación establecidas para juzgar realmente si es necesario incluir dicha complejidad.

Para resumir todo lo anterior, mi estrategia personal de ingeniería de pistas consiste en i) comprometerme con un buen marco de evaluación, ii) empezar con una pista sencilla y iii) añadir poco a poco la complejidad necesaria para alcanzar el nivel de rendimiento deseado.

Anotación:

[1] https://promptingguide.ai[2] https://arxiv.org/abs/2401.01325

[3] https://arxiv.org/abs/2306.15595

[4] https://github.com/gkamradt/LLMTest_NeedleInAHaystack

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Puestos relacionados

Sin comentarios...