Thin-Plate-Spline-Motion-Model: Vídeo de referencia del mapa de retratos estáticos Vídeo de generación de movimiento de retratos

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 49.2K 00

Introducción general

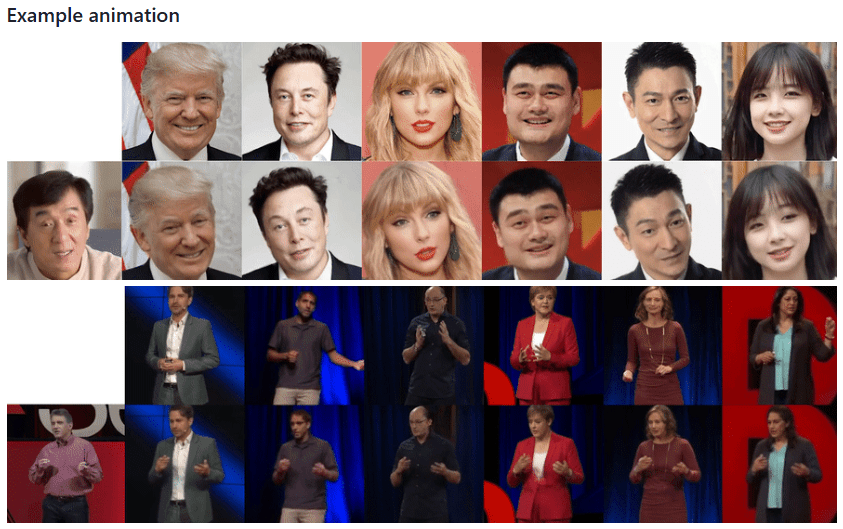

Thin-Plate-Spline-Motion-Model es un innovador proyecto de generación de animación de imágenes presentado en CVPR 2022. El proyecto se basa en la teoría de la Thin Plate Spline Transform, que permite realizar animaciones de alta calidad de imágenes estáticas basadas en vídeos de conducción. El proyecto adopta un marco de aprendizaje no supervisado de extremo a extremo, que es particularmente bueno para hacer frente a situaciones en las que hay grandes diferencias de pose entre la imagen de origen y el vídeo de conducción. Gracias a la innovadora introducción de la estimación de movimiento mediante splines finos y el enmascaramiento multirresolución, el modelo es capaz de generar efectos de animación más naturales y suaves. El proyecto no sólo hace pública la implementación completa del código, sino que también proporciona un modelo preentrenado y una demostración en línea, lo que permite a investigadores y desarrolladores reproducir y aplicar fácilmente la técnica.

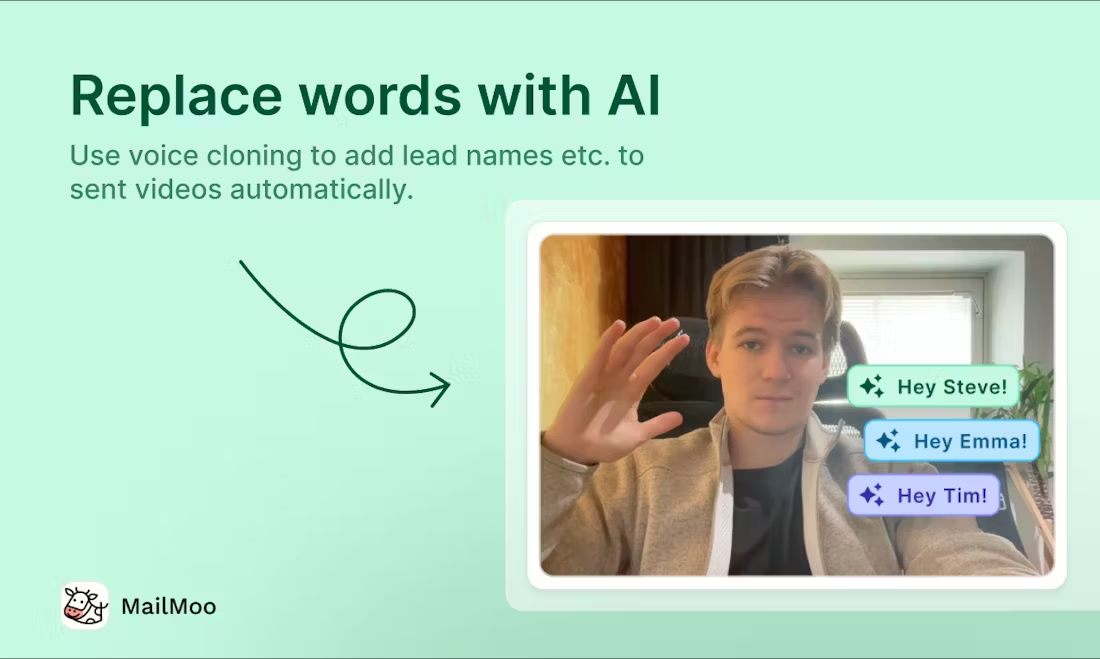

¿Qué pasa si el portavoz de imagen pública se va? Puedes conservar la imagen del portavoz y hacer que otra persona grabe un vídeo de forma que la imagen del portavoz imite las acciones del vídeo grabado para generar el vídeo, de forma similar a la tecnología de intercambio de caras.

Lista de funciones

- Generación de animación de imágenes estáticas

- Soporte para el entrenamiento en múltiples conjuntos de datos (VoxCeleb, TaiChi-HD, TED-talks, etc.)

- Modelos preentrenados disponibles para descargar

- Soporte para presentaciones en línea basadas en web (integración de Hugging Face Spaces)

- Compatible con Google Colab en línea

- Admite el entrenamiento multi-GPU

- Proporciona la función de formación de red AVD (Advanced Video Decoder)

- Función de evaluación de la reconstrucción de vídeo

- Compatibilidad con las llamadas a la API de Python

- Compatibilidad con el entorno Docker

Utilizar la ayuda

1. Configuración medioambiental

El proyecto requiere un entorno Python 3.x (se recomienda Python 3.9), y los pasos de instalación son los siguientes:

- Almacén de proyectos de clonación:

git clone https://github.com/yoyo-nb/Thin-Plate-Spline-Motion-Model.git

cd Thin-Plate-Spline-Motion-Model

- Instale la dependencia:

pip install -r requirements.txt

2. Preparación de los datos

El proyecto admite múltiples conjuntos de datos:

- MGif dataset: consulte el proyecto Monkey-Net para obtenerlo

- Conjuntos de datos TaiChiHD y VoxCeleb: procesamiento mediante directrices de preprocesamiento de vídeo

- Conjunto de datos TED-talks: siguiendo las directrices del proyecto MRAA

Descarga del conjunto de datos de preprocesamiento (VoxCeleb como ejemplo):

# 下载后合并解压

cat vox.tar.* > vox.tar

tar xvf vox.tar

3. Formación de modelos

Órdenes de formación básica:

CUDA_VISIBLE_DEVICES=0,1 python run.py --config config/dataset_name.yaml --device_ids 0,1

Formación de la red AVD:

CUDA_VISIBLE_DEVICES=0 python run.py --mode train_avd --checkpoint '{checkpoint_folder}/checkpoint.pth.tar' --config config/dataset_name.yaml

4. Evaluación de la reconstrucción de vídeo

CUDA_VISIBLE_DEVICES=0 python run.py --mode reconstruction --config config/dataset_name.yaml --checkpoint '{checkpoint_folder}/checkpoint.pth.tar'

5. Presentaciones de animación gráfica

Ofrece diversas formas de utilizarlo:

- Jupyter Notebook: Uso de demo.ipynb

- Línea de comandos Python:

CUDA_VISIBLE_DEVICES=0 python demo.py --config config/vox-256.yaml --checkpoint checkpoints/vox.pth.tar --source_image ./source.jpg --driving_video ./driving.mp4

- Demostración web:

- entrevistasEspacios para abrazar la caraDemostración en línea

- utilizarReplicarDemostración web de la plataforma

- aprobar (una factura o inspección, etc.)Google Colabestar en movimiento

6. Adquisición del modelo de preentrenamiento

Se proporcionan múltiples fuentes de descarga:

- Google Drive

- Disco Yandex

- Baidu.com (Código de extracto: 1234)

7. Precauciones

- Se recomienda entrenar con más datos y ciclos de entrenamiento más largos para obtener mejores resultados

- Garantizar suficiente memoria en la GPU

- Se recomienda utilizar el conjunto de datos preprocesados para el entrenamiento

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Puestos relacionados

Sin comentarios...