TANGO: una herramienta de vídeo retrato gestual coordinado generado por la voz de una persona digital de cuerpo entero

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 70K 00

Introducción general

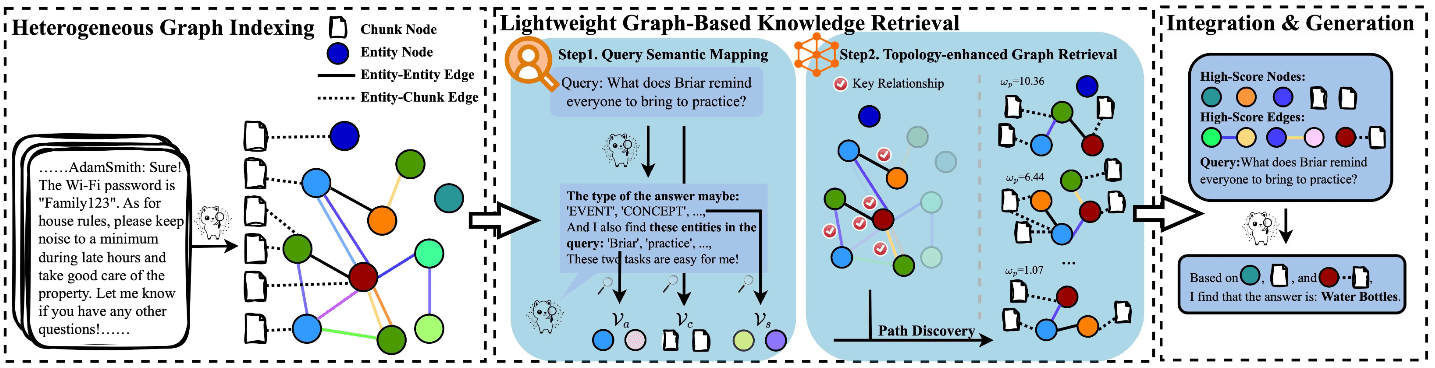

TANGO (Co-Speech Gesture Video Reenactment with Hierarchical Audio-Motion Embedding and Diffusion Interpolation) es un marco de código abierto desarrollado conjuntamente por la Universidad de Tokio y CyberAgent AI Labs para la generación colaborativa de vídeos de voz y gestos. El proyecto utiliza un espacio jerárquico de incrustación de audio-movimiento e interpolación por difusión para generar automáticamente vídeos de gestos naturales, fluidos y sincronizados a partir del discurso de entrada. TANGO consigue una generación de gestos-acción de alta calidad mediante un innovador método de recuperación de gráficos de acción que, en primer lugar, recupera el clip de vídeo de referencia que más se aproxima al discurso de destino en un espacio jerárquico implícito de incrustación de audio-movimiento y, a continuación, utiliza un modelo de difusión para la interpolación de la acción. generación de acciones. Este proyecto no sólo hace avanzar la investigación sobre la interacción persona-ordenador impulsada por la IA, sino que también proporciona un importante apoyo técnico a aplicaciones como los anclajes virtuales y los humanos digitales.

El actual TANGO de código abierto sólo soporta audio de hasta 8s, antes de usarlo, ¡necesitas hacer la segmentación del archivo de audio!

Combinado con la herramienta Voice Lip Sync para un proyecto completo de persona digital: Sync ,Wav2Lip Ultralight Digital Human. El flujo de trabajo completo es: Ultralight Digital Human para el contrapunto, TANGO para generar los movimientos corporales, FaceFusion para cambiar las caras, ¡perfecto!

Experiencia en línea: https://huggingface.co/spaces/H-Liu1997/TANGO

Lista de funciones

- Sincronización de gestos de alta precisión : Sincroniza con precisión cualquier audio con los gestos del vídeo.

- Compatibilidad multilingüe: funciona con una gran variedad de idiomas y sonidos, incluidas caras CGI y sonidos sintetizados.

- Código abierto y gratuito : El código es totalmente público, y los usuarios son libres de utilizarlo y modificarlo.

- Demostración interactiva: Ofrece una demostración en línea en la que los usuarios pueden cargar archivos de vídeo y audio para experimentar.

- Modelos de preentrenamiento: Proporcionan una variedad de modelos de preentrenamiento, que los usuarios pueden utilizar directamente o como entrenamiento secundario.

- Código de entrenamiento completo: incluye el código de entrenamiento para el discriminador de sincronización de gestos y el modelo TANGO.

Utilizar la ayuda

1. Configuración medioambiental

1.1 Requisitos básicos:

- Versión de Python: 3.9.20

- Versión de CUDA: 11.8

- Espacio en disco: al menos 35 GB (para almacenar modelos y diagramas precalculados)

1.2 Pasos de la instalación:

# 克隆项目仓库

git clone https://github.com/CyberAgentAILab/TANGO.git

cd TANGO

git clone https://github.com/justinjohn0306/Wav2Lip.git

git clone https://github.com/dajes/frame-interpolation-pytorch.git

# 创建虚拟环境(可选)

conda create -n tango python==3.9.20

conda activate tango

# 安装依赖

pip install -r ./pre-requirements.txt

pip install -r ./requirements.txt

2. Flujo de utilización

2.1 Inicio rápido:

- Ejecute el script de razonamiento:

python app.py

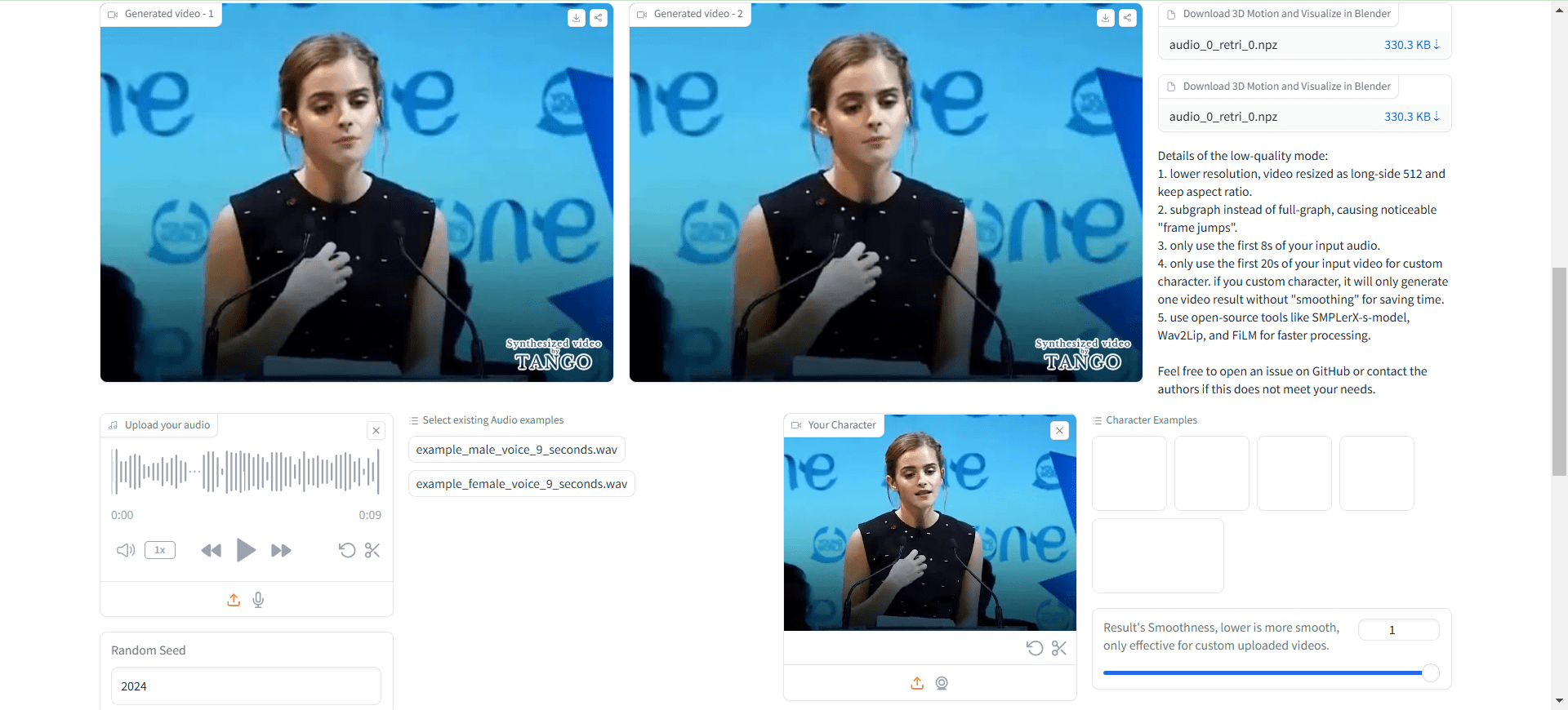

En la primera ejecución, el sistema descarga automáticamente los archivos de puntos de control necesarios y los diagramas precalculados. La generación de aproximadamente 8 segundos de vídeo requiere unos 3 minutos de tiempo de procesamiento.

2.2 Creación de roles personalizados:

- Si necesitas crear una figura de acción para un nuevo personaje:

python create_graph.py

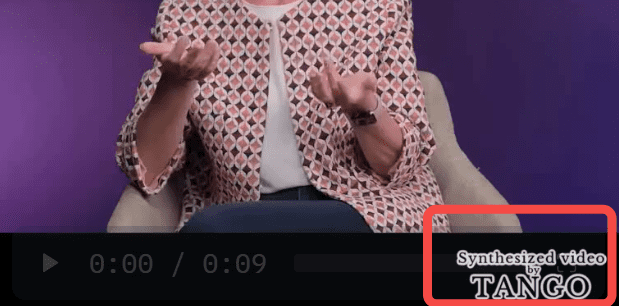

Entre otras cosas, el proyecto genera vídeos con marcas de agua TANGO por defecto, similares a la que se muestra a continuación:

Esencialmente, es una llamada a un ffmpeg local que compone el vídeo original y la imagen con marca de agua en un nuevo vídeo.

Si no quieres una marca de agua, puedes cambiarapp.pyMedio:

gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0", , watermark="./datasets/watermark.png") # 修改为 gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0")

Acceso no localhost, se requieren modificaciones:

demo.launch(server_name="0.0.0.0", server_port=7860)

Ábrelo de nuevo y no encontrarás ninguna marca de agua en el vídeo cargado.

El vídeo resultante no tiene audio, por lo que es necesario sintetizar manualmente el audio en él.

/usr/bin/ffmpeg -i outputs/gradio/test_0/xxx.mp4 -i gen_audio.wav -c:v libx264 -c:a aac result_wav.mp4

Se nota: no hay nada malo en los movimientos del cuerpo, la forma de la boca es completamente errónea.

Esto no lo es. Ultraligero Digital Humano ¿Y fue útil?

Proceso de utilización

- Acceso al servidor local: Abrir en el navegador

http://localhost:3000. - Cargar vídeo y audio : Cargue los archivos de audio y vídeo que desea sincronizar en el cuadro de entrada.

- Realizar la sincronización de gestos : Pulse el botón "Sincronizar", el sistema realizará automáticamente el proceso de sincronización de gestos.

- Visualización y descarga de resultados : Una vez finalizada la sincronización, puedes previsualizar los resultados y descargar los archivos de vídeo sincronizados.

- Utilice la demostración interactiva: cargue archivos de vídeo y audio en la página de demostración para experimentar el efecto de sincronización de gestos en tiempo real.

- Gestionar proyectos : Vea y gestione todos los proyectos cargados en la página Mis proyectos, con soporte para el control de versiones y la colaboración.

Funciones avanzadas

- Sincronización inteligente de gestos : Mejore la presentación de sus contenidos de vídeo con la sincronización inteligente de gestos proporcionada por la IA.

- Soporte multilingüe : Selecciona diferentes idiomas y voces según las necesidades de tu proyecto.

- Desarrollo a medida: Como TANGO es de código abierto, los usuarios pueden desarrollarlo según sus necesidades.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...