Step-Audio: un marco de interacción multimodal por voz que reconoce el habla y se comunica mediante habla clonada, entre otras funciones.

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 67K 00

Introducción general

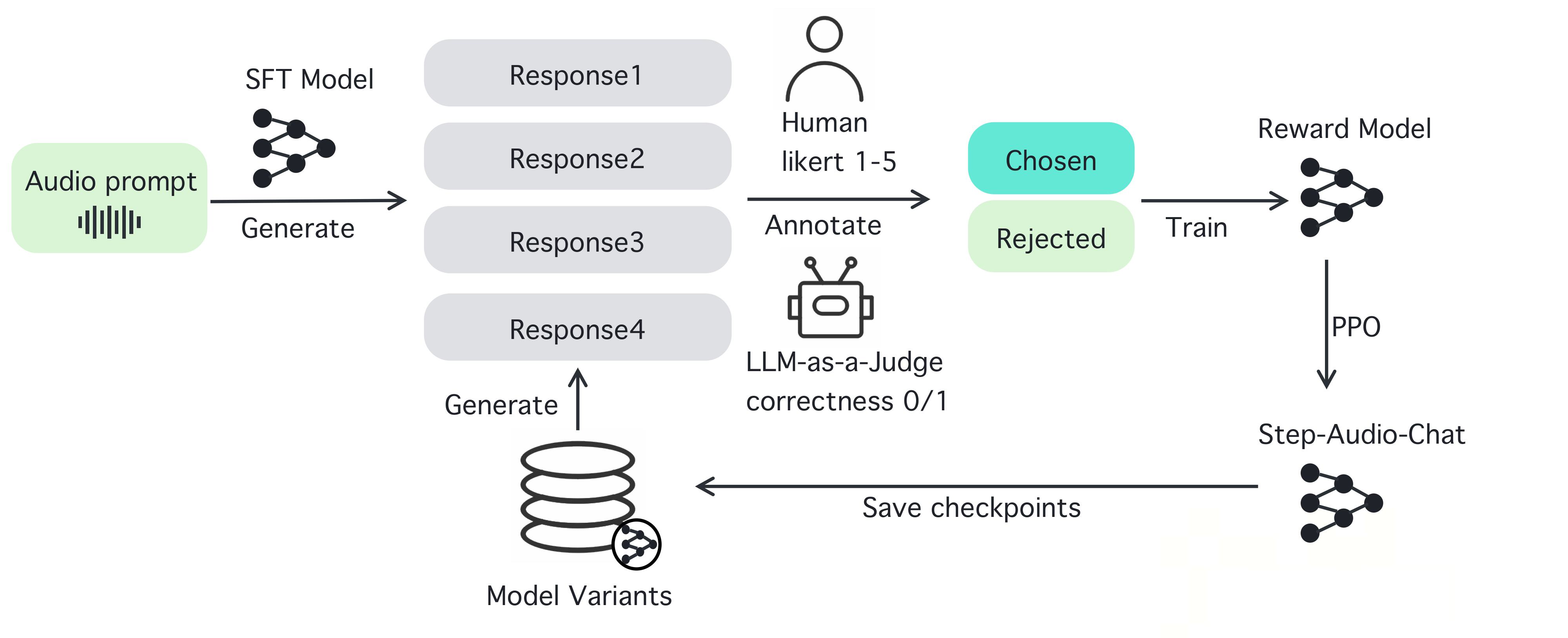

Step-Audio es un marco de interacción de voz inteligente de código abierto diseñado para proporcionar capacidades de comprensión y generación del habla listas para usar en entornos de producción. El marco admite diálogos en varios idiomas (chino, inglés, japonés, etc.), habla emocional (alegre, triste, etc.), dialectos regionales (cantonés, szechuan, etc.) y estilos de ritmo y rima ajustables (rap, etc.). Step-Audio implementa el reconocimiento del habla, la comprensión semántica, el diálogo, la clonación del habla y la síntesis del habla a través de un modelo multimodal de 130B parámetros. Su motor de datos generativos elimina la dependencia de la tradicional recopilación manual de datos TTS al generar audio de alta calidad para entrenar y publicar el modelo Step-Audio-TTS-3B, que consume pocos recursos.

Lista de funciones

- Reconocimiento del habla en tiempo real (ASR): convierte el habla en texto y admite un reconocimiento de alta precisión.

- Síntesis de texto a voz (TTS): convierte el texto en voz natural y admite una amplia gama de emociones y entonaciones.

- Compatibilidad multilingüe: maneja idiomas como el chino, el inglés, el japonés y dialectos como el cantonés y el szechuan.

- Control de la emoción y la entonación: Ajuste de la emoción de salida del habla (por ejemplo, feliz, triste) y el estilo de rima (por ejemplo, RAP, tarareo).

- Clonación de voz: Genera una voz similar basada en la voz de entrada, admite el diseño de voz personalizado.

- Gestión del diálogo: mantenga la continuidad del diálogo y mejore la experiencia del usuario con el Gestor de Contexto.

- Cadena de herramientas de código abierto: proporciona pesos completos de código y modelos que los desarrolladores pueden utilizar directamente o desarrollar dos veces.

Utilizar la ayuda

Step-Audio es un potente framework de código abierto para la interacción multimodal por voz que permite a los desarrolladores crear aplicaciones de voz en tiempo real. A continuación se muestra una guía detallada paso a paso para instalar y utilizar Step-Audio, así como sus características para asegurarse de que puede empezar fácilmente y utilizarlo en todo su potencial.

Proceso de instalación

Para utilizar Step-Audio, es necesario instalar el software en un entorno con una GPU NVIDIA. A continuación se detallan los pasos a seguir:

- Preparación medioambiental::

- Asegúrese de que tiene Python 3.10 instalado en su sistema.

- Instale Anaconda o Miniconda para gestionar el entorno virtual.

- Comprueba que el controlador de la GPU NVIDIA y el soporte CUDA están instalados, se recomiendan 4xA800/H800 GPUs (80GB RAM) para obtener la mejor calidad de generación.

- almacén de clones::

- Abra un terminal y ejecute el siguiente comando para clonar el repositorio de Step-Audio:

git clone https://github.com/stepfun-ai/Step-Audio.git cd Step-Audio

- Abra un terminal y ejecute el siguiente comando para clonar el repositorio de Step-Audio:

- Creación de un entorno virtual::

- Crear y activar un entorno virtual Python:

conda create -n stepaudio python=3.10 conda activate stepaudio

- Crear y activar un entorno virtual Python:

- Instalación de dependencias::

- Instale las bibliotecas y herramientas necesarias:

pip install -r requirements.txt git lfs install - Clonación de pesos adicionales del modelo:

git clone https://huggingface.co/stepfun-ai/Step-Audio-Tokenizer git clone https://huggingface.co/stepfun-ai/Step-Audio-Chat git clone https://huggingface.co/stepfun-ai/Step-Audio-TTS-3B

- Instale las bibliotecas y herramientas necesarias:

- Verificar la instalación::

- Ejecutar un script de prueba simple (como en el código de ejemplo)

run_example.py) para asegurarse de que todos los componentes funcionan correctamente.

- Ejecutar un script de prueba simple (como en el código de ejemplo)

Una vez completada la instalación, puede empezar a utilizar las distintas funciones de Step-Audio. A continuación se detallan las instrucciones para operar las funciones principales y destacadas.

Funciones principales

1. Reconocimiento del habla en tiempo real (ASR)

La función de reconocimiento de voz de Step-Audio convierte la voz del usuario en texto, lo que lo hace idóneo para crear asistentes de voz o sistemas de transcripción en tiempo real.

- procedimiento::

- Asegúrese de que el micrófono está conectado y configurado.

- Utilice el

stream_audio.pyScript para iniciar la transmisión de audio en directo:python stream_audio.py --model Step-Audio-Chat - Cuando hablas, el sistema convierte el habla en texto en tiempo real y emite el resultado en el terminal. Puedes comprobar el registro para confirmar la precisión del reconocimiento.

- Funciones destacadas: Admite el reconocimiento multilingüe y dialectal, como la entrada mixta de chino e inglés, o el habla localizada, como el cantonés y el sichuanés.

2. Síntesis de texto a voz (TTS)

Con la función TTS, puedes convertir cualquier texto en habla natural, compatible con una amplia gama de emociones, velocidades de voz y estilos.

- procedimiento::

- Prepare el texto que va a sintetizar, por ejemplo, guárdelo como

input.txt. - utilizar

text_to_speech.pyGuiones para generar discurso:python text_to_speech.py --model Step-Audio-TTS-3B --input input.txt --output output.wav --emotion happy --speed 1.0 - Descripción de los parámetros:

--emotion: Establece la emoción (por ejemplo, feliz, triste, neutro).--speedAjuste la velocidad del habla (0,5 para lento, 1,0 para normal, 2,0 para rápido).--outputEspecifica la ruta del archivo de audio de salida.

- Prepare el texto que va a sintetizar, por ejemplo, guárdelo como

- Funciones destacadas: Admite la generación de estilos de habla RAP y tarareo, por ejemplo:

python text_to_speech.py --model Step-Audio-TTS-3B --input rap_lyrics.txt --style rap --output rap_output.wav

这将生成一段带有 RAP 节奏的音频,非常适合音乐或娱乐应用。

#### 3. 多语言与情感控制

Step-Audio 支持多种语言和情感控制,适合国际化应用开发。

- **操作步骤**:

- 选择目标语言和情感,例如生成日语悲伤语气语音:

python generate_speech.py --language japanese --emotion sad --text "私は悲しいです" --output sad_jp.wav

- 方言支持:如果需要粤语输出,可以指定:

python generate_speech.py --dialecto cantonés --texto "Estoy tan colgado de ti" --output cantonés.wav

- **特色功能**:通过指令可以无缝切换语言和方言,适合构建跨文化语音交互系统。

#### 4. 语音克隆

语音克隆允许用户上传一段语音样本,生成相似的声音,适用于个性化语音设计。

- **操作步骤**:

- 准备一个音频样本(如 `sample.wav`),确保音频清晰。

- 使用 `voice_clone.py` 进行克隆:

python voz_clonada.py -entrada muestra.wav -- salida voz_clonada.wav --modelo Paso-Audio-Chat

- 生成的 `cloned_voice.wav` 将模仿输入样本的音色和风格。

- **特色功能**:支持高保真克隆,适用于虚拟主播或定制语音助手。

#### 5. 对话管理与上下文保持

Step-Audio 内置上下文管理器,确保对话的连续性和逻辑性。

- **操作步骤**:

- 启动对话系统:

python chat_system.py --modelo Step-Audio-Chat

- Introduzca texto o voz y el sistema generará una respuesta basada en el contexto. Ejemplo:

- Usuario: "¿Qué tiempo hace hoy?"

- SISTEMA: "Por favor, dígame su ubicación y lo comprobaré".

- Usuario: "Estoy en Pekín".

- SISTEMA: "Pekín está soleado hoy, con una temperatura de 15°C".

- Funciones destacadas: Admite varias rondas de diálogo, mantiene la información contextual y es adecuado para bots de atención al cliente o asistentes inteligentes.

advertencia

- requisitos de hardwareAsegúrate de que la GPU tiene suficiente memoria: se recomiendan 80 GB o más para un rendimiento óptimo.

- conexión de red: Algunos de los pesos del modelo deben descargarse de Hugging Face para garantizar una red estable.

- detección de erroresSi encuentra errores de instalación o de ejecución, compruebe los archivos de registro o consulte la página de problemas de GitHub para obtener ayuda.

Siguiendo estos pasos, podrá aprovechar al máximo la potencia de Step-Audio, tanto si desarrolla aplicaciones de voz en tiempo real como si crea contenidos de voz personalizados o un sistema de diálogo multilingüe. la naturaleza de código abierto de Step-Audio también le permite modificar el código y optimizar el modelo según sea necesario para satisfacer las necesidades específicas de su proyecto.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...